多特征融合的遥感图像分类

刘 帅 李士进 冯 钧

(河海大学计算机与信息学院,南京,210098)

引 言

随着遥感和信息技术的迅速发展,每天可获取的遥感图像数据量正以惊人的速度增长。面对海量的遥感数据,如何利用计算机自动把图像按照语义进行分类成为一个极具挑战性的难题。传统的遥感影像目视解译方法不仅要求丰富的专业经验和充足的野外实地调查资料,而且由于这种识别方法是建立在特定的先验知识基础上,因此识别难度大,效率较低[1]。高分辨率遥感影像能够提供丰富的地物细节,但各种地物空间分布复杂,同类物体呈现出很大的光谱异质性,具体表现为特征类内方差变大、类间方差减小、不同地物的光谱相互重叠,使得传统的基于像元的分类技术容易造成过多的错分、漏分,从而导致分类精度较低。以往传统方法主要依据光谱信息,没有较好地利用高空间分辨率影像的对象特征。近年来出现了面向对象的分类方法[2]。

根据描述图像的方式不同,当前面向对象的场景分类方法分为基于全局特征和基于局部特征的视觉词袋模型两大类。早期的场景分类方法是根据图像的全局统计特征来描述场景内容的,如颜色直方图[3]、纹理[4]等。颜色直方图具有较好的几何变换不变性,并且计算效率高。但是由于其舍弃了图像的空间信息,对于两幅颜色分布相同,内容具有显著差别的图像无法区分,因此鲁棒性不好,识别率较低。近年来,场景分类的主流方法是基于词袋模型[5](Bag of visual words,BOVW)的方法,它将图像表示为一些局部图像块,每幅图像像文本句子一样被表示为不同频率的单词,所有单词的集合组成词典。词袋模型具有计算简单,对噪声、光照和局部遮挡更加鲁棒等特点。但是由于遥感图像纹理信息丰富,局部特征点较多,直接采用基于聚类方法获得视觉单词不一定能反映场景特征,从而造成总体分类精度也不高。并且对于高分辨率遥感图像中的不同目标,各种特征的有效性不尽相同:如有些类可能由于其颜色特征的显著性,所以最适合采用颜色直方图特征来进行分类,而有些地物纹理比较丰富,局部特征更加显著。显然如果采用单一特征对不同类别目标进行分类不再适用。

针对上述问题,本文从两方面进行了研究。首先对视觉词袋模型进行了改进,通过对不同场景类的显著单词特征信息进行加权,从而提高了单一图像与整体类的相似程度。对一些个体差异比较明显,但语义相似的图像取得了很好的分类正确率。其次考虑到每类图像所具有的显著特征并不一致,并且不同特征错分的情况也不尽相同,提出了多特征融合的遥感图像分类方法,并根据每种特征的分类结果进行自适应综合,最终获得多特征融合后的分类结果。

1 特征提取

图像特征在模式分类中具有极其重要的作用,本文基于改进的图像视觉词袋模型、颜色直方图和Gabor纹理特征进行遥感影像分类。

1.1 视觉词袋特征

文献[6]提出基于局部特征的生成模型用于图像分类,Lazebnik[7]提出了基于几何对应的图像分类方法,但这些方法性能不稳定而且计算复杂度非常高。为了更好利用这些局部特征,研究人员提出许多基于特征词袋的方法进行图像目标分类,并取得良好性能。视觉词袋的生成算法主要包括局部特征的提取和图像的高层语义表示两个步骤。

图像的局部特征是根据某种显著性准则定义的图像局部模式,通常与一种或几种图像属性的改变相关联,存在点、边、图像区块等多种形式。它可以克服视角和光照变化、复杂背景、遮挡和类内差异等视觉表示的困难。近年Lowe提出的具有各种不变性的尺度不变转换(Scale invariant feature transform,SIFT)特征[8]集特征检测和描述于一体,对旋转、尺度和亮度等变换保持不变,对视角变化和光照变化也具有一定的稳定性。SIFT特征的构造方法包括关键点的检测和描述子的构造两部分。

将输入图像通过不同尺度的高斯核函数进行连续滤波和下采样,形成高斯金字塔图像。再将相邻尺度的两个高斯图像相减得到高分差(Difference of Gaussians,DoG),即金字塔多尺度空间表示。然后对金字塔多尺度空间上的每个点与相邻尺度和相邻位置的点逐个进行比较,得到的局部极值位置即为关键点所处的位置和对应的尺度。通过拟合三维二次函数对关键点进行进一步的精确定位,去除低对比度关键点和不稳定的边缘响应点,以增强匹配稳定性和抗噪声能力。

在构造SIFT描述子之前要为每个关键点赋予一个主方向,使描述子具有旋转不变性。然后以特征点为中心,取16像素×16像素的邻域作为采样窗口,再将此邻域均匀地分为4×4个子区域,计算每个子区域的梯度方向直方图,然后将子区域里的8方向直方图根据位置顺次排序,最后获得4×4×8的128维特征描述子[9]。

提取局部特征描述子后,利用矢量量化方法(如K均值聚类)对局部特征点集进行聚类,聚类中心即为视觉单词。K均值聚类算法具有简单、高效等优点,常用于视觉词袋模型中生成视觉词典。得到视觉词典后,采用硬分配方法将图像特征向量分配到距离最近的视觉单词,然后统计词频形成图像表示。这样一幅图像就可以用一个高维的视觉单词向量进行表示[10]。

1.2 改进的视觉词袋特征

传统的词袋模型已经广泛应用于物体识别和场景分类,但是也存在一些缺点,因此出现很多改进算法。如在视觉表示中加入空间信息[11-12],对聚类算法的改进[13-14]等,本文的改进算法主要是采用软权重的思想加强了图像的显著视觉特征表示。

原始的图像词袋表示仅包含了单幅图像的特征。当同一类场景的各个图像之间存在较大差异时,图像词袋表示之间的差异也会较大。这些差异会影响图像的分类精度。并且,虽然同一类中有些图像与其他图像之间存在着较大的差异,但是这些存在较大差异的图像也包含了能够代表这一类图像所共有的特征,这些特征是进行分类判断的重要依据。如果充分考虑到同一类图像所共有的图像特征,那么在分类时就不仅考虑了图像与图像之间的相似,也考虑了图像与整体类之间的相似性,从而对分类会有较大的帮助。一类场景中所共有的这些特征往往出现在词频比较靠前的一些单词上,这些单词的组合构成了类与类之间的鉴别特征。如果在词袋生成的过程中对这些词频靠前的单词进行加权表示,那么单幅图像就会加入了所属类的共有特征,从而能提高分类精度。

本文据此对词袋模型进行了改进,提出了一种新的加权词袋表示,具体步骤如下:

(1)类总体词袋表示:统计每一类场景所有图像的视觉词袋表示中各个视觉单词的词频,从而得到一类场景的的总体词袋表示。

(2)确定重要单词的权重:从统计结果中取前N名单词的词频,对这N个单词的词频进行归一化,并通过其词频的倒数来表示单词对应的权重值,其值分别为wi(0<i<N+1,i为整数)。将这些权重值进行归一化,使其权重值在0到1之间。然后对每一个权重值进行加1的运算,即wi=wi+1。这样权重值就被量化到1和2之间,以此消除过大的权重所带来的不利影响。

(3)挑选每类重要的单词进行加权:各个图像的特征向量进行词袋分配后,将单幅图像所属类的前N名单词的权重值wi乘以单幅图像中权重值wi所对应的单词词频。这样就得到单幅图像的加权视觉词袋表示。

经过上述处理,得到了加权图像词袋表示,它充分反映了每类图像的显著特征,后面的实验证明能有效提高图像的分类精度。

1.3 颜色直方图

颜色直方图是在许多图像检索系统中被广泛采用的一种全局特征,具有特征提取和相似度计算简便的优点。Swain和Ballard[3]最早提出把直方图应用于图像检索。本文的直方图特征提取基于亮度饱和度(Hue,lightness,saturation,HLS)色彩空间,相对于RGB色彩空间,其更符合人眼的视觉感知特性。具体提取方法如下:

对于图像中的每一个像素,将其H,L,S分量分别量化为8等份,这样HLS直方图就有256个间隔(bin)。然后统计所有像素的直方图,最后再进行归一化,以消除图像大小变化的影响。

1.4 纹理特征

纹理是空间以一定的形式变化而产生的图案,是一种不依赖于颜色或亮度反应图像中同质现象的视觉特征。基于统计信息的纹理特征提取是对图像中颜色及强度的空间分布信息进行统计得到相关纹理信息。使用Gabor滤波器获得图像纹理特征被证明是一种高效的遥感图像分析方法[4],鉴于该方法的优越性,它已经在2002年的MPEG-7多媒体内容描述接口中被标准化[15]。具体提取方法如下:使用5个尺度,6个方向的Gabor滤波器对原始图像进行Gabor变换,可以形成30幅图像纹理表示,再计算这30幅图像的均值和方差从而得到一个60维的特征向量。

2 融合多特征的遥感图像分类算法

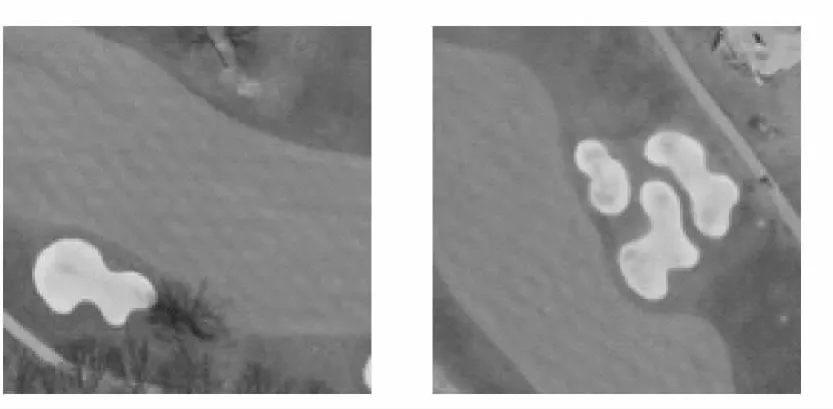

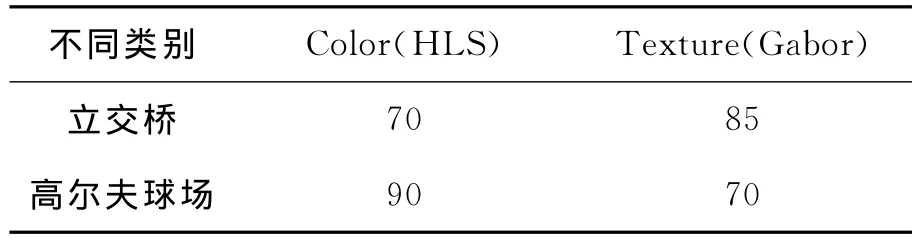

一类场景中图像的显著特征有些表现在局部特征点上,有些表现在颜色直方图上,还有一些则表现在纹理上。如图1中立交桥类的纹理非常明显,如果采用纹理进行分类,将会有很好的效果。而图2中的高尔夫球场,由于颜色特征比较显著,则使用颜色直方图分类效果较好。表1给出了这两类图像采用不同特征的分类结果。可见采用单一的特征对所有类进行分类很容易造成一类场景的显著特征的丢失从而降低分类精度。

图1 立交桥(纹理特征非常明显)Fig.1 Overpass(Texture feature is very obvious)

图2 高尔夫球场(颜色特征非常明显,总是一些绿色和一些白色的搭配)Fig.2 Golfcourse(Colour feature is very obvious,always be the mixture of green and white)

表1 立交桥类和高尔夫球场类采用不同特征的分类结果(80幅训练样本,20幅测试样本) %Table 1 The classification accuracy of different features of overpass and golfcourse(80are training samples,20are testing samples)

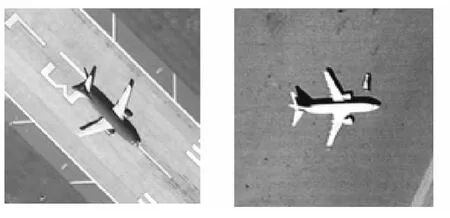

不仅如此,同一类场景的不同图像的显著特征也存在差异,如果只采用一种特征来对图像进行分类,则也很容易丢失单幅图像的显著特征,造成分类精度不高。如飞机类遥感图像中,有些纹理较为显著,而有些局部特征比较显著,见图3。如果只利用单一特征进行识别,则不能较好的利用每幅图像的显著特征,从而造成分类精度降低。多特征融合能够改善这种情况,进一步提高分类精度[16]。

图3 飞机(左边图像的纹理特征比较明显,而右边图像的纹理特征不明显,但是局部形状特征较为明显)Fig.3 Airplane(Texture feature of left images are obvious,while the right are not,but the local features are obvious)

本文的方法就是针对遥感图像中复杂目标的这些特点,首先为不同场景类各个样本分别提取三种特征,然后采用多特征融合的方法,在图像分类中自适应选择不同特征的分类结果进行组合,从而极大提高了分类精度。

本文算法步骤如下:

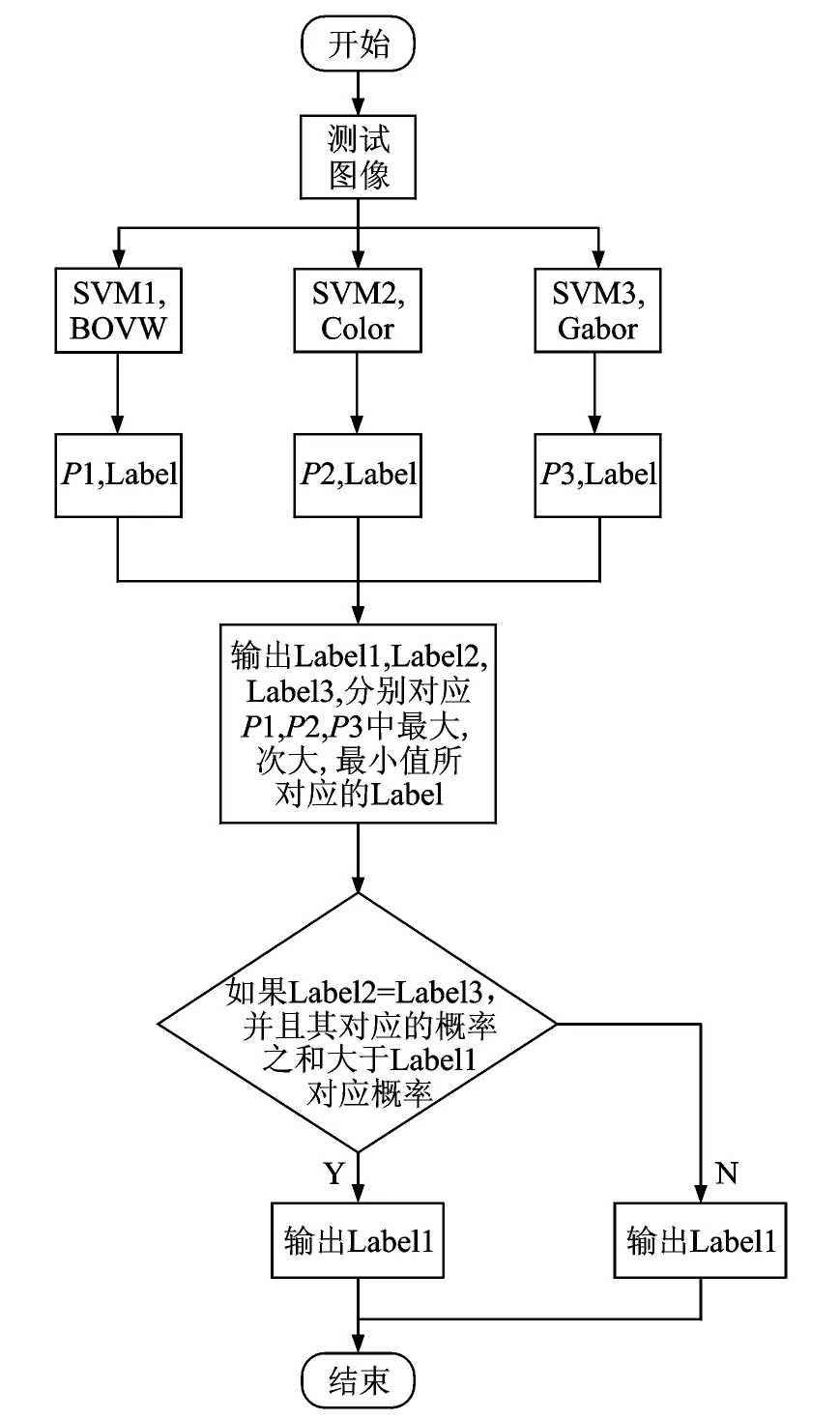

(1)训练过程。将已经标记好类标签的训练样本图像提取局部特征,得到BOVW表示;再提取全局特征,得到HLS颜色直方图表示和Gabor纹理表示。然后分别用支持向量机(Support vector machine,SVM)训练,得到3个不同的支持向量机分类器,分别记为SVM1,SVM2,SVM3。

(2)测试过程。提取待测试图像的BOVW表示,颜色直方图特征以及Gabor纹理特征,将其分别采用SVM1,SVM2,SVM3进行分类,得到该图像的三组预测概率:分别为P1,P2,P3。

(3)判断待检测图像的显著特征,并求其对应的最大概率值:计算P1,P2,P3中的最大值max,并得到该max所对应的类标签为Label1。同时记录P1,P2,P3中的次大值以及第3大值,分别对应次显著特征和最不显著特征,相应的类标签记为Label2和Label3。

(4)由于次显著特征和最不显著特征的组合可能要比显著特征好,因此要比较这两者的投票结果和最显著特征概率的大小:如果Label2和Label3相同,并且对应的概率之和大于max,则最终的分类结果为Label2或Label3。否则,输出Label1作为最终的分类结果。

具体测试流程如图4所示。

图4 本文算法测试过程的流程图Fig.4 The flow chart of testing process of our proposed algorithm

3 实验结果及分析

鉴于支持向量机在解决高维特征空间中线性不可分问题上的优越性能,本文采用支持向量机作为基分类器[17]。对于多类分类问题,采用一组二类分类器来进行最大值投票表决,并根据投票结果得到分类结果和对应的类概率。本文支持向量机实现使用了LIBSVM软件包[18],各个分类器的最优参数通过该软件包附带的网格搜索法获得。

3.1 数据

本文采用了与文献[5]相同的图像数据进行实验。该图像数据集是国际上第一个大型的遥感图像分类公共测试数据集,共21类,每类100幅图像,均为QuickBird高分辨率遥感图像,大小为256×256。这些图像是从美国地质勘探局(United states geological survey,USGS)处下载的,包括美国多个州的各种场景:农田、飞机、棒球内场、海滨、建筑物、灌丛、稠密居住区、森林、高速公路、高尔夫球场、海港、十字路口、中等稠密居住区、活动房区、立交桥、停车场、河流、机场跑道、稀疏居住区、储油罐和网球场。这些图像反映了每类场景的典型情况,具有较好的代表性。

在下面分类实验中,如无特别说明,从每一类中取出80幅图像作为训练样本,20幅图像作为测试样本。

3.2 改进的BOVW

首先比较了采用不同核函数时词袋模型的分类精度,并据此确定后续实验的核函数。图5和图6分别给出了改进的BOVW方法和原始BOVW方法在采用不同的SVM核函数和码本个数时的平均分类精度值。从图5和图6可以看出,直方图相交核(Histogram Inter SVM)要优于线性核函数(Linear SVM)和径向基核(RBF SVM),并且当码本的个数为1 000时,分类效果最好。图5,6中,码本个数分别为200,500,1 000,2 000,5 000。

图5 采用不同的核函数和码本个数,改进的BOVW方法的总体平均分类精度Fig.5 The overall average classification accuracy of our improved BOVW method which use the different kernel function or codebook number

图6 采用不同的核函数和码本个数,原始的BOVW方法的总体平均分类精度Fig.6 The overall average classification accuracy of our original BOVW method which use the different kernel function or codebook number

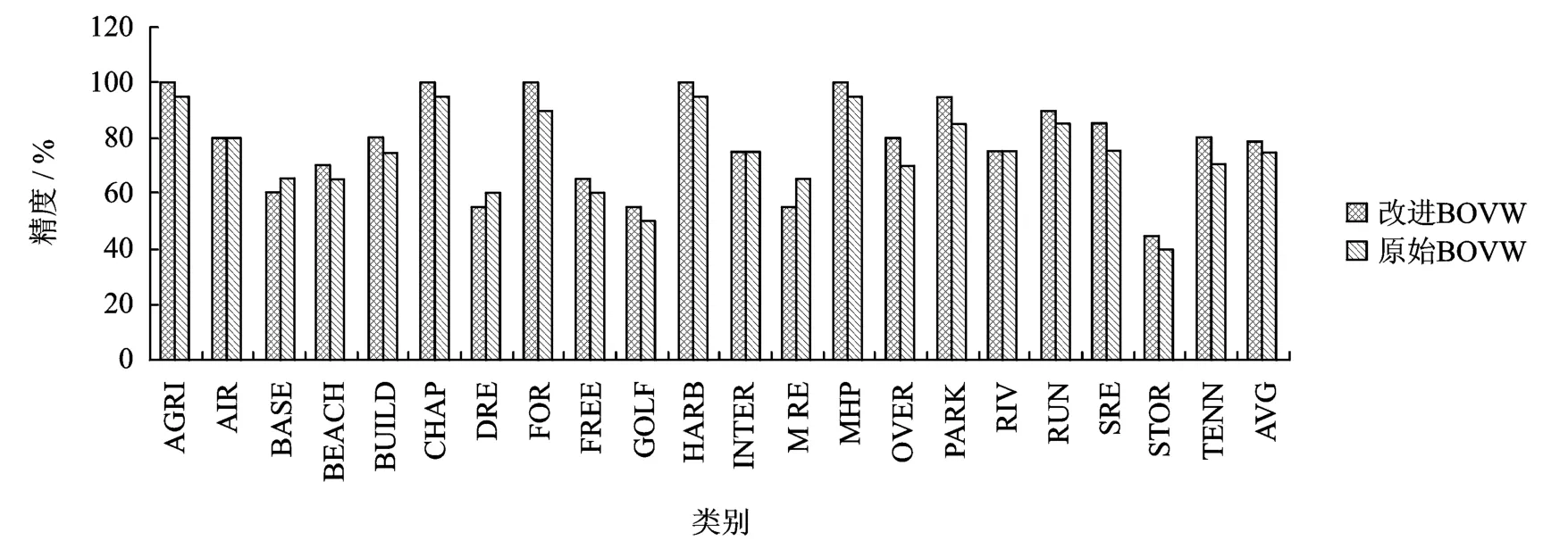

图7 本文改进后的BOVW生成算法和原始BOVW的各类分类精度和总的平均分类精度Fig.7 The average classification accuracy of each class which used our improved BOVW algorithm or the original algorithm,the overall average classification accuracy which use our improved BOVW algorithm or the original algorithm

采用本文改进的BOVW词袋生成算法,算法步骤2中的参数N为20时效果最佳。与普通的BOVW算法进行比较,结果如图7所示。从图7看出,本文改进的BOVW词袋生成算法比原始的BOVW词袋生成算法的总体平均分类精度约有4%的提高(78.33%vs 74.52%)。

3.3 单一特征的分类结果

根据上一节实验分析,采用直方图相交核作为BOVW特征和颜色直方图特征的核函数。RBF核函数作为Gabor纹理特征的的核函数。BOVW特征中,参数C的值设为8时分类结果最优,颜色直方图特征中,参数C的值设为32时最优。Gabor特征中,参数C的值设为128,参数g的值设为0.003 906 25时最优。

如前所述,从每一类中选取80幅图像作为训练样本,利用支持向量机进行训练,其余20幅图像作为测试样本。各个特征对应分类器使用的参数如下:词袋模型中,码本个数为1 000;颜色直方图特征中,向量维数为512;Gabor纹理中,尺度数为5,方向数为6,向量维数为60。分类结果统计如图8所示。

从图8可以看出,对 AGRI,AIR,BUILD,CHAP,FOR,HARB,INTER,MHP,PARK,SRE,TENN 类,BOVW 的 分 类 效 果 较 好,对BASE,BEACH,DRE,GOLF,MRE,RIV,STOR类,颜色直方图的效果较好,对FREE,OVER,RUN类,Gabor纹理特征的分类较高。虽然每一种特征都有表现较好的几类,但是总体平均分类精度都不高,不能满足实际分类精度的要求。3种单一特征BOVW,颜色直方图,Gabor纹理的总体平均分类精度分别为78.33%,78.33%,71.19%。

3.4 多特征融合的结果

采用本文自适应融合算法的分类结果的统计如图8所示。从图8可以看出,除了BASE,BEACH,GOLF,RIV,SRE类,其他类的分类精度都要比单一特征的最大分类精度要高,这说明对每一种特征,其错分的图像不同,并且有交叉。采用多特征融合的方法可以根据图像的显著特征自适应得到较可靠的分类结果。而BASE,BEACH,GOLF,RIV,SRE类,由于个别图像的显著特征将其错分了,从而导致最终的分类错误,降低了总的分类精度。但这些降低是建立在其他大多数类的分类精度的明显提升基础上的,所以这种折中平衡是可以接受的。从图像的总体平均分类精度上看,达到了89.05%,比单一特征分类精度的最高值78.33%要高出约10%。这样好的分类精度表明本文算法具有较大优越性。

3.5 和其他融合方法的比较

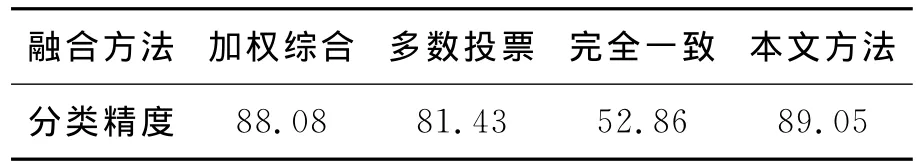

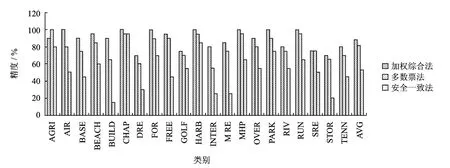

在文献[19,20]中,研究人员提出几种常见的多分类器组合方法用于遥感图像分类,有投票表决法,最大概率类别法及模糊积分判别法等,本文选择对加权综合法,多数票法和完全一致法3种多分类器组合方法进行比较。加权综合法计算每种特征所对应分类器的总体精度,作为其权重值,然后分别求出待识别图像的每种特征所对应的类概率值,并乘以其权重。最后对相同类的概率值相加,并根据最大概率作为最终的输出。多数票法计算每种特征所对应的类标签输出,只有至少两个输出标签相同时才给出识别结果,否则拒识。完全一致法要求更严格,只有在3个分类器输出一致的情况下才输出结果,否则拒识。图9给出了上述3种组合方法对各类的具体识别结果。表2给出了各种方法的平均分类精度对比。

表2 各种方法平均分类精度对比 %Table 2 The comparison of the overall average classification accuracy of different functions

图8 单一特征和多特征融合方法的各类分类精度和总的平均分类精度Fig.8 The average classification accuracy of each class which is based on the single feature or the fusion of multiple features

图9 加权综合法、多数票法和完全一致法各类分类精度和总的平均分类精确度Fig.9 The average classification accuracy of each class which used weighted comprehensive assessment method or the majority vote method or the complete unification method,the overall average classification accuracy which used weighted comprehensive assessment method or the majority vote method or the complete unification method

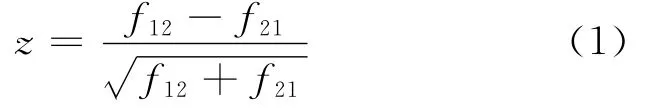

为了说明本文方法的有效性,采用遥感图像分类中常用的非参数 McNemar检验[21]进行统计显著性分析。该方法基于标准正态检验公式

式中:f12表示方法1错分类而方法2正确分类的样本数,f21表示方法2错分类而方法1正确分类的样本数。本文方法和其他方法的显著性检验结果见表3。

表3 本文方法与其他各种方法的非参数McNemar检验结果Table 3 The result comparison of non-parameter of our proposed method and other methods

对于5%的显著性水平,对应的|z|值为1.96。本文方法和加权综合法处于相同水平,而显著优于多数票法与完全一致法。加权综合法平均分类精度与本文算法的结果比较接近,但是由于该方法要求首先根据训练样本集测试精度确定每个分类器的权重,考虑的是所有训练样本的总体平均精度,而本文方法根据每个测试样本的具体情况自适应确定其多特征的融合,因此本文方法平均精度更高。多数票法和完全一致法明显低于本文方法,分别只有81.43%和52.86%。

4 结束语

本文采用基于支持向量机的多特征融合的方法对高分辨率遥感图像进行分类,对各单一特征的分类结果进行自适应综合,提高了分类精度。并且改进了传统的BOVW生成算法,对每类的总体视觉单词特征进行了加权,提高了分类精度。与当前流行的几种融合方法进行比较,在一个大型遥感图像公共测试数据集上进行的对比实验证明了本文方法较有效,具有更高的分类精度。每类遥感目标都有各自的显著性特征,如果采用视觉注意模型,对遥感图像中代表一类场景的显著信息进行提取,并且去除冗余信息,分类精度应该会有更大的提高。

[1]张锦水,何春阳,潘耀忠,等.基于SVM的多源信息复合的高空间分辨率遥感数据分类研究[J].遥感学报.2006,10(1):49-57.

Zhang Jinshui,He Chunyang,Pan Yaozhong,et al.The high spatial resolution RS image classification based on SVM method with the multi-source data[J].Journal of Remote Sensing,2006,10(1):49-57.

[2]黎新亮,赵书河,芮一康,等.面向对象高分辨遥感影像分类研究[J].遥感信息,2007,6:58-61.

Li Xinliang,Zhao Shuhe,Rui Yikan,et al.Study on object-oriented approach to classification of high resolution remote sensed image[J].Remote Sensing Information,2007,6:58-61.

[3]Swain M J,Ballard D H.Color indexing[J].International Journal of Computer Vision,1991,7(1):11-32.

[4]Lee Tai Sing.Image representation using 2Dgabor wavelets[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1996,18(10):1-13.

[5]Yang Yi,Shawn N.Bag of visual words and spatial extensions for land-use classification[C]//ACM International Conference on Advances in Geographic In-formation Systems.New York,USA:[s.n.],2010:270-279.

[6]Li Feifei,Perona P.A Bayesian hierarchical model for learning natural scene categories[C]//IEEE International Conference on Computer Vision and Pattern Recognition.San Diego,CA,USA:[s.n.],2005:524-531.

[7]Lazebnik S,Schmid C,Ponce J.A maximum entropy framework for part-based texture and object recognition[C]//IEEE International Conference on Computer Vision and Pattern Recognition.Beijing,China:[s.n.],2005:832-838.

[8]Lowe D G.Distinctive image features from scale-invariant keypoints[J].International Journal of Computer Vision,2004,60(2):91-100.

[9]李晓明,郑链,胡占义.基于SIFT特征的遥感影像自动配准[J].遥感学报,2006,10(6):885-892.

Li Xiaoming,Zheng Lian,Hu Zhanyi.SIFT based automatic registration of remotely-sensed imagery[J].Journal of Remote Sensing,2006,10(6):885-892.

[10]王传旭,董晨晨.基于时空特征点的群体异常行为检测算法[J].数据采集与处理,2012,27(4):422-428.

Wang Chuanxu,Dong Chenchen.Abnormal crowded behavior detection algorithm based on spatial temporal interesting points[J].Journal of Data Acquisition and Processing,2012,27(4):422-428.

[11]Yang Yi,Shawn N.Spatial pyramid co-occurrence for image classification[C]//IEEE International Conference on Computer Vision.Barcelona,Spain:[s.n.],2011:1465-1472.

[12]Wu J,Rehg J M.Beyond the euclidean distance:Creating effective visual codebooks using the histogram intersection kernel[C]//IEEE International Conference on Computer Vision.Kyoto,Japan:[s.n.],2009:630-637.

[13]刘巍,贺广南,杨育彬.结构上下文:一种新的物体类别描述符[J].计算机科学与探索,2010,4(04):304-311.

Liu Wei,He Guangnan,Yang Yubing.Structural context:A new descriptor for object categorization[J].Journal of Frontiers of Computer Sci & Tech,2010,(04):304-311.

[14]杨丹,李博,赵红.鲁棒视觉词汇本的自适应构造与自然场景分类应用[J].电子与信息学报,2010,32(9):2139-2144.

Yang Dan,Li Bo,Zhao Hong.An adaptive algorithm for robust visual codebook generation and its natural scene categorization application[J].Journal of Electronics &Information Technology,2010,32(9):2139-2144.

[15]Li Shijin,Tao Jian,Wan Dingsheng,et al.Contentbased remote sensing image retrieval using co-training of multiple classifiers[J].Journal of Remote Sensing,2010,14(3):493-506.

[16]罗晓清,吴小俊,王士同,等.基于二次融合多特征的多聚焦图像融合[J].数据采集与处理,2010,25(4):430-436.

Luo Xiaoqing,Wu Xiaojun,Wang Shitong,et al.Multi-focus image fusion based on second fusion and multi-feature[J].Journal of Data Acquisition and Processing,2010,25(4):430-436.

[17]程娟,平西建,周冠玮.基于多特征和SVM的文本图像版面分类方法[J].数据采集与处理,2008,23(5):569-574.

Cheng Juan,Ping Xijian,Zhou Guanwei.Layout analysis based on multi-feature and SVM[J].Journal of Data Acquisition and Processing,2008,23(5):569-574.

[18]Chang C C,Lin C J.LIBSVM:A library for support vector machines[J].ACM Transactions on Intelligent Systems and Technology,2011,2:1-27.

[19]彭正林,毛先成,刘文毅,等.基于多分类器组合的遥感影像分类方法研究[J].国土资源遥感,2011,89(2):19-25.

Peng Zhenglin,Mao Xiancheng,Liu Wenyi,et al.Method for classification of remote sensing images based on multiple classifiers combination[J].Remote Sensing for Land & Resources,2011,89(2):19-25.

[20]孙灏,杜培军,赵卫常.基于多分类器组合的高分辨率遥感影像目标识别[J].地理与地理信息科学,2009,25(1):32-35.

Sun Hao,Du Peijun,Zhao Weichang.Target identification from high resolution remote sensing image based on multiple classifier combination[J].Geography and Geo-Information Science,2009,25(1):32-35.

[21]Foody G M.Thematic map comparison:Evaluating the statistical significance of differences in classification accuracy[J].Photogrammetric Engineering &Remote Sensing,2004,70(5):627-633.