大型数据中心机房基础设施的发展趋势

覃建国(中国移动通信集团设计院有限公司,北京 100080)

大型数据中心机房基础设施的发展趋势

覃建国

(中国移动通信集团设计院有限公司,北京 100080)

摘 要云计算、大数据的兴起和发展,带来了大型数据中心的建设热潮,数据中心机房基础设施的建设也发生了巨大的变化。本文阐述了国内外数据中心的发展趋势,总结了数据中心机房基础设施的发展特点。

关键词数据中心; 机房; 基础设施; 趋势

覃建国 1986年毕业于清华大学,高级工程师,现任中国移动通信集团设计院建筑所总工程师。自参加工作以来,主要从事通信建筑设计和研究工作。在近30年的工作中,作为总负责人完成了多项通信建筑标准化设计,主持编写了多项中国移动企业标准,完成了多项大型工程的咨询设计,多次获得省部级优秀工程设计奖。

1 引言

近年来,随着我国互联网、云计算和大数据产业的加速发展,数据中心机房基础设施进入了大规模的建设阶段。据报道,2014年中国数据中心总面积约为13 km2,预计到2020年,中国数据中心总面积将超过30 km2,各地谋划建设的数据中心众多,大型数据中心将成为主流。

数据中心机房基础设施是信息技术和电信网络赖以生存的基础,主要包括土建机房、空调系统、电源系统、智能化管理系统等。数据中心机房基础设施的建设技术上既要满足IT设备的相关需求,也要兼顾未来的技术发展趋势。满足绿色节能要求;具有高度的灵活性、适应性;高效率和易管理,全生命周期的造价最低已成为数据中心发展的共识。

2 数据中心机房基础设施的发展趋势

2.1可用性规划

数据中心机房基础设施的宏观规划核心是“可用性等级”和“单机架功耗”。根据GB50174—2008《电子信息系统机房设计规范》,机房可用性等级由高到低分为A级、B级、C级。越来越多的证据显示,新建的数据中心机房基础设施的可用性等级不再一味定位在高等

级上,这是因为灾备系统日益完善,通过在异地建立和维护备份存储系统,利用地理上的分离来保证系统和数据对灾难性事件的抵御能力;经过技术经济论证,在数据中心机房基础设施的可用性等级上片面追高是不划算的。一个典型的例子是eBay,eBay由原来所有数据中心Tier4级别转变为20%的Tier4和80%的Tier2,建设成本和运维成本减半,依然可满足业务发展所需。国内数据中心可用性等级的确定大多以B级为基本等级,20%~30%机房通过提高电源和空调的配置,可以达到A级,这种配置既可以满足客户对不同等级需求,同时又兼顾了数据中心的经济性。

随着IT设备的发展,计算机日趋小型化,电子元件的排列越来越密集,计算机散热量也越来越大。国外资料显示,近10年来,服务器功耗增加了15倍;机架的供电密度也提高了10倍。过去一个机架功耗为2~3 kW,现在往往高达20~30 kW。无论是数据中心运营商还是客户,单机架功耗越高,能够为他们提供的利润也就越大,主要原因是扩大了机架的可用空间,省去构建新的数据中心的费用。单机架功耗呈增加的趋势,已经是一个不争的事实,基础设施设计在空调、供电能力及冗余备份上应对此有足够的应对措施。

2.2数据中心选址

数据中心的选址一般主要考虑自然地理条件、资源状况、配套设施、周边环境。

对应空调系统来说,要降低PUE,主要的途径是利用自然冷源,如果没有利用自然冷源,通信机房PUE值很难低于1.5。根据气候分区的不同采用合理的免费制冷方案,通信机房制冷系统全年能耗通常能节约10%~50%,甚至有可能更高。数据中心是能耗、用电大户,要想降低能耗和运维费用,电价也是需要考虑的重要因素。表1为一个6 000机架单机功耗3 kW/架的数据中心,当不同电价、不同PUE值所对应的节电的费用。可以看出,当PUE=1.4时,0.5元/度的电价较0.75元/度的电价20年共节约电费为11.04亿元,数量是非常巨大的。

从以上数据不难看出,数据中心建设,选址在自然冷源丰富的高纬度地区、电价便宜地区对数据中心的能耗降低、提高数据中心的能源效率,降低运营成本具有举足轻重的作用。

表1 不同电价、不同PUE数据中心电费比较

2.3数据中心机房

2.3.1 灵活性

数据中心机楼的建设是基本建设,建设周期长,一般一个钢筋混凝土框架结构的2 km2的数据中心机房楼从开始建设到投入使用大约需要1.5~2年的时间,建成后改造起来难度很大。业主在开始建设数据中心时的条件,在市场需求、机电技术、目标客户等与建成后往往有很大不同。数据中心建设在强调保持可用性、高效安全地运营的同时;又要使数据中心具备灵活的应变能力,以应对多变的业务需求及未来的不确定因素。为了解决上述问题,目前数据中心机房楼普遍采用标准化设计,数据中心园区采取统一规划、分布实施的策略。

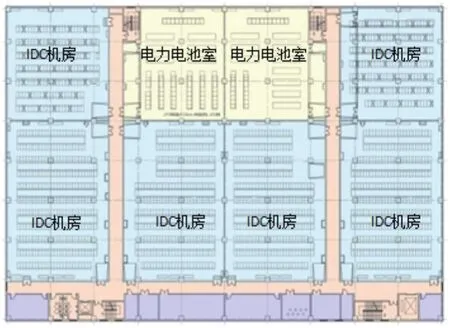

标准化数据中心机房楼一般采用整体设计理念,空调采用能效比高的大中型容量冷水机组,充分利用自然冷源;电源采用高压直流和市电直供系统;选择价格适宜的建筑材料;选用成熟的结构形式,设备选型考虑厂家较多的区段,降低采购成本。图1为某数据中心机房标准层平面。

图1 某数据中心机房标准层平面

标准化方案布局紧凑、合理,装机效率高。采用标准化方案能够减少建造时间,方便维护管理,提高装机率,使机房楼的成本控制在合理的范围内。

数据中心园区建设采用统一规划,分步实施的策

略,这是一种边成长边投资的策略,这种策略降低了资金一次性投入的压力,减少了固定资产折旧造成的损失,最大程度规避市场起伏造成的风险。图2为某数据中心分期总平面图。

图2 某数据中心分期总平面图

大多数数据中心园区都采用分期建设的方式,整个园区分成2~3期进行建设,每期建设2~4栋机房楼,分期时应注意每期地块与总体规划的关系,每期地块能自成系统,配套齐全,可以独立运行,同时注意减少后期建设对前期已建成设施的不利影响。

2.3.2 数据中心机房的柱网、层高、荷载

机房的整体设计考虑不同使用性质的房间组合,满足IT设备、机电设备、空调管路、电缆桥架等管线路由对建筑空间的要求,符合IT工艺、配套设施对各类空间组织的要求,尽量增加可装机面积。建筑的柱网、层高、楼板的承重等均需经过精心核算,既要满足现有设备的使用要求,同时保留一定的富余量,为未来设备的使用留出改造空间。

机房柱网尺寸以8.4 m×7.2 m,8.4 m×8.4 m为主,同时有向更大尺寸发展的趋势,如6 m×12 m,通过加大柱网,可优化机架排列,减少柱子对机房内设备的影响,柱子不占机位,增加装机数量。机房的楼面荷载具有通用性,各类房间布局不再受楼面核载的牵制,使机房后续改造更加灵活。目前已经出现了楼面荷载全部按照16 kN/m2设计的机房楼。机房的层高是架空地板高度、工艺安装净高、上部回风空间、气体灭火管线高度、建筑构件高度之和,目前取值在4.6~5.4 m之间。随着微模块等模块化设计的广泛使用,数据机房的层高还有加高的趋势。

微模块机房也是发展趋势之一,微模块机房是集机柜、供配电、制冷、安防与消防、布线为一体的独立的数据中心运行单元,可工厂预制,快速组装,能够实现数据中心的快速部署、扩容及标准化建设。微模块机房对局房的土建要求较为简单。微模块安装尽量避免柱子的影响,减少因柱网带来的现场改造以及非标定制,放置微模块的柱网间距要求至少是9 m以上。

2.4空调系统

2005年前互联网企业的IT机房多采用风冷精密空

调,2005~2009年由于风冷精密空调固有的缺点,逐渐被可以大幅降低运行能耗的冷冻水系统取代。2010年以来,节能已成为数据中心的重要发展方向,自然冷却技术由于应用范围广、高效节能、环境污染小、运行稳定可靠以及运行费用低而逐渐被应用到数据中心空调系统中。自然冷却分为水侧自然冷却和风侧自然冷却,国内通常采用水侧自然冷却。水侧自然冷却系统应用在大型数据中心项目中的节能效果显著,已经成为数据中心的主流空调系统。

在冷源侧系统不断演进发展的同时,空调末端形式也在迅速演进。在冷冻水型精密空调的基础上,各厂商提出的空调末端解决方案通常可以分为行级空调和机柜级空调两种形式,行级空调通常是列间空调和顶置式空调,常常与封闭冷通道或热通道配合实施,该种空调末端送风距离短,利于预制化;机柜级空调通常有水冷冷门或热管背板等,直接对机柜进行冷却,空调送风距离更短,节能性更好。

与水侧自然冷却系统相比,自然新风冷却系统减少了能量转换和传递环节,节能效果更加直接和显著。目前在美国、欧洲等地区均建设有直接风侧自然冷却数据中心,完全不设置机械制冷设备,PUE可实现接近1.07。从趋势上讲,自然新风冷却也是国内数据中心发展的一个选择。风侧自然冷却依赖于高温耐腐蚀服务器的发展和应用,同时要注意自然新风冷却的环境要求;建筑方案上要配合全新风制冷特点设计建筑的剖面和平面。

利用数据中心余热向办公、生活用房提供采暖和生活热水,也是一种新型的免费制冷方式。设置集中冷冻水空调系统的数据中心,根据数据中心所在区域的热源状况、供热需求,设置机房余热回收装置,利用机房余热向办公、生活用房提供采暖和生活热水,可提高能源的综合利用率。

数据中心的发展趋势决定了制冷空调系统的发展方向。优化空调系统参数,最大程度利用自然冷源,合理优化气流组织,灵活可扩展的模块化冷却系统、高密度制冷等技术势必会成为数据中心空调发展的趋势。图3为国际著名数据中心PUE值。

图3 国际著名数据中心PUE值

2.5电源系统

随着通信网络及电源技术的发展,打造低成本、低能耗的供电系统是通信电源系统的发展趋势。从节能角度及通信设备发展现状,数据中心供电系统将向着简单化、高效化发展。

高压外市电引入电源主要有10 kV、35 kV、110 kV 3种电压等级。采用更高的电压等级引入,具有减少线路损耗、降低电缆投资及施工难度、节省有色金属用量、合理供电距离长等特点。大型数据中心一般以引入110 kV市电并自建110 kV/10 kV变电站为主,个别项目电源引入方案为多路35 kV或10 kV市电。

发电机组一般有高压发电机组和低压发电机组,电压等级的选择要结合供电系统的结构、油机房布局、用电设备电压等级、供电系统容量设置等因素综合考虑。10kV高压发电机组具有以下特点:发电机组可集中设置,远离负荷中心,适合长距离传输电能;可多台并机,根据负荷大小自动投入适当的机组数量,避免大功率机组小负荷运行,实现错峰控制,减少燃油、机油浪费;并机系统容量大,可承受较大负荷变化的冲击;降低线路损耗、减小电缆截面、降低电缆投资及施工难度;能有效抑制非线性负载启动时产生的谐波对发电组的影响,提高发电机组的效率;与0.4 kV发电机组价格接近。

大型数据中心的发电机组一般均选用10 kV高压发电机组,多台并联运行供电。

336V高压直流电源是中国移动提出的面向未来的供电模式。336 V直流电源是一种集中了UPS供电系统和-48 V直流供电系统的优点为一体的新型供电系统,具有电路简单、可靠性高、效率高、易于扩容等优点。336 V直流/市电混供技术是ICT设备由两路电源供电,一路为336 V直流电源,另一路为交流220 V市电,两路电源互为备用。当市电电源满足要求时主要由市电供电,当市电电源出现故障或电源质量不满足要求时,由336 V直流电源供电,由此最大限度的降低电源系统损耗。48 V开关电源高效率整流模块与普效整流模块相比,采用了创新的高能效技术、全新的高效拓扑结构、低压降的功率器件以及更低阻抗更低能耗的材料,效率可达95%以上,并且,高效率整流模块可以在较宽负载率下均具有较高的效率点,也能够获得较好的节能效果。采用高效整流模块所节省的电量可在2~3年内收回高出的成本。相对工频UPS, 高频UPS具有体积小、 重量轻、输入输出功率因素高、输入谐波分量小、效率高等特点。经过近几年的发展,高频UPS的大部分技术指标已经超过了工频UPS。图4为市电直供或混供方案示意图。

图4 市电直供或混供方案示意图

目前,主流UPS生产厂商均生产全系列高频UPS,高频UPS正逐步取代工频UPS。大型数据中心内的通信电源系统建设趋势正朝着推动相关设备集采,推广336V高压直流系统、48V高效整流模块、高频UPS设备的应用方向演进。

大型数据中心内市电油机一般采用自动切换方式,电源系统电池后备时间15 min,满足主用电源和备用电源切换要求;对于散热量高的机房配置UPS供电保障的蓄冷设备。满足市电停电后油机启动前,机房不停电、不过温的要求。电池方面还要关注2 V/12 V的高功率铅酸蓄电池的设备采购和应用,提升设备性能,减少资金投入。

磷酸铁锂电池相比普通铅酸电池具有重量轻、体积小、大电流充放电、循环寿命好等优点。目前磷酸铁锂电池产品形式多样,电芯有卷绕、叠片两种类型,壳体封装形式主要有金属壳、铝塑膜软包装、塑料壳三种形式,单体容量从几安时至几百安时不等。从国际市场来看,国外通信运营商锂电池使用较少。锂电池技术目前仍在快速发展之中,从最近几年测试情况来看,磷酸铁锂电池的一致性、低温性能和高温性能在持续的改进之中,大型数据中心应持续关注该产品的试用情况和成熟度。

2.6智能化管理

目前我国数据中心建设数量多,规模大,但是数据中心的使用效率还有待提高。数据中心使用效率不高的重要原因之一是机房基础设施的管理出现了各自为政,操作离散化、能耗加剧化的现象。如何打破管理孤岛,发挥综合管理的集成效应和倍增效应,提高数据中心的

节能能力,为管理人员提供一个高效易用、智能化管理系统成为迫切需要解决的问题。

数据中心基础设施管理系统(DCIM)的兴起,是为了解决关键动力设备和基础设施一体化管理,实现数据中心机房基础设施动态优化。DCIM的手段是通过一整套硬件设施、从所有系统收集数据,实现机房基础设施的容量规划、集中监控、准确处置、智能管理、预测模型、成本控制等管理目标。

DCIM系统通过数据中心各类监控系统及被监控设备提供的接口,实现统一机房监控报警策略及报警等级,通过短信平台统一报警或将报警信息发送至监控平台;通过机柜内部加装传感器,实现对机柜级温湿度监控,实现机房温湿度环境精细化管理,并生成实时机房内温湿度云图;同时依靠机柜电力监控数据,结合机柜内温湿度检测提供运维数据支持。

依托2D/3D可视化管理平台,DCIM系统可以对数据中心所在园区、楼层及机房进行全元素三维展示,还可根据机房CAD图纸等文件导入或制作生成机房图纸,并按照电力、空调系统绘制动态监控视图;结合设备管理的定位功能及机房图纸布局,按照实际安装位置显示每台机柜内设备,并可显示该设备详细信息及连线信息;同时通过精准识别定位的硬件设备,实现对机房内设备进行管理,解决传统手工运维与信息盘点的效率低下问题。

DCIM系统将数据中心各项基础设施资源量化处理,可按照空间、冷量、电力、承重等多种条件筛选,快速定位可用区域及设备;通过持续记录资源消耗量及分析增长模式,使数据中心管理人员能够更加准确地预测哪种资源将被耗尽,能够更为高效地管理各项关键资源。维护人员远程接入DCIM云服务平台,实施各种运维操作,采用远程巡检的方式,可在短期内对多地数据中心完成巡检工作,以提高效率,减小维护成本。

3 结束语

随着信息化的持续发展,数据中心已经逐渐成为一个专门的建筑类别,大型数据中心的建设在全球各地都是一个崭新的课题。把握数据中心基础设施的发展趋势,建设绿色数据中心机电系统,必须从实际需求出发、认真细致地进行规划设计、把握好安全可靠性、重视节能环保、维护管理方便、降低建设成本。

参考文献

[1] 孙景毅,吴辰,于艳芳. 数据中心布局研究[J]. 通信电源技术, 2014(1).

Development trend of large data center infrastructure

QIN Jian-guo

(China Mobile Group Design Institute Co., Ltd., Beijing 100080, China)

AbstractThe rising and accelerated development of cloud computing and big data have brought the construction upsurge of large-scaledata centre, while the construction of basic facilities of data centre rooms has changed a lot. The paper expounds the development tendency of data centre at home and abroad, and summarizes the development characteristics of basic facilities of data centre rooms.

Keywordstrend; data center; equipment; room; infrastructure

收稿日期:2015-10-26

中图分类号TN915

文献标识码A

文章编号1008-5599(2015)11-0001-06