融合抽象层级变换和卷积神经网络的手绘图像检索方法

刘玉杰, 庞芸萍, 李宗民*, 李 华

(1. 中国石油大学 计算机与通信工程学院, 山东 青岛 266580;2. 中国科学院计算技术研究所 智能信息处理重点实验室, 北京 100190)

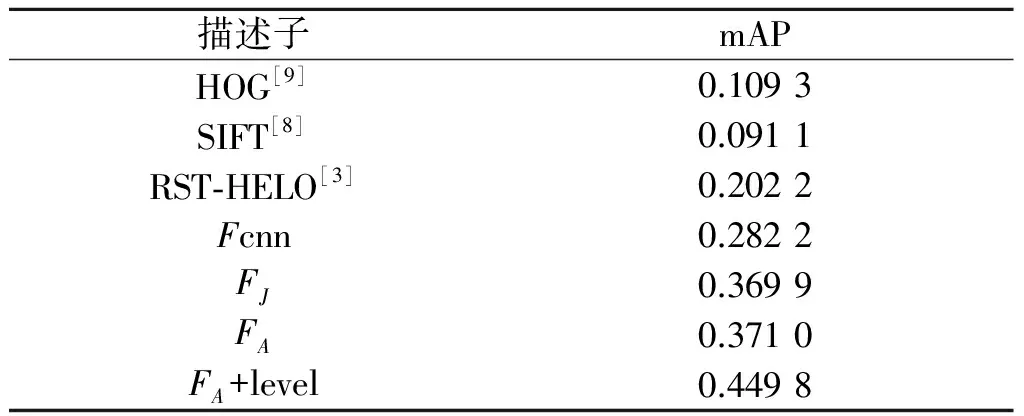

表1 各描述子的mAP值对比表

融合抽象层级变换和卷积神经网络的手绘图像检索方法

刘玉杰1, 庞芸萍1, 李宗民1*, 李 华2

(1. 中国石油大学 计算机与通信工程学院, 山东 青岛 266580;2. 中国科学院计算技术研究所 智能信息处理重点实验室, 北京 100190)

针对人工设计的描述子(HOG、SIFT等)在基于手绘的图像检索(Sketch Based Image Retrieval,SBIR)领域的局限性,提出了一种融合抽象层级变换和卷积神经网络构建联合深度特征描述子的手绘图像检索方法.首先,提取常规图像的边缘概率图,在此基础上进行不同抽象层级的图像变换,将抽象层级变换图像输入到深度神经网络并提取不同隐层的输出向量,最后,联合不同隐层的输出向量作为手绘图像检索的特征描述子(即联合深度特征描述子).在Flickr15k数据库上对本方法进行了实验验证,结果表明:融合抽象层级变换和联合深度特征描述子的检索效果相较HOG、SIFT等传统方法有显著提高.本方法从图像预处理和特征描述子构建2个方面,对SBIR问题进行了改进,具有更高的准确率.

手绘检索;卷积神经网络;边缘概率检测;抽象层级变换;联合深度特征

1 相关工作

如何在海量的图像数据库中实现快速有效的信息检索是机器视觉领域的研究热点之一.早期的学者提出了基于文本的图像检索方式,需要对图像数据库进行人工标注,由于受标注者的主观影响,人工标注的有效性有待考究.大数据时代,图像资源呈指数级增长,人工标注耗费巨大.20世纪90年代,学者提出了基于内容的图像检索(Content Based Image Retrieval,CBIR)方法,通过提取图像底层特征标注图像,以此取代人工标注,CBIR在检索过程中对输入的图像要求比较严格,而人们通常是因为找不到合适的图才选择CBIR去搜索图像,所以CBIR默认输入图像满足合适的属性要求此假设前提有点牵强,这一限制也在一定程度上阻碍了CBIR技术的发展.手绘是人的本能之一,亦是一种特殊形式的“文字”,人类文明诞生时的甲骨文、楔形文字等都是某种形式的“手绘图”,其本身融合了文本和图像内容两方面的优势.手绘既能避免文字的难以描述性又能克服图像内容的难以获取性,所以以手绘为输入进行图像检索的技术(Sketch Based Image Retrieval,SBIR)有很高的研究价值和广阔的应用前景[1-3].近几年,SBIR技术广泛应用于各个领域,例如:在网购过程中,通过手绘印象中的商品并进行检索;检索形状比较明显但难以用语言描述的建筑;检索某种特定的舞蹈动作等.

SBIR技术发展至今仍面临很多难题:手绘图像与常规图像在底层像素表示和高层视觉感知上有很大差异.待检索的常规图像比输入的手绘图像包含更多有用的细节信息以及干扰的噪音信息(颜色、纹理等),也就是说,手绘图像与常规图像分别隶属于不同的图像域,这种域差异直接削弱了SIFT、HOG等基于底层图像特征设计的描述子的有效性.ZHONG等[4]提出了一种域自适应的跨域字典学习方法,通过重构源域与目标域字典的方式,实现图像的跨域表示.本文消除图像域差异的方法是将常规图像转换为“类手绘”图像(边缘图、轮廓图等).

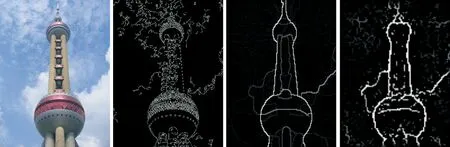

Canny边缘检测是将常规图像转换为边缘图最常用的方法之一,其处理结果往往包含很多噪音信息,例如噪点、短线等(见图1).LIM等[5]提出了一种“Sketch Token”(简称ST)边缘检测模型,该方法将人工标记的边缘图像以边缘像素点为中心截取固定大小(35×35)的图像块,并对这些图像块分别提取Daisy描述子,利用K-means将Daisy描述子进行聚类,得到K个“Token”类别,在每个边缘图像块对应的原图像块上提取通道特征和自相似特征,利用随机森林分类器建立这2种特征与“Token”类别之间的概率模型,如图1所示,ST边缘模型的检测结果比较突出图像的主要边缘,而由于“Token”类别的限制,ST概率模型生成的边缘图与实际边缘不能完全吻合.MARTIN等[6]提出了一种伯克利边缘检测算法,其输出结果与人工标记的边缘图有较强的一致性.该算法首先将图像转换为强度空间与Lab空间表示,提取图像的强度、颜色、纹理特征,将这些特征融合输入到分类器中训练边缘隶属度.伯克利边缘检测算法用到5种分类器,分别是密度估计、分类树、逻辑回归、分层的多专家决策以及支持向量机分类器,通过设定合理的阈值范围可获得比较平滑的边缘图像.

图1 不同边缘检测算法的效果图Fig.1 Different edge detection methods

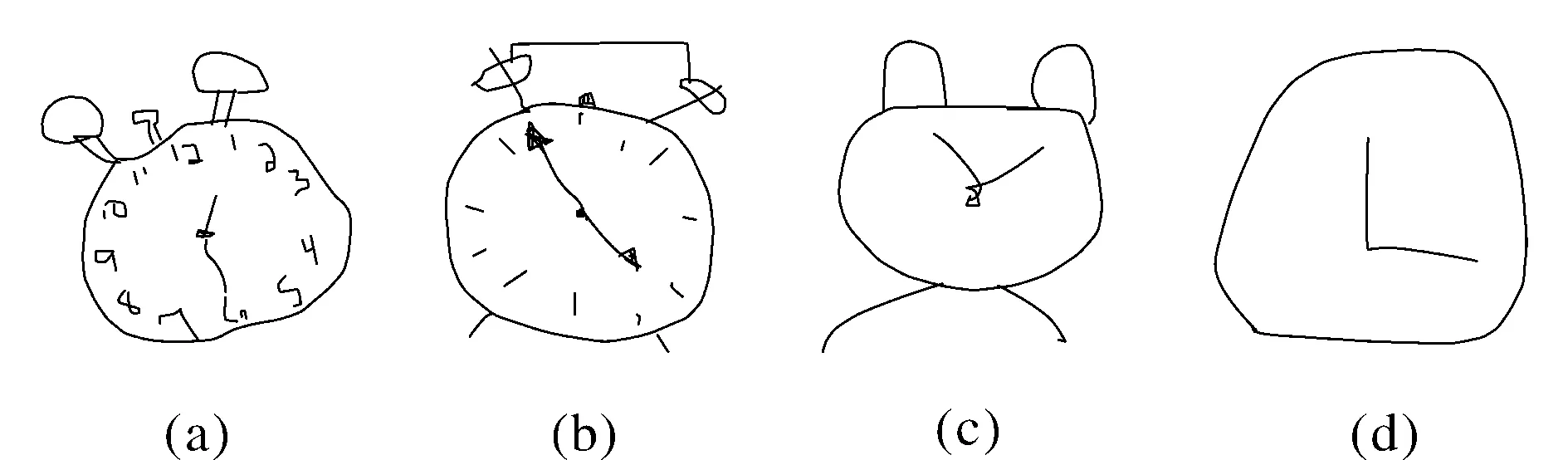

手绘图像本身存在固有的歧义性,如图2所示,一幅圆形的手绘图像可以表示多种不同的事物:既可以表示太阳,也可以表示一轮满月或者一个圆形碟子等,另外,同一事物经由不同的人进行手绘后表达的结果不同.不同人的手绘能力也有很大的差异.从图3可以看出,同样是闹钟,有的人描绘得很粗略(见图3(d),闹钟外轮廓和指针),有的人描绘得很详细(见图3(a)闹钟的外轮廓、指针、刻度、按钮等),即使对指针这一具体细节的表达方式也有差异(见图3(b)与(c)).由此可见,手绘图像本身就存在很大的抽象层次差异;YU等[7]在手绘图像的分类工作中,通过先下采样再上采样的方式将训练数据进行5个等级的高斯模糊处理来抑制同类手绘图像之间的抽象层次差异.

图2 手绘图像固有的歧义性Fig.2 The ambiguity of the sketch

图3 手绘图像的抽象层次差异Fig.3 The different abstractness levels among sketches of one object同一事物的手绘图“繁简”程度有差异,对应不同的抽象层次.The same object can be expressed with different abstractness levels. Some users prefer to draw object details but others do not.

寻找描述力强的描述子来表示图像是SBIR需要解决的核心问题.手绘图像和边缘图像的共同特点是:图像信息主要集中于图像边缘像素部分.所以SBIR的研究方法主要偏向于构建描述边缘、梯度、方向的特征描述子,例如SIFT[8]、HOG[9]、EHD[10]等.2010年EITZ等[11]提出了基于多种局部特征建立词包模型的SBIR检索方法,该方法在HOG、SHOG、Shape Context[12]等局部描述子的基础上建立词包模型进行检索.融合生成的词包具有更强的描述力,但是也增加了计算复杂度.HU等[2,13]提出了基于方向区域描述子的手绘图像检索技术,并于2013年在该工作的基础上进行改进,提出了基于GF-HOG特征的SBIR检索算法,同时公开了一组评价SBIR实验效果的数据集Flickr15K[14].LIM等[5]将ST边缘提取方法与局部边缘方向直方图描述子相结合,提出了基于RST-SHELO的手绘图像检索方法,但是该方法在Flickr15K数据集上检索的mAP(mean Average Precision)也只能达到0.2.

以往方法精度较低的原因有以下几点:一是Flickr15K数据库是自然场景类的数据库,在形状特征上比较复杂;二是特征的表达力度不够.传统的三维模型检索方法[15]需要针对模型特点人工设计特征,这类方法大多不够鲁棒.基于深度学习[16-19]的特征学习方法最近备受关注,在学术界与工业界都掀起了研究热潮.与传统的依据人工构建规则生成特征的方法相比,深度学习利用大量的数据学习特征,能够表达更丰富的图像内在信息,这一优势使其在二维图像及三维模型[19]特征学习领域得到了广泛应用.2015年YU等[7]针对手绘图像分类问题提出了一种多尺度多通道的深度神经网络框架,通过扩大首层卷积核及重叠池化的方式获取更多的空间结构信息,该方法在手绘分类问题上的精度达到了74.9%,首次超过了人的识别精度(73.1%)[14].该方法将一幅手绘图分解组合出6种通道,并将每种通道的手绘输入转化为5种尺度,一幅图像在训练过程中需要经过30次网络框架,训练效率较低.另外,目前最大的手绘分类库为20 000幅,这个数量级在训练网络上是远远不够的,即使通过简单的平移、旋转来扩充数据库,与ImageNet的1 300万仍相去甚远,训练数据的不足直接影响网络框架的精度.

2 基于抽象层级变换和卷积神经网络的SBIR方法

针对手绘图像的抽象层次差异性和手绘图与常规图的域差异问题,提出了一种新的SBIR方法,即基于抽象层级变换和卷积神经网络的手绘图像检索方法.常规图像的处理步骤如下:

Step1 计算常规边缘概率图.为了使边缘概率图与手绘图像的抽象层次相对应,本方法将一幅边缘概率图按阈值划分为3个等级的二值边缘图.

Step2 将所得的二值边缘图输入到深度神经网络中并提取不同隐层的输出向量,联合不同隐层的输出向量构建二值边缘图的特征描述子(即:联合深度特征描述子),这样一幅常规图像最终由3个联合深度特征描述子表示,分别对应常规图像的一个抽象层级.

对于手绘输入图像,只需要提取一个联合深度特征描述子即可,在手绘图像与常规图像的相似度匹配计算过程中,本文将手绘图描述子及与其最相近的一个常规图描述子之间的距离,定义为二者之间的相似性度量值.为了有效地评价本文的工作,在Flickr15K数据集[11,13]和Eitz[11]数据集上对本文方法进行验证并与其他方法比较.

2.1 抽象层级变换

为了实现常规图与手绘图在图像域上的统一,本文方法基于文献[6]人工标注的边缘图数据集,利用监督学习的方式训练边缘概率检测器,具体实现方法如下:

Step1 计算通道梯度.将常规图像转换到RGB空间、强度空间及Lab空间以保证获取足够多的图像信息.分别提取常规图像像素点的强度、颜色、局部纹理的通道梯度G(x,y,θ),通道梯度值由以边缘像素点为圆心的采样区域的属性决定,计算步骤如下:

(a)将图像按角度θ(本文方法选取0°,45°,90°,135° 4个角度)划分4个方向梯度,以边缘像素点(x,y)为圆心,以θ为直径方向,图像对角线的1/10长度为直径作圆,由此可得以该直径为分界线的2个半圆s1和s2;

(b)分别提取半圆s1和s2内的强度、颜色、局部纹理3个直方图,(x,y)点的通道梯度G(x,y,θ)定义为2个半圆直方图h1和h2之间的χ2距离:

(1)

Step2 训练逻辑回归模型的分类器.根据数据集中人工标注的ground truth定义正负样本,其中正样本为ground truth中的边缘点,负样本为ground truth中的背景点.以正负样本的通道梯度为输入训练逻辑回归模型的分类器.

分类器的输出表示像素点隶属于边缘的概率,在此将其定义为边缘隶属度.与Canny等底层数据驱动方法相比,直接以人工标注的ground truth为训练标签充分利用人工手绘图像的主观性,排除了底层干扰信息的影响.边缘隶属度概率图融合了图像的局部纹理、强度、颜色的分布信息,返回的是像素隶属边缘的概率,这种处理方式更符合人的习惯,从图1也可看出,其结果比Canny边缘检测结果更平滑更合理.

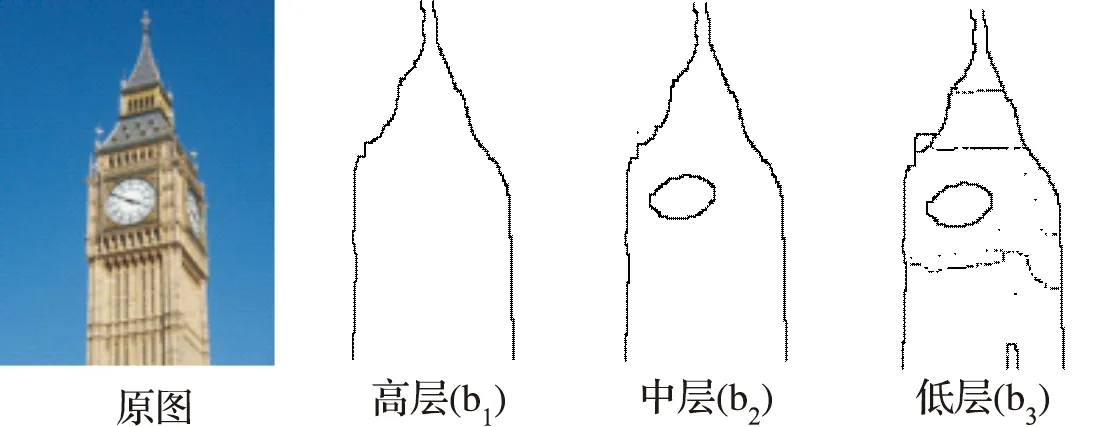

Step3 划分抽象层次,并生成对应的二值边缘图.为了使常规图与手绘图在图像域上达到最大一致性,需要将一幅常规图像的边缘概率图转换为3个不同抽象层级的二值边缘图.本文对常规图库的边缘概率图进行随机采样,将所采集样本中的非零概率聚类生成3个阈值中心t1,t2和t3,以此3个阈值中心的值为标准对边缘概率图进行二值化,得到3个二值边缘图b1,b2和b3.

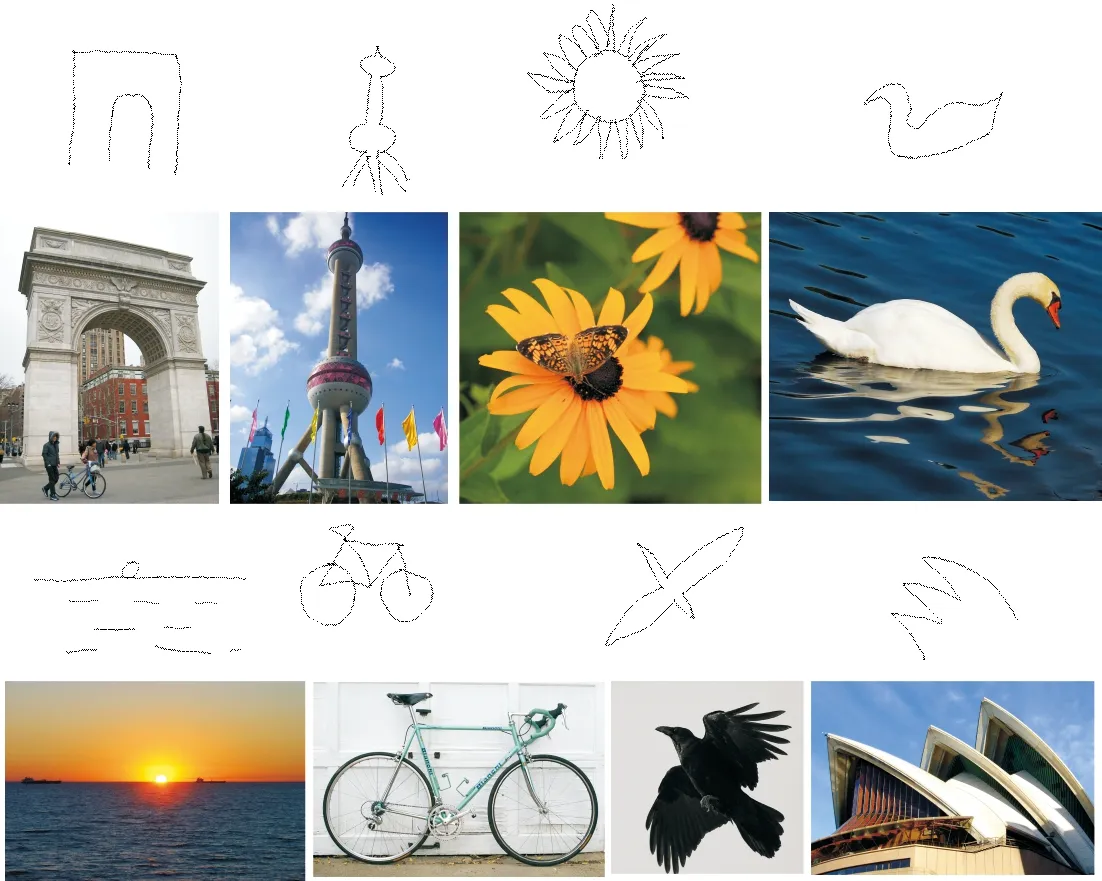

图4 Flickr15K数据库采样示例Fig.4 Samples of hand-drawn sketches and the natural images in Flickr15K第1、3行为手绘图像采样示例,第2、4行为对应的常规图像示例.The 1st and 3rd rows show samples of sketches, and the 2nd and 4th rows show samples of natural images.

如图5所示,高层抽象的二值边缘图b1保留了图像的外围轮廓及比较明显的边缘信息,中层抽象的二值图像b2在高层的基础上增加了更具体的细节信息,而低层抽象的二值图像b3具有更丰富的细节信息,与之对应的是手绘图中的不同抽象层级(见图3).

图5 3个抽象层次的二值边缘图Fig.5 The binary edge maps of 3 abstractness levels

2.2 特征提取

通过边缘概率检测和抽象层级变换这2个步骤的预处理,常规图像被转换为与手绘图像同域的边缘图像,且一幅常规图像对应的3个抽象层级的二值边缘图恰好与手绘输入的抽象层级相对应.接下来就是提取适于SBIR的、描述力强的特征.上文提到,传统的人工设计的特征在手绘图上具有冗余、不鲁棒、仿射不变性差等特点,为了充分利用深度学习框架在图像识别领域的优势,本文采用典型的深度神经网络框架“Alex Net”[15]来提取图像的描述子,“Alex Net”是在ILSVRC 2012 Image Net数据集上训练得到的网络,该数据集共包括1 300万的数据.由Caffe提供的“Alex Net”网络的top-1误差率达到了42.6%,是比较可靠的卷积神经网络之一.

利用深度神经网络提取特征并检索的方法,包括以下主要模块:

(1)以预训练好的“AlexNet”网络模型的参数初始化网络并用手绘数据库进行微调;

(2)建立手绘图像检索所需的特征库;

(3)提取输入的手绘图像的深度特征并进行图像检索.

步骤(1)中,为了使深度神经网络的各项参数更适合于本文的手绘图像,对其进行了微调.以在ILSVRC 2012 Image Net数据集上训练得到的网络的各层参数为初始化值,随机选取TU-Berlin手绘数据库中的100类对已有的网络进行训练,实现微调参数的效果,本方法随机选取100类每类包含80幅图像,共8 000幅.利用手绘图微调令现有的网络达到适应手绘图像域的最佳状态,同时又降低了重新训练网络的开销.得到微调好的网络之后,就是利用该网络提取手绘图像的特征描述子,以构建检索特征库.特征描述子通常是一维向量,可以理解为图像的编码表示.之前有研究者认为,卷积神经网络中的各层输出实际上是对图像的一种特殊的编码表示,且随着网络层数的增加,网络各隐层的输出特征越抽象则越具有代表性,可以作为图像的特征描述子.本文方法将数据库中每幅常规图像对应的3个二值边缘图分别输入到微调好的网络中,提取网络6层、7层的输出向量(记为F6和F7).F6和F7分别是网络的2层全连接层的输出向量,如何充分利用这2个特征向量合理表示图像至关重要,本文采用直接联接和平均联合2种联合方式,分别得到了直接联接深度描述子(FJ)和平均联合深度描述子(FA),联合后的向量作为图像的特征描述子构建检索特征库.定义F6为(x1,x2,…,xn),F7为(y1,y2,…,yn),那么FJ和FA的表达式为

FJ=(x1,x2,…,xn,y1,y2,…,yn),

(2)

(3)

2.3 相似性度量

对于手绘输入,本文直接提取其联合深度特征描述子.对常规图像分2种情况,对于单阈值二值边缘图,直接计算二值边缘图的特征描述子与手绘输入图的特征描述子之间的欧氏距离,作为相似性度量依据.对于基于抽象层级变换的三阈值二值边缘图,相似性距离度量

d=min(Ed(Fq,Fe(i))),

(4)

其中,Ed表示求两向量之间的欧氏距离.Fq表示手绘输入的联合描述子F.Fe(i)表示常规图像第i个抽象层次图的联合描述子F.F可取FJ和FA2种形式,其中,d越小表明两幅图像越相似.

3 实 验

3.1 数据集和评价标准

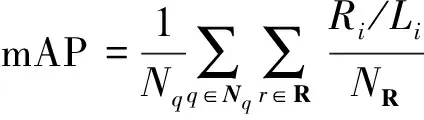

在Flickr15K数据集上进行了评估实验,Flickr15K数据集中的常规图像数据包含60类共14 660幅,手绘图像包含33类,共330幅.Flick15K的部分采样图像如图4所示.由于该数据集属于自然风景类图像,在形状特征上比常规的室内规则物体(例如,桌椅、杯具等)采集的图像更加复杂,所以该数据集对特征的检验更困难.评价过程中采用图像检索、分类、识别领域常用的基本指标:PR曲线(Precision-Recall graphic)和mAP(mean Average Precision).其中,

(5)

式中,q为手绘输入图像集,Nq为图像集的数量,Ri为数据库列表中正样本的排名编号,Li为检索列表中正样本的排名编号,NR为正样本的数量.具体的实验评价及细节分析参见3.2.

3.2 实验评价

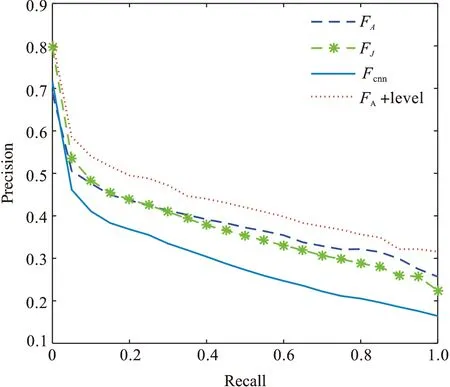

在Windows下用Caffe框架实现微调,利用Caffe的MATLAB接口实现特征的提取和后续的检索.为验证本文方法的有效性,从常规图像边缘检测和特征提取2个方面在Flickr15K数据库上进行了一系列的对比实验.其中,在边缘检测方法上,对比了单阈值的边缘图与3层阈值的边缘图检测方法;在特征提取方面,将本文所用网络中涉及的全连接层描述子Fcnn、直接联接深度描述子FJ及平均联合深度描述子FA与几种传统经典的描述子进行了对比.

图6 不同方法的PR曲线对比图Fig.6 PR curves of three features with different strategies其中,FA为未划分抽象层下的平均联合深度描述子的检索曲线,Fcnn为未划分抽象层下的全连接层描述子的检索曲线,FJ为未划分抽象层下的直接联接深度描述子的检索曲线,FA+level为划分抽象层下的平均联合深度描述子的检索曲线.FA is fusion of averaging two fully connected vectors. Fcnn in the plot means the first fully connected feature vector. FJ is fusion of two fully connected vectors by connecting directly. FA+level in the plot means the combination of leveled abstractness and FA features.

3.2.1 抽象层次变换对手绘检测的影响

在构建检索特征库的过程中,每幅常规图像对应3个抽象层级的特征描述子,本文对抽象层级变换的有效性进行了证明,实验结果如图6所示,可以看出,抽象层级变换后的检索PR曲线(FA+level)高于普通二值化的边缘变换后的检索曲线(FA).这一结果也进一步证明了在不限制用户对手绘输入要求的前提下,手绘图像的抽象属性具有层次性的特点.本文方法并没有对带有抽象层次差异的手绘图像做特别处理,而是对数据库中的常规图像进行层次划分,使其保持与手绘输入的一致性.

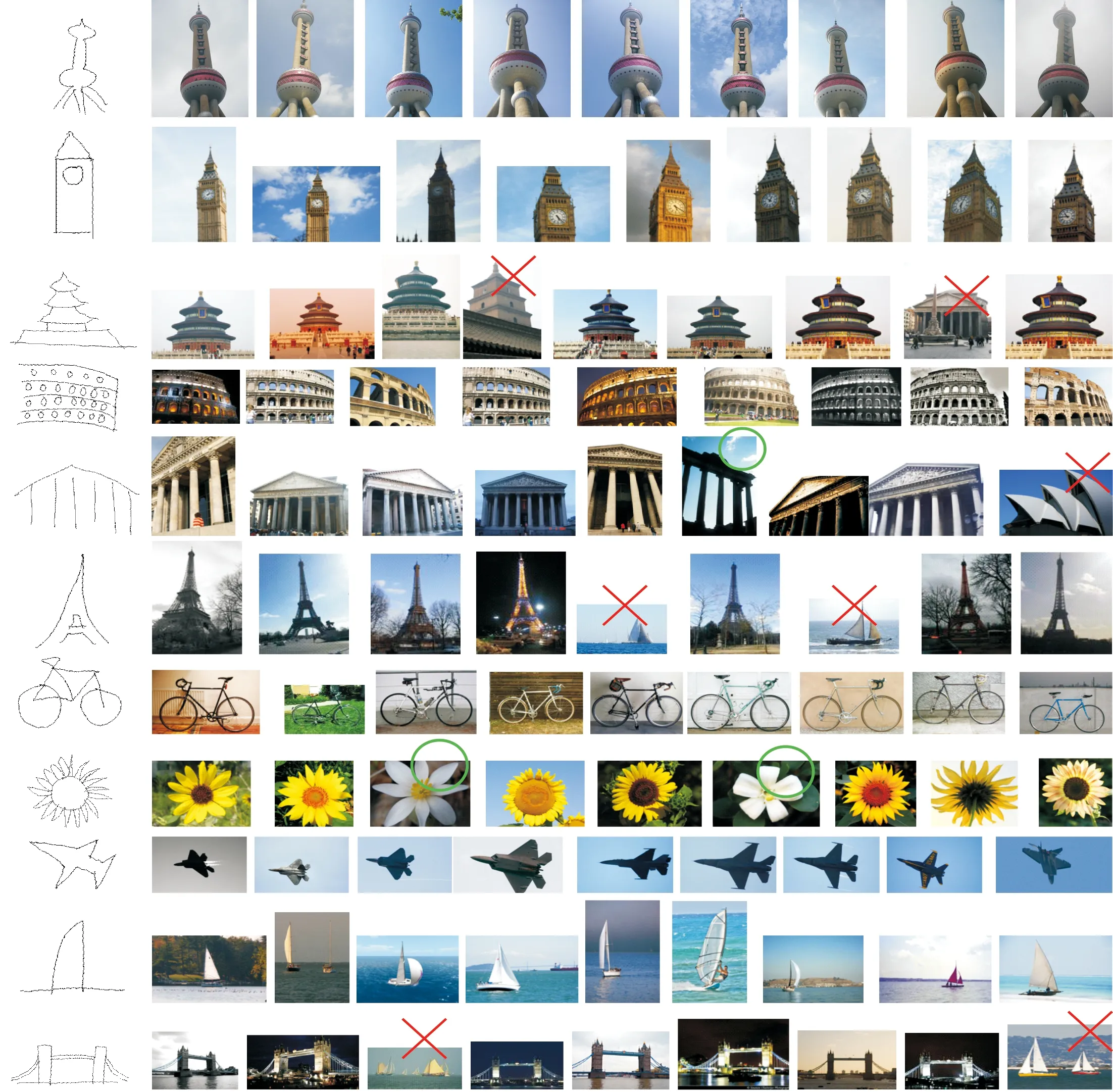

图7 图像检索结果Fig.7 The example results of our approach第1列为手绘输入图像,第2~10列为按相似性得分排列的检索结果;图中×代表检索结果,圆圈代表在形状上很相似但检索错误的检索结果.The first column is the sketch query and the fellow second to tenth columns are the retrieval results of our approach. The×marks indicated the wrong results, and the circle marks indicated the wrong results with similar shapes.

3.2.2 特征评价

以特征向量之间的欧氏距离作为相似性度量方式,并将所用网络中涉及的全连接层描述子Fcnn、直接联接深度描述子FJ及平均联合深度描述子FA与HOG[9]、SIFT[8]、RST-HELO[3]3种传统的人工设计的特征进行了对比,其中HOG、SIFT在Flickr15K数据集上的表达力较弱,其mAP值均小于0.1,在这几种常见的传统描述子中,RST-HELO的效果相对较好,但其mAP值也只能达到0.200 2.从表1中可以看出,Fcnn在SBIR问题上的表现优于传统的图像描述子.而FJ及FA融合了深度神经网络的两层特征输出,二者的表达效果均优于其他,且平均联合方式的FA的表达力最高.图7展示了本文方法在SBIR检索的top-9返回结果.从图7可以看出,本文方法在top-9的精度比较高,尤其是对于一些形状特征比较简单明了的图像,检索top-9精度几乎可以达到100%(图7中的第1、2行),另外,对于一些结构比较复杂但形状特性明显的图像也有很好的检索精度(如图7第5行).但是本文方法也有部分误检的情况,造成误检的原因可能有以下几点:

表1 各描述子的mAP值对比表

Table 1 The mAP of different descriptors

1)待检索图像库预处理后的歧义性.例如图7第10行“Tower Bridge”的检索结果的第3个返回图为“sailing”.该“sailing”图为“海平面上的两艘帆船”,将原图转换为边缘概率图之后,其形状特征与“Tower Bridge”有很强的相似性,进而导致误检.

2)手绘输入本身固有的歧义性.在手绘检索中,因本文所输入的手绘图像比较简单,缺少细节,因此其表达的形状可能造成歧义,同一形状可表示不同事物,例如图7第3行“Temple of Heaven Beijing”的检索列表中,第4个返回图为“Wild Goose Pagoda”类的图,该返回图与手绘输入的“Temple of Heaven Beijing”在形状轮廓上极其相似,只是建筑的层数略有不同,若在构建特征的过程中忽略了层数这一特点,则容易导致误检.

以上两点说明,深度特征描述子对图像局部特征的提取比较灵敏,但是对全局结构的表达尚有不足.

4 结 论

随着触屏设备的广泛普及,手绘图的获取越来越方便,基于手绘图像的检索问题得到了越来越多的关注.针对SBIR技术中的手绘图像与常规图像之间的域差异及手绘图本身的抽象层次差异,提出了一种基于抽象层次变换和卷积神经网络的手绘图像检索方法.利用手绘图像分类库对深度学习框架“Alex Net”进行微调,其次将手绘图像与二值边缘图像输入到深度神经网络中,提取其隐层的输出向量,通过联合特征向量的方式构建图像的特征描述子.在Flickr15K上进行了验证,证明相同评价标准下本文方法的检索精度高于其他算法.经进一步分析发现,对于手绘这种特殊的具有结构特性的图像形式,深度神经网络对其全局结构特征描述略有不足,下一步工作将主要研究手绘图或类手绘图的结构特征的提取.

[1] CHEN T, CHENG M M, TAN P, et al. Sketch2 Photo: Internet image montage[J]. ACM Transactions on Graphics,2009,28(5):89-97.

[2] HU R, WANG T, COLLOMOSSE J. A bag-of-regions approach to sketch-based image retrieval[C]// 18th IEEE International Conference on Image Processing. Brussels:IEEE,2011:3661-3664.

[3] SAAVEDRA J M, BUSTOS B. An Improved Histogram of Edge Local Orientations for Sketch-Based Image Retrieval[M]// Pattern Recognition. Berlin: Springer, 2010:432-441.

[4] ZHONG Z, MIN L Z. Unsupervised domain adaption dictionary learning for visual recognition[J]. Computer Science, 2015. arxiv:1506.01125.

[5] LIM J J, ZITNICK C L, DOLLR P. Sketch tokens: A learned mid-level representation for contour and object detection[C] //Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Portland: IEEE Computer Society Press, 2013:3158-3165.

[6] MARTIN D, FOWLKES C, MALIK J. Learning to detect natural image boundaries using local brightness, color, and texture cues[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2004,26(5):530-549.

[7] YU Q, YANG Y, SONG Y Z, et al. Sketch-a-net that beats humans[C]//Proceedings of the British Machine Vision Conference. Wales: British Machine Vision Association, 2015.

[8] LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004,60(60):91-110.

[9] DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C] //IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Los Alamitos: IEEE Computer Society Press,2005(1):886-893.

[10] PARK D K, JEON Y S, WON C S. Efficient use of local edge histogram descriptor[C]//Proceedings of the 2000 ACM Workshops on Multimedia. New York: ACM, 2000:51-54.

[11] EITZ M, HILDEBRAND K, BOUBEKEUR T, et al. Sketch-based image retrieval: Benchmark and bag-of-features descriptors[J]. IEEE Transactions on Visualization and Computer Graphics, 2011,17(11):1624-1636.

[12] BELONGIE S J, MALIK J, PUZICHA J. Shape matching and object recognition using shape contexts[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2010,24(4):509-522.

[13] HU R, COLLOMOSSE J. A performance evaluation of gradient field HOG descriptor for sketch based image retrieval[J]. Computer Vision & Image Understanding, 2013,117(7):790-806.

[14] EITZ M, HAYS J, ALEXA M. How do humans sketch objects?[J]. ACM Transactions on Graphics, 2012,31(4):Article No.44.

[15] KUANG Z, LI Z, JIANG X, et al. Retrieval of non-rigid 3D shapes from multiple aspects[J]. Computer-Aided Design,2015,58:13-23.

[16] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[J]. Advances in Neural Information Processing Systems, 2012:1097-1105.

[17] DENG J, DONG W, SOCHER R, et al. Imagenet: A large-scale hierarchical image database[C] //IEEE Conference on Computer Vision and Pattern Recognition. Los Alamitos: IEEE Computer Society Press, 2009:248-255.

[18] JIA Y, SHELHAMER E, DONAHUE J, et al. Caffe: Convolutional architecture for fast feature embedding[C] //Proceedings of the ACM International Conference on Multimedia. New York: ACM Press,2014:675-678.

[19] WANG Y, XIE Z, XU K, et al. An efficient and effective convolutional auto-encoder extreme learning machine network for 3d feature learning[J]. Neurocomputing, 2016,174:988-998.

LIU Yujie1, PANG Yunping1, LI Zongmin1, LI Hua2

(1.CollegeofComputer&CommunicationEngineering,ChinaUniversityofPetroleum,Qingdao266580,ShandongProvince,China; 2.KeyLaboratoryofIntelligentInformationProcessing,InstituteofComputingTechnologyChineseAcademyofSciences,Beijing100190,China)

Sketch based image retrieval based on abstract-level transform and convolutional neural networks. Journal of Zhejiang University(Science Edition), 2016,43(6):657-663

The traditional methods on sketch based image retrieval (SBIR) is mainly based on the hand-crafted descriptors such as HOG and SIFT. Considering the limitations of the traditional hand-crafted descriptors, we propose a novel approach based on the abstract-level transform and the convolutional neural network(CNN). Our work is realized by the following steps: 1) Extracting the boundary probability images from the database images; 2) Converting the boundary probability images into abstract-level images; 3) Inputting the abstract-level images into the networks and extracting the hidden layers’ output vectors; 4) Combining different hidden layers’ output vectors as the final descriptor for retrieval. We evaluate our proposed retrieval strategy on Flickr15K datasets. The main contributions of our work are the preprocessing based on the boundary probability detector and the abstract-level transform ation, furthermore, proposing an improved combination of deep features. Results show that the proposal achieves significant improvements.

sketch based image retrieval; convolutional neural network; boundary probability detector; abstract-level transform; joint deep features

2016-07-20.

国家自然科学基金资助项目(61379106);山东省自然科学基金资助项目(ZR2013FM036,ZR2015FM011);浙江大学CAD&CG重点实验室开放基金(A1315).

刘玉杰(1971-),ORCID:http://orcid.org/0000-0002-1838-874X,男,副教授,博士,主要从事计算机图形图像处理、多媒体数据分析、多媒体数据库研究.

*通信作者,ORCID:http://orcid:org/0000-0001-7006-055X,E-mail:lizongmin@upc.edu.cn.

10.3785/j.issn.1008-9497.2016.06.005

TP 391.41

A

1008-9497(2016)06-657-07