多特征的双人交互动作识别算法研究*

黄菲菲,曹江涛,姬晓飞,王佩瑶

1.辽宁石油化工大学 信息与控制工程学院,辽宁 抚顺 113001

2.沈阳航空航天大学 自动化学院,沈阳 110136

多特征的双人交互动作识别算法研究*

黄菲菲1,曹江涛1,姬晓飞2+,王佩瑶1

1.辽宁石油化工大学 信息与控制工程学院,辽宁 抚顺 113001

2.沈阳航空航天大学 自动化学院,沈阳 110136

动作识别;光流特征;剪影特征;HOG特征

1 引言

双人交互动作在日常生活中非常普遍,如握手、拥抱等。基于视频的双人交互行为识别与理解在智能视频监控、人机交互、体育赛事检索、虚拟现实等领域有着广泛的应用前景。与单人动作相比,双人交互动作往往更加复杂,完成双人动作所涉及到的肢体动作种类更多,肢体之间的配合及排列方式也更加多样化。如何有效地提取运动特征以及建立合理的交互模型是双人交互行为识别与理解的两个重要研究内容。大量的国内外科研工作者已经开展了相关项目的研究[1-4]。然而,由于光照条件的变化、背景的混乱干扰、运动目标的影子、运动目标与环境之间的遮挡等,使得双人交互行为识别仍然是一个富有挑战的课题[1]。

目前,基于整体的交互动作识别方法是一种主流的双人交互动作识别方法。此类方法通常将交互动作表示为包含所有动作执行人的一个整体时空描述形式,然后通过度量待识别交互动作时空特征表示与训练模板的匹配程度对交互行为进行识别和理解[5]。Yu等人[6]采用语义基元森林(sematic texton forest)生成词典对视频中的局部时空体进行描述,并引入金字塔时空关系匹配核对交互动作进行识别。Yuan等人[7]提出构造时空上下文对局部时空特征及其相互关系进行描述,并利用相应的核函数进行交互视频的匹配识别。该类方法无需对交互动作的特征进行动作个体的分割,处理思路简单。但是该类方法无法准确地表示交互动作中交互的内在属性,因此其识别的准确性有限,往往需要十分复杂的特征或多特征融合表示及匹配方法来保证识别的准确性。

近年来,利用多种视觉信息融合的思想来进行行为识别日渐成为研究领域中的一个热点和难点。多种特征融合的方法可以充分利用不同特征在不同条件下的互补性,更好地表达人体动作中各个目标之间的相互联系以及目标与整体时间活动的相互联系,适应了现实生活中场景条件的变化,从而得到更加稳定可靠的识别效果。Peng等人[8]利用4种不同的特征组合(DT shape,HOG,HOF,MBH)对多尺度密集轨迹提取底层特征,并利用特征包(bag of feature,BOF)框架对4种特征进行编码作为整个交互动作的运动描述,最终采用支持向量机进行识别取得了令人满意的结果,但该方法依赖于密集采样的结果。Li等人[9]结合运动上下文(motion context)的全局特征和局部时空兴趣点的时空特征相关性(spatio-temporal correlation)对双人交互行为进行描述,并分别提出了基于GA训练的随机森林方法及有效的时空匹配方法实现交互行为的识别与理解。这种方法对视角、遮挡和噪声等干扰不敏感,处理过程简单,但此方法的缺点是检测出来的稳定兴趣点数量较少。

根据以上分析,综合考虑到基于光流的表示法能在没有背景区域任何先验知识的条件下,实现对运动目标的检测和跟踪;基于剪影的描述方法直观,易于实现,且受光照条件影响小;方向梯度直方图(histogram of oriented gradient,HOG)特征是一种不需要在相邻帧间进行处理的简单特征表示法。本文提出了一种基于多特征融合的双人交互动作识别算法,将局部的光流特征、局部的剪影特征以及HOG特征进行融合。由于以往运动目标检测通常利用背景减除法确定出人体的剪影,该方法的抗干扰性较差,很难得到运动人体的精确剪影。本文经过多次尝试,找到一种将K-均值聚类分割法与二维Otsu阈值分割法相融合的方法对图像进行运动目标分割,从而得到理想的剪影。接下来在运动区域内提取光流,并利用分区域的局部光流信息表示双人运动的局部特征,以此来提高光流的抗噪能力。在RGB颜色空间上对图像中的运动区域进行HOG特征的提取和表示,最后将局部的剪影特征、局部的光流特征与HOG特征相结合作为混合特征。特征级直接融合的效果有限,因此本文采用决策级的概率融合,将3个特征的识别概率通过加权融合的方法得到待测试动作图像序列的最终识别概率及结果。实验结果表明,混合特征的鲁棒性及识别性比单一特征好。算法结构框图如图1所示。

Fig.1 Structure of algorithm图1 算法结构框图

2 运动目标检测

运动目标检测是指在序列图像中检测出来变化区域,并将运动目标从背景中提取出来。通常情况下,目标分类、跟踪和行为理解等后处理过程仅仅考虑图像中对应于运动目标的像素区域,因此运动目标的正确检测与分割对于后期处理非常重要。本文提出利用K-均值分割以及最大类间方差法(Otsu)确定出运动的大致区域及人体剪影。

2.1 K-均值聚类分割

K-均值算法[10]是一种基于目标函数的聚类算法,它把聚类归结成一个带约束的非线性规划问题,通过优化求解获得数据集的划分和聚类。其处理流程如下:首先随机地选择k个对象,每个对象代表一个簇的初始均值,对剩余的每个对象,根据其与各个簇均值的距离,将它指派到最相似的簇;然后计算每个簇的新均值。这个过程不断地重复,直到式(1)准则函数收敛为止。

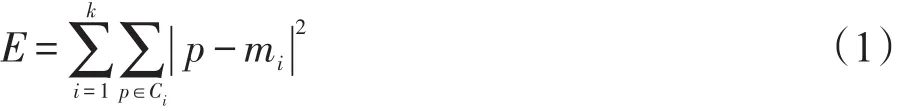

其中,E是所有研究对象的平方误差总和;p为空间的点,即数据对象;mi是簇Ci的平均值。

2.2 二维Otsu阈值分割

二维Otsu阈值分割是一种二维相关性的阈值分割方法[11]。假设原图像f的灰度等级为L,大小为M×N,以f(x,y)表示图像上坐标为(x,y)的像素的灰度值,以函数g(x,y)表示图像上坐标为(x,y)的像素的k×k邻域平均灰度值。设mij表示图像中像素点的灰度值为i,其邻域平均灰度值为j的像素点出现的次数,由此得到该图像点灰度值邻域灰度值的二维直方图。

2.3 算法融合

将K-均值聚类分割法与二维Otsu阈值分割法运用与运算进行融合,得出最好的剪影图,并且标记出运动的大致区域。其过程如图2所示。

Fig.2 Fusion ofK-mean clustering segmentation and 2D-Otsu threshold segmentation图2 K-均值聚类分割与二维Otsu阈值分割的融合

3 特征的表示与提取

3.1 光流特征表示与提取

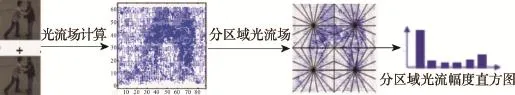

光流特征可以有效、准确地表示视频序列中的动作信息。在运动区域内提取光流,并利用分区域的局部光流信息来表示双人运动的局部特征,以此来提高光流的抗噪能力。具体过程如下:

(1)针对相邻两帧的运动区域所对应的灰度图像,运用Lucas-Kanade算法计算提取动作视频帧的运动区域水平X方向和垂直Y方向的光流场。

(2)运用分区域径向直方图方法来统计光流特征,提高特征的抗扰能力。采用按照长边缩放的方法,将得到的兴趣区域光流图像标准化为120×120维的统一大小光流图。将标准化后的光流图分成2×2的子边框。最后以子边框的中心点为中心将子边框分成18个角度相等互不重叠的扇形区域,每个中心角占20°,这样就形成了72个子区域。

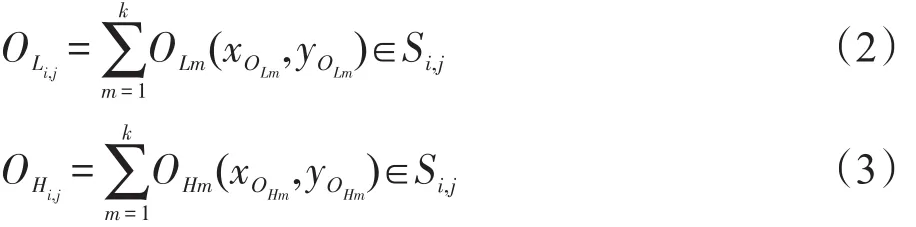

(3)在子区域S中分别统计所有水平X方向光流和垂直Y方向光流幅度之和,作为此区域的光流特征表示。式(2)、(3)分别为计算子区域的水平X方向光流之和和垂直Y方向光流幅度之和。

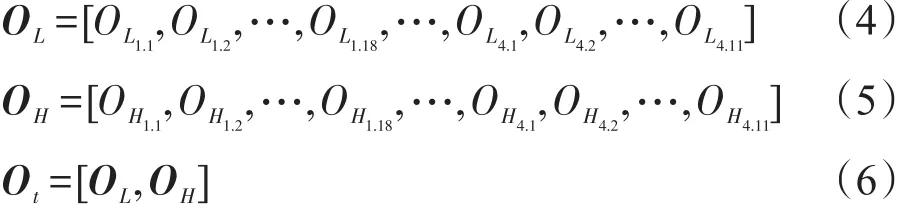

(4)整帧图像It的光流就可以由72个子区域的水平X方向光流之和OL、垂直Y方向光流之和ΟH的组合来表示,如式(4)~(6)所示。

式(4)中OL为水平X方向局部光流向量;式(5)中OH为垂直Y方向局部光流向量;式(6)中Ot为局部光流向量。

(5)使用2-范数对Ot归一化处理就得到了当前帧图像It的局部光流向量的径向直方图表示的特征。分区域光流特征的提取过程如图3所示。

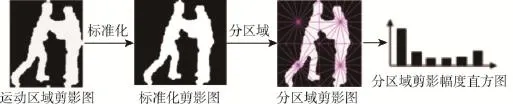

3.2 剪影特征的表示与提取

剪影特征可以简单直观地描述运动人体的形状信息并且易于提取。由检测出来的兴趣区域的位置信息,便可直接获得运动目标的二值化剪影图。鉴于各帧运动区域大小标准不同,需对提取出的运动区域剪影图进行标准化处理,对其利用双线性插值法,使其标准化为120×120维标准大小剪影图。与提取光流特征时相同,对所提取的动作视频帧剪影图划分为2×2子块,且在各子块内部以每个子块的中心为原点,将每个子块划分为18个角度相等互不重叠的扇形区域,分别在每个扇形区域中统计剪影像素点数,获取72维剪影特征的径向直方图表示。分区域剪影特征的提取过程如图4所示。

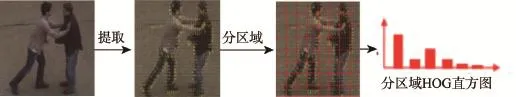

3.3 HOG特征的表示与提取

HOG特征最初是由Dalal等人[12]提出的一种在计算机视觉和图像处理中用来进行物体检测的特征描述子,它通过计算和统计图像局部区域的梯度方向直方图来构成特征。梯度提取操作不仅能够捕捉轮廓、人影和一些纹理信息,还能进一步弱化光照的影响。HOG特征是一种不需要在相邻帧间进行处理的简单全局特征表示法,只需要在当前帧像素点间求取梯度的幅值和方向,并在不同方向区域上对像素点幅值大小进行直方图统计即可。

Fig.3 Extraction of region flow feature图3 分区域光流特征的提取

Fig.4 Extraction of region silhouette feature图4 分区域剪影特征的提取

Fig.5 Extraction of region HOG feature图5 分区域HOG特征的提取

图像梯度的计算可以分解为图像横坐标和纵坐标方向的梯度,像素点(x,y)的梯度为:

式(7)中,Gx(x,y)、Gy(x,y)分别表示输入图像中像素点(x,y)处的水平方向梯度、垂直方向梯度和像素值。像素点(x,y)处的梯度幅值和梯度方向分别如式(8)所示:

图像HOG特征的表示通常先将图像分成小的连通区域,然后采集细胞单元中各像素点的梯度或边缘的方向直方图。最后把这些直方图组合起来就可以构成特征描述器。本文将每一个运动区域进行4× 4的分割,每个分割出的区块提取12维的HOG特征,那么最终特征的长度为16×12=192维。分区域HOG特征的提取如图5所示。

4 多特征融合的识别算法

4.1 帧帧最近邻识别算法

本文选用最简单的最近邻分类器[13],具体算法如下:

(1)找到测试序列每一帧的最近邻。设测试样本序列第t帧的特征向量为(t=1,2,…,T),训练样本所对应的第n帧特征向量为。用欧几里德距离来测试的相似性,与距离最小的训练样本帧就是测试样本序列第t帧的最近邻,如式(9)所示:

(2)将测试帧对应的最近邻的训练帧所属动作的标号赋给当前的测试帧,这样测试序列的每一测试帧都将得到一个动作的标号。

(3)将测试序列每一帧的动作标号进行统计,测试序列类别对应为票数最多的标号对应的动作。

4.2 多特征识别概率的加权融合

通过使用帧帧最近邻分类器可以分别获得光流特征的识别概率、剪影特征的识别概率以及HOG特征的识别概率。将3个特征的识别概率通过加权融合的方法可以得到待测试动作图像序列的最终识别概率及结果,如式(10)所示:

式(10)中,P为待测试动作图像序列的最终识别概率;Pf为光流特征的识别概率;Ps为剪影特征的识别概率;Ph为HOG特征的识别概率。各个特征的识别概率加权参数分别为wf、ws和wh。

通过实验发现,3类特征识别概率权值的选取对识别结果有着很大的影响。本文对训练数据进行多次学习得到最优权值。具体实现为将3个加权参数wf、ws和wh相加之和控制为1,以0.1为间距进行遍历实验,得到最优识别结果对应3类特征的权值,即为最优权值。

5 实验结果

5.1 数据库介绍

本文实验中采用公开的UT-interaction双人交互动作视频数据库。该数据库包含6大类人体交互行为的连续视频序列,分别是握手(handshake)、拥抱(hug)、脚踢(kick)、指向(point)、猛击(punch)和推搡(push),每类动作包含10个动作视频,共60个视频。数据库的示例图如图6所示。

Fig.6 Exemplar frames from UT-interaction dataset图6 UT-interaction数据库示例图

整个数据库由15个人在真实场景下两两完成,该数据库中的视频场景内大多包含杂乱的场景、相机的抖动、变化的光照等挑战因素。视频的分辨率是720×480像素,刷新率20 f/s,其中人的高度约为200像素。因此在该视频上进行双人交互动作的检测与识别是十分具有挑战性的。

5.2 实验及结果研究

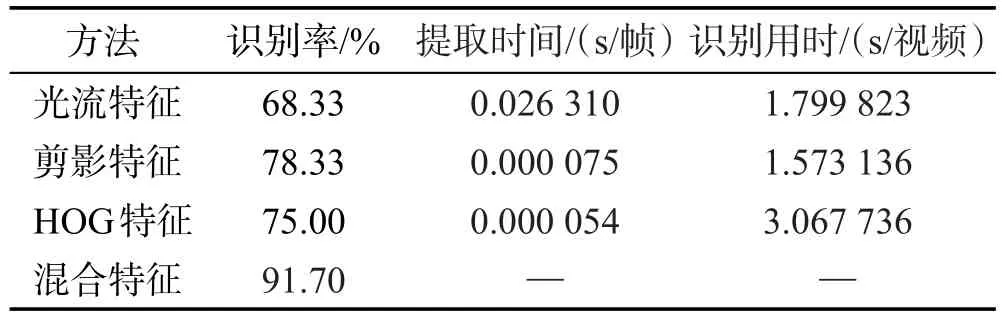

本文采用留一法(leave one out)来验证算法的有效性,即每次实验选择数据库中一个人的所有动作作为测试样本集,而余下的作为训练样本集。然后循环,每个人的动作都将作为测试样本进行测试,并统计识别结果。光流特征、剪影特征、HOG特征以及3种特征混合后的特征识别结果如表1所示。

Table 1 Recognition rate of different features表1 不同特征对应的识别率

由表1的实验结果可以看出,单个特征的识别结果并不理想,但是将3个特征的识别概率进行加权融合后,识别效果有了明显的提升。如图7所示,其最优权值运用遍历的方法,经过大量的实验获得,找到图中的最大峰值点,得到对应的最优权值分别为30%、50%与20%。在UT-interaction数据库可获得91.7%的识别率,可见最优权值参数的选取对识别结果有着很大的影响。

Fig.7 Experimental result of optimal weight based on the fusion of 3 features图7 3个特征融合的最优权值实验结果

在提取特征的速度上,剪影特征和HOG特征非常快,而光流特征稍慢些,是因为光流是在两帧之间进行逐点计算,为了缩短计算时间,根据等间距提取运动信息,将原来的两帧变为5帧,维数不变,从而缩短计算时间。3个特征运用帧帧最近邻分类器进行识别,单个视频的识别时间都在5 s以内,具有应用于实时系统的潜在价值。

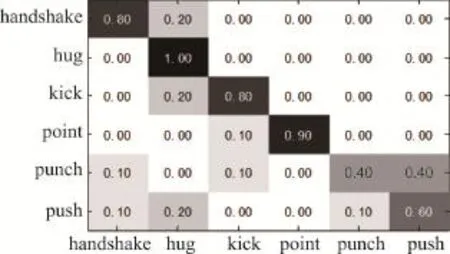

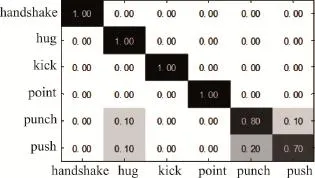

图8~图11分别为光流特征、剪影特征、HOG特征以及3个特征概率融合后的混淆矩阵。

Fig.8 Confusion matrix of flow feature recognition图8 光流特征的识别混淆矩阵图

Fig.9 Confusion matrix of silhouette feature recognition图9 剪影特征的识别混淆矩阵图

Fig.10 Confusion matrix of HOG feature recognition图10 HOG特征的识别混淆矩阵图

Fig.11 Confusion matrix of 3 features recognition probability weighted fusion图11 3个特征概率加权融合后的混淆矩阵图

由图8~图10可以看出“handshake”与“hug”两个动作的识别结果要优于“kick”、“punch”与“push”3个动作的识别效果。其原因是“kick”、“punch”与“push”3个动作帧数较少,且每两帧图像变化较大,区分性差,导致识别结果受到一定的影响。“push”和“punch”两组动作由于相似性较高,不能很好地识别。由图11可以看出,较单一特征,将其识别概率进行加权融合后,有4个动作识别完全正确,分别为“handshake”、“hug”、“kick”和“point”,且对于“punch”以及“push”两类动作的识别结果有了显著的提高。

将本文的识别方法与近期基于UT-interaction数据库的其他方法进行比较。实验结果如表2所示。

Table 2 Recognition rate of combining different features表2 不同特征结合对应的识别率

由表2可以看出,本文方法在交互行为识别的准确率方面要优于文献[9,14]。文献[8]的识别结果与本文方法结果相当,由于文献[8]提出利用4种不同的特征组合密集轨迹形状特征、梯度方向直方图特征、光流方向直方图特征、运动边界直方图特征对多尺度密集轨迹提取底层特征,并利用特征包框架对4种特征进行编码作为整个交互动作的运动描述,最终采用支持向量机预测视频的分类结果。但是其依赖于多尺度密集轨道提取算法的准确性,且密集轨迹的提取和表征过程需要进行大量的计算。相比于其他方法,本文所提出的特征易于提取和表征,且前期预处理运用K-均值聚类分割法与二维Otsu阈值分割法,得到了较好的分割结果,使特征的精确提取成为可能。

6 结束语

本文提出了一种基于多特征融合的双人交互动作识别算法,将局部的光流特征、局部的剪影特征以及HOG特征进行结合,组成混合特征进行动作识别。在UT-interaction数据库上得到了91.7%的识别率,证明了本文方法的有效性及可行性。本文方法对相似的动作仍然存在误差,下一步的工作将尝试对光流特征进行改进,进一步提高算法的计算效率,以期实现算法的实时应用。

References:

[1]Kantorov V,Laptev I.Efficient feature extraction,encoding and classification for action recognition[C]//Proceedings of the 2014 IEEE Computer Society Conference on Computer Vision and Pattern Recognition,Columbus,USA,Jun 23-28, 2014.Washington:IEEE Computer Society,2014:2593-2600.

[2]El Houda Slimani K N,Benezeth Y,Souami F.Human interaction recognition based on the co-occurrence of visual words [C]//Proceedings of the 2014 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops,Columbus,USA,Jun 23-28,2014.Washington: IEEE Computer Society,2014:461-466.

[3]Mukherjee S,Biswas S K,Mukherjee D P.Recognizing interaction between human performers using“key pose doublet”[C]//Proceedings of the 19th ACM International Conference on Multimedea,Scottsdale,USA,Nov 28-Dec 1, 2011.New York:ACM,2011:1329-1332.

[4]Zhang Xinye,Cui Jinshi,Tian Lu,et al.Local spatio-temporal feature based voting framework for complex human activity detection and localization[C]//Proceedings of the 1st Asian Conference on Pattern Recognition,Beijing,China,2011: 12-16.

[5]Vahdat A,Gao Bo,Ranjbar M,et al.A discriminative key pose sequence model for recognizing human interactions [C]//Proceedings of the 2011 IEEE International Conference on Computer Vision,Barcelona,Spain,Nov 6-13,2011. Piscataway,USA:IEEE,2011:1729-1736.

[6]Kong Yu,Jia Yunde,Fu Yun.Interactive phrases:semantic descriptions for human interaction recognition[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014,36(9):1775-1788.

[7]Yuan Fei,Sahbi H,Prinet V.Spatio-temporal context kernel for activity recognition[C]//Proceedings of the 1st Asian Conference on Pattern Recognition,Beijing,China,2011: 436-440.

[8]Peng Xiaojiang,Wu Xiao,Peng Qiang,et al.Exploring dense trajectory feature and encoding methods for human interaction recognition[C]//Proceedings of the 5th International Conference on Internet Multimedia Computing and Service,Huangshan,China,Aug 17-19,2013.New York:ACM, 2013:23-27.

[9]Li Nijun,Cheng Xu,Guo Haiyan,et al.A hybrid method for human interaction recognition using spatio-temporal interest points[C]//Proceedings of the 22nd International Conference on Pattern Recognition,Stockholm,Sweden,Aug 24-28,2014.Piscataway,USA:IEEE,2014:2513-2518.

[10]Forgy E W.Cluster analysis of multivariate data:efficiency versus interpretability of classifications[J].Biometrics,1965, 21(3):768-780.

[11]MacQueen J.Some methods for classification and analysis of multivariate observations[C]//Proceedings of the 5th Berkeley Symposium on Mathematical Statistics and Probability.Berkeley,USA:University of California Press,1967: 281-297.

[12]Dalal N,Triggs B.Histograms of oriented gradients for human detection[C]//Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition,San Diego,USA,Jun 20-26,2005.Washington:IEEE Computer Society,2005:886-893.

[13]Wang Liang,Geng Xin,Leckie C,et al.Moving shape dynamics:a signal processing perspective[C]//Proceedings of the 2008 IEEE Computer Society Conference on Computer Vision and Pattern Recognition,Anchorage,USA,Jun 24-26,2008.Washington:IEEE Computer Society,2008:1649-1656.

[14]Yuan Fei,Prinet V,Yuan Junsong.Middle-level representation for human activities recognition:the role of spatio-temporal relationships[C]//LNCS 6553:Proceedings of the 11th European Conference on Computer Vision,Heraklion,Greece, Sep 10-11,2010.Berlin,Heidelberg:Springer,2010:168-180.

HUANG Feifei was born in 1990.She is an M.S.candidate at Liaoning Shihua University.Her research interest is image processing and recognition.

黄菲菲(1990—),女,辽宁盘锦人,辽宁石油化工大学硕士研究生,主要研究领域为图像处理与识别。

CAO Jiangtao was born in 1978.He received the Ph.D.degree in intelligent control from University of Portsmouth in 2009.Now he is a professor and M.S.supervisor at Liaoning Shihua University.His research interests include intelligent method and its application in industry control information processing and video analysis,etc.

曹江涛(1978—),男,山东菏泽人,2009年于英国普茨茅斯大学获得博士学位,现为辽宁石油化工大学教授、硕士生导师,主要研究领域为智能方法及其在工业控制信息处理上的应用,视频分析与处理等。发表学术论文40余篇,其中被SCI检索6篇,EI检索22篇,承担国家自然科学基金等项目。

JI Xiaofei was born in 1978.She received the Ph.D.degree in pattern recognition and intelligent system from University of Portsmouth in 2010.Now she is an associate professor and M.S.supervisor at Shenyang Aerospace University,and the member of CCF.Her research interests include video analysis and pattern recognition theory,etc.

姬晓飞(1978—),女,辽宁鞍山人,2010年于英国普茨茅斯大学获得博士学位,现为沈阳航空航天大学副教授、硕士生导师,CCF会员,主要研究领域为视频分析与处理,模式识别理论等。发表学术论文30余篇,参与编著英文专著1部,承担国家自然科学基金、教育部留学回国启动基金等课题研究。

WANG Peiyao was born in 1991.She is an M.S.candidate at Liaoning Shihua University.Her research interests include vision analysis and pattern recognition,etc.

王佩瑶(1991—),女,辽宁昌图人,辽宁石油化工大学硕士研究生,主要研究领域为视频分析与处理,模式识别等。

Research on Human Interaction RecognitionAlgorithm Based on Mixed Features*

HUANG Feifei1,CAO Jiangtao1,JI Xiaofei2+,WANG Peiyao1

1.School of Information and Control Engineering,Liaoning Shihua University,Fushun,Liaoning 113001,China

2.School ofAutomation,ShenyangAerospace University,Shenyang 110136,China

+Corresponding author:E-mail:jixiaofei7804@126.com

The choice of motion features affects the result of human interaction recognition algorithm directly.Because of different adaptive scopes,many factors often influence the single features,such as the appearance of human body,environment and camera setting.So it can’t achieve satisfactory accuracy of action recognition.On the basis of studying the representation and recognition of human interaction action,and giving full consideration to the advantages and disadvantages of different features,this paper proposes a mixed feature which combines local optical flow feature,local silhouette feature and HOG(histogram of oriented gradient)feature.The nearest neighbor classifier is used to obtain the recognition probability of three features.Finally,the recognition result is achieved by weighted fusing those recognition probabilities.The experimental results demonstrate that this algorithm achieve better recognition results in the UT-interaction database,and compared with the single features,the mixed feature can improve the recognition rate to 91.7%.

action recognition;optical flow feature;silhouette feature;HOG feature

10.3778/j.issn.1673-9418.1511078

A

TP391.4

*The National Natural Science Foundation of China under Grant No.61103123(国家自然科学基金);the Program for Liaoning Excellent Talents in University under Grant Nos.LJQ2014018,LR2015034(辽宁省高等学校优秀人才支持计划项目).

Received 2015-11,Accepted 2016-02.

CNKI网络优先出版:2016-02-19,http://www.cnki.net/kcms/detail/11.5602.TP.20160219.1651.004.html

HUANG Feifei,CAO Jiangtao,JI Xiaofei,et al.Research on human interaction recognition algorithm based on mixed features.Journal of Frontiers of Computer Science and Technology,2017,11(2):294-302.

摘 要:运动特征的选择直接影响基于整体的双人交互动作识别算法的识别效果。单一的特征因其适应范围不同,受到人体的外观、环境、摄像机设置等因素的影响,识别效果往往不太理想。在研究双人交互动作的表征与识别的基础上,充分考虑不同特征的优缺点,提出了一种结合局部的光流特征、局部的剪影特征以及HOG(histogram of oriented gradient)特征的混合特征,使用帧帧最近邻分类器获得3个特征的识别概率,最终通过加权融合3个特征的识别概率实现交互行为的识别。实验结果表明,对于UT-interaction数据库,该算法得到了较为理想的识别结果,混合特征可将识别率提高到91.7%。

——为小提琴与钢琴而作

———申雪、赵宏博