深度学习发展综述*

侯宇青阳 全吉成 王宏伟

(中国人民解放军空军航空大学 长春 130000)

深度学习发展综述*

侯宇青阳 全吉成 王宏伟

(中国人民解放军空军航空大学 长春 130000)

鉴于深度学习的研究和应用价值及在学术和工业领域中的重要地位,对目前有代表性的主流的深度学习网络模型进行介绍,概述了深度学习当前发展状态,综述了深度学习发展方向。首先介绍了深度学习的历史沿革,根据应用研究对四种主要深度学习网络进行介绍,然后从网络性能提升、网络体系发展、新学习模式探索、深度强化学习、可视化理论研究五个方面总结了目前深度学习的发展状态,最后提出下一步深度学习发展展望。可以看到:深度学习在不同领域都有广泛的应用,而且具有明显的优势,但也存在需要进一步深入探索的问题,如提高深度学习的智能性、提高无标签数据的利用率等。

深度学习; 卷积神经网络; 半监督学习; 深度强化学习; 人工智能

Class Number TP18

1 引言

2006年,深度学习泰斗Hinton[1]提出无监督深度置信网络的训练方法,2013年深度学习位列10大突破性科技之首,到2016年3月,AlphaGO[2]打败人类围棋大师。这十年间深度学习不断发展创新,研究价值和应用潜力不断被挖掘发现。近年来深度学习取得惊人进展,从模型、算法,到大规模的应用都取得了令人瞩目的成果。深度学习的出现是机器学习的一次重要革命,是人工智能发展巨大推力。人工智能是终极目标,机器学习是实现人工智能的一种分支,深度学习隶属于人工神经网络体系,人工神经网络是基于统计的机器学习方法,相比于基于人工规则的专家系统,表现优异。传统的神经网络是一种浅层机器学习,深度学习是传统神经网络发展下的新一代神经网络。深度学习是通过建立、模拟人脑的信息处理神经结构来实现对外部输入的数据进行从低级到高级的特征提取,从而能够使机器理解学习数据,获得信息[3]。

本文主要对深度学习的发展进行总结,介绍现有理论应用成果以及未来的发展方向。

2 深度学习历史沿革

萌芽期:从BP算法[4]的发明(1970s~1980s)到2006年期间;BP算法使得神经网络训练简单可行。这段期间因为神经网络模型存在的一系列问题被主流的计算机视觉和学术界所抛弃,只有少数科学家仍坚持研究。存在的问题主要有: 1) 数据获取的问题。学者们试图利用有监督的方式训练深度神经网络,但是缺少大量有标签的数据,没有足够的样本导致无法拟合复杂网络模型的参数,容易出现过拟合,与当时比较流行的浅层学习方法,如随机森林、支持向量机等,相比,效果不理想,没有受到关注。 2) 局部极值问题。训练深度神经网络时,由于存在非凸优化问题的搜索域中充斥着大量不好的局部极值,使得梯度下降法效果并不好。 3) 梯度弥散问题。这是使得深度神经网络发展缓慢的主要因素。随着网络的深度增加,反向传播的梯度的幅度值会急剧地减小,使得其更新变化非常缓慢,不能对样本进行有效的学习。这种问题被称为“梯度弥散”。 4) 硬件条件不足。由于深度神经网络的训练过程,包括反向传播过程以及大量样本数据的学习压力,对计算机硬件提出很高的要求。随之内存容量扩大、GPU并行计算的发展,为深度学习发展提供了契机。 5) 浅层学习方法大放异彩。随机森林、支持向量机、多层感知机算法等的发展迅速,并在实践中取得很好的效果,也使得深度神经网络受到冷落。

迅速发展期(2006年~2012年):主要以深度无监督学习为主的研究阶段。从2006年Hinton提出“深度学习”概念和深度学习的训练方法之后揭开了深度学习发展的帷幕;

爆发期(2012年至今):2012年Hilton团队的Alexnet模型[5]在imagenet竞赛中取得惊人成绩。现在各大互联网公司纷纷开始成立研究部门进行深度学习工程化的研究,以谷歌、微软、百度为代表,将深度学习广泛应用在语音识别、图像检索、翻译等领域,取得了非凡的实际效果。

3 经典深度学习网络

经过10年的发展历程,深度学习在图像处理、语音识别、文本处理等多领域得到了广泛应用。以卷积神经网络、深度置信网络、栈式自编码网络和递归神经网络为核心的深度学习模型体系逐渐形成。下面对经典深度学习网络进行介绍。

3.1 卷积神经网络

卷积神经网络(Convolution Nerual Net,CNNs)通过结合局部感知区域、共享权重、空间或时间上的池化降采样三大特点来充分利用数据本身包含的局部性等特征,优化网络结构,并且保证一定程度上的位移的不变性[6]。它的权值共享网结构相似于生物神经网络,降低了网络模型的复杂度,减少了权值的数量。因为这样的结构特点使其尤其适合大图像数据的机器学习,可以使数量庞大的图像识别问题不断降维。CNNs的主要结构包括卷积部分和全连接部分。卷积部分包括卷积层、激活层、下采样层,通过卷积部分的叠加提取特征;全连接部分连接特征提取和输出计算损失和完成识别分类等功能。

CNNs是第一个真正成功地采用多层层次结构网络的具有鲁棒性的深度学习方法。CNNs适应性强,善于挖掘数据局部特征,使得CNNs已经成为众多科学领域的研究热点之一,在模式识别中的各个领域得到应用并取得了很好的结果。随着海量标记数据和GPU并行计算的发展,使得卷积神经网络研究大放异彩。

3.2 深度置信网络

深度置信网络的基本结构单元是受限玻尔兹曼机(Restricted Boltzmann Machine,RBM)。受限玻尔玆曼机通过学习数据的概率密度分布提取抽象特征。深度置信网络通过RBM的叠加,逐层学习数据概率分布,即提取多种概率特征。DBN训练过程分为无监督训练阶段和微调阶段。无监督贪婪逐层训练方法获得各层的条件概率分布,微调阶段包括利用带标签数据和BP算法对网络参数进行调整。DBN具有高灵活性,容易拓展,不仅在图像处理、语音识别领域网络预训练中应用广泛,也是构建新型深度学习网络的结构基础。

3.3 栈式自编码网络[8~9]

栈式自编码网络的基本单元是自编码器(Auto-encoder,AE)。自编码器包括编码层和解码层,通过编码-解码的方式复现输入信号。堆栈式自编码网络是累加自编码器,通过无监督贪婪逐层训练得到每层自编码器的权重,在每一层得到了关于输入数据的另一种表达形式,这些不同的表示就是特征,在原有的特征基础上加入自动学习到的特征可以提高学习能力,是深度神经网络预训练的重要方法之一。

3.4 递归神经网络

上述几种模型,隐层之间彼此独立,逐层的提取特征,但这样的连接方式忽略了数据间的关联性。递归神经网络会对上一层的信息进行记忆,添加到当前层的计算输出中,在结构中体现为隐层间有节点相连。递归神经网络是非常强大的动态系统,通常用于描述动态时间行为序列,使状态数据在网络中循环传递,它更擅长语音文本信息[10],一次处理一个输入序列元素每个节点同时包括过去时刻序列元素的历史信息,一般采用时间反传(backpropagation through time,BPTT)训练算法来解决非长时依赖问题。

4 深度学习现阶段研究进展

4.1 改进网络训练技巧,提升网络实用性能

机器学习通过准确率和损失值衡量一个学习网络的好坏,深度学习网络训练的目标就是高准确率和低损失率。经过大量实验研究,针对深度学习网络训练也有技巧和方法来提升算法性能,增强鲁棒性。

4.1.1 数据提升和Dropout[11]——解决过拟合

过拟合是指训练样本不足时,一个模型从中学习到的不能推广到新数据的问题。数据提升和Dropout其本质都是随机打乱数据的相关性。数据提升是指对有限的样本数据随机变化,生成新样本,同时保证数据彼此间相似性低,有利于抑制过拟合,使模型泛化能力更好。Dropout通过设置Dropout参数值,来抑制一定比例神经元活性,使其输出为0,可以视为一种模型平均,把每个批次的训练过程中,随机忽略的隐层节点不同,生成的不同模型平均。这样权值的更新不再依赖于有固定关系隐含节点的共同作用,有效阻止过拟合现象。

4.1.2 参数调优(fine-tune)

对于一个已知的深度学习网络结构,如何提升网络的性能,是我们研究的重点。从理论结构到实际应用需要不断地调整参数,即参数调优。不同的深度学习网络结构适合于不同的实际应用,除了结构固有的优点,还可以通过改变反向传播算法和激活函数来提升网络性能。常用的反向传播算法有:随机梯度下降法(Stochastic Gradient Descend,SGD)、自适应梯度下降方法(AdaGrad)等。激活函数常用的有tanh、sigmoid、ReLU等。ReLU函数的应用是对深度学习应用发展的推进,对于人大脑皮层的工作过程研究,处理信息时有大量神经元处于抑制状态,只有少数的神经元激活工作,是非常高效的。这与ReLU的原理不谋而合,稀疏连接也是表达了这一生理结构。在训练过程中确实提升网络的效率和性能。

4.2 深度学习网络体系发展

4.2.1 卷积神经网络体系

卷积神经网络是发展最为深入的深度学习网络。卷积神经网络的结构特点更适合解决图像领域问题。通过对其结构的不断研究和改进,形成了一系列网络模型,在广泛实际应用中取得成功。

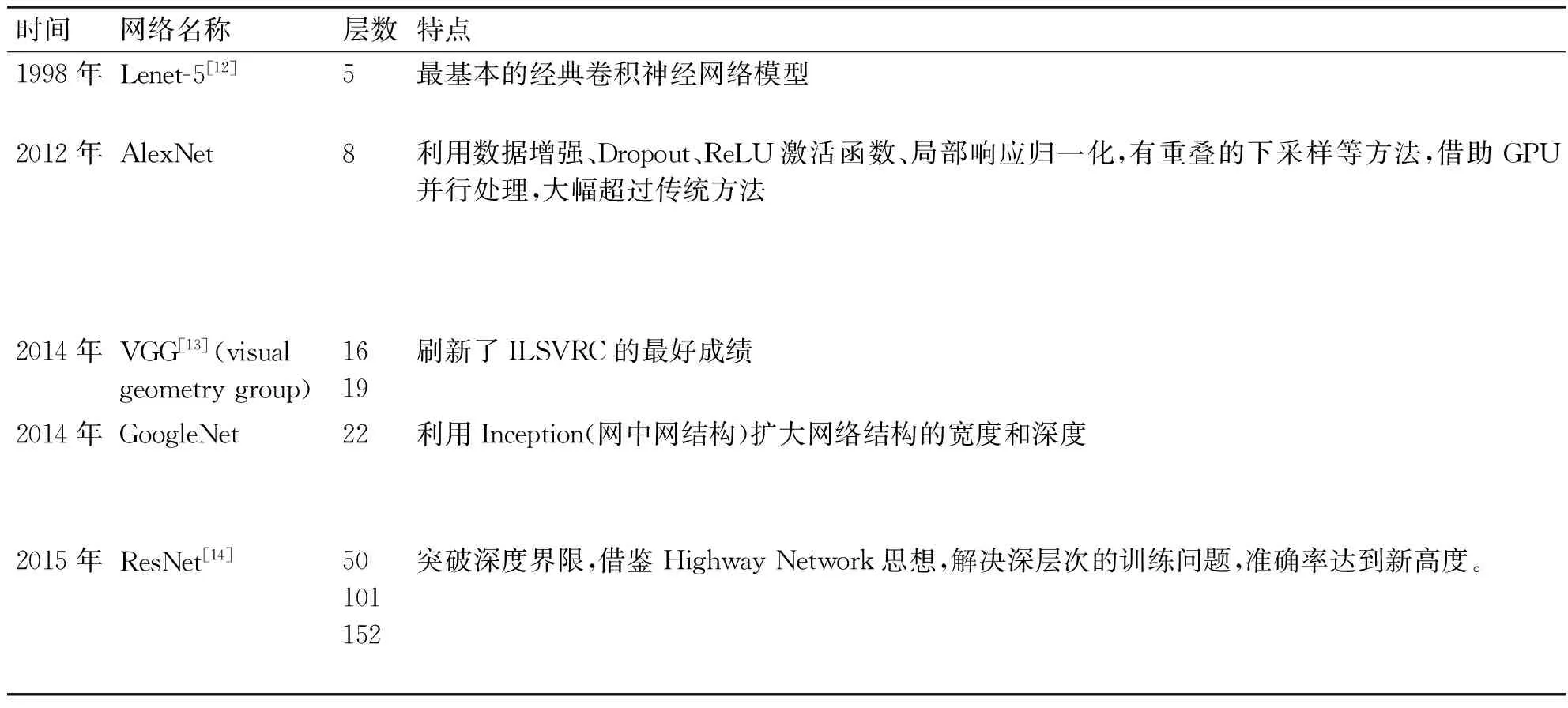

一方面创造性的提出增加跳跃连接结构,克服深度训练难题,增加网络深度。深度学习的学习能力通过深度得以提高,但是深度的增加不仅带来参数激增数据量增大,而且造成训练过程中反向传播困难。突破深度限制是未来深度学习发展的必然趋势。现阶段网络深度研究进展见表1。

表1 深度学习网络深度研究进展

网络结构加深提升准确率,验证了深度学习网络的深度价值和潜力。

另一方面改变卷积神经网络结构,典型的包括全卷积网络[15](Fully Convolutional Networks,FCN)。FCN去掉网络中的全连接层,全部利用卷积结构进行处理数据,使图像级理解上升为像素级理解。全连接结构参数占主要部分,且运算耗时,全卷积网络可以满足实时性要求,目前涌现一大批基于FCN的泛,例如边缘检测、视觉跟踪、图像分割等。

4.2.2 栈式自编码网络体系

基于自编码的深度学习体系也在不断丰富,常用的有稀疏自编码网络(sparse Autoencoder)、降噪自编码网络[16](denoising auto-encoders,DAEs)和收缩自编码网络[17](contractive auto-encoders,CAEs)。稀疏自编码器通过稀疏限制,即控制神经元大多数时间处于抑制状态,来对无标记数据学习,得到的特征往往优于数据的原始表达,在实际应用中取得更好的结果;降噪自编码器通过在原始数据加入随机噪音来使网络学习添加了噪声的数据以提高学习能力;收缩自编码网络通过在损失函数加入惩罚项,增强了特征学习的鲁棒性。

4.2.3 递归神经网络体系

RNN网络重视反馈作用,并储存当前状态和过去状态的连接,适用于文本、语言等时间序列特征明显的数据处理。针对传统RNN网络存在问题,提出长短期记忆神经网络[18](long short-term memory,LSTM)适用于处理和预测时间序列中间隔和延迟非常长的问题,在预测文本和语音识别中表现优异;GRU模型是LSTM模型的改进,在实际应用中,更具有竞争力,性能更稳定。

4.3 构建学习新模式——半监督深度学习

机器学习最常见的就是监督学习和无监督学习,无论浅层学习还是深层学习。无监督学习主要用于网络模型的预训练,监督学习用于提高网络学习能力。通过对人类的学习过程进行研究,对于一种形体事物的认知学习,是少量带标签数据学习,结合大量无标签的图像进一步学习。而现有的无监督+监督学习是不符合人类的学习习惯。在此基础上,提出半监督学习的方法,不是简单的无监督学习和监督学习的叠加,而是将两者的网络结构相融合。主要有阶梯网络[19](Ladder Network)、判别深度置信网、卷积深度网络。下面以阶梯网络为例介绍半监督学习模式:利用现有监督学习网络,如MLP或CNN,融合以降噪自编码的无监督学习算法。对于局部学习所得到的学习结果具有可扩展性,次模型在每一层都有具体学习目标,对更大深度的神经网络是有效的。跳跃网络和基于层的非监督学习的目标函数有效的把自动编码转化为了级联的隐形变量模型,这种模型适合用于半监督学习,经过实验训练在现有数据集均取得最好结果。半监督学习网络结构设计提供了广阔的研究空间,在学习模式有更多创新。

4.4 深度强化学习——跨领域融合的人工智能决策算法

高级人工智能领域中,感知能力和决策能力都是衡量智能水平的重要指标。强化学习能够直接输入高维感知以做出决策控制智能体(agent),但需要依赖人工提取特征;深度学习具有强感知能力,但缺乏一定的决策能力。因此,将两者结合,优势互补,达到合作共赢的效果。深度强化学习是一种更接近人类思维方式的人工智能方法。2013年[20]深智团队提出的深度Q网络(deep Q network,DQN),是将卷积神经网络和Q学习结合,并集成经验回放技术实现的,实现了端对端的学习控制。深度Q网络是深度强化学习领域的具开创性意义的工作。2014年[21]Guo等提出将蒙特卡罗树搜索与深度Q网络结合,实现了Atari游戏的实时处理,游戏表现也普遍高于原始DQN网络。深度强化学习具有很强的时间依赖性,递归神经网络适合处理与时间序列相关的问题,因此强化学习与递归神经网络的结合也是深度强化学习的主要形式。2015年[22]Hausknecht等结合LSTM提出了深度递归Q网络(DRQN),在缺失若干帧的数据中也取得很好的实验结果,鲁棒性更好。2016年,深智团队提出了基于DRL的计算机围棋程序——初奕号,成为深度强化学习的典型应用。深度强化学习在游戏、智能驾驶、机器人、智能制造等领域还有待深入研究。

4.5 基于可视化的理论研究

深度学习的成功背后缺乏深入理论研究的支撑。深度学习的学习过程是端对端的“黑箱”操作过程,对于隐层的学习过程,学习效果都无法监控和评估,网络模型出现问题主要还是通过调节外部参数来试探性的解决,这样的学习模式,对于理解和提升网络性能是不利的,虽然深度学习是基于人工神经网络模拟大脑皮层推断分析数据的复杂层状网络结构,但对于其学习的本质还是未知的。为了研究深度学习的学习本质,2013年[23]提出可视化理解卷积神经网络。通过可视化显示每一隐层学到的特征,然后调整网络提高精度。可视化方法对于深入理解网络具有重要意义,主要有以下几种方法:可视化激活层、可视化权重、图像检索最大化激活神经元、用t-SNE嵌入代码等。

5 深度学习发展展望

虽然深度学习在应用中取得了很多成绩,但是仍存在很多局限:理论研究缺乏、无监督学习能力弱、缺少逻辑推理和记忆能力等。

深度学习的研究多是基于实验训练进行的,但是对其内部原理,学习本质研究很少。现在的研究多是在网络架构、参数选择等方面,而且深度学习得到的结果使局部最优解,并不是全局最优解,还有进一步提升空间,也需要更加完备深入的理论支撑其发展。

目前主流应用还是以监督学习为主的,但在实际生活中,无标签未知的数据占主体,所以更应该应用可以发现事物内在关系的无监督学习,但无监督学习未取得突破性的成果,未来还有更广阔的发展空间。

深度学习是人工智能发展的巨大推力,但是深度学习现阶段更侧重于处理数据,在智能方向发展较少,如记忆能力和逻辑推理能力,在面对复杂现实任务时,预测和存储包含信息序列的内容是必要的,这也将成为未来深度学习的一个研究方向。

深度学习对未来社会发展仍将具有重要意义,需要不断深入研究,多方向多角度更全面的开发深度学习的潜在价值。

[1] HINTON G E, SALAKHUTDINOV R R. Reducing the Dimensionality of Data with Neural Networks[J]. Science,2006,313(5786):504-507.

[2] SILVER D, HUANG A, MADDISON C, et al. Mastering the game of Go with deep neural networks and tree search[J]. Nature,2016,529(7587):484-489.

[3] 尹宝才,王文通,王立春.深度学习研究综述[J].北京工业大学学报,2015,1:48-59.

[4] Rumelhart D, Hinton G, Williams R. Learning representations by back-propagating errors[J]. Nature,1986,323(6088):533-536.

[5] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[C]//Advances in Neural Information Processing Systems. Lake Tahoe: MIT Press,2012:1097-1105.

[6] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]//ar Xiv preprint. 2015. ar Xiv:1409.1556[cs.CV].

[7] MOHAMED A, DAHL G E, HINTON G. Acoustic modeling using deep belief networks[J]. IEEE Transactions on Audio, Speech, and Language Processing,2012,20(1):14-22.

[8] FENG X, ZHANG Y, GLASS J. Speech feature denoising and dereverberation via deep autoencoders for noisy reverberant speech recognition[C]//Proceedings of the IEEE International Conference on Acoustics, Speech and Signal Processing. Florence: IEEE,2014:1759-763.

[9] VINCENT P, LAROCHELLE H, LAJOIE I, et al. Stacked denoising autoencoders: learning useful representations in a deep network with a local denoising criterion[J]. The Journal of Machine Learning Research,2010,11(11):3371-3408.

[10] GRAVERS A, MOHAMED A, HINTON G. Speech recognition with deep recurrent neural networks[C]//Proceedings of the IEEE International Conference on Acoustics, Speech and Signal Processing. Vancouver: IEEE,2013:6645-6649.

[11] Nitish Srivastava, Geoffrey Hinton, Alex Krizhevsky, et al. Dropout: A Simple Way to Prevent Neural Networks from Overfitting[J]. Journal of Machine Learning Research,2014,15:1929-1958.

[12] LECUN Y, BOTTOU L, BENGIO Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE,1998,86(11):2278-2324.

[13] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for largescale image recognition[EB/OL]//ar Xiv preprint. 2015. ar Xiv:1409.1556[cs.CV].

[14] HE K M, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE,2016.

[15] Justin Johnson, Andrej Karpathy, Li Fei-Fei. DenseCap: Fully Convolutional Localization Networks for Dense Captioning[DB/OL]. http://cs.stanford.edu/people/karpathy/densecap.pdf.

[16] VINCENT P, LAROCHELLE H, BENGIO Y, et al. Extracting and composing robust features with denoising autoencoders[C]//Proceedings of the 25th International Conference on Machine Learning. Helsinki: ACM,2008:1096-1103.

[17] RIFAI S, VINCENT P, MULLER X, et al. Contractive auto-encoders: Explicit invariance during feature extraction[C]//Pro-ceedings of the 28th International Conference on Machine Learning. Bellevue: ACM,2011:833-840.

[18] GRAVERS A, MOHAMED A, HINTON G. Speech recognition with deep recurrent neural networks[C]//Proceedings of the IEEE International Conference on Acoustics, Speech and Signal Processing. Vancouver: IEEE,2013:6645-6649.

[19] Rasmus, Antti, Valpola, et al. Tapani. Semi-supervised learning with ladder network. ar Xiv preprint ar Xiv:1507.02672,2015.

[20] MNIH V, KAVUKCUOGLU K, SILVER D, et al. Playing atari with deep reinforcement learning[C]//Proceedings of the NIPS Workshop on Deep Learning. Lake Tahoe: MIT Press,2013.

[21] GUO X, SINGH S, LEE H, et al. Deep learning for real-time Atari game play using offline Monte-Carlo tree search planning[C]//Advances in Neural Information Processing Systems. Montreal: MIT Press,2014:3338-3346.

[22] MNIH V, KAVUKCUOGLU K, SILVER D, et al. Human-level control through deep reinforcement learning[J]. Nature,2015,518(7540):529-533.

[23] Matthew D Zeiler, Rob Fergus. Visualizing and Understanding Convolutional Networks[J]. ar Xiv:1311.2901,2013.

[24] HINTON G E. To Recognize Shapes, First Learn to Generate Images[C]//Computational Neuro science: Theoretical Insights into Brain Function. Elsevier,2006-10-26.

[25] Yann Lecun, Yoshua Bengio, Geoffrey Hinton. Deep Learning[J]. Nature,2015,521:436-444.

[26] 郭丽丽,丁世飞.深度学习研究进展[J].计算机科学,2015,5:28-33.

[27] 余凯,贾磊,陈雨强,等.深度学习的昨天、今天和明天[J].计算机研究与发展,2013,9:1799-1804.

[28] Geoffrey Hinton. Where do features come from?[J]. Cognitive Science,38(6):1078-1101.

[29] Andrej Karpathy, Li Fei-Fei. Deep Visual-Semantic Alignments for Generating Image Descriptions[DB/OL]. http://cs.stanford.edu/people/karpathy/cvpr2015.pdf.

[30] Geofrrey Hinton, Oriol Vinyals, Jeff Dean. Distilling the Knowledge in a Neural Network[DB/OL]. http://www.cs.toronto.edu/~hinton/absps/distillation.pdf.

[31] ABDEL-HAMID O, MOHAMED A, JIANG H, et al. Convolutional neural networks for speech recognition[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing,2014,22(10):1533-1545.

[32] 赵冬斌,邵坤,朱圆恒,等.深度强化学习综述:兼论计算机围棋的发展[J].控制理论与应用,2016,6:701-717.

[33] CARLSON B A, CLEMENTS M A. A projection-based likelihood measure for speech recognition in noise[J]. IEEE Transactions on Speech and Audio Processing,1994,2(1):97-102.

[34] OUYANG W, ZENG X, WANG X. Learning mutual visibility relationship for pedestrian detection with a deep model[J]. International Journal of Computer Vision, 2016, DOI: 10.1007/s11263-016-0890-9.

[35] PINHEIRO P, COLLOBERT R. Recurrent convolutional neural networks for scene labeling[C]//Proceedings of the 31nd International Conference on Machine Learning. Beijing: ACM,2014:82-90.

Review of Deep Learning Development

HOU Yuqingyang QUAN Jicheng WANG Hongwei

(The Aviation University of Airforce, Changchun 130000)

Considering deep learning’s value of researching and applying and the importance in academic and industry area, this paper reviews the main stream deep learning network models and gives theirs introduction. First, the history of deep learning is introduced. According to applying research, four deep learning network of the main streams are introduced. Second, the developing state of current deep learning is summarizedfrom five aspects which are network performance improvement, net system development, the new learning model to explore, deep reinforce learning and visualization theory research. Last, development prospect of deep learning comes up. Although deep learning outperform other methods abviously in different fields, there are still some issues needed to be solved, such as intelligence of deep learning improvement, raising the utilization ratio of data without labels.

deep learning, convolution neural network, semi-supervised learning, deep reinforce learning, artificial intelligence

2016年10月8日,

2016年11月29日

侯宇青阳,女,硕士研究生,研究方向:控制科学与工程、图像处理、模式识别。全吉成,男,博士研究生,研究方向:图像处理,人工智能。王宏伟,男,博士研究生,研究方向:图像处理,人工智能,虚拟现实。

TP18

10.3969/j.issn.1672-9730.2017.04.002