人工智能芯片产业现状

蒋阿芳 中国信息通信研究院泰尔终端实验室高级工程师

纪学毅 中国信息通信研究院泰尔终端实验室硕士研究生

1 引言

随着A lphaGo将AI带入人们的视野,AI逐渐被人们认为是下一个“互联网”类颠覆行业的技术。人工智能的发展正处在第三次高潮,看重AI技术带来的巨大市场潜力,科技巨头们纷纷布局人工智能产业链,具体来讲有3种方式,即打造AI开源平台、布局AI芯片、布局AI核心技术。

人工智能领域是一个数据密集的领域,传统的数据处理技术难以满足高强度、大数据的处理需求。AI芯片的出现让大规模的数据效率大大提升,加速了深层神经网络的训练迭代速度,极大地促进了人工智能行业的发展。

人工智能芯片作为人工智能行业的重要底层架构,其战略重要性不言而喻。如图1所示,AI芯片位于基础层中的计算能力部分。AI芯片作为产业核心,也是技术要求和附加值最高的环节,除了本身的产业价值外,其战略地位也远远大于应用层创新。

目前,AI芯片行业的整体情况是进入门槛偏高,如FPGA领域,有多达9000项的专利,知识产权壁垒较高,Intel也是耗资167亿美元收买了A ltera,从而获得了进入FPGA领域的入场券。且FPGA整个的市场总额偏小,2016年仅为50亿美元,有9成还落入赛灵思和Altera两家公司,另外两类如GPU、ASIC也有相同的情况。同时,芯片行业的整体投入时间较长,一般从研发到产品真正规模化生产需要近7年的时间。

2 AI芯片分类

芯片又叫集成电路,按照功能不同可分为很多种,有负责电源电压输出控制的,有负责音频视频处理的,还有负责复杂运算处理的。算法必须借助芯片才能够运行,而由于各个芯片在不同场景的计算能力不同,算法的处理速度、能耗也就不同。在人工智能市场高速发展的今天,人们都在寻找能让深度学习算法更快速、更低能耗执行的芯片。

人工智能芯片分类如图2所示。从技术架构角度分类,主要包括GPU、FPGA、ASIC以及类脑芯片,在人工智能时代,它们各自发挥优势,呈现出百花齐放的状态;从市场需求角度来讲,AI芯片可分为两大使用场景,即训练(Training)和推断(Inference)。AI芯片共3类,即训练需求(基于云端设备端需求目前不明确)、基于云端的推断需求和基于设备端的推断需求。

2.1 技术架构角度分类

(1)GPU

GPU最初是作为应对图像处理需求而出现的芯片。其特点为擅长大规模并行运算,可以平行处理大量信息。在人工智能技术发展早期,因其优异的大规模数据处理能力,GPU被使用在多个项目之中。在图像识别、棋牌类博弈、辅助驾驶系统和无人驾驶试验中,均使用了GPU作为加速芯片。

图1 AI芯片在人工智能产业要素中的位置

图2 AI芯片分类

然而,从芯片底层架构来讲,由于GPU并非专为深度学习设计的专业芯片,未必为人工智能加速硬件的最终答案。目前,GPU的设计和生产均已非常成熟,在集成度和制造工艺上具有优势,因而从成本和性能的平衡来讲,是当下人工智能运算的很好选择。

(2)FPGA

FPGA全称为“可编辑门阵列”(Field ProgrammableGateArray),它是一种通用型的芯片,设计更接近于硬件底层的架构,其最大特点是可编程。基于可编程的特点,用户可以通过FPGA配置文件来实现应用场景的高度定制,进而实现高性能、低功耗。FPGA成本较高,更适用于企业用户,尤其是可重配置需求较高的军事和工业电子领域。此外,互联网企业也都有专门做FPGA的团队为服务器加速。FPGA在深度学习加速方面具有可重构、低功耗、可定制和高性能等特点。当然,FPGA也存在硬件编程困难,且尚未形成统一的编程模型,重用方面也是一大难题。

(3)ASIC

ASIC全称为“专用集成电路”(ApplicationSpecific Integrated Circuits),对应特定应用场景,针对特定用户需求的专用类芯片。假如把FPGA比作科研研发专用芯片,那么ASIC就是确定应用市场后,大量生产的专用芯片。基于此,厂家可以针对特定用户场景使用FPGA进行研发,当算法成熟、芯片设计固定后可以以ASIC的方式进行大规模生产。因此,作为全定制设计的ASIC芯片,针对适用的应用场景,ASIC的性能和能耗都要优于市场上的现有芯片,包括FPGA和GPU。目前,人工智能类ASIC的发展仍处于早期。其根本原因是,ASIC一旦设计制造完成后电路就固定了,只能微调,无法大改。而硬件的研发设计与生产成本很高,企业很难贸然尝试。此外,能设计出适用于人工智能芯片的公司必然是要既具备人工智能算法又擅长芯片研发的公司。

代表性的ASIC芯片即TPU(Tensor Processing Unit)是Google研发的一款针对深度学习加速的ASIC芯片,第一代TPU仅能用于推理,而目前发布的TPU 2.0既可以用于训练神经网络,又可以用于推理。TPU2.0包括4个芯片,每秒可处理180万亿次浮点运算。Google还找到一种方法,使用新的计算机网络将64个TPU组合到一起,升级为所谓的TPUPods,可提供大约1.15万万亿次浮点运算能力。目前,Google并不直接出售TPU芯片,而是结合其开源深度学习框架TensorFlow为AI开发者提供TPU云加速的服务,以此发展TPU2的应用和生态,比如TPU2同时发布的TensorFlow ResearchCloud(TFRC)。

(4)类脑芯片

类人脑芯片架构是一款模拟人脑的新型芯片编程架构,这种芯片的功能类似于大脑的神经突触,处理器类似于神经元,而其通讯系统类似于神经纤维,可以允许开发者为类人脑芯片设计应用程序。通过这种神经元网络系统,计算机可以感知、记忆和处理大量不同的情况。

IBM从2008年开始研究能模拟人类大脑的芯片项目,2014年推出首个基于SyNAPSE打造的TrueNorth芯片,该芯片内置100万个模拟神经元和2.56亿个模拟神经突触。不同芯片还可以通过阵列的方式互联。据称48颗芯片组建成的具有4800万个神经元的网络,智力水平已经和普通老鼠大脑差不多。

Neural/Neuromorphic Processing Unit为神经/神经形态处理器,更多的时候被称为“神经形态芯片(Neuromorphic Chip)”或者是“类脑芯片(Brain-Inspired Chip)”。这类AI芯片不是用CNN、DNN等网络形式来做计算,而是以更类似于脑神经组成结构的SNN(Spiking Neural Network)的形式来进行计算。2013年10月,高通研发的Zeroth处理器就隶属于NeuralProcessingUnits(NPUs)范畴,其试图通过模拟人脑的方式对外界刺激做出反应,从而“学”到东西,避免程序员再写代码。总体来看,类脑计算芯片领域仍处于探索阶段。

(5)小结

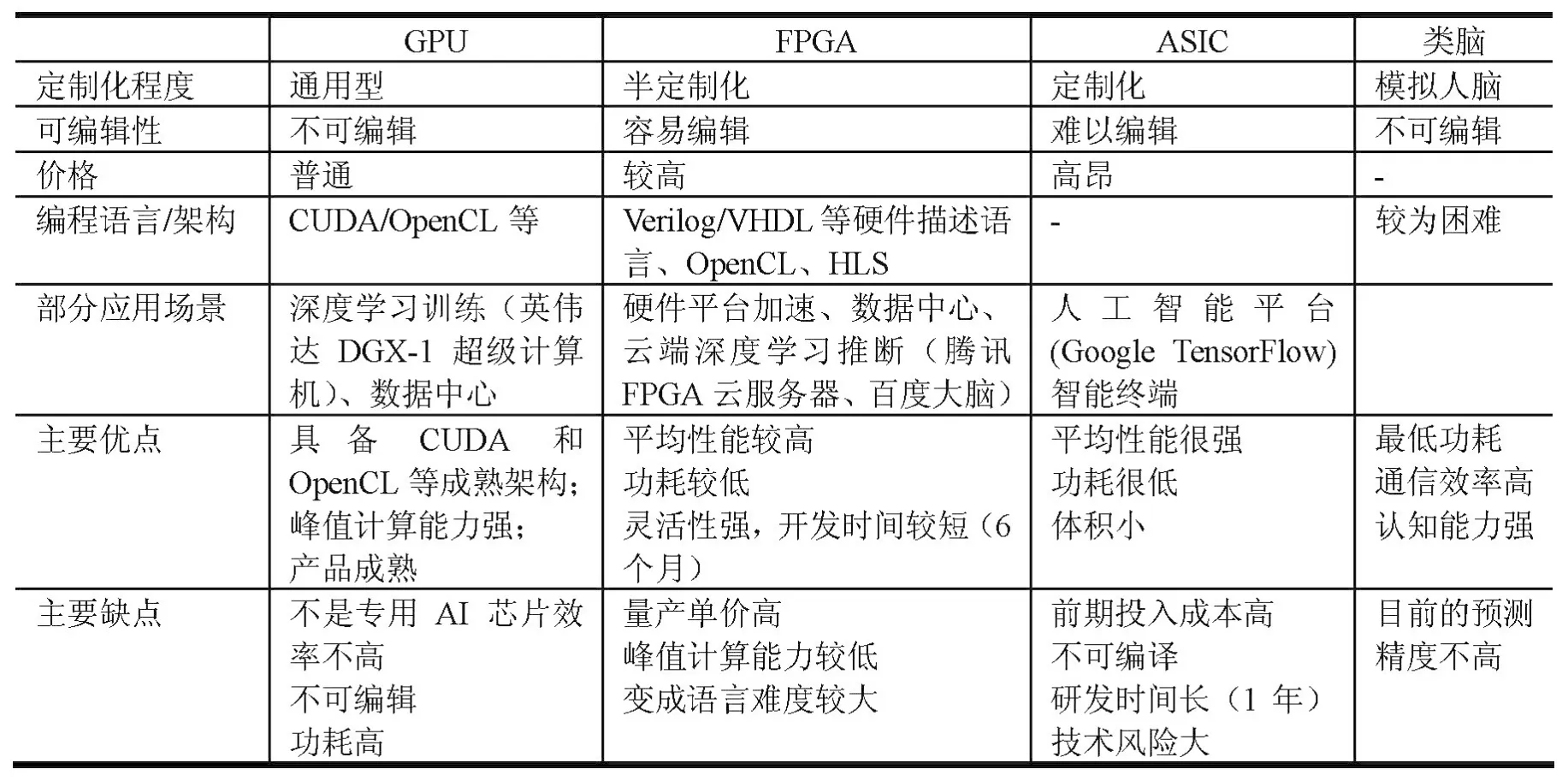

芯片定义了产业链和生态圈的基础计算架构,正如CPU是IT产业的核心一样,芯片也是人工智能产业的核心。对AI芯片按技术架构角度分类,表1列出了主要的4类型芯片对比。

表2进一步对表1中已经发布的具有代表性的芯片从计算能力角度进行了对比,因类脑芯片仍处于探索阶段,且采用非冯诺依曼架构,表中没有对其进行对比。其中,GPU选取的是NVIDIA的TeslaK40,FPGA选取的是Xilinx的V7-690T,ASIC选取的是寒武纪的DIANNAO。从表中的对比来看,能耗比方面为ASIC>FPGA>GPU。

2.2 市场需求角度分类

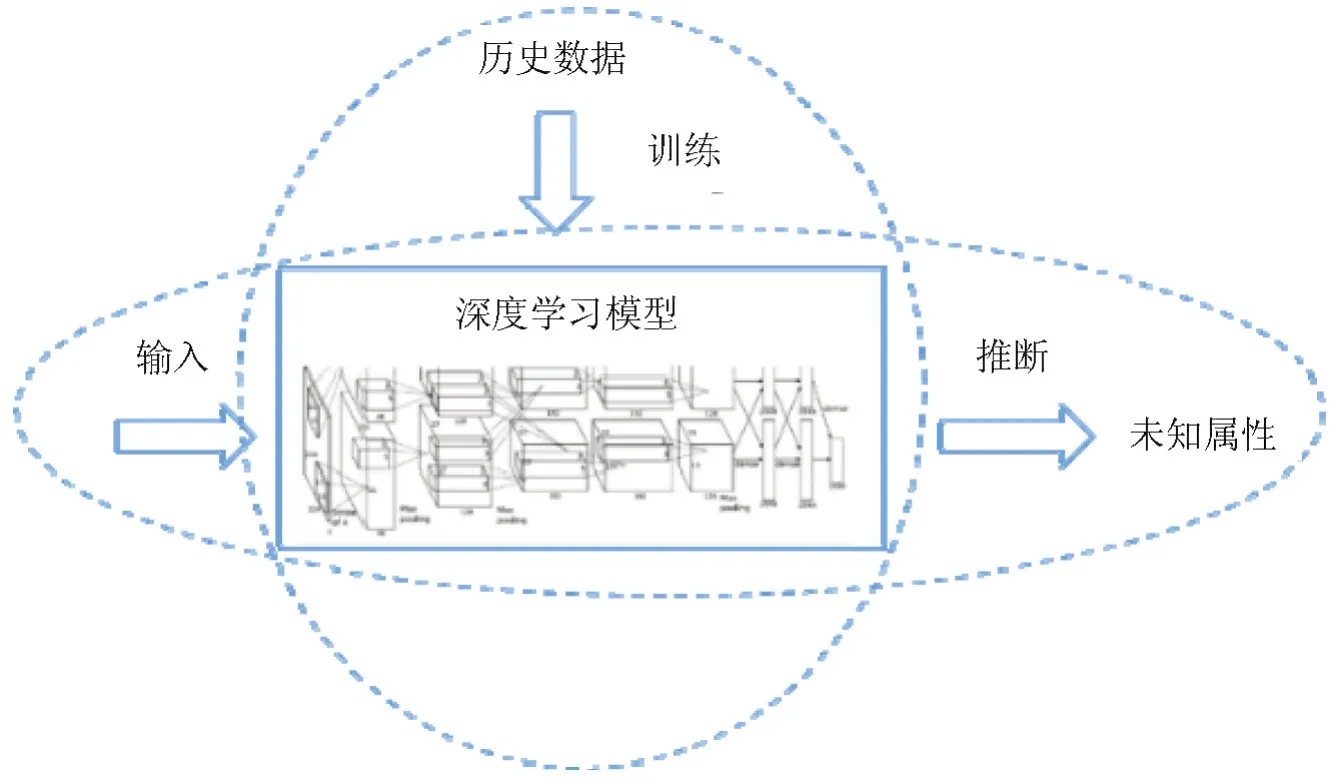

作为推动第三次浪潮的人工智能核心算法,深度学习是机器学习领域的一个重要研究方向,一项深度学习工程的搭建,可分为训练(Training)和推断(Inference)两个环节(见图3)。

(1)训练环节

通常需要通过大量的数据输入,或采取增强学习等非监督学习方法,训练出一个复杂的深度神经网络模型。训练过程由于涉及海量的训练数据和复杂的深度神经网络结构,运算量巨大,需要庞大的计算规模,对于处理器的计算能力、精度、可扩展性等性能要求很高。目前,在训练环节主要使用NVIDIA的GPU集群来完成,Google自主研发的ASIC芯片TPU2.0也支持训练环节的深度网络加速。

(2)推断环节

指利用训练好的模型,使用新的数据去“推理”出各种结论,如利用后台训练好的深度神经网络模型,判断一张输入图片中的目标类别。虽然推断的计算量相比训练少很多,但仍然涉及大量的矩阵运算。在推理环节,GPU、FPGA和ASIC都有很多应用价值。

目前,从市场需求角度来讲,AI芯片主要可分为3类,其相关企业分布如图4所示。

(1)训练需求,面向各大人工智能企业及实验室研发阶段。

(2)基于云端的推断需求,Face++、出门问问、Siri等主流人工智能应用均通过云端提供服务。

(3)基于设备端的推断需求,面向智能手机、智能摄像头、机器人/无人机、自动驾驶、VR等设备的设备端推理市场,需要高度定制化、低功耗的AI芯片产品。例如,华为麒麟970搭载了“神经网络处理单元(NPU,实际为寒武纪的IP)”、苹果A11搭载了“神经网络引擎(NeuralEngine)”。

表1 技术架构角度的主要4类AI芯片对比

表2 性能与功耗对比

3 我国面临的机遇与挑战

图3 深度学习工程搭建的两个环节

人工智能,特别是深度学习,这几年呈爆发性的发展,很大程度上得益于芯片技术多年的积累。如果不是芯片技术已经发展到了一定的高度,能够给大规模的机器学习提供足够的处理能力,就没有战胜人类顶尖棋手的A lphaGo。过去十几年驱动芯片技术发展的主要是通信,即多媒体和智能手机这些应用。而随着这些应用增长放缓,芯片技术发展已经逐步转向了AI领域,AI的驱动效应将在芯片技术上会有更明显的体现。

图4 AI芯片行业布局动态

作为一项计算密集型的新技术,人工智能早期可以依靠通用芯片的性能来迅速发展,而后期则必须依靠专用芯片的出现才能统治市场。人工智能芯片的发展将会从通用走向专用(见图5),定制的硬件才能实现更优的功耗效率,满足不同算法、结构、终端和消费者的需求,实现规模化的收益。同时,通用芯片与专用芯片永远都不是互相替代的关系,二者必须协同工作才能发挥出最大的价值。

图5 AI芯片发展路径

近年来,虽然我国在核心芯片集成能力上大幅提升,但由于核心芯片关键技术缺失,因此在实际设计和生产中仍需要大量引进发达国家和地区的技术和产品。另外,从产业链来看,AI芯片可分为设计、制造和封装3个主要环节,其中设计环节需要EDA和逻辑电路设计验证等软硬件平台的支撑,芯片制造和封装环节需要相关材料和技术的支撑。

随着我国政府不断加大对于人工智能和芯片领域的投入,接下来几年将是我国AI芯片技术和市场成熟的重要阶段,未来产业竞争格局将取决于这几年各企业的技术和市场发展情况。在这种情况下,我国应抓住这一时间窗口,坚持集成创新的思路,通过引人成熟技术,实现AI芯片产业的“弯道超车”。

同时需要认识到的是,AI芯片除了本身的产业价值外,其战略地位也远远大于应用层创新。在巨大的国际竞争压力下,需要多方合作,才能够在AI时代从战略层面占有一席之地。

[1]王冲鶄.人工智能技术与产业发展态势分析[J].电信网技术,2017(7):46-51.

[2]腾讯研究.中美两国人工智能产业发展全面解读.[DB/OL].http://www.tisi.org/4924.August2,2017.

[3]张军阳,王慧丽,郭阳,等.深度学习相关研究综述[J/OL].计算机应用研究,2018(2017-08-18).

[4]Chen T,Du Z,Sun N,et al.DianNao:a small-footprint highthroughput accelerator for ubiquitous machine-learning[J].Acm SigplanNotices,2014,49(4):269-284.

[5]战略前沿技术.AI芯片产业生态梳理.[DB/OL].https://wx.abbao.cn/a/4816-c7ec9c4445fa3d0e.htm l.