基于动态指导滤波的显著性检测方法

王 晨, 樊养余

(1. 西北工业大学电子信息学院, 陕西 西安 710072;2. 空军工程大学航空航天工程学院, 陕西 西安 710038)

0 引 言

显著性检测研究源于人类视觉的独特性、不可预测性、稀缺性以及奇异性。利用计算机模拟人眼视觉的这项功能就是如何在获取图像的第一步就定位显著性物体并将它从场景中突显出来。早期显著性检测研究是基于认知心理学和神经学发展起来的。随着计算机视觉技术的日新月异,图像的显著性区域检测技术已经成为这个领域研究的一个热点。这项技术被应用到图像处理的多个领域,例如图像分割[1]、目标识别[2]、图像压缩[3],以及图像检索[4]等。目前人们将显著性检测方法大致分为两类,一类为自下而上的方法[5-8]。这类方法的特点是不需要人的干预就可以自动检测,由数据驱动。它关注的是如何利用已有的视觉理论来定位图像和场景中的显著性区域。另一类为自上而下的方法[9-10]。这类方法更关注在人的主观意识干预下的显著性检测。本文的研究属于由数据驱动的显著性检测方法。

1 相关研究

在众多的显著性检测算法中应用最早,也是最成功的是基于对比度的显著性检测方法。对比度是影响视觉显著性的最重要因素。在现有研究成果中,绝大部分算法都加入了像素或区域之间的对比度信息来建模。基于对比度的显著性检测方法大致也可以分为两类:一类是基于局部对比度的;另一类是基于全局对比度的。其中利用局部对比度的显著性检测方法是通过计算像素或区域的邻域对比度来衡量自身的显著程度[11-12]。不同算法中邻域大小的选取方法也不尽相同。由于进行的是局部对比,此类算法更趋向于突显边缘周围区域,并不能有效突显整个显著区域。这会使显著性图中,边缘比显著性区域内部具有更高的显著性值。另一类基于全局对比度的方法则是将整个场景或整幅图像作为基准来计算像素或区域的显著性[13-15]。但是由于算法使用的全局信息是图像的平均信息,因而处理效果一般。当显著性区域非常大或者图像背景复杂时,此类方法就会趋向于强调背景区域,而非真实的显著性区域。因此,在显著性图中会存在“图像背景显著”的问题。

近年来有研究者将双边滤波(bilateral filtering, BF)引入到显著性检测领域,提出新的显著性检测方法[16-18]。双边滤波[16]是一种非线性的滤波方法,是结合图像的空间邻近度和像素值相似度的一种折中处理,同时考虑了空域信息和灰度相似性,达到保边去噪的目的。但是由于双边滤波本身的计算量较大,图像进行一次双边滤波需要较长的时间,所以它并不适合图像的预处理。

基于此,本文提出了一种新的基于动态指导滤波的显著性检测方法。相对于双边滤波而言,指导滤波是一种更简单且高效的滤波器,它可以在保证滤波效果的同时,大大缩减滤波的时间。本文算法从以下几方面对以往检测算法进行了改进:

(1) 设计简单的动态迭代指导滤波器,采用动态指导图像,有效地将图像中的主要显著性区域保留下来,使指导滤波更适合进行显著性检测;

(2) 指导滤波兼顾了像素间的邻近度和灰度之间的相似性,可以有效地改善传统基于对比度算法“不一致显示”和“突出背景”的问题;

(3) 利用显著性检测的结果建立关键点集合,通过生态学方法可以获得更完整的显著性区域,实现显著性区域的准确提取。

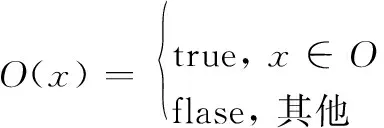

2 经典指导滤波

指导滤波[19](guided filtering, GF),又称为引导滤波,是基于局部且保持边缘的图像平滑滤波方法。它是需要指导图的滤波方法,且指导图可以是单独的图像或者原始输入图像本身。设滤波结果图像为q,输入图像为p,指导图像为I,则GF可以定义为

qi=∑jWij(I)pj

(1)

式中,i与j为像素的索引值;滤波核Wij为I的函数且独立于p。

GF的滤波过程实际上可以看成是输入图像p的一个线性变换,滤波核函数[19]定义为

(2)

式中,μk和σk分别为指导图像I在窗口ωk中的均值与方差;ε是控制图像平滑程度的参数,ε越大,平滑程度越大。从核函数的表达式可以看出它也只与指导图像有关。若指导图像不是原始图像,则此核函数就与原始图像无关。

与双边滤波不同,GF的算法运行时间与窗口半径无关。因此滤波核的尺寸不会影响滤波器的计算效率。另外,GF的图像滤波效果与双边滤波相当,但比双边滤波的处理速度要快。

利用GF的上述特点,本文提出了基于动态GF的显著性检测算法。该算法采用滤波的结果更新指导图像,使指导图像由静态变成动态,从而实现结构信息的更好传递。相对于其他滤波方法,本文方法可以使显著性目标的内部得到高效均匀地显示。

3 动态GF

3.1 简单迭代GF设计

GF的目标是将指导图像(或信号)的结构传递给待滤波图像(或信号)。它的显著缺陷就是这种数据依赖型的框架不能很好地处理指导图像与待滤波图像结构上的不同之处。因此,文献[20]设计了新的迭代GF器,将图像的滤波问题变成一个非凸的优化问题。该方法利用了静态和动态指导图像的联合正则化,其中静态指导图像在优化过程中是不变的,算法利用由它确定的相似矩阵来影响滤波结果。动态指导图像考虑了输入图像与指导图像之间的关系,由输入图像影响的相似矩阵确定指导图像。该滤波方法可以成功地应用到深度超分辨率图像和尺度滤波及去纹理等场合。但是由于迭代次数过多、计算复杂度高,使得该滤波方法的时间成本过大。借助上述算法的思想,在满足显著性检测的精度要求下,本文在经典GF的基础上,设计了一种更简单动态迭代GF方法。

设第t次GF的结果为qt,用原始图像p作为第一次GF的指导图像I,则滤波结果图像为q1。然后,将滤波结果图像q1作为新的指导图像进行再一轮的GF。利用每次滤波图像与上一次滤波结果之间的差异性判断滤波器是否需要再次滤波, 这个差异性定义为

(3)

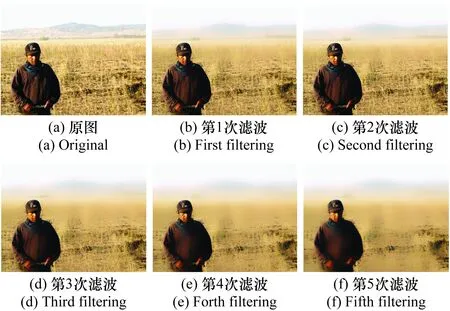

式中,bw()表示图像的二值化。因为GF是低通滤波器的一种,滤波的过程会平滑图像中原有的一些细节信息,所以随着滤波次数的增加,滤波图像与原始图像的差异会越来越大,如图1所示。当两次滤波图像的差异小于等于实验中给定的阈值时,可以近似认为滤波已经将背景和目标内部的纹理和细节平滑完成。此时,迭代结束。

图1 迭代GFFig.1 Iterated GF

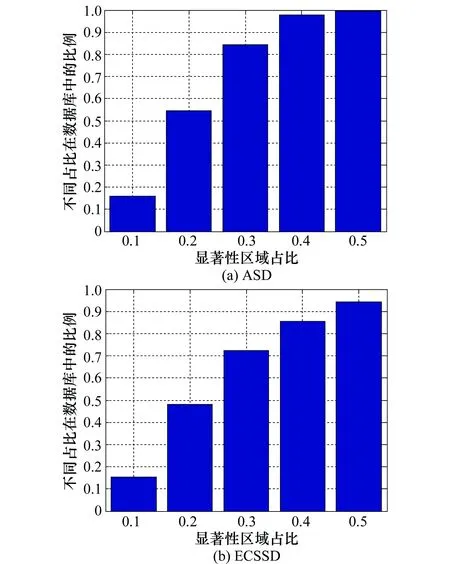

另一方面,重复的GF在得到图像大体轮廓的同时也可能丢失一些十分重要的结构信息。为了防止过度平滑,本文将在阈值的控制上加入显著性区域的指导信息进行阈值的设定。在图像数据库ASD和ECSSD上进行显著性区域在图像中占比的统计,如图2所示。

图2 显著性区域在不同数据库图像上的占比统计Fig.2 Proportion of salient region in images on different databases

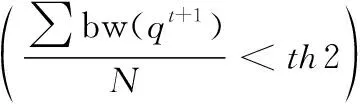

可以看出,ASD数据库中显著性区域不超过图像面积40%的图像占数据库总量的98%,在ECSSD数据库中由于图像的背景大多复杂,这个指标有所下降,但也超过85%。因此,本文假设大多数图像的显著性区域不超过图像面积的40%,即显著性区域在图像面积中的占比小于等于0.4,因此,迭代的停止标准修正为

(4)

式中,N表示图像中像素的数量。本文将不同滤波结果图像之间的差异度控制在10%左右,因此设定th1=0.1。在式(4)中第2项表示从第t+1次滤波图像中粗略提取的显著性,设其应不大于图像总面积的40%,即th2=0.4. 如式(4)所示,当两项中有任意一项为真时,变量T都为真,则迭代停止。当变量T为假时,将滤波结果图像作为新的指导图像进行下一次GF,即

(5)

(6)

利用新定义的滤波核进行GF时,在图像像素强度变化不大的区域(或单色区域),核函数括号中第2项近似为0,这时相当于均值滤波。而在变化大的区域,即物体的边缘轮廓时,当像素位于边缘的不同边时,核函数括号中的值近似为0,对图像的平滑滤波效果减弱,边缘保持下来。上述两种情况下,像素在原始图像p与滤波结果qt中的值相近,滤波会使均匀区域变得更均匀,边缘区域突显。另一方面,当p与qt中像素值差异较大时,也就是说经过t次GF后,原始图像的某些纹理被平滑掉,这时滤波图像qt与原始图像p差异可能会变大,由于平滑的作用,此时核函数中(qt-μk)的值会很小,仍近似相当于均值滤波,这一点与传统GF不同。显然,迭代动态GF比传统GF更有助于保留图像基本结构和平滑纹理。当然,与传统GF的定义类似,ε的作用还是界定什么是变化大,什么是变化小。在窗口大小不变的情况下,随着ε增大,滤波效果越明显。

在这个改进的GF器中,本文利用了动态指导图像和输入图像的联合结构信息设计新的核函数Wij,所以它可以很好地保证指导图像对原输入图像的结构传递性。显著性检测通常是其他具体图像处理领域相关算法的预处理技术,它的目标是准确定位显著性目标区域即可。因此,为了节约算法的时间成本,参考文献[20]中实验数据,本文提前预设迭代的最大次数为5。如图1所示,随着迭代次数的增加,图像中的细节逐渐被平滑,显著性区域逐渐突显出来,本文利用最终的滤波结果生成显著性图为

(7)

式中,q表示迭代GF的结果;S表示得到的显著图。

综上所述,本文利用动态指导图像与原始图像的联合结构信息,通过迭代的方式设计简单的动态指导滤波器来实现图像的视觉显著性检测。虽然本文设定了最高的迭代次数来防止过多迭代造成的细节损失与时间消耗,但是迭代的引入还是会带来时间成本的上升。因此,本文为设计的滤波器进行以下的加速处理。

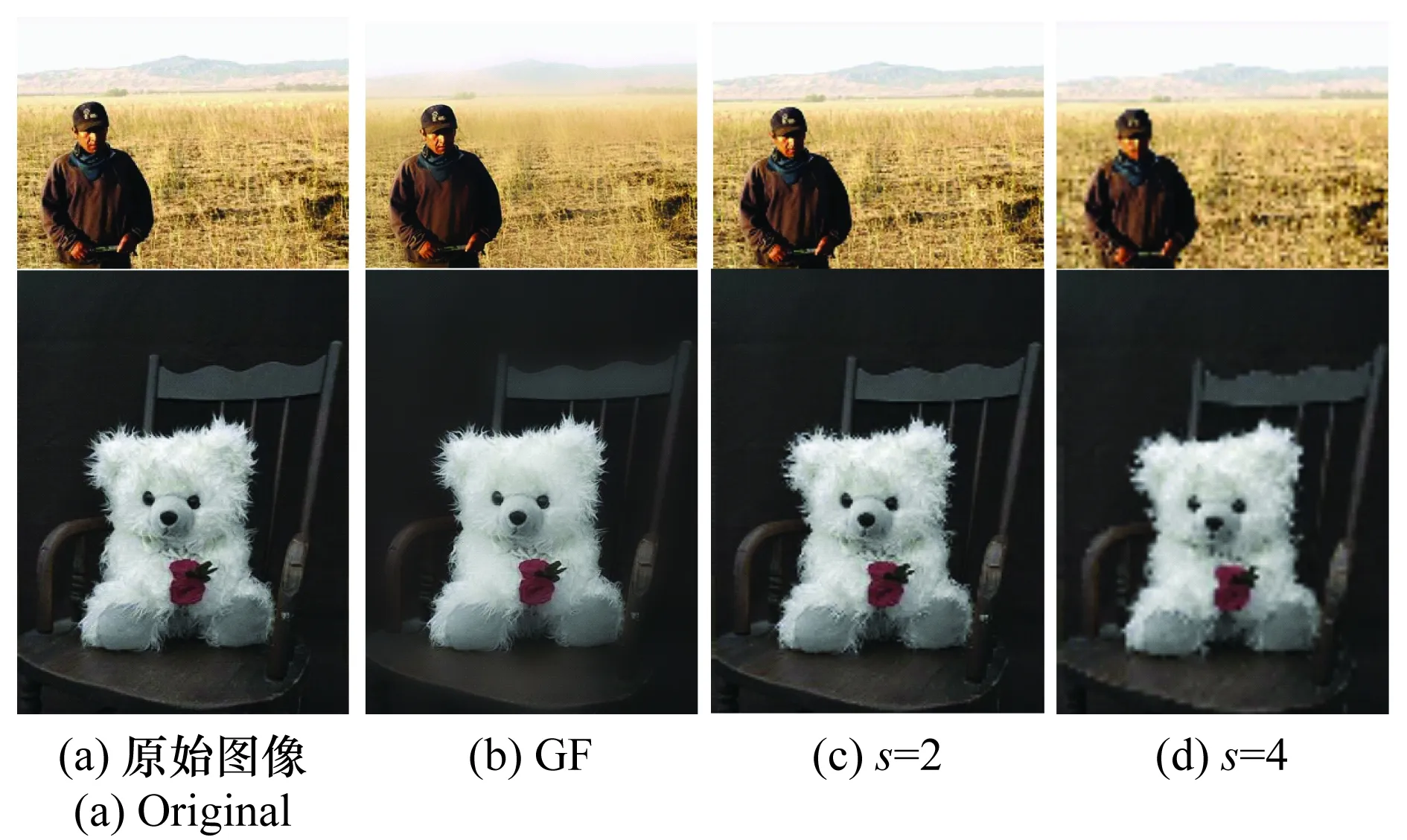

3.2 滤波器的加速

为了进一步节约算法的时间成本,本文将设计的GF器进行改进。如式(5)和式(6)所示,在GF器中主要的计算量是核函数。然而,事实上它并不需要在全分辨率下进行,本文通过下采样的方式缩小计算所需图像,进而降低计算中需要的计算量。设图像的像素数量为N,下采样的比率为s,此方法可以将Boxfilter的计算量从O(N)降到O(N/s2)。最后再用双线性插值方法将得到的滤波结果图像恢复到原始图像尺寸,如图3所示。其中图3(c)和图3(d)是分别使用比率为2和4时GF的结果,与正常图像尺寸GF结果相比,图像质量有一些下降,但并不明显,对于显著性区域检测来说是可以接受的。

图3 GF的加速Fig.3 Acceleration of GF

4 基于动态GF的显著性检测

4.1 算法框架

算法的整体框架如图4所示。

图4 本文算法结构Fig.4 Framework of the proposed algorithm

其基本步骤如下:

步骤1以原始图像作为指导图像对图像进行第1次初始GF,再以滤波结果图像作为新的指导图像,通过新的核函数进行下一次滤波(见图5)。

步骤2将两次的滤波结果进行相似性评价,当差异度大于设定阈值或粗糙显著性区域的面积大于设定面积时,以本次滤波结果作为新的指导图像,进行再次GF。直到上述条件满足其一,迭代结束。

步骤3利用滤波结果和式(7)计算显著图。

步骤4基于显著图,通过生态学膨胀得到关键显著性窗口,并进一步提取图像的完整显著性目标区域。

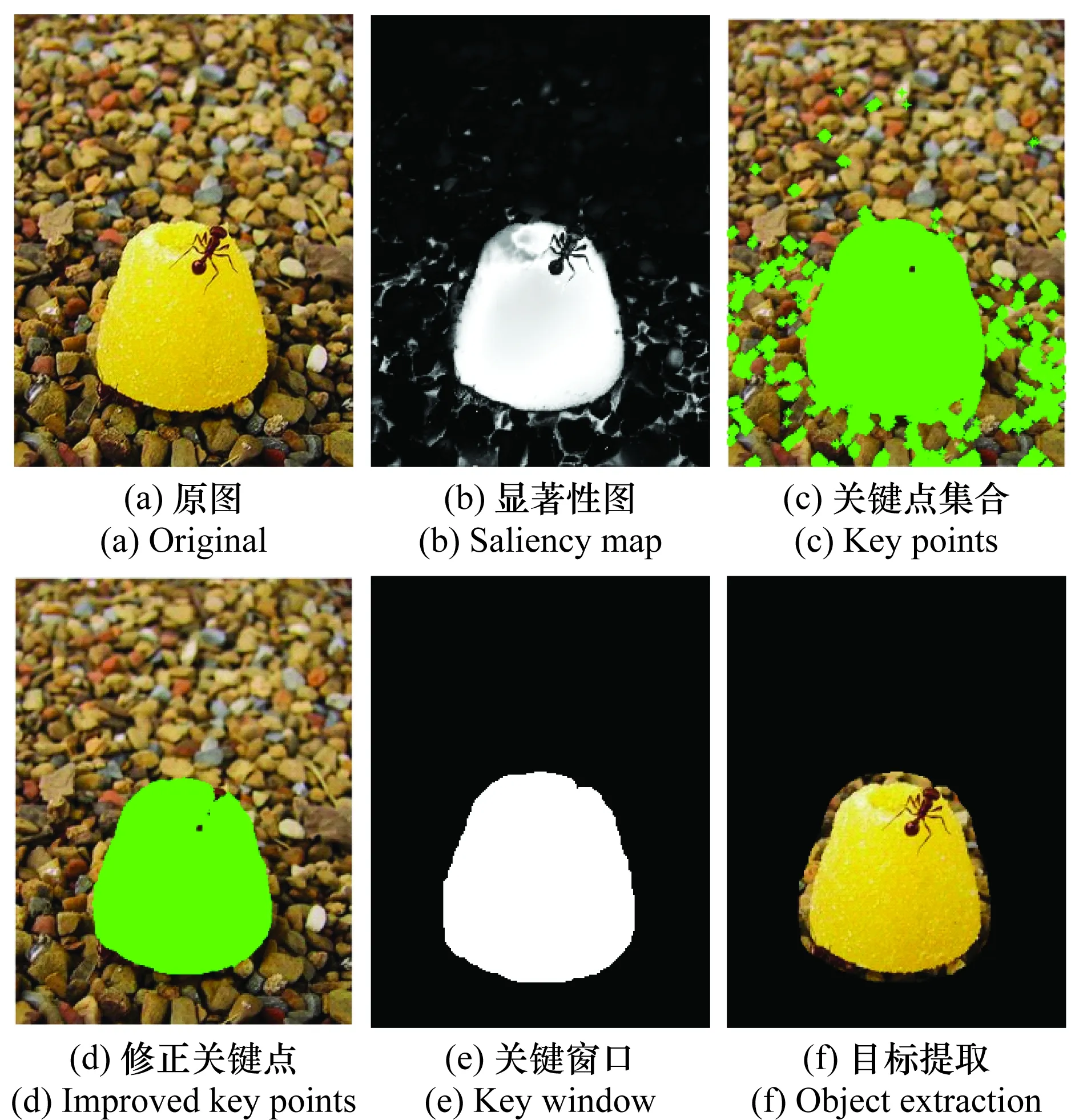

图5 关键显著性目标区域提取Fig.5 Key salient object region extraction

4.2 关键显著性区域提取

经过迭代GF的结果图像,初步突显了显著性目标,如图1(f)所示。但是若图像中存在大的背景干扰区域,上述方法并不能消除或减弱其对显著性目标的影响,通常干扰背景区域会和显著性目标一样被突显出来。为了解决这一问题,本文引入了关键显著性目标检测,通过简单的阈值技术聚焦目标区域。

Gestalt原理[21-22]指出人类的视觉观察一般只关注场景中的一个或几个中心区域,而对其他区域关注程度较差。但事实上,通过不同的显著性检测算法得到的显著性图中往往会呈现出多个显著区域。因此,这项研究是指如何在图像中突显关键目标的区域,同时弱化非关键目标区域的过程。

基于此,本文对得到的初级显著性图进行进一步处理,从而保证关键区域的显著性尽可能多的高于其他区域。也就是在显著性检测方法中加入显著区域关键性判别过程,形成关键显著性检测方法。关键性的确定是通过简单阈值的方法,即

(8)

式中,N是显著性图像中像素的数量。式(8)保证了阈值TH在均值和最大值之间。α越大,TH越接近均值,关键点越多。在实验中,α=0.5是一个很好的选择,如图5(c)和图5(d)所示。

然后通过生态学膨胀算法将修正的关键点集合扩大,得到关键区域范围,通过定位的关键区域可以将显著性目标完整提取:

O=BW⊕t

(9)

式中,t为膨胀半径;BW为通过阈值得到的关键点集合的二值图像;O为关键区域图像,如图5(e)所示。

利用关键区域图像进一步提取原图的显著性区域e(x),即

e(x)=extract(p,O)

(10)

5 实验结果与分析

本文在文献[23]提供的公开测试集ASD上测试了提出算法。测试集不仅提供了较多的测试图像,并且由人工精确标注了显著性区域。

本文实验内容分为3部分。第1部分:与传统基于对比度方法的对比实验,可以从得到的灰度显著性检测结果图像比较检测的效果。第2部分:与近期发表的基于双边滤波的显著性检测方法进行对比实验,从得到的显著性区域提取结果比较检测的有效性。第3部分:将检测结果进行二值分割,用得到的二值结果比较算法的准确性,并在测试数据库上计算平均准确率、召回率、F值。

5.1 与传统方法的对比实验

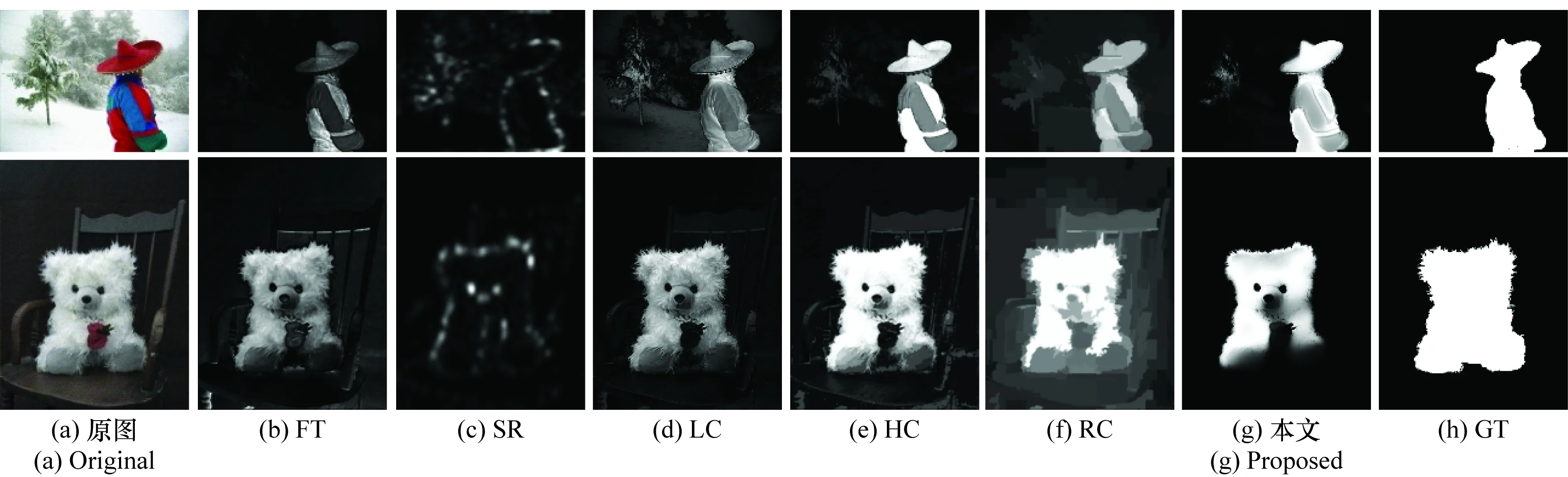

本文将提出算法与FT(frequency tuned)[14]、SR(spectal residual)[24]、LC(large contrast)[13]、HC(histogram contrast)[15]和RC(region contrast)[15]等5种经典的基于对比度的方法进行对比实验,检测结果如图6所示。其中图6(h)表示的是由人工标注的真实图(ground truth, GT),实验将以它作为标准衡量检测结果的优劣。从结果图可以看出,本文方法比其他方法更突显显著性目标,更有效地去除了干扰目标或背景,而且显著性目标内部更均匀高亮。

图6 不同算法的显著性检测结果Fig.6 Saliency detection results of different algorithms

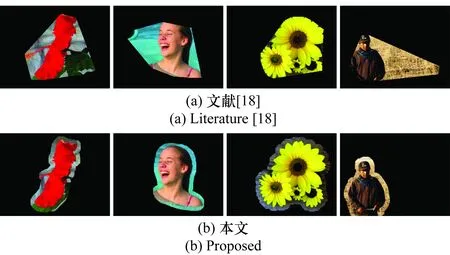

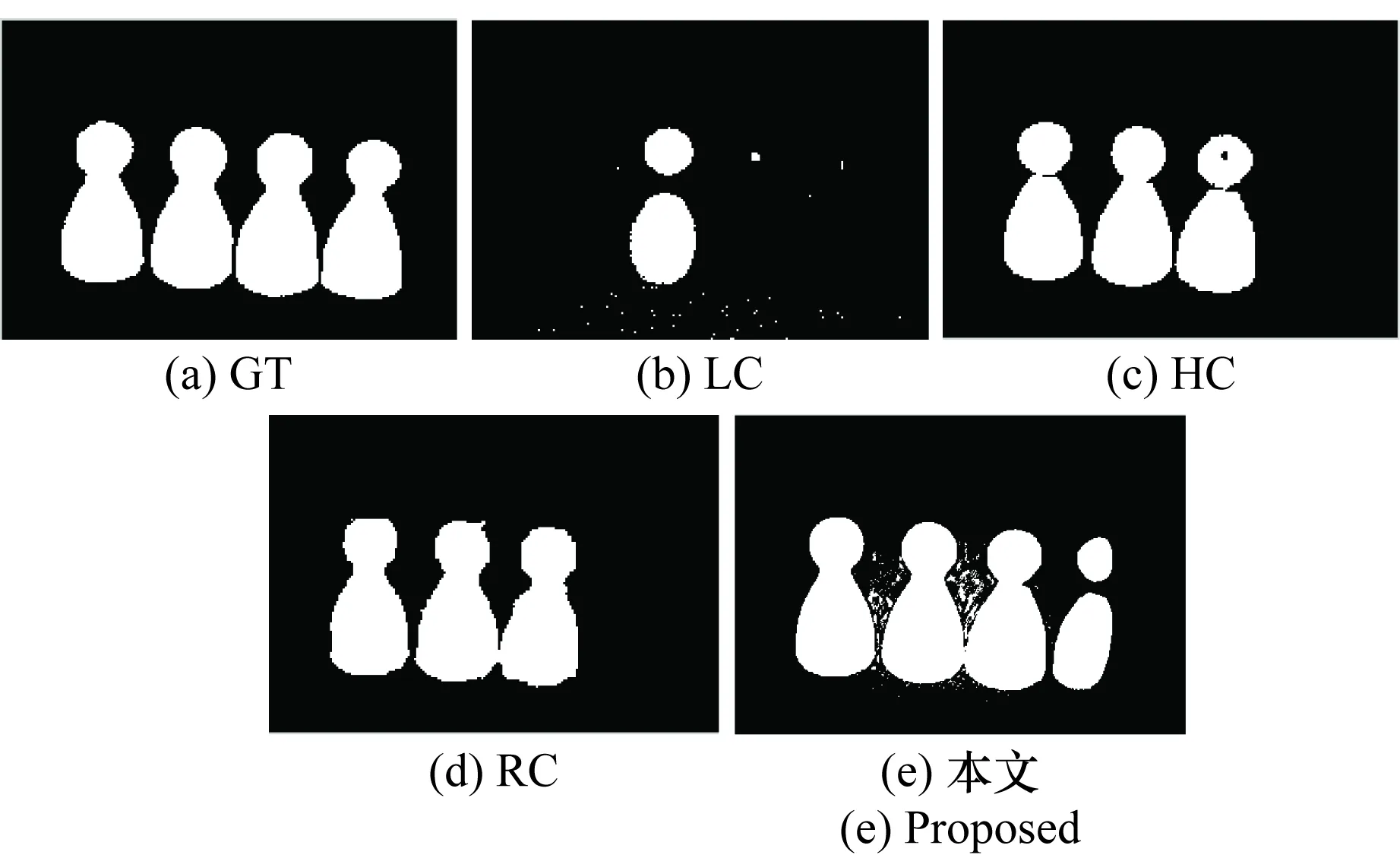

5.2 显著性区域提取实验

显著性目标区域检测技术属于许多图像处理算法的预处理技术,在不同的应用场合对显著性检测算法的要求也不尽相同。本文关注的是如何将目标区域定位并提取,为后续进一步的图像处理过程做准备。文献[18]提出算法是通过双边滤波进行显著性检测,它利用散度计算定义凸包,并成功地提取显著性目标所在区域。但是,凸包的特点决定了它并不能很好地向显著性目标区域收敛。如图7所示,本文共选择了4幅图像进行实验,从显著性区域提取结果来看,本文利用生态学膨胀算法可以提取到更贴近真实目标的显著性区域,其漏检率和误检率都更低。

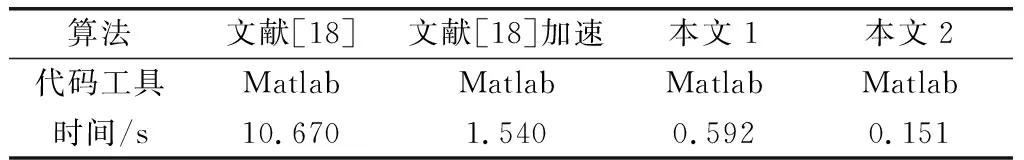

将本算法与基于双边滤波的显著性检测算法进行运行时间的对比。在本文的运行环境中,取图7中4幅测试图像的平均运行时间,如表1所示。实验的运行环境为:Inter(R)Core(TM) id-2410M CPU, 2G内存的笔记本电脑。由于传统双边滤波的计算复杂度较高,利用它进行图像滤波时需要较长的时间,表1中第2列显示的是文献[18]算法所需时间。第3列是使用权重表优化方法对文献[18]算法加速的结果。第4列和第5列分别为本文算法在全分辨率下和取采样率s=2时的结果。从表1可以明显地看出,相对于基于双边滤波的显著性检测方法,本文算法大大减少了运行所需时间。

图7 显著性区域提取实验Fig.7 Experiments of salient region extraction

算法文献[18]文献[18]加速本文1本文2代码工具MatlabMatlabMatlabMatlab时间/s10.6701.5400.5920.151

5.3 分割实验

分割实验是显著性检测中一项重要的实验内容。如图8所示,是本文对不同算法的显著性图分别进行均值分割的结果。为了更好地比较算法的性能,在实验中加入了LC、HC和RC 3种算法,很显然,本文方法的结果与真实值更为接近。为了更可靠地对比几种方法的分割结果,本实验将阈值从单一的图像均值变化为从0到255的区间,从而得到256个分割结果。然后计算每幅分割图像的精度和召回率,如图9(a)所示。从曲线图可以很明显地看出在不同召回率水平时,本文算法的精度都是最高的。

图8 显著区域的分割结果Fig.8 Segmentation result of saliency regions

图9(b)表示的是相应的精度-召回率-F测量值的柱状图。F测量值[8]是精度与召回率的加权平均,它可以在考虑这两个因素的基础上对相应的算法给出一个综合评价。从图上可以看到本文方法的准确率、召回率与F测量值都超过了其他方法。

6 结 论

本文提出了一种简单的动态迭代GF设计思路,并将其用于显著性检测。迭代GF的使用降低了滤波结果对指导图像的依赖,利用指导图像和原图像的联合结构信息进行滤波的迭代控制,使滤波结果的结构更好与指导图像和原图像一致。通过不断迭代可以得到细节平滑且边缘保留的滤波图像。平滑的过程去除了一些干扰细节和纹理,边缘保留可以更准确地定位显著性目标区域。本文算法的显著性检测结果是要实现显著性区域的提取,为后续的图像分割或抠图等应用提供更准确,更完整的目标区域。从对比实验中可以得出,本文算法优于其他几种显著性检测算法。

参考文献:

[1] 郭传鑫,李振波,乔曦, 等. 基于融合显著图与GrabCut算法的水下海参图像分割[J]. 农业机械学报,2015,46(1): 147-152.

GUO C X, LI Z B, QIAO X, et al. Image segmentation of underwater sea cucumber using grabcut with saliency map[J]. Transactions of the Chinese Society for Agricultural Machinery, 2015, 46(1): 147-152.

[2] 薛梦霞,彭晖,刘士荣,等. 基于视觉显著性的场景目标识别[J]. 控制工程,2016,23(5): 687-692.

XUE M X, PENG H, LIU S R, et al. Scene object recognition based on visual saliency[J]. Control Engineering of China, 2016, 23(5): 687-692.

[3] 李然,李艳灵,崔子冠,等.视觉显著性导向的图像压缩感知测量与重建[J].华中科技大学学报(自然科学版),2016,44(5):13-18.

LI R, LI Y L, CUI Z G, et al. Visual saliency oriented compressive sensing measurement and reconstruction of images [J].Journal of Huazhong University of Science and Technology (Natural Science Edition), 2016, 44(5): 13-18.

[4] 赵宏伟,李清亮,刘萍萍, 等. 特征点显著性约束的图像检索方法[J]. 吉林大学学报(工学版),2016,46(2): 542-548.

ZHAO H W, LI Q L, LIU P P, et al. Feature saliency constraint based image retrieval method[J]. Journal of Jinlin University (Engineering and Technology Edition), 2016,46(2): 542-548.

[5] PERAZZI F, KRAHENBUHUL P, PRITCH Y, et al. Saliency filters: contrast based filtering for salient region detection[C]∥Proc.of the Computer Vision and Pattern Recognition, 2012: 733-740.

[6] WEI Y C, WEN F, ZHU W J,et al. Geodesic saliency using background priors[C]∥Proc.of the European Conference on Computer Vision, 2012:29-42.

[7] YANG C, ZHANG L H, LU H C, et al. Saliency detection via graph-based manifold ranking[C]∥Proc.of the Computer Vision and Pattern Recognition, 2013: 3166-3173.

[8] ZHU W J, LIANG S, WEI Y C, et al. Saliency optimization from robust background detection[C]∥Proc.of the Computer Vision and Pattern Recognition, 2014: 2814-2821.

[9] LIU T, SUN J, ZHENG N N, et al. Learning to detect a salient object [C]∥Proc.of the Computer Vision and Pattern Recognition.Minneapolis, 2007: 353-367.

[10] YANG J M and YANG M S. Top-down visual saliency via joint CRF and dictionary learning[C]∥Proc.of the Computer Vision and Pattern Recognition, 2012: 2296-2303.

[11] ITTI L, KOCH K, LI, et al. A model of saliency-based visual attention for rapid scene analysis[J]. IEEE Trans.on Pattern Analysis and Machine Intelligence, 1998,20(11), 1254-1259.

[12] ACHANTA R, ESTRADA F, WILS P, et al. Salient region detection and segmentation[C]∥Proc.of the 6th International Conference on Computer Vision System, 2008: 66-75.

[13] ZHAI Y, SHAH M. Visual attention detection in video sequences using spatiotemporal cues[C]∥Proc.of the 14th Annual ACM International Conference on Multimedia, 2006: 815-824.

[14] ACHANTA R, HEMANMI S, ESTRADA F J, et al. Frequency-tuned salient detection[C]∥Proc.of the 2009 IEEE Conference on Computer Vision and Pattern Recognition, 2009: 1597-1604.

[15] CHENG M M, ZHANG G X, MITRA N J, et al. Global contrast based salient region detection[C]∥Proc.of the IEEE Conference on Computer Vision and Pattern Recognition,2011:409-416.

[16] TOMASI C, MANDUCHI R. Bilateral filtering for gray and color images[C]∥Proc.of the International Conference on Computer Vision, 2002.

[17] DAO N. Inverse bilateral filter for saliency[J]. International Journal of Computer Applications, 2016, 118(10): 975-8887.

[18] DAO N. Divergence filter for saliency[C]∥Proc.of the 7th International Conference on Knowledge & System Engineering, 2016: 238-243.

[19] HE K M, SUM J, AND TANG X O. Guided image filtering[J].IEEE Trans.on Pattern Analysis & Machine Intelligence, 2013, 35(6): 1397-1409.

[20] BUMSUB H, MINSU C, JEAN P. Robust image filtering using joint static and dynamic guidance[C]∥Proc.of the IEEE Computer Visio and Pattern Recognition, 2015: 4823- 4831.

[21] HARMANN G. Gestalt psychology: a survey of facts and principles[M].Kessinger Publishing, 2006.

[22] KOFFKA K. Principles of Gestalt psychology[M].Routledge and Kegan Paul, 1955.

[23] ACHANTA R, SHAJI A, SMITH K, et al. SLIC superpixels compared to state-of-the-art superpixel methods[J]. IEEE Trans.on Pattern Analysis and Machine Intelligence,2012,34(11): 2274-2282.

[24] HOU X D, ZHANG L Q. Saliency detection: a spectral residual approach[C]∥Proc.of the IEEE Computer Visio and Pattern Recognition, 2007: 1-8.

[25] YAN Q, XU L, SHI J P, et al. Hierarchical saliency detection[C]∥Proc.of the IEEE Computer Visio and Pattern Recognition, 2013: 1155-1162.