针对不平衡数据的决策树改进方法

王伟 谢耀滨 尹青

摘 要:针对异常检测中异常数据与正常数据的比例严重不平衡导致决策树性能下降的问题,提出了C4.5决策树的三种改进方法——C4.5+δ、均匀分布熵(UDE)和改进分布熵函数(IDEF)。首先,推导了C4.5算法中属性选择准则会倾向于选择偏斜划分的属性;然后,分析了偏斜划分使得异常(少数类)检测精度下降的原因;其次,分别通过引入缓和因子、均匀分布熵或替换分布熵函数改进了C4.5算法的属性选择准则——信息增益率;最后,利用WEKA平台和NSL-KDD数据集对改进的决策树进行验证。实验结果表明,三种改进方法均能提高异常检测精度。其中,相比于C4.5,C4.5+7、UDE和IDEF算法在KDDTest-21数据集上的少数类检测精度(灵敏度)分别提高了3.16、3.02和3.12个百分点,均优于采用Rényi熵和Tsallis熵作为分裂准则的方法。此外,利用三种改进的决策树检测工业控制系统中的异常,不仅可以提高异常的查全率还能减小误报率。

关键词:不平衡数据;异常检测;决策树;C4.5;信息增益率

中图分类号: TP181

文献标志码:A

文章编号:1001-9081(2019)03-0623-06

Abstract: Focusing on the problem that serious imbalance between abnormal data and normal data in anomaly detection will lead to performance degradation of decision tree, three improved methods for C4.5 decision tree were proposed, which are C4.5+δ, UDE (Uniform Distribution Entropy) and IDEF (Improved Distribution Entropy Function). Firstly, it was deduced that the attribute selection criterion of C4.5 tends to choose the ones with imbalanced splitting. Secondly, why imbalanced splitting decreases the accuracy of anomaly (minority) detection was analyzed. Thirdly, the attribute selection criterion — information gain ratio of C4.5 was improved by introducing relaxation factor and uniform distribution entropy, or substituting distribution entropy function. Finally, three improved decision trees were verified on WEKA platform and NSL-KDD dataset. Experimental results show that three proposed improved methods can increase the accuracy of anomaly detection. Compared with C4.5, the accuracies of C4.5+7, UDE and IDEF on KDDTest-21 dataset are improved by 3.16, 3.02 and 3.12 percentage points respectively, which are better than the methods using Rényi entropy or Tsallis entropy as splitting criterion. Furthermore, using improved decision trees to detect anomalies in the industrial control system can not only improve the recall ratio of anomalies, but also reduce false positive rate.

Key words: imbalanced data; anomaly detection; decision tree; C4.5; information gain ratio

0 引言

異常检测是指从某个系统的日常数据中识别非预期模式,即异常数据。异常通常由恶意行为或违规操作引发,因此异常检测技术广泛应用于网络安全、故障检测等领域[1-3]。

异常检测可以视为一种特殊的分类问题,即分离目标数据集中的正常数据与异常数据。因此,绝大多数基于机器学习的分类方法,如神经网络、支持向量机、决策树等,都可以应用于异常检测。然而异常检测面临数据不平衡问题,即目标数据集中异常数据与正常数据的分布是不平衡的,其中异常数据一般远远少于正常数据。数据不平衡问题在医疗诊断[4]、信用卡诈骗检测[5]、银行风险管控[6]、系统故障检测[7]等应用中十分常见。在传统分类问题中,整体准确度由不同类别的准确度加权组成,因此多数类的准确度对整体准确度的影响要远大于少数类。在传统方法中,分类器会倾向于保证多数类的准确度而牺牲少数类的准确度,导致少数类的漏报率较高。然而在很多异常检测的现实应用中将异常(少数类)误判为正常(多数类)的代价要远远高于相反的情况,因此需要尽可能地检测出异常,降低漏报率。例如,在癌症的诊断中,将癌症(少数类)患者误诊为健康(多数类)的危害要远大于将非癌症患者误诊为癌症的危害,所以要保证检测结果为阳性时尽可能地覆盖真正的癌症患者。

对于不平衡分类问题,主要从数据和算法两个层面来解决[8]。数据层面的方法首先通过数据预处理平衡数据分布从而消除多数类的影响,而后运用传统方法进行分类;算法层面的方法通过修改学习算法来处理不平衡分类问题。这些方法保留原有方法的主体思想,通过调整决策阈值使其偏向于少数类或者在学习过程中引入错误分类代价提高少数类的重要性。除此之外,许多研究人员将数据层面和算法层面的方法相结合[9-10],为不平衡分类问题提供了全新的综合性解决方案。

本文从算法层面入手,对C4.5决策树的特征选择准则进行改进。本文的主要贡献在于:1)提出了三种针对不平衡数据的C4.5决策树改进方法;2)运用改进的决策树进行异常检测并验证了其有效性。

本文将在下一章中回顾近几年来不平衡学习的相关方法。第二章介绍了决策树并分析了特征选择准则对不平衡分类的影响。针对第二章中分析的不平衡分布情况下性能下降的原因,第三章详细描述了三种改进方法的细节。本文将所提的方法应用于异常检测,检测结果及分析将在第四章中进行展示。最后,第五章将对全文进行总结并提出下一步的研究目标。

1 相关工作

为了提升机器学习算法处理不平衡数据的性能,研究人员提出了许多解决办法,大致可分为数据层面和算法层面。数据层面的方法独立于分类器,具有较高的灵活性与普适性;算法层面的方法通过修改学习算法解决不平衡分类问题,具有较强的针对性。

数据层面包含过采样法、欠采样法、过采样和欠采样的综合法。采样方式分为启发式和非启发式,非启发式采样法通常由随机过采样和随机欠采样组成。合成少数类过采样技术(Synthetic Minority Oversampling TEchnique, SMOTE)[11]是一种典型的启发式过采样方法,该算法的提出是为了解决随机过采样法增加过拟合风险的问题。另外,启发式过采样方法包括K近邻规则(K-Nearest Neighbor, KNN)、邻域清理规则(Neighborhood CLeaning rule, NCL)[12]、OSS(One-Sided Selection)[13]和IRUS(Inverse Random Under Sampling)[14]等。

MohammadImran等[15]提出了OSIBD(Over Sampling on Imbalance Big Data)算法提升不平衡分类的性能。该算法采用新型的过采样策略对数据集进行预处理。首先,根据数据分布移除少数类样本中的噪声和边缘点;随后,在处理后的少数类样本之间插入合成样本实现混合过采样;最后,利用C4.5算法进行分类。实验结果证明,改进后的方案中精确度、召回率均有所提升。

在算法层面,不同算法的解决方法有所差异,下面将着重介绍关于决策树算法的相关研究工作。在传统的决策树算法中,香农熵用于度量样例集合的不纯净度,并作为树节点的分裂依据。Lima等[16]针对熵的测量方法对决策树进行改进,分别采用Rényi熵和Tsallis熵代替香农熵作为分裂准则。在KDD(Knowledge Discovery and Data mining)数据集上进行实验,结果表明依据Rényi熵和Tsallis熵建立的决策树模型更加紧凑与高效。

为了提升决策树在不平衡数据集上的学习性能,Boonchuay等[17]提出了一种全新的不纯净度度量方法——少数类熵(Minority Entropy, ME)。首先,确定少数类分布的范围并忽视范围外的多数类样本;随后,计算并衡量少数类范围内的香农熵。该方法通过排除纯净部分的多数类样本,缓解了不平衡分布的问题。

Kirshners等[18]在熵函数的计算公式中引入了权重概念。其中,权重代表每一类样本的重要性,且与分布概率成反比。改进的决策树算法在学习阶段之前计算初始的类分布概率,提高学习阶段中对少数类的重视程度。实验结果表明在不同的数据集上该算法的敏感度(即少数类的准确率)有显著提升。

代价敏感学习是一种解决不平衡分类问题的有效途径。Li等[19]提出了一种代价敏感决策树算法,其中包含了两种自适应机制。自适应分割点选择机制将属性的代价引入到信息增益率的计算公式中,代替原始的遍历选择机制;自适应属性删除机制在节点选择过程中删除冗余属性。相比于C4.5,改进后的算法不仅降低了平均分类代价,而且缩短了算法的运行时间;郑燕等[20]提出了一种代价敏感超网络Boosting集成算法,首先将代价敏感学习引入超网络模型,而后利用Boosting算法对代价敏感超网络进行集成,以处理不平衡数据分类问题。

除此之外,集成法通过综合多种方法为不平衡分类问题提供全新的综合性解决方案,其优势在于通过融合不同方面的优势提高了算法的稳定性。文献[21]中介绍了一种基于包裹式特征选择的引导聚集(Bagging)框架,该框架包含数据预处理和Bagging两个过程。数据预处理过程中,首先采用随机欠采样压缩数据,而后利用包裹式特征选择算法删除冗余属性;Bagging过程中,通过引导采样生成多个子集,而后在多个子集上分别训练决策树,最终输出由多个决策树投票决定的结果。

2 问题分析

为了解决不平衡分类问题,本章对决策树算法进行分析并寻找导致分类性能下降的原因。在2.1节中,介绍了决策树算法的过程及相应的准则;在2.2節中,通过分析两种数据分布情况探究C4.5算法中属性选择对不平衡数据分类的影响。

2.1 决策树算法

1)根据分裂准则,在数据集D上选择一个最优分裂属性;

2)在最优分裂属性上选择最优分裂点,将数据集D分为DL和DR两个子节点;

3)在子节点上重复上述步骤,直到所有叶节点满足停止准则。

在每次迭代过程中,决策树随着子节点的分裂不断生长。当所有的叶节点均满足停止准则时,决策树停止生长。停止准则通常由纯净度、叶节点数和树深度等条件组成。

分裂准则通过计算不纯净度决定叶节点如何分裂。最常用的分裂准则是基于香农熵的信息增益:

其中IG表示分裂前后的信息增益(即熵的衰减值)。香农熵的定义如式(2)所示,其值域范围为[0,lb n],当p(yi)相等时达到极大值,当p(yi)等于0或1时达到最小值。因此,最大化信息增益准则将引导节点向纯净分类。

常用的决策树算法有ID3、C4.5[22]等。ID3算法根据最大化信息增益准则选择最优分裂属性,导致其倾向于选择取值多的属性; C4.5算法对ID3算法进行改进,根据最大化信息增益率准则选择最优分裂属性。为了滤除虚高的信息增益率——低信息增益、低分布熵,C4.5算法涵盖一种启发式规则——首先滤除信息增益低于平均值的属性,而后比较剩余属性的信息增益率。本文将在下一节中分析C4.5决策树建立过程中选择不同的属性对不平衡数据的影响。

2.2 C4.5处理不平衡数据的不足

C4.5算法根据信息增益率选择最优分裂属性,信息增益率公式计算如下:

其中H(X)表示同级子节点的分布熵。随着子节点数量的增多,H(X)相应增大,从而抑制子节点数量对信息增益的影响。

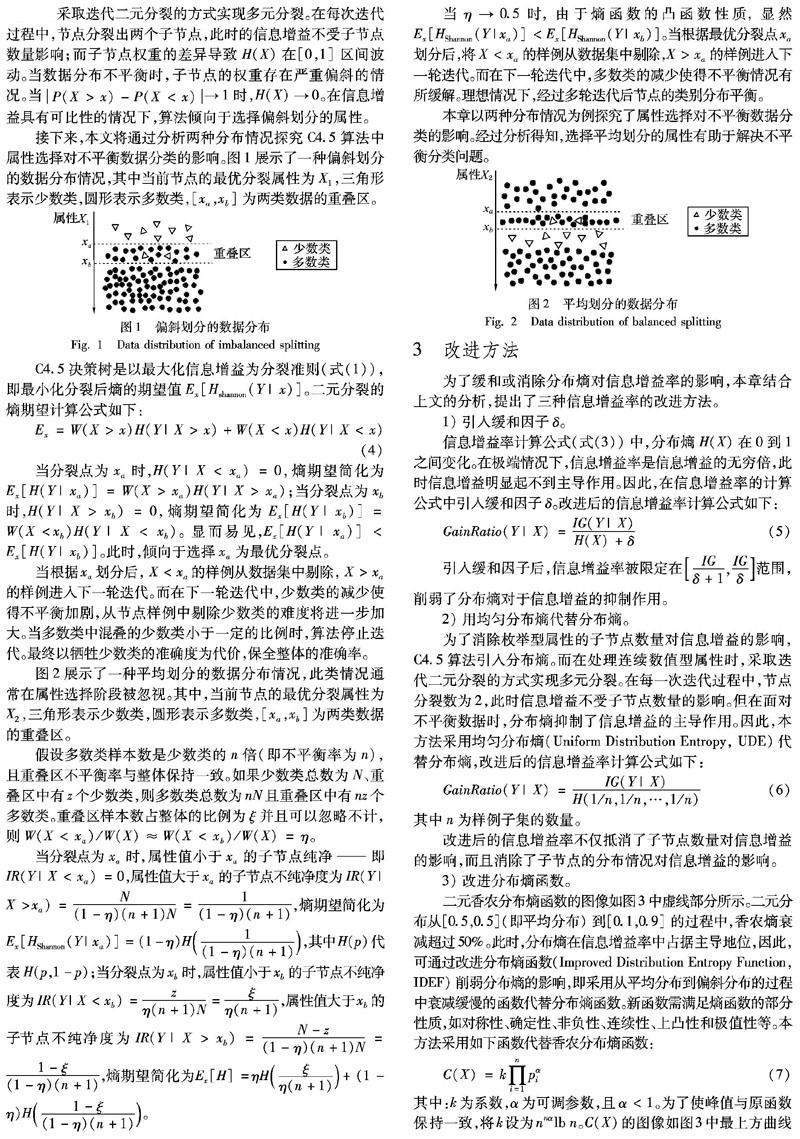

由于理想子节点数量未知,C4.5算法在处理连续型数值属性时,采取迭代二元分裂的方式实现多元分裂。在每次迭代过程中,节点分裂出两个子节点,此时的信息增益不受子节点数量影响;而子节点权重的差异导致H(X)在[0,1]之区间波动。当数据分布不平衡时,子节点的权重存在严重偏斜的情况。当P(X>x)-P(X 3 改进方法 为了缓和或消除分布熵对信息增益率的影响,本章结合上文的分析,提出了三种信息增益率的改进方法。 1)引入缓和因子δ。 信息增益率计算公式(式(3))中,分布熵H(X)在0到1之间变化。在极端情况下,信息增益率是信息增益的无穷倍,此时信息增益明显起不到主导作用。因此,在信息增益率的计算公式中引入缓和因子δ。改进后的信息增益率计算公式如下: 2)用均匀分布熵代替分布熵。 为了消除枚举型属性的子节点数量对信息增益的影响,C4.5算法引入分布熵。而在处理连续数值型属性时,采取迭代二元分裂的方式实现多元分裂。在每一次迭代过程中,节点分裂数为2,此时信息增益不受子节点数量的影响。但在面对不平衡数据时,分布熵抑制了信息增益的主导作用。因此,本方法采用均匀分布熵(Uniform Distribution Entropy, UDE)代替分布熵,改进后的信息增益率计算公式如下: 其中n为样例子集的数量。 改进后的信息增益率不仅抵消了子节点数量对信息增益的影响,而且消除了子节点的分布情况对信息增益的影响。 3)改进分布熵函数。 二元香农分布熵函数的图像如图3中虚线部分所示。二元分布从[0.5,0.5](即平均分布)到[0.1,0.9]的过程中,香农熵衰减超过50%。此时,分布熵在信息增益率中占据主导地位,因此,可通过改进分布熵函数(Improved Distribution Entropy Function, IDEF)削弱分布熵的影响,即采用从平均分布到偏斜分布的过程中衰减缓慢的函数代替分布熵函数。 新函数需满足熵函数的部分性质,如对称性、确定性、非负性、连续性、上凸性和极值性等。本方法采用如下函数代替香农分布熵函数: 其中:k为系数,α为可调参数,且α<1。为了使峰值与原函数保持一致,将k设为nnαlb n。C(X)的图像如图3中红色最上方曲线所示,当α=1/3时,二元分布从[0.5,0.5]到[0.1,0.9]的过程中,衰减减少至30%以内。 4 实验与评估 本章将通过两部分实验对所提方法的有效性进行验证。4.1节将展示在NSL-KDD数据集上评估提出的方法处理不平衡数据的性能,并与采用Rényi熵和Tsallis熵的方法进行对比;4.2节将利用改进的决策树进行工业控制系统中的异常检测;本文实验依托由新西兰怀卡托大学开发的公开数据挖掘工作平台——怀卡托智能分析环境(Waikato Environment for Knowledge Analysis, WEKA)[23],通过修改WEKA 3.8.2中的J48(即C4.5)决策树实现。实验采用十折交叉验证方式,并开启剪枝过程。 4.1 NSL-KDD测试 NSL-KDD数据集[24]是一个面向网络入侵检测系统的公开数据集,共包含41维特征属性以及1维目标属性。KDDTest-21数据集包含2152个正常样本与9698个异常样本;KDDTrain+数据集包含67343个异常样本、58630个正常样本。为了使偏斜率多样化并且降低数据规模,本文对KDDTrain+数据集中的异常样本和正常样本随机抽样,构造了5个不同偏斜率的数据集。本节实验中使用的数据集如表1所示。 在不平衡数据的情况下,准确率和错误率不足以衡量分类算法的性能。因此,本文额外引入两项衡量指标——灵敏度(又称为召回率或查全率)和特異度。灵敏度表示分类算法正确预测正样本数量占实际正样本数量的百分率,其公式表述如式8所示。其中,真阳性(True Positives, TP)表示预测为正的正样本数,假阴性(False Negatives, FN)表示预测为负的正样本数。 特异度表示分类算法正确预测负样本数量占实际负样本数量的百分率,其公式表述如式(9)所示。其中,真阴性(True Negatives, TN)表示预测为负的负样本数,假阳性(False Positives, FP)表示预测为正的负样本数。 本文提出的方法在KDDTest-21及KDD101~105数据集上的结果对比如表2所示。 第一列表示数据集名称,第二列为决策树及其改进方法的简称,其中C4.5+δ表示方法(一)引入缓和因子δ、UDE表示方法(二)用均匀分布熵代替分布熵、IDEF表示方法(三)改进分布熵函数。此外,文献[16]中提出的基于Rényi熵和Tsallis熵的决策树作为本文的比对方法,作者针对不纯净度的度量方法对决策树进行改进,分别采用Rényi熵和Tsallis熵代替香农熵作为分裂准则。Rényi熵和Tsallis熵的计算公式如式(10)和式(11)所示: 在KDDTest-21数据集上,C4.5+δ、UDE、IDEF相对于C4.5均有所提升,且C4.5+δ提升幅度最大,如表2所示(加粗部分表示最佳性能)。当δ=7时,C4.5+7的准确率达到97.76%。与C4.5算法相比, C4.5+7的灵敏度(少数类的分类精度)提升了3.16个百分比,且特异度(即多数类的分类精度)也有小幅提升。而Rényi熵和Tsallis熵在提升灵敏度的同时,特异度有所下降。此外,叶节点数与决策树大小代表模型的复杂度(后续分析中以决策树大小代表模型复杂度)。与C4.5算法相比,C4.5+7算法生成的决策树减小了51.53%。因此,三种改进方法在提升检测效果的同时,又大幅度降低了模型的复杂度。 接下来,利用KDD101~105数据集对三种改进方法进行验证与对比,以探究在不同偏斜率的情況下三种算法的适用性。在KDD101数据集上,C4.5+δ、UDE、IDEF相对于C4.5均有所提升。其中,UDE算法在准确率、错误率和灵敏度上均取得了最优值。相比于C4.5算法,C4.5+5、UDE、IDEF算法的灵敏度分别提升了1.4%、1.5%、0.3%;在特异度指标方面,UDE算法略逊色于IDEF算法。虽然三种改进方法均不同程度上增加了模型的复杂度(UDE模型复杂度相对于C4.5算法提高了19.55个百分点),但仍优于Rényi熵和Tsallis熵(Rényi熵和Tsallis熵分别提高了40.6和26.32个百分点)。因此,可理解为由于KDD101数据集偏斜严重,提高模型复杂度是提升决策树性能的必要条件。 在KDD102上,C4.5+δ、UDE、IDEF相对于C4.5算法均有所提升。当δ增至11时,C4.5+δ的各项性能指标达到最优值,其中灵敏度从97.8%提升至98.75%;尽管Tsallis熵方法的特异度达到了99.86%,但灵敏度相对于原始算法有所下降。在此数据集上虽然Tsallis熵方法提高了准确率,但其显然不是解决不平衡分类问题的有效方法。 从KDD101至KDD104,数据集趋于平衡,C4.5+δ性能最优时对应的参数δ逐渐增大。当δ大于最优值后,性能趋于稳定,但随着δ增大模型趋于简单化。除此之外,随着不平衡情况的减缓,改进方法的提升幅度逐渐降低,而Rényi熵和Tsallis熵方法逐渐失效。例如,在KDD104数据集上,虽然基于Rényi熵的方法准确率高于C4.5算法,但其灵敏度相对于C4.5算法有所降低。与KDD104类似,Rényi熵和Tsallis熵方法在KDD105数据集上(即面临轻微不平衡的情况时)失去效果。 表2展示了几种方法在面临不同偏斜率的数据集时的性能。总体而言,C4.5+δ在解决不平衡分类问题时表现出了突出的性能;而UDE与IDEF也拥有解决不平衡分类问题的能力,并且相对于C4.5+δ而言,具有更好的泛化性能。 4.2 工业控制过程的异常检测 工业控制过程的异常检测常常也面临数据不平衡问题,因为工控系统中正常状态明显多于异常状态。本节利用改进的决策树算法进行工业控制领域的异常检测,进而证明所提方法的实用价值。 水处理安全测试平台(Secure Water Treatment, SWaT)[25]是现实工业中水处理工厂的模型,其处理过程共分为6个阶段,如图4所示。 SWaT数据集[26]共记录了该系统11天的运行数据。前7天系统正常运行,后4天对该系统不定时发动36次攻击。 本节实验在SWaT后4天记录的数据上进行,共包含396019个正常数据与53900个异常数据。检测结果通过混淆矩阵直观展示,混淆矩阵定义如表3所示。 C4.5算法及三种改进方法关于SWaT的异常检测结果如表4所示。原始的C4.5算法检测结果中,异常数据的漏报数量为119,误报数量为90。此时,C4.5算法向正常类偏斜。当δ=7时,C4.5+δ算法的检测效果最佳。其中,异常的漏报数量为92,而误报数量为82。与C4.5算法相比,C4.5+7算法的漏检率减小了22.69%、误报率减小了8.89%。从实验结果来看,两类数据的错误分类数量基本持平。因此,C4.5+δ基本上解决了不平衡分类问题。另外,UDE与IDEF的检测结果相同。相对于C4.5而言,异常的漏报数量从119减少至103,而误报数量从90减少至97。从实验效果来看,UDE和IDEF算法在一定程度上缓解了不平衡分类问题。 由表4可知,三种改进方法均能改善工控异常检测中的不平衡分类问题。其中,UDE与IDEF提高了异常的检测效率,但未彻底解决不平衡问题;而C4.5+δ提升效果明显优于UDE与IDEF,经过改进,异常数据和正常数据的错误分类数量基本持平,基本上解决了异常检测的不平衡问题。 5 结语 在平衡数据的分类任务中,决策树因其简单高效且具有强解释性而备受瞩目。然而,当面临不平衡数据时,决策树算法偏向于多数类使其性能大打折扣。同时,在异常检测任务中,尽管异常数据远远少于正常数据,但异常数据的检测率尤其重要。因此,本文分析了C4.5决策树的不平衡原因,并提出了属性选择准则的三种改进方法——C4.5+δ、UDE、IDEF。 对改进的决策树算法在不同偏斜率的KDD数据集上进行测试,三种方法的灵敏度和特异度均有明显提升。与Rényi熵和Tsallis熵相比,本文提出的方法在提升少数类准确率的同时,还保证了多数类的准确率。最后,改进的决策树应用于工业控制系统的异常检测过程中,实验结果证明本文提出的方法能改善不平衡分类问题。 计划从数据层面开展下一步工作,提出适用于异常检测的人工合成少数类方法,结合本文的方法形成综合性解决方案,进一步提升异常检测的性能。 參考文献 (References) [1] ESKIN E, ARNOLD A, PRERAU M, et al. A geometric framework for unsupervised anomaly detection [J]. Applications of Data Mining in Computer Security, 2002, 6: 77-101. [2] ISERMANN R, BALLE P. Trends in the application of model-based fault detection and diagnosis of technical processes [J]. Control Engineering Practice, 1997, 5(5): 709-719. [3] KOU Y, LU C T, SIRWONGWATTANA S, et al. Survey of fraud detection techniques [C]// Proceedings of the 2004 IEEE International Conference on Networking, Sensing and Control. Piscataway, NJ: IEEE, 2004: 749-754. [4] 王莉莉,付忠良,陶攀,等.基于主动学习不平衡多分类AdaBoost算法的心脏病分类[J].计算机应用,2017,37(7):1994-1998.(WANG L L, FU Z L, TAO P, et al. Heart disease classification based on active imbalance multi-class AdaBoost algorithm [J]. Journal of Computer Applications, 2017, 37(7): 1994-1998.) [5] FU K, CHENG D, TU Y, et al. Credit card fraud detection using convolutional neural networks [C]// Proceedings of the 2016 International Conference on Neural Information Processing. Berlin: Springer, 2016: 483-490. [6] DANENAS P, GARSVA G. Selection of support vector machines based classifiers for credit risk domain [J]. Expert Systems with Applications, 2015, 42(6): 3194-3204. [7] MARTIN-DIAZ I, MORINIGO-SOTELO D, DUQUE-PEREZ O, et al. Early fault detection in induction motors using AdaBoost with imbalanced small data and optimized sampling [J]. IEEE Transactions on Industry Applications, 2017, 53(3): 3066-3075. [8] 赵楠,张小芳,张利军.不平衡数据分类研究综述[J]. 计算机科学,2018,45(S1):22-27.(ZHAO N, ZHANG X F, ZHANG L J. Overview of imbalanced data classification [J]. Computer Science, 2018, 45(S1): 22-27.) [9] IRTAZA A, ADNAN S M, AHMED K T, et al. An ensemble based evolutionary approach to the class imbalance problem with applications in CBIR [J]. Applied Sciences, 2018, 8(4): 495. [10] GALAR M, FERNANDEZ A, BARRENECHEA E, et al. EUSBoost: enhancing ensembles for highly imbalanced data-sets by evolutionary undersampling [J]. Pattern Recognition, 2013, 46(12): 3460-3471. [11] CHAWLA N V, BOWYER K W, HALL L O, et al. SMOTE: synthetic minority over-sampling technique [J]. Journal of Artificial Intelligence Research, 2011, 16(1): 321-357. [12] LAURIKKALA J. Improving identification of difficult small classes by balancing class distribution [C]// Proceedings of the 8th Conference on Artificial Intelligence in Medicine in Europe. Berlin: Springer, 2001: 63-66. [13] KUBAT M, MATWIN S. Addressing the curse of imbalanced training sets: one-sided selection [C]// Proceedings of the 14th International Conference on Machine Learning. New York: ACM, 1997: 179-186. [14] TAHIR M A, KITTLER J, MIKOLAJCZYK K, et al. A multiple expert approach to the class imbalance problem using inverse random under sampling [C]// Proceedings of the 8th International Workshop on Multiple Classifier Systems. Berlin: Springer, 2009: 82-91. [15] IMRAN M, RAO V S, AMARASIMHA T, et al. A novel technique on class imbalance big data using analogous over sampling approach [J]. International Journal of Computational Intelligence Research, 2017, 13(10): 2407-2417. [16] LIMA C F L, de ASSIS F M, de SOUZA C P. Decision tree based on Shannon, Rényi and Tsallis entropies for intrusion tolerant systems [C]// Proceedings of the 5th International Conference on Internet Monitoring and Protection. Piscataway, NJ: IEEE, 2010: 117-122. [17] BOONCHUAY K, SINAPIROMSARAN K, LURSINSAP C. Decision tree induction based on minority entropy for the class imbalance problem [J]. Pattern Analysis and Applications, 2017, 20(3): 769-782. [18] KIRSHNERS A, PARSHUTIN S, GORSKIS H. Entropy-based classifier enhancement to handle imbalanced class problem [J]. Procedia Computer Science, 2017, 104: 586-591. [19] LI X, ZHAO H, ZHU W. A cost sensitive decision tree algorithm with two adaptive mechanisms [J]. Knowledge-Based Systems, 2015, 88: 24-33. [20] 鄭燕,王杨,郝青峰,等.用于不平衡数据分类的代价敏感超网络算法[J].计算机应用,2014,34(5):1336-1340.(ZHENG Y, WANG Y, HAO Q F, et al. Cost-sensitive hypernetworks for imbalanced data classification [J]. Journal of Computer Applications, 2014, 34(5): 1336-1340.) [21] LEE S J, XU Z, LI T, et al. A novel bagging C4.5 algorithm based on wrapper feature selection for supporting wise clinical decision making [J]. Journal of Biomedical Informatics, 2018, 78: 144-155. [22] QUINLAN J R. C4.5: Programs for Machine Learning [M]. San Francisco, CA: Morgan Kaufmann, 1993:17-26. [23] FRANK E, HALL M A, WITTEN L H. The WEKA workbench. online appendix for “Data mining: practical machine learning tools and techniques” [EB/OL]. (2016-11-22) [2018-05-04]. https://www.cs.waikato.ac.nz/ml/weka/Witten_et_al_2016_appendix.pdf. [24] DHANABAL L, SHANTHARAJAH S P. A study on NSL-KDD dataset for intrusion detection system based on classification algorithms [J]. International Journal of Advanced Research in Computer and Communication Engineering, 2015, 4(6): 446-452. [25] ADEPU S, MATHUR A. An investigation into the response of a water treatment system to cyber attacks [C]// Proceedings of the 17th IEEE International Symposium on High Assurance Systems Engineering. Washington, DC: IEEE Computer Society, 2016: 141-148. [26] GOH J, ADEPU S, JUNEJO K N, et al. A dataset to support research in the design of secure water treatment systems [C]// Proceedings of the 11th International Conference on Critical Information Infrastructures Security. Berlin: Springer, 2016: 88-99.