立体沉浸式远程体控机器人系统

王金金 阿迪思 白雪 王钦 熊沁茹

摘 要:项目利用立体沉浸技术和体感控制技术,创新性地将虚拟现实技术应用于监測控制领域,提出远程三维立体沉浸式智能体感控制概念与技术路线。利用电子双目摄像头和虚拟现实技术的显示设备构建三维立体沉浸式监控环境;利用搭载在头部和手臂的姿态传感器、单片机和无线收发模块构建体感控制部分,方便观察者自由选择观察方向与视角,交互性、动作性和自主性较强。立体沉浸式体控机器人能够实现远程沉浸式操作,并结合轮式、履带式等移动机器人或航拍机器人,以更直观、自由的体感控制方式完成各类特定任务,使机器人工作更加安全、可靠和高效。文中提出了立体沉浸式远程体感智能控制器的设计方案,将其应用到轮式移动机械臂的远程立体沉浸式体感控制中,完成了原理样机的测试与分析。

关键词:沉浸式系统;体感控制;虚拟现实;人机交互

1 概 述

1.1 项目背景及意义

2011年日本核电站发生了特大核泄漏事故后,核电站内的核燃料暴露在外并持续高温亟待冷却,而高危环境下的救援抢险工作以及高污染环境的质量监测工作会对人体产生潜在危害,甚至威胁到人身安全。为避免此种情况造成的伤害,可采用智能机器人代替人工进行操作,既可以保证救援人员的生命安全,还可以通过控制精度保证机器人工作的可靠性、高效性和适用性。远程体感控制机器人集人机交互、沉浸式监测与体感控制于一体,可实现远程沉浸式操控,更加直观、自由、安全、可靠、高效。

1.2 国内外研究现状

沉浸式虚拟现实(immersiveVR)技术能为参与者提供完全沉浸的体验,使用户有置身于虚拟世界的感觉。其中,远程自主式智能控制系统具有远程控制、无需人工现场监控、代替人进行一些智能操作的特点;虚拟现实技术则利用头盔显示器将用户的视觉、听觉封闭起来,产生虚拟视觉;与此同时,让参与者对系统主机下达操作命令,头、手、眼均有相应的头部跟踪器、手部跟踪器、眼睛视向跟踪器的追踪,使系统具有实时性。

日本原子能研究学会在1999年东海燃料处理设施发生核事故后研制了坦克式机器人,它高1.5 m,重500 kg。这款机器人每分钟大约移动40 m,可以在距控制器1.1 km的距离范围内操作,如图1(a)所示。

2013年,千叶工业大学公开了水陆两用核电站机器人“樱花2号”,如图1(b)所示。该新型机器人可以在废墟上自由行走,且可通过远程控制,使手臂进行和人相同的复杂动作。具有极强的抗辐射和防水功能,主要用于废料清理。

2001年,美国iRobot公司研制出了Packbots,2008年推出最新军用机器人产品Warrior, 如图2所示。这两款机器人都配有摄像机,把实时视频流传送给操作人员,操作人员使用游戏杆式的控制器操作机器人。其无线范围超600 m,能够绕过瓦砾,爬上台阶,下落1.8 m到混凝土上,即使完全浸入水中仍能工作。Warrior 710甚至能够背着Packbots通过窗户进入建筑物内部。

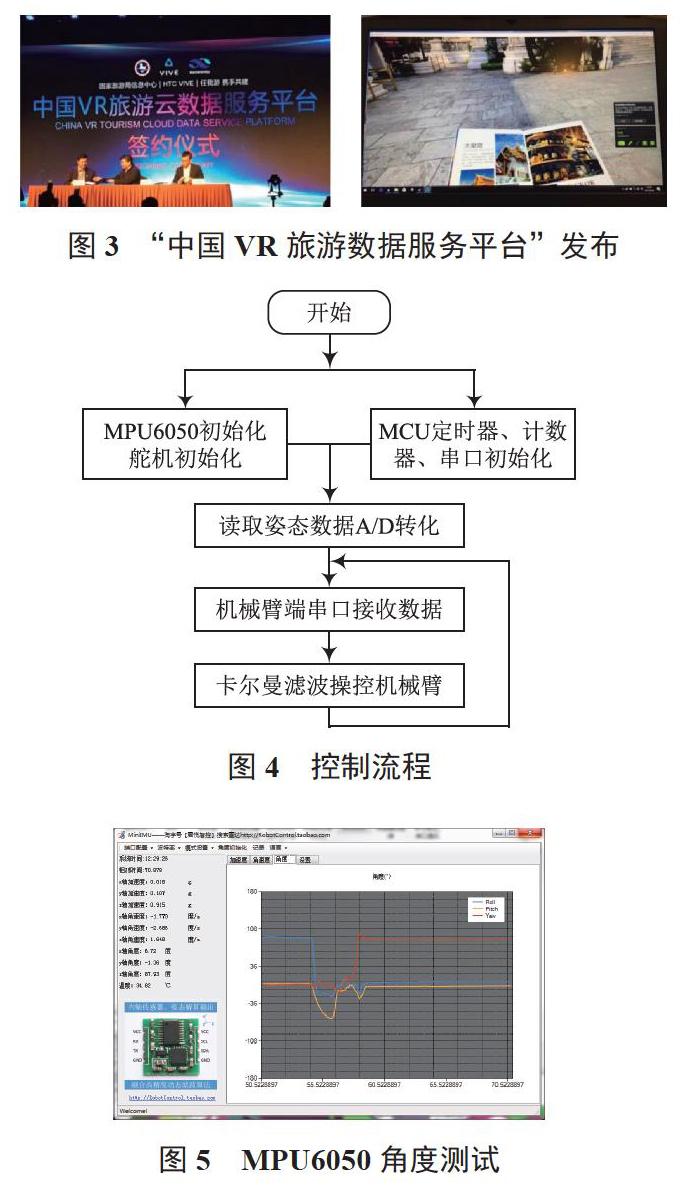

2017年2月22日,在国家旅业头脑风暴大会上,国家旅游局信息中心、任我游(厦门)科技发展有限公司以及HTCVive携手发布了“中国VR旅游云数据服务平台”,如图3所示。

1.3 设计要求及思路

远程体控机器系统最大的困难在于准确捕捉使用者的姿态信息,根据使用者的姿态计算出控制器执行的动作。同时,如何通过无线方式将双目摄像头捕捉的大量图像信息回传到头盔内的显示屏至关重要。

立体沉浸式远程体控机器人系统应满足3D视觉效果好、立体感形成及画面实时传输性好、远距离无线数据链路通信、机械控制动作性强、能耗低等要求。

2 体感控制系统

2.1 机械臂的控制

2.1.1 姿态数据采集

为使立体沉浸式体感控制机器系统具备更好的人机交互性、自由性,在立体环境的基础上设计了姿态数据采集与传输系统来完成和实现人机交互的相关功能,进一步增强沉浸式效果与体验。系统主要由姿态传感器、微处理器(MCU)、电源模块和数据传输模块等组成,可实现对人体头部和手臂姿态的数据采集和数据传输。

(1)姿态传感器

本系统选择MPU6050模块检测人体头部和手臂的姿态角度变化。MPU6050芯片内部集成有姿态传感器、数字滤波、温度传感器、16位ADC及可扩展数字运动处理器(DMP)等。其中姿态传感器选用惯性式姿态传感器,包含三轴陀螺仪和三轴加速度计,可分别测量出运动的角速度和线加速度,经A/D转换,滤波和数据融合处理便可得到反映真实机体状态的姿态角。陀螺仪和加速度传感器测量范围可控,陀螺仪测量范围为±2 000°/s,±1 000°/s,±500°/s,±250°/s;加速度计测量范围为±16g,±8g,±4g,±2g。本项目中陀螺仪通过软件将其测量范围控制在相应范围内。

MPU6050模块通过波特率为9 600 b/s的串口完成所有设备寄存器与MCU的通信,并完成采集三轴加速度、三轴角速度的任务。

(2)微处理器(MCU)

微处理器采用具有低功耗、高性能以及更好兼容性等优点的树莓派(RaspberryPi核心处理器为ARM),主要负责数据调试、控制机械臂和电子双目转动及姿态解算相关运算。

(3)驱动舵机

本项目使用TBSN-K15舵机,该舵机具有耐烧、稳定、虚位小、控制角度大等特点。

2.1.2 系统软件设计

姿态数据采集与传输系统程序主要实现采集人體姿态数据、原始数据调试、姿态数据融合传输等功能,其控制流程如图4所示。

采集人体姿态数据即采集人体运动过程中三轴加速度和角速度数据;姿态数据融合即选择合适的融合方法处理采集到的人体姿态数据,以得到所需的姿态角;数据传输即将融合后的姿态数据通过数据线传输给控制电子双目系统的MCU处理器。

2.1.3 数据采集与调试

利用MPU6050模块采集的只是三轴加速度和三轴角速度的原始数据,姿态传感器所要获取的人体头部和手臂姿态角的变化需经过数据融合处理才能得到。为保证姿态角的精确度和可靠性,需要对采集到的原始数据进行进一步调试与分析。MPU6050角度测试如图5所示。

加速度计或陀螺仪输出的原始数据都存在固有缺陷:当模块处于变速运动状态时,加速度计的输出并非重力加速度,而是重力加速度和其自身加速度的矢量和。陀螺仪通过对角速度积分得到姿态角,随着时间的推移,姿态角的误差越来越大,所以单一的加速度计或陀螺仪都无法获得正确的姿态角,需进行数据融合。

2.1.4 数据处理与集成

MPU6050模块作为系统的数据获取和感知部分,能够准确、实时地获得使用者的姿态角度。目前MEMS陀螺仪的精度不高,难以得到相对真实的姿态角度。为获得准确性较高且可靠的姿态角度,必须对MEMS陀螺仪的随机误差进行补偿,解决噪声干扰与姿态最优估计问题,从而获取最优姿态角度。

考虑到互补滤波算法虽然阶次越高融合效果越好,但迟滞性显著,从实时性和融合效果角度来看,Kalman滤波收敛速度和滤波效果平衡得较好,因此本系统采用卡尔曼滤波对来自加速度计和陀螺仪的信号进行融合。

集成芯片具有体积小、响应快、数据输出稳定准确等优点,能够及时、迅速地输出当前姿态信息,精度高,滤波效果如图6所示,MPU6050集成芯片如图7所示。

集成芯片与单片机经串口通信,MPU6050输出的原始数据经内部集成的姿态解算器和卡尔曼滤波算法后可直接输出稳定、实时的姿态信息至MCU,MCU经数据线传输数据至控制电子双目系统的MCU,该MCU可根据角度值输出不同的指令,对电子双目的转动进行控制,最终带给用户沉浸式体感控制体验。

集成后的芯片可安装于头盔式虚拟现实显示设备和传感器手套上,用于检测和采集使用者的姿态角度信息。

2.1.5 体控机械臂其他方案

现有的沉浸式机器人多采用低延迟、高效率控制方式。由于近年来光学姿态采集器的发展,人们可以徒手远程操控机械臂的运动。LeapMotion控制流程如图8所示。

Leap的优势在于软件,由于使用了红外LED+灰阶camera,成本较低;仅处理手部3D信息,相较于Kinect需要生成全身的skeleton、复杂的depth信息,Leap的运行效率较高,对处理图形的DSP要求较低。

此外,LeapMotion不受光线影响,即使在夜晚,同样可以灵敏捕捉操作者的手部姿态。同时,用户无需培训即可方便地操纵机械臂。系统光学体控系统构件如图9所示。

2.2 电子双目控制

远程体控机器人系统的最大特点是人与电子媒介终端的交互性好、操作性强,用户可通过肢体动作控制电子双目调节视野范围。本控制系统主要由传感环节与执行机构构成,其中传感环节由姿态传感器感知、获取人体头部运动信息并将该信息传输至单片机进行处理,单片机根据不同的姿态信号发送相关指令至执行机构,控制电子双目做出相应的运动,实现具有人机交互性的体感控制。

2.2.1 控制系统设计

利用摄像机云台作为执行机构对摄像机进行水平和垂直的移动和控制。摄像机云台是一种安装在摄像机支撑物上的工作平台,用于摄像机与支撑物之间的连接,在云台水平、垂直运动的同时,携同摄像机做相同的运动。目前国内的云台控制技术系统成熟,在云台上安装摄像头后可调整摄像机水平和俯仰角度,同理,可通过控制机械臂转动的舵机实现对机械臂的控制。

本系统样机阶段,摄像头和机械臂将安装在舵机之上。舵机是一种伺服马达,其本身具有体积小、灵敏度高、可控性强等特点,可在微机电系统中作为基本的输出执行机构,其简单的控制和输出使得单片机系统容易与之接口。舵机接收单片机发送的脉冲信号,转过相应角度,实现对摄像头位置的调整。舵机云台将固定于智能小车上,智能小车作为电子双目控制系统的载体,可程控各方向的启停,调整设备的运动方向,完成探测任务。

2.2.2 舵机控制方式

舵机适用于角度需要不断变化并保持的控制系统,如图10所示。工作原理:控制信号由接收机通道进入信号调制芯片,获得直流偏置电压,其内部有一基准电路,产生周期为20 ms、宽度为1.5 ms的基准信号,将获得的直流偏置电压与电位器电压比较,获得电压差输出。最后,电压差的正负输出至电机驱动芯片决定电机的正反转。当电机转速一定时,通过级联减速齿轮带动电位器旋转,使得电压差为0 V,电机停止转动。

舵机的控制信号是利用占空比变化改变舵机位置的PWM信号。可采用单片机作为舵机的控制单元,使PWM信号的脉冲宽度实现微秒级变化,从而提高舵机的转角精度。单片机完成控制算法后将计算结果转化为PWM信号输出至舵机。单片机系统是一个数字系统,其控制信号的变化依靠硬件计数,受外界干扰较小,工作可靠。

2.2.3 体感控制终端系统

为使电子双目能够进行水平和垂直运动,让使用者拥有更好的体验,本产品的人机交互功能选择二自由度云台对舵机进行控制。RB-150MG轻量型云台是最新一代全金属齿、大扭矩、大转角范围的机器人专用伺服舵机,性价比高,定位精准,可以在水平和垂直方向做二自由度运动,安装摄像头后可实现图像反馈监控、识别定位追踪。

RB-150MG云台通过在正立的舵机上放置一个多功能舵机支架,实现电子双目的水平运动;在该支架上安装一个横向放置的舵机,并将U型支架一侧与该舵机相连,一侧通过杯士轴承与多功能舵机支架结合,实现电子双目的垂直运动,RB-150MG云台如图11所示。

采用9轴惯性姿态传感器采集传感器安放位置处的三个轴,即三个方向的角度数据,取其中代表水平方向、竖直俯仰方向范围为-90°~+90°的两个轴的数据模拟头部运动,此数据经匹配后用无线方式来控制范围为0°~180°的舵机实现相应转动,由此实现头部的体感控制。

2.3 远程控制数据传输

2.3.1 传感器数据的无线传输

体感控制系统通过采集人体头部姿态信息及手臂姿态信息来控制机器人的摄像头云台及机械手的运动。通过nRF24L01单片无线收发器芯片实现100 m以内的无线传输。在机器人控制端及用户体验端分别接入无线模块配合Arduino完成数据的交换传输,延时0.5 s,实时性好。

系统工作在2.4~2.5 GHz的ISM频段,由频率发生器、增强型“SchockBurst”模式控制器、功率放大器、晶体振荡器等组成。输出功率频道选择和协议设置可通过SPI接口进行。

nRF241拥有极低的电流消耗,当工作在发射模式下发射功率为0 dBm时电流消耗为11.3 mA ,接收模式时为12.3 mA,掉电模式和待机模式下电流消耗更低;数据包每次可传输1~32 B的数据;数据传输速率为2 Mb/s;宽电压工作范围为1.9~3.6 V,输入引脚可承受5 V输入电压,适应各种芯片的输出电压,简单易接。

2.3.2 无线通信距离的拓展

体感控制的真正意义在于其通信距离的远程化,在保障控制精度的前提下,尽可能扩展传输距离以提高机器人的可用性。现阶段,环境基础设施完善,可借助局域网访问互联网,实现两局域网子机间的信息交换,方便快捷。

使用云端服务器登录远程控制管理台即可控制服务器,实现功能。如果可以保证带宽,由视觉传感器采集的视频信息也可以通过服务器访问显示。

3 立体沉浸式系统

沉浸式视频即交互式立体视频,是最接近人类视觉方式的三维视觉感知技术。其基本原理是使用两个或多个摄像机从不同角度同一时间拍摄的视频,来产生一个全面的3D数字视频,运用计算机视觉和计算机图形学为交互式视频和电视观察者提供一个“虚拟摄像机”,使观察者可以自由选择观察方向和视角。立体沉浸式视频增加了场景的深度信息,增强了现实感。

构建立体沉浸式的图像环境需要电子双目图像采集系统、头戴式虚拟现实显示设备、姿态传感器、控制系统等,如图12所示。其中电子双目图像采集系统与虚拟现实设备共同构建立体环境,姿态传感器配合控制系统实现体感控制。

图像采集系统由电子双目完成对场景的捕捉与图像获取,用两台摄像机模拟人的双眼对景物进行拍摄,捕捉场景画面并实时传输现场图像,两台摄像机并列放置得到左、右两幅具有视差的图像,最后对该图像进行融合处理或通过3D設备观测图像。

沉浸式显示借助头盔式虚拟现实显示设备,使两幅具有视差的图像分别映入人的左右眼,人的大脑感知图像视察信息,产生立体感。虚拟现实头盔透镜具有放大作用,使图像充满使用者的整个视界,从而使用户产生强烈的沉浸感。在头戴设备上加入姿态传感器感知使用者的姿态信息来控制电子双目的移动,由此构成强交互性、高自由度视点的沉浸式视频体验和智能体感控制系统。

3.1 图像采集模块

捕获场景的空间信息并形成立体图像是立体沉浸式环境构建的前提,要产生立体影像,单台摄像机无法完成,所以本系统采用两个同时工作的摄像头,实时传输两幅具有视差的图像,反映空间场景、位置等信息。再通过头戴观测设备,使左右眼分别观测到两幅图像,人的大脑对这两幅图像进行处理后,根据两幅图像的差异判断物体与双眼的距离等信息,在人的大脑中产生立体效果。电子双目图像采集如图13所示。

常用的双目立体视觉成像模型有平行双目成像模型和汇聚双目成像模型两种,均应用两个单目摄像头取景。所得两幅有视差的图片在大脑中叠加融合处理,构成有深度立体效果的画面。综合人眼获取图像的运作方式,汇聚双目成像模型更符合人眼的视觉习惯。在不考虑畸变和其他外界因素等情况下,双目摄像系统可达到与人眼相似的立体成像效果。

两个目标摄像机与三维模型的位置关系、两个目标摄像机之间的距离、会聚角变化值等是影响立体效果的重要因素。为使电子双目与人眼取景模型更贴合,仅研究主要影响因素,对研究模型作出假设:两个摄像机的镜头完全相同,即聚焦值、白平衡、光圈值等参数相同;两摄像机视野和目标距离均相同,即摄像机和目标左右对称;摄像机观测距离在一定范围内,暂不考虑摄像机自动变焦和视角变化等问题;摄像机镜头中心和目标点在同一平面内,避免产生垂直视差;在工作过程中两个摄像头相对位置不变,成角固定;场景光线正常,所得图像对符合要求。

3.2 图像无线传输模块

3.2.1 视频图像无线回传

选择路由器形成局域网的方式传送图像,如图14所示。

3.2.2 OpenWrt系统

利用OpenWrt系统进行图像无线传输的流程如图15所示。

3.3 构建3D立体环境

3.3.1 虚拟现实设备

虚拟现实技术由计算机硬件、软件及各种传感器构成三维信息的虚拟环境,在虚拟现实环境中可直接实现虚拟场景中的实物交互。从本质上看,虚拟现实技术是一种先进的人机交互技术,其追求的技术目标是尽量使用户与电脑虚拟环境进行自然式交互。

场景显示方式及设备是虚拟现实系统中人机交互的基本组成部分,按照显示方式分为头盔式显示、投影式、手持式和自由立体显示方式等,本系统采用头戴式设备进行研究与改造。

由于虚拟现实设备需要高精度传感器、高清显示屏和强大的计算能力等高端技术,因此大部分虚拟现实产品均基于个人电脑。本系统使用备受关注的基于手机的虚拟现实环境头戴设备,如图16所示。该设备将手机作为显示器,通过分屏软件及设备使电子双目摄像头捕捉的两幅图像分别呈现于手机显示屏的左、右半屏,通过头戴设备观测,图像映入人的大脑后经处理产生立体沉浸感。头戴设备上将安装陀螺仪姿态传感器芯片,监测头部运动形态,完成相应的人机交互,实现立体沉浸式体感控制。

本系统所用头盔式显示设备为Cardboard,Cardboard是款简单的3D眼镜,将手机安装于设备前方作为显示器,在该设备上安装相应的陀螺仪姿态传感器并连接至单片机,配合相应软件控制即可实现沉浸式体感控制:陀螺仪传感器芯片可实时检测使用者头部的位置和方向,并将信息传输至单片机,单片机根据使用者头部位置和方向信息计算出人体当前姿态,从而控制摄像头移动到相应位置,显示当前视点下的场景,人体视点与电子双目的同步性和交互性让使用者产生强烈的沉浸感。该方案的优点在于Cardboard价格低廉,通用性好且便携。

3.3.2 图像分屏显示

图像通过无线方式传输到PC机后,通过登录两个网页分别呈现电子双目采集的图像,如图17所示。使用Splashtop可将画面投射到手机显示屏上进行同步显示。在使用头盔式显示设备观测前,需要在手机上手动将两幅图像调整到中间位置。经过多次测试,利用此方法可以得到延迟少、效果较好的图像显示,基本满足同步性、画质及立体的要求。

4 实验样机

4.1 硬件系统

4.1.1 可穿戴部分

系统可穿戴部分主要由传感器手套、头盔式虚拟现实设备组成。

传感器手套需要搭载不同数量的MEMS陀螺仪加速度传感器模块、无线发送模块、供电装备(传感器供电和无线发送模块供电电压为+3.3 V)。为保证每一个关节的运动都被捕捉到,需要精准地设计传感器的分布位置,确定其运动的初始位置等。

头盔式虚拟现实设备包括MEMS陀螺仪加速度传感器模块、头盔框架、透镜、无线发送模块、显示器搭载台、供电装备。在头戴设备上加入姿态传感器感知使用者的姿态信息来控制电子双目的移动,就构成了强交互性、高自由度视点的沉浸式视频体验和智能体感控制系统。

4.1.2 机器人部分

硬件组成包括搭载小车模块、双目摄像头和舵机云台、机械臂仿生模块。

小车模块:小车上装配有32路舵機控制板、树莓派、电平转换装置、直流电机、锂电池(舵机供电电压+5 V)等。小车可以遥控操作,搭载一定质量物品(不高于5 kg)。

双目摄像头和舵机云台:人的两只眼睛在观看物体时,双眼的观看角度略有差异,这种细微差距通过视神经传输到大脑中枢系统,大脑对其进行辨析处理,从而产生物体远近错落的景象,实现立体效果。

机械臂仿生模块:固定在小车底盘的机械臂模块由无线接收装置、舵机控制器、舵机组成,与人体的手臂稍有不同的是,机械臂的关节有四个自由度,不包含上臂和肩关节,即通过肘关节、下臂、手掌完成操作。

4.2 样机测试

对系统的机械臂控制、VR立体沉浸模块及系统整体运行状态进行测试。

(1) 机械臂控制测试

机械控制的动作性强,舵机控制精度达0.74°,控制端具有较高的自由度和灵活度,能够与使用者的姿态动作保持一致和同步。同时使用者姿态信息的采集和捕捉要灵敏且快速,执行机构(机械臂等)惯性小,能够快速准确响应。能耗低,可持续工作4 h。

(2)VR立体沉浸模块测试

将移动机器人上的双目视觉传感器的视频信号通过无线网络传输到由手机构成的虚拟现实设备上,实验结果表明,系统具有较好的3D视觉效果,立体感的形成及画面的实时传输性较好,延迟约为0.5 s,本次设计可满足500 m无线通信。

(3)样机综合测试

操作人员利用立体沉浸式系统控制移动机械臂完成货物的搬运,基本满足了项目的设计要求。

5 总结与展望

本项目在分析国内外相关技术研究现状的基础上,基于体感控制和虚拟现实技术,提出了立体沉浸式远程体感智能控制器的设计方案,将其应用到了轮式移动机械臂的远程立体沉浸式体感控制中,并对原理样机进行了相关测试,系统具有通信距离远、自由度高、延时小等优点。未来将进一步提升系统的远程信息传输能力,使其能够更好地适应恶劣的野外环境。