基于特征复用的膨胀-残差网络的SAR图像超分辨重建

李 萌 刘 畅

①(中国科学院空天信息创新研究院 北京 100190)

②(中国科学院电子学研究所 北京 100190)

③(中国科学院大学 北京 100049)

1 引言

合成孔径雷达(Synthetic Aperture Radar,SAR)具有的全天时、全天候特性使得SAR图像被广泛应用于各个领域,如目标检测、地物分类和变化检测等。图像分辨率作为评价SAR图像质量的一个重要指标,分辨率越高的图像会携带更多的语义信息,在后续的高级视觉任务中,能够产生更好的处理效果。然而由于经济因素的限制,以及SAR成像系统的本身硬件设备限制,大批SAR图像来自于低端图像采集设备或者未经过无损的保存,导致采集到的SAR图像数据多以低分辨率的形式存在,严重限制了后期的应用需求,因此需要进行SAR图像分辨率的提高。

SAR图像分辨率提高通常有3种途径:其一是改进和更新硬件,如通过增大系统的发射带宽和合成大孔径来提高系统理论分辨率;其二是如现代谱估计法[1]和数据外推法[2]等在成像阶段对SAR成像系统采集的原始回波数据进行处理,但它们对信号模型的依赖性很强,且计算量十分庞大;其三为图像超分辨重建(Super Resolution,SR)方法,即对成像后的SAR图像运用图像处理方法,从而实现分辨率提高。受限于SAR相干成像原理,并且改进和更新硬件所需的周期长、成本高,图像超分辨重建算法的运行成本低,而可行性好,具有重要意义。

插值作为最传统的SAR图像超分辨重建算法,其计算简单、复杂度低,结果计算十分迅速,能够满足实时任务需求。最常用的插值方法为最近邻插值法[3]、双线性插值方法[4]和双三次插值[5],但由于插值法只利用了图像邻域之间的相关信息,因此重建得到的图像精度很低。相较于插值法,Yang等人[6]提出的基于稀疏表示的图像重建方法ScSR(Super-Resolution Via Sparse Representation)可以得到效果较好的超分辨重建结果。其利用图像块的稀疏性训练得到高低分辨率图像块之间的一对字典,实现了高低分辨率图像映射关系的自主学习,然而由于训练集样本受限,因此使用范围较窄。相较于传统的SAR图像超分辨重建算法,卷积神经网络(Convolutional Neural Network,CNN)能够自适应地捕获特征,联合特征网络训练上采样模块,通过图像库直接训练低分辨率(Low Resolution,LR)图像到高分辨率(High Resolution,HR)图像的端对端的映射函数,具有更好的操作性和灵活性,因此能够得到更加准确的超分结果,是目前运用最广并且效果最好的超分辨重建算法。

目前,CNN已被广泛运用到SAR图像超分辨重建领域。例如,Dong等人[7]设计的SRCNN(Super-Resolution Convolutional Neural Network)方法使用前馈的3层卷积神经网络做非线性映射,首次将CNN应用至超分辨领域,但该算法需要对原始高分辨率图像进行两次采样操作来生成输入图像,导致时间开销很大;由于输入的低分辨率图像和输出的高分辨率图像在很大程度上是相似的,也就是低分辨率图像携带的低频信息与高分辨率图像的低频信息相近,训练时带上低频信息部分会多花费大量的时间,Kim等人[8]提出的VDSR(Very Deep Super Resolution)模型将He等人[9]提出的残差结构添加进超分辨模型,在提升效率的同时进而解决了之前网络结构比较深时无法训练的问题;Wang等人[10]使用生成式对抗网络(Generative Adversarial Networks,GAN)来实现SAR图像超分辨重建;Li等人[11]进一步探索了基于反馈机制即权重共享的CNN在超分任务中的运用。

在算法精度方面,全卷积超分辨算法[8-10]均选择普通残差结构作为特征提取模块。然而普通残差单元的感受野较小,因此对微小细节并不敏感,导致小目标的超分效果不够精细,甚至信息无法重建;为增加网络感受野,许多网络结构[12-14]会使用数量庞大的残差块结构,由于网络层数多、结构复杂,以致训练网络十分困难,难以快速达到收敛。而膨胀卷积(Dilated CNN)[15]通过存在空洞的卷积核实现尺寸不变的输出特征图,既能实现特征的快速提取,又能保持微小目标的信息重建。因此本文基于一种膨胀-残差卷积神经网络(Dilated-Resnet CNN,DR-CNN)来提升分类效率。该结构实质上是将残差单元中的普通卷积更替为膨胀卷积,因此很容易实现和迁移推广到复杂的网络结构中。

另外,考虑到全卷积超分辨网络作为一个编码-解码框架,低等级的特征图包含更多的简单信息,比如边界、颜色,而高等级的特征图则可以捕获更抽象且强语义的高维特征,因此本文采用把不同等级上具有相同尺度的特征图叠加后再送入下一步的卷积操作,即特征复用[16]。这种设计可以使特征提取模块同时利用不同尺度上的低级特征和高级特征,从而来捕获更多空间上下文语义特征,进一步提升DR-CNN模型的超分辨精度,文中称该算法为特征复用的膨胀-残差卷积神经网络(Feature Reuse Dilated-Resnet CNN,FRDR-CNN)。同时,在网络中引入感知损失,以此克服SAR图像斑点噪声的干扰,实现了高精度的SAR图像图像重建。

综上,后文的结构安排如下:第2节介绍卷积和感知损失等相关理论;第3节详细介绍DRCNN结构以及FRDR-CNN结构;第4节为实验部分,基于某研究所所提供的某地区两对不同场景下相同空间分辨率的SAR图像,验证了本文采用算法的准确性和可行性。

2 原理介绍

2.1 膨胀卷积

卷积神经网络通过使用局部操作按阶层对不同图像特征进行抽象,随后连接非线性激活层对图像进行去线性化[17]。随着数据的大规模化和计算机硬件的飞速发展,多层CNN模型展现了极大的优势。常见的多层CNN特征模型如VGG[18],ResNet[9]和DenseNet[16]等,并已应用于图像超分辨、图像降噪、目标检测与识别、地物分类和分割等诸多研究领域。

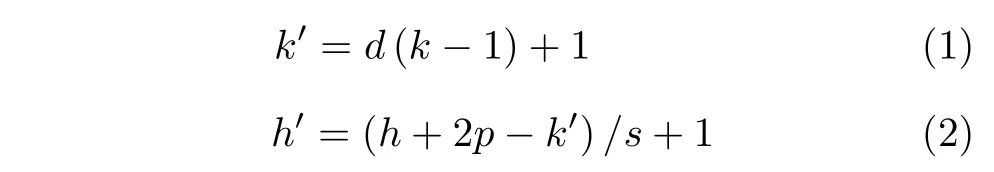

膨胀卷积[15]通过设置不同大小的膨胀因子(dilation rate)对普通卷积窗进行空洞填充(hole padding),填充的元素不会随着学习做出调整,在不增加卷积核参数量的情况下使卷积核的感受野扩大。膨胀卷积的计算方式与普通卷积相同,卷积核逐像素滑动,当滑动至某个像素点后,计算该像素点的邻域像素矩阵与卷积核模板的滑动内积。膨胀卷积的感受野大小和产生的特征图分辨率计算公式为

其中,d为膨胀因子,k,k′分别表示原始卷积核和膨胀后的卷积核尺寸,h,h′分别表示输入和输出特征图的分辨率大小,p表 示边缘填充尺寸,s为滑动步长。

图1为卷积核大小为3×3时,不同膨胀因子所对应的膨胀卷积核感受野大小示意,其中图1(a)对应膨胀因子为1的3×3卷积核,简记为1-Dilated conv,其感受野为3×3;类似地,图1(b)图对应2-Dilated conv,膨胀因子为2,虽然卷积核大小只有3×3,但感受野已扩大至5×5;图1(c)图对应5-Dilated conv,膨胀因子为5,感受野扩大至11×11。不难发现,当膨胀因子为1时,膨胀卷积等价于普通卷积。

膨胀卷积能够在不增加卷积核参数量的情况下扩大卷积核的感受野,因此,不需要通过池化操作降低特征图的分辨率,便可获取到比较高级的语义信息,从而能够有效避免特征图分辨率降低带来的图像局部细节信息损失严重的问题;另外,不同大小的膨胀因子的使用,能够形成不同尺寸的卷积感受野,从而注意到不同尺度的图像特征。

2.2 残差网络

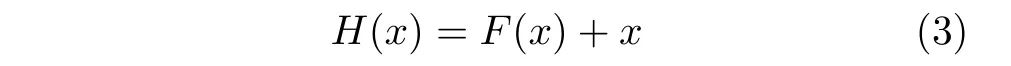

卷积神经网络通过一系列网络层学习层次性特征,随着网络层数的加深,提取细节与抽象能力越丰富,语义信息越完整。因此,理论上深层网络模型的特征提取能力将优于浅层模型。但实际层数迭代的增加也极大地增加了网络权值的训练时间,而且容易出现梯度爆炸或梯度弥散,从而造成训练结果的准确率饱和甚至下降。针对以上问题,He等人[9]提出了残差网络ResNet,其利用拟合残差函数的思想,在保证网络结构足够深的同时,实现了训练过程的优化,有效克服了退化问题,结构如图2(a)所示。

简单而言,残差网络通过卷积神经网络学习残差函数F(x),并与输入的特征图x相加,从而得到输出函数H(x),可以表示为

图1 膨胀卷积原理图Fig.1 Dilated convolution schematic

图2 残差单元结构Fig.2 Structure of residual unit

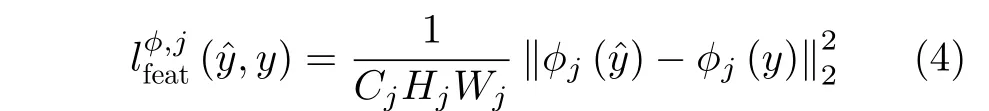

2.3 感知损失

利用卷积神经网络对图像进行超分辨重建时,基本都是通过最小化输出的重建图像和原始高分辨图像之间的平均平方误差(Mean Square Error,MSE)来衡量两者的相似性,这种基于像素点的损失函数虽能得到不错的超分辨率结果,但也会导致超分辨重建中细节等高频信息很难较好地恢复,感知质量较差。JOHNSON等人[19]提出了一种基于特征的损失函数,感知损失(perceptual loss)。在超分网络的后端接入一个权重不更新的VGG16网络[18],利用训练好的VGG16的某层输出作为高维抽象特征学习器,将VGG16提取的特征作为目标函数,通过对比重建图像和原始高分辨图像的特征值,从而判断超分辨率重建结果是否符合自然图像分布规律。感知损失的定义为

值得注意的是,使用不同层的特征输出作为损失函数,将会产生不同的超分辨重建结果,选择低层的特征图,会导致感知损失无法提取到高级的特征,从而影响损失函数的判别结果。若单纯使用高层的特征,则会严重降低训练速度。针对超分任务,文献[19]在实验中证明使用VGG16中relu2_2特征图输出作为感知损失计算层时超分结果最佳,本文沿用该准则,将感知损失加入SAR图像超分辨重建的目标函数,期望重建图像在高层次的语义特征层面和原始高分辨率图像更加逼近。

3 特征复用的膨胀-残差卷积神经网络

本节将详细地介绍基于特征复用的膨胀-残差卷积神经网络(FRDR-CNN)。本文的主要思想与文献[14]类似,设计了一种膨胀-残差单元结构(DR-CNN),并利用DR-CNN为主体框架,构造FRDR-CNN网络作为超分辨生成式对抗网络中的生成网络。鉴于生成式对抗网络的难以解释性,本文只使用生成模型来完成SAR图像的超分任务。

3.1 膨胀-残差单元

图像超分辨问题是一个相对来说比较低级的图像语义问题,特征提取模块决定了图像超分辨效果的上界。作为最常用的特征提取网络,提升感受野通用的方式为增加网络层数,但会带来计算量的激增。另外,将原始图像输入到传统的Res-Net网络模型[9]经过特征提取后,特征图的分辨率会缩小为输入图像的1/32,导致图像大量局部细节信息损失,严重影响图像边缘等微小结构信息的保留能力,这与超分辨任务的初衷是违背的。针对此问题,参考文献[20]的思路,本文设计了一种膨胀-残差单元结构,如图2(b)所示。通过膨胀卷积限制特征图分辨率的严重损失,有效保留更多的细节信息,同时改善了感受野与中低层网络不能并存的矛盾。

DR-CNN结构抛弃传统残差单元中的普通卷积,使用膨胀卷积进行残差块的构建,为保证结构中卷积核的连续性,设计原则应满足混合膨胀卷积框架设计原则(Hybrid Dilated Convolution,HDC)[21]。

本文选择采用Dilation rate分别为[1,2,5],配合3×3大小的卷积核作为DR-CNN的构成元素,对比传统的残差单元,根据式(1)、式(2),可以计算出,DR-CNN使得一个残差单元的感受野由普通的5×5扩大至15×15。DR-CNN单元可以被视作独立的模块,因此能够很容易地加入各种全卷积神经网络中,具有很强的可迁移性。

3.2 特征复用的膨胀-残差卷积神经网络

DR-CNN作为变种的残差单元结构,单纯增加残差单元的个数,不能最大化利用不同尺度上的低级特征和高级特征,提取特征的效率较低。为了提升DR-CNN提取特征的精确度,本文将不同层级的DR-CNN对应的卷积层加入跳线连接结构,将两部分具有同样尺寸的特征图做相加操作后再输入到下一个卷积层,实现了高低维特征的特征复用,称为FRDR-CNN,结构图如图3所示。该结构能够让反向传播信号直接传递到底层,一定程度上解决梯度消失的问题,同时能够实现不同层级的特征最大化利用,从而大幅度提升SAR图像超分辨重建精度。

为加深网络层数,本文在设计的特征提取模块中引入了16个DR-CNN单元。图3中的k表示卷积核大小,s表示卷积步长,n表示卷积核的通道数。为了保证特征复用时跳跃连接的可行性,FRDR-CNN网络要求DR-CNN单元内部的所有膨胀卷积核的边缘填充模式均使用“SAME”模式,且特征图数量和残差块中的特征图通道数均为64,也因此实现了经过FRDR-CNN网络的特征提取部分后输出特征图与输入图像尺寸一致。

SAR图像超分辨任务中的上采样方式有许多种,例如插值(interpolating)、像素重组(pixel shuffle)[22]、转置卷积(deconvolution)[23]等。为保证重建过程参数的可训练性,同时实现信号复原,在FRDR-CNN模型的后端,接入转置卷积作为FRDR-CNN的上采样模块,以此建立LR图像到HR图像端到端的超分辨过程。为了减弱转置卷积带来的棋盘格效应,需要保证卷积核的尺寸大小可以被步长整除,本文采用的卷积核尺寸为4×4,步长为1,通道数为64。

FRDR-CNN网络中首端的普通卷积负责将输入的LR图像进行初级特征提取,并进行通道扩增至64;末端的普通卷积对经过转置卷积实现尺寸放大后的特征图进行通道压缩,将输出置为单通道,即可得到最终的SAR图像超分辨重建结果。将输出结果与真实HR图像送入训练好的VGG16[18]网络,计算二者在高维特征上的均方误差,通过反向传播修正FRDR-CNN网络的参数。

另外,FRDR-CNN中的所有激活函数均使用ReLU[24],为节省位置在结构图中并未画出。其具体形式为

其中,I表示输入图像,S表示经ReLU激活后图像。FRDR-CNN模型的最后一层不使用激活函数。

4 实验结果和分析

为了验证FRDR-CNN模型的超分辨重建能力,本节选择传统重建算法双三次插值(bicubic)[5]、基于稀疏编码的重建算法(ScSR)[6]、参数规模相当的SRResNet[14]与膨胀-残差卷积DR-CNN和采用特征复用后的FRDR-CNN进行对比试验,并尝试在实验中选择是否使用感知损失计算重建误差。本实验所用计算机配置为Intel(R)Xeon(R)CPU X5650@ 2.67 GHz,内存为16 GB RAM,GPU为NVIDIA GEFORCE GTX 1070Ti,显存为8 G,实验环境为Pytorch深度学习框架。

4.1 实验数据介绍

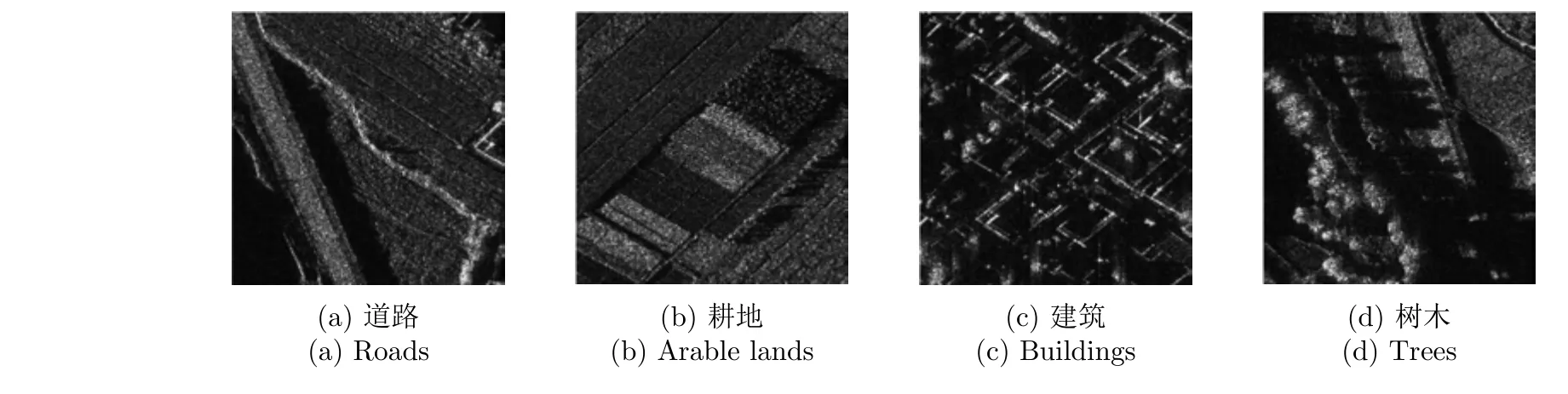

本章实验用到的数据来自某研究所提供的某地区两对不同分辨率的机载SAR图像,图像空间分辨率为0.5 m,图像大小为8192×16384,图像中有农田,道路以及少量建筑,包含的信息比较丰富,典型场景如图4所示。

图3 联合感知损失的FRDR-CNN网络结构Fig.3 Structure of Feature Reuse Dilated-Resnet CNN(FRDR-CNN)with perceptual loss

图4 数据集中的典型场景图Fig.4 Typical scene graphs in the dataset

和光学图像超分辨的数据处理过程相同,参考Wang[25]的实验过程,本文将原始SAR图像视作高分辨图像(HR),使用三次方插值(bicubic)将HR的物理宽和高分辨率均缩小至1/4大小,以此作为低分辨数据(LR)。这种策略能够弥补SAR图像数据不足的缺陷,另外也解决了HR与LR严格配准难度大的问题。将一整幅HR的SAR图像裁剪为256×256像素的小图像作为标签图像,同样对应的LR的SAR图像裁剪为64×64像素的小图像,为扩充数据量,采用0,90,180和270°的图像旋转,图像翻转以及图像镜像等操作进行数据增广(data augmentation)。共生成6000对数据集,选取其中5对作为测试图像,其余数据作为训练数据。其中测试图像含有树木,河流、耕地等不同场景,以测试算法模型的鲁棒性。

4.2 SAR图像超分辨评价指标

为了对SAR图像超分辨算法效果进行客观评价,本文选取峰值信噪比(Peak Signal to Noise Ratio,PSNR)[26]、结构相似性指数(Structural SIMilarity index,SSIM)[27]和边缘保持系数(Edge Preservation Degreebased on the Ratio Of Average,EPD-ROA)[28]作为重建图像质量的客观评价指标。

PSNR由均方误差决定,以原始的高分辨率图像作为基准,定量对超分辨重建后的结果进行评价,其计算如式(6)所示

其中,MSE(x,y)表示x,y两幅图像之间的均方误差,L为图像的灰度级。PSNR值越大,表示两幅图像的相似度越高。

SSIM可以有效反映图像整体结构相似性,其定义如式(7)所示其中,x,y分别代表原始图像和超分辨重建图像,l(x,y)表征亮度对比,s(x,y)表征结构信息对比,c(x,y)表征对比度对比,而α,β和γ 3个指数用来调节亮度、结构信息及对比度3部分在SSIM指标中所占的比例大小。SSIM值越接近1,表示超分辨重建图像与原始图像的结构相似度越强。

EPD-ROA的HD和VD计算值可以反映重建图像在水平和垂直方向的边缘保持度,有利于超分重建算法对边界等高频信息的恢复效果。其定义为

其中,m为选定区域内的像素总数,X1(i),X2(i)代表重建图像沿水平和垂直方向上的两个相邻像素,Y1(i),Y2(i)代表原始高分辨图像中与X1(i),X2(i)相邻的两个像素。EPD-ROA的分子表示测试图像的边缘总量,分母表示真实的边缘总量,其值越接近1,表示超分辨重建图像的边缘保持性越好。

4.3 实验结果与分析

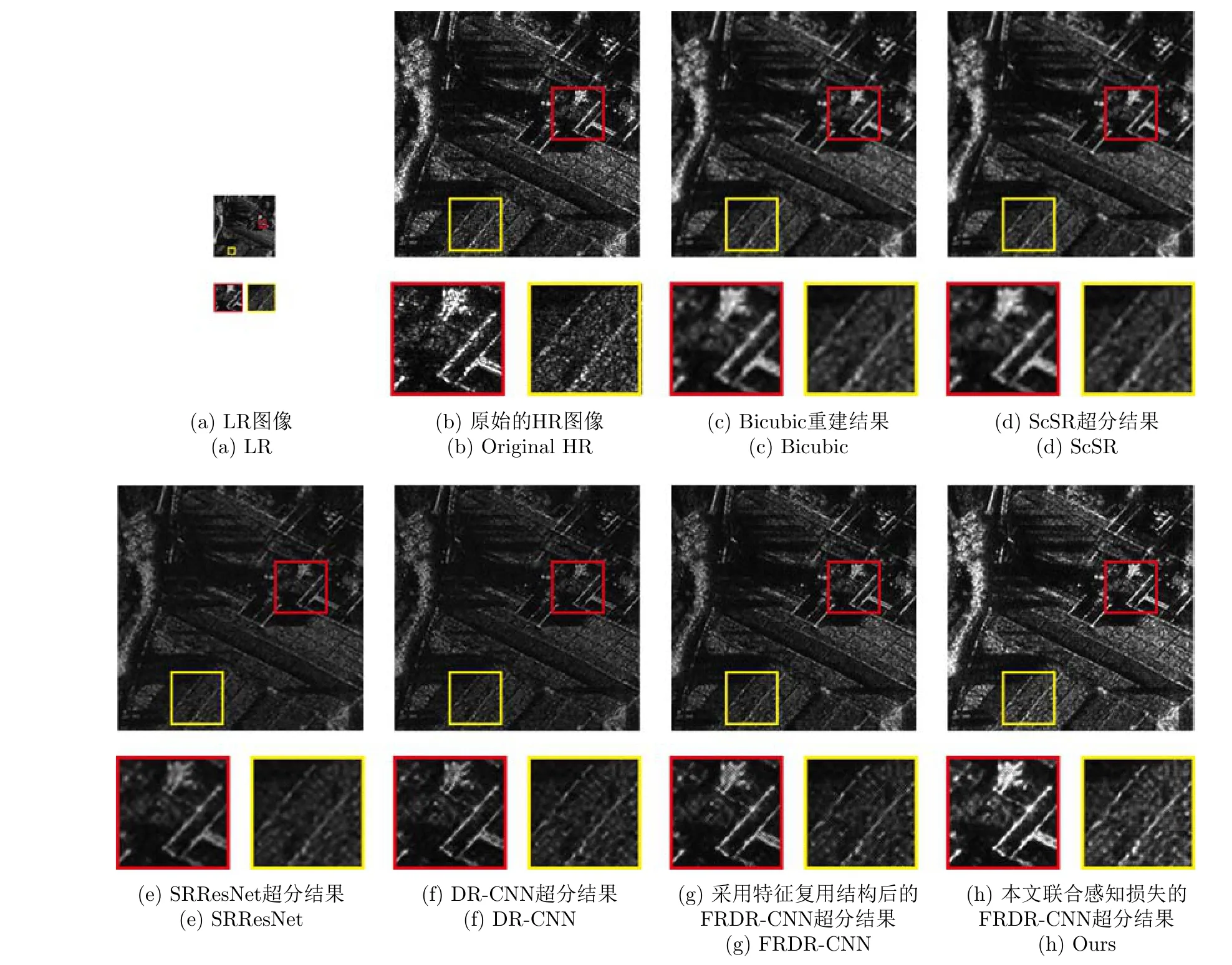

图5和图6给出了两幅SAR测试图像的4倍超分辨结果及局部放大图,其中下方小图为上方大图对应颜色框部分的细节放大展示。其中,图5(a)与图6(a)为LR图像,图5(b)与图6(b)为原始的HR图像,图5(c)与图6(c)为Bicubic重建结果,图5(d)与图6(d)为ScSR的超分辨结果,图5(e)与图6(e)为SRResNet超分结果,图5(f)与图6(f)为DR-CNN超分结果,图5(g)与图6(g)为采用特征复用结构后的FRDR-CNN超分辨结果,图5(h)与图6(h)为联合感知损失的FRDR-CNN的超分结果。

主观上,从图5和图6可以看出,Bicubic和ScSR的结果整体上十分模糊,边缘细节的恢复效果较差,如图5(c)和5(d)中的耕地界限。DRCNN与SRResNet超分算法的视觉效果比较接近,这两种方法均比传统算法得到的结果线条更为锐利,且能够恢复较多的小目标信息,如图6(f)红框中的树木。从图5(g)和图6(g)可以看出,采用了特征复用结构后视觉效果提升十分明显,极大地增强了图像的纹理重建效果。联合了感知损失后的FRDRCNN层次感比较分明,整体更加明朗,同时细节更为清晰,点线目标的保持性较好,在图5(h)和图6(h)都有所体现。总体上,针对4×放大任务,本文提出的基于感知损失的FRDR-CNN与HR图像的差异性最小,在视觉上具有最理想的SAR图像重建效果。

图5 场景1的SAR图像超分结果及局部放大图Fig.5 Super resolution results and partial enlargement images of scene 1

选择峰值信噪比PSNR[26]、结构相似性指数SSIM[27]和边缘保持系数EPD-ROA[28]作为图像质量的客观评价指标。与图5和图6对应的两个场景的超分客观指标由表1给出。

由表1结果可以看出,基于卷积神经网络的超分辨算法在指标上领先Bicubic方法很多;DR-CNN表现明显优于SRResNet,证明了膨胀-残差网络的有效性;采用特征复用结构后,使得FRDR-CNN算法的PSNR较DR-CNN提高了约0.80 dB,而SSIM和EPD-ROA计算值则提高了1.7%;感知损失的加入将FRDR-CNN算法的PSNR指标计算值提升了1.0 dB,而SSIM和EPD-ROA指标计算值分别提升了约0.010和0.015,这与图5和图6的主观感受是一致的。

为对所有场景进行客观评价,探讨模型的稳定性和鲁棒性,并进行算法的时间消耗评估,图7展示了6种算法对应的5张测试图像的平均PSNR,SSIM与EPD-ROA值。为便于展示,图7中将PSNR值除以了100。

从5组测试集的评估图中可以看出,基于特征复用的膨胀-残差网络在联合了感知损失后,PSNR均值为33.5023 dB,SSIM均值为0.5127,EPD-ROA(HD)均值为0.4243,EPD-ROA(VD)均值为0.4373,4个指标均为6种算法最高,说明该方法与原始HR图的相似度和边缘保持能力都达到了最优。基于特征复用的膨胀-残差网络能学习更多的上下文语义特征,并具有超大感受野,从而提升了微小目标和细节的超分效果。同时,感知损失由于使用了高级语义特征,能够根据像素的空间关联信息判断图像之间的相似度,使得FRDR-CNN的超分效果实现了进一步提升,在图像全局和边缘细节上都有最好表现。综上,上述实验验证了基于特征复用的膨胀-残差网络模型能够实现高精度的SAR图像超分辨重建。

图6 场景2的SAR图像超分结果及局部放大图Fig.6 Super resolution results and partial enlargement images of scene 2

表1 场景1和场景2的SAR图像重建结果表Tab.1 SAR image reconstruction results table of scene 1 and 2

5 结论

本文通过联合了感知损失的FRDR-CNN算法实现了精准的SAR图像超分辨重建。该算法首先提出一种膨胀-残差单元结构,在保留边缘结构信息的情形下仍可获得超大感受野;通过特征复用,实现了不同层级的特征最大化利用,以此捕获更多上下文强语义特征,进而提升小物体的超分精度;引入感知损失来约束超分辨率结果,实现了边缘信息的精准重建。实验表明,相较于Bicubic和普通残差超分辨网络,DR-CNN在主观感受和客观指标均取得了精度上的大幅度提升,同时,DR-CNN作为一种独立的单元模块,也具有很强的迁移性。使用特征复用结构构成的FRDR-CNN进一步提高了DR-CNN算法的精度,联合了感知损失的FRDRCNN算法得到了更为逼真和准确的超分辨重建结果,因此具有很强的实用性。

图7 5张测试图像的平均SSIM与EPD-ROA值Fig.7 Average SSIM and EPD-ROA values for five test images