基于特征融合的复杂场景多目标跟踪算法研究

摘要:在复杂地物类型背景条件下,多目标跟踪算法通常表现出目标识别与跟踪能力较差问题,特别在被其它地物遮挡后目标跟踪丢失更严重。提出一种改进的基于多源特征提取与特征融合的多目标跟踪算法。为提高目标在复杂背景下的空间分辨力,充分利用对异类物体判别能力较强的高层特征和针对同类不同物体判别能力较强的浅层特征,提高复杂背景下地物目标的识别能力。同时,为了解决物体被遮挡后导致跟踪算法丢失目标问题,利用滤波器获得追踪目标的空间尺度大小,提高跟踪算法的准确性与可靠性。实验表明,多目标跟踪算法识别目标的准确性可达87.5%,误差在±2.31%左右,具有良好的尺度估计效果。

关键词:机器视觉;特征融合;目标跟踪;尺度估计;运动检测

DOI: 10. 11907/rjdk.191604

开放科学(资源服务)标识码(OSID):

中图分类号:TP312

文献标识码:A

文章编号:1672-7800( 2020)004-0046-04

Research on Multi-target Tracking Algorithm for Complex Background

Based on Feature Fusion

WANG Zhi-yu1.2

(l.College of Computer Science arzd Engineering , .Sh.andong Univer.sity of Scie,zce and Tech.nology ,

Qingda0 2665 90 , Ch.ina ;

2. Huangrlao District Ch.inese Medicine. Hospital, Qingda0 266500 . Clzina )

Abstract: In the context of conlplex object types, multi-target tracking algorithrus usually show poor target recognition and targettracking ability, especially after being occluded by other objects, u-hich will lead to the loss of tracking sef targets. A multi-fargettracking algorithm for rnulti-source feature extraction and feature fusion is proposed in order to improve the spatial resolving power of'neural networks. iuake f'ull use of' different depth f'eatures and high-level f'eatures that have strong discriminative ability for heteroge-neous objects and discriminate against different objects of the same kind. Strong shallow features and multi-source fusion for featuresare fully used to improve the recognition of ground objects. At the same time. in order to solve the problem that the tracking algorithmloses the target after the object is occluded. the scale filter is used to calculate the spatial scale of the target, and the performance ofthe iuulti-target tracking algorithm is improved. Field experiments show, that multi-target tracking algorithm can achieve target accura-cy of 87.5% , error rate is +2.31% . and the algorithm has good scale estimation effect.Key Words : machine vision ; feature fusion ; target tracking; scale estimation ;motion detection

O 引言

深度卷积神经网络可以提取并表达目标的深层特征,被广泛用于提高目标追踪算法的准确性,适用于运动目标轨迹不断变化情况。但卷积预算过程中大量的矩阵操作导致计算量较大,影响多目标追踪的时效性,为此学者进行了相关研究。如周奇等…利用多特征进行轮船运动目标的跟踪和轨迹获取;李宁宁等[2]利用基于中心对比的卷积神经网络实现特定目标的跟踪算法;冯乐乐等[3]基于连续帧神经网络实现行人的白动检测。这些算法都有效利用了卷积神经网络强大的多尺度特征表达能力,但神经网络高层卷积层输出特征尺寸较小,使用高层特征进行目标跟踪时受各种外界因素的影響[5-6]较大,难以达到理想效为解决此问题,通过局部裁剪方式。[7]计算前一帧图像的预测结果作为当前帧的中心,根据滤波框架位置裁剪出一块略大于目标尺寸的局部区域,通过图像采样处理,输入到卷积神经网络。利用基于纹理和空间信息的多特征融合算法,通过目标的多尺度高层特征提高目标识别的准确性。

针对复杂场景图像局部裁剪引起的运动目标跟踪丢失等问题。[8-9],本文提出一种改进的基于深度卷积特征融合的多目标跟踪算法,利用多尺度融合特征提高目标的空间分辨能力和目标识别能力。

1 算法流程及步骤

传统的目标检测和跟踪算法普遍利用梯度“0。、纹理llll和边缘[12]等特征,在分离图像前景和背景基础上,采用特定模型在待检测图像中进行特征匹配。但是,这类方法通常实现起来比较复杂[13-14],并且容易受到外界环境因素和目标自身形态变化的影响。在场景不受限制的条件下,人T设计的特征较难适应各种动态变化[15];在实际应用场景下,由于背景的复杂性和多样性,造成运动目标检测效果不佳。

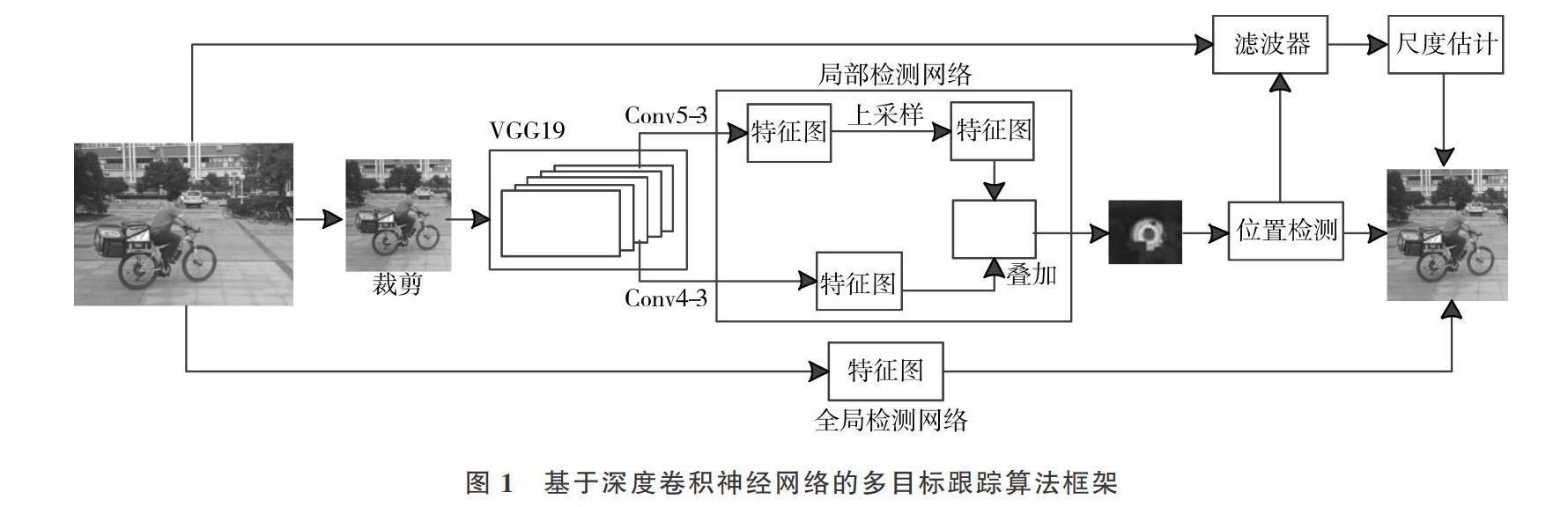

本文针对复杂背景下多目标跟踪问题,利用深度卷积模型VGG19,采用滤波器提取目标区域的多层次深度卷积特征,设计了改进的多目标跟踪算法,主要包含目标定位、目标尺度计算和模型更新。本文提出的目标跟踪算法框架如图1所示。

1.1 定位阶段

1.1.1 局部检测模型

利用裁剪的目标局部区域,对多尺度目标图像的深层特征进行特征提取和特征融合,通过改进的反卷积层,上采样处理Conv5输出特征图,使其与Conv4层的特征图尺寸大小相同。用两个特征图构造一个叠加的高层特征图,提取高层深度特征,得到局部检测模型的预测输出结果。

使用第一帧图像进行训练。在局部检测模型给定的目标框周围,沿着目标框边缘进行裁剪,将裁剪得到的局部区域图像拉伸至VGG19网络的输入尺寸,并输入到网络得到特征图,输出预测追踪目标在热度图上对应的每个点出现的概率大小。

计算损失函数,实现局部检测网络训练。

其中,M,为局部检测模型输出,M2为目标热度图,它符合二维高斯分布,采用随机梯度下降法进行模型参数的训练。

计算前一帧图像预测的目标位置,并以该位置为中心进行目标局部区域的图像裁剪。根据追踪目标的预测热度图,计算概率最大的位置为当前数据帧预测目标所在位置。

1.1.2 全局搜索模型

在目标检测过程中,物体的遮挡、光照、阴影以及背景对象的移动等因素都会影响目标检测和识别精度[16-17].本文使用Faster RCNN算法作为全局检测模型,对目标框聚类分析,计算得到目标区域的权值。若超过设定的目标识别阈值,则将权值最高点作为目标新位置,继续利用局部检测模型进行特定目标的识别与跟踪,如图2所示。

本文设计了一种区域生成网络优化策略:①区分目标与背景类型,采取二分类标签判定策略:背景标签为O,目标标签为1;②采样区域生成网络,生成一系列带有权值的矩形区域框。

若局部检测模型特征图输出的最高值大于给定阈值,则作为检测目标位置。此时,将整张图像输入到全局检测网络中,预测出一组带有权值的矩形候选框,获得权值最高的候选区域。如果矩形框的权值大于给定阈值,则将其中心作为当前数据帧目标所在位置,继续利用局部检测网络并跟踪目标。

1.2计算目标尺度

在追踪目标对象过程中,不但要预测给定目标的当前位置,还要计算目标的尺度大小,获得目标在整幅图像中的候选区域[18]。

在确定目标对象位置后,首先以该位置为中心截取不同尺度大小的候选区域,然后将这些图片拉伸至同样大小[19],根据目标框提取不同尺度的特征构造输出。在跟踪过程中,通过不断训练和迭代确定目标对象位置,利用计算尺度滤波器的响应最大值获取当前帧目标框。

1.3 模型更新

在目标对象追踪运动过程中,外观有可能会发生渐变现象[20-21]。为提高目标追踪效率并避免丢失追踪目标对象,要不断更新局部检测模型和尺度滤波器。

根据热度图的最大响应值,如果权值大于阈值,则认为局部检测模型可以对当前图片进行准确检测[22]。利用当前数据帧预测的目标框作为局部检测模型的输入,通过不断迭代更新局部检测模型。

在目标对象跟踪过程中,算法对目标的运动模糊无法进行有效识别,因此该算法不适合对全局检测模型进行更新。

2 特征融合方法

本文没计一种改进的多目标跟踪特征融合方法,主要流程如下:①针对视频中的每一帧图像,识别特定目标与背景信息,分出待识别的目标信息;②提取目标的边缘与纹理特征,建立特征直方图并进行相似性度量;③计算特征相似性度量值,针对计算结果进行目标图像的深层特征融合;④针对视频中的每一帧图像进行处理,构建特征融合匹配矩阵。

目标特征融合方法算法流程如下:

输入:视频、图像

输出:特征融合匹配矩阵

detect video target

get N frames foreground image

for i=l.2.…….N do

extract edge features

generate HSV spatial color histogram

calculate similaritv M

//汁算目标和候选目标的匹配度

extract texture fratures

generate HSV spatial color histogram

calculate similarity M

extract texture fratures

add fusion feature matching ll特征融合

end for

return feature matching matrix

3 實验结果及分析

为检验目标跟踪算法的工作效率,结合实际环境中的复杂地物背景,选取视频序列进行测试,主要考虑光照变化、尺度变化、背景杂乱、目标遮挡、快速运动等因素。

3.1 步行实验

本实验是一种基于连续帧的行人检测,利用连续数据帧提取视频序列的时间和空间特征,提高遮挡行人检测能力。基于行人检测在时间上的持续性,采用目标跟踪算法进行行人检测,预测行人位置,评估行人检测结果,提高行人被遮挡情况下的识别与跟踪能力。

本次实验先后出现3个行人步行状态的跟踪目标,如图3所示。从图3(a)第523帧目标出现在场景中开始,一直追踪行人在马路上行走过程,直到图3(g)和图3(h)行人被大树遮挡,目标追踪丢失。本实验场景较为复杂,算法判别给定目标与背景的准确性达到87.5%以上,误差在±2.31%左右。

3.2 快速运动实验

跟踪该物体一直到视频播放结束,如图4所示。由于加强了尺度估计,算法在平均重叠率和平均中心点误差方面表现较好。目标特征从图片部分区域获得,超出采样区域或目标背景中其它物体遮挡,则裁剪得到的图片中没有目标物,导致目标跟踪算法失败。 4 结语

在计算机视觉领域的复杂场景环境中,目标在运动过程中经常会发生被遮挡、背景杂波干扰和目标形变等情况,造成多目标对象跟踪算法识别效果不佳,当目标被其它物体遮挡时,容易发生目标跟踪丢失问题。

本文针对视频监控环境中的运动目标检测和跟踪问题,提出一种改进的基于多源特征提取和特征融合的多目标跟踪算法。在目标比例发生变化的情况下,利用跟踪框更新机制,自适应调整跟踪框尺寸大小,以适应目标比例变化。充分利用目标的多尺度特征进行特征融合,提高目标对象的判别能力。

經过现场实验验证,本文提出的多目标跟踪算法能够较好地判别给定目标,跟踪准确性有一定程度提高。但该算法针对目标外观特征提取不稳定,利用目标状态特征构造多目标外观特征的稀疏表示模型有利于提高目标跟踪的准确性,下一步将针对该问题进行深入研究。

参考文献:

[1]周奇基于多特征的轮船运动目标跟踪及轨迹获取方法[D].北京:北方工业大学,2018.

[2]李宁宁.基于中心对比卷积神经网络的目标跟踪算法研究[D].北京:北京邮电大学,2018.

[3]冯乐乐基于连续帧卷积神经网络的行人检测方法研究[D]北京:北京工业大学,2017.

[4]尹宏鹏,陈波.基于视觉的目标检测与跟踪综述[J].自动化学报, 2016. 42( 10): 1466-1489.

[5] 闵召阳,赵文杰基于卷积神经网络检测的多镜头多目标跟踪算法[J]舰船电子工程,2017,37(12):25-28,38.

[6] 孙皓,孙显.一种高分辨率遥感图像舰船检测方法研究[J].测绘 科学,2013,38(5):112-116.

[7]李明杰,刘小飞基于粒子滤波和背景减除的多目标检测与跟踪算法[J].计算机应用研究,2018,35(8):2506-2509.

[8]王国坤.复杂背景下基于深度学习的多目标跟踪算法研究[D].合肥:中国科学技术大学,2018

[9]顾苏杭,陆兵.基于轮廓和ASIFT特征的目标检测与跟踪算法[J].计算机仿真,2017,34(6):266-271,339

[10]丁冉冉基于步态识别的人体目标检测与跟踪[D].北京:北京交通大学,2017.

[II]周雅基于目标检测与加权混合特征的目标跟踪算法[J].科技通报,2017,33( 4):138-143

[12]汪宏异,郝群.一种抗遮挡抗干扰的目标检测跟踪方法研究[J]光学技术,2016,42( 4):376-379,384.

[13]郭毓,苏鹏飞基于Faster R-CNN的机器人目标检测及空间定位[J].华中科技大学学报(自然科学版),2018,46(12):55-59.

[14]陈飞,章东平.基于多尺度特征融合的Faster-RCNN道路目标检测[J].中国计量大学学报,2018,29(4):393-397

[15]杨磊,庞芳.基于低秩一稀疏联合表示的视频序列运动目标检测[J].系统仿真学报,2018,30(12):4693-4702

[16]曹雯雯.基于多特征融合的稀疏表示目标追踪方法的研究[D].南京:南京邮电大学,2018.

[17] 陈莹莹,房胜,李哲.加权多特征外观表示的实时目标追踪[J].中国图象图形学报,2019,24(2):291-301.

[18]孙海宇,陈秀宏.联合外形响应的深度目标追踪器[J].智能系统学报,2018(6):1-8.

[19]孙晓霞,庞春江基于全巷积对称网络的目标尺度自适应追踪[J].激光与光电子学进展,2019,56(1):242-250

[20]张伟东,赵建伟基于特征选择与时间一致性稀疏外观模型的目标追踪算法[J]模式识别与人工智能,2018,31(3):245-255.

[21] 李厚彪,樊庆宇基于自适应同时稀疏表示的鲁棒性目标追踪[J].电子科技大学学报,2018,47(1):1-12.

[22]赵中楠,王健基于多源协同感知的目标追踪优化模型[J].北京理工大学学报,2017,37(11):1137-1143.(责任编辑:杜能钢)

收稿日期:2019-04-25

基金项目:山东省自然科学基金项目( ZR2018BFOOI)

作者简介:王志余(1967-),男,山东科技大学计算机学院硕士研究生、黄岛中医医院工程师,研究方向为机器视觉、高性能计算、深度

学习。