在线学习环境下的自我调节学习和学习分析实证研究述评

奥尔加·维伯格 默罕默德·哈利勒

【摘 要】 我们能够根据学生自我调节学习情况预测其学业表现,然而,自我调节学习对学习者而言并非易事。在新兴在线学习环境下自我调节学习能力变得更加重要。学习分析能改变我们提供学习支持的方式从而提升学习表现,因此在培养学生掌握自我调节学习能力上发挥关键作用。本文对2011—2019年间发表的54篇学习分析在在线学习环境下自我调节学习中的应用的实证研究论文做一个概括性评价。本文的研究问题是:学习分析在评价和支持在线学习环境下学生自我调节学习方面的应用情况如何?重点关注学习分析涉及自我调节学习哪些阶段、方法、自我调节学习支持形式、学习分析促进学习的证据以及在线学习环境的类型。本文根据齐默尔曼(Zimmerman)2002年提出的模型划分自我调节学习的不同阶段,而学习分析促进学习的证据则从四个方面进行分析,即学习分析是否提升了学习效果、提高了学习支持和教学支持水平、广泛应用和使用符合伦理道德规范。文献综述结果表明,大多数研究重点涉及自我调节学习的预先计划阶段和行为表现阶段,较少关注反思阶段;提升学习效果(20%)以及学习支持和教学支持水平(22%)的证据不充分;尚未得到广泛应用;遵循道德规范的研究为数不多(15%)。从总体看,学习分析研究主要是为了评价而非支持自我调节学习。因此,非常有必要进一步发挥学习分析支持自我调节学习的作用,培养学生在在线学习环境下自我调节学习的能力。

【关键词】 自我调节学习;学习分析;在线学习;教育;实证研究;文献综述

【中图分类号】 G420 【文献标识码】 B 【文章编号】 1009-458x(2020)12-0028-15

导读:当今以及未来,教育与技术的融合日趋全方位,技术既是教与学的工具,又可以是研究教与学的工具,这是不可逆转的潮流。然而,不管是教与学的实践还是研究,“人性”永远优先于“技术性”,技术不能喧宾夺主,这是教育本质使然的结果。教育领域的一切改革,归根结底都是为了促进学生的学习。有一篇文章介绍西班牙和美国两所大学开展基于技术的协作教师培训“翻转课堂”模式,文章的标题包含这句话“If you dont improve,whats the point?”(如果你没有得到提高,那么意义何在?)①,我认为这句话适用于任何以技术为媒介或技术促进的教与学实践和研究。

学习分析(learning analytics, LA)在很大程度上因大数据而生,过去十年发展迅速,成为许多教育研究者手中的香饽饽。传统上学习分析主要是用于预测学生学业成绩,及时进行教学干预,防止“高危”学生辍学,而现在也被越来越多地用于其他目的,包括支持学生发展终身学习技能和策略、向学生提供个性化和及时学习反馈、支持学生发展协作、批判性思维、交流和创造性等方面的重要技能、支持学生反思以培养他们的学习意识和提供教学创新有效性的实证证据支持优质教与学。①由此可见,如同其他(教育)技术一样,学习分析归根结底也是为了促进学生的学习。2018年,本文第一作者瑞典皇家理工学院(KTH Royal Institute of Technology)奥尔加·维伯格(Olga Viberg)博士等四位研究者在《计算机在人类行为的应用》(Computers in Human Behavior)期刊发表一篇综述②,分析2012—2018年间发表的252篇学习分析在高等教育中应用的研究论文,旨在了解它们所采用的研究方法、数据采集方法、数据分析方法和促进学习的证据;促进学习的证据包括是否提升学习效果、是否支持教与学、是否广泛应用和是否符合伦理道德规范?四个方面综述结果表明,上述四个方面的证据不充分,分别仅有9%、35%、6%和18%的研究呈现这些方面的证据。

本文可以看作是2018年这篇综述的续篇。维伯格博士继续担任第一作者,另外两位作者分别是挪威卑尔根大学(University of Bergen)的默罕默德·哈利勒(Mohammad Khalil)博士和荷兰鹿特丹伊拉斯姆斯大学(Erasmus University Rotterdam)的马丁尼·巴斯(Martine Baars)博士。本文是提交给第十届学习分析和知识国际会议(the 10th International Conference on Learning Analytics & Knowledge)的论文(本次会议原计划2020年3月23-27日在德国法兰克福歌德大学[Goethe University]举行,后因受到新冠疫情影响改为3月25-27日在网上举行)。这篇新作基本沿用原来的框架,但仅聚焦学习分析应用于自我调节学习的研究,同时又将研究背景扩大到基础教育和职场学习,“对2011—2019年间发表的54篇学习分析在在线学习环境下自我调节学习中的应用的实证研究论文做一个概括性评价”。

文章首先闡述提供自我调节学习支持的必要性,并指出本综述的目的是了解学习分析在评价和支持在线学习环境下学生自我调节学习方面的应用情况,具体包括这些研究主要聚焦自我调节学习的哪(些)阶段、运用哪些学习分析方法、以哪些形式提供支持、学习效果是否得以提升、是否提高学习支持和教学支持的水平、是否得到广泛应用、是否遵循伦理道德规范以及用于何种在线学习环境。文章接着简要介绍齐默尔曼自我调节学习三阶段模型,即预先计划、行为表现和反思,指出随着学习分析在评价和支持在线自我调节学习行为方面的潜在优势越来越受到重视,有必要系统回顾这个领域的实证研究,了解言辞与现实的差距,明确今后研究方向。

文章详细、清楚地呈现研究问题涉及的各方面内容的分析结果,我在这里重点转述学习分析是否促进学习的情况,其他内容恕不赘述。文献综述结果表明,没有充分证据表明学习分析提升了学习效果(20%)以及学习支持和教学支持水平(22%),得到广泛应用(“这些研究大多数规模小,涉及学生人数少……和(或)历时短。它们经常只是呈现初步研究结果”)并遵循伦理道德规范(15%)。从总体看,“学习分析研究主要是为了评价而非支持自我调节学习”。换言之,如同其他教育技术一样,言辞(促进学习的潜能)与现实(促进学习的实际效果)之间存在一道鸿沟。在“讨论和结论”一节,作者从三个方面简要讨论本综述结果并提出一些建议和(或)今后实践与研究的方向。

或许正是因为我们对技术促进教育的潜能言过其实,所以现实才这么骨感。2014年英格兰高等教育拨款委员会(The Higher Education Funding Council for England)推出“研究卓越框架”(Research Excellence Framework, REF)用以取代原来的“研究评估活动”(Research Assessment Exercise,RAE),强调必须呈现“感知研究对‘现实世界的影响”的证据(简称“研究影响”)是REF与RAE的主要区别之一。教育技术研究也不例外。③

我认为,对于技术促进教育的潜能,我们既不能盲目乐观、夸大其词,也不能全盘否定,把技术拒之门外。而技术促进教育的潜能能否得到发挥,转化成实际成效?这涉及多方面因素。比如,技术的应用是否具备与之相适应的社会经济基础?是否有助于促进教育公平?是否较之于人力资源(教师)的投入更有成本效益?是否遵循教与学的规律、建立在合适教学法理论的基础上?教学实验的设计和实施是否科学严谨和符合伦理道德规范?是否做到以点带面、逐步推广、迭代创新?研究者是否恪守专业操守全面客观呈现研究发现而不是只报喜不报忧?是否具备解读研究发现的理论和实践素养?教育机构乃至教育行政主管部门是否能做到循证决策?诸如此类的“是否”问题,都能在不同程度上影响技术促进学习的潜能的(全面)发挥。或许正是因为没有意识到教育研究的复杂性,很多研究似乎有“浮光掠影”之嫌,因此尽管“声势浩大”成果丰硕,但是对实践的影响却远不如人意,研究与实践之间的鸿沟依旧存在。

我多次在本论坛的导读中对教学自动化和教育研究自动化提出质疑,不是因为我反对技术的教育(研究)应用,而是因为我坚信技术在教育教学实践和研究中只是一种工具,为人所用的工具,不能代替学生的学习,不能代替教师的教学,不能代替研究者的研究素养。

最后,衷心感谢本文三位国际同行对翻译工作的支持和对本刊的信任!(肖俊洪)

一、引言

本文旨在通过文献综述呈现将学习分析(learning analytics, LA)应用于在线学习者自我调节学习(self-regulated learning, SRL)的实证研究现状。自我调节学习关乎学习和学习进步(Zimmerman, 2002),是一种能够指导学习者今后学习和工作的技能。学生可以通过接受培训掌握自我调节学习技能(Raaijmakers, Baars, Schaap, Paas, Van Merri?nboer, & Van Gog, 2018),也能够控制自我调节学习情况(Chang, Liang, Chou, & Liao, 2018)。然而,研究表明很多学生自我调节学习表现欠佳,包括不能精准调整自己的学习过程(Dunlosky & Lipko, 2007)。此外,如果没有教师在教学上提供支持,学生可能会高估自己理解学习材料的能力(Baars, Leopold, & Paas, 2018; Thiede, Griffin, Wiley, & Redford, 2009),从而可能对后续学习过程产生负面影响(Dunlosky & Rawson, 2012)。由此可见,我们有必要向学生提供自我调节学习支持。

虽然过去我们经常认为自我调节学习某种程度上讲是一种比较稳定的状态,不受学习环境的影响,但是研究发现学生自我调节学习表现会因学习环境的不同而异,比如学生在在线环境与身临现场环境下的自我调节学习表现是不同的(Lee & Recker, 2017; Sedrakyan, Malmberg, Verbert, J?rvel?, & Kirschner, 2018)。学习分析领域近年的发展表明,如果我们想了解学生在在线学习环境下自我调节学习行为不同方面的情况,那么我们可以采用不同的学习分析方法评价和支持他们的自我调节学习(Noroozi, Alikhani, J?rvel?, Kirschner, Sepp?nen, & Juuso, 2019)。本综述旨在调查应用学习分析评价和支持在线学习环境下自我调节学习的研究现状。

虽然如何应用学习分析支持自我调节学习的研究刚刚起步不久(Winne, 2017),但是这个领域已经初具雏形,明确要跟踪哪些活动、如何收集学生自我调节学习数据以及哪些计算工具可以用于分析自我调节学习。本研究有助于我们了解这些方面的研究现状,填补本研究领域的一个空白。

为了了解学习分析如何用于支持学生自我调节学习,本研究拟回答以下研究问题:学习分析在评价和支持在线学习环境下学生自我调节学习方面的应用情况如何?重点关注这个领域的实证研究,以2011—2019年间发表的54篇实证研究论文为样本,具体了解以下几个方面的情况:

二、背景

(一)自我调节学习

自我调节学习过程指的是“学生激活和保持为了达成个人目标而有组织地采取的认知、情感和行为的各种过程”(Zimmerman & Schunk, 2011, p.1)。根据齐默尔曼的模型(Zimmerman, 1990, 2002),自我调节学习第一阶段是预先计划(forethought),即学生制定计划、设定目标和分析拟完成的任务,比如计划花多少时间学习以达成某一个目标。在行为表现(performance)阶段,学生监控自己的表现,应用相关策略,控制学习过程。换言之,他们根据第一阶段设定的目标监控学习活动和所使用的策略是否有效。根據这个阶段对学习过程的监控情况,学生能够决定是否投入更多的学习时间、使用不同的学习策略或因为学习目标已经达成而停止学习(采取相应控制措施)。最后阶段是反思(reflection),即学生评估自己的学习过程。这时,学生可以反思自己所采取的每一个步骤,以提高接下来学习的效果。

根据齐默尔曼模型和其他模型(Panadero, 2017),监控和反思可以被视为自我调节学习的关键过程,因为如果监控和(或)反思不准确,便难以保证能够成功控制和调节学习。然而,对阅读的元认知监控(Thiede, et al., 2009)和学习解决问题(Baars, Leopold, & Paas, 2018)的研究表明,除非对他们进行额外培训,学生一般无法准确监控自己的学习。因此,了解学生如何监控自己的学习以及教师如何在这个过程提供支持尤为重要。

根据线索利用(cue-utilization)框架(Koriat, 1997),监控是推论过程,即学生根据学习过程和(或)学习环境中的具体线索做出监控判断。尤其是在教师临场不明显的在线环境中,学生必须掌握有效的自我调节学习技能方能顺利完成学习任务(Broadbent, 2017)。在这一点上,学习分析使评价自我调节学习行为和支持学生监控和控制在线学习成为可能。换言之,学习分析能帮助学生了解自己的自我调节学习行为,学生反过来可以利用这些信息(把它们当成线索)监控和控制自己的学习过程。

(二)自我调节学习和学习分析

学习分析指测量、收集、分析和使用学生数据以提升学习体验和优化学习过程和学习环境(Khalil & Ebner, 2015; Long & Siemens, 2011)。弗格森和克洛(Ferguson & Clow, 2017)指出,学习分析的目的是为了提高学习效果以及学习支持和教学支持水平,学习分析应该得到广泛且合乎伦理道德规范的应用。就自我调节学习而言,不管是分开或同时达成这些目标都有助于学生更好地调节自己的学习和教师支持学生掌握自我调节学习技能。

温(Winne, 2017)认为,学习分析在自我调节学习中的应用有两个方面的作用:一是根据学习过程或学习活动留下的痕迹评价自我调节学习表现,二是提出建议,即哪些方面的学习行为应该得到改变和如何对学习进行相应调节。因此,学习分析的使用能给学习者创造自我调节学习的机会,使他们最终掌握与学习以及今后工作相关的自我调节学习策略、技能和知识。

虽然学习分析支持自我调节学习这个方面的研究仍然处于起步阶段,刚刚形成自己的领域(Winne, 2017),学习分析在评价学生的在线自我调节学习行为方面的潜在优势得到越来越广泛的认可(Kim, Yoon, Jo, & Branch, 2018; Noroozi, et al., 2019)。目前所采用的学习分析方法很大程度上是因为能够获得学习者跟踪数据,这些数据主要来自学习管理系统和慕课,被视为“支持对构成自我调节学习的学习者元认知监控和元认知控制进行有效推论的可观察指标”(Winne, 2017, p. 241)。但是获得和解读这类数据并非简单的事情(Noroozi, et al., 2019),研究者深知这一点(Winne, 2017; Wong, Khalil, Baars, de Koning, & Paas, 2019)。尽管如此,越来越多的研究试图借助学习分析更好地了解和支持在线学习环境下自我调节学习(Cicchinelli, Veas, Pardo, Pammer-Schindler, Fessl, Barreiros, & Lindst?dt, 2018; Wong, et al., 2019)。目前我们尚不了解这方面的实际情况,本研究旨在填补这个空白但又不限于此。

三、研究方法

(一)文献检索与筛选

本研究采用可汗等(Khan, Kunz, Kleijnen, & Antes, 2003)提出的文献综述五步法:①提出综述的研究问题;②确定综述范围(样本);③评估样本质量;④总结相关研究发现;⑤解读研究结果。

如前所述,本综述的研究问题是:学习分析在评价和支持在线学习环境下学生自我调节学习方面的应用情况如何?(具体研究内容,详见“引言”)。

2019年3月我们进行第二步确定综述范围(样本)的工作。首先,我们在两个主要数据库(Scopus和Web of Science)检索相关文献,两位作者各自进行检索,确保检索结果准确。检索条件是標题、摘要和关键词,包含“Learning Analytics” AND “Self-Regulated”和“Learning Analytics” AND “SRL”。我们认为用SRL(自我调节学习)这个术语足以检索到包含自我调节学习各个构念的论文,因此检索条件不包括自我调节学习的微观过程(比如“goal setting”[设定目标])。其次,为了进一步确保信度,我们遵循韦伯斯特和沃森(Webster & Watson, 2002)的指南,检索到综述样本之后又检索发表在主要期刊的论文。换言之,在两大数据库检索到相关文献之后,我们人工检索发表于这些主要期刊的相关论文:《计算机与教育》(Computers & Education)、《计算机在人类行为的应用》(Computers in Human Behavior)、《英国教育技术期刊》(British Journal of Educational Technology)和《因特网与高等教育》(Internet and Higher Education)。最后,我们还人工检索本领域专业期刊《学习分析期刊》(Journal of Learning Analytics)的论文以及专业会议“学习分析和知识国际会议”(International Conference on Learning Analytics and Knowledge)的论文集(LAK Proceedings)(这是我们分析新兴的学习分析研究的重要依据)。论文发表的时间跨度从2011年至2019年3月,由两位作者共同完成这个阶段的工作。

在评估样本质量阶段,我们遵循以下采纳标准对论文进行甄别,仅纳入①实证研究论文;②发表于学术期刊或会议论文集的论文;③用英语发表的同行评审论文;④涉及教育(如高等教育)和非教育(如职场)学习环境研究的论文;⑤会议论文集中的正式论文(比如海报被排除在外)。综述和概念性或理论性文章不予纳入。

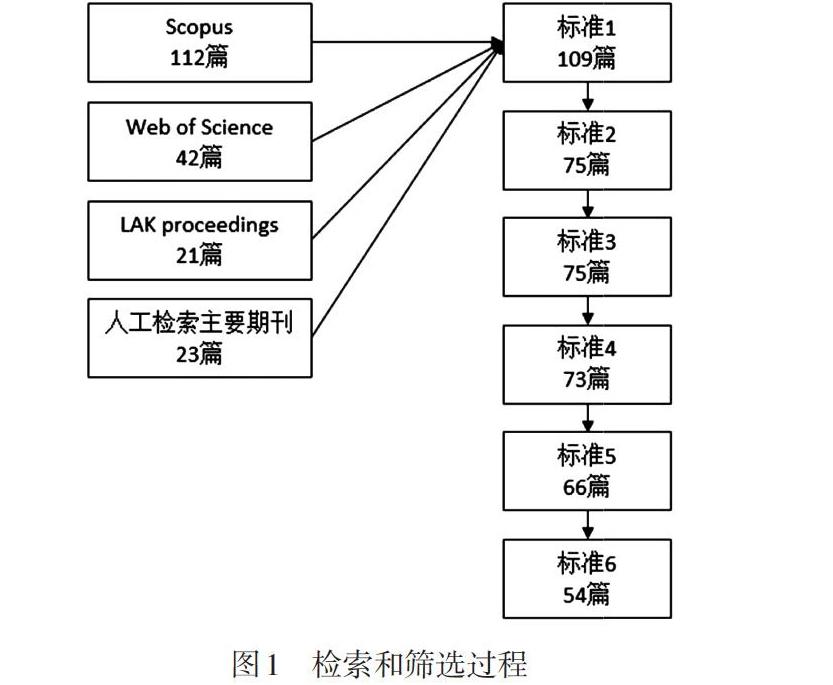

初次检索获得198篇论文(如图1所示),剔除重复论文和根据上述采纳标准进行筛选,最终剩下54篇论文(详见http://bit.do/LASRL)。

(二)数据分析

文章的编码使用Google Sheet进行,三位作者一起对其中10篇(19%)进行编码以验证编码体系,然后各自对其他论文进行编码,讨论分歧并重新编码,直至达成一致意见。

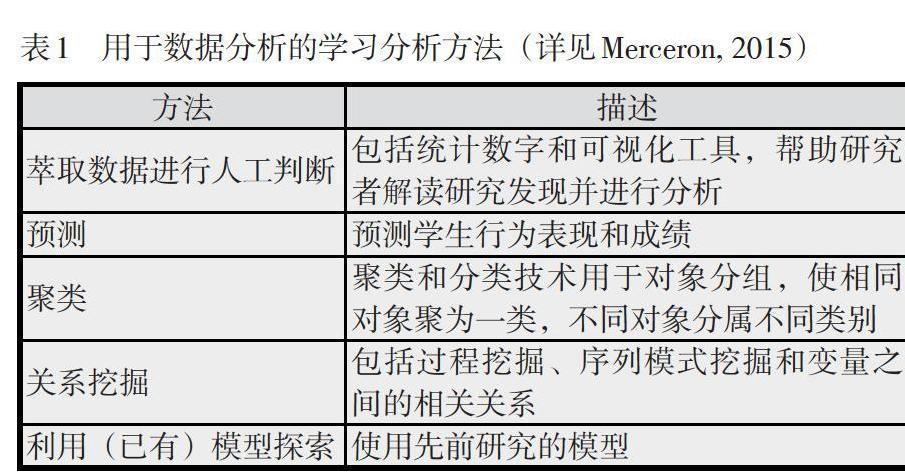

首先,我们分析了这些论文所涉及的自我调节学习阶段,即预先计划、行为表现和反思(Zimmerman, 2002)。我们采用齐默尔曼模型,因为它从社会—认知观视角理解自我调节学习,认为有三个方面因素影响自我调节行为:个人、行为和环境因素(Zimmerman, 1990; 2002)。学习分析与在线学习环境息息相关,我们需要一个既考虑个人和行为影响(比如Winne, 2011)又重视关键环境影响的稳健模型,因此齐默尔曼模型最适合本研究的目的。其次,我们根据梅瑟龙(Merceron, 2015)的范畴(见表1)对所采用的学习分析方法进行归类。再次,在评估学习分析支持自我调节学习的效果方面,我们采用弗格森和克洛(Ferguson & Clow, 2017)的框架,即学习分析是否提升了学习效果、提高了学习支持和教学支持水平、得到广泛应用以及合乎伦理道德规范的应用。至于教育层次,我们分为高等教育、基础教育和职场学习。可汗等(Khan, et al., 2003)提出的第4步“总结相关研究发现”和第5步“解读研究结果”将在下文“研究结果”一节介绍。

(三)本研究的局限

我们承认除了Scopus和Web of Science外没有在其他文献数据库进行检索,本研究仅收录英语论文,检索条件不包括自我调节学习的微观过程。因此,本研究可能不能全面反映这个主题已发表的全部论文。

四、研究结果

本研究的样本是54篇论文,其中约24%(n=13)发表于2016年,2017年和2018年发表的论文则各占约20%(n=11)。其他年份发文数量较少,2015年和2019年的论文分别占约15%(n=8)和9%(n=5),2014年、2012年和2013年的发文量依次递减,分别占约6%(n=3)、4%(n=2)和2%(n=1)(见图2)。

(一)自我调节学习各阶段

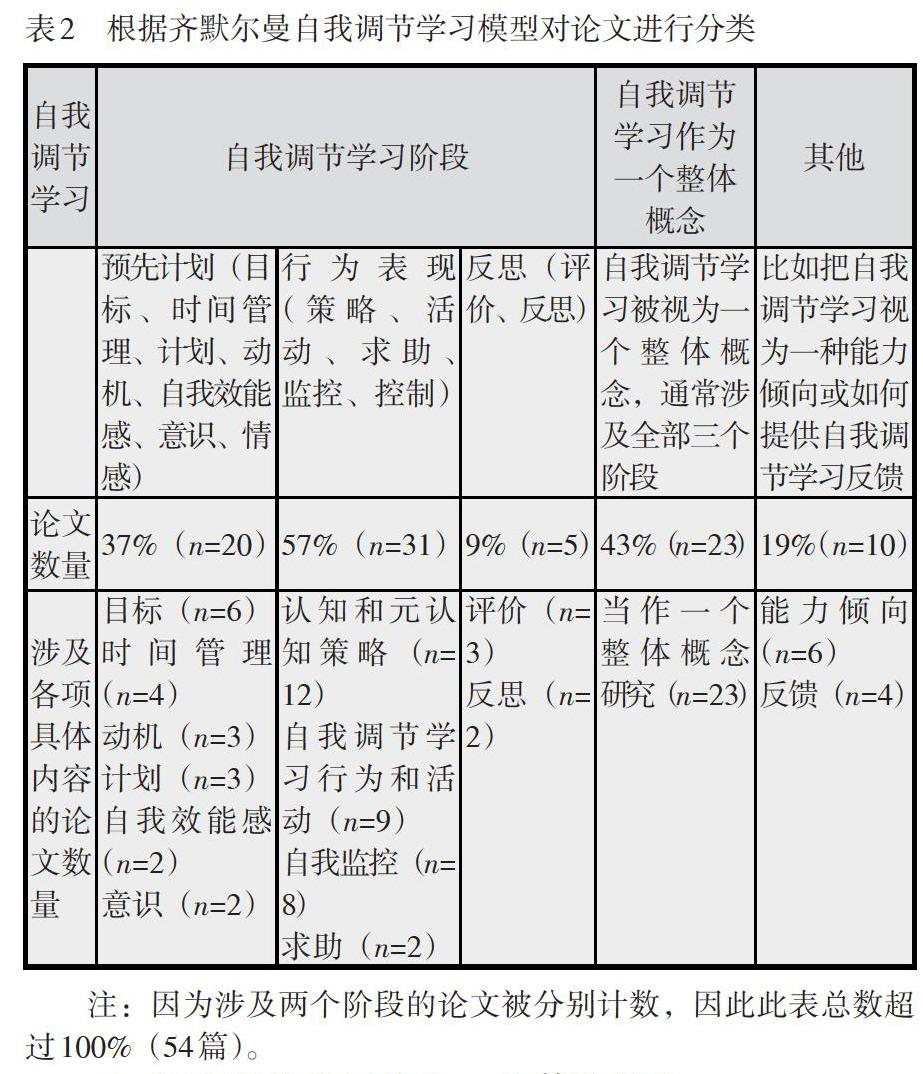

为了了解这些论文在多大程度上涉及自我调节学习各个阶段(Zimmerman, 2002),我们根据它们的研究重点按照预先计划、行为表现和反思三种情况对它们进行分类统计,没有侧重具体某个阶段的论文被归入“自我调节学习作为一个整体概念”类,它们通常同时涉及全部三个阶段。有几篇把自我调节学习当成一种能力倾向研究或如何提供自我调节学习反馈研究的论文被列入“其他”类。如表2所示,分析结果表明,多数论文属于“预先计划”“行为表现”“自我调节学习作为一个整体概念”类,仅有9%(n=5)聚焦反思或评价。有几篇论文不止涉及一个阶段(比如:Di Mitri, Scheffel, Drachsler, B?rner, Ternier, & Specht, 2017; Papamitsiou, Economides, Pappas, & Giannakos, 2018; Rohloff & Meinel, 2018)。

1. 自我調节学习作为一个整体概念

约43%的论文属于此类研究,即把自我调节学习作为一个概括性概念,通常涵盖齐默尔曼模型的全部三个阶段,比如有一项研究(Ott, et al., 2015)根据一门编程入门课程的诊断性数据研究学生的自我调节学习活动。

2. 预先计划阶段

约37%的论文属于此类,其中6篇(11%)研究自我调节学习的目标设定,4篇(7%)研究时间管理,比如用移动App帮助学生管理学习时间(Tabuenca, Kalz, Drachsler, & Specht, 2015)。3篇(5%)聚焦动机,比如把诸如动机这些自我报告的变量与学习环境中观察到的变量(如学习投入)结合在一起研究(Manzanares, Sánchez, García Osorio, & Díez-Pastor, 2017),这种结合很有价值,因为研究发现自我报告的动机和自我调节学习的其他变量有助于从学生视角深入了解学习过程(如学习者体验),而学习环境中所观察到的变量(如学生与内容的交互)则能解释他们如何与在线课程交互。3篇论文研究计划问题,比如巴斯克斯等(Vázquez, Rodríguez, & Nistal, 2018)研究如何支持学生制定计划以及监控和评价策略。有2篇论文研究自我效能感,比如孙等(Sun, Lu, & Xie, 2016)应用学习分析研究历时一个学期的翻转课堂学习中学生的行为表现变化,发现第一次考试自我效能感是预测行为表现的重要变量,但随后的考试则不然。还有2篇论文主要研究提高学习者意识,比如努斯鲍姆等(Nussbaumer, Scheffel, Niemann, Kravcik, & Albert, 2012)用可观察的跟踪数据提取关键行动,把它们跟学习活动结合起来帮助学生增强元认知和认知学习活动意识。

3. 行为表现阶段

9篇论文(17%)研究自我调节学习行为和活动(如解决问题)(比如:Ruiperez-Valiente, Munoz-Merino, Kloos, Niemann, Scheffel, & Wolpers, 2016),它们并没有明确用自我调节学习指这些行为,比如慕课环境下主动学习者的行为表现(比如:Davis, Chen, Jivet, Hauff, & Houben, 2016)。12篇论文(22%)研究策略方面的问题,这些策略可能更倾向于认知(如学习策略),或更倾向于元认知(应用某种工具以方便师生监控学习过程)(比如:Vázquez, Rodríguez, & Nistal, 2015)。8篇论文(15%)研究自我监控,比如锡达蒂等(Siadaty, Ga?evi , & Hatala, 2016)通过在线学习平台向职场学习者提供如何自我监控的信息,帮助他们做好自我监控和评价。还有2篇论文研究求助,比如金等(Kim, et al., 2018)根据日志数据分析自我调节学习情况,发现能自我调节的学习者更早开始学习课程内容,考试期间会求助。

4. 反思阶段

只有3篇论文研究评价问题,比如罗洛夫和梅内尔(Rohloff & Meinel, 2018)研究慕课如何能够支持个性化学习目标以帮助学生评价学习。有2篇论文聚焦反思,比如伽瑟维克等(Ga?evi , Mirriahi, & Dawson, 2014)研究学生在评分和不评分自我反思活动中使用视频标注软件的情况,揭示与对视频进行反思标注相关的语言和心理过程。该研究发现评分的反思涉及更多的语言和心理过程。

5. 其他

5篇论文(9%)不是采用跟踪数据,而是使用调查问卷研究自我调节学习能力倾向,比如贝赫什达等(Beheshitha, Ga?evi , & Hatala, 2015)使用调查问卷评估自我调节学习能力倾向并分析这种倾向与自我调节学习活动(“事件”)的关系。4篇论文(7%)研究反馈,比如奥特等(Ott, Robins, Haden, & Shephard, 2015)向學习一门编程课程的学生提供他们在不同学习阶段表现的反馈并预测最终成绩,以帮助他们更好地调节自己的学习。研究发现,学生虽然重视这些反馈但并没有改变自己的行为。

(二)学习分析方法

我们采用梅瑟龙(Merceron, 2015)的分类框架(见表1)对54篇论文所采用的学习分析方法进行分类(结果如图3所示)。最常用的方法是“萃取数据进行人工判断”(52%),比如佩雷斯-阿尔瓦雷斯等(Pérez-?lvarez, Maldonado-Mahauad, & Pérez- Sanagustín, 2018)研发一种支持自我调节学习的学习分析工具——NoteMyProgress,包括一个呈现各种可视化效果的管理界面(仪表盘),帮助学生跟踪学习一门慕课的活动,提高使用自我调节学习策略的意识。紧随其后的是“关系挖掘”方法(30%),比如锡达蒂等(Siadaty, et al., 2016)用转换图和社交网络分析对跟踪数据进行分析并提出自我调节学习干预措施。再如,蒙哥马利等(Montgomery, Mousavi, Carbonaro, Hayward, & Dunn, 2019)研究学习管理系统各变量的相关性,发现自我调节学习行为的激活与学业成绩相关。

最常用的第三种方法是“其他”类(22%),指不是单纯采用学习分析方法,而是把这些方法与其他自我报告类的调查和问卷相结合,比如柯林和德巴尔巴(Corrin & De Barba, 2014)使用《学习动机策略问卷》(Motivated Strategies for Learning Questionnaire)评价学期初学生与专业相关的学习动机水平和了解他们的个人学习目标。帕尔多等(Pardo, Han, & Ellis, 2016)采用《学习动机策略问卷》和关系挖掘法研究自我调节学习如何影响学生与学习活动的在线交互和对学习表现的影响。奇基内利等(Cicchinelli, et al., 2018)采用《动机信念和自我调节策略问卷》(Motivational Beliefs and Self-Regulation Strategies Questionnaire)和学习管理系统的日志数据识别和评价自我调节学习。

“聚类”(17%)和“预测”(13%)分别是第四和第五最常用的方法,比如曼萨纳雷斯等(Manzanares, et al., 2017)采用k-means聚类了解学生在一个学习管理系统上的自我调节学习行为。至于“预测”,游(You, 2016)研究了影响成绩的变量,发现定期学习、完成作业、上课次数和完成课程阅读任务等变量能够预测学生的课程成绩。

相比之下,“利用(已有)模型探索”(4%)是最不常用的方法(比如:Nussbaumer, et al., 2012; Stoten, 2019)。

(三)自我调节学习的支持形式

59%的论文没有应用学习分析技术提供后续支持(见图4),很多论文不吝笔墨阐述前景但没有具体行动和改进措施。可视化是最常用的支持形式(20%),这一类研究绝大多数使用管理界面(仪表盘)提高学生的自我意识(比如:Davis, et al., 2016; Marzouk, Rakovic, Liaqat, Vytasek, Samadi, Stewart-Alonso, ... & Nesbit, 2016; Pérez-?lvarez, et al., 2018),信息图也是可视化这一类的一种(Ott, et al., 2015)。第二最常用的支持形式是提供反馈(19%),比如舍费尔等(Scheffel, Kirschenmann, Taske, Adloff, Kiesel, Klemke, & Wolpers, 2013)和迪米特里等(Di Mitri, et al., 2017)通过书面反馈提示学生反思自己的学习体验。提出建议是最不常用的支持形式(4%),只有两项研究采用这种形式(Nussbaumer, et al., 2012; Siadaty, et al., 2016)。

(四)提升学习效果和提高学习支持和教学水平的证据

1. 学习效果

仅有20%(n=11)的论文有证据表明应用学习分析支持自我调节学习能够提升学习效果(见图5)。大多数研究(70%)甚至没有评估学习效果方面的提升和(或)没有讨论学习分析在这方面的潜能。由此可见,学习分析研究的重点是对自我调节学习的不同方面进行评价,而不是在于提高在线学习环境下学习成绩,而这本该是学习分析的主要目的之一。仅有8%的论文清楚讨论应用学习分析提升学习效果的潜能(比如:Matcha, Ga?evi , Uzir, Jovanovi , & Pardo, 2019; Montgomery, et al., 2019; Sun, et al., 2016)。

研究表明,学习效果的提升体现在课程成绩(比如:Cicchinelli, et al., 2018; Davis, et al., 2016; Fincham, Gasevic, Jovanovic, & Pardo, 2018; Molenaar, Horvers, & Baker, 2019a; Pardo, et al., 2016)和掌握与学习进步相关的自我调节学习技能上,如时间管理和设定目标。塔布恩卡等(Tabuenca, et al., 2015)使用一个移动App记录学生学习时间,然后以图表形式把这些信息反馈给学生,帮助他们提高时间管理意识和掌握时间管理技能。这项研究的结果显示,与一般自我调节提示相比,本研究的方法效果更好,提高了学生时间管理能力。锡达蒂等(Siadaty, et al., 2016)的研究借助技术手段对自我调节学习微观过程(如设定目标)进行引导干预的影响,发现系统推荐的学习路径、学习活动和知識库是设定目标和制定个人计划这些微观过程的决定因素。

有几项研究的结果显示,基于学习分析提供及时反馈有助于学生提升学习效果。戴维斯等(Davis, et al., 2016)设计了一个学习跟踪软件(Learning Tracker),向慕课学习者提供及时、目标导向的反馈,鼓励反思和自我调节。这项研究发现,这种反馈显著提高学习成绩和促进学习投入,具体包括实验组的最终成绩和通过率比控制组高。最近的一项研究(Matcha, et al., 2019)聚焦反馈(包括以个人管理界面[仪表盘]形式提供反馈和通过个性化电子邮件提供基于学习分析的反馈)对学习策略的选择和调节的影响,即研究学习策略在顺序和时间上的特点并分析这些特点与反馈的关系。研究结果表明,个性化反馈和使用有效策略正相关,使用多种学习策略的学生成绩高于使用单一策略的学生。还有一项研究应用学习分析通过以学生为中心的管理界面仪表盘向他们提供反馈,研究结果表明这种方法有助于提高学习成绩但没有促进知识转移(Molenaar, et al., 2019b)。

8%的论文明确指出学习分析有可能提升学习效果。莫勒纳尔等(Molenaar, Horvers, & Baker, 2019a)强调个性化的可视化反馈似乎有助于培养学生更好地理解关键数学技能所需的自我调节学习能力。罗洛夫和梅内尔(Rohloff & Meinel, 2018)也讨论了学习分析在这方面的潜能。总体上看,虽然有一些研究表明把学习分析应用于自我调节学习能够提升学习效果,但是它们基本上都是小规模实验(研究对象数量少、实验持续时间短、研究背景局限于某一门课程等)。

2. 学习支持和教学支持水平

仅有22%的研究显示学习分析提高学习支持(18%)和教学支持(4%)水平(见图6)。尽管如此,多达70%的论文讨论了学习分析提升学习支持和(或)教学支持水平的潜能。另有8%的论文没有涉及这方面内容。

本综述表明,各种基于网络的可视化工具(包括以学习者为中心的学习管理界面[仪表盘])(比如:Davis, et al., 2016)、智能辅导系统(比如:Lau, Sinclair, Taub, Azevedo, & Jang, 2017)和以简报形式提供支持自我调节学习的反馈(Silva, Zambom, Rodrigues, Ramos, & Da Fonseca De Souza, 2018)等有助于提高学习支持的水平,比如有研究者(Lau, et al., 2017)研发了一款智能辅导系统——MetaTutor,它能针对某些特定元认知自我调节学习过程(包括学习判断和内容评估)自适应支持自我调节学习。该研究表明,学生在使用MetaTutor时会收到针对自身薄弱环节的反馈,从而提升学习效果。席尔瓦等(Silva, et al., 2018)发现,在翻转课堂环境下实验组学生接收的支持自我调节学习反馈简报激发他们自我反思和向同学求助释疑,学习分析促进了学生的自我调节学习。戴维斯等(Davis, et al., 2016)的研究则表明,基于网络的可视化工具促进学生学习投入,提升学生的学习表现。

至于教学支持,仅有两项研究聚焦这个方面。斯托腾(Stoten, 2019)介绍了一个电子教科书学习平台的情况,该平台生成各种数据分析,帮助教师了解学生与教材的交互情况。帕尔多等(Pardo, et al., 2016)研究自我调节、在线活动和学习表现之间的关系,发现提供反馈(比如在管理界面[仪表盘]和以多项选择题形式提供反馈)、反思和推理机会(比如完成锻炼解决问题能力的练习)与成绩正相关。教师可以根据学习分析结果设计学习任务,向学生讲解什么是有效的自我调节、如何有效地参加在线学习活动或重新设计教学材料。

虽然这方面的研究仅占全部样本的22%,但是大多数论文(70%)讨论学习分析提升学习支持和(或)教学支持水平的可能性,其中15%的论文同时讨论学习分析在学习支持和教学支持方面的应用潜能,比如奇基内利等(Cicchinelli, et al., 2018)发现对行为聚类有助于说明学生使用学习策略的模式和各种认知过程的相互影响。从教学的角度讲,这些发现可以被用于说明哪些学习策略最能有效地达成学习目标和提高学生对自己学习过程的意识,使之能够转移到其他学习环境并调整适应新环境。

虽然如前所述学习分析支持教学方面的研究为数很少,但是有34%的论文强调学习分析提升教学水平的潜能(Ga?evi , Mirriahi, Dawson, & Joksimovi , 2017; Manzanares, et al., 2017; Sun, et al., 2016)。由此可见,这是一个值得进一步研究的课题,以使这种潜能在教学实践中变成现实,改善学生学习条件。

3. 广泛应用和伦理道德规范

学习分析是否已经得到广泛应用?这个问题不仅指学习分析的应用程度,而且也涉及机构态度和政策倾向。是否把支持自我调节学习的学习分析方法和工具的应用在机构全面实施或推广到其他机构?这是一个复杂问题。我们认为只有相当数量的学生或教师参与到学习分析的实际应用中时才具备规模化条件(Viberg, Hatakka, B?lter, & Mavroudi, 2018)。本综述的结果表明,学习分析尚未被大规模应用于支持自我调节学习,因为如前所述这些研究大多数规模小,涉及学生人数少(比如:Beheshitha, et al., 2015; Tabuenca, et al., 2015)和(或)历时短。它们经常只是呈现初步研究结果(Molenaar, et al., 2019b)。即使一些基于大数据集分析的研究也未见学习分析得到广泛应用的证据(比如:Li, Ogata, Tsuchiya, Suzuki, Uchida, Ohashi, & Konomi, 2017)。

学习分析在支持自我调节学习上的应用是否符合伦理道德规范?“这涉及‘我们是否应该(应用学习分析支持自我调节学习),而不是本文其他研究问题所涉及的‘我们是否能够做到的问题”(Viberg, et al., 2018, p.107)。只有15%的论文明确讨论其研究的伦理道德和(或)隐私问题。即使详细处理伦理道德问题(如知情同意、数据隐私和安全)的研究,也很少系统采取符合机构伦理道德规范的方法(比如:Ga?evi , et al., 2014; Montgomery, et al., 2019; Pardo, et al., 2016)。有一些研究则针对研究的某一些方面从伦理道德角度进行反思,缺乏系统性,比如奇基内利等(Cicchinelli, et al., 2018)和孙等(Sun, et al., 2016)报告说他们的问卷調查获得受访者的知情同意,但其他方面却没有类似措施。塔布恩卡等(Tabuenca, et al., 2015)表达了对数据储存和安全的关切,但没有涉及其他方面(如数据收集)的工作。

(五)学习环境和教育层次

70%的研究针对高等教育(n=38),包括本科生、研究生(Ga?evi , et al., 2017)和博士生(Di Mitri, et al., 2017),聚焦基础教育(k-12)和职场学习的研究为数极少,分别仅占4%(n=2)和7%(n=4),另有19%(n=10)没有清楚说明教育层次。

至于学习环境,如图7所示,67%的研究(n=36)针对虚拟学习环境,如电子书平台(Stoten, 2019)、混合式学习环境(Sáiz Manzanares, Marticorena Sánchez, García Osorio, & Díez-Pastor, 2017)、移动App(Tabuenca, et al., 2015)、数字化协作系统(Ga?evi , et al., 2017)和多模态教学环境(Di Mitri, et al., 2017);19%(n=10)针对学习管理系统,另有11%(n=6)和4%(n=2)分别针对慕课和个性化学习环境。

五、讨论和结论

(一)支持自我调节学习的证据有限

学习分析有可能提升教与学效果。但是,本综述表明从总体看只有少数实证研究支持这种观点。大多数研究应用学习分析分析数据,即评价自我调节学习各方面情况,而不是把学习分析应用于支持学习者自我调节学习。换言之,大多数研究的目的只是了解学生自我调节学习各方面情况,而不是帮助他们计划、监控和反思自己的学习活动和(或)帮助教师提供相应的自我调节学习支持。

本综述结果表明,仅有20%的研究证明学习分析提升学习效果。这个比例高于另一项研究的比例。维伯格等(Viberg, et al., 2018)的研究表明,在252项针对高等教育的学习分析研究(包括聚焦自我调节学习的研究)中,仅有9%显示学习分析提升学习效果。这可能是因为本综述的样本不限于高等教育(虽然这个比例高达70%),而且仅针对学习分析在自我调节学习方面的应用。两项研究在这一点上的不同,一方面可能显示与其他方面相比自我调节学习更加得益于学习分析,另一方面也提醒我们不应该想当然以为这些研究结果具有普遍意义,因为它们虽然有证据证明学生的成绩和(或)自我调节学习技能提高了,但如前所述居多是小规模研究,而且经常只是呈现初步研究结果。

至于在学习分析促进学习支持和教学支持方面,仅有22%的研究证明学习分析在这个方面的作用,而且主要集中在学习支持(18%)而不是教学支持(4%)上。自我调节学习技能不但可以通过学习掌握,也可以通过教学培养(Raaijmakers, et al., 2018),因此我们也需要给教师提供更好的支持,帮助他们进一步了解学生在学习中如何使用自我调节学习策略以及如何在在线学习环境下有效、持之以恒地培训学生这方面的技能,因为学生只有懂得如何使用有效自我调节学习策略方能顺利完成在线学习环境下的学习任务(Broadbent, et al., 2017)。虽然34%的论文提到学习分析支持教学的潜能,但是我们仍然需要能有效地把这种潜能付诸实践的指导原则,才能达成优化学生学习条件的目的。

如前所述,学习分析在自我调节学习中的应用有两个方面的目的:一是评价学生行为,二是提出如何调节学习行为的建议(Winne, 2017)。本综述表明,迄今开展的大多数实证研究主要是围绕评价学生行为这个方面,然而光是评价不会自动导致学习成绩的提高。由此可见,学习分析的潜能还没有得到充分发挥。研究者必须进一步开展研究,利用现有工具(如移动技术)或研发新工具,探索如何才能不但评价师生的教与学而且还能向他们提供相关支持。

本綜述表明,虽然15%的论文反思其研究某(些)方面的伦理道德规范,但总体而言研究者尚未系统遵循伦理道德规范开展研究。学习分析研究不能不考虑伦理道德规范(Slade & Prinsloo, 2013),因此研究者应该全面、系统地处理好这些问题,包括数据所有权、隐私、获取、政策、安全和透明性等问题(Khalil & Ebner, 2015)。

(二)重自我调节学习的预先计划和行为表现而轻反思

不管是从评价还是支持自我调节学习方面看,大多数研究的重点在于齐默尔曼模型(Zimmerman, 2002)的预先计划阶段和行为表现阶段,很少聚焦反思阶段。然而,学习者可以也应该利用行为表现阶段的信息在反思阶段准确决定如何调整接下来的学习(比如:Panadero, 2017; Zimmerman, 2002),因此今后的研究应该更加关注如何评价和支持学生在在线学习环境下的反思活动。此外,因为监控和控制是成功自我调节学习的关键(Dunlosky & Rawson, 2012; Panadero, 2017),我们必须更加重视在线学习环境下学生如何监控自己的学习、学习分析如何能够支持这些监控过程和如何把监控结果转变为控制行动等方面的研究。比如,我们可以向学生提供基于学习分析、针对其学习过程的提示(Koriat, 1997),他们可以根据这些提示有针对性地开展监控并进行反思,或者根据学习分析的提示决定如何控制和调节学习过程。

(三)评价有余而支持不足

自我调节学习有助于取得更好的学业成绩,但是学习分析促进学生自我调节学习的潜能至今还没有得到充分发挥。本综述表明,学习分析向学生提供在线学习环境下自我调节学习支持和(或)支持教师在教学中培养学生自我调节学习能力的证据很有限,而且形式也比较单一,主要是通过基于网络、以学生为中心的学习管理界面(仪表盘)提供这方面的支持。这一点印证了先前研究结果,即包含丰富可视化工具的学习管理界面(仪表盘)是支持自我调节学习的重要手段(Matcha, Gasevic, & Pardo, 2019)。学习者的正式和非正式在线学习经常“居无定所”而且广泛使用其他各种技术(包括自己的移动设备),因此通过基于网络的学习管理界面(仪表盘)提供自我调节学习支持从可及性和可用性讲可能具有明显的局限性。鉴于此,建议设计者和研究者考虑和研究如何更有效地借助学习者自己正在使用的移动设备向他们提供自我调节学习支持。这样的设计能提供过程导向的自我调节学习行为数据,研究者因此能够把学生的自我调节学习作为一个不断变化的过程而不是一成不变的“产品”进行研究。

学习分析方法主要被应用于评价不同阶段的自我调节学习。虽然学习分析经常与预测模型联系在一起(Leitner, Khalil, & Ebner, 2017),但是本综述样本最常用的学习分析方法是“萃取数据进行人工判断”,不是“预测”。这意味着在自我调节学习研究中应用学习分析方法的主要目的是了解学生的自我调节学习行为。这一点与一项先前研究的结果一致(Viberg, et al., 2018),该研究发现学习分析研究的重点正在从关注预测(如辍学和成绩等)转向更加深入了解学生的学习过程。

最后,本综述显示,这些实证研究70%是针对高等教育的。这也可以被看作是一个研究局限,因为学生自我调节学习能力的培养应该从早抓起,比如在基础教育阶段而不是等到高等教育阶段才开始。今天,很多国家基础教育正朝着数字化方向发展,使用各种数字化学习工具,学生也经常不得不在各种在线环境下学习。这意味着学生经常要面临如何使用“合适”的工具选择有效学习路径的挑战,因此需要在教学中给他们提供额外支持。建议进一步加强学习分析在基础教育自我调节学习中的应用和研究。

综上所述,目前学习分析研究主要是为了评价在线学习环境下学生自我调节学习情况而不是提供这方面的支持。如何充分发挥学习分析促进自我调节学习的优势是一个紧迫课题。

【鸣谢】本文第一作者获得瑞典研究和高等教育国际合作基金(Swedish Foundation for International Cooperation in Research and Higher Education, STINT)资助(Dnr:MC2018—7984)。

[参考文献]

Baars, M., Leopold, C., & Paas, F. (2018). Self-explaining steps in problem-solving tasks to improve self-regulation in secondary education. Journal of Educational Psychology, 110, 578-595.

Beheshitha, S. S., Ga?evi , D., & Hatala, M. (2015). A process mining approach to linking the study of aptitude and event facets of self-regulated learning. In Proceedings of the Fifth International Conference on Learning Analytics And Knowledge (LAK15) (pp. 265-269). New York, NY, USA: ACM.

Broadbent, J. (2017). Comparing online and blended learners self-regulated learning strategies and academic performance. Internet and Higher Education, 33, 24-32.

Chang, C.-C., Liang, C., Chou, P.-N., & Liao, Y.-M. (2018). Using e-portfolio for learning goal setting to facilitate self-regulated learning of high school students. Behavior & Information Technology, 37 (12), 1237-1251.

Cicchinelli, A., Veas, E., Pardo, A., Pammer-Schindler, V., Fessl, A., Barreiros, C., & Lindst?dt, S. (2018). Finding traces of self-regulated learning in activity streams. In Proceedings of the 8th International Conference on Learning Analytics and Knowledge (pp. 191-200). New York, NY, USA: ACM.

Corrin, L., & De Barba, P. (2014). Exploring students interpretation of feedback delivered through learning analytics dashboards. In Proceedings of ASCILITE 2014 - Annual Conference of the Australian Society for Computers in Tertiary Education (pp. 629-633). Dunedin, NZ: ASCILITE.

Davis, D., Chen, G., Jivet, I., Hauff, C., & Houben, G. -J. (2016). Encouraging metacognition and self-regulation in MOOCs through increased learner feedback. In S. Bull, B. M. Ginon, J. Kay, M. D. Kickmeier-Rust, & M. D. Johnson (Eds.), LAL 2016 - Learning Analytics for Learners: Proceedings of the LAK 2016 Workshop on Learning Analytics for Learners (pp. 17-22). (CEUR Workshop Proceedings; Vol. 1596). CEUR.

Di Mitri, D., Scheffel, M., Drachsler, H., B?rner, D., Ternier, S., & Specht, M. (2017). Learning pulse: a machine learning approach for predicting performance in self-regulated learning using multimodal data. In Proceedings of the seventh international learning analytics & knowledge conference (pp. 188-197). New York, NY, USA: ACM.

Dunlosky, J., & Lipko, A. R. (2007). Metacomprehension a brief history and how to improve its accuracy. Current Directions in Psychological Science, 16, 228-232.

Dunlosky, J., & Rawson, K. A. (2012). Overconfidence produces underachievement: Inaccurate self-evaluations undermine students learning and retention. Learning and Instruction, 22(4), 271-280.

Ferguson, R., & Clow, D. (2017). Where is the evidence? A call to action for learning analytics. In Proceedings of the Seventh International Learning Analytics & Knowledge Conference (pp. 56-65). New York, USA: ACM.

Fincham, O. E., Gasevic, D. V., Jovanovic, J. M., & Pardo, A. (2018). From study tactics to learning strategies: An analytical method for extracting interpretable representations. IEEE Transactions on Learning Technologies, doi:10.1109/TLT.2018.2823317

Ga?evi , D., Mirriahi, N., & Dawson, S. (2014). Analytics of the effects of video use and instruction to support reflective learning. In Proceedings of the Fourth International Conference on Learning Analytics And Knowledge (LAK14) (pp. 123-132). New York, NY, USA: ACM.

Ga?evi , D., Mirriahi, N., Dawson, S., & Joksimovi , S. (2017). Effects of instructional conditions and experience on the adoption of a learning tool. Computers in Human Behavior, 67, 207-220.

Khalil, M., & Ebner, M. (2015). Learning analytics: principles and constraints. In Proceedings of ED-Media 2015 conference (pp. 1789- 1799). Chesapeake: VA: AACE.

Khan, K. S., Kunz, R., Kleijnen, J., & Antes, G. (2003). Five steps to conducting a systematic review. Journal of the Royal Society of Medicine, 96(3), 118-121.

Kim, D., Yoon, M., Jo, I., & Branch, R. M. (2018). Learning analytics to support self-regulated learning in asynchronous online courses: A case study at a womens university in South Korea. Computers and Education, 127,233-251.

Kizilcec, R. F., Pérez-Sanagustín, M., & Maldonado, J. J. (2017). Self-regulated learning strategies predict learner behavior and goal attainment in Massive Open Online Courses. Computers & Education, 104, 18-33.

Koriat, A. (1997). Monitoring Ones Own Knowledge during study: A cue-utilization approach to judgements of learning. Journal of Experimental Psychology, 126 (4), 349-370.

Lau, C., Sinclair, J., Taub, M., Azevedo, R., & Jang, J. (2017). Transitioning self-regulated learning profiles in hypermedia-learning environments. In Proceedings of the Seventh International Learning Analytics & Knowledge Conference (LAK 17) (pp. 198-202). New York, NY, USA: ACM.

Lee, J. E., & Recker, M. (2017). Measuring students use of self-regulated learning strategies from learning management system data: An evidence-centered design approach about analytics for learning (A4L). Technical report. Utah State University. DOI: 10.13140/RG.2.2. 24971.75047

Leitner, P., Khalil, M., & Ebner, M. (2017). Learning analytics in higher education—a literature review. In A. Pe?a-Ayala (Ed.), Learning analytics: Fundaments, applications, and trends (pp. 1-23). Springer International Publishing AG.

Li, H., Ogata, H., Tsuchiya, T., Suzuki, Y., Uchida, S., Ohashi, H., & Konomi, S. (2017). Using learning analytics to support computer-assisted language learning. In Proceedings of the 25th International Conference on Computers in Education, ICCE 2017 - Main Conference Proceedings (pp. 908-913). Asia-Pacific Society for Computers in Education.

Long, P., & Siemens, G. (2011). Penetrating the fog: Analytics in learning and education. Educause Review, 46(5), 31-40.

Manzanares, M. C. S., Sánchez, R. M., García Osorio, C. I., & Díez-Pastor, J. F. (2017). How do B-learning and learning patterns influence learning outcomes? Frontiers in Psychology, 8, 745.

Marzouk, Z., Rakovic, M., Liaqat, A., Vytasek, J., Samadi, D., Stewart-Alonso, J., ... & Nesbit, J. C. (2016). What if learning analytics were based on learning science? Australasian Journal of Educational Technology, 32(6). https://doi.org/10.14742/ajet.3058

Matcha, W., Ga?evi , D., Uzir, N. A., Jovanovi , J., & Pardo, A. 2019. Analytics of learning strategies: Associations with academic performance and feedback. In Proceedings of LAK19 (pp. 461-470). New York, NY, USA: ACM.

Matcha, W., Ga?evi , D., & Pardo, A. (2019). A Systematic Review of Empirical Studies on Learning Analytics Dashboards: A Self-Regulated Learning Perspective. IEEE Transactions on Learning Technologies. PP(99):1-1.

Merceron, A. (2015). Educational data mining/learning analytics: Methods, tasks and current trends. In Proceedings of DeLFI Workshops 2015 co-located with 13th e-Learning Conference of the German Computer Society. Munchen, Germany. Retrieved from https://pdfs.semanticscholar.org/1d3a/

Molenaar, I., Horvers, A., & Baker, R. S. (2019a). What can moment-by-moment learning curves tell about students self-regulated learning? Learning and Instruction, https://doi.org/10.1016/j.learninstruc.2019.05.003.

Molenaar, I., Horvers, A., & Baker, R. S. (2019b). Towards Hybrid Human-System Regulation: Understanding Children SRL Support Needs in Blended Classrooms. In Proceedings of the 9th International Conference on Learning Analytics & Knowledge (LAK19) (pp. 471-480). New York, NY, USA: ACM.

Montgomery, A. P., Mousavi, A., Carbonaro, M., Hayward, D. V., & Dunn, W. (2019). Using learning analytics to explore self-regulated learning in flipped blended learning music teacher education. British Journal of Educational Technology, 50 (1), 114-127.

Noroozi, O., Alikhani, I., J?rvel?, S., Kirschner, P., Sepp?nen, T., & Juuso, I. (2019). Multimodal data to design visual learning analytics for understanding regulation of learning. Computers in Human Behavior, 100, 298-304.

Nussbaumer, A., Scheffel, M., Niemann, K., Kravcik, M., & Albert, D. (2012). Detecting and reflecting learning activities in personal learning environments. Paper presented at the CEUR Workshop Proceedings, 931125-131.

Ott, C., Robins, A., Haden, P., & Shephard, K. (2015). Illustrating performance indicators and course characteristics to support students self-regulated learning in CS1. Computer Science Education, 25(2), 174-198.

Panadero, E. (2017). A review of self-regulated learning: six models and four directions for research. Frontiers in Psychology, 8, 1-28.

Papamitsiou, Z., Economides, A., Pappas, I., & Giannakos, M. (2018). Explaining learning performance using response-time, self-regulation and satisfaction from content: an fsQCA approach. In Proceedings of the 8th International Conference on Learning Analytics and Knowledge (LAK 18) (pp. 181-190). New York, NY, USA: ACM.

Pardo, A., Han, F., & Ellis, R. A. (2016). Exploring the relation between self-regulation, online activities, and academic performance: A case study. In Proceedings of the Sixth International Conference on Learning Analytics & Knowledge (pp. 422-429). New York, NY, USA:ACM.

Pardo, A., Han, F., & Ellis, R. A. (2017). Combining university student self-regulated learning indicators and engagement with online learning events to predict academic performance. IEEE Transactions on Learning Technologies, 10(1), 82-92. doi:10.1109/TLT.2016.2639508

Pérez-?lvarez, R., Maldonado-Mahauad, J., & Pérez-Sanagustín, M. (2018). Design of a Tool to Support Self-Regulated Learning Strategies in MOOCs. J. UCS, 24(8), 1090-1109.

Raaijmakers, S. F., Baars, M., Schaap, L., Paas, F., Van Merri?nboer, J., & Van Gog, T. (2018). Training self-regulated learning skills with video modeling examples: Do task-selection skills transfer? Instructional Science, 46(2), 273-290.

Rohloff, T., & Meinel, C. (2018). Towards personalized learning objectives in MOOCs. In European Conference on Technology Enhanced Learning (pp. 202-215). Springer, Cham.

Ruiperez-Valiente, J. A., Munoz-Merino, P. J., Kloos, C. D., Niemann, K., Scheffel, M., & Wolpers, M. (2016). Analyzing the impact of using optional activities in self-regulated learning. IEEE Transactions on Learning Technologies, 9(3), 231-243.

Sáiz Manzanares, M. C., Marticorena Sánchez, R., García Osorio, C. I., & Díez-Pastor, J. F. (2017). How do B-Learning and learning patterns influence learning outcomes? Frontiers in Psychology, 8, 745.

Scheffel, M., Kirschenmann, U., Taske, A., Adloff, K., Kiesel, M., Klemke, R., & Wolpers, M. (2013). Exploring LogiAssist-the mobile learning and assistance platform for truck drivers. In European Conference on Technology Enhanced Learning (pp. 343-356). Springer, Berlin, Heidelberg.

Sedrakyan, G., Malmberg, J., Verbert, K., J?rvel?, S., & Kirschner, P. (2018). Linking learning behavior learning analytics and learning science concepts: Designing a learning analytics dashboard for feedback to support learning regulation. Computers in Human Behavior. https://doi.org/10.1016/j.chb.2018.05.004

Siadaty, M., Ga?evi , D., & Hatala, M. (2016). Measuring the impact of technological scaffolding interventions on micro-level processes of self-regulated workplace learning. Computers in Human Behavior, 59, 469-482.

Silva, J. C. S., Zambom, E., Rodrigues, R. L., Ramos, J. L. C., & Da Fonseca De Souza, F. (2018). Effects of learning analytics on students self-regulated learning in flipped classroom. International Journal of Information and Communication Technology Education, 14(3), 91-107.

Slade, S., & Prinsloo, P. (2013). Learning analytics: Ethical issues and dilemmas. American Behavioral Scientist, 57(10), 1510-1529.

Stoten, D. W. (2019). Using an e-book platform as a learning resource and information management tool: the case study of the “K” e-book platform at an English business school. On the Horizon, 27(1), 12-23.

Sun, Z., Lu, L., & Xie, K. (2016). The effects of self-regulated learning on students performance trajectory in the flipped math classroom. In Proceedings of International Conference of the Learning Sciences, ICLS (pp. 66-73). Singapore: International Society of the Learning Sciences.

Tabuenca, B., Kalz, M., Drachsler, H., & Specht, M. (2015). Time will tell: The role of mobile learning analytics in self-regulated learning. Computers and Education, 89, 53-74.

Thiede, K. W., Griffin, T. D., Wiley, J., & Redford, J. S. (2009). Metacognitive monitoring during and after reading. In D. J. Hacker, J. Dunlosky, & A. C. Graesser (Eds.), Handbook of metacognition in education (pp. 85-106). New York: Routledge.

Vázquez, M. M., Rodríguez, M. C., & Nistal, M. L. (2015). Development of a xAPI application profile for self-regulated learning requirements for capturing SRL related data. In 2015 IEEE Global Engineering Education Conference (EDUCON) (pp. 358-365). IEEE.

Vázquez, M., Rodríguez, M., & Nistal, M. (2018). An xAPI application profile to monitor self-regulated learning strategies. IEEE Access, 6, 42467-42481.

Viberg, O., Hatakka, M., B?lter, O., & Mavroudi, A. (2018). The current landscape of learning analytics in higher education. Computers in Human Behavior, 89, 98-110.

Webster, J., & Watson, R. (2002). Analyzing the past to prepare for the future: writing a literature review. MIS Quarterly, 26(2), xiii-xxiii.

Winne P. (2011). A cognitive and metacognitive analysis of self-regulated learning. In B. J. Zimmerman, & D. H. Schunk (Eds.), Handbook of Self-Regulation of Learning and Performance (pp. 15-32). New York, NY: Routledge.

Winne, P. (2017). Learning analytics for self-regulated learning. In C. Lang, G. Siemens, Wise, A., & D. Gasevic (Eds.), Handbook of Learning Analytics (pp.241-249). Society for Learning Analytics Research.

Wong, J., Baars, M., Davis, D., Van Der Zee, T., Houben, G. J., & Paas, F. (2018). Supporting self-regulated learning in online learning environments and MOOCs: A systematic review. International Journal of Human-Computer Interaction, 35 (4-5), 356-373.

Wong, J., Khalil, M., Baars, M., de Koning, B. B., & Paas, F. (2019). Exploring sequences of learner activities in relation to self-regulated learning in a massive open online course. Computers & Education, 103595.

You, J. W. (2016). Identifying significant indicators using LMS data to predict course achievement in online learning. Internet and Higher Education, 29, 23-30.

Zimmerman, B. (1990). Self-regulated learning and academic achievement: an overview. Educational Psychologist, 25(1), 3-17.

Zimmerman, B. (2002). Becoming a self-regulated learner: An overview. Theory into Practice, 41(2), 64-70.

Zimmerman, B., & Schunk, D. (2011). Handbook of Self-Regulation of Learning and Performance. New York: Routledge.