这束激光不一般

神秘的激光雷达

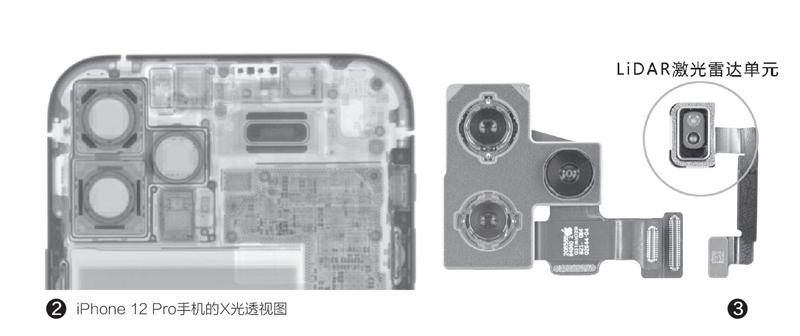

苹果iPhone 12 Pro系列的相机模组一共有5个“窟窿”,除了主摄、超广角和长焦镜头各占其一以外,另外两个“窟窿”内则嵌入了闪光灯和L i DA R(图2)。通过iPhone 12 Pro的拆机图可见,LiDAR单元的体积不小,基本等同于一颗普通的摄像头(图3),而我们本文的目的,就是全面分析一下这个单元的用途和意义。

3D感知时代来临

自NPU和AI概念进入智能手机领域,后者便获得了更强的“感知”能力。比如,拍照时系统会感知当前拍摄场景自动完成参数优化;当我们点亮屏幕的瞬间,前置摄像头(包括结构光模块)会感知面前的用户是不是主人,如果是就可以自动解锁。而感知的提升,还离不开手机的“3D取景”能力。

感知空间的方式

在过去的很长一段时间,手机只能感知2D画面,随着AI算法的成熟,可以在一定程度上识别相对立体的画面。比如很多手机只用一颗前置摄像头就能进行人脸识别,而且还具备一定的安全等级,像只有睁眼时才能解锁、防止使用人脸照片解锁等等(图4)。但是,想利用人脸识别进行金融级别的支付能力,还必须搭配其他识别模块,真正让手机可以感知3 D立体画面。

在LiDAR上台之前,咱们先来了解一下手机如何才能感知立体空间。

双目相机

双目相机即同时搭配两颗(或更多)摄像头(图5),两个摄像头拍摄同一物体,因为摄像头之间存在空隙(也包括焦距上的差异),理论上就可以构建出一个物体的三维模型,还能在一定程度上侦测物体的远近,也是实现“硬件级”背景虚化能力的基础。但是,双目相机只能识别层次,无法测算具體的距离,而且CMOS传感器需要有足够多的光线才能清晰成像,在暗光下就基本“残废”了,因此该方案的成就上限也就是简单的A R合影和AR萌拍。

3D结构光

从iPhone X开始,苹果之所以坚持刘海屏设计,就是为了同时嵌入包括红外镜头、泛光感应元件和点阵投影器在内的“结构光模组”(图6),通过点阵投影器发射出来的数万个光点投影进行高精度的面部三维建模(分辨率可达1280×800像素,夜间也能正常工作),从而实现更安全的人脸识别能力。但是,结构光投射的是一簇簇的光线,如果距离过远光线就会发散从而失去识别能力,因此这种3D感知方案存在严格的距离限制(1米以内),目前比较成熟的方案就是将结构光模块前置,用于面部解锁、面部支付、3D美颜以及类似Animojis的3D表情制作等。

ToF方案

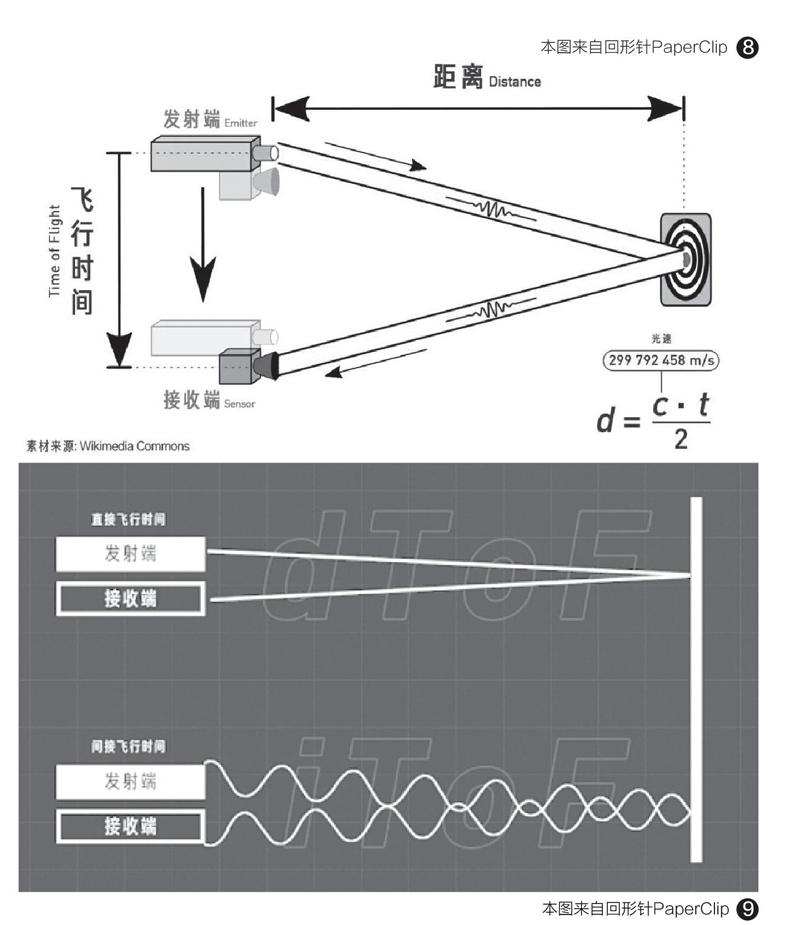

我们可以将ToF方案(Time of flight,飞行时间测距法)理解为结构光的进阶版,它的基本原理是通过专用传感器,给目标连续发送光脉冲,然后用传感器接收从物体返回的光,最终通过探测光脉冲的飞行(往返)时间来得到目标物距离。只要发射的光脉冲能完全覆盖测量物,通过算法就能得到物体的3D成像。

和结构光投射的一簇簇点阵光线不同的是,ToF投射的是一整个面的光,根据红外线的反射时间来计算深度信息,发射器与摄像头越近精度就越高(图7),有效工作距离达5米,可以进一步扩展3D视觉成像应用的范围和潜力。当然,ToF方案也存在不少缺陷,比如环境光过强会影响反射信号的探测,分辨率随距离的增加会越来越较低(240×180像素左右)。

理论上,ToF方案最适合后置,也就是和后置摄像头做邻居,从而实现3D美颜、AR装潢、AR游戏、体感游戏、全息影像交互等功能。当然,现实中也有部分产品会将ToF前置用于人面识别,但想达到金融级别的刷脸支付能力还需要搭配额外的红外传感器来解决分辨率过低的问题。

浅析LiDAR方案

苹果的LiDAR方案在iPad Pro 2020的宣传中曾被称为“Light Detection and Ranging”(光探测和测距),只是在推广iPhone 12 Pro系列时才改为更具科技感的“激光雷达”。它的基本原理是,通过测量光触及物体并反射回来所需的时间来确定距离。

看起来很熟悉?没错,LiDAR其实就是ToF。

不一样的ToF

前文我们说过,ToF是飞行时间测距法。但是,ToF往下还能进一步细分为“直接飞行时间”(directToF,简称dToF)和“间接飞行时间”(indirectToF,简称iToF)。在苹果之前,Android一众手机采用的ToF方案都是“iToF”,而苹果采用的方案则是“dToF”,由于两种方案在成像精度上的差异较大,所以苹果才有底气为其取了一个更酷的LiDAR激光雷达称号。

简单来说,无论苹果LiDAR(dToF)还是Android手机常用的ToF(iToF),都是由发射端(垂直腔面发射激光器)和接收端(定制的CMOS传感器)组成,前者发出的光经反射被后者接收,光速经历的这段时间即飞行时间(图8)。

问题来了,iToF方案中的发射端发射的并非直来直去的激光束,而是一种经过了正弦波调制,明暗强度呈现规律变换的光信号,光线的飞行时间会因正弦波的特性而被延长,还会影响成像的精度(分辨率低),而且这种影响会随距离的增加而变得更大。反观dToF,其发射端发射的则是笔直的脉冲激光,比雷达利用的无线电波波长更短、频率更高,可以反射出分辨率更高且更精准的图像(图9),成像更快延迟更低。

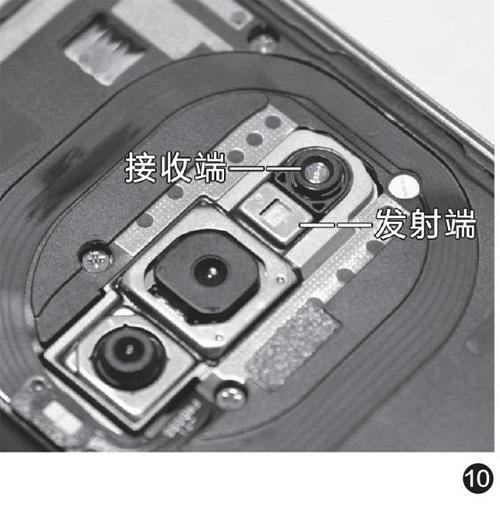

iToF方案能在Android手机圈普及的最大原因就是成本低,它的发射端不需要特殊的高速传感器(图10),接收端使用最普通的小尺寸CMOS也能搞定,但代价就是距离不超过5 米,而且测量精度和分辨率低等问题。

dTo F方案的发射端和接收端使用的传感器都需要重新定制,才能满足更远距离(理论最高200米,但苹果LiDAR方案的有效距离依旧是5米左右)和更好的抗干扰能力,成本自然也会更高一些。在苹果将dToF引入到平板电脑和智能手机领域之前,dToF早已被广泛应用在汽车领域,特斯拉的自动驾驶、索尼Vision-S概念车的无人导航测距、科沃斯地宝T8AIVI扫地机器人主打的TrueMapping全局规划技术都离不开dToF模块的辅助。

了解了dToF的技术原理,下面我们要讨论的重点就是,基于该方案的LiDAR到底能干啥。

LiDAR能干啥

LiDAR的主要工作場景包括优化拍照、3D扫描和AR应用。理论上,LiDAR能干的事情,传统iToF方案也能实现。但是,由于二者在5米范围采集成像精度和延迟方面存在较大差距,在实际体验层面的差异将被进一步放大。

以优化拍照为例,无论多摄方案还是iToF都能带来硬件级的背景虚化效果,但前者在夜间(光线不足时)可能连对焦都无法完成,后者虽然可以解决夜间拍人像的问题,但受制于分辨率和精度,人物(或其他拍摄主体)在背景虚化边缘可能存在明显的“抠图”痕迹。而在LiDAR的帮助下,无论环境光线怎样变化(白天夜晚)都能带来更好的景深控制,比如人物的发丝和考验细节的画面过渡会更加自然(图11),最大限度减小抠图痕迹的情况。

苹果早在2017年就推出了针对AR(AugmentedRealit,增强现实)的ARkit开发套件,并在后置多摄和结构光模块的帮助下实现了很多AR应用。现在有了LiDAR,可以让设备更快进入AR应用环境,减少等待时间,更精准的测距表现还能让AR应用虚实结合得更逼真,提供更好的遮挡表现等等(图12)。在过去,我们想对房屋内的家具或其他物品进行3D扫描,需要不断调整位置、方向和距离。在LiDAR的帮助下,可以大大简化上述操作的流程,并让3D扫描成像的精度更高,细节表现更完美。

总的来说,LiDAR和iToF相比体现了“人无我有,人有我优”的思路,封闭的iOS生态也有利于与LiDAR相关的软硬件生态建设,比如在iPhone12Pro刚发布不久Snap就宣布旗下内容创作平台SnapLenses3.2版本正式兼容LiDAR模组,创作者可创作出更身临其境的AR体验(图13)。反观Android手机圈,可以完美调度ToF(如果有)的应用多见于手机厂商自己开发的小程序。

小结

根据历史的经验,每当苹果设备引入一项新功能或技术后,它大概率会被Android同行借鉴参考。LiDAR自然也不例外,虽然现在dToF定制的传感器成本较高,但只要有市场需求其成本很快就会降下来。希望随着5G网络的普及,可以让拥有更强3D感知能力的LiDAR(dToF)技术和AR相关应用走向成熟。