基于流量感知的网络切片资源智能分配方法

郭红峰,黄继宁

(中国移动通信集团广东有限公司,广东 广州 510623)

0 引言

未来5G业务的多样化发展将存在信道、流量需求、业务场景等很多不确定因素。5G核心网云化、网络切片等资源灵活分配手段,是当前运营商提高用户服务质量、增加网络性能的法宝。很多学者在该领域进行相关的研究。Falahatraftar等人[1]在5G应用场景下提出一种基于条件生成对抗网络的异构车辆网络切片方法;及翠婷等人[2]在农业网监控传输领域提出一种多元化信息的5G切片传输方案;Barakabitze等人[3]提出基于SDN和NFV的5G切片方案并提供开源代码编程器;Abidi等人[4]提出一种基于机器学习和深度学习的5G切片方案,基于深度学习实现最优加权特征提取并提出一个有效的网络切片混合学习算法;高亮等人[5]提出一种基于SDN的网络资源管理方法,其仿真结果显示带宽资源利用率明显提高。上述研究大多数从业务请求的动态变化来实现网络资源的分配,却没有结合当前业务流量的感知角度,即仅仅采用简单方法预测的网络未来负载状态来分配资源。上述方法有可能出现VNF(Virtual Network Feature,虚拟网络功能)频繁迁移问题,即系统一旦出现网络流量过载,为了保证业务可靠性,系统开始启动数据重定向,从而实现数据快速迁移。而VNF频繁迁移必然占用大量计算资源和存储资源,降低系统性能,增加用户使用的业务时延。因此,本文采用一种流量感知的方法预测未来业务对资源的动态需求,降低由于业务请求动态变化引起的VNF迁移频率,从而在一定程度上避免了由于网络功能虚拟化调度产生的端到端时延增加的问题。

1 基于流量感知的网络切片资源智能分配方法

随着5G快速商用,用户需求和业务量规模迅速膨胀,如何在不影响网络性能的情况下,结合流量现状描述端到端流量需求,预测流量变化趋势,结合变化趋势对网络切片资源进行智能分配,是解决当前VNF频繁迁移问题的重要思路。本文针对网络流量具有自相似性、多分形性的特点,提出一种基于残差-预测框架的流量重构算法,采用一种多时间序列相关性的流量校正方法,通过多次校正与迭代来复原流量残差,从而保证流量重构的质量;其次,采用BP神经网络实现服务器负载的动态预测;最后,采用NFV技术实现网络切片资源智能分配。

1.1 基于残差-预测框架的流量重构

为了实现流量重构,对某时刻待重构流量的近似流量值进行线性组合,通过残差优化的方法找到一个最佳的线性组合,将该线性组合作为待重构流量的预测值。因此,本文采用一种基于残差-预测框架的流量重构算法,该方法充分挖掘流量的时间相关性以提高当前时刻流量的预测精度。基于该框架能够弱化流量“突变”的效应,实现较优的重构性能。基于残差-预测框架的流量重构算法如图1所示。

图1 基于残差-预测框架的流量重构算法

在解释图1的步骤之前,先解释几个与残差-预测框架相关的术语。

残差是在数理统计中实际观察值与估计值(拟合值)之间的差[6]。

自回归是统计上处理时间序列的方法,一个变量的未来变化趋势通常采用与其他变量的关系来预测[7]。

加权平均法是指利用某变量过去若干个时间序列的观测值计算对应的权重,并将观测值乘以权重并求和,得出的数字作为该变量预测值的一种趋势预测法[8]。

图1展示的流量重构算法分为三个步骤:

1)流量预测。对T-1时刻和T+1时刻的流量采用自回归方法进行流量预测,结合T-1时刻和T+1时刻的流量预测值对T时刻的流量值采用加权平均法进行流量预测;

2)残差重构。采用迭代法计算预测值与实际值之间的残差,并采用预测残差重构算法对T时刻的残差进行重构;

3)重构流量值。将残差重构的结果加上预测的结果即为当前时刻流量重构的结果。

1.2 基于流量感知的负载预测

VNF频繁迁出会造成网络资源利用率降低和业务时延过大。VNF频繁迁出的原因有5G业务的动态变化、用户使用流量的突发性增长以及用户对流量反馈时延等。显然,如何结合流量感知,选择合适的时间点完成VNF网元迁出,是降低服务器流量负载的重要课题。

因此,如果能够有效预测未来某一时刻服务器的负载情况,并设置一个比较合理的阈值,那么系统会在服务器出现问题之前将该服务功能链的业务模块迁出该服务器,就能够很大程度防止系统宕机,降低业务时延。本文基于各业务的流量感知数据,采用BP神经网络算法预测未来某一个时刻的服务器负载,进而为NFV网元迁移提供依据。

图2展示了基于BP神经网络的服务器负载预测,BP神经网络包括输入层、隐含层和输出层。输入层对应输入的信息;隐含层肩负特征提取的使命,该层每一个节点都会接收输入层的不同权重,并通过控制权重的方式形成模式识别偏向;输出层负责输出结果,输出层的神经元根据隐含层的特征与权重的结果进行加权后,会得出最终的识别结果。

图2 基于BP神经网络的服务器负载预测

服务器负载与很多因素有关,考虑到5G核心网的服务器负载主要与NFV网元有关,因此,本文将不同类型NFV网元流量感知作为输入,将不同NFV网元流量预测作为服务器负载,实现基于流量的负载预测,进而结合系统设置的阈值,将变化较大的部分NFV网元迁至其他服务器。其中输入层包括N个神经元,其实就是NFV神经元的数量;隐含层神经元数量为6;输出层神经元数量为1。

该方法分为三个步骤:

1)神经网络中连接神经元权值的训练。结合历史数据训练输入层到隐含层的连接权值、隐含层到输出层的连接权值,通过误差反传,令网络预测的误差不断缩小,最后BP神经网络能够相对准确预测某一个时刻服务器负载。

2)当服务器连续几个时刻的负载预测值高于系统设定的阈值时,系统将会启动迁移功能链业务模块的进程,告知系统某一个服务器将会面临负载过高或者系统存在不稳定的风险。

3)系统将该观测周期内流量感知变化较大的部分NFV网元迁出,降低本服务器的负载。迁入功能链业务模块的服务器将根据模块的需求进行资源分配。

1.3 网络切片资源智能分配方法

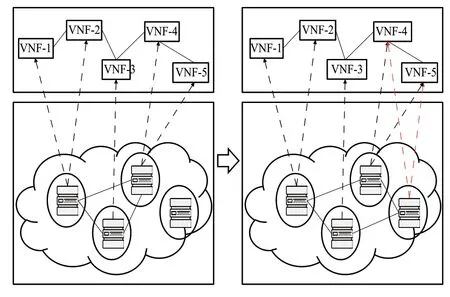

基于网络功能虚拟化的技术,实现软硬件的完全解耦,从而实现基于NFV网元智能迁出和迁入。基于NFV技术实现网络切片资源智能分配过程如图3所示。

图3 基于NFV技术实现端到端的资源分配过程图

基于NFV技术能够将网络设备资源整合在统一的资源池中,根据抽象出来的网络服务和功能需求,对资源池进行动态调度。图3显示当NFV网元4和网元5共用一个服务器并出现负载过大时,系统根据NFV网元4和网元5的流量感知水平,将NFV部分网元迁出原服务器,迁入到满足流量需求的服务器中,实现网络资源的智能分配。

2 实验分析

本文在现网5G核心网环境进行试验,目标是验证本文提出的资源智能分配算法的有效性,并以NFV网元数据包调度的端到端时延、CPU利用率2个指标进行比较。图4显示了不同的资源分配方案下随着迭代次数的增加数据包整体调度时延的变化情况。

图4中,三种方案的迭代次数都在降低并趋于稳定,其中ACA-D是一种基于蚁群算法的云计算资源调度策略,它是一种群集智能搜索算法,通过正反馈、分布式协作来寻找最优路径[9]。该策略假设每一只蚂蚁都是独立个体,独立个体在信息搜索过程中可以实现信息交换和通信,这种独立并行的搜索能力将提升全局的搜索能力。但该算法在非凸情况下会出现过早收敛,陷入局部最优现象。GA-D是一种基于遗传算法的云计算资源调度策略,是一种借鉴生物界进化思想和自然界”优胜劣汰”思想的进化方法[10]。该算法具备并行性和全局解空间搜索的特点。该算法需要设置一个适应度函数,以保证算法收敛,因此,在适应性函数设置不合理的情况下会出现“早熟”问题,同样会陷入局部最优现象。

图4 数据包整体调度时延

本文方案在数据包整体调度时延方面优于其他两种方法,这是因为ACA-D和GA-D没有对流量进行预测,而是针对现实的流量情况进行调度,容易陷入局部最优解。因此,本文的方案在时延方面的性能优于其他两种方案。

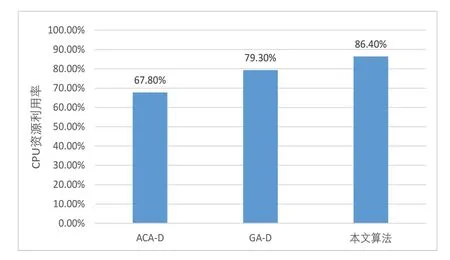

在CPU利用率方面,本文算法与传统的ACA-D和GA-D方法进行对比,结果如图5所示。

图5显示了500个观测周期内不同方案CPU资源利用率的平均值。可以看出本文算法处于较高水平。这是因为本文采用了基于残差-预测框架重构流量,完成了基于流量感知的服务器负载预测,再结合NFV的技术进行网元调度,实现较为公平的资源分配,避免了类似ACA-D和GA-D算法陷入局部最优的局面,提高了切片资源智能分配的寻优能力。

图5 集群CPU资源利用率

3 结束语

针对5G业务需求的动态变化和流量反馈时延导致VNF频繁迁出,造成资源利用率不高和时延过长等问题,提出了一种基于流量感知的网络切片资源智能分配方法。该模型在获取流量感知的基础上,结合残差-预测框架的流量感知算法来预测网络流量,并采用神经网络预测网络负载,基于预测结果实现资源调度,从而能够避免基于现实流量情况进行资源调度而容易陷于局部最优的问题;最后利用NFV的技术进行有针对性网元调度,以较为公平的方式实现资源智能分配,能够降低数据包调度时延,提高CPU资源利用率。未来,不仅研究核心网切片资源的分配,还需要考虑接入网等切片资源的分配,从业务出发实现端到端的切片资源分配,实现业务资源的再优化。