近5年图情SSCI期刊人工智能伦理研究文献分析与启示

黄崑 徐晓婷 黎安润泽 徐峰

关键词:人工智能;伦理;图书情报;内容分析

1问题提出

人工智能(Artificial Intelligence,简称AI)兴起于20世纪50年代,研究和制造能够模拟人类智能活动的智能机器或智能系统,用来延伸和扩展人类的智能。人工智能技术发展驱动了新一轮产业变革和第四次科技革命。美国、日本、英国等国家(地区)都已出台相关政策对人工智能技术的发展予以支持,我国政府也高度重视,相继出台《新一代人工智能发展规划》(2017年7月)、《促进新一代人工智能产业发展三年行动计划(2018-2020)》(2017年12月)、《关于促进人工智能和实体经济深度融合的指导意见》(2019年3月)等多项战略规划和行动计划。然而,技术的健康发展离不开伦理研究的同步发展。2018年,习近平总书记在主持中共中央政治局第九次集体学习时,指出“要整合多学科力量,加强人工智能相关法律、伦理、社会问题研究”。在国务院印发的《新一代人工智能发展规划》中,提出到2025年“初步建立人工智能法律法规、伦理规范和政策体系,形成人工智能安全评估和管控能力”。可见,在人工智能技术发展过程中,伦理研究至关重要。伦理泛指“道德”,狭义上常用来表示某一特定传统、群体或个人的道德原则,表现为人与社会、人与自然和人与人关系的思想与行为准则。在人工智能时代伦理的内涵,指在一定社会历史条件下,通过制定相关原则、规范和标准,促进人、社会、自然和人工智能机器的和谐共处。

新技术的发展及其社会影响是图情学科重要的内容之一。人工智能是一个新兴的交叉学科,应用领域广泛。图情学科现有的情报分析方法,可能在处理人工智能伦理问题研究上,还需要结合新的理论视角和研究手段,这也有助于推进图情学科在处理交叉学科问题上研究方法的探索。不仅如此,图情学科对信息生命周期的管理研究,各类信息系统、信息技术的创新研究,都存在着道德伦理的风险,也需要对伦理问题进行思考并应对。洞察国际图情领域所关注的伦理风险情境和应对,不仅可以用于分析与计算机、哲学等不同学科关注的联系和差异,也可以为我国图情学科研究者进入这一领域提供参考和借鉴。

根据对国内图情CSSCI期刊的论文调研可以看到,研究者们已经从隐私保护、数据安全等问题角度进行探讨,还有研究者从国际角度,对人工智能伦理问题研究进行分析,如刘鸿宇等、汪玉兰等都运用CiteSpace工具,对人工智能伦理领域文献研究论文研究的主题、经典文献与重要作者等进行了分析。王晰巍等则利用CiteSpace工具,对国内外图情领域在人工智能问题上的研究论文进行分析,指出国内外研究者主要围绕人工智能在信息检索、社交媒体内容分类、情感分析、知识问答、网络舆情分析等方面。虽然伦理问题研究并非当下图情领域在人工智能方面研究关注的热点,但是.人工智能技术对隐私与安全的影响等相关伦理问题被认为是未来研究趋势中重要的方向之一。

可见,国内图情领域已经开始关注人工智能伦理问题,为了进一步推动图情领域的研究关注和力度,本研究选取了近5年图情学科SSCI期刊发表的相关论文,利用内容分析法对这些研究探讨的伦理风险问题情境、应对策略进行编码和分析,力图为我国图情领域同行开展研究提供参考和借鉴。

2研究设计

2.1研究问题

本研究通过分析国际图书情报领域人工智能伦理研究文献,探究图书情报领域人工智能伦理研究现状,具体研究问题如下:

1)研究了哪些主题的人工智能伦理问题?

2)提出了哪些伦理风险应对的策略?

2.2编码设计

本研究采取内容分析法,从问题层次、应用领域、对策3个方面,对收集到的论文进行编码。其中,问题层次又分为数据、算法和人工智能系统3类。应用领域根据《中国图书馆分类法》中的21个大类(去掉z综合性)进行编码。在对策层面,借鉴Hagendorff T提出的社会方法和技术方法分类方式,如表1所示。编码过程由两位编码员进行,在编码分歧时进行讨论,最终取得一致后完成编码工作。

2.3数据收集

为了收集图情领域相关论文,根据Web of Sci.ence(WOS)数据库图书情报学科类目下进行检索。一方面,综合两种策略检索人工智能主题,如表2所示。第一,使用“人工智能”或人工智能系统载体的“机器人”为主题词;第二,根据人工智能相关发展报告,将人工智能领域的相关技术作为主题词。

另一方面,确定“伦理”或“道德”作为伦理主题的检索词。

因此,最终确定的检索式为TS=(“ArtificialIntelligen”OR AI OR Robot。OR“Machine Learn-ing”OR“Deep Learning”OR“Natural LanguageProcessing”OR“Image Recognition”OR“FaceRecognition”OR“Computer Vision”OR“VirtualAssistant”OR“Visual Search”OR“Text Analysis”OR“Semantic Search”OR“Predictive Analysis”OR“Intelligent System”OR“Semantic Web”、AND TS=(Ethic OR Moral),并限定WOS类别为图书情报(INFORMATION SCIENCE LIBRARYSCIENCE),文献类型为学术论文(Article,Re.view,Proceedings Paper),在2015年1月1日一2019年12月31日期间发表,检索到43篇论文。其中4篇无法获得全文,最终分析的论文数为39篇。自2015年起,逐年发表论文数为4、7、3、10和15,整体呈现上升趋势。

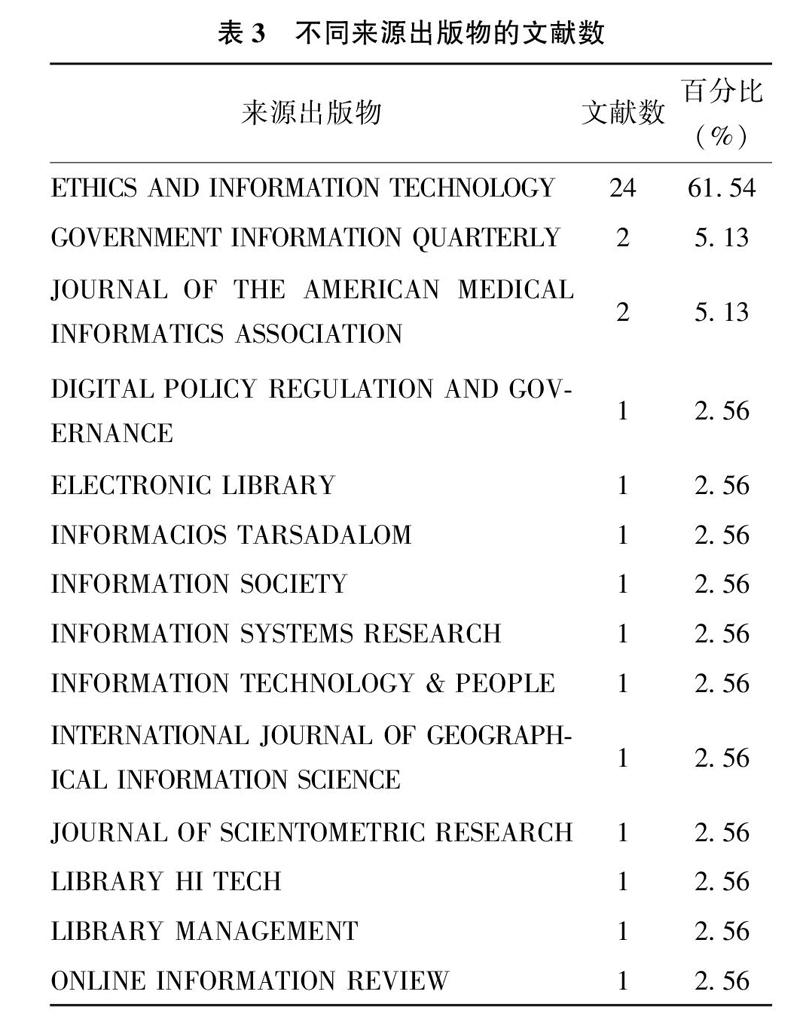

对文献来源出版物进行统计,共有14个来源期刊。发表在期刊《Ethics and Information Techn01.ogy》的论文占61%,如表3所示,该期刊是图书情报学科类目下发表人工智能伦理研究文献的主要刊物。该期刊的出版商为Springer Nature,出版年份可追溯到1999年,出版频率为每年出版4期,2019年期刊影響因子为2.06。根据WOS的学科分类,该期刊同时归类在图书情报学和伦理学学科,办刊宗旨是推动道德哲学与信息通信技术领域之间的对话。

从论文作者机构来看.这39篇论文共计涉及83位作者,来自18个国家(地区),其中,美国、英国和荷兰的作者发表文献最多,分别有11篇、8篇和6篇研究文献:意大利和丹麦研究者分别发表了3篇文献。我国研究者发表了1篇相关研究。

3数据分析

3.1基本情况

根据编码结果,39篇论文分为两类,一类在论文标题中就出现“伦理或道德”,主要探究或解决某一类伦理问题,如无人机在人道主义领域应用中的道德反思、人工智能产品与人权问题、机器人、生物特征识别等数字化应用带来的社会伦理问题。第二类在关键词或摘要内容中出现“伦理或道德”,通常将伦理作为研究分析或讨论的视角之一。如探讨人工智能在公共部门服务领域的应用和发展问题时涉及了将人工智能政策和伦理纳入应用各层面的观点。在访谈图书馆馆长、图书馆评论员等人员探究人工智能对高校图书馆潜在影响时提及,人工智能应用的伦理问题是图书馆面临的挑战之一。

在应用领域上.共计出现9类领域,医药卫生领域出现最多,如图1所示。

在问题层次上,数据、算法和人工智能系统层面伦理问题研究各有14篇、11篇和31篇。可见,对人工智能系统层面的关注度更高。下面,结合问题层次、应用领域进行分析。

3.2数据层面

数据层面伦理问题研究涉及的应用领域如图2所示。

关于医药卫生领域,主要探讨护理和医疗中的数据采集、共享中的伦理风险。针对护理数据的采集,护理机器人24小时监视、记录并传递护理对象的身体状况,这些数据包含护理对象日常行动的大量信息,如洗澡或尚未穿好衣服等时刻被监视或记录,这些信息如果在未征得护理对象许可情况下被收集、观看甚至利用,会威胁到护理对象的隐私。针对医疗数据的共享,不同医疗机构之间的共享数据有助于增加数据样本的容量和多样性,大量训练数据可以促进医疗记录监测和医学治疗改善,但是共享过程容易因为数据保护不当而侵犯患者的健康隐私。

关于政治领域,主要探讨公共服务中公民数据利用产生的伦理风险。Sousa w G等提出公共部门应用人工智能技术时要避免数据被一些追求个人利益的人破坏和利用。针对公民数据利用,Lindgren I等指出应用人工智能技术生成或分析大量公民数据时,结果可能用于监视公民线上或线下行为而限制其行为活动.对公民数据隐私造成影响。

关于地球科学领域.主要探讨地理文本分析的数据标注可能引发的伦理问题。McDonough K等分析了跨越历史的地理文本给地理信息检索带来的挑战,认为常用地名词典由于缺少链接到历史地名形式的时间元数据,造成地名历史被遗忘、殖民时期地名永久化,从而引发殖民时期地名历史延续、当地命名历史文化遭破坏等一系列社会伦理问题。

关于工业技术领域.主要探讨家居产品应用中的伦理风险。如智能家居产品收集用户个人信息和产品使用等数据,虽然智能产品提供了隐私协议,但人们通常不能完全理解协议内容,或者由于产品的使用限制和隐私协议的阅读时间过长而习惯性选择“同意”,这给隐私安全带来威胁。

在经济、军事、交通运输等领域,数据层面的问题也主要集中在数据生命周期的不同阶段,如在数据组织阶段,Iliadis A提出应用本体对军事情报、社会计划和经济学等领域的数据进行组织分析时,需要关注错误识别社会实体可能产生的伦理道德风险。

此外,表情数据采集问题也受到关注。表情数据采集不仅存在常见的数据泄露的隐患,还会带来精神层面的隐私侵犯形式。如面部识别软件可以自动发现人们不自觉的面部微表情.揭示人们视为隐私的情绪。又如机器人教师可以通过情绪探测器和传感器识别学生的情绪,然而这些个人情绪识别信息在存储和传输过程中可能会侵犯到学生的隐私,带来新的隐患。情绪识别技术通过检查人们在无意识发出的非语言信息(如面部表情、走路方式),可能因为泄露人们原本希望隐藏的心理状态或情绪而侵犯人的“精神隐私”。

3.3算法层面

算法层面伦理问题研究涉及的应用领域如图3所示。

关于经济领域,主要探讨区域经济分析、社会就业、金融信贷和商业销售等应用情境中应用人工智能算法产生的伦理问题。具体包括:①在区域经济分析中,运用卷积神经网络识别高分辨率卫星图像的特征,据此分析地方经济发展,进而确定各地区的经济水平,但这可能造成因地区经济水平差异产生的差别对待;②在就业机会分配时,由于现有的工作数据中男性和女性的工作情况存在差异,基于这些数据进行算法模型训练,容易延续数据中的性别歧视给男性提供更具经济优势的工作机会;③在金融信贷中,运用人工智能技术帮助金融机构决定提供贷款的对象,算法运行结果可能产生地域、种族和性别上的偏见。此外,金融机构根据信用预测算法的结果确定提供贷款的对象虽然有助于规避贷款风险,但同时也可能加大良好信用群体与信用有风险群体之间信用评分的差距,加剧不平等现象;④在商业销售中,Ien.ca M提到面部识别算法识别非裔美国人始终比白种人效果差,产生诸如面部识别等技术应用的社会受益不平等问题。

关于政治领域,主要探讨在竞选活动和公共部门服务中使用算法可能会引发的伦理问题。在竞选活动中,人工智能算法根据选民搜索行为预测选择偏好,通过改变搜索结果顺序影响选民偏好,对选举的民主造成威胁。同时,信息技术创造的更智慧算法会有意或无意地“惩罚”某些群体或减少他们获得某种机会的可能性,破坏低水平的消费者享有某些服务的公平机会。这些算法偏见或歧视会进一步侵犯人类原有的自我决策权,公共部门在应对算法偏见带来的不利影响时,存在法律问责的困难。

关于法律领域,主要探讨犯罪预测中算法应用产生的伦理问题。Vetro A等提到法官用来评估被告再犯概率以防止累犯行为的算法存在对黑人被告的偏见,该算法使他们普遍呈現更高的犯罪风险.加剧现实社会的种族歧视,带来社会不安定因素。Rahwan I也提到警务预测中使用AI会使得一些人很难摆脱遭受歧视的恶性循环。

在文化科学领域,主要讨论新闻传播中使用人工智能算法可能引起的伦理问题。运用机器学习算法.通过用户的浏览和点击等行为预测他们的偏好选择,并据此推荐新闻内容,在用户对推荐算法不知情或不理解的情况下.将他们阅读的新闻内容朝着算法预测的方向引导.这可能限制了用户对新闻内容的自主选择权利。

3.4人工智能系统层面

人工智能系统层面伦理问题研究涉及的应用领域如图4所示。

在社会科学领域,主要讨论机器人在人类社会活动中引发的伦理问题。如聊天、陪伴等社交机器人通过模仿人类行为触发用户的情绪反应,可能让用户投入情感并建立一种新的社会关系。对于认知水平有限的用户,可能会降低他们参与真正社会互动的意愿,造成道德伤害。又如机器人拥有的道德能力引发的伦理问题.包括机器人是否应该有自主性、是否应该总是听从人类的命令、是否应该被允许在一定情境下杀害人类、是否应该享有被保护权利等。人们很容易将机器人使用中产生的问题归咎于机器人本身或对机器人负有责任的代理人,但机器人往往不满足被迫责的条件或者不适合成为被追责的责任主体.由此可能导致道德替罪羊的出现,削弱公众对法治的信心。

在医药卫生领域,主要探讨护理机器人引发的伦理问题。机器人在喂食、搬运等行为时不能像人一样对照料对象提供关爱,因而被照料者可能会感觉自己被当作物体来对待,个人尊严受到伤害。Draper H等提到使用机器人为老年人提供家庭护理服务时,机器人的监视可能干扰老人的行动,剥夺他们自主选择权。Tuisku O等也指出机器人无法代替人类的声音和手.机器人的使用会减少护理中的人际接触,造成人类关怀的丧失。Rodog.no R探究陪伴型机器人与老年人的关系时指出,为了获得护理机器人的积极情感交流,老年人可能夸大悲伤经历而变得更加多愁善感。Wynsberghe AV也指出.设计护理机器人应重视“关怀伦理”,其核心元素为关系、角色和责任,强调护理机器人的道德水平不只是關注照顾效率和隐私保护,还需要考虑对被照料者的道德品格的影响。

在军事领域.主要讨论军用武器系统应用人工智能技术的伦理问题,包括对人的尊严的影响和武器系统自主决策的道德责任问题。自主武器系统使用传感器获取目标,会在人类难以直接干预决策情况下进行自主攻击。Sharkey A认为目前自主武器系统无法理解或尊重生命的价值,使用武器系统做出杀人的决定是对生命不负责任的行为。因此,自主武器系统或军用机器人的使用需要在最大限度减少间接伤害和实现军事优势间进行权衡。然而,一旦发生不必要的平民伤亡,明确追责或进行惩罚都变得相当困难。

在政治领域,主要关注在人道主义援助和国家安全中应用人工智能技术产生的伦理问题。在人道主义援助方面,针对政治避难和移民的临时收容所.利用无人机收集收容中心场地数据,尽管可以检查中心的生活条件,但也减少了人与人之间的互动.如果未考虑无人机使用的潜在危害,可能伤害到受援助对象的尊严。在国家安全方面,相关研究中提到国家安全机构或其他政府机构部署监视系统用于控制和约束公民,引发了侵犯公民自由权利的争论。

在文化科学领域,主要关注在文化服务、教育中使用机器人产生的伦理问题。如机器人可以代替图书馆工作人员进行书籍订购、分类以及咨询等工作,使相关人员感受到就业环境威胁,甚至产生心理健康问题。机器人教师、同伴在儿童教育中的应用,可能因为长时间陪伴和相处让学生产生情感依恋,减少与人的相处.影响他们社交能力的发展。

在交通运输领域,主要对自动驾驶汽车应用产生的伦理困境进行探讨。自动驾驶汽车在即将发生交通事故时需要做出决策,在驾驶员、乘客、行人安全以及其他相关因素之间进行权衡,面临类似于人类社会的“电车难题”.自动驾驶汽车做出决定会使交通事故的责任归属变得更加复杂.引起道德责任主体与承担方式的争议。此外,自动化使得人们高度依赖技术.一旦自动化生产机器不能正常工作,工人缺乏替代机器进行生产工作的能力,主管作为管理者同样缺乏相关的专业知识和手工技能,使生产链的脆弱性增加。

3.5对策层面

研究中针对人工智能技术应用的伦理问题提出的解决方法,根据借助的工具类型不同,将其分为社会方法和技术方法。

3.5.1社会方法

社会方法倡导,将道德原则、法律法规等有助于规避伦理风险的社会规范融人人工智能技术设计与应用场景,使个人或组织在社会环境中更负责任地使用人工智能技术。

一方面,根据道德原则建立技术规范要求,尽可能降低人工智能技术应用中的伦理道德风险。例如,针对机器学习可能产生的偏见风险.可以通过强调公正和尊重的道德原则来构建公平、非歧视的社会,通过社会数据处理前的伦理分析或道德审查规避风险。同时,人工智能程序设计需要兼顾人工智能的“理性代理”与“对社会负责的代理”角色,设计高效且尊重人类社会的人工智能应用。针对人工智能技术可能破坏人类社会的民主、自由和公平,可以构建一种介于严格监管和自由放任之间的、积极主动的技术民主化方法,对技术设计和应用进行规范化。此外,还可以建立适用于自主机器人开发的公司或组织的道德责任规范体系,通过安全协议事先明确责任归属。更多推广“以关怀为中心的价值敏感设计”方法,将伦理维度纳入机器人设计和实现框架,这种方法目前主要应用于医疗保健领域,通过设计过程的价值观反思性评价,规范机器人的护理实践步骤。

另一方面,使用约束力更强的法律法规应对人工智能技术应用的伦理问题。例如,为了确保公共价值观和人的基本权利在人工智能技术应用中得到保障,Royakkers L等提出设计人员需要认识并遵循国际条约中大数据监管和算法透明度的有关规定。Vamplew P等提到设计自主军事系统时应保证机器的行动符合《战争法》和《交战规则》的有关规定。Ransbotham S等提到针对算法偏见和歧视问题,应参考国家法院《民权法案》中相应的法律原则,在美国《民权法》第七章中就提到了有关的歧视案件的法律条文。

3.5.2技术方法

技术方法是从技术操作层面思考解决方法,以降低人工智能技术应用的伦理风险。

在数据操作方面,根据数据生命周期探讨不同阶段的伦理风险规避。例如,从数据采集来看,Robinson L等提出对机器人收集的信息进行分类.建立各类信息合法获取和使用的标准,可以保护个人隐私信息。从数据处理来看,Hagendorff T提到通过删除敏感、受保护属性,或者修正训练集消除伦理隐患。但是,非敏感属性同样存在产生歧视的可能,而且对训练数据集的修正可能降低数据分析的质量和有用性。从数据组织来看,McDonoughK等提出使用扩展命名实体标注具有历史跨越的地理文本,综合考虑地理空间位置和非地理空间或时间的多样性信息,提高对空间历史的解释力度。从数据共享来看,Kuo T T等提出将隐私保护的学习模型与区块链技术结合起来开发通用的保护隐私的预测模型共享框架,为机构间数据共享时的隐私保护提供帮助。

在算法模型方面,Ananny M提到开发“非监督式学习”算法来识别数据集中可能导致歧视的模式或结构,避免总是基于一种假设而扭曲数据集。Marlies V D V等构建了一个道德决策模型,针对不同的人机关系进行不同道德模式的响应,辅助人工智能系统做出恰当的道德决策。

在智能系统结构方面.Arnold T等提出通过伦理核心应对人工智能系统的道德威胁,伦理核心在智能系统的体系结构中,位于硬件(或最小操作系统层)与虚拟机层之间,由场景生成,仿真引擎以及最小关闭3种机制组成。Malle B F提出通过赋予机器人道德能力来解决伦理问题.包括强化对道德词汇的监测、编写道德规范和道德事件评估的程序、建立道德推理和沟通的能力。

4讨论

综前所述,图情SSCI期刊有关人工智能伦理问题的研究在研究内容的广泛性、领域的结合性上主要体现了如下特点:

第一,研究内容涉及医药卫生、文化教育、军事、政治等多个领域,较为全面地涵盖了从数据、算法到人工智能系统的不同层次.并以人工智能系统层面的问题研究数量最多。

数据层面研究主要围绕数据生命周期,探讨采集、加工、组织、共享等过程中的隐私侵犯隐患和风险。如数据采集、传播时采集原则解释说明缺失或者不充分、数据标注的不当都可能带来侵犯数据采集对象的隐私.给相关社会实体带来伤害,引发社会伦理问题。此外,数据的二次使用或再利用也会加大数据知情同意的实施和数据保护的困难而引发伦理问题。

算法层面的研究结合算法的特性,探讨人工智能算法在具体应用中引发的歧视、偏见、影响人类自主权等问题。过度依赖人工智能算法结果会影响人的自主选择。同时,根据算法的统计结果进行决策可能导致某些歧视性的决定,从而延续甚至加深人类社会的偏见。如地区经济水平的识别、信用资质的评估、就业机会的分配等。

人工智能系統层面主要从智能系统对人的尊严和权利,以及社会关系的影响角度进行分析。例如探讨人工智能系统与人类形成的社会关系对人类社会的影响、在医药卫生行业对护理治疗对象的心理和精神的影响以及自动驾驶汽车、自主军事武器等代替人类进行决策对于人类生命和社会秩序的影响等。因为这些问题的存在,研究者们也对机器伦理道德的设计方面进行了探讨,以及对智能机器的道德地位进行讨论.分析人工智能体是否享有道德权利或承担道德责任等问题。

第二,研究视角覆盖人本主义观和技术主义观,包括积极伦理和消极伦理两类观点倾向。消极伦理观点更多考虑到人工智能技术带来的伦理危机,希望通过规则的制定让问题回归传统伦理规范。积极伦理观点则更多关注人工智能技术带来的促进与机遇。

在人本主义观视角下,以人与人类社会为中心,探讨人工智能技术的应用对社会中的个体以及整体产生的伦理影响。研究中探讨较多的是人的隐私、平等、自主、自由、尊严等以及社会的历史文化和社会联系。如具有历史和文化敏感性的数据组织不当可能对社会的历史文化带来冲击.影响到个人或群体的尊严。推荐系统对特定人种的倾向可能导致偏见、不平等。而医疗护理、娱乐陪伴等应用中智能机器人对人际社会关系的影响也会对人们的心理和精神层面产生影响。

在技术主义观视角下,以数据、算法和智能体为中心,更多从数据化、算法和智能系统的应用出发,考虑数据化的重要性、算法的公平性,尤其是智能体的道德地位。如Miao z通过文献调研讨论人工智能技术应用中的人权伦理困境。又如,从机器人角度,探讨机器的社会道德地位和机器人是否成为道德主体、拥有道德权利、承担道德责任等问题。对于机器道德地位问题的探讨主要是运用对比分析的方法,将智能机器与人或动物等社会实体进行比较分析,基于哲学思维或理论进行分析讨论。在道德地位问题上,Johnson D G等认为,动物和机器人的区别在于对痛苦的感受差异,对机器道德地位问题的讨论会细化出对机器享有道德权利和承担道德责任等问题的探究.但目前的观点和看法尚未取得一致。

由上述分析可见.图情SSCI期刊论文探讨的问题与国内外人工智能伦理研究有着较高的一致性,人工智能算法与数据伦理控制、人工智能体设计、人工智能道德代理等均是整个领域关注的议题。尤其在机器人伦理方面,关于幼儿、老人看护机器人的伦理研究,机器人护理与受护理者尊严的伦理研究,战争机器人行为的伦理研究等也都在图情SSCI期刊中有所体现。从研究机构来看,研究者来自计算机科学、信息系统、信息技术、哲学、心理学、图书情报、语言学等诸多学科。可见,人工智能伦理问题是一个与多学科交织的问题领域。对于图书情报领域而言,信息伦理、用户隐私保护、数据与信息安全一直是关注的研究问题,顺应人工智能时代发展的背景,有必要在伦理研究方面有所加强,推动健全图情学科在交叉学科问题上的研究方法体系建立,促进信息管理技术在同步发展的伦理研究中健康发展.如下问题值得进一步研究:

一方面,加强对不同层次与应用领域问题的涉入和研究。结合信息生命周期管理阶段(如信息创建、信息采集、信息组织、信息存储、信息利用和信息清理),从人工智能技术相关的数据、算法和人工智能系统3个方面进一步加强相关研究的开展。例如,在数据层面,加强在移动互联网应用、社交媒体、公共信息资源管理等情境下,对数据采集方式、用途、规范使用、隐私保护的研究。在算法层面,加大对各类网络搜索、推荐等系统中的偏见问题研究。在人工智能系统层面,加强对丰富应用场景下的探讨,如图书馆中的智能咨询服务机器人、盘点机器人、阅读机器人等在应用中的伦理风险,对现实从业人员的冲击以及应对等问题。人工智能技术在图情服务的应用场景多样,人工智能技术与知识服务基础设施建设、智能知识化服务创新等方面的融合中都会涉及到不同层次的伦理问题研究,都值得从研究脉络溯源、伦理风险识别与应对、智能道德代理、用户对智慧应用态度等角度进行深入研究。

另一方面,加强对人工智能伦理倡导的规范与准则研究。在人工智能技术应用过程中,最大限度降低伦理风险与追求技术优势这两个目标可能存在的冲突,需要结合特定的应用情境,分析不同伦理因素之间的关系,进行综合的分析和权衡。因此,未来研究需要进一步探索人工智能技术在具体应用中的伦理规范,丰富和完善人工智能伦理准则。目前.诸多国家都从政府层面对人工智能实践发展提供了政策支持与推动,在我国,党中央、国务院在人工智能发展规划中都曾专门提及伦理问题研究。相比英、美、日等国,我国在伦理规范与制度建设方面还有待进一步深化。因此,进一步加强对各国政府、国际组织,以及相关行业协会的人工智能伦理倡议、原则的研究,结合我国的应用实践状况,探索从数据、算法、智能系统等微观层面,到人工智能产业、人类社会秩序的宏观层面的人工智能伦理规范与准则的研制与贯彻,促进我国人工智能技术在伦理规范指引下的健康发展,提升在推动全球社会秩序稳定中的地位和作用。

5结语

本研究运用内容分析法对WOS图书情报学科类目的文献进行分析,探讨人工智能伦理问题的研究现状,结果表明,图情学科SSCI期刊的论文从数据、算法以及人工智能系统等多个层面,结合政治法律、军事、经济、文化科学、医药卫生、交通运输等应用领域,进行了一系列的研究,探讨人工智能技术对个体以及人类社会的影响;并且,从人本主义观点和技术主义观点角度进行了共同的探讨,从社会方法和技术方法角度提出了应对的策略。在此基础上展望了图情领域的未来研究问题。

本研究的不足主要包括.尽管调查的文献来自图情学科SSCI期刊论文,这些文献只能有限地反映图情学科对人工智能伦理问题的研究状况.还需要结合学者发文角度,以及人工智能技术应用的实践角度进行综合分析。同时,加强与相关学科人工智能伦理问题研究的比较,进一步结合图情领域的典型应用与服务场景,分析人工智能技术的应用现状、发展趋势,以及伴生的伦理风险与应对,与相关学科一同促进人工智能技术整体的健康发展。