基于计算机视觉的定位引导机器人研究

郑越 罗雅涵 张馨元

摘要:科技的高速发展使工业生产实现自动化功能的要求愈来愈高,工业机器人行业的计算机视觉技术应用愈发广泛。定位引导是自主移动机器人解决各种复杂任务的关键,对于提高机器人自动化水平具有重要的理论意义和应用价值。基于计算机视觉的定位引导机器人能使用计算机视觉去精确获取目标并定位,利用视觉系统获取外部信息,用单摄像头或多摄像头采用第一视角或者第三视角对环境进行成像处理,根据对目标识别匹配或跟踪,实时得到目标的位姿信息,将目标位置的图像坐标转换为机器人能够识别的机器人坐标并对机器人进行修正引导。

关键词:定位引导 计算机视觉 图像识别

基于视觉的定位引导机器人是在OpenCV技术之上利用计算机视觉系统来模拟人眼,使用图像处理来获取有用信息,通过定位技术与定位引导技术,将经信息处理与理解后的图像信息进行检测并控制完成机器人的引导。通过摄像头获得的实时画面,可在整个引导过程中实时检测与修正导航设置,能够确保导引的高精准性。且在实施时仅需在机器人上方架设摄像头,从而能够极大地降低建设的成本。

1视觉技术

1.1.视觉系统

视觉系统的主要任务是实时采集、处理以及识别平台图像,得到平台上目标的相关数据信息,供定位系统以及决策系统使用。图像分割是视觉系统的基础和关键,分割方法的选择对系统整体起决定性作用。颜色作为物体表面的基本特征,是进行物体识别和认知必不可少的信息。目前颜色信息丰富且易于应用,所以本文基于颜色进行图像分割,得到两个色块的坐标信息,从而获知机器人的位姿信息,实现定位。

1.2.openCV

OpenCV 包含了大量视觉相关函数,OpenCV 主体由 5 个模块组成,CV 模块主要包括图像处理的各种基本函数以及计算机视觉的高级处理算法。HighGUI 模块则包括视频图像输入、输出及图像界面函数。ML(Machine Learning)模块包含了机器学习的函数类库,由一些聚类算法、数据分析函数及分类组成。CxCore 模块指基础结构、数组操作、绘图函数错误处理等数据结构及相关函数。第五个模块是 CvAux 模块,包含许多面临淘汰的函数以及算法,还包括许多实验性的函数、算法,诸如前景检测、背景剔除等。

1.3.目标识别

通过摄像头获取的原始图像大都不尽人意,会存在很多干扰信息,诸如复杂的背景、噪声以及光照因素,需要对图像进行预处理,从而降低对目标提取的干扰,以便快速准确得到目标信息。

HSV 颜色模型是按照颜色的直观特征建立的颜色空间模型。该模型三个参数分别为色调(H,hue)、饱和度(S,saturation)和亮度(V,value),由于在目标的识别提取中常常会受到各种光线的影响,这就需要一种在不同亮度条件下而基本没什么变化的颜色模型。通过调用cvtColor(frame,cv2.COLOR_BGR2HSV)方法即可完成颜色空间转换。

在图像的分析与处理中,图像二值化可以说是最常见最基础也特别关键的一种处理手段,有助于对图像进行进一步的分析,可以大大消减图像中的数据量,以便尽早显现出感兴趣的目标轮廓。调用cv2.inRange(hsv,lower_red,upper_red)方法即可实现图像二值化。

为更好地识别我们的核心目标(两个圆球),将原图像和二值化图像进行与操作,去除干扰背景,接着将对图像进行灰度处理,去除检测算法对目标检测的资源耗费,将灰度处理后的结果,传递给检测模块,循环调用霍夫曼检测模块,对目标进行识别标记。

2.定位技术

2.1.推算定位

在导航系统中,推算定位(DR)是一个借助于先前已知位置,以及估计出的速度随时间的变化量来推导出当前位置的过程。本文中推算定位算法是只根据左右两侧车轮行走过的距离实现定位的一种方法,左右兩轮都安装有驱动电机,将光电码盘固定在电机轮轴上,随轮子同步转动。设机器人车轮的直径为D,所使用的光电码盘的线数为P ,在Δt时间内光电编码器的输出脉冲个数ΔN,则机器人走过的距离。

2.2.视觉里程计

视觉里程计是一种利用连续的图像序列来估计机器人移动距离的方法。视觉里程计增强了机器人在任何表面以任何方式移动时的导航精度。本文中视觉里程计算主要包含以下几个步骤:

(1)图像获取,通过单目照相机、双目照相机或者全向照相机获得机器人的运动画面。

(2)图像校正,利用图像处理技术,将获取的图像中的干扰因素去掉,然后对图像进行一系列的初始化处理。

(3)特征检测,在获得预处理后的图像数据后,根据需要检测的特征,在帧与帧之间匹配特征并构建光流场;

(4)检查光流场向量是否存在潜在的跟踪误差,移除外点;

(5)使用由光流场估计照相机的运动;

(6)周期性的重定位跟踪点;

3.导航系统

3.1.目标位置设定

通过摄像头获得场域地图后将地图信息通过GUI反馈给用户,用户通过鼠标等操作确定目标位置,再通过cv2.EVENT_ LBUTTO NDOWN事件获得目标像素坐标,从而确定目标位置

3.2.关键点的像素坐标转化为世界坐标

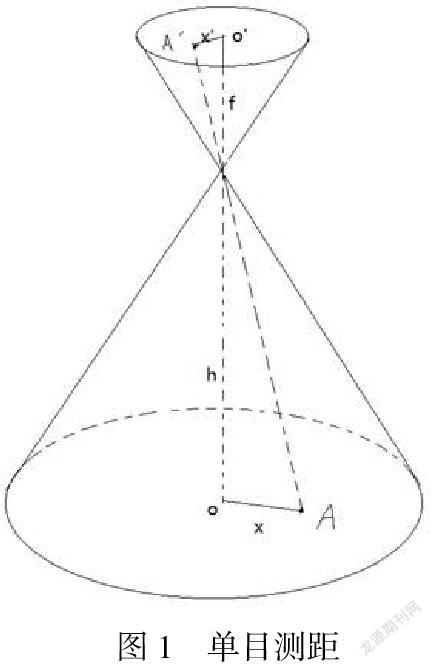

上面文中的视觉处理一共捕获两个圆,一个小圆,一个大圆,其中大圆圆心表示机器人所在点A(x1,y1),小圆圆心表示机器人朝向点B(x2,y2);用户通过鼠标点击事件输入了目的地C(x3,y3)。但这些坐标都是图像中的像素坐标,为此我们要做的第一步是要将摄像头捕获的图像中的距离转化为实际距离。单目测距思想借鉴小孔成像原理,已知物体A到图像中心o’的距离x’,相机焦距f,镜头到地面的高度h,更具三角形相似可得:物体到相机视野区域的中心o的距离问题x=(x’h)/f。如下图1。

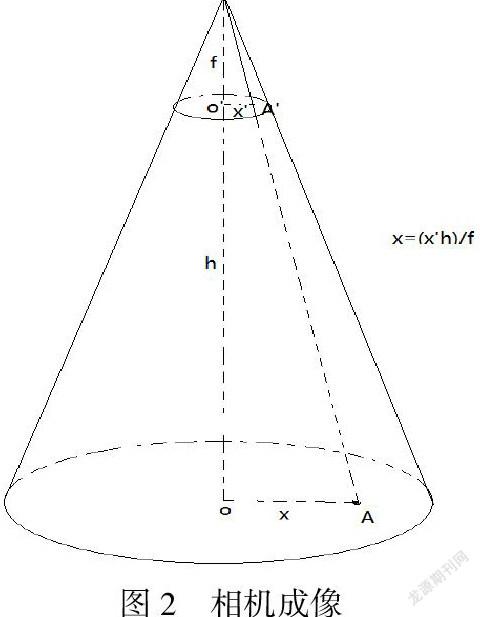

小孔生成的像与视觉生成的像相反,而最终我们观察到的图像与现实一致,这可能是相机通过软件或是硬件调生成的。但我们得到的图像与现实世界可以看作等比缩放,而这个缩放比又由相机高度h和相机焦距f所确定。相机成像数学模型图如下图2所示:

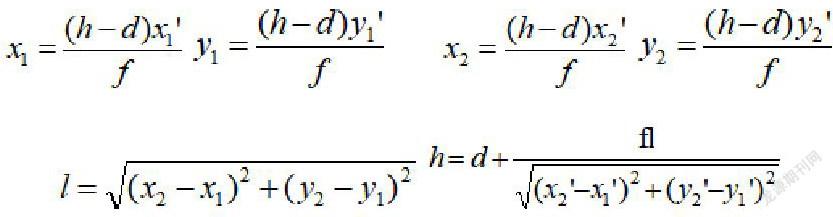

已知小车高度d,AB距离l,相机高度h,相机焦距f,A点在相机成像中的坐标A’(x1,y1),B点在相机所成像中的坐标B’(x2,y2),C点在相机成像所成像中的坐标C(x3,y3),建立图示图像坐标系x’-o’-y’,世界坐标系x-o-y。有如下关系:

因此可看出h为多余条件,即在我们的模型中相机高度h可以未知,但能够正确地将图像里的像素坐标转化为世界坐标。

3.3 定位引导

搭建视觉全局定位平台,是利用摄像头对平台进行图像采集,通过先对图像进行减色处理,方便色标位置更好更快地识别,再将图像从通常用于显示器颜色的 RGB 颜色空间转换为不受亮度影响的 HSV 颜色空间,使得平台更稳定可靠,接着在 HSV 空间进行直方图均衡化,使得色标颜色和背景色对比度变大,增加下一步的识别效率。在预处理的图像中进行识别,得到二值图像,此时,二值图会有一些噪点,色标也不一定就是现实中的形状,由此我们提出了运用腐蚀和膨胀交替进行的开运算、闭运算方式,删除一些孤立零星的噪点,补上一些目标区域的白洞,得到轮廓清晰、噪点很少的二值图,再计算就能得到两个色标的图像坐标。结合参考点及数学建模就能得到机器人的位置信息和到达目的地的运动路径。得到机器人运动路径后,可通过无线传输的方式发送给机器人。机器人在運动过程中,引导系统实时检测机器人位置信息,若发现机器人偏离预定轨道,引导系统即发送指令修正机器人的行驶路线,如此以来便能做到精准引导。

4.结束语

定位是自主移动机器人解决各种复杂任务的关键,对于提高机器人自动化水平具有重要的理论意义和应用价值。本文中通过搭建全局视觉定位平台,及固定在平台正上方的一个第三视角摄像头对实验平台定期采样,经一系列图像处理,得到移动机器人顶部两个色标的图像坐标,再根据图像坐标和世界坐标已知的两个参考点,计算出机器人在实验平台上的世界坐标,得到机器人的位姿信息,从而完成定位引导。结果表明,视觉全局定位精度可达厘米级别,符合室内移动机器人对定位精度的要求。

参考文献

[1]吴晓明.基于计算机视觉的机器人导航综述[J].实验科学与技术,2007(05):25-28.

[2]周艳芳.基于计算机视觉的机器人路径识别与目标跟踪系统[J].信息技术与信息化,2021(04):246-248.

[3]刘康.室内视觉定位与导航综述[J].黑龙江科技信息,2017(08):7.

[4]温倩雯,苏毅辉,李庚.基于单目相机与里程计的室内机器人定位研究[J].电视技术,2021,45(03):100-105+125.

作者简介:

郑越(1999—),男,四川省什邡市,本科,研究方向:内江师范学院物联网工程专业2018级在读本科生;罗雅涵(1998—),女,四川省自贡市,本科,研究方向:内江师范学院物联网工程专业2018级在读本科生;张馨元(1999—),女,四川省成都市,本科,研究方向:内江师范学院物联网工程专业2018级在读本科生。

项目名称:基于计算机视觉的工业机器人,项目编号:X202044