基于Mask R-CNN的玉米苗与株芯检测方法

张伟荣,温浩军,2,谯超凡,汪光岩

(1.石河子大学机械电气工程学院,新疆石河子 832000;2.农业农村部西北农业装备重点实验室,新疆石河子 832000)

0 引 言

【研究意义】玉米是我国北方地区的主要粮食作物[1],传统农业机械智能化水平较低[2]。精准施肥技术能够区分施肥对象与土壤背景,根据作物特征调整施肥量,有效降低化肥量的使用,对节约作业成本和减少环境污染有重要意义[3]。精准对靶施肥通过实时检测来定位每一株玉米的位置,通过施肥器对单株玉米进行定点施肥,减少了施肥量并有效提高化肥的利用率。【前人研究进展】应用机器视觉或者深度学习的方法在果园果实检测[4-6]、田间作物病虫害检测[7-9]、识别作物及杂草[10-12]等均有研究。苗荣慧等[13]基于图像分块及重构的方法,识别菠菜重叠叶片杂草,平均识别率达到83%以上。胡炼等[14]利用超绿色法2G-R-B结合Otsu法对进行处理,随后利用行与列的像素累加曲线和正弦波曲线等方法拟合识别出作物及定位棉苗和生菜苗的质心位置。魏帅均等[15]利用超绿因子与Otsu法分割出苗期玉米植株,并结合水平集法与分治法,俯视图像识别单株玉米冠层的株心,但是该方法田间适用性较差。孙哲等[16]对数据集训练了Faster R-CNN模型,对自然环境下的西兰花幼苗进行有效检测,确定了最优的特征提取网络为ResNet101。宗泽等[17]基于Faster R-CNN算法和差分内积线性特性改进质心检测算法对玉米冠层进行识别与质心定位计算,但无法计算玉米苗的叶面积信息。【本研究切入点】目前部分相关研究的方法大部分适用于静态环境下,达不到田间作业实时性与准确性的要求,没有计算出作业对象的叶面积信息,田间实际作业环境下玉米苗与株芯识别精度低。研究田间实际作业环境下,玉米苗叶面积计算与株芯识别的图像分割方法。提高株芯识别精度对于田间实际作业情况下的精准施肥具有重要意义。【拟解决的关键问题】采集田间实际作业环境下玉米苗俯视图像,以不同特征提取网络的Mask R-CNN图像分割算法,获取适应不同光照强度及有无苗草交叉重合的最优卷积主干网络,构建玉米苗叶面积提取与株芯识别精度最优的检测模型,为对靶精准施肥技术提供理论基础。

1 材料与方法

1.1 材 料

1.1.1 图像采集与预处理

图片采集设备为FLIR BFS-U3-32S4C-C彩色工业相机,最大分辨率为2 048×1 536像素。当玉米幼苗处于2~5叶时,分别采集有无伴生杂草的阴天和晴天两种不同的光照条件下的玉米苗图像。拍摄时相机离地高度约为50 cm,角度设置为垂直地面,以减轻阳光和反射对图像清晰度的影响。采集不同生长阶段田间玉米苗图像共650张。图1

1.1.2 图像数据预处理

将原图像尺寸2 048×1 536等比例缩放为800×600,在训练深度学习模型时,采用包括加噪声、随机模糊、平移、水平与垂直镜像、对角翻转等数据扩增方法。数据增强技术加快了数据集的构建,增加模型训练的鲁棒性和泛化能力,降低过拟合的可能性,得到1 800张扩增后的幼苗数据集。

将数据集图像按照7∶2∶1的比例随机划分为训练集1 260张、验证集360张及测试集180张。训练集用来进行特征提取和训练模型参数,验证集用来对模型进行参数优化,测试集用来评估训练后模型的性能。将整体样本按照COCO数据集格式使用labelme[18]图像标注工具对图像进行手工标注,生成玉米苗和株芯的蒙版图像及对应的json文件。图2

1.1.3 试验环境

模型训练平台为台式计算机,软件操作系统采用Ubuntu18.04,处理器为Intel(R) Core(TM)i7-9700K,主频4.20 GHz,硬盘2T,内存32G,显卡NVIDIA Geforce RTX 2080Ti。采用了基于PyTorch的Detectron2框架,同时采用CUDA 10.2对训练过程进行加速,使用Mask R-CNN在COCO数据集上预训练模型的迁移学习方法以减少训练时间。

1.2 方 法

1.2.1 图像分割算法

Mask R-CNN[19]是一种经典的图像分割算法,可以检测图像中的目标对象并标记对象区域轮廓,提取相关的像素进行面积计算。采用此算法识别玉米芯具体位置和冠层面积的大小。

Mask R-CNN 结合了用于目标检测的Faster R-CNN[20]和用于语义分割的全卷积网络FCN[21]。在Faster R-CNN检测到目标的基础上,将FCN用于掩码预测,边界回归和分类。Mask R-CNN模型的框架,主要包括以ResNet/ResNeXt为卷积主干的特征提取层、区域建议网络(Region proposal network,RPN)、双线性插值(ROIAlign)以及全连接FC和全卷积网络FCN。利用残差网络(Residual network,ResNet)和特征金字塔网络(Feature Pyramid Network,FPN)对输入图像进行特征提取并生成多尺度特征图(Feature Map)。将输出的特征图发送到区域提议网络(RPN)以生成正负样本,选出玉米苗上的感兴趣区域(Region of interest,RoI)。映射从RPN输出的ROI到特征图后,ROIAlign层进一步对特征图进行像素校正以提取共享特征图中的相应目标特征,分别输出到全连接层FC和全卷积网络FCN,以进行目标分类和实例分割,完成分类分数、边界框、分割蒙版以及像素值的计算。图3

1.2.2 改进卷积主干网络

输入的图片通过骨干网络提取多尺度特征图,其骨干网络由残差网络ResNet和特征金字塔网络FPN组成。ResNet[22]是一种借鉴了跨层连接的深度残差卷积网络,采用ResNeXt[23]作为特征提取网络的Mask R-CNN图像分割算法,实现对玉米苗及株芯的识别、检测与分割。

ResNeXt网络模型是在ResNet基础上改进的,吸收了VGG[24]堆叠重复网络层的优点以及Inception[25]网络拆分-转换-合并的思想。ResNeXt的本质是分组卷积(Group Convolution),通过变量基数(Cardinality)来控制组的数量,用一种平行堆叠且相同拓扑结构的块替代原来ResNet三层卷积的块。在ResNeXt中,拆分-转换-合并的形式可表示为

(1)

其中,C表示基数,指一个模块中具有相同拓扑分支的数量,Ti(x)表示具有相同拓扑结构的每个分支的变换。图4

1.2.3 损失函数

Mask R-CNN的损失函数有3部分组成:边界框的分类损失,边界框的位置回归损失及掩膜损失。网络中每个样本ROI的损失函数L为

L=Lbox+Lcls+Lmask.

(2)

其中,有3部分组成:Lbox为分类计算损失,Lcls为边界框的位置回归损失,Lmask为掩膜计算损失。边框损失函数、分类计算损失如式及掩膜计算损失如下式所示,

(3)

(4)

(5)

(6)

1.2.4 评估指标

使用平均准确度均值(Mean Average Precision,mAP)作为评估训练模型精度的指标。mAP是用于预测目标位置和类别的算法性能指标,指的是多个类别平均精度(Average Precision,AP)的平均值,较高的mAP值表明该模型更好。图像分割中,每一类都可以根据准确率P(Precision)和召回率R(Recall)绘制一条曲线,精确率均值AP就是该曲线下的面积。多个指标的计算公式如下:

(7)

(8)

(9)

(10)

其中,TP表示被正确预测为正样本的数量,FP表示负样本被预测为正样本的样本数量,FN表示正样本被预测为负样本的样本数量,k表示类别的数目;P指准确率,指正确检测到的样本占所有实际被检测到样本的比例;R指召回率,指正确检测的样本数占应检测到样本数的比例。

孟欣欣等[26]为了更好评价Mask R-CNN模型对图片的分割效果,引入了分割精度(SA),公式为:

(11)

其中RS表示测试图像中目标的实际像素点个数,TS表示测试图像中分割算法计算得到的像素点个数。分割精度均值(mSA)定义如下:

(12)

其中n表示测试图像的数量。

2 结果与分析

2.1 主体卷积网络性能

研究表明,在训练阶段,在迭代过程中4个模型的整体损失都呈整体下降趋势,其中以ResNeXt-FPN为卷积主干网络的检测模型总体训练损失值要低于相同残差层数的ResNet-FPN卷积主干网络,ResNeXt50-FPN要低ResNet50-FPN,ResNeXt101-FPN要低于ResNet101-FPN。ResNeXt101-FPN卷积主干Mask R-CNN的mAP为0.547,这表明其具有最佳的分割性能;其次为ResNet101-FPN,而ResNeXt50-FPN稍低于ResNeXt101-FPN,高于ResNet50-FPN。ResNeXt卷积主干网络在ResNet基础上引入了拆分-转换-合并思想和分组卷积后,整体上提高了分割模型的性能。随着模型主干网络性能的提升,模型的复杂度和图片平均检测时间会有所增加,具有ResNet101-FPN与ResNeXt101-FPN卷积主干的Mask R-CNN算法对每幅图像的检测时间分别为61 ms与67 ms,可以满足田间作业的实时性。优先采用整体损失值最低的ResNeXt101作为卷积主干网络。图5,表1

表1 识别模型中不同卷积主干网络的试验Table 1 Test results of different convolutional backbone networks in the recognition model

2.2 检测性能

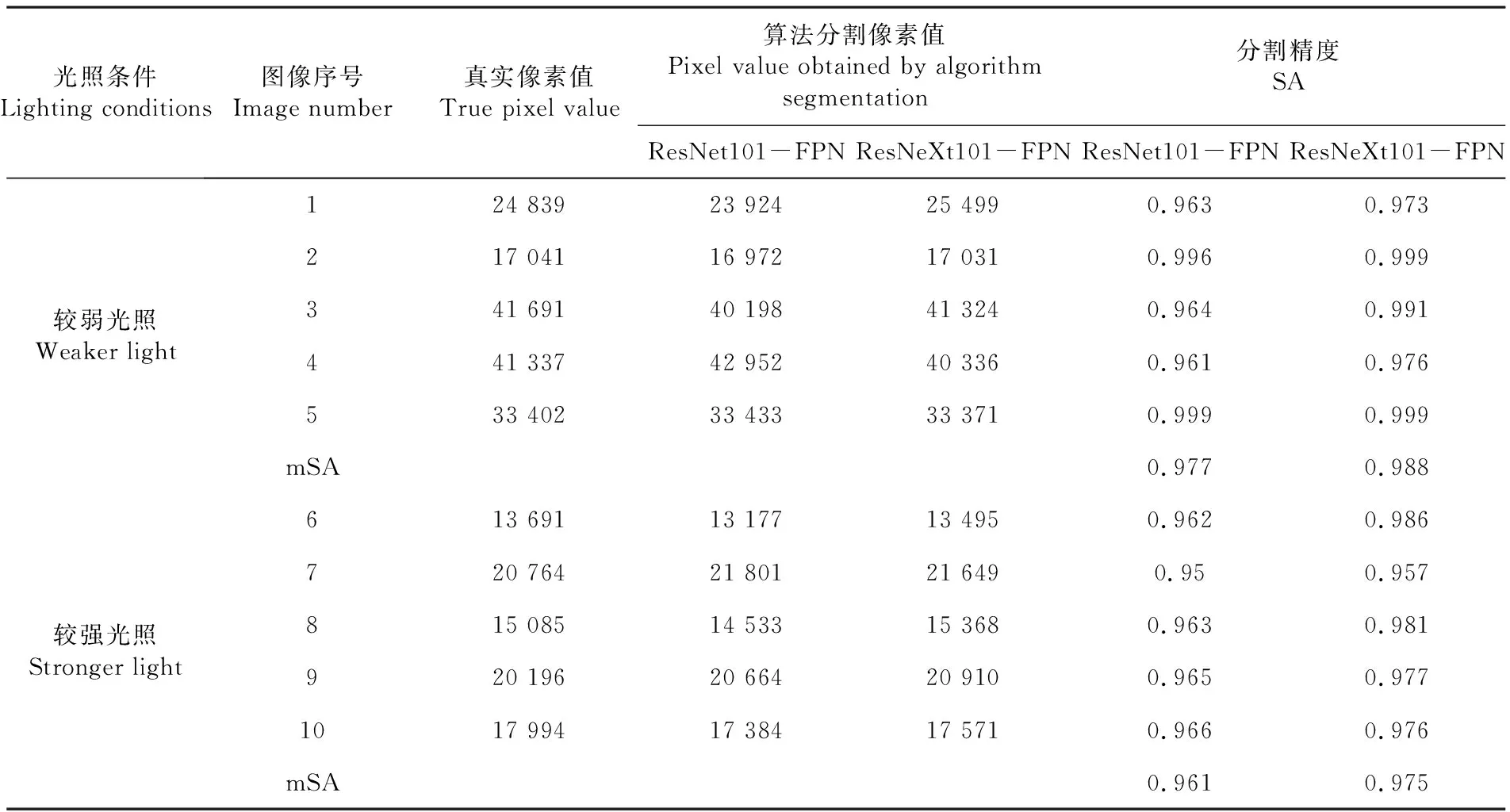

2.2.1 不同光照强度下玉米苗/玉米芯的检测

研究表明,在不同光照条件下,ResNeXt101-FPN卷积主干网络模型的玉米苗和玉米芯识别精度较高。与ResNeXt101-FPN相比,在阴天较弱光照条件下,玉米苗的识别精度高了6.7%,玉米芯的识别精度持平;在晴天较强光照条件下,玉米苗识别精度持平,玉米芯识别精度高了2.7%。玉米苗识别不成功的原因主要是图片中玉米苗的冠层轮廓不完整,导致分割模型对不完整玉米苗的轮廓识别率较低;玉米芯受到部分遮挡、晴天天气下的阴影与玉米芯颜色相近的情况都会导致玉米芯无法识别或误识别的情况发生。

ResNeXt101-FPN作为卷积主干的模型分割精度比ResNet101-FPN要高。晴天较强光照下的分割精度略低,主要原因在于晴天天气下玉米苗在其边缘处产生的阴影会影响叶片的边缘处轮廓分割,模型会将与叶片边缘的部分阴影分割为叶片的一部分,造成过度分割。在不同光照强度下,原始分割模型的平均分割精度值为96.9%,分割模型平均分割精度值则为98.2%,比原始模型的平均分割精度均值提高了1.3%,Mask R-CNN模型对不同光照强度的图像有着更好的分割效果。(a1-a4 代表原图,b1-b4 代表原始的以 ResNet101-FPN 为卷积主干的模型检测结果,c1-c4代表以 ResNeXt101-FPN 作为卷积主干的模型检测结果。两种模型检测结果显示阴天较弱光照下的b1、c1、b2、c2或者晴天较强光照下b3、c3、b4、c4的玉米苗图像)。表2,表3,图6

表2 不同光照强度下的目标分割像素Table 2 Target segmentation pixel statistics table under different light intensity

表3 不同光照强度下的像素计算误差对比Table 3 Comparison of pixel calculation errors under different light intensity

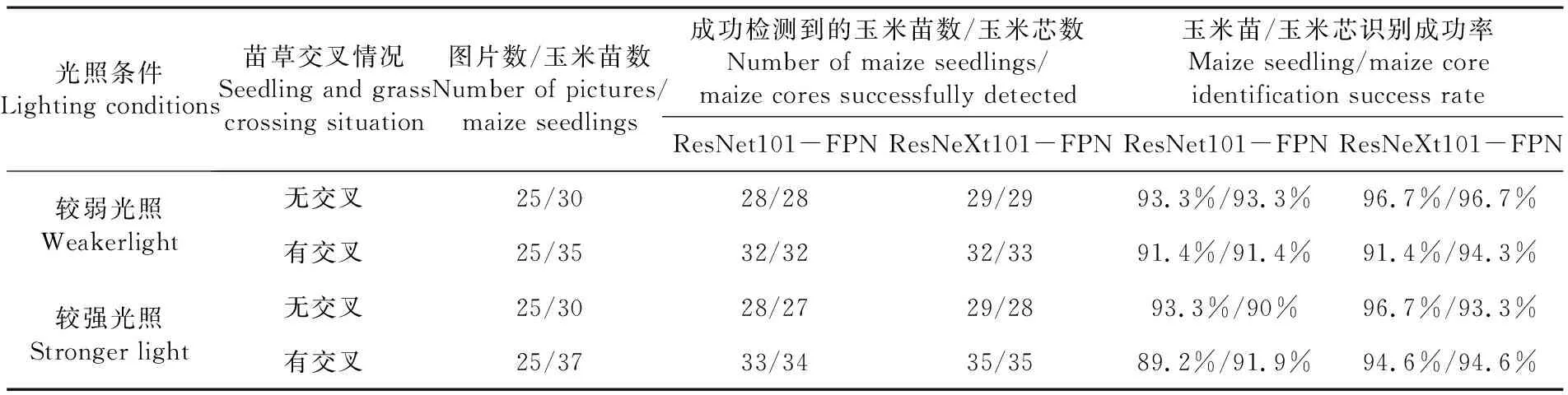

2.2.2 有伴生杂草情况下玉米苗/玉米芯的检测

研究表明,对于阴天较弱光照或者晴天较强光照条件下有伴生杂草的玉米苗图像,2种模型的检测效果较好,采用的模型对玉米苗叶片和玉米芯的叶面积及边界框位置有着更高的准确度。(a1-a4 代表原图,b1-b4 代表原始的以 ResNet101-FPN 为卷积主干的模型检测结果,c1-c4 代表以 ResNeXt101-FPN 作为卷积主干的模型检测结果。 a1-c1及a2-c2代表图像中有伴生杂草但苗草不存在交叉情况的玉米苗检测结果,a3-c3及a4-c4代表图像中有伴生杂草且苗草存在交叉情况的玉米苗检测结果)。图7,图8

当有伴生杂草时,2个模型的识别准确率相比无伴生杂草分别下降1.45%和0.74%。在相同的光照条件下,当伴生杂草与玉米苗存在有交叉重合情况时,2个模型的识别精度均有下降。在阴天较弱光照条件下,2个模型在无交叉情况下的玉米苗和玉米芯检测精度比有交叉情况平均要高1.9%和5.3%;在晴天较强光照条件下,无交叉情况下要比有交叉情况平均要高1.1%和0.4%。在伴生杂草与玉米苗存在交叉重合和不存在交叉重合情况下,阴天较弱光照和晴天较强光照下的ResNeXt101-FPN模型的平均识别准确率比ResNet101-FPN模型高2.4%和3.7%。表2,表4

表4 不同光照强度下有伴生杂草的目标识别成功率Table 4 Target recognition success rate with associated weeds under different light intensities

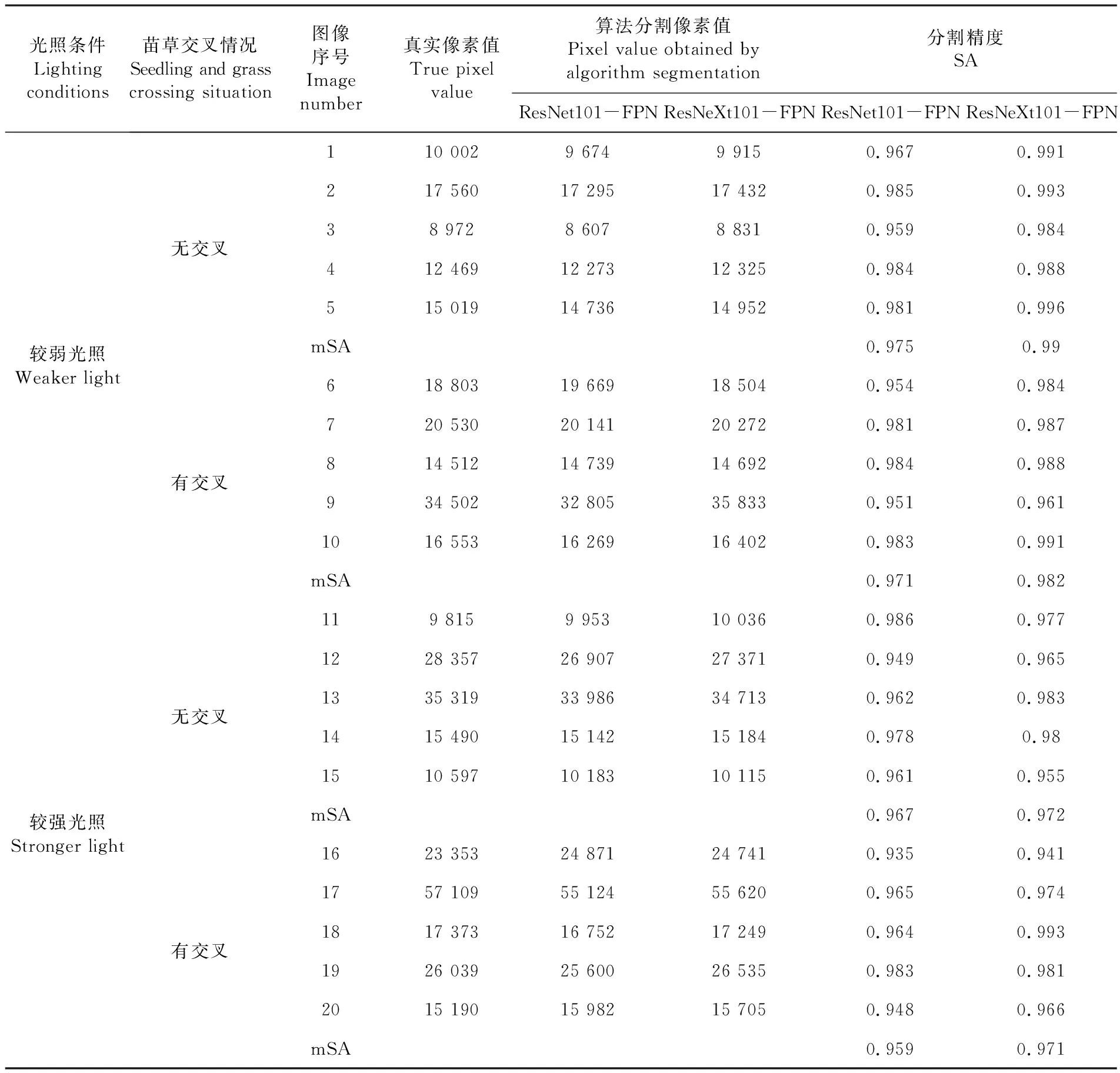

研究表明,与阴天较弱光照和苗草无交叉情况下对比,晴天较强光照与苗草有交叉情况下模型的分割精度均较低,且晴天苗草有交叉重合的情况下模型的分割精度最低。当伴生杂草和玉米苗有交叉重合的情况时,由于玉米苗与杂草边缘的交界处存在高度相似性,使得模型对玉米苗的边缘轮廓分割精度变差,模型容易把边缘重合处的部分杂草识别为玉米苗轮廓的过度分割及无法识别边缘重合处玉米苗的不完整分割。尤其在晴天的较强光照条件下,阳光投射的阴影更会加大玉米苗边缘轮廓的分割难度。表5

表5 不同光照强度下有伴生杂草的目标分割像素Table 5 Pixel statistics table of target segmentation with associated weeds under different light intensities

在不同光照强度和有无苗草交叉重合情况下,原始分割模型的平均分割精度值为96.8%,以ResNeXt101-FPN卷积主干网络模型平均分割精度值则为97.9%,分割模型比原始模型的平均分割精度均值提高了1.1%,Mask R-CNN分割模型对不同光照苗草交叉重合情况下的图像有着更好的分割效果。

3 讨 论

3.1对玉米苗冠层面积信息的提取关系到对靶施肥化肥使用量的大小,株芯的识别与定位则是能否精准对靶的关键,通过分析前人利用机器视觉或深度学习算法提取玉米苗冠层和株芯的方法,得知目前研究对于农田作物信息的获取不够全面,无法满足田间实际环境精准作业的要求。

3.2对比Zong Z[27]等基于机器视觉的玉米株芯定位方法来进一步验证研究方法的有效性,在有伴生杂草与玉米苗有交叉重合的情况下,讨论算法玉米芯识别精度为94.7%,高于文中基于灰度的最小交叉熵法算法的玉米株芯识别率88.37%。研究方法具有较高的识别速度和较高的鲁棒性,而且讨论使用的分割算法还能实时计算玉米苗的冠层面积,可针对单株玉米苗冠层叶片面积大小进行变量施肥,基本满足大田复杂光照及背景的实时检测及对靶施肥需求。

3.3但该方法仍存在一些不足:(1)虽然对于阴天较弱光照及晴天较强光照下的目标识别准确率都比较高,但是对于晴天天气下的阴影导致玉米苗部分边缘区域分割不理想;(2)对于伴生杂草与玉米苗有交叉重合的情况,由于玉米苗边缘与杂草存在一定程度的颜色相近与边缘重合,模型准确率也有一定下降,尤其是晴天天气下且伴生杂草与玉米苗有交叉重合时,模型更易把苗株边缘重合的杂草部分识别为玉米苗。后期需要对模型进行进一步优化改进来解决上述遇到的问题,需要未来进一步探讨。

4 结 论

通过Mask R-CNN模型特征提取网络的改进,提取了田间实际情况下的玉米苗叶面积与株芯等关键信息。在强光照条件下的识别精度下降问题得到基本解决,不同光照强度下无伴生杂草的平均识别精度高于95.5%,分割精度达98.1%;在有伴生杂草与玉米苗有交叉重合情况下,改进后的分割算法比原始算法的分割精度均值有所提高,识别精度高于94.7%,分割精度达97.9%。