基于特征递归融合YOLOv4网络模型的春见柑橘检测与计数

易 诗,李俊杰,张 鹏,王丹丹

基于特征递归融合YOLOv4网络模型的春见柑橘检测与计数

易 诗1,2,李俊杰1,张 鹏1,王丹丹1

(1. 成都理工大学机电工程学院,成都 610059;2. 重庆邮电大学工业互联网与网络化控制教育部重点实验室,重庆 400065)

春见柑橘个体小、单株果树柑橘密集、柑橘之间的形态与颜色相似度高且易被树叶严重遮挡,这些特点给春见柑橘检测与计数带来了较大困难。该研究以实际春见果园环境中的春见柑橘作为检测与计数对象,提出了一种以春见柑橘为检测目标的基于特征递归融合YOLOv4网络模型(YOLOv4 network model based on recursive fusion of features,FR-YOLOv4)。针对春见柑橘尺寸小的特点,FR-YOLOv4网络模型的主干特征提取网络采用了感受野更小的CSPResNest50网络,降低了小尺寸目标的特征图传不到目标检测器中的可能性;针对春见柑橘被遮挡和密集分布的情况,采用了递归特征金字塔(Recursive Feature Pyramid,RFP)网络来进行特征递归融合,提高了对果园环境下春见柑橘的检测精度。试验结果表明:FR-YOLOv4网络模型对于果园环境中春见柑橘的平均检测精度为94.6%,视频检测帧率为51帧/s。FR-YOLOv4网络模型相比于YOLOv4、单次多框检测器(Single Shot Multi-Box Detector,SSD)、CenterNet和更快速卷积神经网络(Faster- Region-Convolutional Neural Networks,Faster R-CNN)的平均检测精度分别提高了8.9、29.3、14.1和16.2个百分点,视频检测帧率分别比SSD、Faster R-CNN提高了17和33帧/s。FR-YOLOv4网络模型对于实际果园环境中春见柑橘的检测精度高,具备检测实时性,适用于春见果园中春见柑橘检测与计数。

机器视觉;图像处理;模型;检测;春见柑橘;YOLOv4

0 引 言

随着农业智能化与自动化的普及,种植园果实的检测与计数是近年来的研究热点。春见柑橘为晚熟杂柑品种,是日本有发展前途的杂交柑良种。由于其产量高、肉质脆嫩、化渣、清甜,少籽与无籽、品质优的特点,被广泛种植于四川、重庆等地[1-2]。春见柑橘果园环境复杂,且单株果树产量高,柑橘之间遮挡严重,在人工劳动力紧张条件下,实现春见柑橘的精准检测与计数对春见柑橘的经济价值评估与机械自动化果实采摘具有广阔应用前景与重大现实意义。

基于深度学习的目标检测算法具有强大的学习能力和特征表示能力,在对存在遮挡、尺度变换和背景切换的目标检测效果上比传统的检测算法更具优势。基于深度学习的目标检测主要包括三类,第一类是基于区域生成的卷积网络结构,代表网络为区域卷积神经网络(Region-Convolutional Neural Networks,RCNN)、更快速卷积神经网络(Faster Region-Convolutional Neural Networks,Faster R-CNN)[3-4];第二类是把目标位置的检测视作回归问题,直接利用卷积神经网络(Convolutional Neural Networks,CNN)进行图像处理,同时预测出目标的类别和位置,代表网络有单次多框检测器(Single Shot Multi-Box Detector,SSD)、单次检测器(You Only Look Once,YOLO)[5-6];第三类是检测器采用目标的关键点以估计目标中心点,再回归到其他目标属性的无锚点目标检测方法,代表网络有用于目标检测的关键三元组(CenterNet)[7]。在农作物目标检测方面,薛月菊等[8]采用了改进型的YOLOv2检测方法实现了对未成熟芒果的识别。武星等[9]采用了残差块串联的轻量化YOLOv3检测算法实现了对苹果的识别。吕石磊等[10]采用了改进的YOLOv3-LITE轻量级神经网络实现了对柑橘的识别。李善军等[11]采用了改进的SSD检测方法实现了对柑橘的实时分类检测。张领先等[12]等采用非极大值抑制的卷积神经网络检测方法对冬小麦麦穗进行计数。鲍文霞等[13]等采用拥挤场景识别网络(Congested Scene Recognition Network,CSRNet)对田间麦穗进行麦穗密度估计及计数。Yu等[14]采用了基于掩膜的区域卷积神经网络(Mask Region-based Convolutional Neural Network,Mask R-CNN)提高了草莓采摘机器人果实检测的性能。Tian等[15]采用了改进的YOLOv3检测方法实现了对果园不同生长阶段的苹果的识别。Anami等[16]设计了一个深度卷积神经网络对稻谷各阶段进行了检测。Neupane等[17]利用无人飞行器结合深度学习的方法对香蕉进行检测和计数。Khaki等[18]将卷积神经网络与非最大抑制结合对玉米籽粒进行计数。Häni等[19]结合深度学习方法和基于高斯混合模型的半监督方法对苹果进行了高精度的检测和计数。Afonso等[20]利用Mask R-CNN对西红柿进行了像素级检测。Rahnemoonfar等[21]设计了一种基于Inception-ResNet的改进型算法对水果进行了有效的计数。Qureshi等[22]利用深度学习对芒果纹理进行分割后对芒果进行计数。黄豪杰等[23]利用基于SSD改进模型对苹果进行检测。Wu等[24]采用了改进的YOLOv4网络模型实现了对苹果花的识别。但以上方法未涉及复杂特定条件下的果实检测与计数,本研究以YOLOv4网络模型为基础,以遮挡等复杂特定条件为背景,以春见柑橘为检测与计数对象进行研究。其中YOLOv4网络模型具有检测速度快、检测精度高、模型泛化能力强等优点,但对复杂果园环境中的春见柑橘进行检测还存在以下问题:1)对小尺寸春见柑橘的检测精度需进一步提高;2)对重叠和遮挡下的春见柑橘检测精度需进一步提高;3)对各种不同光照等复杂环境下的密集春见柑橘目标检测精度需进一步提高。

综上,本研究针对复杂果园环境中的春见柑橘特点,在YOLOv4目标检测网络的基础结构上,提出了一种基于特征递归融合YOLOv4网络模型(YOLOv4 network model based on recursive fusion of features,FR-YOLOv4)。该网络模型根据复杂果园环境中春见柑橘的尺寸小、密度大、易遮挡等特点,将原始YOLOv4的主干特征提取网络换为感受野更小的CSPDarknet53网络[25],以此提高对小尺寸春见柑橘的检测能力,特征融合层采用递归特征金字塔(Recursive Feature Pyramid,RFP)[26],以提高对不同环境下密集遮挡目标的检测精度。

1 材料与方法

1.1 试验数据采集

为进行对春见柑橘的精确检测与计数,需根据果园环境的多样性进行春见柑橘数据采集,本研究数据采集于四川省蒲江县春见果园,使用4K摄像头(AT-C0320X2-REV1.1,索尼)、4K高清相机(FDR-AX700,索尼)等多种设备实时采集图像与视频,采集距离为1~3 m,采集时间为1月中上旬,采集环境包括阴天、雨天、晴天、遮挡等,共拍摄得到时长为15~600 s的多段视频。为增强模型泛化能力和保证春见柑橘数据的多样性,通过网络爬虫得到春见柑橘图像200张。经过图像和视频数据处理,共得到900张不同环境下的高清春见柑橘数据集图像。

1.2 数据集制作

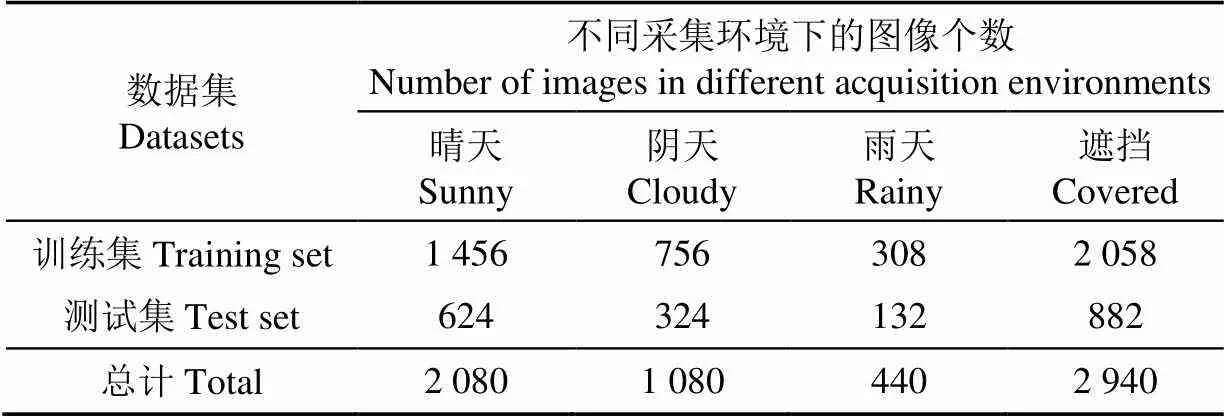

为提高模型的泛化能力,采用OpenCV软件工具对数据集进行增广,包括亮度变化、加入高斯噪声、45°~60°方向的随机旋转。对原始数据集中900张图像进行上述3种方式的数据增强,最终得到了3 600张图像的增强数据集。对增强数据集使用LabelImg软件工具对春见柑橘进行标注。按7∶3划分训练集与测试集,其中训练集包括2 520张图像,测试集包括1 080张图像,数据集样本中春见柑橘图像样本如图1所示。数据集中不同情况数量具体分布如表1所示。

表1 春见柑橘数据集数量分布

2 检测方法

2.1 YOLOv4 网络模型

YOLO系列目标检测网络模型由于其速度与检测精度的优势,被广泛用于工业与科研领域,YOLOv4是YOLO系列目标检测网络模型之一,其特点在于训练成本低、检测速度快、检测精度高。YOLOv4网络模型由主干特征提取网络(CSPDarknet53)、YOLOv3目标检测器[27]、路径聚合网络(Path Aggregation Network,PANet)[28]、基于距离交并比的非极大值抑制(Distance Intersection over Union Non Maximum Suppression,DIoU_NMS)[29]4 个部分组成,YOLOv4结构如图2所示,其中卷积残差层CSPRes_X结构如图3所示。YOLOv4模型输入图像分辨率为608×608,其主干特征提取网络采用CSPDarknet53网络,经主干特征提取网络得到大小为19×19的深层特征图,利用空间金字塔池化(Spatial Pyramid Pooling,SPP)[30]对最后得到的特征进行不同尺寸的最大值池化。将经过空间金字塔池化得到的特征进行拼接和处理后送入PANet网络。PANet网络在进行特征融合的同时减少了浅层特征的丢失,有助于提高模型的准确率。YOLOv3目标检测器对不同尺寸的特征进行回归分析,得到目标位置和分类置信度,DIoU_NMS算法在剔除冗余的检测框的同时,不仅提高了模型的收敛速度,而且使目标框回归更加稳定,使目标位置信息更准确,置信度更高。

YOLOv4虽在COCO数据集[31]上取得了较好的检测效果,但由于YOLOv4网络模型的主干特征提取网络CSPDarknet53感受野太大,小目标信息不易传到YOLOv4的目标检测器中,易造成小目标丢失。此外特征融合方式不利于检测遮挡环境下、光照变化条件下的密集春见柑橘目标。因此需要对YOLOv4网络模型做出改进,进一步提高复杂果园环境中春见柑橘的检测精度。

2.2 特征递归融合YOLOv4网络模型(FR-YOLOv4)

YOLOv4网络模型中,在主干特征提取网络中采用了多个3×3卷积层,并未充分考虑到小尺寸目标的特征图向后传递过程中会因为感受野过大而出现信息丢失严重的问题,并且在特征融合层中采用的路径聚合网络(PANet)只是单纯保留了更多的浅层信息,然而忽视了对于复杂环境单次提取的特征不足的问题和特征金字塔(Feature Pyramid Network,FPN)[31]的表示能力不足以应对遮挡和不同光照等复杂问题。为提高YOLOv4网络模型对实际复杂果园环境中具有遮挡、不同光照、不同尺寸的春见柑橘目标检测精度,同时保证检测的实时性。本研究提出了特征递归融合YOLOv4网络模型。特征递归融合YOLOv4网络模型结构如图4所示,在YOLOv4网络模型基础上采用了一种感受野更小的特征提取网络CSPResNext50,并将原始YOLOv4网络模型中的特征融合层FPN换为递归特征金字塔(Recursive Feature Pyramid,RFP)。该改进提高了对小尺寸目标的特征提取能力,增强了网络对特征的学习能力,有利于提升其目标检测性能,提升实时性。

小尺寸目标检测困难是由于随着卷积神经网络中卷积层数的增加,特征图的尺寸会不断缩小,导致小尺寸目标的特征图传不到目标检测器中。FR-YOLOv4网络模型使用了主干特征提取网络CSPResNext50,主干特征提取网络CSPResNext50在ResNext50网络[32]的基础之上引入了CSPNet结构。与ResNext50网络相比,CSPResNext50网络的计算量减少了47%左右[33],有利于提高检测速度,并且ResNext50网络的残差单元中采用了组卷积,大大降低了参数量,模型因此更轻量化,便于部署在移动嵌入式设备上。FR-YOLOv4网络模型的主干特征提取网络主要由3个卷积归一化层(Conv_BN_Leaky)、1个最大池化层(MaxPooling)、4个跨阶段卷积残差层(CSPResx_X)组成,跨阶段卷积残差层(CSPResx_X)结构如图5所示。其中4个跨阶段卷积残差层中的残差单元的数量分别为3、4、6、3。在最后3个跨阶段卷积残差层中输出19×19、38×38、76×76大小的特征图,19×19大小的特征图用于检测大尺寸目标,38×38大小的特征图用于检测中尺寸目标,76×76大小的特征图用于检测小尺寸目标,在递归特征金字塔RFP中,以3个尺寸的特征图进行特征融合,提升检测精度。

RFP结构主要思想是在特征提取网络和特征金字塔网络之间加入了若干条反馈连接,该反馈连接可以将FPN中的特征信息再送给特征提取网络进行2次甚至多次提取。在反馈连接之前首先会采用1×1的卷积来处理FPN中需要进行反馈的特征,使反馈特征的维度与主干网络提取的特征维度适配。该方法既能增强主干特征提取网络提取特征的能力,也能增强FPN对特征的表示能力,极大地提高了检测性能。

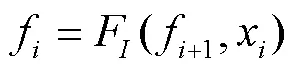

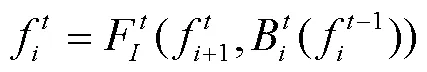

主干特征提取网络第层输出的特征图x计算如式(1)所示。

式中B表示主干特征提取网络的第层,表示主干特征提取网络总共的层数,x表示主干特征提取网络第层所提取的特征图。

特征金字塔网络(FPN)第层输出的特征图f计算如式(2)所示。

式中F表示特征金字塔FPN中的第次特征融合操作,f表示同时拥有主干特征提取网络和FPN的网络中FPN所输出的第层特征图。

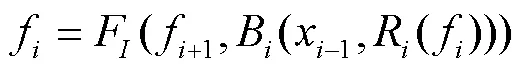

在RFP中,采用R来表示特征在反馈到主干特征提取网络之前进行的特征转换,则x的计算如式(3)所示,RFP中输出的第层特征图f计算如式(4)所示。

由此构成一个递归特征金字塔,输出特征f可以不断地通过递归特征金字塔送回到主干网络反复进行特征提取,有助于网络对于复杂特征的理解。采用来表示RFP中的第次递归,则第次递归过程中x的计算公式如式(5)所示,RFP中输出的第层特征图f计算公式如式(6)所示。

由于递归特征金字塔RFP会增加整个网络的计算成本,为保证实时性要求,在本试验中,取最大递归次数为2。如再增加递归次数,对本试验配置而言,不仅会造成视频处理帧率下降,平均精度也不会显然提高。因此在本文试验中,保持最大递归次数为2,这能以较少的计算成本换取较高的检测精度,实现对果园环境中具有不同光照和遮挡程度的春见柑橘目标进行高精度与高实时性检测。

2.3 FR-YOLOv4网络模型的损失函数

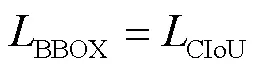

FR-YOLOv4网络模型的损失函数继续沿用原始YOLOv4网络模型中的损失函数,总的损失函数主要分为边界框回归损失值(BBOX)、分类损失值(Class)、置信度损失值(Pre)三部分[27],其计算如式(7)所示。

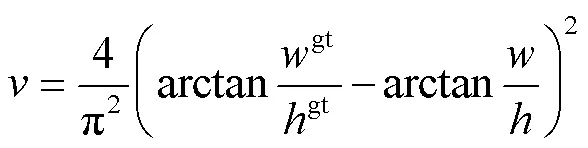

与YOLOv3网络模型相比,YOLOv4网络模型只在边界框回归损失值(BBOX)上做了改进,边界框回归损失采用了完全交并比损失值(Complete Intersection over Union loss,CIoU)[32],CIoU考虑了边界框回归中被忽略的3个几何因素,即重叠面积、中心距离、宽高比。因而CIoU能够更好地描述边界框回归,同时CIoU 损失的收敛速度更快,性能更优越。完全交并比损失值(CIoU)的相关定义如式(8)和式(9)所示。

式中IoU为交并比,为预测框,为真实框,ctr为预测框的中心坐标,ctr为真实框的中心坐标,为欧氏距离,表示和的最小包围框的对角线长度,为长宽比的惩罚项,其中和的相关定义分别如式(10)和式(11)所示。

式中gt、gt分别为真实框的宽和高,、分别为预测框的宽和高,为正参数,用以调节宽高比,衡量了边界框宽高比的一致性。主要用来使预测框的宽高比与真实框的宽高比尽可能接近,当预测框的宽高比与真实框的宽高比相等时,值为0,CIoU减小,进一步使边界框的回归效果更精确,与真实框更接近。

综上,使用CIoU损失可以直接最小化预测框和真实框的中心距离,有利于提高FR-YOLOv4网络模型的收敛速度以及边界框的回归精度,进一步提高对复杂果园环境中春见柑橘的平均检测精度与检测实时性。

2.4 试验参数

本试验采用硬件设备配置为Core i5-10600kf 4.1Ghz处理器,内存为16 GB,Geforce GTX 1080ti 8 GB显卡,软件试验配置环境为:Win10操作系统,配置安装tensorflow1.13.1,Python3.6和Opencv4.4。对FR-YOLOv4网络模型训练时,优化器采用随机梯度下降算法(Stochastic Gradient Descent,SGD)[34],训练集图像分辨率为608×608的图像,初始学习率设置为0.000 1,动量设置为0.95,训练迭代次数设置为5 000,每次训练喂入网络的批量样本数为8,每迭代100次保存模型,最终选取在测试集上损失最小的模型为本研究试验模型[21-24]。

2.5 评价指标

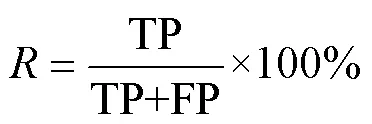

本试验采用精确率(Precision,)、召回率(Recall,)、平均精度均值(mean Average Precision,mAP)、帧率(Frames Per Seconds,FPS,帧/s)作为评价指标。试验采用动态视频采样,以置信度分数高于0.6的目标数量作为本网络所检测到的春见柑橘数量。、和mAP的相关计算如式(12)、式(13)和式(14)所示。

式中TP为被模型预测为正类的正样本,FP为被模型预测为正类的负样本,FN为被模型预测为负类的正样本。

3 结果与分析

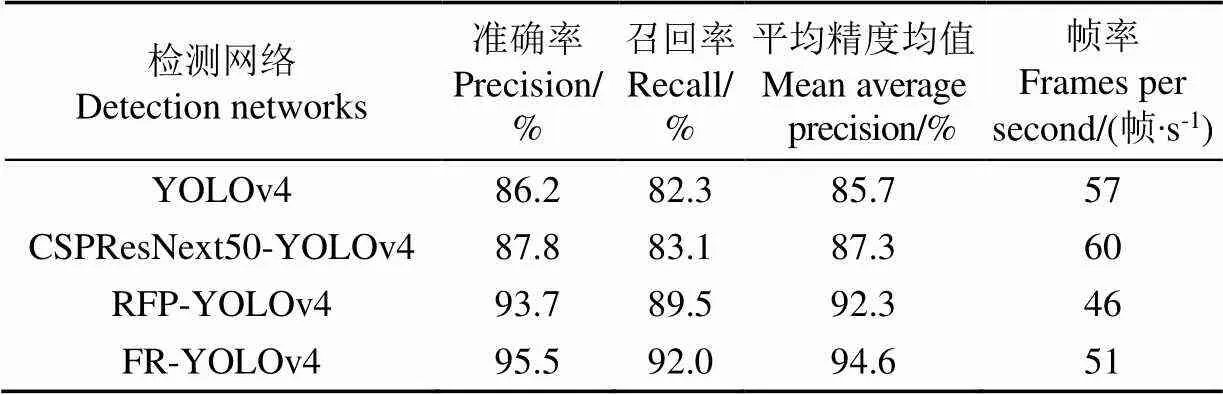

3.1 YOLOv4网络模型改进前后的效果对比

为验证本研究提出的FR-YOLOv4网络对实际果园环境中的春见柑橘检测的优势,试验采用改进前的YOLOv4网络模型、主干特征提取网络为CSPResNext50的YOLOv4网络模型、特征融合层为RFP的YOLOv4网络模型、特征递归融合YOLOv4网络模型(FR-YOLOv4)进行对比。试验采用相同数据集和相同参数训练各个模型,并且采用相同测试集来评估模型。在实际果园环境中,春见柑橘体积偏小,柑橘密度大,柑橘之间、柑橘与树叶之间遮挡严重。因此首先选取测试集中在此类情况下出现的春见柑橘目标进行检测,其检测结果如图6所示。

对比小目标测试结果图,对主干特征提取网络进行改进前,YOLOv4网络不能检测出矩形框中小尺寸春见柑橘。对主干特征提取网络进行改进后,矩形框中小尺寸春见果实目标能够被检测到,春见柑橘边界框回归也更精准。因此,采用感受野更小的CSPResNext50特征提取网络,可防止小尺寸目标特征信息丢失,利于小尺寸目标的检测,提高了小尺寸春见果实的平均检测精度。

对比遮挡目标测试结果图和密集目标测试结果图,对特征融合层改进前,YOLOv4网络对于密集春见柑橘目标的识别能力不足,并且由于春见果树单株产量高,YOLOv4网络不足应对春见柑橘之间遮挡和树叶遮挡情况。采用递归特征金字塔RFP作为YOLOv4的特征融合网络后,改进的YOLOv4网络能够顺利识别到遮挡目标测试图中矩形框标注的两处遮挡春见柑橘和密集目标测试图中矩形框标注的一处密集春见柑橘。因此,该改进提高了YOLOv4网络在复杂果园环境中的识别力,提高了对遮挡春见柑橘与密集情况下的春见柑橘检测精度。对于FR-YOLOv4网络,RFP特征融合网络弥补了由于CSPResNext50网络深度不够而带来的识别能力不足的问题,CSPResNext50特征提取网络也弥补了RFP对小尺寸目标特征融合不足的问题。最终测试效果(图6)显示FR-YOLOv4网络模型能够实现对实际果园环境中小尺寸、高密度、重叠遮挡等不同环境下春见柑橘的精准识别。

经完整测试后,对上述4个目标检测网络检测春见柑橘目标的准确率、召回率、平均精度均值mAP、视频处理帧率进行统计。由表2可知,对于春见柑橘检测平均精度,本研究提出的FR-YOLOv4网络模型比原始的YOLOv4目标检测网络模型高出了8.9个百分点,分别比只改进特征提取网络为CSPResNext50的YOLOv4网络模型与只改进特征融合层为RFP的YOLOv4网络模型高出7.3与2.3个百分点,因此FR-YOLOv4网络模型对于实际果园环境下的春见柑橘检测效果最精确。FR-YOLOv4网络模型的视频处理帧率分别比原始YOLOv4网络模型和CSPResNext50-YOLOv4网络模型降低了6和9帧/s,比RFP-YOLOv4网络模型提高了5帧/s。虽然RFP网络会增加YOLOv4网络模型的计算量,造成了帧率的下降,但对于春见柑橘检测与计数任务,该帧率足以保证春见柑橘检测的高实时性。

表2 不同YOLOv4网络模型识别春见柑橘的结果对比

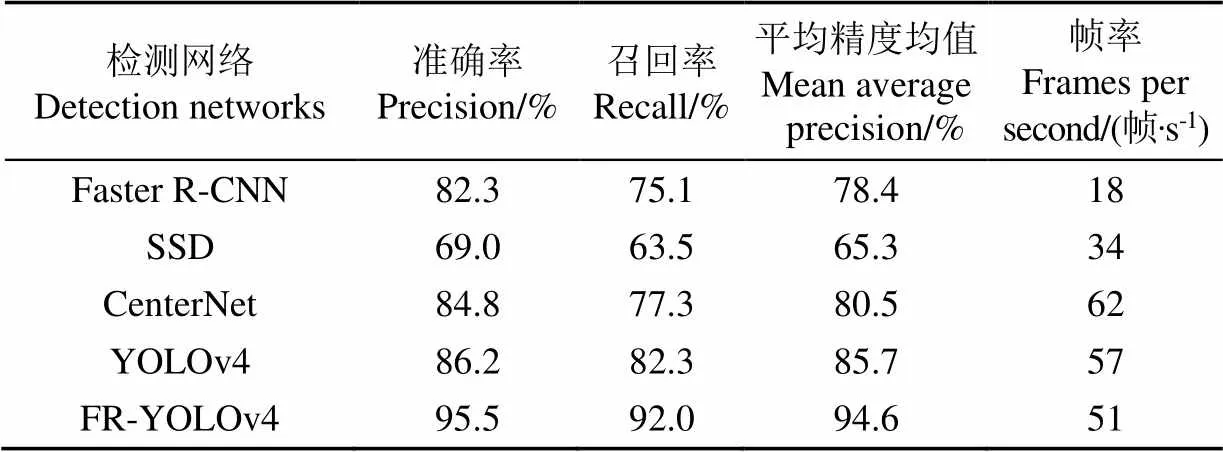

3.2 不同方法的效果对比

为了验证本研究提取的方法相对于其他目标检测方法在检测复杂果园环境中春见柑橘的优势,本研究采用FR-YOLOv4与目前具有代表性的目标检测网络Faster R-CNN[4]、SSD[5]、CenterNet[7]、YOLOv4[27]进行对比,试验采用相同数据集和相同参数进行训练,采用相同测试集进行模型评价。在测试时,主要测试小尺寸、遮挡、密集3种情况下春见柑橘的检测情况,各个模型的检测情况如图7所示。

首先,选择远距离拍摄的春见柑橘图像进行测试,此类图像春见柑橘目标尺寸较小,测试结果如图7小目标结果图所示。由图7小目标测试结果,FR-YOLOv4网络检测精度最高。YOLOv4网络能够检测大尺寸春见柑橘,对小尺寸识别精度不足。SSD目标检测网络模型只检测到了3处春见柑橘,CenterNet和Faster R-CNN检测效果居于SSD和YOLOv4之间。

在实际的果园环境中,由于春见树叶茂盛,果实产量高,春见柑橘通常被树叶和果实遮挡,这对检测与计数造成了相当大的难度。因此再选取测试集中具有遮挡效果的春见柑橘图像进行测试,测试结果如图7遮挡结果图所示。由图7遮挡结果图所示,FR-YOLOv4网络模型对遮挡春见柑橘目标的检测数量最多,YOLOv4、CenterNet、Faster R-CNN对弱遮挡目标的检测有一定效果,SSD对遮挡春见柑橘的检测效果最差。由结果可知,FR-YOLOv4网络模型对遮挡春见柑橘的检测最精准。

在春见果园中,春见柑橘常以小尺寸且多遮挡的密集状态出现,对春见柑橘的精确检测有一定程度上的影响。因而最后选取测试集中密集状态下的春见柑橘目标进行测试,检测结果如图7密集结果图所示。由图7密集结果图,FR-YOLOv4检测到的春见柑橘数量最多,对密集状态下各种复杂遮挡的小尺寸春见柑橘检测精度最高。YOLOv4网络检测数量低于FR-YOLOv4,高于SSD、CenterNet、Faster R-CNN这3种目标检测网络模型,仅对轻遮挡目标有较好的检测效果。

经完整测试后,对上述5个目标检测网络检测春见柑橘目标的准确率、召回率、平均精度均值mAP、视频处理帧率进行统计。由表3可知,本研究提出的FR-YOLOv4网络模型,对实际果园环境中的春见柑橘目标检测精度最高,分别高于YOLOv4、SSD、CenterNet、Faster R-CNN网络模型8.9、29.3、14.1、16.2个百分点。在检测实时性上,由于RFP网络会增加计算时间,因而FR-YOLOv4网络模型分别比YOLOv4网络模型、CenterNet网络模型降低了6和11帧/s,分别比SSD网络模型、Faster R-CNN网络模型提高了17和33帧/s。对于春见柑橘目标检测与计数任务,51帧/s的处理速度足以保证任务的实时性检测。综上所述,基于特征递归融合YOLOv4网络模型(FR-YOLOv4)的春见柑橘检测方法,是一种精度高、处理速度快的目标检测方法。

表3 不同网络模型识别春见柑橘的结果对比

4 结 论

1)本研究针对实际春见果园环境中春见柑橘检测与计数提出了一种特征递归融合YOLOv4网络模型(YOLOv4 network model based on recursive fusion of feature,FR-YOLOv4),该网络模型具有较高的准确率,试验结果表明,模型平均精度均值达到了94.6%,平均检测速度达到了51帧/s。

2)针对春见果园中出现的春见柑橘目标特点,本研究对YOLOv4网络模型结构做出改进,首先将主干特征提取网络换为CSPResNext50网络,降低了原始主干特征网络的感受野,提高了小目标检测精度;然后将路径聚合网络(Path Aggregation Network,PANet)换为递归特征金字塔(Recursive Feature Pyramid,RFP),提高了网络对具有密集遮挡的小尺寸春见柑橘的检测精度。

3)对实际果园环境下的春见柑橘检测测试中,本研究所提出的FR-YOLOv4网络模型是一种精度高、处理速度快的目标检测网络模型。平均检测率高于改进前YOLOv4目标检测网络8.9个百分点,分别高于单次多框检测器(Single Shot Multi-Box Detector,SSD)、CenterNet、更快速卷积神经网络(Faster Region-Convolutional Neural Networks,Faster R-CNN)29.3、14.1、16.2个百分点。对于检测速度,FR-YOLOv4网络的帧率为51帧/s,分别比SSD网络模型、Faster R-CNN网络模型快了17和33帧/s,满足实际春见果园环境下对春见柑橘的检测与计数要求。

[1] 钟德民. 高糖型柑桔新品种“春见”的生物学特性与栽培要点初报[J]. 中国南方果树,2005,34(5):6-7.

Zhong Demin. Preliminary report on biological characteristics and cultivation key points of a new citrus variety “Chunjian” with high sugar content[J]. Fruit Science in South China, 2005, 34(5): 6-7. (in Chinese with English abstract)

[2] 林媚,姚周麟,王天玉,等. 8个杂交柑橘品种的糖酸组分含量及特征研究[J]. 果树学报,2021,38(2):202-211.

Lin Mei, Yao Zhoulin, Wang Tianyu, et al. Study on the content and characteristics of sugar and acid components in 8 hybrid citrus cultivars[J]. Journal of Fruit Science, 2021, 38(2): 202-211. (in Chinese with English abstract)

[3] Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Colombia: IEEE, 2014.

[4] Ren S Q, He K M, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[C]//Advances in Neural Information Processing Systems, Montreal: NIPS Foundation, 2015: 91-99.

[5] Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector[C]//European Conference on Computer Vision, Amsterdam: Springer, 2016.

[6] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas: IEEE, 2016.

[7] Duan K W, Bai S, Xie L X, et al. CenterNet: Keypoint triplets for object detection[C]//Proceedings of the IEEE International Conference on Computer Vision, Seoul: IEEE, 2019.

[8] 薛月菊,黄宁,涂淑琴,等. 未成熟芒果的改进 YOLOv2 识别方法[J]. 农业工程学报,2018,34(7):173-179.

Xue Yueju, Huang Ning, Tu Shuqin, et al. Improved YOLOv2 identification method for immature mango[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(7): 173-179. (in Chinese with English abstract)

[9] 武星,齐泽宇,王龙军,等. 基于轻量化YOLOv3卷积神经网络的苹果检测方法[J]. 农业机械学报,2020,51(8):17-25.

Wu Xing, Qi Zeyu, Wang Longjun, et al. Apple detection method based on lightweight YOLOv3 convolutional neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(8): 17-25. (in Chinese with English abstract)

[10] 吕石磊,卢思华,李震,等. 基于改进YOLOv3-LITE轻量级神经网络的柑橘识别方法[J]. 农业工程学报,2019,35(17):205-214.

Lü Shilei, Lu Sihua, Li Zhen, et al. Citrus recognition method based on improved YOLOv3-LITE lightweight neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(17): 205-214. (in Chinese with English abstract)

[11] 李善军,胡定一,高淑敏,等. 基于改进SSD的柑橘实时分类检测[J]. 农业工程学报,2019,35(24):307-313.

Li Shanjun, Hu Dingyi, Gao Shumin, et al. Real-time classification and detection of citrus based on improved SSD[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(24): 307-313. (in Chinese with English abstract)

[12] 张领先,陈运强,李云霞,等. 基于卷积神经网络的冬小麦麦穗检测计数系统[J]. 农业机械学报,2019,50(3):144-150.

Zhang Lingxian, Chen Yunqiang, Li Yunxia, et al. Convolutional neural network based winter wheat spike detection and counting system[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(3): 144-150. (in Chinese with English abstract)

[13] 鲍文霞,张鑫,胡根生,等. 基于深度卷积神经网络的田间麦穗密度估计及计数[J]. 农业工程学报,2020,36(21):186-193.

Bao Wenxia, Zhang Xin, Hu Gensheng, et al. Estimation and counting of field wheat ear density based on deep convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(21): 186-193. (in Chinese with English abstract)

[14] Yu Y, Zhang K L, Yang Li, et al. Fruit detection for strawberry harvesting robot in non-structural environment based on Mask-RCNN[J]. Computers and Electronics in Agriculture, 2019, 163(32): 104846.

[15] Tian Y, Yang G, Wang Z, et al. Apple detection during different growth stages in orchards using the improved YOLO-V3 model[J]. Computers and Electronics in Agriculture, 2019, 157(15): 417-426.

[16] Anami B S, Malvade N N, Palaiah S. Deep learning approach for recognition and classification of yield affecting paddy crop stresses using field images[J]. Artificial Intelligence in Agriculture, 2020, 4(24): 12-20.

[17] Neupane B, Horanont T, Hung N D. Deep learning based banana plant detection and counting using high-resolution Red-Green-Blue (RGB) images collected from Unmanned Aerial Vehicle (UAV)[J/OL]. PloS one, 2019, 14(10), [2019-10-17], https://doi.org/10.1371/journal.pone.0223906.

[18] Khaki S, Pham H, Han Y, et al. Convolutional neural networks for image-based corn kernel detection and counting[J]. Sensors, 2020, 20(9): 2721.

[19] Häni N, Roy P, Isler V. A comparative study of fruit detection and counting methods for yield mapping in apple orchards[J]. Journal of Field Robotics, 2020, 37(2): 263-282.

[20] Afonso M, Fonteijn H, Fiorentin F S, et al. Tomato fruit detection and counting in greenhouses using deep learning[J]. Frontiers in Plant Science, 2020, 11: 1759.

[21] Rahnemoonfar M, Sheppard C. Deep count: Fruit counting based on deep simulated learning[J]. Sensors, 2017, 17(4): 905.

[22] Qureshi W S, Payne A, Walsh K B, et al. Machine vision for counting fruit on mango tree canopies[J]. Precision Agriculture, 2017, 18(2): 224-244.

[23] 黄豪杰,段先华,黄欣辰. 基于深度学习水果检测的研究与改进[J]. 计算机工程与应用,2020,56(3):127-133.

Huang Haojie, Duan Xianhua, Huang Xinchen. Research and improvement of fruit detection based on deep learning[J]. Computer Engineering and Applications, 2020, 56(3): 127-133. (in Chinese with English abstract)

[24] Wu D, Lv S, Jiang M, et al. Using channel pruning-based YOLO v4 deep learning algorithm for the real-time and accurate detection of apple flowers in natural environments[J]. Computers and Electronics in Agriculture, 2020, 178: 105742.

[25] Wang C Y, Liao H Y M, Wu Y H, et al. CSPNet: A new backbone that can enhance learning capability of CNN[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Seattle: IEEE, 2020.

[26] Qiao S, Chen L C, Yuille A. Detectors: Detecting objects with recursive feature pyramid and switchable atrous convolution[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Kuala Lumpur, Malaysia: IEEE, 2021.

[27] Bochkovskiy A, Wang C Y, Liao H Y M. Yolov4: Optimal speed and accuracy of object detection[J/OL]. Computer Science, (2020)[2021-3-17]. https://arxiv.org/abs/2004. 10934.

[28] Wang K X, Liew J H, Zou Y T, et al. Panet: Few-shot image semantic segmentation with prototype alignment[C]// Proceedings of the IEEE International Conference on Computer Vision, Seoul: IEEE, 2019.

[29] Zheng Z H, Wang Ping, Liu Wei, et al. Distance-IoU Loss: Faster and Better Learning for Bounding Box Regression[C]// Proceedings of the AAAI Conference on Artificial Intelligence. A Virtual, Online-only Conference: AAAI, 2020.

[30] He K M, Zhang X Y, Ren S Q, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.

[31] Lin T Y, Dollár P, Girshick R, et al. Feature pyramid networks for object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Hawaii: IEEE, 2017.

[32] Xie S N, Girshick R, Dollár P, et al. Aggregated residual transformations for deep neural networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Hawaii: IEEE, 2017.

[33] Wang C Y, Bochkovskiy A, Liao H Y M. Scaled-yolov4: Scaling cross stage partial network[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Kuala Lumpur, Malaysia: IEEE, 2021.

[34] Bottou L. Stochastic Gradient Descent Tricks[M]. Berlin: Springer, 2012.

Detecting and counting of spring-see citrus using YOLOv4 network model and recursive fusion of features

Yi Shi1,2, Li Junjie1, Zhang Peng1, Wang Dandan1

(1.,,610059,; 2.,,,400065,)

Automatic fruit picking has widely been popular for the intelligent estimation of orchard economic harvest in the field of smart agriculture. Object detection using deep learning has presented broad application prospects for spring-see citrus detection and counting. But, it is still a very challenging task to detect and count spring-see fruits, due mainly to the small size of spring-see citrus, the high density of fruit on a single spring-see tree, the similar shape and color of fruits, and the tendency to be heavily shaded by foliage. In this study, a YOLOv4 network model was proposed using a recursive fusion of features (FR-YOLOv4) for spring-see citrus detection. CSPResNext50 network with a smaller receptive field was also selected to detect small targets with higher accuracy. As such, the feature extraction in the original YOLOv4 object detection network model was replaced with the CSPResNext50 network, particularly for the small size of spring-see citrus. Therefore, the difficulty was reduced to greatly improve the detection accuracy of small-scale spring-see citrus, where the feature map of small-scale objects was easily transmitted to the object detector. In addition, the Recursive Feature Pyramid (RFP) network was used to replace the original YOLOv4 Path Aggregation Network (PANet), because of the fuzzy and dense distribution of spring-seeing citrus. Correspondingly, RFP networks significantly enhanced the feature extraction and characterization capabilities of the entire YOLOv4 network at a small computational cost. More importantly, the detection accuracy of the YOLOv4 network was improved for spring-see citrus in a real orchard environment. Additionally, a dataset was collected using images and videos of spring-see citrus captured in various environments in spring-see orchards. Subsequently, three data augmentation operations were performed using OpenCV tools to add Gaussian noise, luminance variation and rotation. The dataset was obtained with a total of 3 600 images, of which the training dataset consisted of 2 520 images and the test dataset consisted of 1 080 images. The experimental results on this test dataset showed that the average detection accuracy of FR-YOLOv4 was 94.6% for spring-see citrus in complex orchard environments, and the frame rate of video detection was 51 frames/s. Specifically, the average detection accuracy increased by 8.9 percentage points, whereas, the frame rate of video detection was only 6 frames/s lower, compared with YOLOv4 before the improvement. Consequently, the FR-YOLOv4 presented an average detection accuracy of 29.3, 14.1, and 16.2 percentages higher than that of Single Shot Multi-Box Detector (SSD), CenterNet, and Faster Region-Convolutional Neural Networks (Faster-RCNN), respectively. The frame rate of video detection was 17 and 33 frames/s higher than SSD and Faster-RCNN, respectively. Anyway, the YOLOv4 network model using a recursive fusion of features (FR-YOLOv4) can widely be expected to detect and count spring citrus suitable for actual complex environments in orchards, indicating a higher detection accuracy with real-time performance.

machine vision; image processing; models; detection; spring-see citrus; YOLOv4

易诗,李俊杰,张鹏,等. 基于特征递归融合YOLOv4网络模型的春见柑橘检测与计数[J]. 农业工程学报,2021,37(18):161-169.doi:10.11975/j.issn.1002-6819.2021.18.019 http://www.tcsae.org

Yi Shi, Li Junjie, Zhang Peng, et al. Detecting and counting of spring-see citrus using YOLOv4 network model and recursive fusion of features[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(18): 161-169. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.18.019 http://www.tcsae.org

2021-02-22

2021-04-02

国家自然科学基金项目(61771096);成都理工大学2020年研究生质量工程教育教学改革项目(人工智能图像处理可视化综合实验平台建设);工业物联网与网络化控制教育部重点实验室开放基金(2020FF06)

易诗,高级实验师,研究方向为人工智能、红外图像处理、信号处理、嵌入式系统开发。Email:549745481@qq.com

10.11975/j.issn.1002-6819.2021.18.019

S126

A

1002-6819(2021)-18-0161-09