基于强化学习的电力系统应急物资仓储控制算法

俞虹,程文美,代洲,王钧泽,徐一蝶

摘 要:在人工智能飞速发展的启发下,智能库存控制和调度系统被认为是电力系统稳定性的一个有效的解决方案。提出了一种“端到端”强化学习方法,用于联合优化库存控制和应急电源交付策略,以平衡维护成本和电力系统稳定性。所提出算法为“端到端”算法,算法不预测需求,直接做出库存控制和调度决策;所提出的算法为“在线”算法,即库存控制和调度决策仅依赖于对过去事件的观察;所提出的算法也是“无模型”算法,即算法不依赖于任何假定的不确定事件随机模型。通过利用真实数据进行数值模拟,表明所提出的“端到端”强化算法平均比有代表性的基准算法在性能上高出138.5%。

关键词:仓储系统;调度系统;电力系统;强化学习;人工智能

中图分类号:TM711 文献标识码:A 文章编号:1001-5922(2021)11-0173-06

Reinforcement Learning Based Storage Control Algorithm for Emergency Materials in Power System

Yu Hong1, Cheng Wenmei2, Dai Zhou2, Wang Junze2, Xu Yidie3

(1. Guiyang Power Supply Bureau of Guizhou Power Grid Co., Ltd., Guiyang 550001, China;

2. Southern Power Grid Materials Co., Ltd., Guangzhou 510620, China; 3. Guiyang Xiuwen Power Supply Bureau of Guizhou Power Grid Co., Ltd., Guiyang 550200, China)

Abstract:Inspired by the rapid development of artificial intelligence, the intelligent inventory control and scheduling system is considered as an effective solution for the stability of the power system. This paper proposes an "end-to-end" reinforcement learning approach to jointly optimize inventory control and emergency power delivery strategies to balance maintenance costs and power system stability. The proposed algorithm is an "end-to-end" algorithm, which does not predict demand and directly makes inventory control and scheduling decisions. The proposed algorithm is the "online" algorithm, where inventory control and scheduling decisions rely only on observations of past events. The proposed algorithm is also a "model-free" algorithm, where the algorithm does not rely on any putative stochastic model of uncertain events. By using numerical simulations using real data, it is showed that the proposed "end-to-end" reinforcement algorithm achieves on average 138.5% higher performance than the representative benchmark algorithm.representative benchmark algorithm.

Key words:storage system; dispatching system; power system; intensive learning; artificial intelligence

0 引言

在當今庞大的电力系统下,稳定性是系统最基本的要求之一。电力的系统性稳定受到应急物资供应链应急响应,也就是应急物资的响应时间的影响[1-2]。不同位置的不同应急物资存在需求互补、相互扶持的特性,局部的需求可能波动较大,但是大范围内的需求波动相对较小,因而统筹仓储和共享补给的可调度性更强,能够更好保持电力系统的稳定性。 区域联合的电力系统仓储控制与调度系统有助于实现对大区域电力系统仓储系统的监视和控制,有助于电力系统调度部门从整体上调整调度的计划,从而保证电能质量[3],减少备用容量[4],降低运行的成本,减轻自然灾害、器件老化对电力系统造成的影响[5],从而保证电网经济运行。电力系统仓储系统的控制方法可以分为两类。

(1)统计优化法[6-8]。根据统计规律,建模各种紧急需求的分布,通过中心化的数学建模,计算出统计上平均最优的仓储分布。但该方法对于区域内所有的需求分布需要有完备的统计,同时每次发生状态转移,紧急事件,都需要重新计算最优分布,计算资源消耗大,响应较慢,具有一定的局限性。

(2)数据预测法[9-10]。基于每个区域内的数据分析和挖掘的思想,利用人工智能与机器学习方法,将每个区域的不同需求构建时间序列模型(sequence-to-sequence model),从而进行时间序列的预测;然后在预测的基础上,中心化的对于仓储系统和调度进行布局与优化。

数据预测法的先决条件是将自然时间转换成数据,即特征提取和特征选取。传统的特征选取通常基于特征排序法,根据计算出的各个特征的重要性与相关性,并取前k个特征作为需求预测的输入。这种方法最大的缺点在于选取k个重要性与相关性最大的特征并不能很好的代表系统的全局信息,从而就不能为预测系统提供最丰富的信息。 同时,由于预测的结果并非最终的结果,根据预测结果我们将进行二次计算,得出调度与控制方案,多步骤的框架会使得错误累计,导致最终结果的偏差。 此外,由于区域与区域之间,存在需求的相关性以及互补性,仅仅考虑单一区域的历史数据,往往很难准确预测未来需求[11],也无法利用区域之间的互补性[12]。

为了解决错误累加以及实现不同区域之间的联动,本文提出了一种基于马科夫决策过程和强化学习的电力系统仓储系统控制与调度算法,并基于贵州省贵阳市附近的15个区(县)2016年1月1日至2019年12月31日的应急物资需求数据,进行算法验证。实验表明,本文提出的算法不仅能提高电力系统的收益,同时具有很快的收敛率,能够及时适应环境变化。

本文的主要贡献有3点:①提出利用马科夫随机过程和强化学习求解电力系统应急物资的联合仓储控制和调度问题;②提出的算法为“端到端”算法,算法不预测需求,直接做出库存控制和调度决策;所提出的算法是“在线”算法,即库存控制和调度决策仅依赖于对过去事件的观察;所提出的算法也是“无模型”算法,不依赖于任何假定的不确定事件随机模型;③利用贵州省贵阳市的真实数据,很好的验证了提出算法的收益率和收敛性,证明了本文提出算法的可用性与实践价值。

1 应急物资仓储系统建模

1.1 问题说明与建模

基于需求特性的库存控制模型主要包括确定性和随机性两个方面的需求。其中,确定性需求通常包括常数需求和时变需求等,如日常物资、应急物资等,生产单一物品,需求量为常数且连续均匀;不允许缺货(缺货成本为无穷大);生产需要一定时间,全部生产完毕一次交付等等。随机性需求涵盖的更多,通常有线性分布、正态分布、泊松分布和指数分布以及任意分布等,达到网上商城零仓储、应急物资少仓储和重大灾害协同仓储的目标[13-14]。

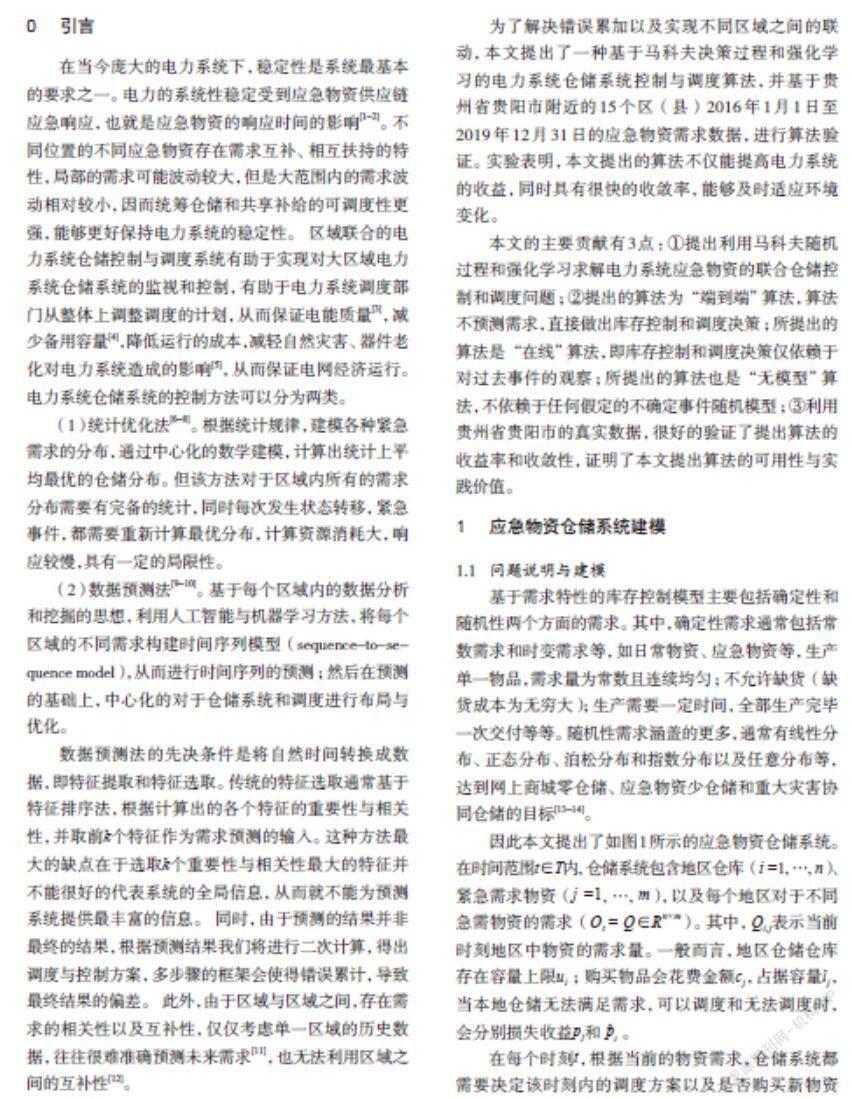

因此本文提出了如图1所示的应急物资仓储系统。在时间范围t∈T内, 仓储系统包含地区仓库(i =1, …, n)、紧急需求物资(j =1, …, m),以及每个地区对于不同急需物资的需求(Ot = Q∈Rn×m)。其中,Qi,j表示当前时刻地区中物资的需求量。一般而言,地区仓储仓库存在容量上限ui; 购买物品会花费金额cj,占据容量lj,当本地仓储无法满足需求,可以调度和无法調度时,会分别损失收益pj和。

在每个时刻t,根据当前的物资需求,仓储系统都需要决定该时刻内的调度方案以及是否购买新物资进行仓储。该决策将会影响每个仓库的仓储情况,进而影响未来的调度和购买决策。因此,最优化调度决策可视为一个马可夫决策过程 (Markov Decision Process, MDP)。本文首先定义了仓储MDP问题中的状态(State)、决策(Action)和奖励函数(Reward Function)。

(1)状态:当前时刻的状态可以描述为每个仓库所储存的物资St = Z∈Rn×m。其中,Zi, j表示当前时刻仓库i中物资 j 的数量。

(2)决策:根据当前状态St∈Rn×m和需求Q∈Rn×m,仓储系统决定该时刻的调度方案X和采购方案B。其中,Xi,j和Bi,j分别表示当前时刻仓库 i 中物资 j 的出库数量和购买数量。

(3)状态转移方程:当仓储系统决定调度和采购方案之后,在下一时刻,仓储状态随机发生状态转移。数学上,表示为:

由于仓储物资无法为负数,同时仓储空间总是有限的,因此有效决策(X, B)必须满足以下不等式:

(4)奖励函数:仓储系统主要目标为满足地区内和地区间的紧急物资需求问题,因此奖励函数为当前时刻的损失收益减去购买物资花费:

其中,符号(x)-为:

因此,在时刻t,仓储系统将试图求解以下MDP问题,来获得最优的调度策略和采购存储方案:

其中γ∈[0, 1)为衰减因子(Discount Factor)。

1.2 马科夫随机过程分析与建模

如果物资需求Ot的分布确定,以上问题可以用基于蒙特卡洛抽样方法(Monte Carlo Sampling Techniques Methods)的抽样平均近似方法(Sample Average Approximation) 等经典方法解决。然而在实际生产生活中,需求Ot的分布在实际问题中通常难以确定,我们将上述贝尔曼公示 (Bellman Equation) 转换成数据驱动在线更新的形式(为时刻t的学习率):

然后,我们可以采用基于强化学习的算法,求解上述问题。特别地,为了在探索与开发之间取得平衡,我们采取ε贪婪策略,即充电站在1-ε的概率下采取当前最佳动作将V(St)最大化;在ε的概率下,随机选择动作。如式(7)所示:

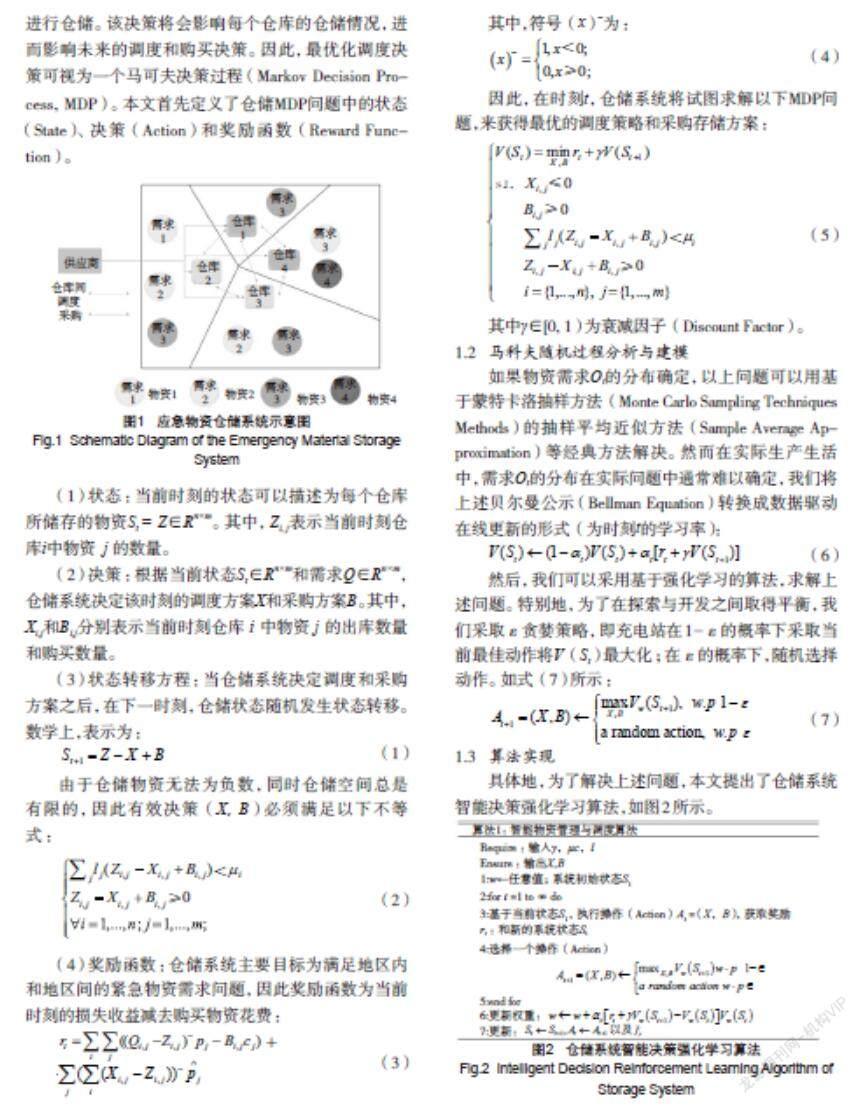

1.3 算法实现

具体地,为了解决上述问题,本文提出了仓储系统智能决策强化学习算法,如图2所示。

其中w和Vw(S)分别为强化学习的参数和当前参数下强化学习拟合的状态方程。不失一般性,文章将αt设为式(8)以此来保证所提出的算法的收敛性[15]。

本文在下一实验中验证了该算法的收敛性。

2 实验结果

本文将所提出的仓储系统智能决策强化学习算法运用到实际数据中,并对所提出的算法进行效果验证。不失一般性的,在所有的实验中我们设定γ=0.95和默认仓库储存上限为10;所有展示的数值均为100次实验的平均值;所有的实验均实现于搭载Intel Xeon E5-2630 CPU,NVidia GTX 1080 GPU和64GB内存的主机上,具有较强的普适性和实用价值。

2.1 数据说明

为了验证所提出算法的实用性,本文收集了贵州省贵阳市管辖或者周边的15个地区:白云、城北、花溪、惠水、金阳、开阳、龙里、南明、清镇、双龙、乌当、息烽、小河、修文、云岩的应急物资需求,贵阳市周围的区县区域分布如图3所示,数据时间段为2016年1月至2019年12月。

2.2 收敛性

本文首先对算法的收敛性进行了验证,以展示所提出的仓储系统智能决策强化学习算法的平均收益随迭代周期(epoch)的变化。如图4所示,在前25个迭代周期中,平均收益快速的增长并收敛到了一个稳定值;同时,在第26至200个迭代周期中,平均收益稳定在固定的区间并随着环境的变化稍小震荡。这表明了所提出的仓储系统智能决策强化学习算法能快速的学习物资需求和仓储系统之间的关系,实现仓储消耗和需求满足之间的平衡。

2.3 收益对比

目前贪婪算法(Greedy Policy)是业界常见的仿真基准(Benchmark)[16]。在贪婪算法中,仓储系统的采购和调度决策都基于假设未来短时间内无新的紧急需求。因此,采购和调度的决策变成了确定性最优化(Deterministic Optimization)问题求解。本文对比了所提出的仓储系统智能决策强化学习算法和贪婪策略在不同仓储容量下的收益情况,如图5所示,其中平均收益为30 d内的平均值。

由图5可知,不管是贪婪策略还是本文提出的仓储系统智能决策强化学习算法,平均收益均会随着仓储容量的增加而增加。同时,仓储系统智能决策强化学习算法对比贪婪策略的增益也会随着仓储容量的增加而增加,这表明所提出的算法是可缩放的。

此外,本文还展示对比所提出的仓储系统智能决策强化学习算法在不同仓储容量下和不同衰减因子下的收益情况。图6中所展示的数据是100次随机初始状态下的平均收益。对于所有不同的衰减系数, 所有收益均随着仓储容量的增加而增加。同时,越大的衰减系数会导致越高的平均收益,这是因为当衰减系数越大时,算法的全局视野更宽,能够更好的平衡当前的收益和未来的收益。

2.4 可伸缩性

本文进一步展示了所提出的仓储系统智能决策强化学习算法运算时间随着仓库仓储容量变化而发生的变化。

表1中所展示的数据是100次随机初始状态下的平均单次决策运算时间。对于不同的衰减系数,所有运算时间都随着仓储容量的增加而增加,但是增加的速度却越来越慢,这是因为随着仓储容量的增加,系统的决策空间几何的增长了,但是本算法的运算只有在局部发生了增加,这证明了本文所提出的算法是具有可伸縮性的,可以适用于不同场景大小下的电力系统仓储调度。同时,计算时间随着衰减系数的减少而轻微的减少,这是因为随着目标更着眼于当前,算法能更快的收敛,减少探索的过程,提高运算的效率。

因此如表1所示,本文提出的算法是节省计算资源、具有可伸缩性的高效算法,可以适应海量的电力系统仓储调度需求。

3 结语

本文提出了无模型假设数据驱动的仓储系统智能决策强化学习算法来解决电力系统紧急物资仓储控制与调度问题。所提出的算法平衡了采购物资的费用和紧急需求满足之间的平衡,最大化了电力系统仓储系统的收益。由于不需要对紧急物资的需求分布进行假设和建模,本文提出的算法是无模型假设的一般性算法,可以迁移至不同城市不同大小的仓储系统。 特别地,本文将仓储系统调度问题建模为马科夫随机过程(MDP)问题,并通过提出基于强化学习算法(Q-learning based method)进行求解。通过基于实际电力系统数据下的多重实验,验证了所提出的强化学习算法不仅具有良好的收益表现,相比基本的贪婪算法有超过138.5%的收益,而且收敛率快,可以随时应对需求的变化。

参考文献

[1]GOUVEIA J,MOREIRA C L,LOPES J A P. Grid-forming inverters sizing in islanded power systems a stability perspective[C]. International Conference on Smart Energy Systems and Technologies(SEST),2019:1-6.

[2]BI Jingtian,SUN Huadong ,XU Shiyun,et al. Impact of multiple identical grid-connected DFIGs on the small-signal angular stability of power system[C]. Chinese Control Conference(CCC),2019.

[3]TESHAGER B G,MINXIAO H,PATROBERS S,et al. Direct power control strategy based variable speed pumped storage system for the reduction of the wind power fluctuation impact on the grid stability[C]. 2018 IEEE 12th International Conference on Compatibility, Power Electronics and Power Engineering (CPE-POWERENG 2018),2018:1-6.

[4]HUANG Y,WU H,WEI R,et al. Research on multi-objective power emergency supplies dispatch model considering material and time satisfaction[C]. China International Conference on Electricity Distribution (CICED),2018:901-905.

[5]H RUI,G ZHAOLI,X MINGKAI,et al. Research on fault emergency strategy for substation DC system[C]. International Conference on Advanced Mechatronic Systems(ICAMechS),2018:27-30.

[6]J ZHANG,F JIANG,Y ZHAO,et al. An improved hierarchical and decentralized control strategy for emergency power supply during disaster[C]. International Conference on Power System Technology(POWERCON),2018:3 485-3 490.

[7]CHEN DA-HENG HU GONG A. Schedule on the relief supplies with transportation models in emergency logistics[C]. 35th Chinese Control Conference(CCC),2016.

[8]H WU, J LIU .A Multi-agent genetic algorithm based on natural coding for emergency resources scheduling problems[C]. IEEE Congress on Evolutionary Computation (CEC),2016:2706-2711.

[9]SHI Xiaofeng,WANG Minzhen,WU Zhiwei,et al. Optimization research on vehicle scheduling path for emergency repairs of power transmission lines[C]. Proceedings of 2019 International Conference on Intelligent Transportation,Big Data & Smart City(ICITBS 2019),2019.

[10]TANG Weiqin,LIU Tenghong,ZHANG Min,et al. Scheduling of commodities from multirescuing points to multi-demand points in large-scale emergencies[C]. Proceedings of 2010 IEEE International Conference on Emergency Management and Management Sciences(ICEMMS2010),2010.

[11]C CHUN-GUANG,C DONGWEN,W LI-JIE,et al. Study on multi-destination emergency scheduling model under dynamic continuous consumption[C]. International Conference on Logistics Systems and Intelligent Management(ICLSIM),2010.

[12]MIZUNO Y,TANAKA Y, KUROKAWA F, et al. A new approach of optimum energy scheduling of emergency generators using linear programing in a large hospital[C]. IEEE International Conference on Renewable Energy Research and Applications(ICRERA),2016.

[13]XIONG Yan,ZHENG Liqun,WANG Jie. Scheduling model for the satisfaction of emergency material on huband-spoke network [C]. The 27th Chinese Control and Decision Conference (2015 CCDC),2015.

[14]LIU Tongjuan, DUAN Yanlin. Application of cloud computing in the emergency scheduling architecture of the Internet of Things[C]. Proceedings of 2015 IEEE 6th International Conference on Software Engineering and Service Science(ICSESS 2015),2015.

[15]LUCIAN BUSONIU,ROBERT BABUSKA,Bart De Schutter,et al. Reinforcement learning and dynamic programming using function approximators[M]. CRC press,2010.

[16]S.WANG,S.BI,Y. J. Angela Zhang, “Reinforcement Learning for Real-time Pricing and Scheduling Control in EV Charging Stations,”in IEEE Transactions on Industrial Informatics, 2019.