联合YOLOv4检测的候选框选择和目标跟踪方法

李福进,黄志伟,史涛,任红格

(华北理工大学 电气工程学院,河北 唐山063200)

0 引言

近年来,随着人工智能技术的快速发展,目标跟踪已经成为计算机视觉领域研究热点之一,而自动驾驶、视频监控、人机交互等的研究使得目标跟踪更受关注。由于在目标跟踪中存在着目标形态、尺度变化以及环境、光照、遮挡等因素的影响,为研究增加了难度。从经典Meanshift算法、Camshift算法等,到基于相关滤波(Correlation Filter)跟踪方法再到基于检测的跟踪(Detection-based Tracking,DBT)方法,目标跟踪方法研究一直在进步。在基于目标检测的跟踪算法中,将任务分解为两个步骤简化跟踪任务:在视频每一帧中独立地检测目标位置;通过跨时间连接相应的检测形成轨迹,而在连接过程中,数据关联是一项具有挑战性的任务。

为此,本文提出一种融合YOLOv4检测算法的跟踪方法。利用YOLOv4检测结构进行分类和特征提取,形成检测数据集,并将检测和跟踪结果作为候选框,通过分类选择器选择最优的候选结果。本文还加入了基于外观向量身份重识别(ReID)算法提取深度外观特征,用于将跟踪轨迹和选定候选对象关联。

1 基本概念

当前的目标跟踪算法主流是DBT,所以检测质量对跟踪的性能影响很大。将深度学习检测分为两类:基于分类的R-CNN系列目标检测算法和将检测转换为回归的检测算法。前者首先通过Selective Search等算法产生候选 区域,代表算 法有R-CNN、Faster R-CNN、Mask RCNN等,此类算法检测精度较高,但是实时性难以满足需求;后者将检测作为一个回归问题处理,直接预测目标位置和分类,代表算法有YOLO(You Only Look Once)系列算法和SSD(Single Shot MultiBox Detector)算法等,此类算法速度快,但精度相对较低。为了实现实时跟踪要求,本文选用YOLOv4算法作为检测模块。

1.1 YOLOv4介绍

YOLOv4算法是YOLO系列检测算法的第4个版本,主要由CSPDarknet-53、SPP和PANet三部分组成,分别用于主干特征提取、尺度识别和分类。特征提取网络结构如图1所示。

图1 YOLOv4算法特征提取网络结构

首先将输入图像调整到416×416大小,使用类似特征金字塔网络(Feature Pyramid Network,FPN)结构,在CSPDarknet-53特征提取网络中将输入图像划分成×大小的单元格,得到三种不同尺度的特征图,即13×13,26×26,52×52,分别用于检测大、中、小三种目标,同时在每个单元格上的回归预测有3个anchor box预测三个边界框。选取其中置信度最大的作为最终检测结果。

1.2 身份重识别(ReID)结构

身份重识别(Re-identification,ReID),其定义是利用计算机视觉技术在图像库和视频序列中找到要搜索目标的技术,有学者将重识别看作是分类和验证两类问题:分类是指将目标的ID或特征作为训练标签来训练模型;验证是指输入图像对,让网络学习两张图像中目标是否相同。

用Rank1和mAP指标评价ReID算法,其主干结构为Resnet50,将图片输入经过卷积得到特征图谱,然后经池化层输出特征向量,最后识别最终结果。

2 目标跟踪模型

近年来,单目标跟踪领域取得了重大进展。像GOTURN、Siamese FC、ECO、Siamese RPN这样的跟踪器极大地提高了跟踪精度。但是,在线更新的目标跟踪器速度慢,同时占用大量的内存,而离线训练跟踪器如Siamese-RPN,以每秒超过80帧(目标)的速度达到最先进的精度。更重要的是,大多数方法没有将目标跟踪器生成的线索与其他线索结合起来,它们将跟踪器和数据关联过程分开。与此不同,本文提出一种联合YOLOv4检测算法的目标跟踪算法,由候选框选择和数据关联两部分组成。

本文设计了一个对象选择器,利用深度特征和轨迹置信度设计统一的评分函数来选择候选框。利用身份重识别ReID将候选信息和跟踪轨迹关联实现检测跟踪。

2.1 深度特征提取

检测过程中有多个候选框被选出,为了跟踪更精确,需要对候选框进行筛选。本文选用HSV颜色特征直方图和LBP局部特征直方图筛选候选框。最后利用非极大抑制确定跟踪目标。LBP特征提取方法如下:

式中:(,)为中心像素;i,分别是灰度值和相邻像素灰度值。

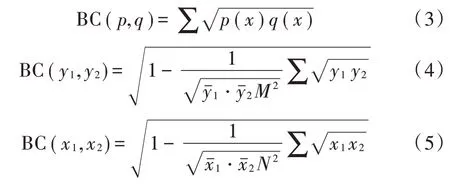

在进行边界框选择时,首先分类过程会过滤掉非目标候选框,剩余候选框根据目标的HSV颜色特征和LBP局部特征进行特征相似度计算。选取计算数值最大的作为筛选结果,计算过程设置权重比例为1∶2,相似度阈值为5和3。本文利用巴氏相关系数处理直方图特征,巴氏系数公式如下:

式中:,分别为图像在直方图上的中心坐标和概率密度。HSV颜色特征直方图和LBP局部特征直方图计算公式相似度分数为:

式中()=-ln;为候选框分数。

2.2 轨迹置信度

在视频序列给定帧的情况下,利用Kalman滤波预测每条轨迹的新位置,这些预测结果将被作为解决物体属性变化和在拥挤场景中遮挡而导致检测失败的方法。

利用Kalman滤波通过对连续的候选帧进行时间关联生成跟踪轨迹,可以把一个长期轨迹分割成一组短期轨迹,每一次从短期状态检索,卡尔曼滤波器将被重新初始化。置信度用来测量时域信息的滤波精度。仅利用最后一个轨迹的信息表示轨迹的置信度。

式中表示最后一个预测轨迹。将提取的深度特征和轨迹置信度融合,形成候选框的统一评分函数:

式中是Kronecker delta函数用于判断深度特征提取中某个检测候选框和轨迹候选框是否相等。在候选框选择中基于这个统一的评分,根据定义的最大交集(IOU)阈值和最小分数阈值使用非最大抑制确定最终候选框。

2.3 ReID数据关联

为了防止跟踪目标发生漂移,本文提出一种基于Siamese网络作为ReID主干的CNN方法,将得到的最优候选框与现有轨迹进行数据关联,使跟踪更加精确,关联结构如图2所示。

图2 ReID数据关联方法

对于跟踪目标,首先将轨迹每一帧看作一个独立节点,提取ReID特征,将距离小于给定阈值的两个节点进行连通,形成一个连通子图;然后计算候选框与连通子图的ReID特征相似度和mAP,将符合特征相似度高、mAP值大于阈值的图合并;最后把合并图在跟踪轨迹上进行插值修复更多的假阴跟踪。

2.4 融合检测的候选框选择算法结构

该方法提出的融合YOLOv4检测和ReID的目标跟踪方法结构如下:

输入:视频序列V

1.初始化,←,检 测集合←在视频序列每一帧中收集候选框

2.在每一帧中利用YOLOv4检测得到,在中利用Kalman收集筛选候选框

3.←⋃,由式(8)得出

4.,←NMS(,,)

5.过滤<数据关联

6.提 取的ReID特 征,提 取的ReID特征

7.计算与的平均特征距离和mAP

8.合并:←⋃

9.插值:←⋃

输出:跟踪轨迹

3 实验结果与仿真

本文实验设备CPU为i5-4509,GPU为GT705,该实验在Windows 7系统下利用Matlab进行开发,编程语言选用C语言。为了更好地展现跟踪性能,本实验利用tracker_benchmark_v1.0结合9种跟踪算法作为对比算法,且数据结果均已在各文献中公开发表。测试数据集为Object Tracking Benchmark(OTB)。

3.1 实验定量分析

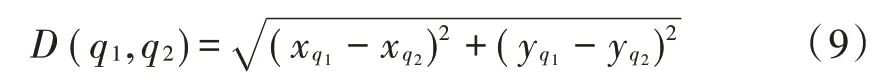

为了更好地衡量跟踪算法性能,本实验采用中心点误差和边界框重叠率(IOU)评价跟踪。中心点误差是指实际跟踪目标的中心点与跟踪框中心点之间的欧氏距离:

式中:(x,y)为跟踪框中心点坐标;(x,y)为实际目标中心点坐标。边界框重叠率是指跟踪结果与实际目标之间的交并比:

式中:area()为算法跟踪框面积;area()为实际面积。给定阈值,计算重叠率大于阈值的帧数量,本实验设定=0.6。10种对比算法在OTB100数据集中选取DragonBaby、Singer1、Jump、Walking2、CarScale、Matrix这6组序列图进行测试,其中包括了光照变化(IV)、尺度变化(SV)、物体遮挡(OCC)、形变(DEF)、运动模糊(MB)、旋转(PR)测试结果,选取5种性能较好的算法进行对比,如表1所示。

表1 中心点距离误差、重叠率、帧率对比

由表1可以看出,在进行中心点误差和边界框覆盖率对比中,本文提出的算法跟踪性能最优,这为跟踪的精确度提供了保证,并且能够适应多种复杂环境下的跟踪。同时,本文在OTB100多种复杂环境视频序列下与其他9种算法进行整体性能对比,跟踪精度和成功率如图3所示。

图3 十种算法跟踪性能对比曲线

可以看出,在不同干扰下本文算法性能整体优于其他9种算法,其中跟踪精度(Precision plots of OPE)达到84.9%,跟踪成功率(Success plots of OPE)为82.2%,并且在滤波器与ReID不同的情况下平均跟踪速度仍能达到29.369 6 f/s,可以满足算法对实时性的要求。

3.2 实验定性分析

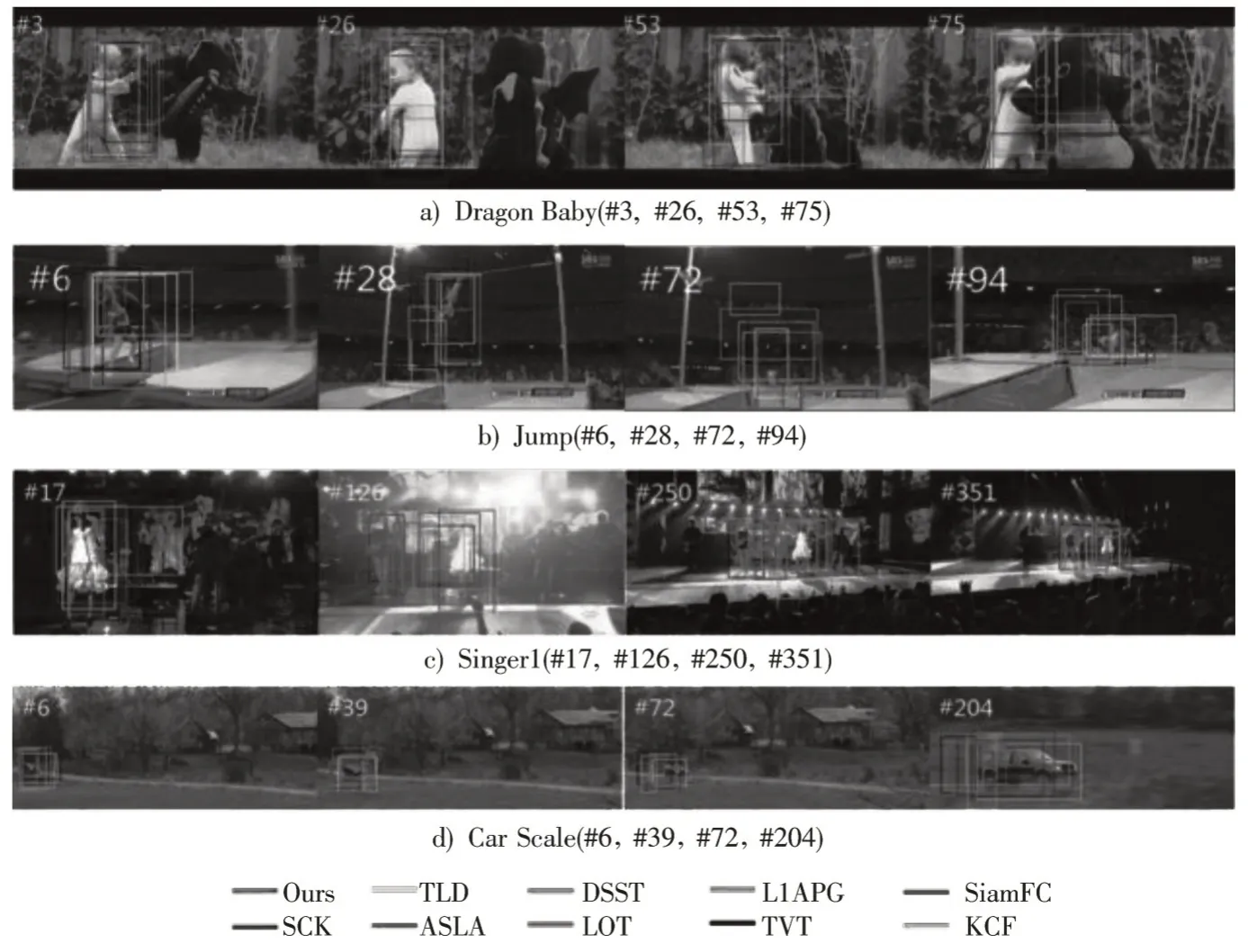

综合考虑实际跟踪中受到环境变化因素影响,该实验选取TOB100数据集中6组序列图进行测试。测试结果如图4所示,其中左上角“#”代表图所在帧。本文实验选用不同颜色的跟踪框区分多个算法的跟踪性能。

1)姿态变化

在序列图Dragon Baby中选取第3、26、53、75帧图,跟踪性能如图4a)所示。当跟踪目标如第3、26帧仅仅发生手臂变化,动作姿态变化较小,10个跟踪算法都能够准确跟踪目标;当目标姿态发生较大变化时,如第53帧腿部发生变化,只有TLD算法和本文提出的算法能够准确跟踪目标。

图4 Dragon Baby、Jump、Singer1、Car Scale序列跟踪结果

2)尺度变化

如图4d)所示,选取序列图中Car Scale作为跟踪目标,可以看出当跟踪目标发生不同尺度变化时各跟踪算法基本能够跟踪目标,但是存在不同程度的偏移。

3)旋转变化

图4b)是序列Jump的旋转跟踪,从图中可以看出,目标在完成起跳、旋转等一系列动作的过程中伴随着姿态的变化,所以跟踪难度加大,算法发生了不同程度偏移,而KCF算法直接丢失目标,只有本文算法精度较高。

4)光照变化

图4c)是对光照变化的跟踪,选取Singer1序列,可以看出,在第17帧时各算法可以满足要求,在第250帧时各算法不同程度丢失目标,只有本文算法可以满足要求。

综上所述,本文提出的目标跟踪算法在遇到姿态变化、遮挡、光照变化、运动状态等因素影响时,对比9种算法有了很大提升。

4 结语

本文选用YOLOv4为检测算法,同时在长期目标跟踪过程中加入了基于Siamese网络作为ReID主干的CNN子网,使得在长期跟踪过程中有效地解决了跟踪漂移现象。由于实验设备影响,本文提出的算法未达到预期效果。但是,本文提出的检测和轨迹连接的方法使得跟踪更加精确,有效地避免了目标跟踪过程中的假阴现象,结合的ReID算法也是现在的研究热点,这为以后研究目标跟踪提供了新思路。