支持多数不规则用户的隐私保护联邦学习框架

陈前昕,毕仁万,林劼,金彪,熊金波

支持多数不规则用户的隐私保护联邦学习框架

陈前昕1,2,毕仁万1,2,林劼1,金彪1,熊金波1,2

(1. 福建师范大学计算机与网络空间安全学院,福建 福州 350117;2. 福建师范大学福建省网络安全与密码技术重点实验室,福建 福州 350007)

针对联邦学习存在处理大多数不规则用户易引起聚合效率降低,以及采用明文通信导致参数隐私泄露的问题,基于设计的安全除法协议构建针对不规则用户鲁棒的隐私保护联邦学习框架。该框架通过将模型相关计算外包给两台边缘服务器以减小采用同态加密产生的高额计算开销,不仅允许模型及其相关信息以密文形式在边缘服务器上进行密文聚合,还支持用户在本地进行模型可靠性计算以减小传统方法采用安全乘法协议造成的额外通信开销。在该框架的基础上,为更精准评估模型的泛化性能,用户完成本地模型参数更新后,利用边缘服务器下发的验证集与本地持有的验证集联合计算模型损失值,并结合损失值历史信息动态更新模型可靠性以作为模型权重。进一步,在模型可靠性先验知识指导下进行模型权重缩放,将密文模型与密文权重信息交由边缘服务器对全局模型参数进行聚合更新,保证全局模型变化主要由高质量数据用户贡献,提高收敛速度。通过HybridArgument模型进行安全性分析,论证表明PPRFL(privacy-preserving robust federated learning)可以有效保护模型参数以及包括用户可靠性等中间交互参数的隐私。实验结果表明,当联邦聚合任务中的所有参与方均为不规则用户时,PPRFL方案准确率仍然能达到92%,收敛效率较PPFDL(privacy-preserving federated deep learning with irregular users)提高1.4倍;当联邦聚合任务中80%用户持有的训练数据都为噪声数据时,PPRFL方案准确率仍然能达到89%,收敛效率较PPFDL提高2.3倍。

联邦学习;隐私保护;安全聚合;大多数不规则用户;安全除法协议

0 引言

近年来,各类数据驱动的深度学习(DL,deep learning)系统性能获得大幅提升,人工智能实现了经济与公众效益的共赢[1]。然而,由第三方服务商收集用户数据将不可避免地导致个人隐私数据泄露[2]。为解决数据孤岛难题并实现数据隐私共享,联邦学习(FL,federated learning)技术应运而生[3-4]。尽管联邦学习能缓解公众对隐私泄露的担忧,但相关研究[5-6]表明,攻击者可以通过用户上传的明文梯度信息间接推理出用户本地部分数据集成员和对应标签的信息。此外,明文梯度有可能遭受模型反演、模型推理等攻击[7],导致数据隐私泄露。

针对联邦学习梯度逆推带来的新挑战,已有一些研究[8-9]聚焦于提升联邦学习的隐私性,并应用于各种场景[10-12]。在保证隐私性的同时,多种联邦学习方案进一步研究如何提高系统的训练效率。Kanagavelu等[13]为降低通信成本和提高可扩展性,提出一种支持安全多方计算的两阶段联邦学习方案。董业等[14]基于秘密共享技术和Top-K梯度选择算法,提出高效安全的联邦学习框架。Aono等[15]对梯度数据进行同态加密,保证多个训练者的本地数据隐私安全。文献[16]方案使用Paillier同态加密方法优化加密模型聚合过程。

然而,这些隐私保护联邦学习方案假设每个用户均持有高质量的数据,没有考虑系统中存在不规则用户的情况。实际上,拥有高级专业知识或高级设备的用户通常会生成高质量的数据,其他用户却可能由于噪声干扰、记录错误等产生低质量数据,这些用户称为不规则用户[17],他们上传的模型参数可能会对全局模型精度造成负面影响。

针对上述直接传输原始模型梯度导致模型隐私信息泄露以及大多数不规则用户存在导致现有联邦学习框架效率降低的严峻问题,本文提出一种支持大多数不规则用户鲁棒的隐私保护联邦学习(PPRFL,privacy-preserving robust federated learning)框架,主要贡献总结如下。

1)设计一种动态的模型可靠性更新策略,解决大多数不规则用户参与训练的精度提升缓慢问题,并基于可靠性先验知识指导模型权重缩放,实现全局模型聚合更新,保证全局模型变化主要由高质量数据用户贡献,进一步提高了联邦模型收敛的效率。

2)设计高效的安全除法协议,构建边缘服务器辅助的鲁棒隐私保护联邦学习框架PPRFL,规避上传和处理过程中的模型参数隐私泄露风险。

3)安全性详细证明PPRFL框架可以有效保护模型参数的隐私性。实验结果表明,当所有参与方都为不规则用户时,PPRFL方案的准确率仍可达92%,相比PPFDL方案,聚合效率提高1.4倍,并且服务器间的计算与通信开销较低。

1 预备知识

1.1 联邦学习

1.2 Paillier密码系统

2 系统模型与安全模型

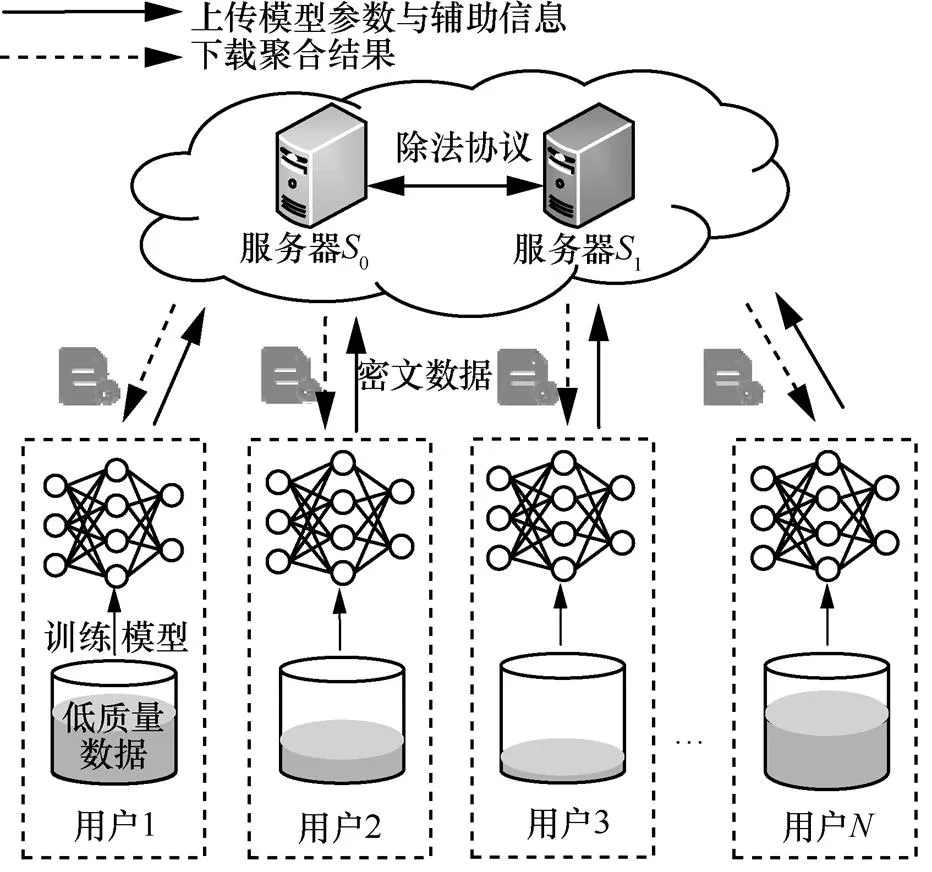

2.1 系统模型

图1 PPRFL方案系统模型

Figure 1 System model of the PPRFL scheme

2.2 安全模型

如同大多数外包计算场景的安全假设一样,两台服务器为不共谋的诚实但好奇服务器[20-22]。服务器能正确地执行协议规范和相应操作,但可能利用在协议期间收集到的存储信息和消息流中的数据来推测用户的隐私数据[29]。恶意用户通常会对图像进行标签翻转或植入Pattern实现投毒攻击。与恶意用户不同,不规则用户通常在生成和存储数据的过程中,由于记录错误、噪声数据干扰、使用陈旧数据等产生低质量数据。此外,用户会诚实地执行模型训练以及后续加密上传等操作,因此认为用户是可信的。

基于上述威胁模型,与文献[19,21]类似,本文有如下隐私需求。①用户模型参数。敌手可以通过本地模型和全局模型参数对用户进行成员推理等攻击恢复出用户的敏感信息,为保护用户数据隐私,模型参数应该以密文形式提交到服务器。②模型可靠性。模型可靠性可以认为是用户数据质量的评价,为使学习过程公平无歧视,这个信息应对除用户外的其他参与方保密。③模型聚合结果。全局模型的聚合结果可以视为用户使用大量数据资源生成的知识产权,除了参与训练的用户外应对其他参与方保密。

3 PPRFL方案

PPRFL包含用户端和服务器端两个部分,用户端上的参与方在本地训练得到局部模型,基于组合验证集计算损失值,并结合历史信息,采用动态更新以及权重缩放方式得到模型可靠性;在服务器端上,服务器收到加密参数后先利用加同态性质进行聚合,然后交互执行安全除法协议得到全局模型。参与联邦学习的用户有着相似的收集数据场景,类似于隐私保护联邦学习方案[11,15,30],本文考虑每个用户持有的高质量数据都满足独立同分布(IID,independent and identically distributed)。

3.1 模型可靠性更新

本节通过验证集损失分析来介绍处理大多数不规则用户的动态更新策略。在低质量数据集的联邦学习场景中,直接使用验证集损失值作为模型权重的计算方法将导致权重区分度失衡。这种失衡表现为经不同噪声比例数据训练出来的模型,在同一损失值下模型精度差异大;或是在相同的模型精度上,损失值差异大。基于以上观察,本文设计组合验证集计算用户模型损失值,并结合损失值历史信息辅助评估当前模型可靠性的动态更新方法。

算法1 PPRFL框架在用户端的执行算法

9) 进入下一轮迭代

3.2 模型聚合更新

本节介绍PPRFL框架在服务器端进行模型聚合更新的执行算法,具体步骤如下。

7) 返回1)进入下一轮迭代

其中安全除法协议的构造详见附录。

4 理论分析

4.1 安全性分析

证毕。

4.2 功能性分析

表1比较了SecProbe[17]、SAHPP[19]、PPFDL[21]以及本文PPRFL框架的功能性,4种方案均能保护用户上传的模型参数信息。运行在半可信服务器环境下的SecProbe需要在线评估模型效用并进行模型聚合,这会造成可靠性隐私和聚合模型参数隐私泄露的问题,并且SecProbe采用的差分隐私方法不支持用户中途退出。SAHPP、PPFDL以及本文方案采用同态加密体系,对中间过程参数和聚合结果都进行保护,服务器无法得知用户可靠性和聚合参数结果。此外,SecProbe、SAHPP和PPFDL在设计之初考虑的是低质量数据不超过全局总数据量一半的情况,在噪声数据占比过多时将造成聚合效率降低的问题。而本文的PPRFL框架依托组合验证集上的损失值,并采用动态更新和缩放方式计算模型可靠性,使本文方案在大多数不规则用户环境下仍能保持较高的模型收敛效率。

表1 不同方案的功能性比较

注:“√”表示满足对应功能,“×”表示不满足。

5 性能分析

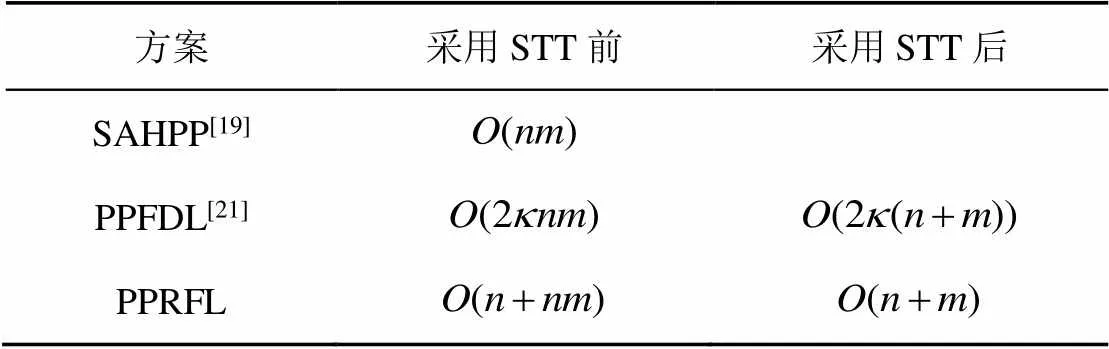

在功能性分析中,SecProbe[17]会导致模型可靠性和聚合参数隐私泄露并且无法应对用户中途退出的情况。因此在接下来的分析中,本文只与安全性较强的SAHPP[19]和PPFDL[21]方案进行对比。

5.1 通信开销

5.2 计算开销

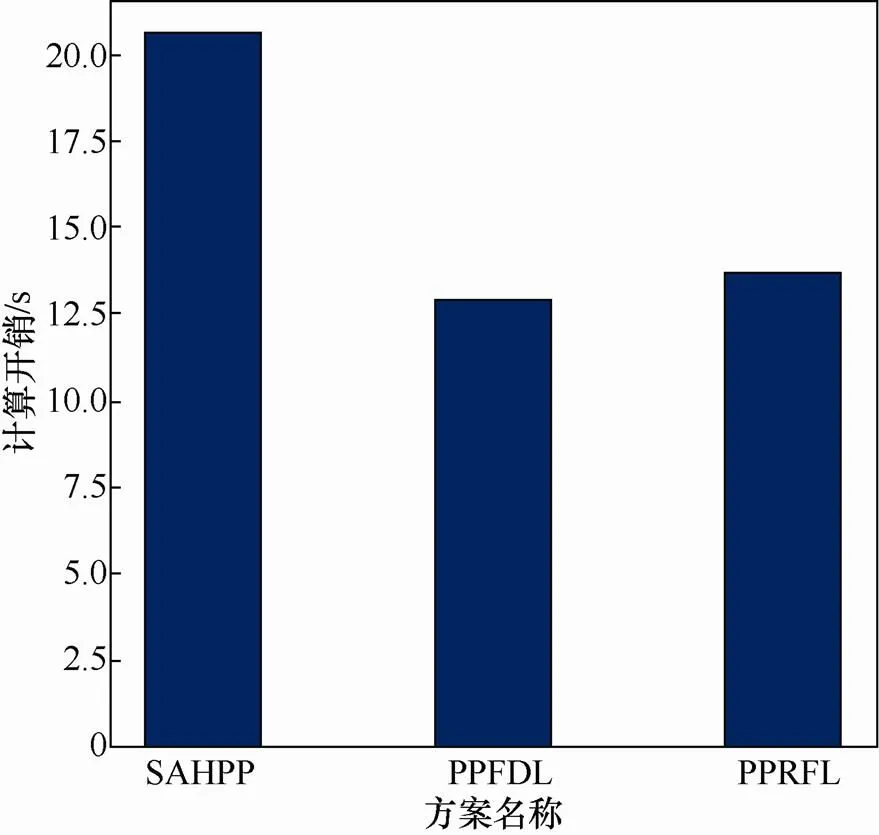

由于用户端的计算能力有限,在考虑模型精度和通信开销的同时应注意用户端的计算开销。图2给出在上传相同的模型参数数量时,不同方案的用户端计算开销。SAHPP[19]不仅需要密钥协商交互计算,并且需要计算本地模型与全局模型的空间距离,因此SAHPP方案中的用户端计算开销较高。PPFDL[21]仅需进行模型训练与模型参数加密,计算开销相比较低。PPRFL比PPFDL方案需要多执行一次前向计算和缩放模型参数计算,计算开销略高于PPFDL,但大大增强了模型对于不规则用户比例的鲁棒性。

图2 不同方案的用户端计算开销

Figure 2 Comparison of client’s computation costs among different schemes

图3 不同方案的服务器端计算开销

Figure 3 Comparison of server’s computation costs among different schemes

表3 不同方案的计算复杂度对比

5.3 收敛效率

图4 不同用户比例下模型准确率随着通信轮次的变化曲线

Figure 4 Curves showing the variations of model accuracy with number of communication rounds under different client ratios

图5 不同噪声比例下模型准确率随着通信轮次的变化曲线

Figure 5 Curves showing the variations of model accuracy with number of communication rounds under different noise ratios

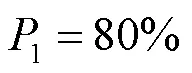

图6 相同噪声比下收敛次数随着用户数量的变化曲线

Figure 6 Curves showing the variations of convergence counts with number of clients under the same noise ratios

6 结束语

针对现有联邦学习方案受大多数不规则用户影响产生聚合效率降低、采用明文通信导致隐私信息泄露的问题,本文提出了一种支持多数不规则用户的鲁棒隐私保护联邦学习框架PPRFL。PPRFL在用户端利用组合验证集的损失值动态计算和缩放模型可靠性;在服务器端结合设计的除法协议进行安全参数聚合。经过理论分析和实验验证,PPRFL可以保证模型精度并提高联邦聚合的收敛效率,而且计算和通信开销均优于PPFDL。未来的工作将研究纵向联邦学习架构下处理不规则用户的方案,寻找进一步减小计算和通信开销的方法。

附录

安全除法协议的安全性证明如命题2所述。

证毕。

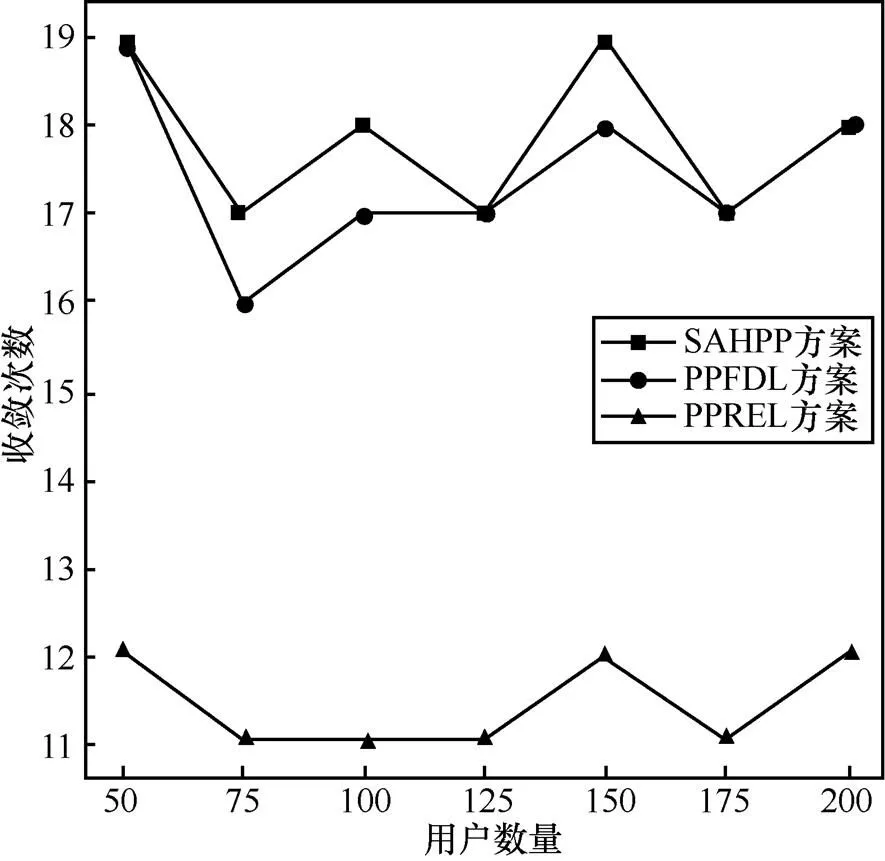

表4 不同除法协议的计算开销对比

在通信开销方面,SecDiv需要2次通信传输同态密文,且需要执行通信开销较高的混淆电路和不经意传输操作,而本文提出的安全除法协议仅需要2次通信传输同态密文,通信开销远低于SecDiv协议。

[1] LI T, SAHU A K, TALWALKAR A, et al. Federated learning: challenges, methods, and future directions[J]. IEEE Signal Processing Magazine, 2020, 37(3): 50-60.

[2] YANG Q, LIU Y, CHEN T J, et al. Federated machine learning[J]. ACM Transactions on Intelligent Systems and Technology, 2019, 10(2): 1-19.

[3] 梁应敞, 谭俊杰, Dusit Niyato. 智能无线通信技术研究概况[J]. 通信学报, 2020, 41(7): 1-17.

LIANG Y C, TAN J J, NIYATO D. Overview on intelligent wireless communication technology[J]. Journal on Communications, 2020, 41(7): 1-17.

[4] 杨强. AI与数据隐私保护:联邦学习的破解之道[J]. 信息安全研究, 2019, 5(11): 961-965.

YANG Q. AI and data privacy protection: the way to federated learning[J]. Journal of Information Security Research, 2019, 5(11): 961-965.

[5] 谭清尹, 曾颖明, 韩叶, 等. 神经网络后门攻击研究[J]. 网络与信息安全学报, 2021, 7(3): 46-58.

TAN Q Y, ZENG Y M, HAN Y, et al. Survey on backdoor attacks targeted on neural network[J]. Chinese Journal of Network and Information Security, 2021, 7(3): 46-58.

[6] MELIS L, SONG C Z, DE CRISTOFARO E, et al. Exploiting unintended feature leakage in collaborative learning[C]//Proceed- ings of 2019 IEEE Symposium on Security and Privacy. Piscataway: IEEE Press, 2019: 691-706.

[7] 周传鑫, 孙奕, 汪德刚, 等. 联邦学习研究综述[J]. 网络与信息安全学报, 2021, 7(5): 77-92.

ZHOU C X, SUN Y, WANG D G, et al. Survey of federated learning research[J]. Chinese Journal of Network and Information Security, 2021, 7(5): 77-92.

[8] HITAJ B, ATENIESE G, PEREZ-CRUZ F. Deep models under the GAN: information leakage from collaborative deep learning[C]//Pr- oceedings of CCS '17: Proceedings of the 2017 ACM SIGSAC Conference on Computer and Communications Security. 2017: 603-618.

[9] MOTHUKURI V, PARIZI R M, POURIYEH S, et al. A survey on security and privacy of federated learning[J]. Future Generation Computer Systems, 2021, 115: 619-640.

[10] WAGH S, GUPTA D, CHANDRAN N. SecureNN: 3-party secure computation for neural network training[J]. Proceedings on Privacy Enhancing Technologies, 2019, 2019(3): 26-49.

[11] XU R H, BARACALDO N, ZHOU Y, et al. HybridAlpha: an efficient approach for privacy-preserving federated learning[C]//Pro- ceedings of the 12th ACM Workshop on Artificial Intelligence and Security. 2019: 13-23.

[12] 方晨, 郭渊博, 王一丰, 等. 基于区块链和联邦学习的边缘计算隐私保护方法[J]. 通信学报, 2021, 42(11): 28-40.

FANG C, GUO Y B, WANG Y F, et al. Edge computing privacy protection method based on blockchain and federated learning[J]. Journal on Communications, 2021, 42(11): 28-40.

[13] KANAGAVELU R, LI Z X, SAMSUDIN J, et al. Two-phase multi-party computation enabled privacy-preserving federated learning[C]// Proceedings of 2020 20th IEEE/ACM International Symposium on Cluster, Cloud and Internet Computing (CCGRID). 2020: 410-419.

[14] 董业, 侯炜, 陈小军, 等. 基于秘密分享和梯度选择的高效安全联邦学习[J]. 计算机研究与发展, 2020, 57(10): 2241-2250.

DONG Y, HOU W, CHEN X J, et al. Efficient and secure federated learning based on secret sharing and gradients selection[J]. Journal of Computer Research and Development, 2020, 57(10): 2241-2250.

[15] PHONG L T, AONO Y, HAYASHI T, et al. Privacy-preserving deep learning via additively homomorphic encryption[J]. IEEE Transactions on Information Forensics and Security, 2018, 13(5): 1333-1345.

[16] 张泽辉, 富瑶, 高铁杠. 支持数据隐私保护的联邦深度神经网络模型研究[J].自动化学报, 2020.

ZHANG Z H, FU Y, GAO T G. Research on federated deep neural network model for data privacy protection[J]. Acta Automatica Sinica, 2020.

[17] ZHAO L C, WANG Q, ZOU Q, et al. Privacy-preserving collaborative deep learning with unreliable participants[J]. IEEE Transactions on Information Forensics and Security, 2020, 15: 1486-1500.

[18] JAYARAMAN B, EVANS D. Evaluating differentially private machine learning in practice[C]//Proceedings of the28th USENIX Security Symposium. 2019: 1895-1912.

[19] 成艺. 联合学习环境下保护隐私的数据聚合技术研究[D].成都:电子科技大学, 2020: 17-45.

CHENG Y. Research on data aggregation technology based on privacy-preserving in federated learning[D]. Chengdu: University of Electronic Science and Technology of China, 2020: 17-45.

[20] SHAMIR A. How to share a secret[J]. Communications of the ACM, 1979, 22(11): 612-613.

[21] XU G W, LI H W, ZHANG Y, et al. Privacy-preserving federated deep learning with irregular users[J]. IEEE Transactions on Dependable and Secure Computing, 2020, (99): 1.

[22] ZHENG Y F, DUAN H Y, WANG C. Learning the truth privately and confidently: encrypted confidence-aware truth discovery in mobile crowdsensing[J]. IEEE Transactions on Information Forensics and Security, 2018, 13(10): 2475-2489.

[23] TIAN Y L, LI T, XIONG J B, et al. A blockchain-based machine learning framework for edge services in IoT[J]. IEEE Transactions on Industrial Informatics, 2022, 18(3): 1918-1929.

[24] XIONG J B, BI R W, ZHAO M F, et al. Edge-assisted privacy-preserving raw data sharing framework for connected autonomous vehicles[J]. IEEE Wireless Communications, 2020, 27(3): 24-30.

[25] BONAWITZ K, EICHNER H, GRIESKAMP W, et al. Towards federated learning at scale: system design[J]. arXiv preprint arXiv:1902.01046, 2019.

[26] MCMAHAN H B, MOORE E, RAMAGE D, et al. Communication-efficient learning of deep networks from decentralized data[C]//Proceedings of the 20th International Conference on Artificial Intelligence and Statistics. 2017: 1273-1282.

[27] PAILLIER P. Public-key cryptosystems based on composite degree residuosity classes[C]// Proceedings of the International Conference on the Theory and Applications of Cryptographic Techniques. 1999: 223-238.

[28] ACAR A, AKSU H, ULUAGAC A S, et al. A survey on homomorphic encryption schemes[J]. ACM Computing Surveys, 2019, 51(4): 1-35.

[29] CANETTI R, FEIGE U, GOLDREICH O, et al. Adaptively secure multi-party computation[C]//Proceedings of the twenty-eighth annual ACM Symposium on Theory of Computing. 1996: 639-648.

[30] HENDERSON M, THOMSON B, WILLIAMS J D. The third dialog state tracking challenge[C]//Proceedings of 2014 IEEE Spoken Language Technology Workshop. 2014: 324-329.

[31] BUDZIANOWSKI P, WEN T H, TSENG B H, et al. MultiWOZ - A large-scale multi-domain wizard-of-odataset for task-oriented dialogue modelling[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. 2018: 5016-5026.

[32] SHOKRI R, SHMATIKOV V. Privacy-preserving deep learning[C]//Proceedings of the 22nd ACM SIGSAC Conference on Computer and Communications Security. 2015: 1310-1321.

[33] KANG J W, XIONG Z H, NIYATO D, et al. Toward secure blockchain-enabled Internet of vehicles: optimizing consensus management using reputation and contract theory[J]. IEEE Transactions on Vehicular Technology, 2019, 68(3): 2906-2920.

[34] KANG J W, XIONG Z H, NIYATO D, et al. Incentive mechanism for reliable federated learning: a joint optimization approach to combining reputation and contract theory[J]. IEEE Internet of Things Journal, 2019, 6(6): 10700-10714.

[35] KANG J W, XIONG Z H, NIYATO D, et al. Reliable federated learning for mobile networks[J]. IEEE Wireless Communications, 2020, 27(2): 72-80.

[36] CATALANO D, FIORE D. Using linearly-homomorphic encryption to evaluate degree-2 functions on encrypted data[C]//Procee- dings of the 22nd ACM SIGSAC Conference on Computer and Communications Security. 2015: 1518-1529.

[37] LECUN Y, BOTTOU L, BENGIO Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324.

Privacy-preserving federated learningframework with irregular-majority users

CHEN Qianxin1,2, BI Renwan1,2, LIN Jie1, JIN Biao1, XIONG Jinbo1,2

1. College of Computer and Cyber Security, Fujian Normal University, Fuzhou 350117, China 2. Fujian Provincial Key Laboratory of Network Security and Cryptology, Fujian Normal University, Fuzhou 350007, China

In response to the existing problems that the federated learning might lead to the reduction of aggregation efficiency by handing the majority of irregular users and the leak of parameter privacy by adopting plaintext communication, a framework of privacy-preserving robust federated learning was proposed for ensuring the robustness of the irregular user based on the designed security division protocol. PPRFL could enable the model and its related information to aggregate in ciphertext on the edge server facilitate users to calculate the model reliability locally for reducing the additional communication overhead caused by the adoption of the security multiplication protocol in conventional methods, apart from lowering the high computational overhead resulted from homomorphic encryption with outsourcing computing to two edge servers. Based on this, user could calculate the loss value of the model through jointly using the verification sets issued by the edge server and that held locally after parameter updating of the local model. Then the model reliability could be dynamically updated as the model weight together with the historic information of the loss value. Further, the model weight was scaled under the guidance of prior knowledge, and the ciphertext model and ciphertext weight information are sent to the edge server to aggregate and update the global model parameters, ensuring that global model changes are contributed by high-quality data users, and improving the convergence speed. Through the security analysis of the Hybrid Argument model, the demonstration shows that PPRFL can effectively protect the privacy of model parameters and intermediate interaction parameters including user reliability. The experimental results show that the PPRFL scheme could still achieve the accuracy of 92% when all the participants in the federated aggregation task are irregular users, with the convergence efficiency 1.4 times higher than that of the PPFDL. Besides, the PPRFL scheme could still reach the accuracy of 89% when training data possessed by 80% of the users in the federated aggregation task were noise data, with the convergence efficiency 2.3 times higher than that of the PPFDL.

federated learning, privacy-preserving, secure aggregation, irregular-majority users, security division protocol

s: The National Natural Science Foundation of China (61872088, 61872090, U1905211), The Natural Science Foundation of Fujian Province (2019J01276)

TP309

A

10.11959/j.issn.2096−109x.2022011

2021−10−07;

2022−01−05

林劼, linjie891@163.com

国家自然科学基金(61872088, 61872090, U1905211);福建省自然科学基金(2019J01276)

陈前昕, 毕仁万, 林劼, 等. 支持多数不规则用户的隐私保护联邦学习框架[J]. 网络与信息安全学报, 2022, 8(1): 139-150.

Format: CHEN Q X, BI R W, LIN J, et al. Privacy-preserving federated learning framework with irregular-majority users[J]. Chinese Journal of Network and Information Security, 2022, 8(1): 139-150.

陈前昕(1996−),男,福建泉州人,福建师范大学硕士生,主要研究方向为安全深度学习、隐私保护技术。

毕仁万(1996−),男,湖南常德人,福建师范大学博士生,主要研究方向为安全深度学习、安全多方计算。

林劼(1972−),男,福建三明人,博士,福建师范大学教授,主要研究方向为机器学习、生物信息学。

金彪(1985−),男,安徽六安人,博士,福建师范大学高级实验师,主要研究方向为信息安全、数据挖掘。

熊金波(1981−),男,湖南益阳人,博士,福建师范大学教授,主要研究方向为安全深度学习、移动群智感知、隐私保护技术。