基于空间自适应和混合损失对抗网络的乳腺肿块图像分割方法

刘 东,陈境宇,王生生**

(1. 湘南学院 医学影像人工智能湖南省重点实验室,湖南 郴州 423300;2. 湘南学院 计算机与人工智能学院,湖南 郴州 423300;3. 吉林大学 符号计算与知识工程教育部重点实验室,吉林 长春 130012;4. 吉林大学 计算机科学与技术学院,吉林 长春 130012)

根据世界卫生组织国家癌症研究机构(International Agency for Research on Cancer,IARC)2020 年发布的最新数据,乳腺癌已取代肺癌成为全球第一大高发癌. 基于医学影像的辅助诊断技术可有效提升癌症的筛查效率[1],对于肿瘤早筛诊断具有重要意义. 乳腺肿块是乳腺筛查过程中重要的病理特征,精确分割出乳腺肿块区域能够为乳腺肿块的良性恶性分类以及精准诊断提供可靠依据[2-3].

随着计算机视觉技术的发展,大量关于乳腺肿块分割的算法被提出,大致可划分为两类. ①人工特征提取的方法,包括基于区域的方法、基于边缘轮廓的方法和聚类方法. 例如,文献[4]从优化动态规划的角度提出乳腺图像肿块边界区域跟踪方法;Rahmati 等[5]则采用伽马分布估计思想,设计了一种基于水平集的肿块轮廓动态分割方法;文献[6]基于纹理特征采用模糊C 均值聚类算法实现乳腺肿块的半自动分割. 上述基于人工特征提取的分割方法设计较为简单,携带一定的语义特性,但分割性能受到一定限制,在复杂场景中难以满足需求. ②深度学习方法. 深度网络模型的出现将图像分割模型在泛化性和分割精度方面提升了一个层次[7]. 文献[8]提出基于U-Net 的深度网络结构在乳腺图像软组织病灶区域分割中获得较好的性能. 文献[9]则提出两阶段学习网络,分别对乳腺病灶区域进行粗分割、细粒度优化. 文献[10]改进了U-Net 分割模型应用于乳腺肿瘤边界的分割.Hai 等[11]则通过多尺度信息的刻画提升深度网络的乳腺肿块分割性能. 最近提出的一项代表性工作是AUNet 方法[12],其综合利用密集上采样和注意力机制思想,设计了一种新的网络在乳腺肿块分割中取得良好的效果. 上述方法在一定程度上提升了乳腺肿块分割的精度,但依然存在一些待解决的问题:①分割过程对掩码的像素是分开区分的,造成分割结果的空间连续性不够理想;②掩码中的一些细节存在模糊不清,需要借助后处理进行修正,但是计算复杂性较高;③深度模型依赖海量数据,语义特征利用不够充分.

因此,针对以上问题,本文研究在对抗网络中引入语义信息刻画的分割方法,提出一种基于空间自适应和混合损失对抗网络的乳腺肿块分割方法.在两个公开数据集上对所提出的方法进行了大量乳腺肿块分割实验,多个客观性指标表明了本文方法的优越性和有效性. 主要贡献包括:

(1)采用条件生成对抗网络对分割模型输出的结果进行精细化处理,使得像素之间空间连续性得到一定程度改善;

(2)在对抗网络判别器中,结合空间自适应归一化模块学习乳腺肿块的高级特征,以捕捉更多蕴含的语义特性;

(3)提出一种混合损失函数,分别添加Dice 损失和感知损失,以期改善类别不平衡问题,并减小预测掩码和对应的真实标签在卷积过程中特征图之间的距离.

1 本文方法

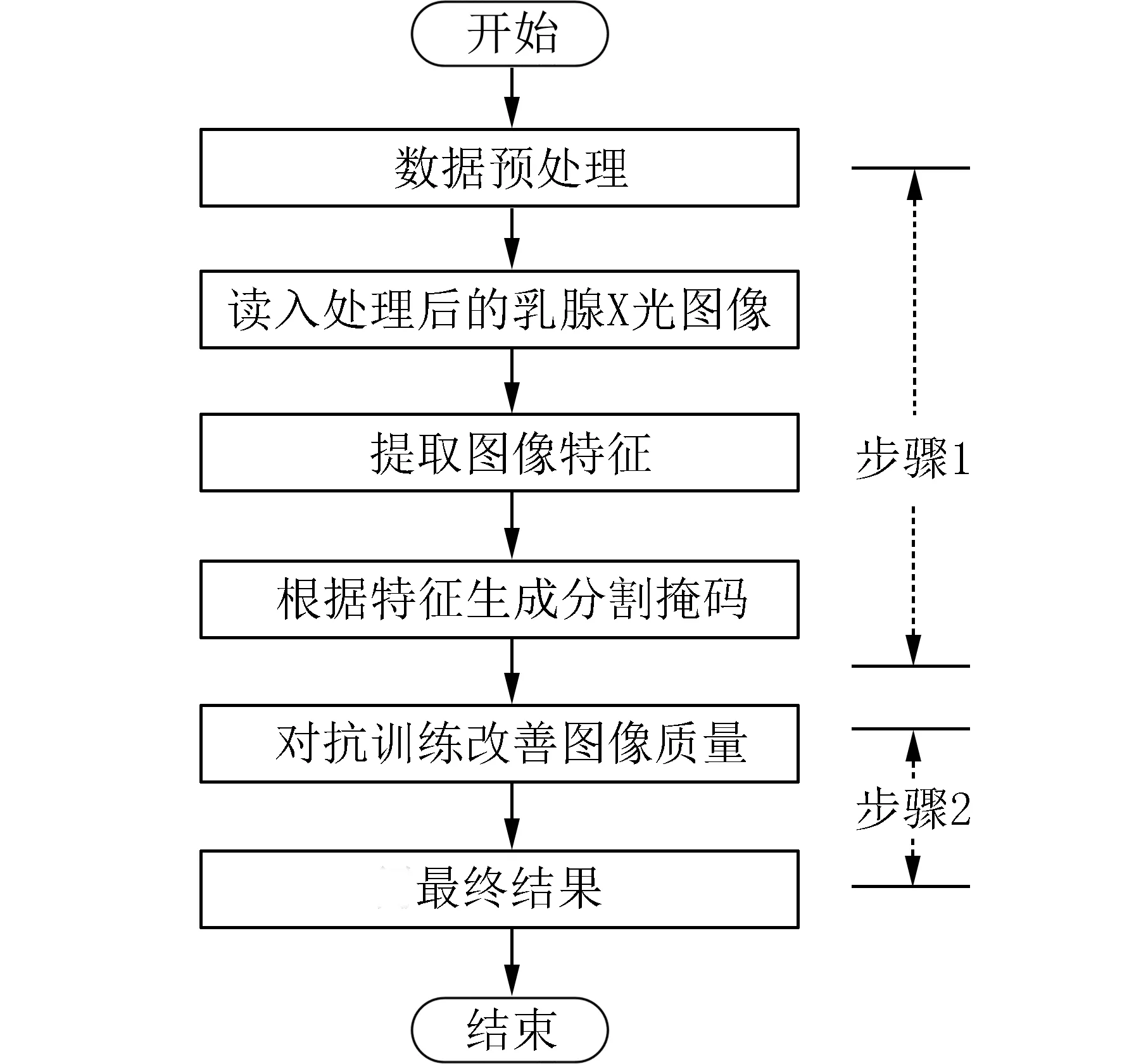

本文提出一种基于空间自适应的轻量级混合损失对抗分割网络模型,其工作流程如图1 所示,主要包括两个步骤:训练生成器和添加判别器. 首先,对乳腺X 光图像进行预处理并送入生成器,通过一系列降采样和上采样操作得到初始的粗略结果. 其次,将对抗训练框架加入模型,把粗略结果和对应的真实标签送入判别器,通过判别器的输出以及相应的损失回传帮助生成器改善生成结果,即对初步分割结果进行优化. 整体而言,所提模型的训练类似于生成对抗网络训练过程,将轻量级的可分离卷积U-Net 作为生成器进行粗略结果的生成,添加判别器构成对抗训练的基本条件.

图1 乳腺肿块图像分割流程图Fig. 1 The flow chart of breast mass image segmentation

1.1 数据预处理 首先,对乳腺X 光图像数据进行旋转、对称等数据增强操作,并将图像数据调整为统一的尺寸便于实验. 然后,采用基于像素值的算法去除不相关的黑色背景区域,仅保留与乳房影像相关的区域. 最后,将纹理特征相似的图像进行分离,以确保它们不会同时作为一个批量被输入到模型中.

1.2 可分离卷积U-Net 模型 目前流行的U-Net模型在医学图像分割领域取得较优异的性能[13].然而,U-Net 计算量很大,作为生成器与生成对抗网络结合后可能导致模型运算效率不高. 因此,本文提出采用可分离卷积U-Net 模型以降低深度网络计算时间.

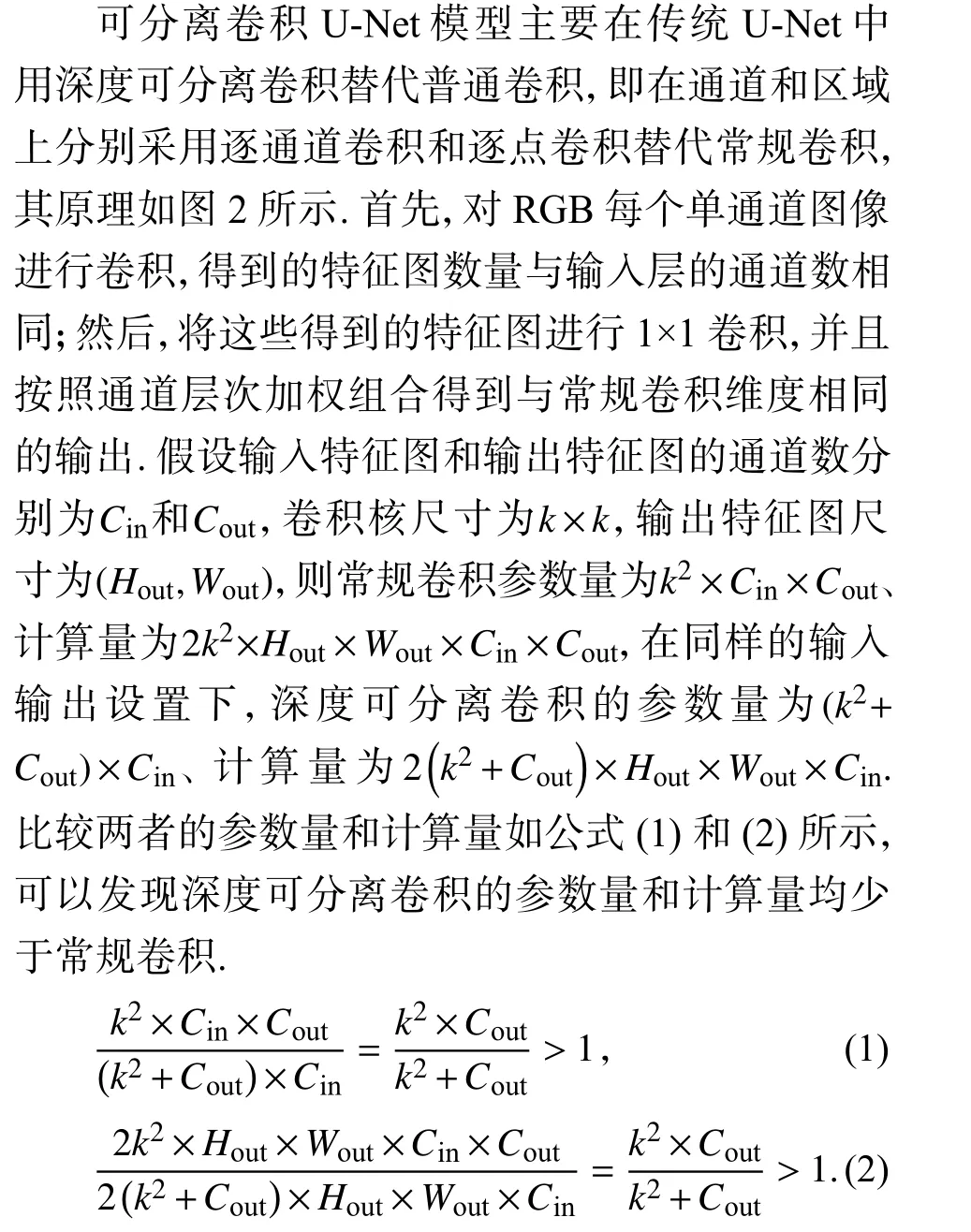

图2 可分离卷积示意图Fig. 2 The computing process of separable convolution model

以一幅5×5 的RGB 三通道彩色图像为例,以常规卷积计算,经过3×3 卷积核的卷积层,输出通道为4,最终输出4 个Feature Map,则卷积层参数数量为4×3×3×3=108. 而若采用深度可分离卷积,则首先经过3 个3×3 的卷积,再经过3 个1×1 的卷积,输出通道同样为4,其卷积层参数数量为3×3×3+1×1×3×4=39. 不难发现,相比常规卷积操作,可分离卷积模型的参数数量和运算成本大大降低.

1.3 基于空间自适应和混合损失的对抗分割网络模型 对抗网络结构可以良好地捕捉到图像的高级特征,从而提升医学图像病灶分割性能[14]. 本文提出一种新的轻量级混合损失对抗分割网络模型应用于乳腺肿块分割,即在分离卷积U-Net 分割模型后增加判别器,使用对抗训练的方式对U-Net 分割出来的结果进行后处理优化,并提出一种空间自适应层替换原始的归一化层,以获取更多的语义和本质特征.

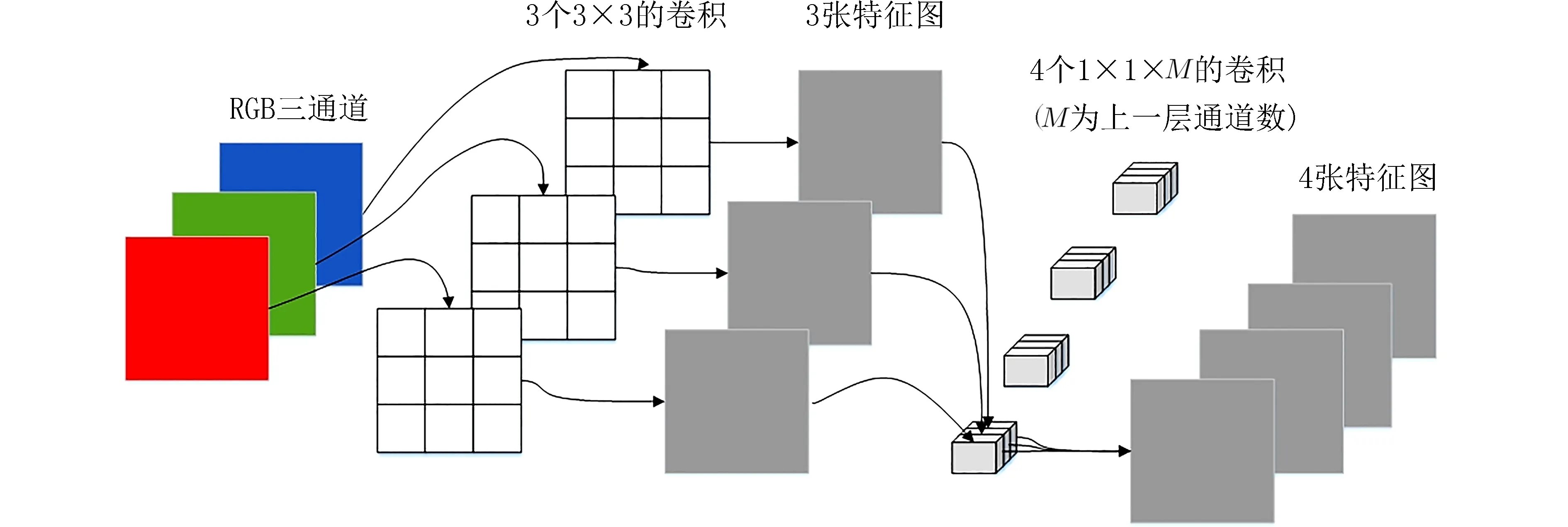

图3 展示了所提模型的完整架构,对抗网络结构中的生成器采用可分离卷积U-Net,原始图像经过3×3 的卷积获取高级特征,进而经过3×3 的卷积层和2×2 的上采样层映射为分割掩码,图中的蓝线表示“跳跃连接”. 判别器则采用卷积神经网络结构,由若干卷积和归一化操作构成,完成对输入图像真假的判别.

图3 基于空间自适应和混合损失的对抗分割网络模型Fig. 3 The adversarial networks model based on spatial adaptive and mixed loss

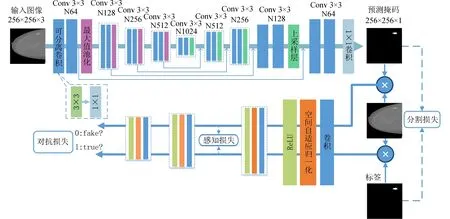

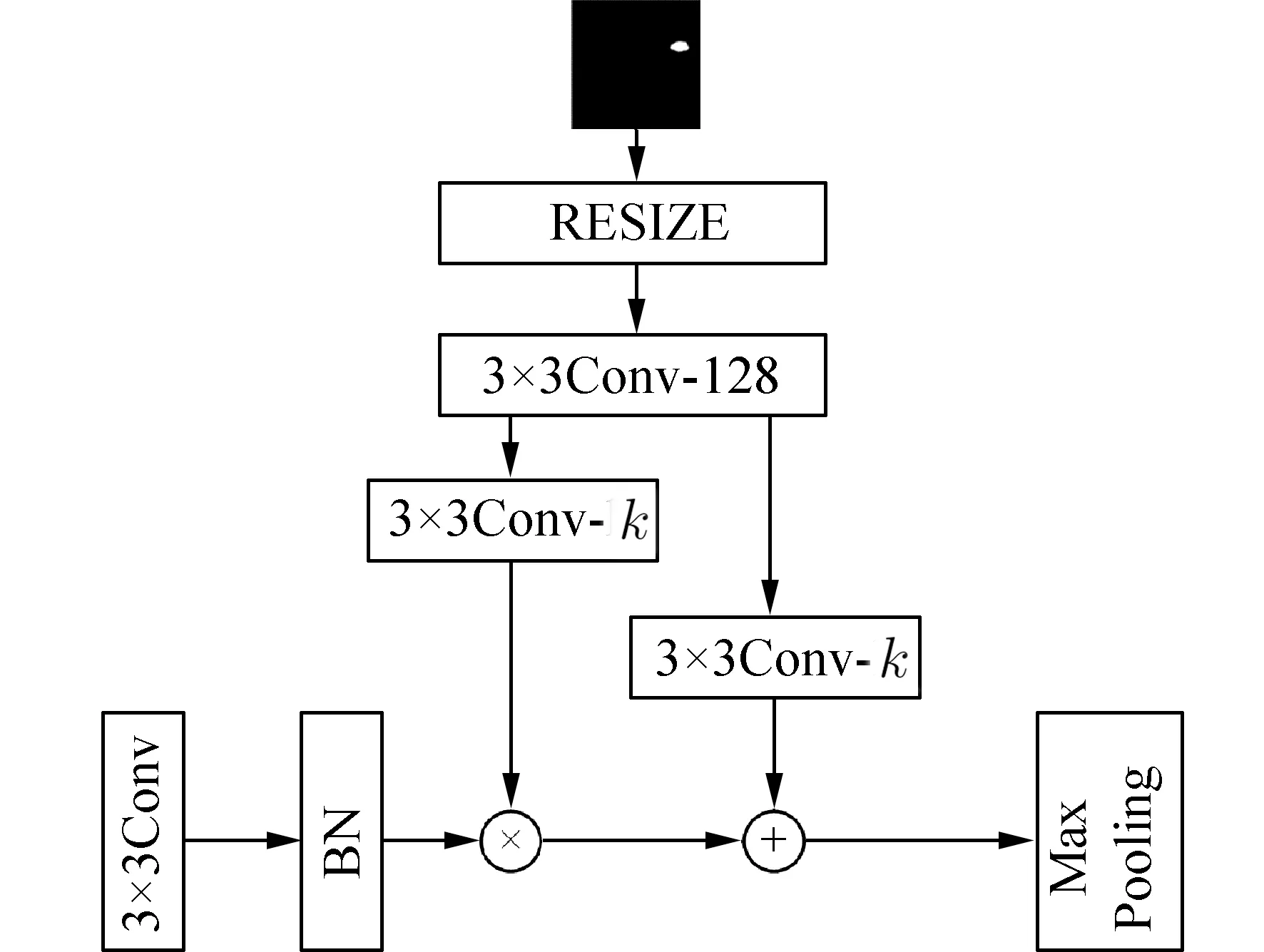

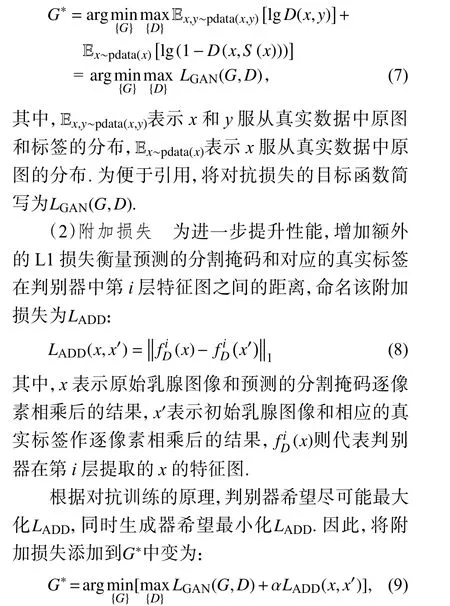

1.3.1 空间自适应归一化层 深度神经网络中一般具有一个归一化层,对于加速网络收敛和避免梯度消失具有重要的意义. 但是,当蕴含语义信息的分割掩码被归一化操作后,可能导致掩码中隐含的语义信息被过滤掉. 特别是对于在乳腺肿块分割这类语义分割任务,掩码只有一个标签(1 表示目标区域,0 表示非目标区域),进行归一化后值将全变为0,从而丢失了语义信息. 因此,本文提出空间自适应策略保持输入图像的语义信息,不仅将卷积后的特征图作为归一化层输入,同时将判别器的输入图像也作为补充信息,如图4 所示. 对图像进行逐通道归一化,并用学习到的调节参数,即缩放平移变量进行调节. 同时,调整判别器的输入图像尺寸使其和特征图大小保持一致.

图4 空间自适应归一化层示意图Fig. 4 The schematic diagram of spatial adaptive normalization layer

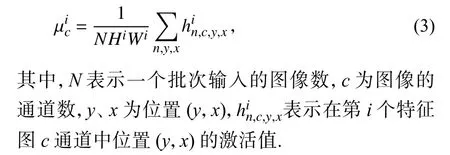

假定第i次卷积后的特征图高度和宽度分别为Hi和Wi,下面给出空间自适应归一化的形式化过程.

步骤 1 计算特征图像素的均值 µic:

步骤 2 计算特征图像素的方差:

步骤 3 对输入数据进行归一化:

步骤 4 进行尺度变化和偏移,获取最终特征图:

其中,参数γ和β是经过卷积层学习得到的,并且随着输入的改变而改变. 以这种方式学习得到的参数将保留更多图像中的语义信息. 使用一个两层的卷积网络来训练这两个参数,并通过学习得到的这两个参数来进行变化重构,从而保持图片中的语义信息.

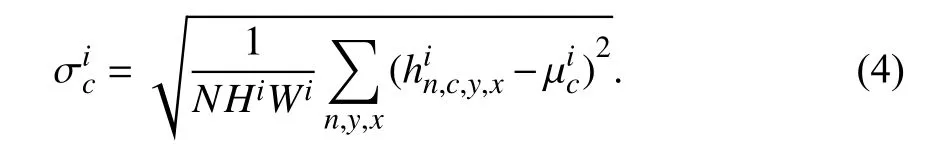

1.3.2 混合损失函数设计 为进一步提升乳腺肿块分割性能,提出一种混合损失函数,主要由对抗损失、特征映射之间的附加损失和分割损失3部分组成.

(1)对抗损失 假定模型输入为乳腺图像x,S(x)表 示分割网络输出的乳腺图像掩码,D(x,y)为判别器判断输入y是原始乳腺图像x真实标签的概率. 那么,模型训练目的主要在于生成器尽可能生成能够欺骗判别器的分割结果,同时,判别器尽可能把生成的图像和真实的图像区分开来. 按照原始GAN 的基本思想,其对抗训练的结果则是判别器尽可能地最大化D(x,y)、 最小化D(x,S(x)),同时生成器想最大化D(x,S(x)),因此,对抗损失函数如下:

其中,α是平衡因子.

(3)分割损失 通过对乳腺图像数据的分析,可以发现乳腺背景等占据了图像很大一部分,如果仅使用L1 损失指导训练方向,将使图像中的目标和背景像素得到同样的重视程度,显然不够合理.因此,进一步采用Dice 损失督促分割网络并把注意力放在感兴趣区域,提高肿块区域的重视程度,以提升特征的学习能力,命名这种损失为分割损失LSEG.

其中,n表示预测分割掩码中的像素数量,i代表像素的位置,yi和S(x)i则表示i位置的像素在真实标签中的值和在预测分割掩码中的值.

最终,提出融合3 个损失的混合损失函数如下:

2 实验与结果分析

2.1 实验数据与设置 实验采用两种公开、来源合法的乳腺图像数据集. ①INbreast 数据集[15],是葡萄牙波尔图乳腺癌中心获取并公开给学术界用于科学研究的数据集,共有410 张图像,其中包含钙化、不对称、肿块等多种类型的乳腺疾病. 针对本文肿块分割任务,选取其中107 张图像作为实验数据. ②CBIS-DDSM[16],为一种大型医学数据集,选取其中800 个乳腺肿块影像作为实验数据. 上述数据均由放射科专家进行标注与识别,具有准确的分割标签. 图5 显示了部分样本.

图5 乳腺肿块样本图像示例Fig. 5 Sample image of breast mass

实验采用NVIDIA GeForce GTX 1080Ti GPU(11 GB)平台,并使用PyTorch 框架. 在训练过程中,交替训练生成器和判别器以达到平衡状态.

实验参数设置训练批量大小为4,学习率初始固定为0.005,使用Adam 优化器改变学习率. 由于分割损失在肿块分割任务中用于衡量最终的分割结果和相应的标签之间的相似度,直接决定了分割效果的好坏,因此给予分割损失平衡因子λ分配较大的权重,而附加损失主要用于优化分割网络输出的粗分割结果,则给α分配相对较小的权重,因此最终将λ和α分别设为10 和1.

评价标准选取准确率(Accuracy)、灵敏度(Sensitivity)、特异度(Specificity)和集合相似度(Dice)[17]4 个常用指标进行实验性能评估.

2.2 实验结果分析 为客观验证本文方法的性能,在实验中对比了目前医学图像分割领域的几种流行方法:FCNs[7]、U-Net[8]、CGAN 和AUNet[12]. 其中,FCNs 和U-Net 常作为医学图像分割领域的基准模型. CGAN 是指在U-Net 的基础上,以原始乳腺X 光图像作为原始输入,以对抗训练方式训练的分割模型. AUNet 则是最新提出的基于注意力的分割模型. 下面分别在INbreast 和CBIS-DDSM 数据集上进行实验评估.

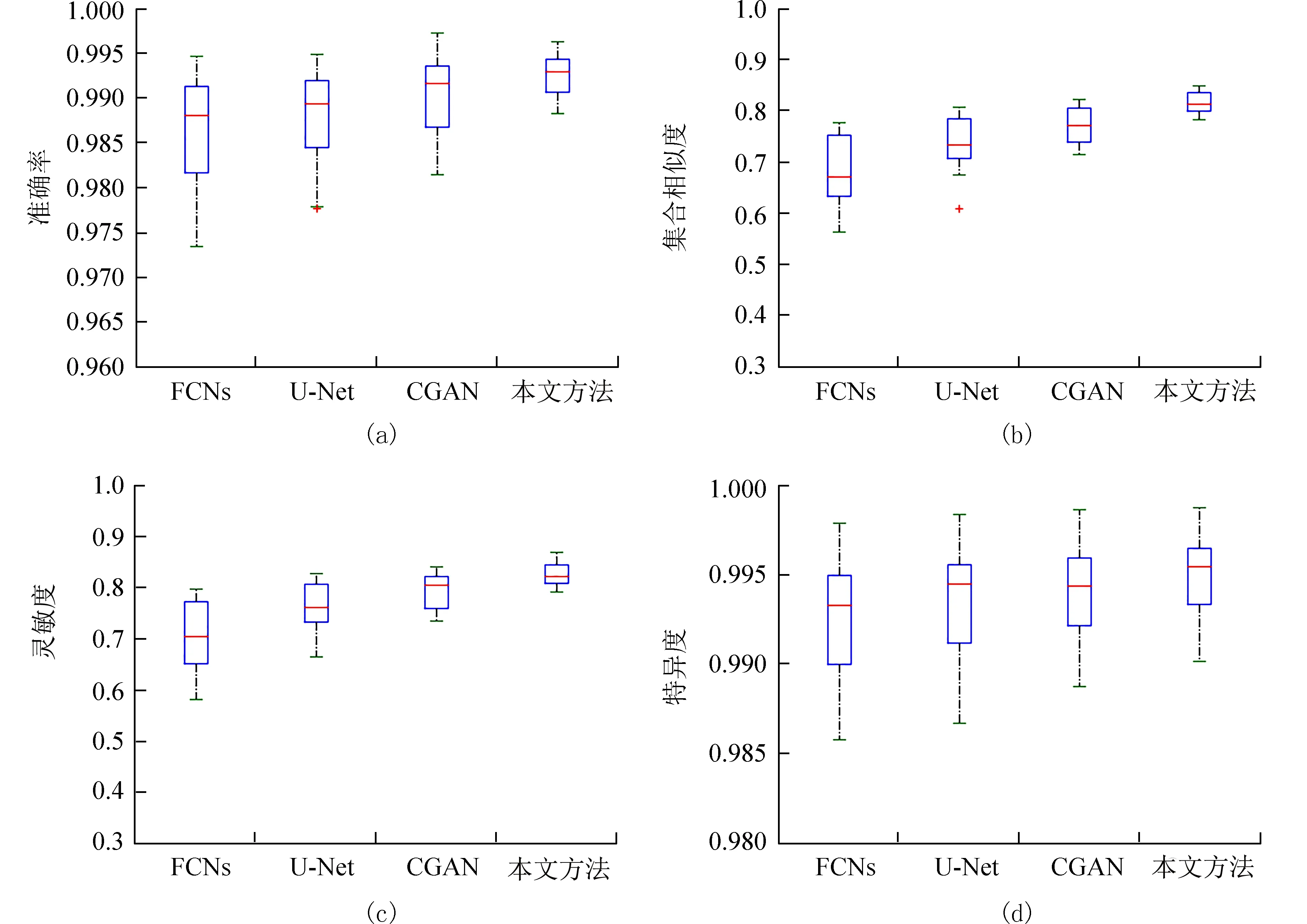

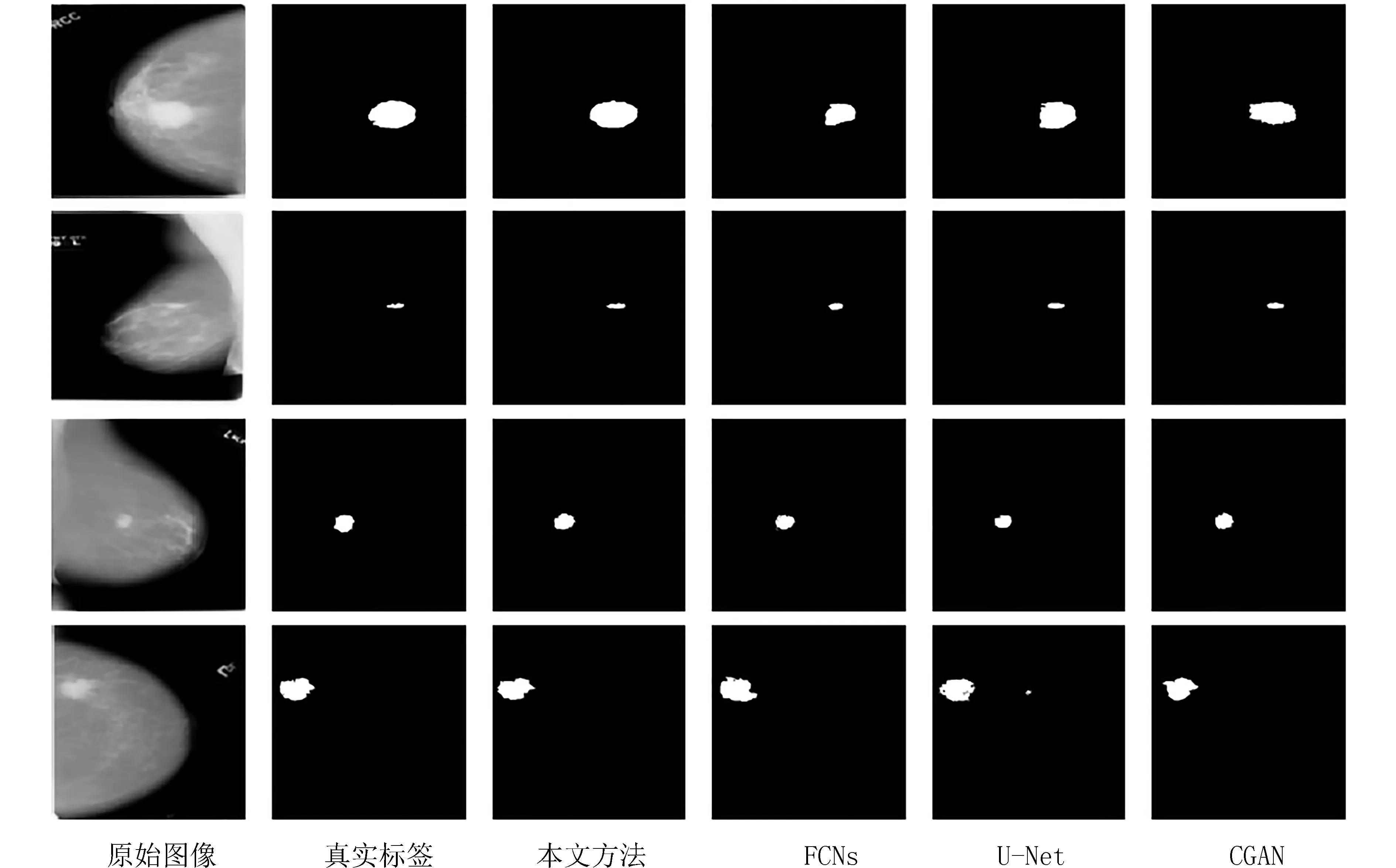

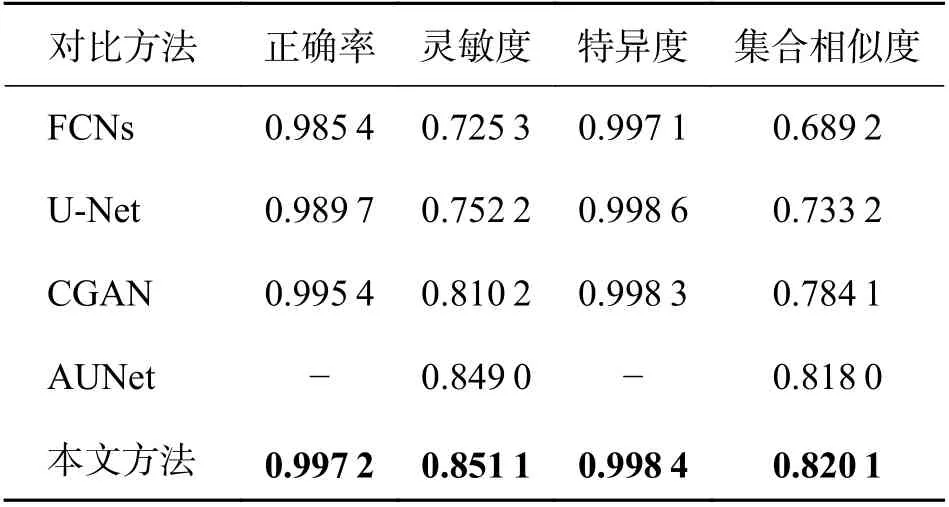

2.2.1 INbreast 数据集实验评估 所有对比方法在INbreast 数据集上的实验结果如表1 所示,图6展示了测试数据关于4 组评价指标的箱线图. 同时,给出了不同方法的分割效果图,如图7 所示.

图6 准确率、集合相似度、灵敏度、特异度4 组评价指标的箱线图Fig. 6 The boxplots of the four evaluation criterions for accuracy, dice, sensitivity and specificity

图7 对比方法在INbreast 数据集上的分割效果图Fig. 7 The segmentation results of compared methods on INbreast dataset

表1 对比方法在INbreast 数据集上的实验结果Tab. 1 The experimental results of compared methods on INbreast dataset

分析上述实验结果可以得到如下结论:①从分割精度上看,本文方法在4 个评价指标上均取得最高的性能,尤其是在集合相似度指标上获得较大提升,这说明使用Dice 损失替代原有的L1 损失,能够有效提升对抗学习的性能;②从箱线图来看,相比其他方法而言,本文所提方法具有最小的范围波动. 其中集合相似度指标,结果处于78%到83%范围之内,远小于其他方法的范围;③从分割效果上来看,所提模型获取的分割结果相比其他方法更接近真实标签,取得更令人满意的效果. 通过实验对比发现,形状规则、面积较大的肿块分割效果较好,而不规则、面积小的肿块则在分割过程中面临更大的挑战;④值得说明的是,所有对比方法均获得很高的准确率,这是由于数据集中图像的肿块区域相比背景很小,这导致目标区域的像素被错误分类时,并不会对准确率产生较大影响. 同理,特异度也远高于灵敏度.

2.2.2 CBIS-DDSM 数据集实验评估 在CBISDDSM 数据集中进行评估. 表2 展示了对比方法在4 个指标上的分割结果,图8 给出了几组样本的分割效果图.

图8 对比方法在CBIS-DDSM 数据集上的分割效果图Fig. 8 The segmentation results of compared methods on CBIS-DDSM dataset

表2 对比方法在CBIS-DDSM 数据集上的实验结果Tab. 2 The experimental results of compared methods on CBIS-DDSM dataset

通过CBIS-DDSM 数据集的实验结果可以发现,本文方法在4 个评价指标上获得最高的性能,这说明所提模型可以适应于不同乳腺影像数据,具备较强的泛化能力. 从分割效果上看,本文方法针对不同形状和尺寸的乳腺肿块,均取得较好效果.此外,CBIS-DDSM 数据集中背景区域更大,这意味着类别不平衡问题更为严重,本文方法依然取得显著的性能提升.

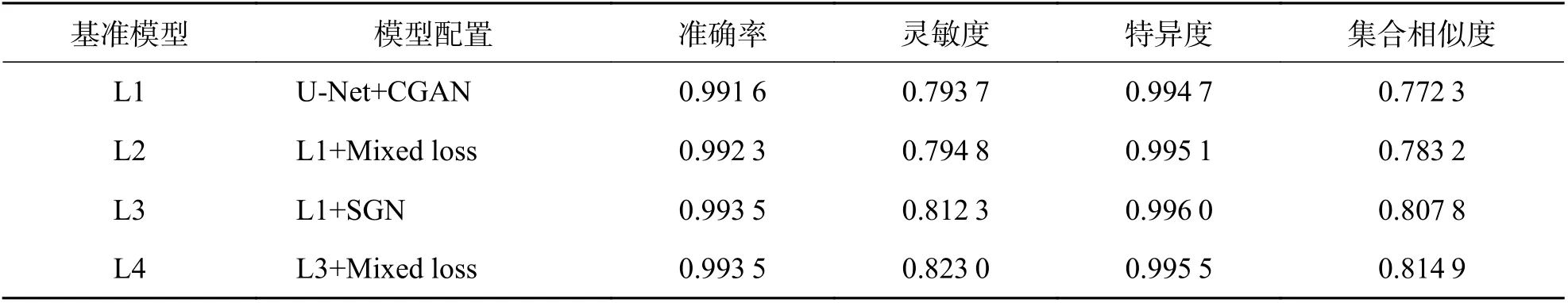

2.2.3 消融实验 最后,在INbreast 数据集上进行消融实验,以评估每个附加组件的性能,设置如下4 个基准模型:① L1:在U-Net 模型的基础上添加条件对抗训练,使用原始乳腺图像作为条件信息,即U-Net+CGAN;② L2:在L1 的基础上添加多重损失函数,即L1+ Mixed loss;③ L3:在L1 的基础上添加空间自适应归一化层,即L1+ SGN;④ L4:在L3 的基础上添加多重损失函数,即本文提出的方法:L3+Mixed loss.

上述4 个模型的实验结果如表3 所示.此外,为进一步验证所提方法在计算复杂度方面的优势,分别采用经典卷积和可分离卷积部署L4 模型,得到两种操作下的参数量和计算量如表4 所示.

表3 4 个基准模型在INbreast 数据集上的实验结果Tab. 3 The experimental results of four bechmark models on INbreast dataset

表4 经典卷积和可分离卷积的参数量及计算量对比Tab. 4 The parameter number and computation cost of clasical and separable convolution MB

从实验结果可以看出,每个部件的增加都在一定程度上提升了分割的性能,具体分析如下:①添加了混合损失函数后的L2 优于L1,这归因于在多重损失函数中引入了蕴含特征表达的损失,使得模型更加关注感兴趣区域,而不是将注意力均匀分散到反映大量背景的每个像素;②添加了空间自适应归一化层后的L3 模型在准确率、灵敏度、特异度、集合相似度等指标上相较于L1 均有明显提升,这说明空间自适应归一化层能有效保持一定的语义信息,提升模型训练性能;③提出的L4 模型取得最好的实验结果,这说明基于空间自适应归一化和混合损失的对抗网络方法综合了优化训练方向、语义特征保持等多方面的优势,能够有效提升乳腺肿块的分割性能;④由表4 可知,深度可分离卷积相比经典卷积,参数量和计算量分别减少了50%和58%,有效地提升了计算效率.

3 结论

本文主要研究乳腺肿块分割问题,提出一种基于空间自适应和混合损失函数的对抗网络分割模型,即使用卷积可分离U-Net 作为生成器,通过对抗训练中判别器优化生成器的分割结果. 通过引入空间自适应归一化模块提升语义信息的表达能力,并设计了一种混合损失函数规避不利因素带来的影响. 在两个公开数据集上的实验表明,所提方法的各个模块有机连接、互相支撑,在多个评价指标上取得优于其他模型的性能. 通过对分割结果的主观观察亦可发现,所提方法获取的分割结果与医生的诊断标注十分接近,有望应用于临床实际应用.

由于X 光成像中乳腺肿块尺寸差异较大、边界模糊问题较为严重,本文方法在不规则小肿块分割中还存在少许的误差,如何进一步提高分割模型的鲁棒性,尤其是提升不规则小病灶区域的分割性能,是未来研究工作需要重点解决的问题.