走向可解释性:打开教育中人工智能的“黑盒”

刘?桐 顾小清

摘要:教育是人工智能的重要应用领域,探索教育中人工智能的可解释性,是让人工智能在教育领域中更具“责任感”的重要议题。该文从教育中人工智能应用的现实问题出发,重点回应教育中人工智能的可解释性是什么,做了什么,以及未来走向三个问题。首先,以数据、任务、模型、人四个关键要素为切入点,分析阐述教育中人工智能的可解释性内涵;之后纵观教育中人工智能的可解释工作的演进过程,分析得出已有工作在教育意义注入、模型趋于复杂以及单向解释信息传递等方面的局限性;最后,从知识联邦、模型融生、人在回路三个角度,阐释教育中人工智能可解释性的未来发展方向。

关键词:教育人工智能;可解释性;“黑盒”模型;人在回路

中图分类号:G434 文献标识码:A

* 本文系2020年上海市科学技术委员会科研计划项目“教育数据治理与智能教育大脑关键技术研究及典型应用”(项目编号:20511101600)研究成果。

纵观历史,20世纪70年代出现的专家系统(Expert System)是人工智能应用教育领域的早期标志[1][2],时至今日,以个性化差异化为目标的自适应学习系统,以及软硬兼备的智能教育设备走进人们视野,人工智能成为有效推动教育教学变革的重要工具[3]。观其背后,教育与人工智能从以专家知识管理为主的初步结合阶段,走到以智能算法、教育大数据、云计算等技术交叉助力的应用爆发阶段,这使得人工智能赋能教育的伦理问题逐步凸显[4]。因此,在对人工智能存有一种理性防备的情况下,安全可靠的应用人工智能成为教育领域中亟待解决的问题。聚焦当下,人工智能呈现出一种“大数据+高算力+深度学习+小任务”的应用形态。深度学习算法作为人工智能的主要核心,是一种“端到端”式的知识挖掘模式,虽然取得优异的任务表现,但计算过程与求解结果难以被人理解,因此有学者提出“我们生长在一个‘黑盒世界’”[5]的言论。

站在教育立场当中,可解释性的缺位引发出以下三点问题:首先,人工智能应用难以落地。由于最终结果不可解释,造成人们难以理解最终结果,无法提供可靠的确定性信息,在实验室环境中的人工智能难以在教育情景中寻找认同,缺少落地的先决条件;其次,增加教育决策的潜在风险。由于算法决策过程不透明,机器在数据中如何学到知识以及学到哪些知识不可而知,因此,在计算结果上存在较大的不可预见性,影响教育决策者的判断依据,增加教育决策风险;最后,增加教育不公平与伦理风险。算法模型的不可解释,忽视了人的知情权益,影响了人的主体地位,同时,会造成算法开发者与使用者之间的信息不对称,造成被“算法绑架”的不公平现象。

因此,为了避免人工智能弱解释性所带来的消极影响,可解释性问题获得广泛而持久的研究[6][7]。诸多国家与国际组织也围绕此话题进行了相关政策的制定。例如,我国在2017年印发的《新一代人工智能发展规划》中提到要“重点突破自适应学习、自主学习等理论方法,实现具备高可解释性、强泛化能力的人工智能”[8]。美国国防部高级研究计划局设立“可解释人工智能(Explainable AI)项目,旨在提高人工智能算法的可解释性[9]。欧洲《通用数据保护条例》(General Data Protection Regulation,GDPR)中赋予其公民受算法决策影响后“获得解释的权利”,从而降低“黑盒”所带来的公民权力侵犯与隐私问题的风险[10]。

探讨教育中人工智能的可解释性问题,可使其在未来走的更加可靠安全、更具“责任感”。因此,本文主要回应较为关心的几个问题,即,教育中人工智能的可解释性是什么?在教育领域中,我们做了哪些与可解释性有关的工作?存在哪些局限和问题?我们未来又该走向何处?由此,才可将人工智能与教育情景适切性地结合,让人工智能在教育应用之路走得更为深远。

本部分回应前文提出的“教育中人工智能的可解释性是什么?”这一问题。首先系统阐述“可解释性”的内涵,进一步探讨教育中人工智能的可解释性,从而更加清晰明确教育中人工智能可解释性的内涵与特征。

(一)可解释性的内涵

谈及解释的概念,在科学哲学中,早期对于“解释”的理解,常常会把实用主义和语境搁置,而把重點放在构成“解释”的形式关系或特征的说明上,例如,Hempel认为解释的本质是一种“演绎法则”[11]。在这种观点下,解释就像逻辑上的证明,复杂的规律和演绎顺序构成了解释。虽然此观点在科学哲学中获得了较多批评,但却是许多解释理论讨论的起点,衍生出更多层次的解释理论,例如将解释作为一种机械的因果推理形式[12],将解释作为一种统计推断的形式[13]等。而随着解释理论的发展,实用主义的观点也逐渐获得人们认可,他们认为“解释”通常与解释的情境有关[14],即在不同的背景下,需要不同的解释来阐明同一种观察结果。但总的来说,解释是一组陈述,通常用来描述一组事实,阐明这些事实的原因、背景和结果。

可解释性是在解释的基础上的进一步扩展,不仅是解释者的思维产物,还会涉及到被解释者。对于可解释性的内涵,当前主要有以下三种观点:

1.从技术开发的角度。将可解释性视为一个系统工程,通过开发相关的技术工具,达到理解与管理人工智能技术的目的。例如,xAI(Explainable Artificial Intelligence)项目中将可解释性定位为,使人类用户能够理解、适当信任和有效管理人工智能的机器学习技术[15]。

2.从计算过程的角度。从操作的层面理解可解释性,通过调整数据输入、模型参数等关键要素,从结果的变化来寻找其中的因果关系,达到人可理解的“尺度”。例如,加州大学伯克利分校在《人工智能系统挑战的伯克利观点》中将可解释性定义为“解释人工智能算法输入的某些特性引起的某个特定输出结果的原因”[16]。

3.从人理解的角度。更多的学者是从人的角度定义可解释性,认为可解释性是为人提供解释的过程。例如,Bao等人提出可解释性是指人类具有足够的可以理解的信息来解决某个问题[17]。再如Arrieta等人认为可解释性是面向特定受众,通过提供模型的细节和原因,以使其功能清晰或易于人的理解[18]。

综上而言,可以说解释是解释者的产物,而可解释性取决于被解释者。它受到被解释者个人经验(例如专业背景)的影响,个体间的差异会影响可解释性的深度。由此我们认为,可解释是人工智能的固有属性,而可解释建立在人可理解的“尺度”上,通过恰当的方式,传递人能读懂的信息,其目的在于建立人机之间的信任关系。

(二)教育中人工智能的可解释性

前文给出了解释以及可解释性的内涵,聚焦在教育领域中,可解释性的内涵相应也会发生变化。因此,本文结合教育自身特性,抽取可解释工作的关键要素,从操作层面进一步理解教育中人工智能的可解释性。

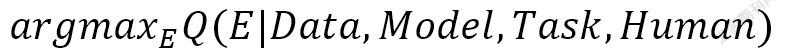

谷歌大脑团队的首席专家Been Kim,将可解释性的主要工作归纳在评价性公式之内[19]:

其中Q为可解释性的评价方程,E是实现可解释性的具体方法,可解释性工作即,在一定的数据(Data)和任务(Task)范围内,通过实现可解释性的方法,来训练机器模型(Model),从而达成人(Human)的最大程度的理解。在实际操作过程中,数据、任务、模型以及人的理解是开展可解释工作不可忽视的四个关键要素,据此,教育中人工智能的可解释也具有更为多样的内涵。

首先,教育领域中存在教学、学习、管理、评价等诸多教育情境,不同情境中发生的教育教学活动处于动态同步发生的过程,具有碎片化、多维度、时序性的特点,大范围的数据采集会带来诸多问题,例如,教育数据采集工作已成为投入与产出之间的动态博弈,因为增加一个新的数据采集维度,就可能增加巨大的建设成本,但却难以保证数据的有效性。可以说,教育数据是在一定教育情境中对教育现象的数值化描述。而教育数据角度的可解释性是在数据特征级别上围绕教育现象的表述,即以“先验知识+数据驱动”的形式抽取采集维度中的关键特征维度,在节省数据采集成本的同时,以数值化的形式融合多源数据,从而进一步明确数据采集方向。本质上,教育数据角度的可解释性以挖掘数据特征为目标,从而推断“采集哪些数据”这一关键问题。

其次,认识发现教育中的客观规律,是教育研究与实践的主要目的。在当下,以数据为工具研究教育的客观发展规律,是时代背景下的新兴研究范式。在大量数据输入的情况下,机器自动化计算为我们提供了一定置信区间内的关系可信度。因此,在预测基础上,通过与教育现象的结合,发现教育现象间的相关关系,关联关系,再到因果推理,而最终结论是在确定性与概率性之间往复权衡,建立出相对完备的解释关系。进一步说,教育任务角度的可解释性工作重点探索教育现象中的复杂多样关系,与先验假设之间建立关联,形成逻辑自洽的时空一致性结论,即对教育规律的关切。

再次,教育算法模型是挖掘教育数据价值的主要表现形式,模型设计的透明程度与最终解釋方法与理解效果有直接关系。因此,教育算法模型角度的可解释性大致可分为三种类型:(1)参数模糊模型的解释性,作为一种技术手段,如果可明确人工智能技术的具体功能属性,无需解释其内部结构或模型内部处理数据的计算方法,使人类能够理解其功能,知道模型如何工作,满足功能使用需要,但是具体的参数设置并未有比较扎实的数理基础。例如当前的主流深度学习模型就具有此特征。(2)参数明确模型的解释性。此类模型可通过研究者或者数据科学家来解释,例如在教育测量中广泛使用的项目反应理论(IRT模型),通过对数学公式的解读以及相关图示的形式,达到模型本身的可解释。(3)参数外显模型的解释性,满足完全理解的算法模型。这与模型本身的属性相关,主要用于解释本就透明的模型,或称白盒模型,例如决策树模型的结果以“if/ then”的表达形式呈现,是人类能够读懂的自然语言。模型映射结构,换句话说模型的参数设置,参数设置形式不同,可解释性也不相同。

最后,从教育中“人”的角度考虑最终的解释效果。人工智能在教育中的应用主体涉及到决策者、学生、教师以及研究者等人群,但个体所具备的人工智能经验有所不同,由此造成可解释的最终效果不尽相同。结合不同教育算法模型的透明程度,理解程度也可分为三个层次:(1)“黑盒”理解层次,对应参数模糊的算法模型,由于无需了解详尽的模型信息与实现机制,可解释性的重点在于将模型输出结果与特定教育情境结合,合理控制数据输入与结果输出即可。(2)局部理解层次,对应参数明确的算法模型,主要关注模型的局部效果,以一种“控制变量”的方式,建立模型给出的预测值和某些特征之间的作用关系,可能是线性关系,也可能是单调关系,更加关注单条样本或一组样本。例如1970年,Salmon在试图解释概率现象时,通过移除模型的组成部分来寻找改变概率的因素来筛选因果影响,从而获取高概率结果[20]。(3)全局理解层次,对应参数外显的算法模型,由于模型是以通俗易懂的自然语言方式呈现,应用主体能够了解模型的内部规则与计算流程,从而建立输入特征数据与最终结果,以及输入特征间的相互作用关系,进一步达成解释和理解模型决策过程的效果。

综上所述,教育中人工智能的可解释性更加侧重教育语义的注入,是解释者借助机器模型,通过人能够理解的自然语言的解释方式,阐述教育现象中的因果关联,寻求被解释者的意义共鸣的过程。在这之中,主要涉及到人、人工智能以及二者之间的交互过程,解释者使用的数据输入,设计的算法结构与解释方式,以及被解释者的接受程度,交互决定了教育中人工智能的可解释程度。

从20世纪70年代到21世纪初,人工智能在教育中的应用范围与用户群体在不断扩大,为了更加安全可靠的使用人工智能技术,在历史演进过程中,人们围绕可解释性陆续提出了许多方法与策略,也在不断修正已有做法。本部分在教育中人工智能的可解释性内涵的基础上,分析讨论已有的工作进展,从而可更加明确现有做法的优劣势,为后续可解释性工作的开展提供借鉴依据。

(一)教育中人工智能可解释性的演进过程

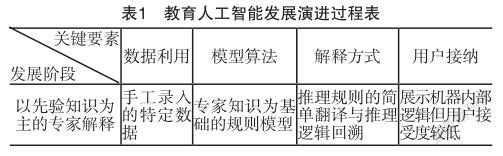

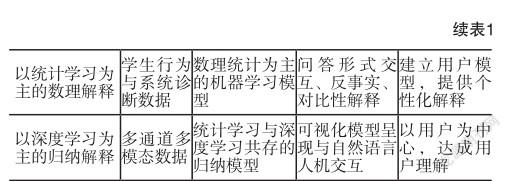

本部分基于可解释性的关键要素,从数据利用、模型算法、解释方式以及用户接纳四个维度,分析讨论人工智能在教育中可解释性的演进过程,如表1所示。

1.以先验知识为主的专家解释

在20世纪70年代左右,人工智能的概念被提出,第一代专家系统(Expert System)应运而生,例如SOPHIE-I[21],BUGGY[22]等,它们是人工智能在教育领域应用的初始形态。早期的专家系统设计较为朴素,主要用于特定问题的诊断以及决策辅助。系统通常由专家知识以及推理引擎构成,专家知识以条件规则的形式出现,推理引擎主要用于条件判断以及逻辑的推演,由此也掀起了可解释工作在教育人工智能领域的探索。

在数据利用层面,受到时代技术条件的限制,数值形式的数据并未被大规模的采集存储,数据通常是通过手工方式录入系统,例如XPLAIN系统,它会要求用户输入特定类型数据,从而依靠固定模板解释正在做的事情,同时,系统也会扮演导师的角色,为经验不足的用户提供详细的解释信息[23]。

在模型算法层面,早期系统设计较为简单,此阶段的系统较少使用数学模型进行计算,规则模型是整个系统的运行基础,同时也是系统可解释工作的主要知识来源。通过专家知识间的逻辑规则形成简单的语义网络,根据条件概率完成信息传递流程。例如斯坦福大学在1975—1980年开发的Mycin系统,里面包含了超过600条专家知识规则,它会提问用户一系列简单的是/否或文本问题,最终提供一份包含诊断概率的结果列表[24]。

在解释方式层面,当时的人工智能主要用于推理任务,如何解释机器推理过程成为当时主要的可解释方向。当时可解释工作大多将机器内部的推理逻辑展示给用户,通过回溯与数据及解释相关的推理链,用人类可读的语言表达用于做出决定的规则[25],例如,它们通常是将LISP语言中的if-then产生式规则,简单翻译并提供给用户。

在用户接纳层面,由于机器内部的规则最初由专家制定,有的规则是针对模型正常工作而设计,并不旨在让用户读懂,并且反馈给用户的可解释信息是对规则的简单翻译,因此,即使提供了决策规则和步骤,但也不一定是用户所关心和需要的。

综合来看,早期的解释工作集中在表达机器内部的状态、目标以及执行计划等内容,虽然模型足够透明,但当时的工作具有时代的局限性,首先,解释力较差,由于专家知识库的不足,使得可解释工作限定在特定专家规则之上,灵活性以及可扩展性较差,仅能对给定问题进行程序化描述;其次,知识表示存在缺陷,缺少丰富的术语基础和领域因果知识,如果用户使用与知识库相异的其它知识表示方式,系统将会无法响应用户的解释请求。

2.以统计学习为主的数理解释

随着时代技术的进步,第一代专家系统逐步被智能导师系统(ITS)所替代。此时的算法模型更加关注对学习情境的感知理解[26],学习情境包括学习者个人信息、学习历史、学习目标和领域知识等内容,同时,模型还可利用学习数据不断迭代改进,进行自我更新,这也为可解释性工作带来了难度。

在数据利用层面,此阶段能够利用的数据类型有所增加,包含学生的个人信息、学习行为以及系统对学生的诊断数据等数据。例如,Wick和Thompson利用学生行为数据,提出了一种重建解释(Reconstructive Explanation)方法[27],该方法存在两个知识库,第一个知识库包含所要学习的专家知识,第二个知识库中是学生学习状态点以及假设出错情况的集合。系统会记录学生问题解决路径,之后,结合过程行为数据以及第二个知识库进行系统结果解释。

在模型算法层面,概率模型的应用。例如,贝叶斯知识追踪模型(BKT)[28],学生对知识点的动态掌握状态影響着题目的作答结果,整个过程非常符合隐马尔可夫模型的建模过程,借此模拟学生知识状态的转移,从而预测学生知识掌握程度。与之前不同的是,此时的模型已经从固定的规则模型,发展成为能够基于统计信息学习更新的机器学习模型,由于参数较为固定,可以达到前文所提到的参数明确模型的解释性。

在解释方式层面,不同于为用户提供推理规则简单翻译文本的方式,此阶段的人机交互能力有所提升,机器能够读懂用户的问题,更加贴近人类之间的交流沟通。例如,Scholar系统使用了面向信息结构的ISO(Information-Structure-Oriented)解释框架[29],它可以结合交互情境特征,生成文本、问题和相应的答案,使人机交互变得更加自然。同时,反事实的解释、对比性的解释也出现在此阶段的解释方式中。

在用户接纳层面,此时教育人工智能的任务更加多样复杂,不仅包含决策推理等早期任务,同时也包含帮助学习者进行复杂技能提升的任务[30]。因此,可解释的目标不仅停留为用户解释,而是让用户信服,越来越多的研究者以及开发者意识到,为了让用户接受模型结果,千篇一律的解释并不能解决用户需求,而可以通过建立学习者模型,为用户提供个性化的解释信息。例如,有的研究者提出从评估用户水平、定制化学习内容以及定制化学习目标三个层面建立学习者模型[31],诊断评估学习者当前知识水平等信息,为之生成特定的学习目标及内容,从而达到学习者的心理预期,建立学习者与机器之间的信任关系。

综合来看,此阶段的解释工作意识到上一代工作的不足,发现仅表述系统内部状态与推理逻辑并不能与用户达成共识,并且用户可能也不需要此种解释。因此,在继承上一年代工作的基础上,此阶段解释工作在用户与系统两个角度进行了改进,首先,强调学习情境,建立用户模型,为每个用户提供个性化的解释内容,其次,将解释任务看作为系统自身的问题解决过程[32],Brézillon认为解释是用户和系统之间的合作问题解决过程,双方都需要理解对方的目标才能实现可解释性[33]。

3.以深度学习为主的归纳解释

随着信息技术手段不断更新,教育数据持续积累,学习分析技术的出现,建立了数据科学与教育的新连接。同时,人工智能浪潮再次袭来,“人工智能+教育”成为新的增长点,对可解释性的需求卷土重来。为了追求算法的高效能,在研究领域与工业界出现了越来越多的复杂人工神经网络,由于深层网络自身不够“透明”,神经元之间的信息传递人们无法解释,算法模型从数据中如何学到知识以及学到了哪些知识不可而知。并且,数据特征过于复杂,人们难以理解高维度输入数据的真实意义,也就无法进行合理解释。

在数据利用层面,教育数据捕获和处理技术的进步,多模态数据被广泛应用于教育场景之中。Lane和D’Mello总结了使用不同的生理数据(例如凝视、面部表情、fMRI、EMG、EEG)来衡量学习者注意力、专注力、认知负荷和学习策略的方法[34]。例如,Beardsley等人使用EEG和行为数据(例如反应时间)[35],使用机器学习算法来预测学生的在回忆任务上的表现。与之前不同是,多模态数据增加了数据来源通道,不同通道数据的相互映证,增强了模型结果的可信度。

在模型算法层面,统计学习模型依旧在被广泛应用,例如,卡耐基梅隆大学提出PFA(Performance Factors Analysis)算法,基于统计方法,利用试题难度和学生历史成绩预测学生成绩[36]。进一步,深度学习模型成为当前主流方法之一,例如,卢宇等人在循环神经网络基础上,加入逐层相关传播方法(Layer-wise Relevance Propagation)[37],解释学生知识学习的过程。Nakagawa等人通过数值化学生知识建构过程中潜在的图表示结构[38],利用图神经网络建立学生深度知识追踪模型,并将预测结果利用网络结构图表示,达到较高的解释与预测效果,与之类似的还有AKT[39]、RKT[40]等,但由于算法本身的限制,大部分算法并不具有较强的可解释性。

在解释方式层面,计算机技术在视觉、自然语言、语义标注等方面的进步,为解释方式提供了诸多可行方法。例如,朱军等人提出可视化解释系统CNNVis[41],通过数据预处理模块、聚合模块以及可视化模块,提取神经元的特征、连接,分析网络学习的特征、激活特征以及对结果的贡献等,同时还具有交互功能,可以人为改变数据聚合过程,从而更好地观察模型内部的运作过程。再如Ribeiro等人提出较为通用的可解释框架LIME[42],其核心是在算法模型的结果附近训练一个可解释的模型,比如线性模型,实现原模型预测结果的局部可解释性。

在用户接纳层面,以用户为中心的解释性成为当前研究的重点。例如有学者提出面向設计师的可解释AI框架,从而帮助游戏设计师在设计任务中,更好地利用人工智能技术[43]。Bauer与Baldes提出一种基于模型本体的用户界面[44],通过交互的方式帮助用户更加深入地理解模型结果。Wang等人基于哲学与心理学理论[45],构建以用户为中心的可解释AI框架,并在此基础上,确定了人类认知模式驱动建立可解释AI的需求途径,以及如何减轻常见的认知偏差。

(二)教育人工智能可解释性的局限性

回望教育中人工智能可解释性的发展过程,虽然已经提出很多方法,但依旧存在瓶颈与局限性:

1.教育数据生命周期缺少教育意义的注入。随着人工智能技术与理念的不断进步,其所利用的教育数据经历了关注学习者个体基本属性(如年龄、学习风格等)到基于系统客观记录数据(如在线学习行为流等)再到多模态数据(如眼动数据、生物电数据等)的过程。本质上,经历了从主观走向客观,从单通道走向多通道,从个体走向环境的过程。

但随着所能采集的数据类型源源不断的增加,在处理过程中存在两点问题:首先,高维度数据难以被常人理解,目前大多数人工智能算法数据输入为矩阵形式,例如将图片转化为二维矩阵或者多维张量的形式输入,此做法易于算法理解,但缺失了与元数据之间的实际意义关联。例如,在自然语言处理中用到的词嵌入(Word Embedding)技术,通过机器训练的方式,学习每一个字或词在向量空间中的唯一表示,通常是一个高维向量,并且每一维都缺少对应的实际意义,但人是无法理解的。其次,数据融合过程成为现实困境,不同数据流从横向跨度上描述了教育现象发生的过程,但是如何在多模态数据间实现信息匹配与意义建构极具挑战性,当前的主流做法是将高维向量进行拼接,而数据意义建构则依赖于后续的模型计算,但为何这样拼接很难解释。综合来看,从数据采集、清洗到模型输入、训练以及输出,在整个数据利用的生命周期中,缺少教育意义的注入,由此带来教育活动意义的描述偏差,将会损失可解释的空间。

2.模型设计趋于参数模糊的复杂模型。教育中的人工智能算法模型的解释性发生了从基于规则模型解释到基于数据学习模型解释的转变。本质上,规则模型属于演绎方法,而数据学习模型属于归纳方法[46],前者将专家知识符号化,以演绎的方式得出结果,后者通过大量的数据,无限逼近某种未知的规则,因此存在可解释性差异。具体来说,规则模型更接近因果关系,调整规则会带来显而易见的变化,可解释性更强;数据学习模型具有非线性特征,虽然带来了较好的系统涌现效果,然而过于依赖参数设置与调整,无法主动思考与决策,大部分情况下很难解释。

不难发现,复杂算法模型逐渐成为数据挖掘的主流力量,但却增加了解释工作的难度。例如,在知识追踪任务中,深度知识追踪模型可建立复杂知识点之间的关联,反映学生知识点掌握程度的连续变化,预测效果也明显高于传统贝叶斯知识追踪模型,但由于深度模型的“黑盒”属性,却难以给出预测结果的依据与原理,降低了结果的可信度;由此,也造成了第二个问题,复杂模型与教育场景的适切性匹配问题,主要考虑针对一定的教育现象,合理建立模型参数与教育现象特征之间的映射关系。当前,在计算机视觉、自然语言处理领域取得优异效果的算法,被应用于教育情境之内,缺少对教育现象的独特分析理解,例如,深度知识追踪中用到的卷积神经网络(CNN)、长短时记忆网络(LSTM)以及其它更为复杂的模型,由于算法设计阶段所考虑的应用任务不同,但被解释者的差异也会造成结果认同感的降低。

3.解释过程是解释者的单向信息传递。解释过程以“如何得到此结果”为问题核心,从为用户展示机器内部逻辑的形式,再到模型内部可视化等人类“尺度”的形式,其最终目标是寻求被解释者意义认同,但整体过程普遍是由人工智能技术本身驱动,而非来自真实用户的需求。被解释者作为解释过程的重要一环,一直处于被动接受的状态,解释信息的单向传递,难以形成解释的闭环,会造成以下两点问题:首先,模型修正效率降低,在模型部署应用阶段,由于模型训练阶段缺少被解释者的主动参与,造成数据与模型参数不可修改的情况,因此会增加模型修正调整的周期,降低部署应用效率;其次,容易造成伦理风险,由于解释内容与方式受解释者控制,容易造成被解释者与解释者之间信息的不对称,走进伦理道德误区。因此,现有的解释过程只停留在技术层面,缺少一种以用户为中心的务实且自然的方式,不利于利益相关者之间的对话。

针对前文所提到教育中人工智能可解释性的局限性,本部分探讨未来可解释性的发展方向,主要包括:以知识联邦为主要思路的数据合成,可为人工智能的可解释性提供教育意义;以透明“白盒”与追因溯源的模型融生,可推动教育中的人工智能从可解释性走向可信赖;以人在回路为中心的混合智能,可为教育中人工智能的可解释性提供质量保障。

(一)知识联邦:融入教育语义的数据合成

正如前文所述,分布式、碎片化是当前教育数据的主要特征,随着此类数据体量与来源的逐步扩张,数据丰富度增加的同时也为可解释工作带来困难。不仅考虑“数据解释了什么”并要考虑“用哪些数据解释”。因此,在未来,如何有效处理融合数据、提取数据特征成为可解释性工作的一大挑战。

首先,由于数据产生在的不同教育场景中,采用中心化汇聚的形式不仅容易造成成本浪费,同时也易造成数据泄露。因此,可通过建立一套的教育语义编码规范与语义数据交换标准,在特征级别实现数据一致化与标准化,将数值数据转换为人类与机器都可理解的语义数据。之后,利用分布式的思路,建立知识联邦,将语义信息存储于本地,通过语义数据交换标准,在数据利用阶段进行分布式数据抽取。不仅有利于在语义层面进行可解释性数据融合,也在保障数据安全的前提下,节省后续数据利用成本。

其次,从模型输入的角度来看,以“理论+数据”双驱动的特征工程方式蒸馏数据,依据专家先验知识,为数据的采集、清洗加入理论约束,在数据中融入教育教学理论知识,提取数据显式特征,在计算源头建立可解释性基础。其次,表示学习是机器自动学习数据中的隐式特征的过程,在表示学习中加入教育教学理论知识,一方面可降低数据维度,同时可与专家知识结合,调整模型学习策略,减轻认知负荷,增强结果的可解释性。

(二)模型融生:从可解释走向可信赖

可解释性是在模型精准度与透明度之间权衡后的结果。当前,衡量一个好的算法模型的标准是结果的精确度与准确度,因此,开发者更关切模型是否达到SOTA(State of the Art)水平,缺少对可解释性的关注。而在未来,教育领域对可解释性的关注,会从目标导向的角度,影响到最初的算法模型设计与后续应用。

首先,可在教育情境当中,创新应用可解释的“白盒”模型,让模型参数或者数据特征的教育内涵更加外显,从而可在计算过程中了解模型学习的过程,减轻可解释的难度。例如,有学者在贝叶斯知识追踪模型中融合布卢姆教育目标分类[47],通过衡量每个教育目标对其他教育目标的影响,提出解释模型输出的新方法。

其次,算法结果可溯源,走向可信赖的人工智能。在当前的教育情境中,使用者对机器决策结果不相信、难认同是在模型应用层面的困境。因此,可在模型设计阶段设立溯源机制,例如,借用区块链技术思想,建立分布式的算法账本,不仅可保障结果的不可篡改性,也可以帮助人们有效追溯所有的机器决策步骤[48],将解释逻辑自然地包含于算法流程中,从而在出现错误时明确人与机器的责任归属,让使用者更好地明確算法流程的执行过程。

(三)人在回路:促进人机对话的混合智能

解释过程离不开所要解释的内容和方式,而理解在于被解释者。从以“人”为本的角度来看,解释的过程在与被解释者的特点、所处环境、被解释者的反馈等多元信息整合后,综合达成可解释的目标。

首先,解释过程需要满足人对于解释信息的接受习惯。例如,人们所能接受的解释是对比性的,Miller在综合哲学、心理学和认知科学等领域的研究发现,事件A发生后,人们可能会问为什么是事件A而不是事件B发生;人们所接受的解释是选择性的,人们可能会关注诸多原因中的部分而非全部;以及人们在对话与社会交互的过程中接受解释[49]。由此可见,面对复杂的“人”,如果缺少被解释者自身特点的考量,教育中人工智能的可解释性发展也会受到限制。

其次,设计以“人”为中心的解释通道,形成人在回路(Human in the Loop)模式。机器善于从海量数据中学习知识,而人更善于在信息较少的情况下做出决策。因此,在从数据输入、模型训练、模型测试、模型部署的周期内,可设计并行的反馈通道,让人参与到全过程中,形成机器与人频繁交互的混合智能。通过人的引导,在交互节点之间,机器自动化构建决策结果,从而加速从模型训练到模型部署的过程,增加任务过程透明度,走向可信赖、具有“负责感”的人工智能。

随着人工智能技术逐步融入在教育情境的过程,可解释性必将是教育人工智能未来不可回避的重要问题,也是一个重要的研究方向。本文在对教育中人工智能可解释性的现实需求基础上,站在教育的立场中,分析阐述了教育人工智能的可解释性内涵,并从历史演变的视角,从算法模型、解释方式、数据、用户接纳四个关键要素总结了教育人工智能的已有工作,并分析了其局限性。最后,在回望历史的基础上,提出了教育人工智能可解释性的未来发展方向。

參考文献:

[1] Richer,M.H.,Clancey,W.J.GUIDON-WATCH:A Graphic Interface for Viewing A Knowledge-Based System [J].IEEE Computer Graphics and Applications,1987,5(11):51-64.

[2] Clancey,W.J,Letsinger,R.NEOMYCIN:Reconfiguring A Rule-Based Expert System for Application to Teaching [M].Stanford,CA:Stanford University,1982.

[3] 李子运.人工智能赋能教育的伦理思考[J].中国电化教育,2021,(11):39-45.

[4] 黄荣怀,王运武等.面向智能时代的教育变革——关于科技与教育双向赋能的命题[J].中国电化教育,2021,(7):22-29.

[5] Pasquale,F.The Black Box Society [M].Cambridge:Harvard University Press,2015.

[6] Swartout,W.R.Explaining and Justifying Expert Consulting Programs [M].New York:Springer,1985.

[7] Scott,A.C.,Clancey,W.J.,et al.Explanation Capabilities of ProductionBased Consultation Systems [R].Fort Belvoir:STANFORD UNIV CA DEPT OF COMPUTER SCIENCE,1977.

[8] 国务院.国务院关于印发新一代人工智能发展规划的通知[EB/OL]. http://www.gov.cn/zhengce/content/2017-07/20/content_5211996. htm,2021-07-20.

[9] Matt,T.Explainable Artificial Intelligence (XAI) [EB/OL].https://www. darpa.mil/program/explainable-artificial-intelligence,2021-07-20.

[10] Goodman,B.,Flaxman,S.European Union Regulations on Algorithmic DecisionMaking and A “Right to Explanation” [J].AI Magazine,2017,38(3):50-57.

[11] Hempel,C.G.,Oppenheim P.Studies in the Logic of Explanation [J]. Philosophy of Science,1948,15(2):135-175.

[12] Sober,E.Common Cause Explanation [J].Philosophy of Science,1984, 51(2):212-241.

[13][20] Salmon,W.C.Statistical Explanation and Statistical Relevance [M]. Pittsburgh:University of Pittsburgh Press,1971.

[14] Vasilyeva,N.,Wilkenfeld,D.A.,et al.Goals Affect the Perceived Quality of Explanations [A].Noelle,D.C.,et al.Proceedings of the 37th Annual Meeting of the Cognitive Science Society [C].Austin:Cognitive Science Society,2015.2469-2474.

[15] Gunning,D.,Aha,D.DARPA’s Explainable Artificial Intelligence (XAI) program [J].AI Magazine,2019,40(2):44-58.

[16] Stoica,I.,Song,D.,et al.A Berkeley View of Systems Challenges for AI [R].Berkeley:Electrical Engineering and Computer Sciences,UC Berkeley,2017.1-13.

[17] Bao,W.,Yue,J.,et al.A Deep Learning Framework for Financial Time Series Using Stacked Autoencoders and Long-Short Term Memory [EB/OL].https:// journals.plos.org/plosone/article/file id=10.1371/journal.pone.018094 4&type=printable,2017-07-14.

[18] Arrieta,A.B,Díaz-Rodríguez,N.,et al.Explainable Artificial Intellige nce(XAI):Concepts,Taxonomies,Opportunities and Challenges Toward Responsible AI [J].Information Fusion,2020,58:82-115.

[19] Been,K.Interpretability [EB/OL].https://www.youtube.com/ watch v=JkaF997hyB4,2021-07-20.

[21] Nicolosi,S.L.Sophie:An Expert System for the Selection of Hazard Evaluation Procedures [M].Boston:Springer,1988.

[22] Brown,J.S.,Burton,R.R.Diagnostic Models for Procedural Bugs in Basic Mathematical Skills [J].Cognitive Science,1978,2(2):155-192.

[23] Swartout,W.R.XPLAIN:A System for Creating and Explaining Expert Consulting Programs [J].Artificial Intelligence,1983,21(3):285-325.

[24] Van,M.W.MYCIN:A Knowledge-Based Consultation Program for Infectious Disease Diagnosis [J].International Journal of Man-Machine Studies,1978,10(3):313-322.

[25] Moore,J.D.,Swartout,W.R.Explanation in Expert Systems:A Survey [R].Fort Belvoir:UNIVERSITY OF SOUTHERN CALIFORNIA MARINA DEL REY INFORMATION SCIENCES INST,1988.1-55.

[26] Mueller,S.T.,Hoffman,R.R.,et al.Explanation in Human-AI Systems:A Literature Meta-Review,Synopsis of Key Ideas and Publications,and Bibliography for Explainable AI [R].Fort Belvoir:DARPA XAI Program,2019.49-60.

[27] Wick,M.R.,Thompson,W.B.Reconstructive Expert System Explanation [J].Artificial Intelligence,1992,54(1-2):33-70.

[28] Corbett,A.T.,Anderson J R.Knowledge Tracing:Modeling the Acquisition of Procedural Knowledge [J].User Modeling and User-Adapted Interaction,1994,4(4):253-278.

[29] Carbonell,J.R.AI in CAI:An Artificial-Intelligence Approach to Computer-Assisted Instruction [J].IEEE Transactions on ManMachine Systems,1970,11(4):190-202.

[30] McKendree,J.Effective Feedback Content for Tutoring Complex Skills [J]. Human-Computer Interaction,1990,5(4):381-413.

[31][32] Swartout,W.R.,Moore,J.D.Explanation in Second Generation Expert Systems [M].Berlin,Heidelberg:Springer,1993.

[33] Brézillon,P.Context in Problem Solving:A Survey [J].The Knowledge Engineering Review,1999,14(1):47-80.

[34] Lane,H.C.,D’Mello,S.K.Uses of Physiological Monitoring in Intelligent Learning Environments:A Review of Research,Evidence,and Technologies [A].Parsons,T.,et al.Brain and Technology.Educational Communications and Technology:Issues and Innovations [C]. Cham:Springer,2019.67-86.

[35] Beardsley,M.,Hernández‐Leo,D.,et al.Seeking Reproducibility:Assessing A Multimodal Study of the Testing Effect [J].Journal of Computer Assisted Learning,2018,34(4):378-386.

[36] Pavlik,Jr.P.I.,Cen,H.,et al.Performance Factors Analysis—A New Alternative to Knowledge Tracing [A].Darina,D.,et al.Proceedings of the 14th International Conference on Artificial Intelligence in Education [C].Berlin,Heidelberg:Springer-Verlag,2009.531-538.

[37] Lu,Y.,Wang,D.,et al.Towards Interpretable Deep Learning Models for Knowledge Tracing [A].Bittencourt I.,et al.Proceedings of the 21st International Conference on Artificial Intelligence in Education [C]. Cham:Springer.2020.185-190.

[38] Nakagawa,H.,Iwasawa,Y.,et al.Graph-Based Knowledge Tracing: Modeling Student Proficiency Using Graph Neural Network [A]. Payam,B.,et al.Proceedings of WI ‘19:IEEE/WIC/ACM International Conference on Web Intelligence [C].New York:Association for Computing Machinery,2019.156-163.

[39] Ghosh,A.,Heffernan,N.,et al.Context-Aware Attentive Knowledge Tracing [A].Rajesh,G.,et al.Proceedings of the 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining [C]. New York:Association for Computing Machinery,2020.2330-2339.

[40] Pandey,S.,Srivastava,J.RKT:Relation-Aware Self-Attention for Knowledge Tracing [A].Mathieu,D.,et al.Proceedings of the 29th ACM International Conference on Information & Knowledge Management [C]. New York:Association for Computing Machinery,2020.1205-1214.

[41] Liu,M.,Shi,J.,et al.Towards Better Analysis of Deep Convolutional Neural Networks [J].IEEE Transactions on Visualization and Computer Graphics,2016,23(1):91-100.

[42] Ribeiro,M.T.,Singh,S.,et al.”Why Should I Trust You ” Explaining the Predictions of Any Classifier [A].Balaji,K.,et al.Proceedings of the 22nd ACM SIGKDD international conference on knowledge discovery and data mining [C].New York:Association for Computing Machinery,2016.1135-1144.

[43] Zhu,J.,Liapis,A.,et al.Explainable AI for Designers: A HumanCentered Perspective on Mixed-Initiative Co-Creation [A]. Cameron,B.,et al.Proceedings of the 2018 IEEE Conference on Computational Intelligence and Games (CIG) [C].Maastricht:IEEE,2018.1-8.

[44] Bauer,M.,Baldes,S.An Ontology-Based Interface for Machine Learning [A].Rob,St.A.Proceedings of the 10th International Conference on Intelligent User Interfaces [C].New York:Association for Computing Machinery,2005.314-316.

[45] Wang,D.,Yang,Q.,et al.Designing Theory-Driven User-Centric Explainable AI [A].Stephen B.,et al.Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems [C].New York:Association for Computing Machinery,2019.1-15.

[46] 黃闪闪,林田.欧洲通用数据保护条例(GDPR)视角下深度学习算法的理据性问题刍议[J].系统科学学报,2021,29(1):31-34+66.

[47] Miller,T.Explanation in Artificial Intelligence:Insights from the Social Sciences [J].Artificial Intelligence,2019,267:1-38.

[48] Shruthi,C.,Daniel,M.G.et al.Directions for Explainable KnowledgeEnabled Systems [A].Ilaria,T.et al.Knowledge Graphs for eXplainable AI—Foundations,Applications and Challenges.Studies on the Semantic Web [C].Amsterdam:IOS Press,2020.245-261.

[49] Lalwani,A.,Agrawal,S.Validating Revised Bloom’S Taxonomy Using Deep Knowledge Tracing [A].Penstein,R.C.,et al.Proceedings of the 19th International Conference on Artificial Intelligence in Education [C]. Cham:Springer,2018.225-238.

作者簡介:

刘桐:在读博士,研究方向为学习分析、教育数据挖掘。

顾小清:教授,博士,博士生导师,研究方向为学习科学与技术设计、学习分析与学习设计、智能教育。

Opening the “Black Box”: Exploring the Interpretability of Artificial Intelligence in Education

Liu Tong, Gu Xiaoqing(Department of Education Information and Technology, East China Normal University, Shanghai 200062)

Abstract: Education is an important application field of artificial intelligence. Exploring the interpretability of Artificial Intelligence in education is an important issue that makes artificial intelligence more “responsible” in the field of education. This article starts from the practical problems of artificial intelligence application in education, and focuses on three questions about what is the interpretability of artificial intelligence in education, what has been done, and the future direction. First, the four key elements of data, tasks, models, and people are used as the starting point to analyze and explain the explainable connotation of Artificial Intelligence in education; The work has limitations in terms of the injection of educational meaning, the complexity of models, and the transmission of one-way interpretation information; Finally, the future development of artificial intelligence interpretability in education is explained from the three perspectives of knowledge federation, model integration, and human-in-the-loop.

Keywords: educational Artificial Intelligence; interpretability; “black box” model; human in the loop

责任编辑:李雅瑄