基于欧氏距离匹配的三维点云混合算法设计与实现

黄奕程 李光平

摘要:随着三维扫描设备和深度学习的快速发展,三维点云数据的处理成了热门趋势。目前,点云分类网络大都基于特征提取层面的算法改进提升点云分类网络分类准确率。相比于传统的数据增强方法,文章提出了一种基于数据预处理阶段的点云混合算法。在不改变分类网络结构的前提下,对数据进行混合处理。通过点云的相似度匹配,选取相似度小的点云进行混合,进而提升模型的泛化性能。实验结果表明:所提出的基于欧氏距离匹配的三维点云混合算法应用在点云分类任务上能显著提高点云分类的准确率。

关键词:点云;混合;深度学习

中图分类号:TP391 文献标识码:A

文章编号:1009-3044(2022)29-0001-03

1 概述

点云(Point Cloud)是在同一空间参考系下表达目标空间分布和目标表面特性的海量点集合。通过不同设备可以获取带有不同信息的点云,激光雷达得到的点云包括三维坐标和激光反射强度,通过RGBD相机得到的点云有三维坐标和颜色信息,结合两种设备得到的点云可同时携带两种设备特有的信息。点云目前被广泛应用于测绘、汽车、建筑等领域。随着自动驾驶的发展,利用深度学习方法对点云数据进行目标物体分类和语义分割的研究将成为热门趋势。

点云分类指将相同或相似属性的点划分到同一点集合的过程。随着深度学习的发展,点云的分类技术日渐成熟,分类准确率也日益提高。在以往的点云分类中,研究学者H.Su[1]等提出了借鉴卷积神经网络在二维图像应用的先验知识,把原始的三维点云从多个视角投影成二维图像,使用卷积神经网络分别处理二维图像,最后把处理后的每张图的信息聚合生成分类结果。但基于投影的点云分类策略计算复杂度高、高维信息在转换到低维信息时会有信息丢失的缺点,为了解决上述弊端,Qi[2]等人开创性地提出了PointNet网络,将深度学习模型首次直接应用于原始输入点云,该网络在点云分类和语义分割的准确率上有很大的提高。相比于传统的点云分类算法,利用深度学习的方法对点云数据进行处理的优势在于分类网络可以自动学习点云特征,通过给网络输入大量的数据,让点云分类网络有更好的鲁棒性和更高的分类准确率。数据增强是提升点云分类准确率的一个热门策略,优秀的数据增强方法可以提升模型的泛化性能,有效地避免数据过拟合。传统的数据增强方法是在原有数据的基础上,利用几何变换创造新的数据。三维点云混合和二维图像类似,通过对输入数据加入旋转、翻转、比例缩放、移位等方式对数据扩充。随着计算机视觉的发展,数据增强的手段越来越多,Li[3]等人在2020年提出了基于点云分类的自适应增强框架,可以自动优化和增强点云样本。通过联合训练分类器和增强器来丰富训练样本提高分类准确率。

目前用于训练点云分类网络的数据集较少,常用的点云数据集ModelNet[4]所包含的ModelNet10和ModelNet40分别只有10个类和40个类,ScanNet[5]是RGB-D室内场景数据集,有21个类,ISPRS[6]公共数据集总共有9个子类别。相比于图像的数据集,用于点云训练的数据集还是很少,需要进一步扩充点云训练数据和丰富样本。为了提高分类模型的泛化性能,防止模型过拟合,本文提出了一种点云混合网络。相比于通过改进神经网络特征提取结构或者优化分类损失函数的方法来提升分类准确率,本文的方法更具有广泛的适用性和兼容性。它可以在不改变现有分类网络结构的基础上,插入本文的混合网络就能使分类网络的性能得到显著提高。

1 相关工作

1.1基于深度学习的点云分类网络

由于点云的无序性,在处理点云数据时很难保证每次输入网络的点的顺序是相同的,很可能导致同一物体的点云多次输入网络,被网络提取到不同的特征。因此,早期学者往往通过把三维物体投影到二维,再利用二维的深度学习方法处理投影得到的信息。

相比于之前的模型需要额外的结构提取,Pointnet网络模型可以直接使用无序点集作为输入的深度学习框架,可以很大程度保留点云的空间特征。开创性地使用了对称函数来解决输入点云的无序性问题。同时,提出了T-Net网络,通过对输入点云学习得到一个3×3矩阵,解决点云的旋转问题。此网络直接把所有点通过最大池化的方式得到的全局特征进行分类,但是忽略了局部特征在点云数据的处理中也有一定的重要性。因为局部特征包含了临近点的几何结构等信息,因此作者后来提出了PointNet++[7]进行优化改进。2018年,Wang[8]等人提出了一个新的网络DGCNN,该网络提出了新的模块EdgeConv,获取足够的点云局部邻域信息的同时,也可以通过堆叠EdgeConv模块提取到全局形状信息。DGCNN在数据集ModelNet40和S3DIS把点云分类准确率和语义分割的准确率推到了新的高度。

1.2混合数据在深度学习中的应用

Zhang[9]等人在2018年提出了基于经验风险最小化的混合网络,该网络在几乎无额外计算开销的情况下,稳定地提升了1个百分点的图像分类进度。在图像混合样本数据增强方面做出了巨大的贡献。它通过随机数生成器生成一个概率随机数,利用随机数确定两张图片的混合比例后,混合两张图片,再放入网络进行训练,提高了神经网络的泛化性能增加了网络的鲁棒性。但混合网络在点云方面的应用较少,Chen[10]等人提出了基于点云的混合网络,因为点云不像图像一样有一一对应的关系,因此作者通过对現有的训练点云进行插值来增加点云数据,以此达到数据增强的目的,该方法在提升点云分类准确率方面也有很大的进步。

2总览

2.1方法

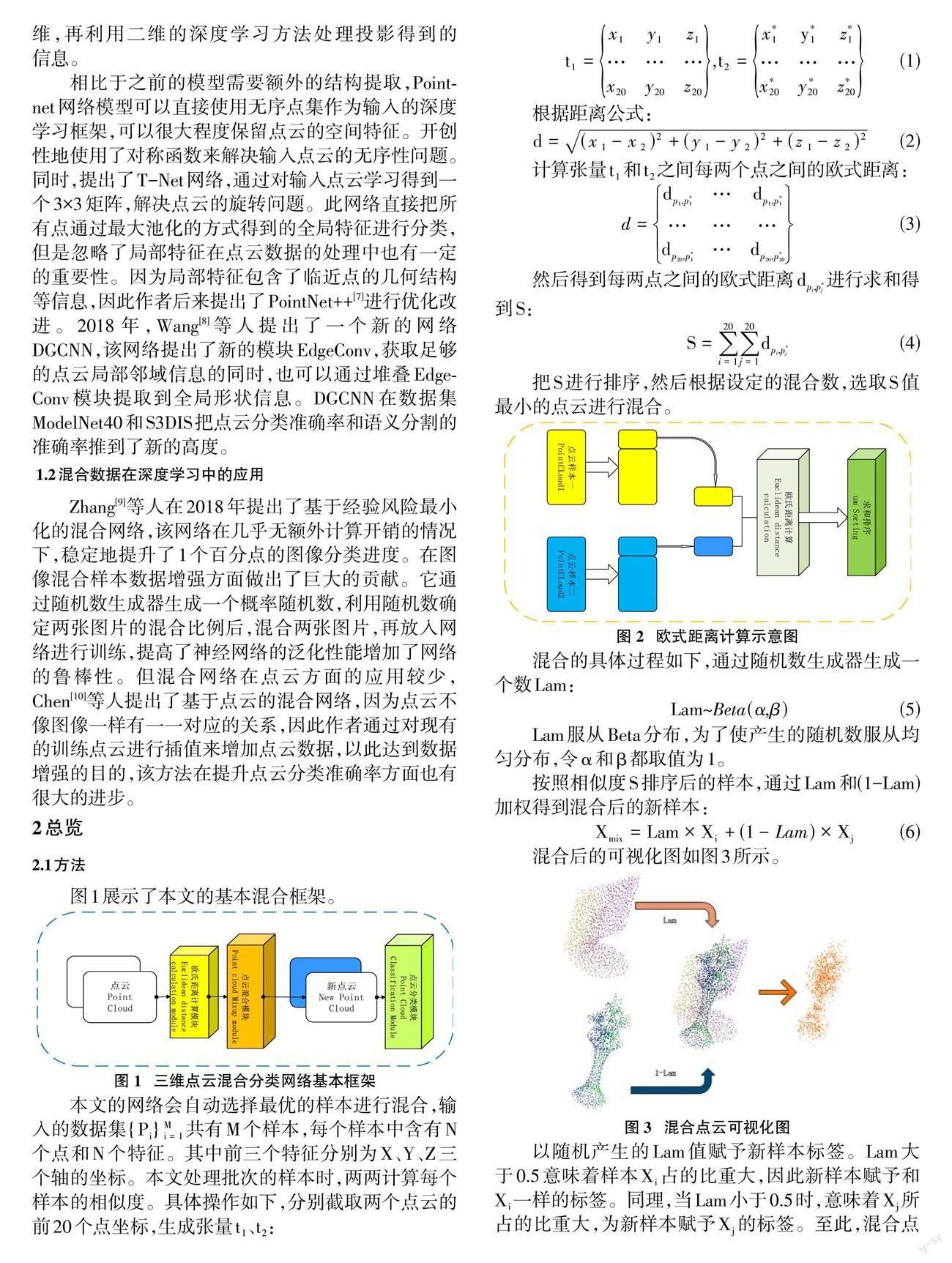

图1展示了本文的基本混合框架。

本文的网络会自动选择最优的样本进行混合,输入的数据集[{Pi}Mi=1]共有M个样本,每个样本中含有N个点和N个特征。其中前三个特征分别为X、Y、Z三个轴的坐标。本文处理批次的样本时,两两计算每个样本的相似度。具体操作如下,分别截取两个点云的前20个点坐标,生成张量[t1]、[t2]:

[t1=x1y1z1………x20y20z20,t2=x*1y*1z*1………x*20y*20z*20] (1)

根据距离公式:

[d=(x1-x2)2+(y1-y2)2+(z1-z2)2] (2)

计算张量[t1]和[t2]之间每两个点之间的欧式距离:

[d=dp1,p*1…dp1,p*1………dp20,p*1…dp20,p*20] (3)

然后得到每两点之间的欧式距离[dpi,p*j]进行求和得到S:

[S=i=120j=120dpi,p*j] (4)

把S进行排序,然后根据设定的混合数,选取S值最小的点云进行混合。

混合的具体过程如下,通过随机数生成器生成一个数Lam:

[Lam~Beta(α,β)] (5)

Lam服从Beta分布,为了使产生的随机数服从均匀分布,令α和β都取值为1。

按照相似度S排序后的样本,通过Lam和(1-Lam)加权得到混合后的新样本:

[Xmix=Lam×Xi+(1-Lam)×Xj] (6)

混合后的可视化图如图3所示。

以随机产生的Lam值赋予新样本标签。Lam大于0.5意味着样本[Xi]占的比重大,因此新样本赋予和[Xi]一样的标签。同理,当Lam小于0.5时,意味着[Xj]所占的比重大,为新样本赋予[Xj]的标签。至此,混合点云样本制作完成。

2.2损失函数

根据混合后样本的变化,原有的分类损失函数和增强损失函数也需要改进,为此提出了新的增强损失和分类损失,把混合的思想加入损失函数中,增强损失[LAug]:

[LAug=Lam×LAug_i+(1-Lam)×LAug_j] (7)

其中,[LAug_i]為混合样本和原始样本标签的交叉熵损失函数。[LAug_j]为混合样本与混合样本标签的交叉熵损失函数。

分类损失函数[LCls];

[LCls=Lam×LCls_i+(1-Lam)×LCLS_j] (8)

其中,[LCls_i]为混合样本和原始样本标签的交叉熵损失函数。[LCls_j]为混合样本与混合样本标签的交叉熵损失函数。

3实验与结果分析

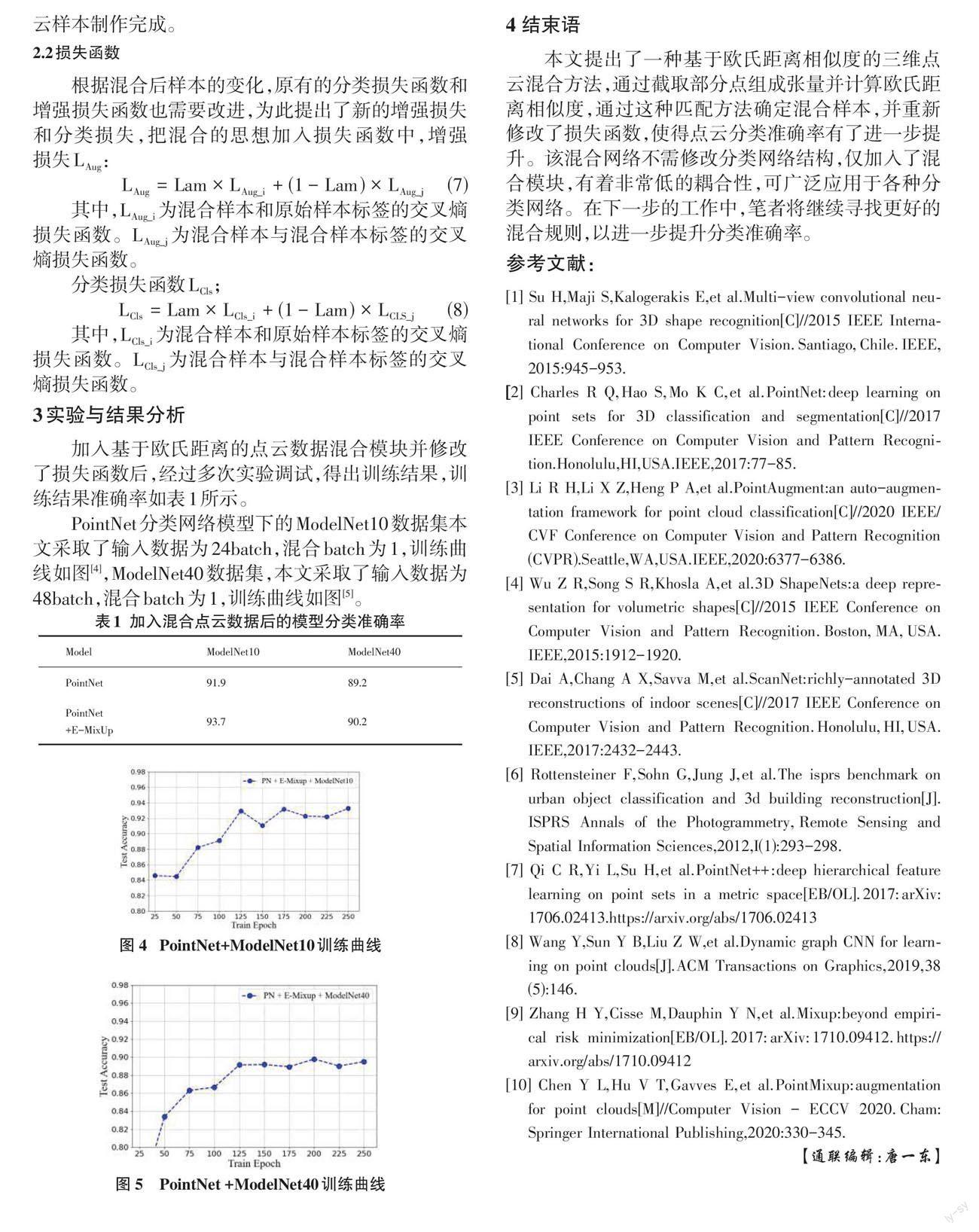

加入基于欧氏距离的点云数据混合模块并修改了损失函数后,经过多次实验调试,得出训练结果,训练结果准确率如表1所示。

PointNet分类网络模型下的ModelNet10数据集本文采取了输入数据为24batch,混合batch为1,训练曲线如图[4],ModelNet40数据集,本文采取了输入数据为48batch,混合batch为1,训练曲线如图[5]。

4 结束语

本文提出了一种基于欧氏距离相似度的三维点云混合方法,通过截取部分点组成张量并计算欧氏距离相似度,通过这种匹配方法确定混合样本,并重新修改了损失函数,使得点云分类准确率有了进一步提升。该混合网络不需修改分类网络结构,仅加入了混合模块,有着非常低的耦合性,可广泛应用于各种分类网络。在下一步的工作中,笔者将继续寻找更好的混合规则,以进一步提升分类准确率。

参考文献:

[1] Su H,Maji S,Kalogerakis E,et al.Multi-view convolutional neural networks for 3D shape recognition[C]//2015 IEEE International Conference on Computer Vision.Santiago,Chile.IEEE,2015:945-953.

[2] Charles R Q,Hao S,Mo K C,et al.PointNet:deep learning on point sets for 3D classification and segmentation[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition.Honolulu,HI,USA.IEEE,2017:77-85.

[3] Li R H,Li X Z,Heng P A,et al.PointAugment:an auto-augmentation framework for point cloud classification[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Seattle,WA,USA.IEEE,2020:6377-6386.

[4] Wu Z R,Song S R,Khosla A,et al.3D ShapeNets:a deep representation for volumetric shapes[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition.Boston,MA,USA.IEEE,2015:1912-1920.

[5] Dai A,Chang A X,Savva M,et al.ScanNet:richly-annotated 3D reconstructions of indoor scenes[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition.Honolulu,HI,USA.IEEE,2017:2432-2443.

[6] Rottensteiner F,Sohn G,Jung J,et al.The isprs benchmark on urban object classification and 3d building reconstruction[J].ISPRS Annals of the Photogrammetry,Remote Sensing and Spatial Information Sciences,2012,I(1):293-298.

[7] Qi C R,Yi L,Su H,et al.PointNet++:deep hierarchical feature learning on point sets in a metric space[EB/OL].2017:arXiv:1706.02413.https://arxiv.org/abs/1706.02413

[8] Wang Y,Sun Y B,Liu Z W,et al.Dynamic graph CNN for learning on point clouds[J].ACM Transactions on Graphics,2019,38(5):146.

[9] Zhang H Y,Cisse M,Dauphin Y N,et al.Mixup:beyond empirical risk minimization[EB/OL].2017:arXiv:1710.09412.https://arxiv.org/abs/1710.09412

[10] Chen Y L,Hu V T,Gavves E,et al.PointMixup:augmentation for point clouds[M]//Computer Vision - ECCV 2020.Cham:Springer International Publishing,2020:330-345.

【通聯编辑:唐一东】