人们对人工智能建议接受度的影响因素

李思贤 陈佳昕 宋艾珈 王梦琳 段锦云

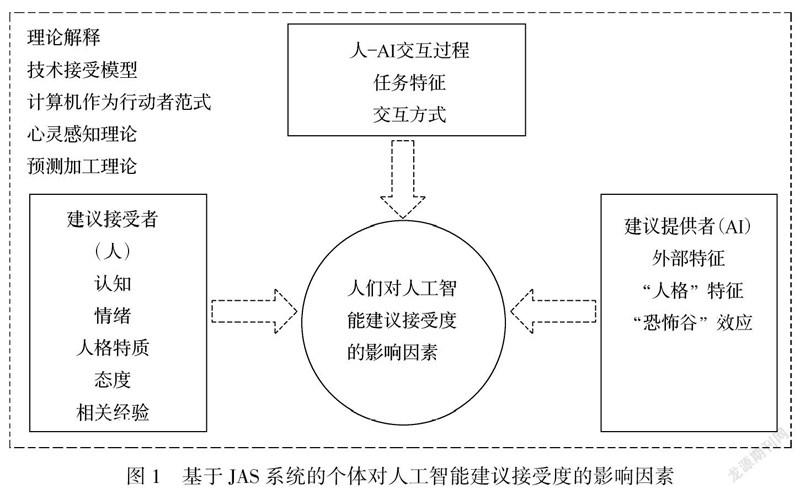

摘要人工智能(AI)正在逐步渗透至人类社会生活的方方面面,AI的使用能够在很大程度上节省时间、精力等诸多资源,但人们对AI提供的各类服务及建议的接受程度仍然不足。本文从建议接受者(人)的认知、情绪、态度等,建议提出者(AI)的外部特征、 “人格”特征等,以及人-AI互动(系统)三个角度讨论“影响个体接受AI建议的因素”,并且梳理了相关理论(技术接受模型、计算机为行动者范式、心灵感知理论和预测加工理论),以解释个体对AI的建议接受度。基于以上梳理分析,我们认为,未来研究可关注AI感知对建议采纳机制及调节作用、个体对AI建议偏好情境、对AI角色特征的感知态度,以及接受AI的心理模型动态化等角度,更加全面、系统地补充AI在建议采纳领域的应用。

关键词人工智能建议;建议采纳;人机互动;建议者-决策者系统

分类号B849

DOI: 10.16842/j.cnki.issn2095-5588.2022.04.002

1人工智能接受度现状

人工智能(Artificial Intelligence,以下简称AI)的广泛应用对经济和社会产生了重大影响。AI逐渐成为人类劳动的主要辅助者和替代者,从简单重复性的工作(如承担计数、搬运等)到复杂计算、推理性的工作(如金融分析师、管理咨询师等),AI都承担了重要角色(Huang & Rust, 2018)。同时,人类有限的精力、非理性决策和认知偏差使人们需要借助一定的外力来保证决策质量。由此,AI逐渐以顾问或客服的形式出现,代替人工向用户提供建议,如在网络销售/金融领域中,机器人顾问的数量逐年增长(Shanmuganathan, 2020)。与传统的人力顾问相比,机器人顾问可以改善金融服务的时限性和可获得性、降低管理费用、为用户提供更广泛的投资选择、避免不良动机等(Belanche et al., 2019)。

然而人们对AI提供的各类服务及建议的接受程度仍然不足(Hertz & Wiese, 2019; Jung et al., 2018)。这可能与人们对新技术的接受度有关,每当新兴技术产生时,人们总会对新技术过度恐惧(Orben, 2020)。但AI不同于其他新技术的独特之处在于,AI和人类有相似性,人们能够从AI技术中感受到和人有关的部分。基于此,本文试图回答以下问题:AI的建议在何种程度上被人们所接受,影响人们接受其建议的因素及机制是什么,以及如何改进以促进个体对AI建议的采纳(如图1所示)。

在传统的建议采纳研究领域,学者通常采用建议者-决策者系统(Judge-Advisor System, JAS)对影响建议采纳的因素进行探究。因此,本文也从JAS系统出发,分别从人(决策者角色)、AI(建议者角色)、以及人-AI互动过程(系统)三方面进行梳理。本文将AI定义为基于各种技术实现的对人类智能片段的模拟(Glikson & Woolley, 2020),包括计算机、机器人、以及运用于电脑或手机等的智能系统、算法等。同时,由于有关人类与AI交互的研究大多以对AI的接受度、偏好程度、使用意愿等作为考察对象,这也是决策者建议采纳时考虑的因素(Haran & Shalvi, 2020; Collins et al., 2011),因此本文将对AI的接受度、偏好程度以及使用意愿等作为建议采纳的指标。

2建议接受者的因素

对于建议接受者(人)而言,是否采纳AI的建议,以及对AI建议是否满意受限于个体长期以来形成的对AI的观点,较为稳定。本文提出个体对AI的认知、情感、态度,以及个体的人格特质和先前与AI互动的经验,都会影响到对AI建议的接受度。

2.1认知

心灵感知理论提出, 个体对人类和非人类实体均从以下两个维度进行感知: 能动(agency)——思考,计划和自愿行动的能力;体验(experience)——感觉情绪,痛苦和愉悦的能力(Gray et al., 2007)。因此,我们将人类对AI的认知也从能动性认知和体验性认知两个方面分析。

在能动性认知方面,首先,人对AI可解释性的感知会影响其接受程度。具体来说,通过对AI执行任务过程的解释,个体提高了对AI的理解, 从而产生信任(Donghee, 2021)。Mercado等人(2016)的研究表明,对于透明度较高的AI系统,参与者对该系统的信任度和感知可用性更高,表现更出色;同样地,一项综述也表明向用户解释系统的运行方式会提高用户对系统的可理解性感知,从而提高信任度(Schaefer et al., 2016)。除此之外,有学者提出个体对AI表现期待(performance expectation)和努力期待(effort expectation)的感知也会影响AI接受度(Venkatesh et al., 2003)。前者是指个体相信使用AI能够有助于其在相应任务上取得成就的程度,后者为个体认为使用AI的容易程度,这两者均可以正向预测个体对AI的使用意愿(Venkatesh et al., 2003)。由此,当个体对AI的能动性认知增加时,对AI的使用意愿和接受程度也有所提升。

在体验性认知方面,由于人们认为AI的體验性较低,缺乏体验情绪的能力,相较于人类,AI更不易受到偏见(如种族歧视)的影响,继而做出不公正的决策。因此,在涉及到平等、公正的道德决策时,人们更愿意接受AI建议(Bigman et al., 2021)。相反,相比于人类导购,顾客更不愿接受AI导购对享受型商品的推荐,因为该类商品需要有主观感受和体验才能做出合理评价,而这正是AI所缺乏的(Wien & Peluso, 2021)。另一方面,Yam等人(2020)的研究发现,相比于低AI体验性感知,顾客感知到AI体验性较强时,更能够容忍AI在服务过程中犯的错误,这可能是由于个体认为“体验性强的机器人对服务失败而感到自责和后悔”。由此可以看出,相比于能动性认知,个体对AI体验性认知和AI接受度之间的关系更复杂且不稳定,更多取决于情境条件。A9D08A6C-8D3C-4567-A816-1556B9F6C0D8

2.2情感

在建议采纳领域,研究者发现相比于中性情绪,个体体验到积极情绪时更倾向于采纳建议,而体验到消极情绪时则更不愿采纳建议(Gino & Schweitzer, 2008)。情绪同样可以影响个体对AI的使用意愿和偏好。一方面,研究表明,焦虑是阻碍人们与AI互动意愿的主要情绪(Nomura et al., 2006)。当人们缺乏与AI互动的体验时,会困惑如何与AI互动、担心受伤害,甚至会担心AI对社会造成潜在负面影响,如抢走人类的工作、对人类造成困扰等,这些都会引发焦虑,从而影响AI接受度(Nomura et al., 2006)。厌恶是对AI的另一种消极情绪反应。部分AI不仅会引起焦虑,还会引起个体产生怪诞、厌恶等消极感受,即“恐怖谷效应”(the uncanny effect; Mori, 1970)。有研究者从心灵感知理论出发对恐怖效应提出探究,认为这可能与人们对AI的体验性感知相关(Gray & Wegner, 2012)。但另一方面,个体在想到AI或实际与AI互动时,不只会产生消极情绪,还会产生积极情绪。如老年人与机器海豹“帕罗”互动时(Takayanagi et al., 2014),会表现出积极情绪,而积极情绪比消极情绪更能够预测对AI的使用意愿(Smith et al., 2020)。

為什么个体会对无生命的AI产生如此生动且丰富的情绪呢?如前所述,根据心灵感知理论,AI相对其他无生命个体而言,与人类最为接近,具有其独特性。因此有研究者认为,在如下三种条件之下,个体会由于心灵感知而对AI产生特定的情绪:(1)当个体对AI的某些方面感到惊讶时;(2)当AI按照社会规则行动时;(3)当AI具备似人的特征时(Shank et al., 2019)。在这三种条件下,对AI能动性和体验性的不同感知,可能会导致个体对AI的不同情绪反应,进而影响到对待AI建议的态度和接受意愿。同时,个体对AI的情绪可能是复杂、矛盾的,如既担心AI带来的威胁,又享受AI所带来的服务。因此,个体对AI产生的多重情绪如何交互地影响对其建议和决策的接受度,也是人-AI互动中重要的一方面。

2.3人格特质

人格特质对个体与AI互动的意愿、AI互动的类型都有影响,但是人格特质与对AI接受度之间的关系却十分复杂。以大五人格为例,最为稳定的预测因子是宜人性和外倾性,绝大部分研究发现个体的宜人性和外倾性与AI接受度之间存在显著正相关。开放性与AI接受度之间存在较弱的正相关,而对神经质、尽责性而言,不同研究者得出的结果并不一致。此类矛盾的结果可能与研究者采用的测量方式和选取情景有关,比如,具有高尽责性个体更不喜欢使用物理界面的社交机器人,因为有责任心的人更喜欢文本界面(Looije et al., 2010);并且,由于AI的智能性,很少甚至不再需要有条理的人工输入就能输出结果,这与尽责性个体的特征相重合,使得尽责性强的员工产生对工作角色的模糊,因此更不愿意使用AI (Tang et al., 2021)。

除大五人格之外,个体对AI的拟人化倾向也是影响AI建议接受度的重要人格特质,目前有大量研究关注到了对AI的拟人化倾向(衡书鹏等, 2019)。拟人化倾向指个体会在多大程度上以人的角度来理解和看待非人类实体 (Epley et al., 2007)。Martin等人(2020)的结果表明,有较高拟人化倾向的消费者会更加积极地看待AI建议,建议采纳率也更高。并且,高拟人化倾向的个体感知AI的共情能力更强,预期与AI的交往更愉快,对AI接受度更高(Pelau et al., 2021)。

2.4态度

个体如何看待AI是影响其使用意愿的重要因素。根据技术接受模型(Technology Acceptance Model, TAM),个体是否执行某行为的意图主要取决于其态度——一个人对相关行为的有利或不利评价的程度,同时感知有用性和感知易用性也会影响使用态度和意愿(Davis, 1989)。W?rn和Ramberg(1996)探讨了对AI建议态度的积极程度与采纳AI建议之间的关系。研究结果发现,个体对AI提出的建议态度越积极,则越倾向于采纳其建议。在金融领域,Belanche等人(2019)对金融AI建议者的使用意愿进行了考察,同样发现客户对AI态度的积极程度是采纳AI建议的最强预测因素。在医疗领域的研究发现,当人们对AI建议的准确性和质量有所怀疑时,采纳AI建议的态度会更犹豫(Nadarzynski et al., 2019);当个体为某领域的专家时,对AI在该领域提出的建议接受度则会下降(Logg et al., 2019)。最近一项研究表明,个体对AI的态度实际上是矛盾的,即既认为AI是有能力的,又担心AI的能力对人类产生威胁(Dang & Liu, 2021)。类似地,在中国老年人中的一项调查发现,感知AI能力强会引发老人关于经济、技术和隐私方面的担忧;而感知AI温暖性则会减少这些担忧(Liu et al., 2021)。

2.5相关经验

基于职业、文化程度和年龄的不同,人们对人工智能的熟悉度会不同(Young et al., 2009)。对人工智能是否熟悉影响了人们采用其建议的程度。对创新技术熟悉度高的用户由于对技术有第一手的知识,会更多地从有用性的角度去衡量其价值,对技术的接受度也更高(Young et al., 2009)。相反,对新技术熟悉度较低的用户对AI的了解更模糊和间接,更容易受到主观规范(如,他人意见)的影响(Belanch et al., 2019)。研究者发现,参与者与AI进行有趣且体验感强的合作任务能够正向影响个体对AI的印象,即在与AI进行积极互动后,个体对AI的评价更高、认为与AI相处更舒服(Paetzel et al., 2020)。但是,并不是对AI认知的所有维度都会随互动次数增加而产生线性变化,如感知到的能力、AI的拟人程度和对AI的喜爱度仅在与AI互动的前期会发生变化,之后基本保持不变;与之相反,感知威胁程度和不适感却在与AI互动的整个过程中都会发生变化(Paetzel et al., 2020)。A9D08A6C-8D3C-4567-A816-1556B9F6C0D8

除了个体本身的经验外,来自他人的经验也会对接受和使用AI产生一定作用。这种来自他人的经验,也可以被看作主观规范的来源。主观社会规范对AI建议的采纳有显著影响(Belanch et al., 2019),主要以社会信息为线索形成一种压力,使得个体在感知他人意见的基础上去执行某特定行为(Taylor & Todd, 1995)。如果上级或同事认为使用AI是正确的,那么尽管个体对AI的熟悉度较低,也会遵从他人的意见和态度去使用AI。比如在电子金融领域,个体对待新兴科技(如AI)的行为就会受到他人评论以及相关媒体新闻对该技术报道的影响(Belanche et al., 2019)。

3建议提供者的因素

在交互时,AI首先会通过其外部特征给个体留下第一印象。外部特征主要通过具体表现形式(有无实体、有无形象)和外观是否拟人化来传达。在互动过程中,AI的语言、动作、神态等会传达其“人格”特征,是“冷冰冰的机器”还是“热情洋溢的伙伴”。但并不是AI与人类越相似越好,高度拟人化的AI反而会导致“恐怖谷”效应的产生。

3.1AI的外部特征

AI的视觉外观是影响人类对其第一印象的主要因素之一,外观会影响人们与之互动时的期望,从而影响人们对AI的接受度(de Visser et al., 2016)。相关研究主要集中在对AI具体表现形式和拟人化外观方面。

目前,AI的具体表现形式可以分为实体式(有形机器人)、虚拟式(二维形象)和嵌入式(以用户看不见的形式嵌入计算机或其他工具中; Glikson & Woolley, 2020)。相比于无实体AI,实体AI能够为人类提供更多的感官输入(如视觉、触觉等),这些输入刺激会使人类认为其具有更强烈的社会存在感(Lee et al., 2006)。社会存在感与个体感知到的“真正参与到某一社交过程中的程度”有关,即是否感受到被一个社会实体所陪伴的感觉,是社会互动中的重要影响因素,是进行态度改变、说服和建议采纳的基点(Wang & Rau, 2019)。一般而言,实体机器人比虚拟机器人更具有吸引力、更可信、提供的信息更丰富、更有说服力(Glikson & Woolley, 2020)。但值得注意的是,这种影响有可能取决于参与者当时所处的环境。如研究发现,在三维环境下,实体机器人给出的建议要比虚拟机器人给出的建议更容易被采纳;但在二维环境中,虚拟机器人的建议更受欢迎(Shinozawa et al., 2005)。这表明,AI呈现形式与任务所处环境的一致性会对人类采纳建议的倾向产生影响。

由于与人类的相似性,AI外观的拟人化是研究的热门话题之一。比如,下巴较短的类人机器人能够预测机器人的社交性,因此人们也更容易采纳短下巴机器人的建议(Powers & Kiesler, 2006); 增加对服务型机器人似人外观的感知能够提高顾客对其服务的满意度(Yam et al., 2020)。另外,AI拟人化的非言语信息也会对建议采纳、说服等社会行为产生影响。这些非言语信息包括身体姿态(如距离、 凝视、 手势、 面部表情)和声音线索(音调、 音色)等。相比于没有非语言线索,当AI使用非语言线索时,人们会更愿意采纳机器人的建议。如,人们更容易采纳发出男性声音AI的建议(Powers & Kiesler, 2006); 而男性更愿意听取女性机器人的建议进行捐赠(Siegel et al., 2009)。使用手势可以提高建議采纳(Chidambaram et al., 2012),但也有研究发现,机器人同时使用凝视和手势时说服力才会增强,而单独使用手势则会削弱机器人的说服力(Ham et al., 2015)。

根据心灵感知理论,与人类相似的外表提供的社会线索使得人们将无生命的AI当作另一个人类, 认为AI具有与人类一般的心智(Wang & Krumhuber, 2018),从而引起个体对其的信任(de Visser et al., 2016)、共情(Pelau et al., 2021)等感受,并促进合作(Martin et al., 2020)和进一步的交往意愿。

3.2AI的“人格特征”

不少研究者考察了AI的大五人格是否会影响个体对其的接受程度,个体对外倾性高的AI的印象更积极,并且认为其更加有趣(Chang et al., 2018);同时,也有研究者认为,AI的自动化、系统化和有秩序体现的是尽责性,在工作场所中能与尽责性低的员工形成互补(Tang et al., 2021),从而提高其接受度。除大五人格之外,有知识的AI和友善的AI能够正向预测个体对AI建议的采纳程度(Powers & Kiesler, 2006)。并且,提高AI的自主性能够通过增强个体对AI的能力和温暖维度上的感知,从而提高个体使用AI的意愿和行为。具体来说,相比于思维自主性,提高AI感觉自主性和行动自主性在个体对其能力维度上的感知作用更大(Hu et al., 2021)。

并且,对于服务型机器人而言,个体对其社交技能的要求更高(Heerink et al., 2010)。比如在商场中,顾客更喜欢外向的导购AI(Ludewig et al., 2012);而在养老院,人们更青睐于富有情感的AI(Cadman & Brewer, 2001)。研究表明,AI展示出的性格特征与参与者的性格相匹配时,参与者会对AI产生更强的偏好(Aly & Tapus, 2015),如当计算机声音表现出的个性与参与者的个性相匹配时,参与者认为计算机声音更有吸引力、更可信、更有价值,从而更可能听从该计算机的建议而购买产品(Nass & Lee, 2001)。

3.3“恐怖谷”效应

“恐怖谷”效应最初由Mori(1970)提出,他认为个体对机器人或AI的接受度在一定范围内与AI的拟人化程度呈正相关,然而,当AI拟人化程度过高直至接近真人时,个体对其的接受度会显著下降。不仅如此,Gray和Wegner(2012)认为,个体感知AI体验性过高也会导致恐怖谷效应。推究其解释,研究者认为这是个体期待与现实不符的结果(K?tsyri et al., 2015)。比如,人们普遍认为AI本质上缺乏体验性,那么当AI具有传达体验性的能力时,如能够表达情绪的眼神和语气,人们就会感受到不安和焦躁(Gray & Wegner, 2012)。类似地,研究发现相比于拥有自我控制能力的AI,拥有感受能力的AI会让个体感到更怪诞和阴森。但当AI的角色为照料者时,个体的怪诞感受则会减少(Appel et al., 2020)。A9D08A6C-8D3C-4567-A816-1556B9F6C0D8

基于现有研究,学者提出两类观点来解释“恐怖谷”效应(Zhang et al., 2020)。第一类观点基于进化心理学,认为“恐怖谷”效应来源于AI和机器人的外观本身,威胁到人类的存在;第二类观点则基于认知冲突,认为当AI的表现和自己的期望不吻合时,人们会产生怪诞感受。

4人-AI交互过程

建议采纳是个动态的过程,必须存在接受者和建议者AI的互动才能完成。个体在不同任务情境、不同交互方式下对AI所提的建议也会有不一样的评估。

4.1任务特征

研究者通过操纵建议者(人vs. AI)和任务类型的匹配,探讨任务类型与建议采纳的关系(Hertz & Wiese, 2019)。结果发现,无论在何种条件下,在社交任务中的参与者都更加偏爱人类提出的建议;相反,在分析任务中的参与者则对AI的建议有更高的遵从率。类似地,另一项研究发现,人们在社交任务中会更信任与人类相似的AI,而在分析任务中更信任机器形式的AI (Hertz & Wiese, 2019)。

也有研究者认为,人们会根据AI执行的功能而对AI产生不同心灵感知,如社交任务中的AI被认为更具有体验性,而在经济型任务中的AI则更具有能动性(Wang & Krumhuber, 2018)。这是因为与执行经济型功能的AI相比,人们会认为执行社交型任务的AI具有更多的情绪体验。这也在一定程度上解释了人类为何会在不同任务情境下对不同类型AI建议的接受度有所差别。

前文论述了个体对具有不同人格特征AI的偏好,但是这一效应也会被任务特征所影响。如,在康复中心人们更喜欢外倾性AI,而不是内倾性AI; 然而在执行安全任务时, 与外倾性AI相比, 人们更偏好内倾性高的AI(Tay et al., 2014)。此外,外倾性个体更喜欢外倾性的AI导游,而内倾型个体更喜欢内向的AI清洁工。即表明,个体对机器人个性的偏好取决于机器人的角色背景和对个别工作的刻板印象(Joosse et al., 2013)。这与建议采纳领域中的研究一致,当决策者认为建议者更聪敏、更准确或更专业时,对相应建议的采纳程度更高(Leong & Zaki, 2018)。

4.2交互方式

人际互动能够引发观点采择,而人们可以通过观点采择而缩小自我与他人之间的差异(Ames et al., 2008)。根据心灵感知理论,与AI进行互动也可以使人类认为AI与自身更加相似,具有心智(Waytz et al., 2010)。当个体认为AI具有心智时,会与其更加亲近,从而影响个体对AI的使用意愿(Lee et al., 2020)。

由于最初设计机器人是为了帮助人类完成工作、提高效率,因此人们会认为机器人在执行任务时仅仅关注于动作的完成,而缺乏对动作意图的认识(Kim & Duhachek, 2020)。当AI仅注重于动作“怎样”完成时,表示其能动性达到了一定水平;但由于缺乏对“为什么”完成动作的认知,所以AI缺乏特定的体验。因此,当AI提供的建议聚焦于“怎样”,而非“为什么”时,个体会产生匹配、符合期待的感受,从而更容易被AI说服(Kim & Duhachek, 2020)。

另外,有学者认为,沉浸体验(flow experience)也应该被添加到研究框架中(Oh & Yoon, 2014),沉浸体验是指个体所有注意力都集中在当下活动上且产生愉快的体验(Ghani & Deshpande, 1994)。有关沉浸体验的研究集中在互联网、电视节目以及计算机使用方面(Oh & Yoon, 2014),这些研究都发现沉浸体验可以提高个体对提供信息的接受程度,或许可以为人类采纳AI建议提供新的研究方向。

5影响AI接受度的理论解释

本文整理了近几十年较为流行的解释人机互动的理论模型,包括经典的技术接受模型、计算机作为行动者范式,以及认知科学领域的心灵感知理论和预测加工理论。

5.1技术接受模型

技术接受模型(Technology Acceptance Model, TAM; Davis, 1989)是所有人-机互动模型中广为接受和使用的模型之一。该模型认为,当个体感知到使用一个系统能帮助他们在工作上表现更好时,就会倾向于使用该系统;同时,如果个体认为该系统难以操作,且使用该系统付出的努力超过获得的益处时,使用意愿会削弱。研究者将前者归纳为感知有用性,將后者命名为感知易用性,并认为这两者是决定个体是否愿意使用该系统的关键因素(Davis, 1989)。感知有用性和感知易用性会通过影响个体对使用系统的态度,从而进一步影响使用意愿,甚至实际的使用行为。

但是,TAM的缺陷在于只关注个体对机器功能性的感知,而忽视了社会因素,因此,后续研究者提出TAM2对原有模型进行补充,以适用于更广的范围(Venkatesh & Davis, 1996)。TAM2提出了社会影响和认知因素两组概念来提高个体感知到的有用性。前者主要通过个体对使用该系统给自己带来的影响而改变感知有用性(如采纳AI的建议是否会得到他人赞赏),后者通过个体对系统输出结果的认知而起作用(如采纳AI的建议是否能提高工作效率)。

5.2计算机作为行动者范式

计算机作为行动者范式(Computers As Social Actors, CASA; Nass et al., 1994)指出,人类会自发地将计算机、电视等传播媒介当作社会行动者,并采用相应的社会规则与之互动。这是因为个体会无意识地对媒介传达出的社会线索进行加工,比如,当AI发出女性声音时,人们会自发地认为在与女性互动,并采用与女性交往的社会规范与其交流。同时,CASA的提出者并不认为计算机的拟人化是个体将其当作社会行动者的先决条件(Nass & Moon, 2000)。换句话说,个体并不需要认为AI拥有心智,也会与其进行社会化交互。但是,这一论点也迅速受到了挑战。研究发现,拟人化倾向——个体在多大程度上将非人类实体当作人——会影响到人与计算机的交互(Lee, 2010)。拟人化倾向低的个体,仅将计算机看作一种完成任务的工具,而拟人化倾向高的个体则不然。A9D08A6C-8D3C-4567-A816-1556B9F6C0D8

综上所述,当个体无意识地采用CASA范式时,接受来自AI的建议与接受来自他人的建议一样,受到建议者特征(如,性别、专业程度、人格等)和任务特征(如,计算任务或社交任务)的影响,同时也会存在以自我为中心对建议进行加权的现象,即不信任AI的建议。

5.3心灵感知理论

Gray等人(2007)提出的心灵感知理论认为,个体分别从能动和体验两个维度对人类和非人类实体进行感知。许多研究通过考察个体对AI能动性和体验性维度上的感知,探索影响个体接受AI建议或服务的因素(Yam et al., 2020)。能动是指思考、计划和自愿行动的能力;体验则为感觉情绪、痛苦和愉悦的能力。如成年人被认为具有高能动性和高体验性,而婴儿则被认为具有高体验性和低能动性。由于设计机器人/AI的初衷是帮助人类提高生产效率和计算精度(Young & Monroe, 2019),因此AI总是被人们认为是具有较高能动性而低体验性的(Gray & Wegner, 2012)。许多研究者从此角度出发,对影响个体接受AI的程度进行大量探索,并做出相应的解释和预测(Lee et al., 2020)。在建议采纳领域,决策者是否采纳建议既会受到建议专业度、合理性的影响(与建议者能动性有关),也会受到交互过程中感受的影响(与建议者和决策者体验性有关)。因此,心灵感知理论可以为进一步探索与AI相关的建议采纳提供理论基础。

5.4预测加工理论

前文中提到,个体对AI的行为模式是具有一定期待的,即在脑海中存在相关行为框架。当AI的表现与期待不相符合时,会引发个体强烈的情绪反应(Shank et al., 2019)、产生不匹配的感受(Kim & Duhachek, 2020)、出现“恐怖谷”效应(Mori, 1970),进而影响到对AI的接受程度。这些现象可以被预测加工理论(Predictive Processing; Clark, 2018)所概括。该理论指出,个体会根据已有的框架对动态环境(AI)进行永不停息的预测,如果预测与实际情况相吻合,则人与环境(AI)的互动就可以顺畅进行;如果预测与实际情况不相符,则会出现“预测偏差”,使得个体重新架构框架或者改变环境,以达到预测与实际相一致。

对于人和AI的互动而言,如果个体认为有AI能力做出决策,那么AI做出决策的行为就与个体预测相一致;如果个体认为AI不具有共情能力,而AI对情绪的解读和传达与个体的预测不一致,此时个体就要采取相应的行为或思维方式消除“预测偏差”,如认为AI不可靠或可能对人类产生威胁。

6未来研究展望

通过对文献的梳理可以发现,有关个体对AI接受度的研究已经取得了一些有意义的成果,但是整体而言相对松散,无法形成明确的结构体系,也缺乏成熟的路径模型指导如何充分利用AI建议者。因此,本文在梳理现有研究的基础上,从“AI(建议者)—人(决策者)—系统”的角度整理了相关研究和理论模型,探讨影响人们接受AI建议的因素,并提出亟待探讨的未来研究方向,以期为相关研究提供启发。

6.1明确化AI感知对建议采纳的机制及调节作用如前所述,人们做不受情感影响的决策时更容易接受AI建议(如公正),但做需要感受性较强的决策时更容易拒绝AI建议(如购物销售)。这与“AI擅长计算却缺乏感受”的心灵知觉有关,与心灵感知理论相关的大部分研究都支持这一观点。然而,人们为什么对AI有此种感知,其机理尚不清楚。先前研究认为这种感觉是人类自然而然产生的解释 (邓世昌等, 2022;Longoni et al., 2019)。这种观点既缺乏解释力,也不能为后续的深层探究提供明确的机制,因此后续研究需要进一步探究该感知产生的原因和机制。同时,利用该感知的规律去探索AI接受度的调节作用也是必要的,从而为在适宜的场景下充分、有效利用AI建议者奠定基础。

6.2清晰化人对AI建议者偏好的情境

未来研究可以探索人们何时可能对AI建议比人类建议更多偏好的情境。例如,需要高度准确性的建议时,AI建议者可能比人类提供者更受欢迎。另外,当人们需要吐露某种隐私或秘密以得到建议时,AI建议者可能也比人类更受欢迎。更重要的是,目前研究中,对AI建议者影响建议采纳的研究大部分是基于决策者的人类属性作为延伸(如性别、专业程度、人格等)进行比较的。但AI不同于人类的部分也可能会促进建议采纳。如根据建议采纳领域中的面子理论,人们在收到他人建议时面子会受到威胁从而影响建议接受度(Brown & Levinson, 1987)。此领域的相关研究通常都是以人为主体,人和人之间存在的共同基础所导致的差异(如社会比较)可能是引起决策者抗拒建议的来源。若将建议者换成AI,由于人和AI缺乏共同基础(尤其是社会比较的基础),此时有可能较好地消除面子威胁,让人们更容易接受建议,做出更优决策。

6.3精细化人在AI不同角色特征下的感知和态度尽管有研究注意到区分AI的工具性角色和服务性角色(Hertz & Wiese, 2019),但有所欠缺的则是对个体主观感受测量方式的模糊,常常以“态度”“接受度”等笼统词汇概括,且测量维度往往是单维的,如“积极/消极”(Dang & Liu et al., 2021)。无法清晰地反映个体对AI矛盾、复杂的态度,更无法体现个体如何应对AI的广泛应用给人类社会带来的冲击。因此,未来研究者可以尝试从多维角度进行分析,更細致地划分个体对AI的态度和建议接受度,可能会得到更一致的结果。

6.4动态化AI-人互动过程中的心理模型

后续研究需要构建AI-人互动的心理模型,同时需要探究随着时间的推移,人与AI的互动如何影响建议采纳,以及这种互动如何改变心理模型。从工具性/能动性角度分析,与过去机器不同,AI需要很少(甚至不需要)人工操控和命令即能完成一系列行动;从服务性/体验性角度分析,智能特性使得AI能够与使用者进行情感上的交流互动。这意味着在人与AI的互动中,AI不再是被动的接受方,而人类也不再是唯一的主动发起方,两者在交往中的作用是相互的(许为, 2020)。因此后续研究不仅需要建构AI和人的初始心理模型,还需要探究心理模型中的初始属性如何改变后续的交互风格,以及交互的各个方面如何改变未来的心理模型。此外,AI在工具性方面的主动虽然可以节省人力资源、提高效率,但同时也意味着会导致部分员工失业;AI在服务性方面的主动可以为人类提供社会支持、满足人类情感需求,但具有情绪也意味着对人类社会的威胁。因此,人类也需要不断地探索相应的应对方式。A9D08A6C-8D3C-4567-A816-1556B9F6C0D8

參考文献

邓士昌, 许祺, 张晶晶, 李象千 (2022). 基于心灵知觉理论的AI服务用户接受机制及使用促进策略. 心理科学进展, 30(4), 723-737.

衡书鹏, 赵换方, 孙丽君, 周宗奎 (2019). 虚拟销售代理的拟人效应. 心理科学进展, 27(5), 884-904.

许为 (2020). 五论以用户为中心的设计:从自动化到智能时代的自主化以及自动驾驶车. 应用心理学, 26(2), 108-128.

Aly, A., & Tapus, A. (2015). Towards an intelligent system for generating an adapted verbal and nonverbal combined behavior in human-robot interaction. Autonomous Robots, 40(2), 1-17.

Ames, D. L., Jenkins, A. C., Banaji, M. R., & Mitchell, J. P. (2008). Taking another persons perspective increases self-referential neural processing. Psychological Science, 19(7), 642-644.

Appel, M., Izydorczyk, D., Weber, S., Mara, M., & Lischetzke, T. (2020). The uncanny of mind in a machine: Humanoid robots as tools, agents, and experiencers. Computers in Human Behavior, 102, 274-286.

Belanche, D., Casaló, L. V., & Flavián, C. (2019). Artificial intelligence in FinTech: Understanding roboadvisors adop-tion among customers. Industrial Management and Data Systems, 119(7), 1411-1430.

Bigman, Y. E., Yam, K. C., Marciano, D., Reynolds, S. J., & Gray, K. (2021). Threat of racial and economic inequality increases preference for algorithm decision-making. Computers in Human Behavior, 122, Article 106859.

Brown, P., & Levinson, S. C. (1987). Politeness: Some universals in language usage. Cambridge: University Press.

Cadman, C., & Brewer, J. (2001). Emotional intelligence: A vital prerequisite for recruitment in nursing. Journal of Nursing Management, 9(6), 321-324.

Chang, R. C. S., Lu, H. P., & Yang, P. (2018). Stereotypes or golden rules? Exploring likable voice traits of social robots as active aging companions for tech-savvy baby boomers in Taiwan. Computers in Human Behavior, 84, 194-210.

Chidambaram, V., Chiang, Y. H., & Mutlu, B. (2012, March). Designing persuasive robots: how robots might persuade people using vocal and nonverbal cues. In Proceedings of the seventh annual ACM/IEEE international conference on Human-Robot Interaction (pp. 293-300).

Clark, A. (2018). A nice surprise? Predictive processing and the active pursuit of novelty. Phenomenology and the Cognitive Sciences, 17(3), 521-534.

Collins, E. C., Percy, E. J., Smith, E. R., & Kruschke, J. K. (2011). Integrating advice and experience: Learning and decision making with social and nonsocial cues. Journal of Personality and Social Psychology, 100(6), 967-982.A9D08A6C-8D3C-4567-A816-1556B9F6C0D8

Dang, J., & Liu, L. (2021). Robots are friends as well as foes: Ambivalent attitudes toward mindful and mindless AI robots in the United States and China. Computers in Human Behavior, 115, Article 106612.

Davis, F. D. (1989). Perceived usefulness, perceived ease of use, and user acceptance of information technology. MIS Quarterly, 13(3), 319-340.

de Visser, E. J., Monfort, S. S., McKendrick, R., Smith, M. A. B., McKnight, P. E., Krueger, F., & Parasuraman, R. (2016). Almost human: Anthropomorphism increases trust resilience in cognitive agents. Journal of Experimental Psychology: Applied, 22(3), 331-349.

Donghee. (2021). The effects of explainability and causability on perception, trust, and acceptance: Implications for explainable AI. International Journal of Human-Computer Studies, 146, Article102551.

Epley, N., Waytz, A., & Cacioppo, J. T. (2007). On Seeing Human: A three-factor theory of anthropomorphism. Psychological Review, 114(4), 864-886.

Ghani, J. A., & Deshpande, S. P. (1994). Task characteristics and the experience of optimal flow in human-computer interaction. The Journal of Psychology: Interdisciplinary and Applied, 128(4), 381-391.

Gino, F., & Schweitzer, M. E. (2008). Blinded by anger or feeling the love: How emotions influence advice taking. Journal of Applied Psychology, 93(5), 1165-1173.

Glikson, E., & Woolley, A. W. (2020). Human trust in artificial intelligence: Review of empirical research. Academy of Management Annals, 14(2), 627-660.

Gray, H. M., Gray, K., & Wegner, D. M. (2007). Dimensions of mind perception. Science, 315(5812), 619-619.

Gray, K., & Wegner, D. M. (2012). Feeling robots and human zombies: Mind perception and the uncanny valley. Cognition, 125(1), 125-130.

Ham, J., Cuijpers, R. H., & Cabibihan, J. J. (2015). Combining robotic persuasive strategies: The persuasive power of a storytelling robot that uses gazing and gestures. International Journal of Social Robotics, 7(4), 479-487.

Haran, U., & Shalvi, S. (2020). The implicit honesty premium: Why honest advice is more persuasive than highly informed advice. Journal of Experimental Psychology: General, 149(4), 757-773.

Heerink, M., Kr?se, B., Evers, V., & Wielinga, B. (2010). Assessing acceptance of assistive social agent technology by older adults: The almere model. International Journal of Social Robotics, 2(4), 361-375.A9D08A6C-8D3C-4567-A816-1556B9F6C0D8

Hertz, N., Wiese, E. (2019). Good advice is beyond all price, but what if it comes from a machine? Journal of Experimental Psychology: Applied, 3(25), 386-395.

Hu, Q., Lu, Y., Pan, Z., Gong, Y., & Yang, Z. (2021). Can AI artifacts influence human cognition? The effects of artificial autonomy in intelligent personal assistants. International Journal of Information Management, 56, Article 102250.

Huang, M. H., & Rust, R. T. (2018). Artificial intelligence in service. Journal of Service Research, 21(2), 155-172.

Joosse, M., Lohse, M., Pérez, J. G., & Evers, V. (2013, May). What you do is who you are: The role of task context in perceived social robot personality. In 2013 IEEE international conference on robotics and automation (pp. 2134-2139). IEEE.

Jung, D., Dorner, V., Glaser, F., & Morana, S. (2018). Robo-advisory: Digitalization and automation of financial advisory. Business and Information Systems Engineering, 60 (1), 81-86.

K?tsyri, J., F?rger, K., M?k?r?inen, M., & Takala, T. (2015). A review of empirical evidence on different uncanny valley hypotheses: Support for perceptual mismatch as one road to the valley of eeriness. Frontiers in Psychology, 6, 390-406.

Kim, T. W., & Duhachek, A. (2020). Artificial intelligence and persuasion: A construal-level account. Psychological Science, 31(4), 363-380.

Lee, E. J. (2010). What triggers social responses to flattering computers? Experimental tests of anthropomorphism and mindlessness explanations. Communication Research, 37(2), 191-214.

Lee, K. M., Jung, Y., Kim, J., & Kim, S. R. (2006). Are physically embodied social agents better than disembodied socialagents? The effects of physical embodiment, tactile interaction, and peoples loneliness in human-robot interaction. International Journal of Human Computer Studies, 64(10), 962-973.

Lee, S., Lee, N., & Sah, Y. J. (2020). Perceiving a mind in a chatbot: Effect of mind perception and social cues on co-presence, closeness, and intention to use. International Journal of Human-Computer Interaction, 36(10), 930-940.

Leong, Y. C., & Zaki, J. (2018). Unrealistic optimism in advice taking: A computational account. Journal of Experimental Psychology: General, 147(2), 170-189.

Liu, S. X., Shen, Q., & Hancock, J. (2021). Can a social robot be too warm or too competent? Older Chinese adultsperceptions of social robots and vulnerabilities. Computers in Human Behavior, 125, Article 106942.A9D08A6C-8D3C-4567-A816-1556B9F6C0D8

Logg, J. M., Minson, J. A., & Moore, D. A. (2019). Algorithm appreciation: People prefer algorithmic to human judgment. Organizational Behavior and Human Decision Processes, 151, 90-103.

Longoni, C., Bonezzi, A., & Morewedge, C. K. (2019). Resistance to medical artificial intelligence. The Journal of Consumer Research, 46(4), 629-650.

Looije, R., Neerincx, M. A., & Cnossen, F. (2010). Persuasive robotic assistant for health self-management of older adults: Design and evaluation of social behaviors. International Journal of Human-Computer Studies, 68(6), 386-397.

Ludewig, Y., D?ring, N., & Exner, N. (2012, September). Design and evaluation of the personality trait extraversion of a shopping robot. In 2012 IEEE RO-MAN: The 21st IEEE international symposium on robot and human interactive communication (pp. 372-379).

Martin, B A. S., Jin, H. S., Wang, D., Nguyen, H., Zhan, K., Wang, Y. X. (2020). The influence of consumer anthropomorphism on attitudes towards artificial intelligence trip advisors. Journal of Hospitality and Tourism Management, 44, 108-111.

Mercado, J. E., Rupp, M. A., Chen, J. Y. C., Barnes, M. J., Barber, D., & Procci, K. (2016). Intelligent agent transparency in human-agent teaming for Multi-UxV management. Human Factors, 58(3), 401-415.

Mori, M. (1970). The uncanny valley. Energy, 7(4), 33-35.

Nadarzynski, T., Miles, O., Cowie, A., & Ridge, D. (2019). Acceptability of artificial intelligence (AI)-led chatbot services in healthcare: A mixed-methods study. Digital Health, 5(1), Article 2055207619871808.

Nass, C., & Lee, K. M. (2001). Does computer-synthesized speech manifest personality? Experimental tests of recognition, similarity-attraction, and consistency-attraction. Journal of Experimental Psychology: Applied, 7(3), 171-181.

Nass, C., & Moon, Y. (2000). Machines and mindlessness: Social responses to computers. Journal of Social Issues, 56(1), 81-103.

Nass, C., Steuer, J., & Tauber, E. R. (1994). Computers are social actors. InProceedings of the SIGCHI conference on human factors in computing systems (pp. 72-78), New York:ACM Press.

Nomura, T., Kanda, T., & Suzuki, T. (2006). Experimental investigation into influence of negative attitudes toward robots on human-robot interaction. AI & Society, 20(2), 138-150.

Oh, J. C., & Yoon, S. J. (2014). Predicting the use of online information services based on a modified UTAUT model. Behaviour & Information Technology, 33(7), 716-729.A9D08A6C-8D3C-4567-A816-1556B9F6C0D8

Orben, A. (2020). Thesisyphean cycle of technology panics. Perspectives on Psychological Science, 15(5), 1143-1157.

Paetzel, M., Perugia, G., & Castellano, G. (2020, March). The persistence of first impressions: The effect of repeated interactions on the perception of a social robot. In Proceedings of the 2020 ACM/IEEE international conference on human-robot interaction (pp. 73-82).

Pelau, C., Dabija, D. C., & Ene, I. (2021). What makes an AI device human-like? The role of interaction quality, empathy and perceived psychological anthropomorphic characteristics in the acceptance of artificial intelligence in the service industry. Computers in Human Behavior, 122, Article 106855.

Powers, A., & Kiesler, S. (2006). The advisor robot: tracing peoples mental model from a robots physical attributes. InProceedings of the 1st ACM SIGCHI/SIGART conference on human-robot interaction (pp. 218-225), Salt Lake City.

Schaefer, K. E., Chen, J. Y., Szalma, J. L., & Hancock, P. A. (2016). A meta-analysis of factors influencing the development of trust in automation: Implications for understanding autonomy in future systems. Human Factors, 58(3), 377-400.

Shank, D. B., Graves, C., Gott, A., Gamez, P., & Rodriguez, S. (2019). Feeling our way to machine minds: Peoples emotions when perceiving mind in artificial intelligence. Computers in Human Behavior, 98, 256-266.

Shanmuganathan, M. (2020). Behavioural finance in an era of artificial intelligence: Longitudinal case study of robo-advisors in investment decisions. Journal of Behavioral and Experimental Finance, 27, Article 100297.

Shinozawa, K., Naya, F., Yamato, J., & Kogure, K. (2005). Differences in effect of robot and screen agent recommendations on human decision-making. International Journal of Human Computer Studies, 62(2), 267-279.

Siegel, M., Breazeal, C., & Norton, M. I. (2009). Persuasive robotics: The influence of robot gender on human behavior. In2009 IEEE/RSJ International conference on intelligent robots and systems (pp. 2563-2568), St. Louis.

Smith, E. R., Sherrin, S., Fraune, M. R., & ?abanovi, S. (2020). Positive emotions, more than anxiety or other negative emotions, predict willingness to interact with robots. Personality and Social Psychology Bulletin, 46(8), 1270-1283.

Takayanagi, K., Kirita, T., & Shibata, T. (2014). Comparison of verbal and emotional responses of elderly people with mild/moderate dementia and those with severe dementia in responses to seal robot, PARO. Frontiers in Aging Neuroscience, 6, 257-262.A9D08A6C-8D3C-4567-A816-1556B9F6C0D8

Tang, P. M., Koopman, J., McClean, S. T., Zhang, J. H., Li, C. H., De Cremer, D., ... & Ng, C. T. S. (2021). When conscientious employees meet intelligent machines: An integrative approach inspired by complementarity theory and role theory. Academy of Management Journal. Advance online publication.

Tay, B., Jung, Y., & Park, T. (2014). When stereotypes meet robots: the double-edge sword of robot gender and personality in human-robot interaction. Computers in Human Behavior, 38, 75-84.

Taylor, S., & Todd, P. A. (1995). Understanding information technology usage: A test of competing models. Information Systems Research, 5(2), 91-108.

Venkatesh, V., & Davis, F. D. (1996). A model of the antecedents of perceived ease of use: Development and test. Decision Sciences, 27(3), 451-481.

Venkatesh, V., Morris, M. G., Davis, G. B., & Davis, F. D. (2003). User acceptance of information technology: Toward a unified view. MIS Quarterly, 27(3), 425-478.

W?rn, Y., & Ramberg, R. (1996). Peoples perception of human and computer advice. Computers in Human Behavior, 12, 17-27.

Wang, B., & Rau, P. L. P. (2019). Influence of embodiment and substrate of social robots on users decision-making and attitude. International Journal of Social Robotics, 11(3), 411-421.

Wang, X., & Krumhuber, E. G. (2018). Mind perception of robots varies with their economic versus social function. Frontiers in Psychology, 9, Article 1230.

Waytz, A., Gray, K., Epley, N., & Wegner, D. M. (2010). Causes and consequences of mind perception. Trends Cognitive Science, 14(8), 383-388.

Wien, A. H., & Peluso, A. M. (2021). Influence of human versus AI recommenders: The roles of product type and cognitive processes. Journal of Business Research, 137, 13-27.

Yam, K. C., Bigman, Y. E., Tang, P. M., Ilies, R., De Cremer, D., Soh, H., & Gray, K. (2020). Robots at work: People prefer—and forgive—service robots with perceived feelings. Journal of Applied Psychology, 106(10), 1557-1572.

Young, A. D., & Monroe, A. E. (2019). Autonomous morals: Inferences of mind predict acceptance of AI behavior in sacrificial moral dilemmas. Journal of Experimental Social Psychology, 85, Article 103870.

Young, J. E., Hawkins, R., Sharlin, E., & Igarashi, T. (2009). Toward acceptable domestic robots: Applying insights from social psychology. International Journal of Social Robotics, 1(1), 95-108.A9D08A6C-8D3C-4567-A816-1556B9F6C0D8

Zhang, J., Li, S., Zhang, J. Y., Du, F., Qi, Y., & Liu, X. (2020). A literature review of the research on the uncanny valley. InInternational conference on human-computer interaction (pp. 255-268).

The Influencing Factors on Peoples Acceptance of Artificial Intelligences AdviceLI Sixian; CHEN Jiaxin; SONG Aijia; WANG Menglin; DUAN Jinyun

(School of Psychology and Cognitive Science, East China Normal University, Shanghai 200062, China)Abstract

Artificial intelligence (AI) application is gradually infiltrating into daily aspects of human society. AI applications can greatly conserve resources for users, such as time and efforts. But most people are still reluctant to accept the services and suggestions provided by AI applications. Therefore, this paper aims to discuss the factors that influence individualsacceptance of AI advice from three main perspectives. Specifically, by adopting JAS (Judge-Advisor System) paradigm, we discuss it from the decision-maker (human) aspect (e.g., cognition, emotion, attitudes), advisor (AI) aspect (e.g., external features, personality characteristics), as well as human-AI interaction (system) aspect. With the developing stream of intelligent machines, we also sort out relevant theories that explain individualsacceptance of AIs advice, such as Technology Acceptance Model, Computers as Social Actors Paradigm, the Mind Perception Theory and Predictive Processing Theory. Finally, based on the arguments, future research for acceptance of AI applications can focus on more detailed underlying mechanism, situational factors, and build a more dynamic and comprehensive psychological model.

Key words: artificial intelligences advice; advice-taking; human-robot interaction; judge-advisor systemA9D08A6C-8D3C-4567-A816-1556B9F6C0D8