基于机器视觉的内燃机试验台架火灾监测方法

孙淑军,郭永刚,刘 杰

(1. 内燃机可靠性国家重点试验室,山东 潍坊 261061;2. 潍柴动力股份有限公司,山东 潍坊 261061)

1 引言

内燃机试验台架在实际作业过程中有许多高温源,如内燃机增压器、排气管等,同时台架内部也存在许多易燃物,如燃气、燃油、机油、防冻液等,一旦台架内部发生故障很容易引发火灾,如果火灾不能被及时扑灭会造成极大的经济损失。因此发生初期火灾时报警系统能够及时触发报警尤为重要。

目前试验台架内部主要借助紫外和红外火焰探测器对火焰进行监控,但是受探测器实际安装位置和探测角度有限的影响,在试验台架内部一些位置发生初期火焰时,探测器无法探测到火焰从而无法可靠触发报警,错过灭火最佳时期。而试验台架内部有相当完善的摄像头监控系统,每个试验台架部署有2个以上网络监控摄像头,基本实现了对试验台架内部的无死角监控,且图片信息随时可以通过网络推送到移动客户端等供相关用户查看。正式借助网络摄像头视野广的优势和试验室完善的智能报警安防系统,本文提出了基于机器视觉的台架火灾监测方法。

本监测方法首先获取网络摄像头传输的视频流,然后通过算法获取每一帧图片中可能为火焰的静态区域,并结合帧间特征将动态区域进行捕获,利用两者的交集经过一定的算法处理组合成关键特征图片,将此图片传入训练好的神经网络模型进行识别,如果识别为火焰,系统便向试验室报警安防系统发出信息,控制安防系统发出警报,从而加速初期火灾扑灭进度,提高试验台架安全性。

2 神经网络模型训练

2.1 数据集制作

火焰实际发生时受光照、摄像头参数等影响,经摄像头传输后其颜色特征极易发生变化,为了更好地针对内燃机试验台架这个特定环境,我们在台架内部进行了模拟火焰发生试验,结合真实火灾事故和网络上的部分火焰图片,本方法共收集制作了40 720张图片组成样本集,其中火焰样本集有15 100张图片,部分参与训练的火焰样本如图1所示。本火焰样本制作的目的是为了更好地发现初期火焰,因此要求样本图片中火焰像素占比尽量小同时又要防止占比过小引起训练过程中关键特征消失。因此收集的火焰图片都是经过筛选后火焰像素面积占比在6%~50%的图片。

图1 用于训练的火焰图片

实际研究过程中发现台架测功机、人员等均可能对模型识别产生干扰,因此我们采用分类神经网络模型进行训练时将图像分成了4类,分别对应火焰、测功机、人员和其他非火焰。

2.2 模型训练和验证

利用Pytorch工具对样本集进行一定的数据增强和归一化处理后,修改InceptionV3网络输出层参数以符合分类需求,然后利用该网络对制作好的样本集进行了训练和验证,训练准确度大于99%时停止训练,从而得到最终的神经网络模型。经验证,模型对验证集有很好地识别准确率,准确率大于96%。由于训练方法比较常见,本文不再详细描述训练过程。虽然模型对验证集有较高的识别度,但是在实际测试时发现模型识别视频中火焰的效果很差,分析发现摄像头传输的主流视频帧分辨率很高,一般分辨率超过1 920像素×1 080像素。实际发生初期火灾时,火焰在原始图片中的像素占比很小(面积占比一般小于2%),如果直接将整张图片传入神经网络,将极大降低火焰识别准确率。同样如果直接训练这样的图片,因为火焰关键特征像素占比很小容易导致训练过程中火焰特征消失从而使得训练识别效果非常差。

3 关键特征图像获取

通过第1章分析可得出,模型在识别较大火焰图片时效果较好,但是识别小火焰图片时效果很差。根据我们对内燃机试验台架历史火灾事故统计,96.2%以上的火焰图片为分辨率小于56像素×56像素的图片,为此有必要研究小火焰图片识别准确性的方法。因此,我们针对摄像头传来的视频帧进行了预处理:只有图片中有符合我们要求的信息时才会传入神经网络模型做进一步分析。传入神经网络模型前先对图片进行分类处理以获得关键区域,将关键特征图片分为三类,分别对应224像素×224像素、112像素×112像素和56像素×56像素这三种。具体分类由实际关键特征图片分辨率大小决定。

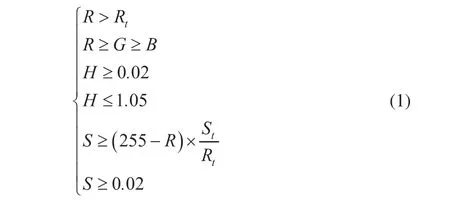

对于摄像头传来的原始帧,我们首先分析图片的特征并与火焰颜色特征进行比较,如果符合火焰颜色特征,则将符合的部分转换成二值化图片MASK1。其中火焰颜色特征主要参考何爱龙的判定规则结合台架内实际火焰特征定义规则为

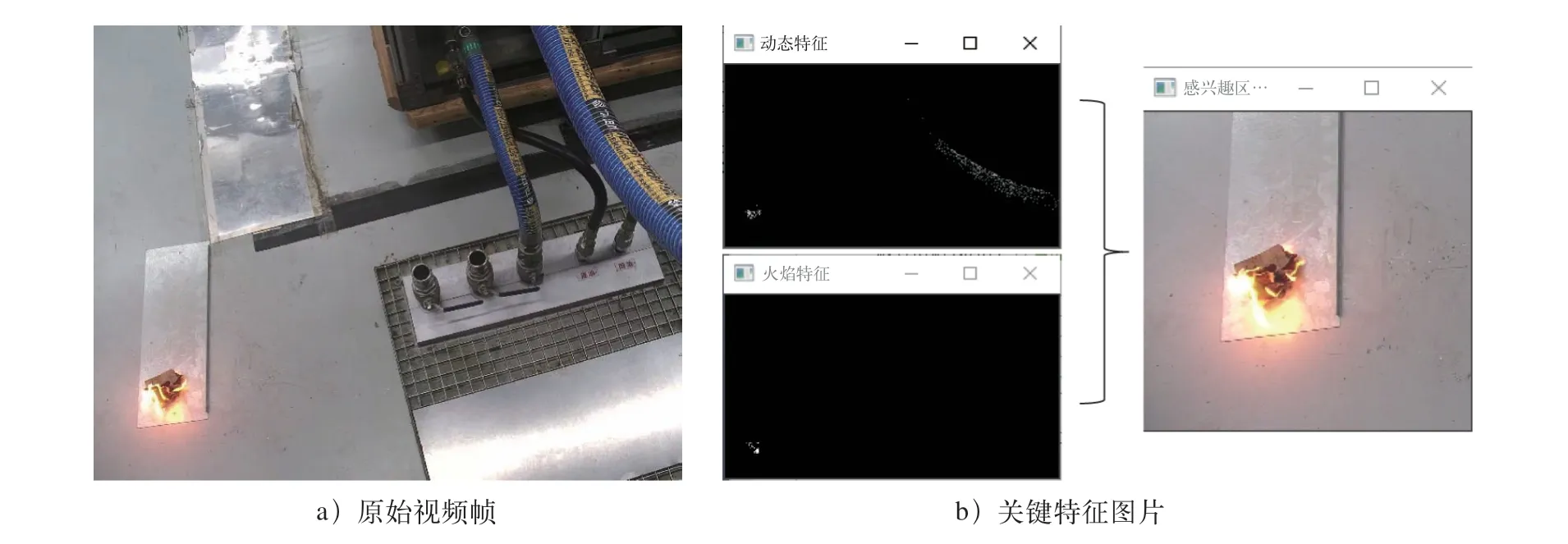

规则中,R、G、B分别代表每个像素点在RGB空间上的红色、绿色、蓝色分量;H、S代表每个像素点在HSV空间上的色调、饱和度分量;R取115,S取55。当获取完图片的火焰特征后再分析其动态特征,利用高斯混合模型来获取动态特征,同样将符合运动的部分转换成二值化图片MASK2,MASK1和MASK2的交集对应原始帧中区域便是感兴趣区域ROI,即ROI=MASK1∩MASK2,ROI经过进一步处理便可得到关键特征图片。摄像头关键特征图片获取示意图如图2所示,图2 a为摄像头传来的原始视频帧,图2 b为通过上述方法来获取关键特征图片的示意图,图2 b中左侧分别代表火焰的动态特征和火焰的颜色特征,右侧代表获取到的关键特征图。

图2 摄像头关键特征图片获取示意图

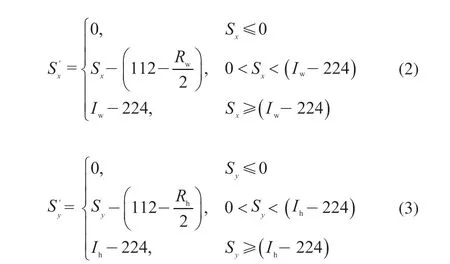

如果交集ROI为0,则本帧图片将不会被分析处理,系统将直接分析下一帧图片;如果ROI不为0,则根据ROI大小先截取关键特征区域。如前文所述,如果ROI像素大于112像素×112像素,则以图片为中心在原始帧上截取224像素×224像素分辨率的图片,截取过程中可能会因为图片中心过于靠近原始帧边界导致截取失败,此时可以根据具体边界情况适当调整,以成功获取需求的关键特征图片。首先获取ROI的起始像素点(S,S),ROI高度R和宽度R以及原始帧的高度I和宽度I,然后按下述计算公式计算关键特征图片的起始点(S’,S’):

得到起始点后,便可以根据目标分辨率截取关键特征图片。

如果分辨率大于56像素×56像素且小于112像素×112像素,则按照上述方法截取112像素×112像素分辨率的图片;获取公式与上式类似。同理当分辨率小于56像素×56像素时,按上述方法截取56像素×56像素分辨率的图片。

验证发现,火焰区域分辨率大于56像素×56像素时,模型能较好地完成火焰识别工作,当小于56像素×56像素时虽然也可以识别出火焰,但是很容易导致一些非火焰目标被误识别成火焰,为此,每当获取到一帧小于56像素×56像素分辨率的关键特征图片时,我们都继续以该图片中心为中心截取接下来连续3帧原始帧对应的区域作为关键特征图片,分辨率仍然为56像素×56像素,这样便得到了4张56像素×56像素的图片,按照从左到右从上到下的顺序把这4张图片组合成一张112像素×112像素的图片,以此作为关键特征图片传入神经网络再进行分析,如图3所示。

图3 拼接组合的火焰图片

根据关键特征图片提取算法,共提取到1 182帧关键特征。因此方法相较原始帧直接传入神经网络分析对计算机资源占用降低了98%。

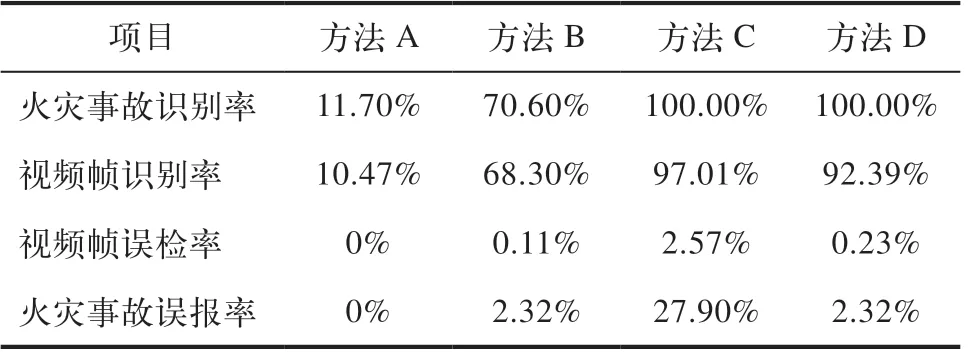

利用4种方法将图片传入同一神经网络模型后识别统计结果见表1,其中火灾事故识别率定义为在火焰发生10 s内模型监测到火焰的概率,视频帧识别率定义为每一帧火焰图片传入神经网络后被成功识别的概率,视频帧误检率定义为每一帧非火焰图片传入神经网络后被误识别成火焰图片的概率,火灾事故误报率定义为整个视频播放期间模型将非火焰目标误识别成火焰目标触发误报警的概率。表中方法A表示直接将原始帧传入神经网络分析的方法;方法B表示将所有关键特征区域截取成224像素×224像素分辨率的图片后进行分析的方法;方法C是将实际关键特征区域划分为224像素×224像素、112像素×112像素和56像素×56像素的关键特征图片后进行分析的方法;方法D是在方法C的基础上,按照上文所述拼图方法将56像素×56像素分辨率图像拼接成1张112像素×112像素图片后进行分析的方法。

表1 不同方法下火焰识别能力比较

由上表分析可知,方法A和方法B虽然几乎没有火灾事故误报率和视频帧误检率,但火焰事故识别率较低,尤其是方法A,几乎无识别能力。方法C和方法D都有很好的火灾事故识别率,虽然方法D相较方法C视频帧识别率减少了4.76%,但是视频帧误报率只有方法C的8.95%,火灾事故误报率相比方法C降低了91.68%。因此本文采用的方法D能够对内燃机试验台架内部火灾进行可靠监测同时又尽可能少的减少了误报率。

4 视频流获取与图像神经网络识别

基于前文的内容,部署模型进行内燃机试验台架火灾监控测试。利用多线程的方式分别独立获取网络摄像头视频流以及将视频流传入神经网络模型。网络摄像头是非常成熟的产品,可以利用摄像头厂家提供的SDK或者利用RTSP协议来获取视频流。然后利用OpenCV工具对视频流进行格式处理,结合第3章关键特征图片获取方法,将获取的关键特征传入OpenCV的DNN处理函数中,如果识别到火焰便以Web Sevice服务的形式传送报警指令来控制报警系统报警,从而达到火灾监测的目的。

5 结束语