基于TeleTransformer的AI时序预测算法实现

摘 要: 本论文实现了一种基于TeleTransformer的AI时间序列动态预测方法和系統,以Transformer模型为基础,自研复现NLP论文注意力算法模块,降低时间复杂度, 具有更强的长期依赖建模能力,将研究成果应用于通信运营商话务量等数据的AI时序预测。

关键词:Transformer;Attention;Encoder;Decoder;Time Series Prediction

1 背景

本文的研究成果应用于通信运营商话务量、接通率、接通次数时序预测,采用时间序列法对未来的话务量状况进行预测,客观地反映话务量的动态变化趋势,从而对话务量网络运行价值进行预测,并对管理者的智能运维决策起到指导作用,对实现正确决策具有十分重要的意义。

2 标准Transformer算法

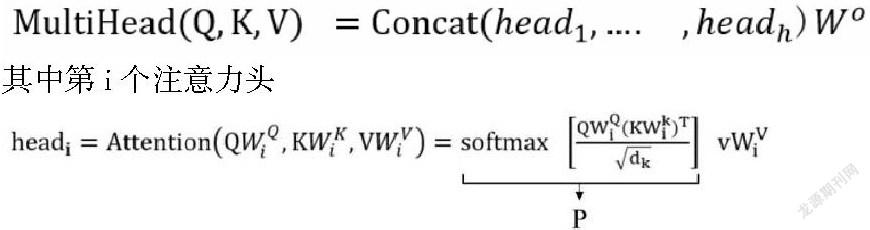

标准Transformer算法是Google团队2017年在论文《Attention is All You Need》中提出的,Transformer算法近年来在NLP自然语言处理、计算机视觉领域取得了巨大的成功,在智能对话机器人领域具有广泛的应用前景,基于Transformer算法的对话系统的轻量级语言理解(Lightweight Language Understanding for Dialogue Systems)是意图识别和实体信息抽取的统一框架、Dialogue Transformers面向多轮业务对话信息处理引入了Transformer Embedding Dialogue架构的对话策略。Transformer算法由编码器堆栈及解码器堆栈组成,其构建了多头注意力模块(Multi-Head Self Attention, MHA), 多头注意力使Transformer模型可以关注来自不同位置子空间的不同表征的信息。

3 TeleTransformer框架建设

自研TeleTransformer框架实现了编码器及解码器架构,编码器包括输入嵌入层模块,位置编码层模块、多头注意力层模块、正则化层模块、前馈神经网络模块;解码器包括输出嵌入层模块,位置编码层模块、多头注意力层(掩码)模块、正则化层模块、前馈神经网络模块、线性转换模块、Softmax层模块。

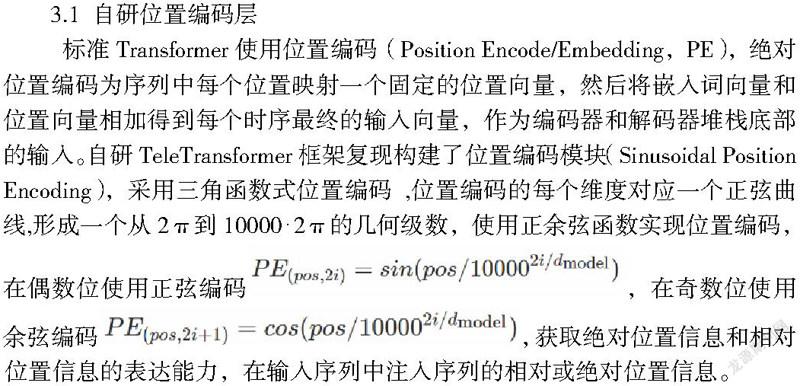

3.1 自研位置编码层

标准Transformer使用位置编码(Position Encode/Embedding,PE),绝对位置编码为序列中每个位置映射一个固定的位置向量,然后将嵌入词向量和位置向量相加得到每个时序最终的输入向量,作为编码器和解码器堆栈底部的输入。自研TeleTransformer框架复现构建了位置编码模块(Sinusoidal Position Encoding),采用三角函数式位置编码 ,位置编码的每个维度对应一个正弦曲线,形成一个从2π到10000⋅2π的几何级数,使用正余弦函数实现位置编码,在偶数位使用正弦编码,在奇数位使用余弦编码,获取绝对位置信息和相对位置信息的表达能力,在输入序列中注入序列的相对或绝对位置信息。

3.2 自研注意力层

自研AI时间序列预测框架对Transformer模型注意力机制进行改进,提升算法运行效率。标准Transformer模型在处理长序列数据时,受到自注意力模块时间复杂度和内存空间复杂度的限制,TeleTransformer对标准Transformer模型进行改进,复现了轻量级注意力模块(线性映射注意力模块、稀疏注意力模块、Nyström注意力模块、Residual注意力模块等)。

4 TeleTransformer模型改进实验

基于TeleTransformer的AI时间序列动态预测方法和系统实施例的模型改进实验。对标准Transformer的改进,涉及位置编码、多头注意力层、正则化层、前馈神经网络及编码器、解码器架构的改进,主要涉及自注意力部分的改进,降低自注意力部分计算的复杂度,学习到更长序列的依赖关系。从实验中可以看出:自相关注意力取得较好的效果,降低时间复杂度至O(N), 能够捕获时间序列输入输出之间的长依赖关系,TeleTransformer模型对激活函数较敏感,可以选择Gelu等激活函数。

5 结论及展望

自从Google在2017发布Transformer论文以来,以Transformer为核心的新一代NLP技术在短短的2年左右的时间就彻底革新了整个NLP领域,尤其是2018年的BERT极大的加速了这一革新进程,无论是学术界还是工业界(Google、Amazon、Facebook、Alibaba、Tencent、ByteDance等)的近几年NLP工作均是围绕Transformer这个新一代的NLP架构系统而展开。人工智能领域具有全球广泛影响力的科学家Andrew Ng在2021年回顾AI的最新进展中甚至说 “Originally developed for natural language processing, transformers are becoming the Swiss Army Knife of deep learning.” 其明确表示就最新AI发展进展表明Transformer已经逐步实现了“One Architecture to Do Them All”的人工智能大一统趋势。

Transformer实现一种架构,统治一切,研究人员正将其发展至更广阔的新领域,在智能对话机器人领域,Rasa是Conversational AI在智能业务对话领域工程落地全球最为成功对话机器人系统,基于Transformer架构实现了全球使用最广泛的智能业务对话机器人框架。

参考文献

[1] 《企业级AI技术内幕:深度学习框架开发+机器学习案例+Alluxio解密》 清华大学出版社 王家林、段智华

[2]《Spark大数据商业实战三部曲》第二版:清华大学出版社 王家林、段智华