一种基于可穿戴器件触觉感知信息的盲人虚拟视觉导航系统*

葛 松 林衍旎 赖舜男 徐晶晶 何宇力 赵 琦 张 弘 许胜勇**

(1)北京大学电子学院,教育部纳米器件物理与化学重点实验室,北京 100871;2)山东大学微电子学院,济南 250100;3)北京航空航天大学电子信息工程学院,北京 100191;4)北京航空航天大学宇航学院,北京 100191)

世界卫生组织报告显示,全球中度或重度视力受损或失明者人数已超过2亿,其中中国盲人约有700多万[1]。盲杖是历史最悠久的盲人辅助工具,当代社会的交通情况和生活场景复杂,仅仅依靠盲杖已经不足以完成在街道穿行、乘车、购物等复杂的生活任务。因此,长期以来各类人工视觉系统被广泛研究[2],以帮助盲人和视觉障碍人群顺利完成如读书学习、长距离旅行、购物等日常生活,甚至参加体育比赛等复杂活动。

目前,人工视觉系统的研发主要有两种技术路径。第一种是通过高技术手段帮助盲人或视觉障碍者重建部分视力,受试者通过重建的微弱视觉能力获得部分环境图像信息,自己完成图像判断、自己下达行动指令。第二种是运用技术手段分析环境图像信息,直接转化成指导受试者行动的指令信号。

第一种技术路径研制的主要是各类植入式人工视觉装置,主要包括视网膜植入装置和大脑皮层植入装置。前者称为“人工视网膜植入技术”(又称“视网膜假体”)[3],是主流技术,其核心器件在受试者体内的植入位置可以分为视网膜前[4]、视网膜下[5]、脉络膜上[6]等不同部位。目前,真正获得批准上市、应用于部分患者的只有Second Sight Medical Products团队于2013年推出的Argus II人工视网膜系统[7]。该系统利用外部摄像机捕获图像,经由数据处理、图像压缩和编码,通过无线传输技术将刺激命令发送至植入眼球的微电极阵列来刺激视网膜神经结细胞,使受试者能看见漫射光斑,恢复一定光感。由于植入器件制作工艺复杂、视网膜前有效面积小,该系统最多只有60个电极组成阵列,受试者在经过数月的训练之后,最佳状态下也只能定位一些光线下高对比度的物体,比如门框,或只能判断出眼前物体的模糊形状,在实际生活中并不能起到很好的作用。因此,Argus II系统因价格昂贵(大约15万美元)、手术复杂、实际效果欠佳,已经于2019年停止销售[4]。而全球所研发的其他十多种人工视网膜装置,有的处于临床试验阶段,有的仅发表了早期结果没有后续进展。

科学家也长期尝试在大脑视觉皮层上植入电极阵列让受试者获得视觉响应[4]。相关研究发现,通过电刺激视皮层的单一位置,可以产生单一磷光体光斑的“视觉”感受,同时刺激视觉皮层的多个部位而产生的多个磷光体可以结合起来形成一个连贯的形式,就像视觉显示中的像素一样[8]。但近一个世纪的实验尝试并没有找到让受试者产生可识别图形的方法。大脑视皮层感知视觉的方式十分复杂,似乎和视网膜对二维图形的感知方式有重大区别。直到2020年5月,《细胞》杂志(Cell)发表了美国贝勒医学院Daniel Yoshor团队里程碑式的成果:可以通过一系列电极阵列在时间上顺次激发的动态电刺激过程,让受试者脑海中准确呈现指定的“视觉图像”[9]。这种类似“直接实时书写”的刺激方法,可以让受试者在未经训练的情况下,以比较高的准确度还原依次激发电极的空间分布图形,从而识别各种字母形状。该团队计划通过减小电极尺度、增加电极数量和面密度、优化电刺激参数和模式,达到单个神经细胞的空间精度,帮助盲人“看到”更复杂的信息,实现恢复视觉的梦想。这项技术,对于静态辨识物体有很大价值,但是,受试者对一个动态电极刺激图案做出响应和形成“视觉”需要一段时间,能不能把这段时间压缩到100 ms之内以适应日常活动所需要的实时反应,还有待检验。

现有的各类植入式装置普遍面临各种技术难题,比如与视神经生物相容性差、器件容易脱落损伤、跨眼球操作困难电池问题、复杂制作工艺、成本高昂、激发电极数量有限使得像素偏少等。这些植入装置和系统的缺陷,使得近年来体外视觉辅助装置的研究和产品开发获得新的关注。

第二种人工视觉系统技术路径,主要是各类非植入式、可穿戴装置。自20世纪60年代开始出现帮助盲人进行日常活动的体外辅助装置,早期是基于声纳的移动辅助设备,如Russell Pathsounder和Mowat研制的传感器,起到障碍物探测器的作用[10]。随着计算机化的辅助系统面世,NavBelt是一个可穿戴的、计算机化的、装备声纳的系统,盲人用户能够安全通过未知的有障碍物环境[11]。Ultracane装置则将长拐杖与超声波传感器结合以辅助行走[12]。但这些装置相对功能简单、指令含糊,难以适应现代城市复杂的环境和路况,因此都没有得到普遍的应用。

2012年4月谷歌公司发布的“谷歌眼镜”[13]配有微芯片处理器,具有图像采集和处理功能。当配合适当的AI图像解读软件和自然语音输出能力后,就具备了部分满足指导盲人日常生活的功能,相信将来这类技术装置具有很大的市场。然而,成本过高导致售价过高,也存在侵犯隐私、分散注意等问题,2015年1月谷歌停止了谷歌眼镜的进一步研发。2020年11月,谷歌公司试运行了一个名为Project Guideline的人工智能系统,旨在帮助盲人和低视力人群在一部智能手机的帮助下就能独立完成跑步比赛。只要在道路上预先画出指引线路,并将手机挂在腰间,让手机镜头能持续拍摄路面,并影像识别。一旦用户跑步路线过度偏离,手机就会通过骨传导耳机让使用者左耳或右耳听到不协调声音,进而让使用者知晓放缓脚步、调整行进方向[14]。功能比较单一,适合简单特定的环境条件,并不能应对复杂的路况。

利用人体触觉解读视觉图像,也是一种有趣的路径。近年来一款“舌上触觉”视觉辅助设备被研发出来,称为“Brain Port”,它可以利用舌平面的电刺激感觉“辨识”外界物体的形状[15]。其外形类似一副太阳镜,经由细电缆与一个形同扁平“棒棒糖”式样的装置相连接。通过微型摄像机拍摄图像,将图像信息简化后转换成舌平面电极阵列的电脉冲。实验表明,经过20 h左右的培训,将电脉冲信号不断刺激舌头表面神经,受试者能够将这些图形化位点的电刺痛感觉转化为图形感觉。但舌头用于说话和饮食,并不适合长期佩戴电极阵列装置。

2021年10月斯坦福大学智能系统实验室制造了配备GPS和陀螺仪的盲杖[16],同时辅以加速计和磁力计,可以实时输出用户的位置、速度、方向等信息。基于人工智能寻路和机器人算法,引导用户走向目标。盲杖的顶端利用一个电动的、360°转向的轮子,时刻保持与地面的接触。在实地测试中,视力受损参与者的行走速度提高了大约20%,戴着眼罩视力正常参与者的行走速度提高了1/3以上。

辅助盲人生活的关键在于研发实用型人工视觉系统。本文将展示一种将视觉信息转化成头部触觉指令和语音的人工视觉辅助原型系统概念。系统采集受试者周边环境的图像信息并无线传输到后台,操作人员分析处理图像信息后再以触觉编码形式无线驱动激发头部装置内置振动马达,利用头部对前后左右的天然区分能力和对触觉的快速反应,为受试者提供准确的行动指令。同时辅以语音信息,让受试者获得更多周边视觉信息。该系统低成本、低风险,适合多种生活和工作场景。实验结果表明,在人工后台支持的条件下,该系统能够有效帮助盲人完成复杂的日常活动。

1 系统与方法

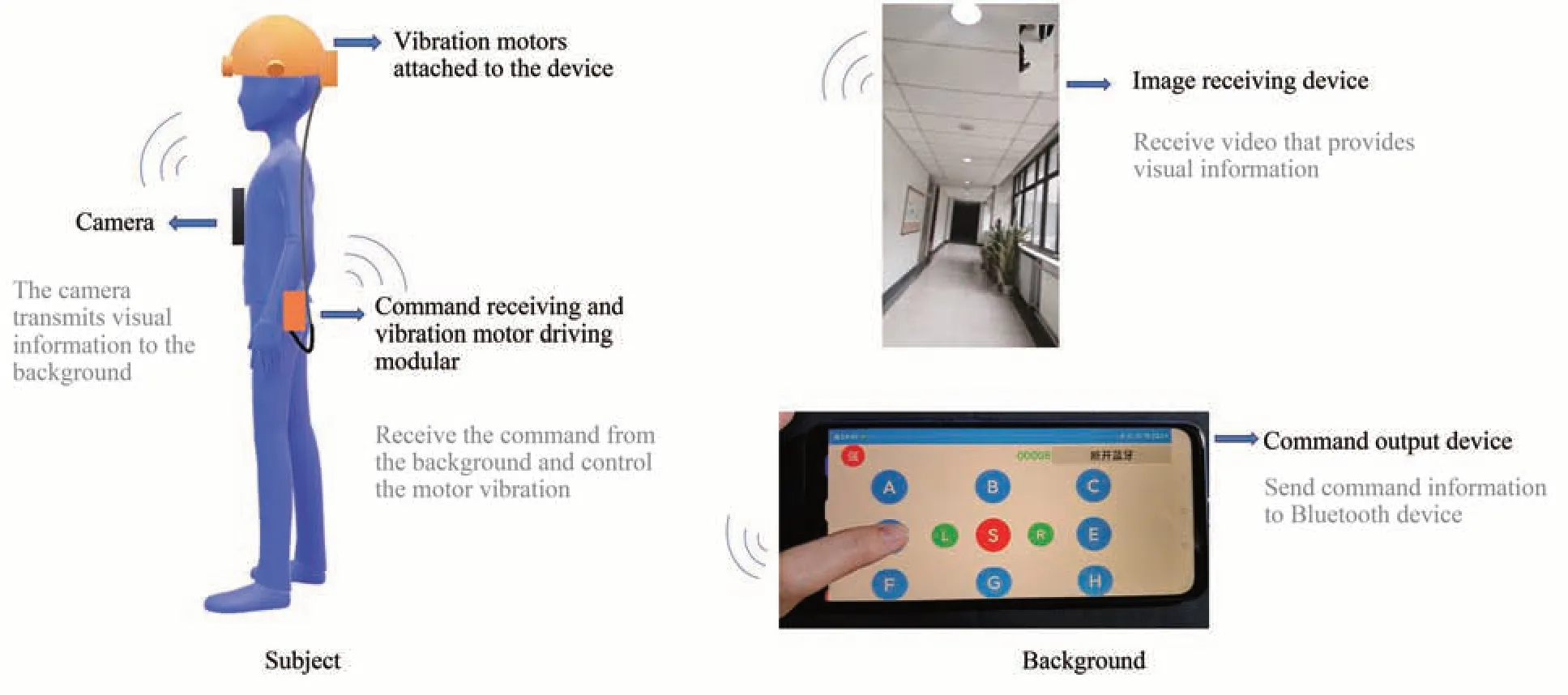

本系统由多个装置与功能模块构成,包括视觉图像采集装置、视觉图像无线传输与接收装置、视觉图像处理、触觉编码输出、触觉指令无线传输与接收装置、振动马达驱动电路装置、可穿戴式触觉和语音输出装置等(图1)。

具体而言,佩戴在受试者身上(头部或胸口)的摄像头装置对周围环境信息进行图像采集,采集到的图像经wifi或者4G/5G网络传输到后台,通过人工判断或人工智能(artificial inteligence,AI)判断获取街道边界、台阶、路面坑洼情况、行人、自行车、垃圾箱、树木、墙壁围栏、交通灯、斑马线、来往汽车等重要因素,分析和判断图像信息后输出触觉指令。指令通过无线网络传输到佩戴在受试者身上的驱动电路,驱动相应位置的振动马达,给受试者触觉指令。同时,根据情景需要,辅助以语音信息,比如描述路径、路况、对面行人相貌、车牌号、店名、餐桌位置、菜单内容等。

Fig.1 Diagram of system modules

本文主要介绍由后台人员判断现场图像信息并发出指令、由蓝牙装置完成触觉编码无线信号传输、振动马达安装在头套上的原型系统。

1.1 视觉图像采集装置

本系统可采用多种图像获取装置。其中一类是通用手机摄像头,用可穿戴织物固定于胸前,可以在行走时获得前方大角度视野,也可通过行走或者停止时的身体左右偏转提供更丰富的周围图像信息。利用手机摄像头的便利之处,是可以直接借助4G/5G或者wifi信号通道将视频数据和受试者的语音传输给后台。另外一些类型的图像采集装置为各类商用网络摄像头。

1.2 后台操作

受试者佩戴眼罩遮挡视线模拟视觉障碍,胸前用拍摄支架固定手机以拍摄前方视频。后台辅助人员通过观看视频,判断应发出的指令并操控手机中的蓝牙系统控制装置定制APP来完成指令,可同步发出振动指令以及语音提示。

1.3 可穿戴装置部分

本实验制作了多种柔性装置,能够内置并固定多个振动马达,使马达尽可能贴近头部皮肤(隔着头发),让头皮能够快速、准确感知马达振动的强度和次数。图2是其中一种利用弹性织物条带制作而成的内胆戴在受试者头部的照片。内胆前后左右和顶部安装了11个振动马达,马达驱动电线汇聚于后脑位置。当头套外面再戴上普通的鸭舌帽之后,从外观上已经看不到内胆。将来,内胆装置可以与小型化驱动电源一起安装在头部,也可以用隐蔽的细小连线连接安装在腰部的驱动电路,使得佩戴测试装置的受试者在外观上与正常路人无异。

Fig.2 Photos of human wearing devices from different angles(a-f),schematic diagram of device tank(g)and physical drawing of bluetooth module(h)

1.4 蓝牙通讯装置和振动马达电路

通过接收外部手机蓝牙控制APP发出的指令,控制振动马达电路的通断和电压,从而形成触觉的指令信息。附件图S1是蓝牙模块的电路设计图。

手机APP以屏幕上的按键控制蓝牙输出的通断,每个按键对应一路振动马达,当按下屏幕上的按键时,相应的振动马达开始震动。同时可在左上角选择强弱电压的输出,当选中“强”时振动马达在3.7 V电压下进行强震动,选中“弱”时振动马达在2 V电压下进行相对弱震动。手机APP界面见图1。其中的A、B、C、D、E、F、G、H、S、L、R按键分别对应于上面头盔内部震动马达分布图中的左前、前、右前、左、右、左后、后、右后、中、中间偏左(位于中和左前的中间)、中间偏右(位于中和右前的中间)11个方位的振动马达。

1.5 触觉指令编码

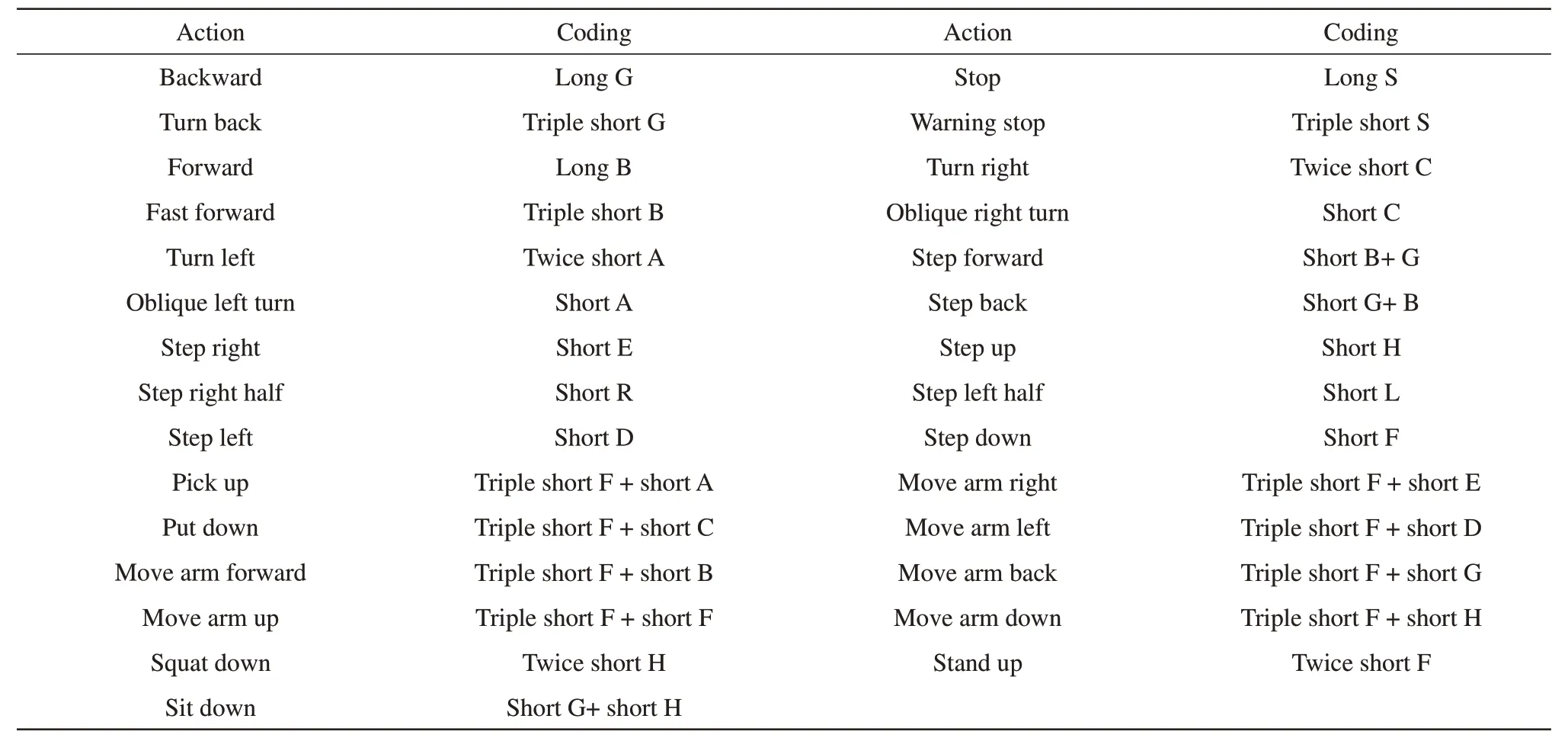

根据固有经验和尽可能避免指令的混淆以及方便记忆,经过反复实验和调整设计了指令集(指令按照手机APP上的A、B、C、D、E、F、G、H、S、L、R进行描述)(表1)。

1.6 实际场景测试设计

为测试原型系统的功能和局限,找到志愿者佩戴原型装置,设计了大量由简单到复杂的多种实际场地测试。

首先让受试者在空旷的场地上沿着预先标识的直线路径行走,来测试振动马达输出指令的延时、受试者的动作响应延时、行走路径偏差等多项参数,以优化指令集和指令时间参数。通过视频逐帧分析,提取受试者脚部所在方位的空间与对应时间,计算所有参数。

其他场地测试包括在实验大楼的回型走廊内真实测试直线行走、躲避障碍物、躲避对面行人(不知情的其他人员)等,在正常营业的咖啡厅内行走并寻找空位坐下、上下台阶等,以及在真实的人行路上测试直线行走、转弯、躲避障碍物,还包括用触觉指令控制手臂和手的动作,尝试从桌子上取水杯等。

Table 1 The instruction set of 11 tactile keyboards

2 结 果

本工作前期做了大量的各类验证实验,历时近1年。志愿者为18~28岁的5名高校在读学生(2男3女)以及1位31岁的盲症患者(男)。限于篇幅,以下重点介绍一些实验结果,以展示本文原型系统的基本功能,进而讨论其技术升级路线和和应用潜力。

2.1 头部触觉对马达振动的敏感度和空间方位的感知

实验结果显示,受试者头部皮肤触觉敏感性因人而异。主要区别有两项,一是对振动马达信号的分辨能力有区别,有些受试者能够感知驱动电压为1~3 V的微弱振动信号,有些则需要提高马达驱动电压、增加振动强度。对于后面的场地测试,需要对驱动电压做调整,达到既能感知振动、也不会觉得不舒服的效果。这样,受试者才能准确理解振动马达阵列的编码。

二是振动触觉的空间分辨率也因人而异,因头部皮肤位置和头发的多少而变化。表2是前述5位学生做测试的结果。头皮分辨率的测试结果既和个人的头皮触觉敏感度有关,同时和振动马达与头皮的接触面积、直接接触还是间接接触(存在头发)有关,头皮触觉越敏感,头部震动分辨率越高;振动马达与头皮接触面积越大,分辨率越高。

作为平均结果,在两个马达相距超过3 cm时所有受试者都能感知到两个马达的不同振动点,因而能接受触觉编码。后期实验中,头套装置上,两个马达的间距都超过5 cm,以确保受试者对每一个振动点相对头顶的空间方位有准确地判断,从而能够正确执行编码指令。随后对多名受试者进行11个振动马达位置判断准确度实验,经过初步熟悉后,受试者均能准确识别每个马达的振动方位。并且根据实验中记录,频繁短按发出指令时间隔0.5 s以上比较容易分辨,各个指令间的时间间隔应在至少3 s以上(排除紧急指令,紧急指令有最高优先级)。实验显示,5位受试者经过几次训练熟悉后对此指令集均能保证准确度和辨别敏锐度。

2.2 空旷场地直线行走偏差测试

在空旷的场地上贴好直线标记,让视力正常的受试者对准直线方向,再戴上眼罩,靠自己的判断沿着这个“直线”行走。几步之后,通常会有明显的方向偏移。多个受试者测试结果的统计分析表明,视觉遮挡下的“盲走”会逐渐失去方向感,这与迷雾天人在空旷地带会绕圈的案例相类似。事实表明,视觉在“直线行走”中一直担当了“方向矫正”的作用。

作为对比,对头部携带了人工视觉装置的“盲行者”做同样的测试,表现要好得多。图3是带有装置一次测试的视频截图。本装置辅助的情况下,当受试者保持直线行走时不发出指令;当受试者右偏时,根据受试者所在位置发出“左缓冲/左跨一步/左转一定角度”的振动编码指令以纠正其行走方向;当受试者左偏时,根据受试者所在位置发出“右缓冲/右跨一步/右转一定角度”的振动编码指令以纠正其行走方向。图4是一个典型的对比结果。行走13步(约7 m距离)的标准差平均值,从没有辅助装置提醒而完全“盲走”的(65±12)cm降低到(16±10)cm。行走偏差数据见附件表S1~S3。

测试结果表明,一个人完全盲走有很大的随机性,因人而异,总体规律是偏向某一侧。而听从头部振动辅助装置的“触觉指令”后,行走路线不会偏离目标直线太远,其行动轨迹不太连续,但始终在目标直线这个“中心线”左右。

Fig.4 Measured data of walking deviations from the two subjects A and B

2.3 规避障碍物测试

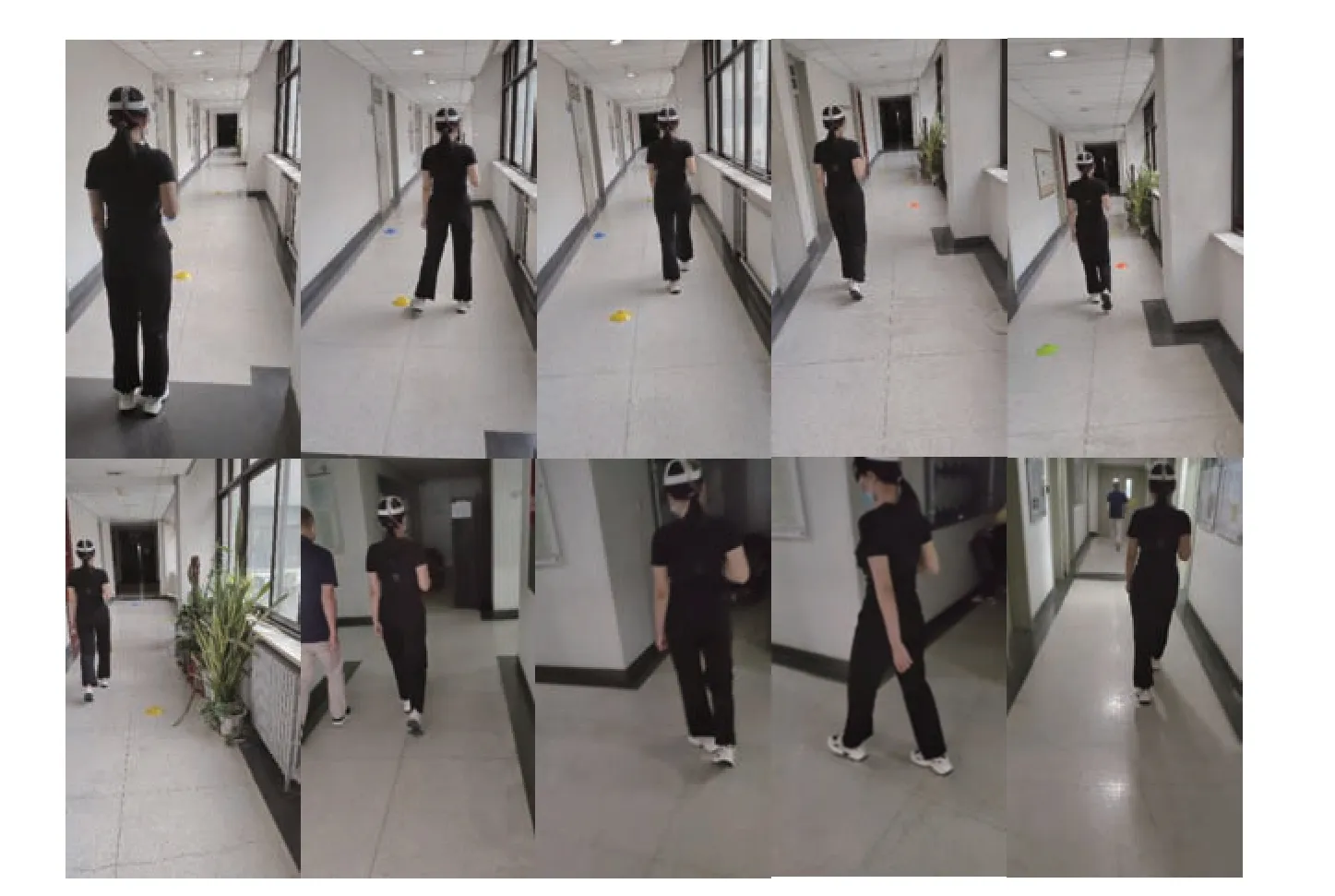

在受试者熟悉“触觉指令”的含义、后台调控者掌握了合适的时间预判、时间延时和指令的搭配之后,受试者能够在直线行走顺利绕过路上的障碍物(足球训练障碍标),也能在走廊里顺利完成转弯。图5是某一次实际走廊测试的视频截图。

实验中后台指挥者能够清楚地通过视频识别出前方的盆栽、打开的房门、随机出现的行人以及人工设置的障碍物,并且灵活运用前进、左右转向、左右缓冲、左右跨一步、停步、后转等指令,让受试者在往返于直角弯时可以成功避开固定或随机障碍物。如果障碍物距离比较近或者是随机出现的行人,速度比较快来不及躲避,可以采用先停步指令,再左右跨一步进行躲避。

Fig.5 Video screenshots from the walking experiment in return corridor(screenshot from Video S2 in Supplementary)

2.4 上台阶、找椅座、咖啡馆行走等复杂场景测试结果

上台阶场景测试时选定路线为一段台阶,受试者靠右侧上台阶测试,走n级台阶到平台后停止,楼梯处可能随机出现行人。实验中该装置主要帮助受试者成功完成台阶行走,重点关注台阶开始和结束的两个阶梯。

与平地测试和走廊测试不同,上台阶测试实验中,向下30°~45°固定的摄像头可以拍摄出前方脚下路况,方便后台指挥者通过视频准确定位台阶的出现和结束,以及随机出现的行人,避免出现距离估测失误的情况;指挥者灵活运用前进、上台阶、左右跨一步、停步指令,让受试者走过12级台阶并且成功躲避随机出现的行人。同时辅以语音提示,准确告知受试者台阶的出现和结束。上台阶时,通常用左或右跨一步进行位置调整。当需要躲避随机出现的行人时,大多同样采用左或右跨一步指令,如果行人速度比较快来不及躲避,可以采用先停步指令,再左右跨一步进行躲避,如图6a系列视频截图所示。

上下台阶的任务比较复杂,需要后台指令清晰、时间准确,受试者需要练习、熟悉指令的时差,以避免踏空或者碰伤脚。采用语音辅助、降低行走速度都有利于顺利完成上下台阶任务。

找椅座任务是在室内布置一些障碍物(箱子等)以及一把椅子,受试者需要躲避障碍物找到椅子并且坐下。实验中该装置主要帮助受试者成功完成室内行走,重点关注障碍物的躲避以及到达椅子的最优路径,如图6b系列视频截图所示。

咖啡馆场景要求视觉遮挡的受试者在该装置的帮助下,在咖啡馆的座椅之间躲避桌椅和顾客完成正常穿行。选定路线为:从咖啡馆门口走到室内并坐在选定的座椅上。实验中重点关注行人和桌椅的躲避。指挥者能够清楚地通过视频判断出桌椅的位置以及随机出现的顾客,并且灵活运用前进、左右跨一步、左右转、左右缓冲、停步指令,让受试者成功走到咖啡馆内侧,同时辅以语音提示。实验如图6c系列视频截图所示。

Fig.6 Video screenshots from the experiments of climbing steps(a)and finding chairs(b)(screenshot from Video S3,4 in Supplementary)

2.5 桌上取物:控制手臂和手的运动

本文不仅进行了在各种复杂场景里的行走测试,也初步试验了运用触觉编码控制手臂和手的运动,这为进一步完善触觉编码,使之成为可以与手语、摩斯码等相比较的复杂信息编码系统打下了基础。

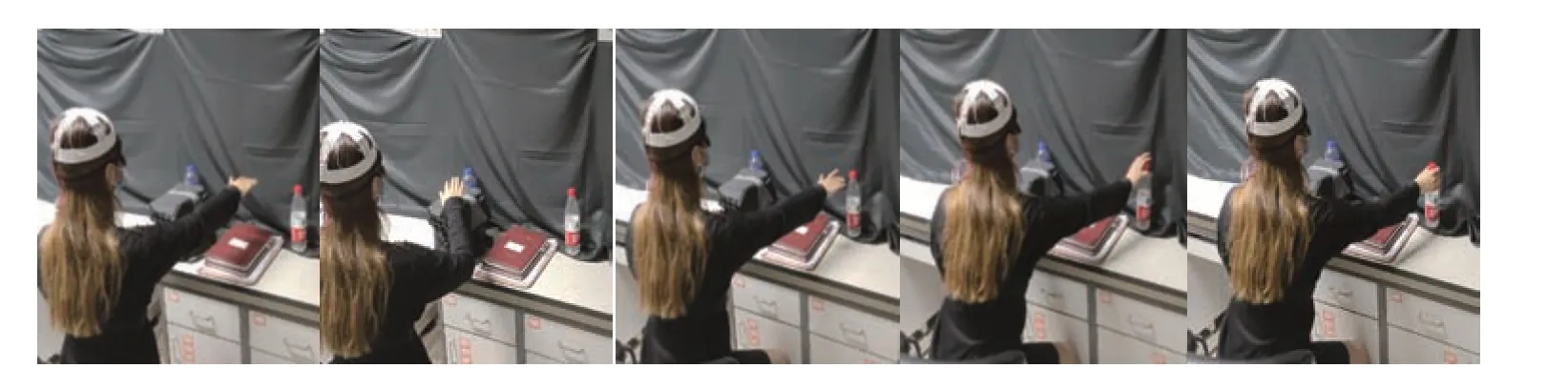

实验中选定一个室内环境,在桌子随机位置摆放一个杯子,受试者坐在桌子前,借助该装置的触觉指令信息移动手臂、找到杯子并拿起。初步实验中桌面上没有其他障碍物,测试成功后在桌面上放置一些书和笔筒以增加实验难度,让受试者的手臂躲避高低障碍物后移动到杯子处并成功拿起。实验中该装置主要帮助受试者手臂成功移动到杯子处。图7是拿放杯子场景测试视频的截图。

Fig.7 Video screenshots from the experiments of finding a seat in the cafe(a)and taking the cup from the table(b)(screenshot from Video S5,6 in Supplementary)

实验中,后台人员能够清楚地通过视频判断出杯子的位置并且迅速判断出应指挥的路线,灵活运用手臂前伸后缩、手臂上下左右移动指令,让受试者的手臂成功绕过障碍物移动到杯子处并拿起杯子。由于是室内环境,同样可以适当提高与受试者的语音交流频率准确告知受试者已到达杯子处。

2.6 盲人实地测试

由于上述实验的受试者均为高校在校学生,为了进一步测试原型系统的可行性以及真实盲症患者对此系统的接受能力和反应准确度,本文邀请到了一位31岁的全盲患者。该志愿者因患有先天性白内障,1岁时手术失败致全盲。

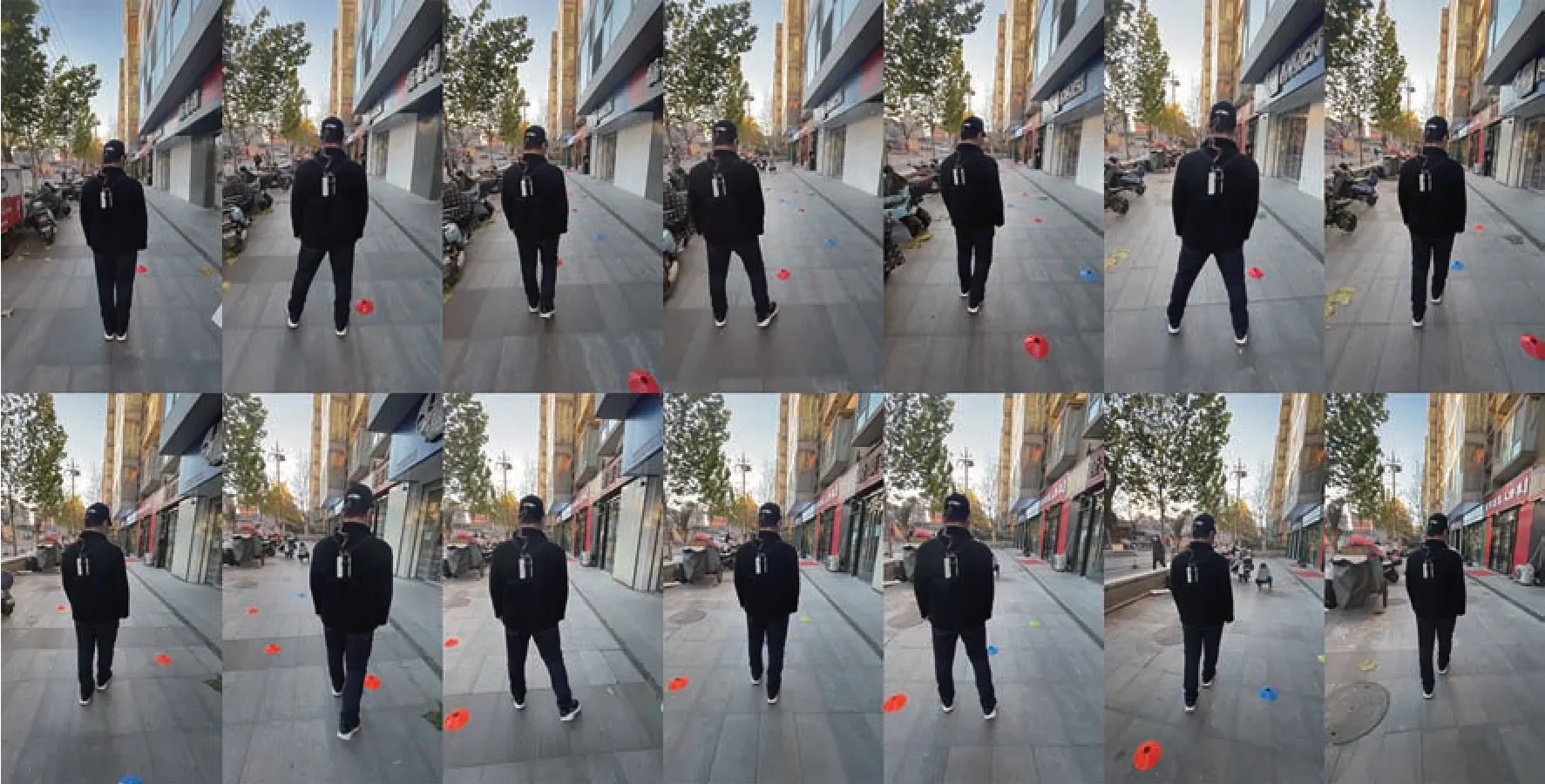

志愿者佩戴原型系统,熟悉指令后在真实的人行街道处做L型(直行加转弯测试)的路线行走,过程中要注意躲避来往的行人、停靠的车辆、路边的台阶以及树木,并且注意到转弯时机,及时发出转弯指令。实验视频见附件视频S7。之后找到一段比较空旷的场地进行躲避障碍物测试,根据志愿者躲避时采取的行动判断其对指令的接受程度和反应速度。图8是志愿者进行躲避障碍物测试的视频截图。

Fig.8 Video screenshots from the experiments of blind avoiding obstacles(screenshot from Video S8 in Supplementary)

实验中,后台人员能够清楚地通过视频判断出志愿者所在的位置并且迅速判断出应指挥的路线,灵活运用前进停止、左右转向、左右跨步指令,让志愿者成功避让开路上行人、停靠的车辆、树木、台阶、设置的障碍物等,完成人行路的行走和躲避障碍物行走。实验表明,盲人志愿者可以准确接受触觉指令,并且按照指令指示行动,以在一些比较简单的路况行走。

3 讨 论

3.1 头顶部位触觉的天然优势

触觉在神经系统进化过程中占据重要位置,与生物体寻找食物、规避伤害、求偶、逃生等功能直接关联。研究表明,人体全身的皮肤触觉感知与大脑皮层负责触觉的区域形成一一对应关系,也就是说,全身皮肤任何一点在大脑皮层的二维地图上均占据一个独一无二的二维坐标点。

由于身体各部位触觉传感器面密度的不同,手指、手掌等部位的触觉空间分辨率较高,而背部等区域的触觉空间分辨率比较低。实验表明,头皮区域的触觉空间分辨率在2~3 cm,比背部略好。

头顶皮肤接近半球形,头顶皮肤相对于眼睛的空间方位,能够自然分辨前、后、左、右等触觉方位。场地实验测试表明,人体对本论文器件振动马达产生的头皮触觉可以形成快速响应,响应时间在0.5 s之内,且不会搞错前后左右的方位。因此通过合适的触觉编码,控制振动点的振动强度、振动间隔和次数,可以形成明确的行动指令传输给器件携带者。受试者接受指令后,其行动的准确性超过

90%。

后期将募集更多盲人志愿者开展实际场地测试,来量化表征本系统所需的训练时间和出错率,并简化、完善头部指令的触觉编码,优化指令的时间、提前量等参数。

3.2 与其他辅助系统之比较

拐杖是古老而极为有效的盲人行走辅助工具。它的特点是能够实时获得前方一米范围内的路面状态,尤其是在农村,可以有效帮助盲人完成独立行走任务。而训练有素的导盲犬,能比拐杖更好地完成这项任务。现在城市街道复杂性超过了农村道路,行人、自行车、垃圾箱、树木等障碍高密度存在于城市街道以及街道四周。仅用拐杖,已经难以在城市行走。

超声拐杖是上个世界开发的辅助盲人行走的技术手段。鉴于电子器件落后,当时没有能够普及推广。最近,随着芯片技术、无线通讯技术的极大发展,超声装置被成功小型化、可以安装在鞋子头部,据报道已经可以帮助盲人准确判断障碍物的距离,在比较安全的城市道路上独立行走、跑步,比如参加马拉松比赛,这是可喜的进步。

已经见诸报道的利用舌上触觉阵列器件输入前方物体形状的技术,还未见应用报道。从基础研究角度看,舌上输入信息是有价值的探索,可以加强人们对于舌部感觉的理解。但从实际应用角度看,舌上器件局限在较小的面积,并且对饮食和说话都带来影响。若使用有线信号输入输出,电极线势必要穿透面部皮肤或者从咽喉出入,留下创口。如果应用无线信号输入输出,器件质量和体积较大,也并不容易安置在嘴中。

另一种直接将视觉图像实时处理后语音输出指令的是盲人眼镜系统。这是一个极为有前景的技术,它强烈依赖专用芯片技术、专用AI图像识别技术和图像要素转化为语音指令的软件技术。

本文提出的将视觉图像转化成头顶触觉输入行动指令、并辅助以语音环境的系统,其有效性、信息全面程度、安全性等均优于之前的几项传统盲人体外辅助技术。相对比较昂贵的体内植入器件,本文展示的振动马达和无线通信技术装备成本也比较小,适合普通民众使用。头部振动马达阵列的触觉编码,除去简单的前、后、左、右、转弯、停顿等指令,还可以像摩斯码、手语和旗语等编码语言,增加大量的信息,用于特殊的工作场景。触觉和语音的双重信息转化,比单单只有一个指令途径更有优势。触觉感知到的行动指令,能让受试者快速、准确执行身体动作,而语音能提供比触觉更加丰富的信息,包括周边路况整体状况、整体行走路线描述、时间进展等信息,相辅相成,双重保险。

更重要的是,受试者可以通过语音反馈自身要求、状态、对指令的理解,与后台人员进行有效的交流。这不仅增加了系统工作的安全性和可靠性,也使得个性化服务得以实现。比如,现场装置使用者是一位视觉退化、很少出门的老人,后台辅助者是其子女,那么,通过触觉指令、语音辅助和语音交流,帮助老人顺利出行、购物、就餐,就是一次温馨的虚拟陪伴。

4 展 望

多项实际场地测试表明,利用头部触觉辅助盲人行动的无线电子系统原型已经达到预期效果。受试者能够快速响应头部振动触觉指令,并实时调整自己的步伐、行走方向和身体整体动作,从而完成复杂场景下的独立行走、上台阶、躲避障碍物、在桌子上取杯子等日常任务。

另一方面,该系统不局限于盲人和视觉障碍人士使用,也适用于帮助老人独自上街,或者军队的无声通信场景。针对不同的应用场景,该系统有潜力发展出不同的器件模式,比如多摄像头模式,以及不同的工作模式,比如城市街道导航模式、户外旅行模式、夜间工作模式(比如通过增加红外摄像头)、采购模式、日常家居模式,甚至游戏模式等,具有广阔的产业前景。在不同的工作模式下,开发出专用的AI图像识别技术、触觉编码和语音辅助软件。在开发专用AI图像识别技术时,需要专用芯片设计与制造、专用算法和软件、重点目标提取并转化成振动马达编码和自然语言提示等多种技术的合作与协调,相当有挑战。

触觉指令具备静默、隐蔽、保护隐私等功能。还可以将器件位置从头部头套延伸到颈圈、腰带、手环、脚环等。另外,在物联网,盲人导航系统有可能享受“专门识别”待遇,与汽车、摩托车等自动电子系统之间形成通讯联系,这样可以大大增加盲人出行的安全系数。

5 结 论

本文介绍了一种利用触觉和语音辅助盲人或视觉障碍者获取外界环境图像和导航信息的原型系统。该系统的头部触觉装置中,11个微型振动马达被固定在特制的弹性头套内胆上,外部可用普通帽子遮掩,具有很好的隐蔽性,能够保护使用者的隐私。该系统属于非植入式人工视觉系统,它充分利用现有的网络无线通讯技术,通过后台人员分析视觉图像,直接、实时地转化成头部触觉振动编码,并辅以语音描述和提示,能够帮助受试者完成独自出行和诸如进咖啡馆等生活任务。

实验表明,受试者对触觉指令响应时间在0.5 s内;施加2~3 V驱动电压即可使马达振动形成有效头皮触觉,4~5 V电压可形成很强的触觉信号。当两个振动点的间距超过3 cm时,所有测试者的头部皮肤都能够明确分辨不同振动位点、识别不同触觉指令。该系统利用头部相对于面部的天然前、后、左前、左、右前、右等方位感,以及人体对于触觉的快速响应机制,控制多个振动位点的振动强度、振动间隔、振动次数、振动时序、位点组合等,从而形成明确的行动指令触觉编码,传输给佩戴者。

本文完成了多项实际场地测试,证明该系统能够帮助盲人在行走过程中完成正确的左右方向微调、左转、右转、避让障碍物、上台阶等动作,顺利实现在复杂环境里独立行走;也能指导手的动作,帮助盲人完成从桌上取杯子等简单的日常生活任务。随着AI技术的发展,在后期的研究中,将研发现场AI图像识别技术以取代或者辅助后台人工识别模式,并针对不同的应用场景开发相应的系统模式和专用软件。本文展示的系统和实验结果,为人工视觉系统的发展提供了一种全新的技术路径。附件PIBB_20210320_DOC_S1.pdf、 PIBB_20210320_Video_S1~8.avi见本文网络版(http://www.pibb.ac.cn或http://www.cnki.ent)。