沉浸式视频质量评价综述

曾焕强 丁瑞 黄海靓 陈婧 朱建清

(1.华侨大学工学院,福建泉州 362021;2.华侨大学信息科学与工程学院,福建厦门 361021)

1 引言

随着视觉媒体技术的快速发展,人们在学习、工作和休闲等各个方面都渴望更加真实的视觉体验,沉浸式视频(Immersive video)获得了越来越多的关注。沉浸式的概念早期出现于电影领域,通过覆盖人眼至少120°(水平)×70°(垂直)视场角的巨幕,与音频及特效系统相辅助,能让观众完全沉浸在视听环境中并有身临其境的感觉[1]。目前,沉浸式视频通过人机交互、虚拟现实(Virtual Reality,VR)等技术,可将现实环境营造成兼具画面包围感和沉浸式音响的场景,并通过头戴式显示器(Head-Mounted Display,HMD)、传感器及手柄等设备实现沉浸式体验。

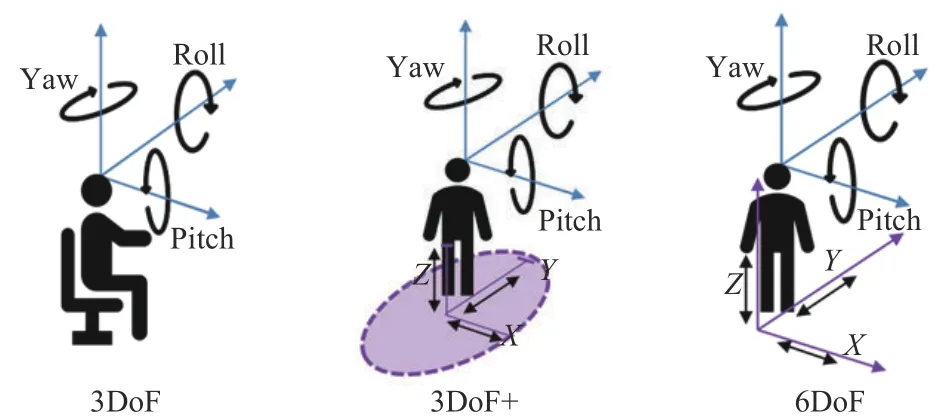

伴随着数字时代技术的更新,沉浸式视频也在不断更新迭代,高分辨率、高帧率、高色深、广色域、高动态的视频能提供更为丰富的画面层次,保持更为精致的画面细节,进一步强化沉浸式视频的空间表现力和临场感,更好地提升沉浸式视听效果。与此同时,通过HMD 观察的沉浸式视频格式也不断在变化,MPEG 会议上针对沉浸式媒体的标准化工作制定了MPEG-I标准[2],其根据视频格式将沉浸式视频分为了三个阶段:3 个自由度(3DoF)、3DoF+(3 Degrees of Freedom Plus)和6DoF[3-5]。

与传统视觉信号相同,沉浸式视频在采集、处理、传输和展示等过程中,不可避免地受到外界干扰而导致视频质量下降。所以如何量化沉浸式视频的质量损耗并进行质量评价,对于沉浸式视频处理研究领域的发展具有学术研究意义和现实应用价值。近年来,基于3DoF 的沉浸式视频质量评价研究已引起学术界的广泛关注,并取得了初步进展[6-10],关于6DoF 沉浸式视频的相关研究也在逐步探索中。沉浸式视频质量评价的研究目标是设计符合人眼视觉主观感知的算法模型,用以准确高效地评估视频质量。研究内容主要包括:主观质量评价数据库和客观质量评价方法。

本文其余部分的安排如下:第2 节介绍基于3DoF 的沉浸式视频质量评价数据库和质量评价算法,第3节介绍涉及6DoF 沉浸式视频质量评价的主要技术,第4节给出总结和未来的展望。

2 3DoF沉浸式视频的质量评价

如图1 所示,3DoF 沉浸式视频指观察者在固定位置上于三个旋转度(偏航角(Yaw)、俯仰角(Pitch)、滚转角(Roll))上自由活动,即在一个固定的观看位置上环顾四周,如360°视频[11],即具有360°宽广视野感知范围的视频,用户可视作球体的中心点,与球体表面的不同视频信息具有相同距离,并可通过改变方向来选择观看内容。3DoF+沉浸式视频是对3DoF 的有限修改,即添加了三个位置维度(X,Y,Z)上头部的有限范围活动(脚步固定,不允许走动),其更加符合用户感知事物的真实过程,并能兼容混合现实(Mixed Reality,MR)和增强现实(Augmented Reality,AR)。6DoF 沉浸式视频是3DoF+的进一步改进,在3DoF视频的基础上额外提供3 个平动自由度,即视频内容可根据观众位置的移动而改变,支持用户更大范围的观察行动。

图1 关于3DoF(左)、3DoF+(中)、6DoF(右)的划分[3]Fig.1 About the classification of 3DoF(left),3DoF+(middle),6DoF(right)[3]

在3DoF 的概念提出之前,通过HMD 实现的沉浸式体验通常基于自然/屏幕视频和360°视频,而现有的3DoF 沉浸式视频一般都指代360°视频(或称为全向视频、全景视频)。用户可通过改变方向来选择观看内容。

2.1 3DoF沉浸式视频的主观质量评价数据库

沉浸式视频主观评价方法一般遵照国际标准ITU-R BT.500-13[12]中所规定的实验设置搭建主观质量评价平台,在特定环境内观看测试序列并基于各项规定方法进行打分,再对评分进行处理分析得到主观平均得分(Mean Opinion Score,MOS)或主观差异平均得分(Differential Mean Opinion Score,DMOS),以此反映失真沉浸式视频的感知质量退化。现有的主观评价方法主要分为以下几种:

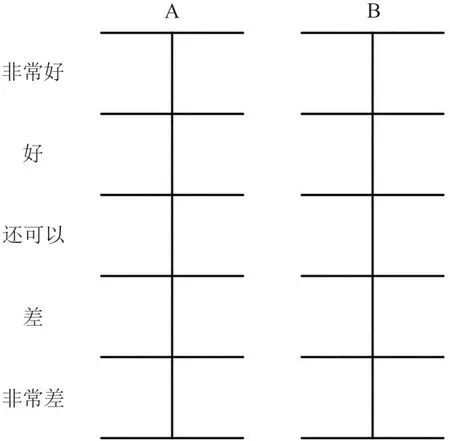

(1)双刺激损伤尺度法(Double Stimulus Impairment Scale,DSIS):将参考视频和失真视频以“视频对”的形式展示给受试者,观看顺序为参考视频在前,失真视频在后,即对参考视频有主观印象后再进行失真视频的评分,通常采用表1 所示的5 分制评分表。

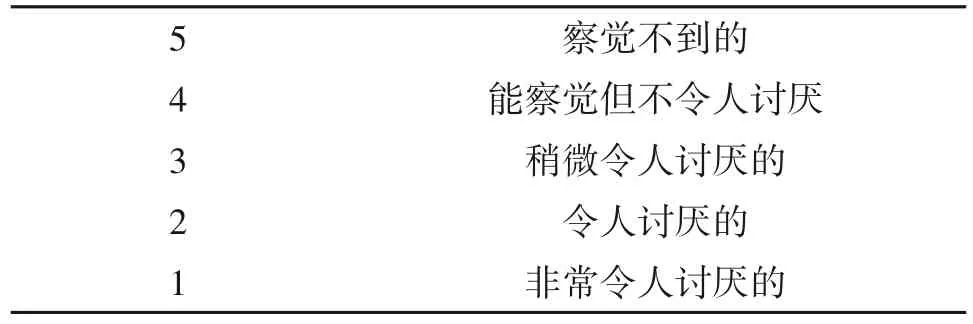

表1 DSIS的5分制失真测度Tab.1 Distortion measures on the 5-point scale for DSIS

(2)双刺激连续质量尺度法(Double Stimulus Continuous Quality Scale,DSCQS):与DSIS 观看方式大致相同,区别是参考和失真视频的播放顺序随机,且二者都需要评分,通常采用图2 所示的5 分制失真测度。

图2 DSCQS的评分测度Fig.2 Scoring measures of DSCQS

(3)单刺激法(Single Stimulus Methods,SSM):在不观看参考视频的前提下,以随机方式显示测试视频并进行主观评分,具体实现时根据播放次数分为两种方式:不重复播放视频序列(Single Stimulus,SS)和重复播放测试序列(Single Stimulus with Multiple Repetition,SSMR)。除了常用的5 分制评分,还可以通过采用图3 所示9 分制或11 分制提高精度[12]。

图3 SSM评分测度Fig.3 Scoring measures of SSM

(4)单刺激连续质量评估方法(Single Stimulus Continuous Quality Evaluation,SSCQE):在不观看参考视频的前提下,选择序列的时间较长,分值取平均,对序列评分时不仅考虑分值大小,还需关注评分时长。

(5)同时双激励连续质量评估方法(Simultaneously Double Stimulus Continuous Evaluation,SDSCE):该方法以SSCQE 为基准条件而制定,用以衡量较长序列的视频质量。

(6)多媒体视频质量主观评估方法(Subjective Assessment Method for Video Quality evaluation,SAMVIQ)[13]:1)训练测试人员,播放一组参考视频及相应的测试序列(质量从高到低排列),给定测试人员以基本的预期得分;2)进行预测试,播放一组包含参考视频和三个失真视频的视频集合,当测试人员的评分结果与预期得分相匹配时可正式测试;3)测试人员观看多类视频序列,每组包含一个原始视频和三个随机的失真序列,并基于连续评分测度进行打分,即在0 到100 之间的连续尺度(分5 个等级分别表示很好、好、一般、差、很差)上对视频序列进行打分。

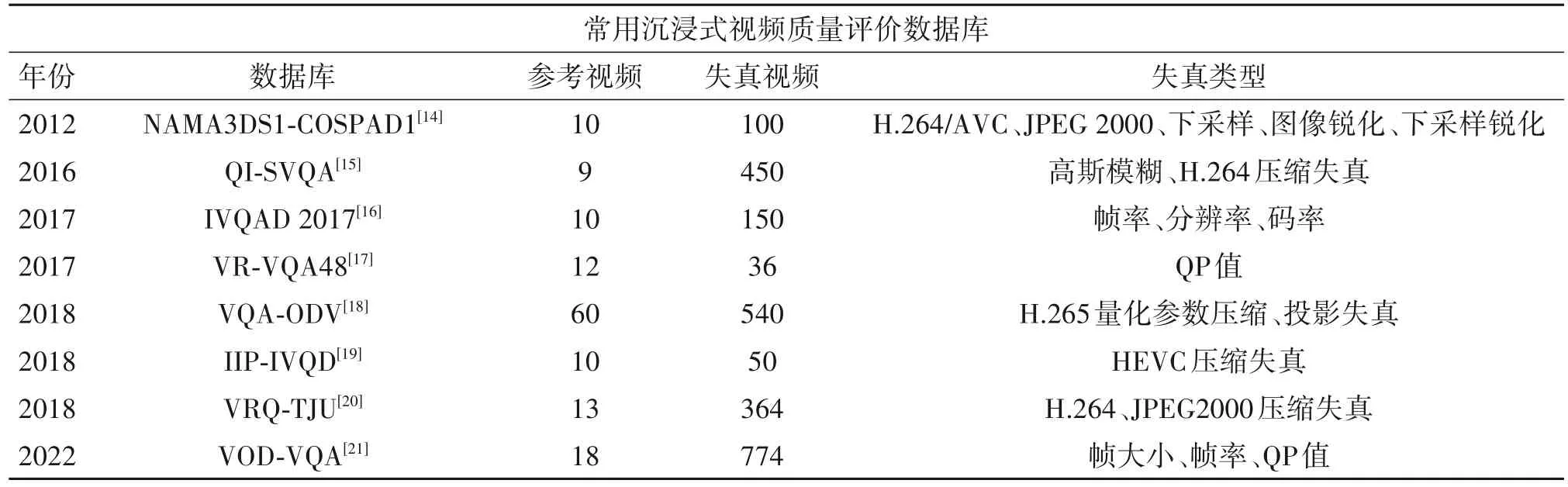

沉浸式视频质量评价数据库反映了人类视觉系统对于沉浸式视频的主观质量感知,是设计和评判沉浸式视频客观质量评价方法的重要依据。目前,基于3DoF 沉浸式视频的主观质量评价数据库已经较为成熟,考虑到数据库的多样性和实用性,本文具体介绍几种常用的数据库,如表2所示。

表2 几种常用沉浸式视频数据库Tab.2 Several common immersive video databases

1)NAMA3DS1-COSPAD1 数据库[14]:由10 个原始参考视频、100个失真视频及对应主观评分组成,失真类型包括H.264/AVC压缩失真、JPEG2000压缩失真、图像锐化和下采样锐化等。

2)QI-SVQA 数据库[15]:包括9 个原始视频和450个失真视频,失真类型包括高斯模糊和H.264压缩失真。

3)IVQAD 2017 数据库[16]:由Insta 360 4K 球形VR 摄像机拍摄的10个不同场景构成,涵盖了人物、草坪、建筑物等室内外场景,通过设置不同的帧率、分辨率和码率模拟失真情况。

4)VR-VQA48 数据集[17]:采集了12 个参考视频,并通过设置4种QP值模拟压缩失真。

5)VQA-ODV[18]数据库:参考视频涉及60 个不同的场景,包括真实场景与CG 合成场景。该数据库的失真视频构建考虑了沉浸式视频在传输、重建以及显示过程中可能引入的失真效应,即3 种不同量化参数(QP=27、37、42)下的H.265 压缩失真与3 种不同投影格式(ERP、RCMP、TSP)的组合失真,每个视频序列对应9种质量损失程度。

6)IIP-IVQD数据集[19]:在10个参考场景下通过HEVC压缩失真模拟获取50个失真视频。

7)VRQ-TJU 数据集[20]:包含13 个VR 原始视频,并基于H.264和JPEG2000压缩失真构建失真视频数据集,其中包含104 个对称视频和260 个非对称视频。

8)VOD-VQA 数据库[21]:选择18 个360°视频序列作为参考视频,通过设置不同的帧大小、帧率和QP值得到774个失真视频。

主观实验的观看设备通常为HMD,后续再采用不同的主观评分标准进行打分。值得注意的是,现有的主观实验仅能实现HMD 观看者的口述评分与手动记录数据,主观质量评价实验所需的大量数据处理工作仍然是亟待解决的一个问题。

2.2 3DoF沉浸式视频客观质量评价方法

沉浸式视频的客观质量评价方法是通过数学统计方法预测失真视频的质量损耗,可以有效弥补主观质量评价方法适用范围的局限,主观实验物力及人力耗费过高,做不到实时性,同时结果易受观察者和观测环境的影响。客观质量评价方法计算简便,实用性强。根据对参考视频的依赖程度可分为全参考、半参考和无参考方法[22]。现有的沉浸式视频客观评价方法主要是针对3DoF 沉浸式视频,包括全参考质量评价和无参考质量评价两种类型。

关于全参考质量评价方法,Sun等[22]提出了一种基于球形均匀加权的方法来准确评估失真360°视频的客观质量,通过对投影平面上每个像素点的误差引入对应的权重值,避免了由重采样表示空间转换到观察空间时产生的误差传播。Azevedo等[23]提出了一种基于视口的多度量融合方法,通过组合从360°视频的视口中提取的多种时空客观质量指标(特征)来实现失真360°视频的质量评估。Gao等[24]考虑到失真空间特征和对应时间变化对人眼视觉的影响,提出了一种时空建模方法,并将三种现有的VQA指标(S-PSNR、CPP-PSNR、WS-PSNR)集成进该方法,提高了失真360°视频的质量评估准确性。

关于无参考沉浸式视频质量评价方法,Zhang等[25]通过整合代表不同失真因素的质量因子,构建了一种VR 环境下的视听质量评估框架。Li等[26]同时考虑于视口方案(viewport proposal)和视口显著性预测,提出了基于视口方案的CNN 方法来预测失真360°视频的质量评分。Zhang等[27]基于球域提取360°视频的空间和时间特征,并通过多核学习(Multiple Kernel Learning,MKL)回归计算失真视频质量分数。Yang等[28]设计了一种端到端的神经网络模型来实现360°视频质量评价,该算法通过结合球形CNN 和非局部神经网络,有效地提取360°视频的复杂时空特征。

然而,360°视频不支持人眼的运动视差,观看360°视频时,物体的相对位置信息无法根据观看者与物体的相对位置变化而更新,这与用户在现实世界中的体验背道而驰,会导致感知的不适应。3DoF+沉浸式视频作为3DoF 至6DoF 阶段的过渡产物,除了提供三个旋转度上的体验之外,还允许一定范围的头部活动,而6DoF视频较3DoF+视频进一步增加了用户自由度,即视频内容可以根据用户观看位置的移动而改变。因此,6DoF 沉浸式视频较3DoF视频可提供正确的运动视差,带来与真实世界更为相似的观看体验,并可进一步满足沉浸式视频的相关需求。

因此,观测自由度及视差信息的增加使得基于3DoF 沉浸式视频所设计的客观质量评价方法不适用于6DoF 视频,如何探索出针对人类视觉系统和6DoF 沉浸式视频特征的高效客观质量评价算法模型是当前视频处理领域的研究热点。

3 6DoF沉浸式视频概念及相关技术

3.1 6DoF视频概念

MPEG-Ⅰ制定了沉浸式视频标准,具体涉及3DoF、3DoF+视频及6DoF 视频等等[29]。其中提及6DoF 视频具有图4 所示的三种类型:窗口式6DoF[30]、全向6DoF[31]以及6DoF。其中,窗口式6DoF需要借助显示器的帮助,在窗口受限的情况下观看视频场景,窗口式6DoF 内容是由普通2D 相机拍摄。全向6DoF 指提供不受限制的自由旋转角度(Yaw、Pitch、Roll)和有限体积内的小幅度身体平移活动,是一种受限制的6DoF形式,与3DoF+相似,但允许更大的视角范围,全向6DoF 内容是由全向(360°视频)摄像机拍摄。

图4 窗口式6DoF(左)、全向6DoF(中)和6DoF(右)[3]Fig.4 Windowed 6DoF(left)、Omnidirectional 6DoF(middle)和6DoF(right)[3]

MPEG-I 定义了6DoF 沉浸式视频的源视频格式,主要分为多视图视频加深度(Multiview Video Plus Depth,MVD)、多平面图像(Multiplane Image,MPI)和多球 形图像(Multi Sphere Image,MSI)。6DoF 视频主要采用MVD 格式,如图5 所示,具有每帧相关联的多视图纹理视频和深度视频,视频子集为具有多个视图的立体视频格式,通常由多相机系统采集[32-35]。图5(b)显示的深度视频序列场景与图5(a)中的纹理视频相对应,并可通过深度估计算法从后者提取。MVD 格式源自单视图视频加深度(Single-View Video Plus Depth,VPD),可利用深度图来渲染虚拟视图。由于MVD 格式表示的视图合成基于多个纹理视图和深度视图,其合成视图的质量通常优于VPD格式的质量。MPI格式或MSI格式主要应用于沉浸式光场视频。将视频的每一层像素固定为某一深度,MPI 视频可近似为一叠排列在不同的深度的半透明彩色层,如图6(a)所示,其是由二维规则网格图像组成的单一矩形视频。这些纹理视图的分辨率相同,是由多个相机(如微透镜阵列光场相机)拍摄得到的[36-37]。将来自相机阵列的视频流编码为一组具有RGBA 纹理的同心球体,得到如图6(b)所示的MSI视频。但由于MSI格式所占空间过大,存储数据过多不易压缩,不利于传输与展示,通常将其转换为MPI格式以作后续处理。

图5 6DoF沉浸式视频的MVD视频源格式Fig.5 MVD video source format for 6DoF immersive video

图6 沉浸式光场视频的MPI视频和MSI视频源格式Fig.6 MPI video and MSI video source formats for immersive light field video

MPEG-Ⅰ标准除了对沉浸式视频做出的规划和技术支持,其还提供部分可下载的测试参考序列(Common Test Conditions,CTC)[38],其中包含了纹理信息和深度信息。这些序列涵盖了18 种不同场景,分别以普通视口的自然视图或ERP 投影格式下的球面虚拟视图呈现。目前,MPEG-Ⅰ标准架构下已提出了许多关于6DoF 视频的算法模型,如视频的编码和解码技术,用于提取纹理视频中深度信息的深度估计技术,以及对针对场景中某一目标视点的虚拟视图合成技术等。考虑到深度估计技术和虚拟视图合成技术对沉浸式视觉感知的影响,二者已受到计算机图形学领域的广泛关注,并有望应用于沉浸式质量评价研究工作中。接下来我们分别介绍影响人眼视觉感知的6DoF 关键技术:深度估计技术和虚拟视图合成技术。

3.2 深度估计技术

针对6DoF 沉浸式视频的特征提取方案无法仅依靠纹理图像来表征场景的全部信息,而深度信息表征了拍摄对象与相机之间的空间距离,可通过计算各点之间的相对距离对场景信息进行额外补充。具体来说,相机与拍摄场景中某个像素点的相对距离可由深度信息推断,而深度信息一般以归一化视差的形式来适应人眼视觉系统,即目标像素点的灰度值反映了该点与摄像机的距离,因此更亮的区域对应更高的视差(更小的相机拍摄距离)。然而,自然场景信息采集时可能无法直接获取深度信息,深度估计技术应运而生,即利用纹理信息来计算出场景深度信息[39-40]。

目前,获取深度信息的方式主要分为主动方式和被动方式两种。其中,主动方式需要采集设备自身发射能量,常用设备包括结构光相机[41]、TOF 相机和激光雷达等。以TOF 相机[42]为例,其通过比较发射脉冲和反射脉冲的相位差来推算传输过程中的传输延迟,进而计算场景中拍摄对象与相机的距离。然而TOF 相机仍存在一些缺陷,比如相机的造价较高、采集过程易受噪声的干扰、相机获取的深度图像分辨率不及纹理图像的分辨率大,以及物体的边缘深度信息不准确等。此外,在被动获取深度信息的方式中,双目立体视觉[43-44]是比较通用的方法,即对同时获得的两张同一场景图像使用匹配算法,找寻二者间相适配的像素点,再应用三角原理得出视差,针对多张图像进行相同运算得到场景深度信息。类似的,该算法同样适用于同一场景下不同角度的图像深度信息获取。但基于双目立体视觉获取视差信息的过程易受像素点匹配精度的影响,其生成的视图仍然存在一定误差。除此之外,深度信息也能通过间接估算图像的光度特征[45]、明暗特征[46]等特征获取。以上方法主要都针对3DoF视频设计,对于6DoF 视频具有局限性,不能完全满足其深度估计的相关需求。

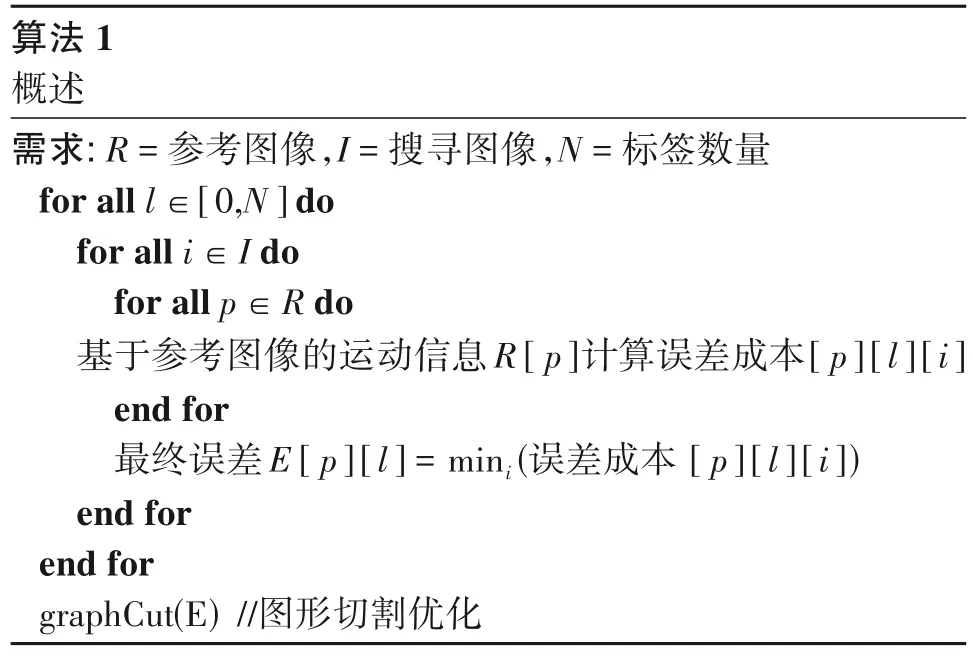

为此,MPEG-Ⅰ标准提出一种高质量的深度估计软件(Depth Estimation Reference Software,DERS),目前已经更新到DERS 8.0[47-49]。DERS 主要由表3所示的三个部分组成,即匹配成本、时间增强和图像切割。首先,基于所有可能的标签(如深度信息)为参考图像的每个像素计算一个误差成本;其次,将每个像素和标签的最终误差设定为图像对的最小误差;最后,将其进行图形切割优化,以找到每个像素的最佳深度估计。

表3 DERS算法框架[39]Tab.3 Basic framework of DERS[39]

3.3 虚拟视图合成技术

6DoF 沉浸式视频支持双目立体视差、运动视差,提供了与现实世界更相似的观看体验。但是由于采集和存储条件的限制,任意视点间的视觉信息不能完全获取,即在位移、遮挡等情况下导致采集时的信息丢失。现有情况下,如何有效利用已知视点预测目标视点是6DoF 视频重建及展示阶段亟须解决的一项重要问题。

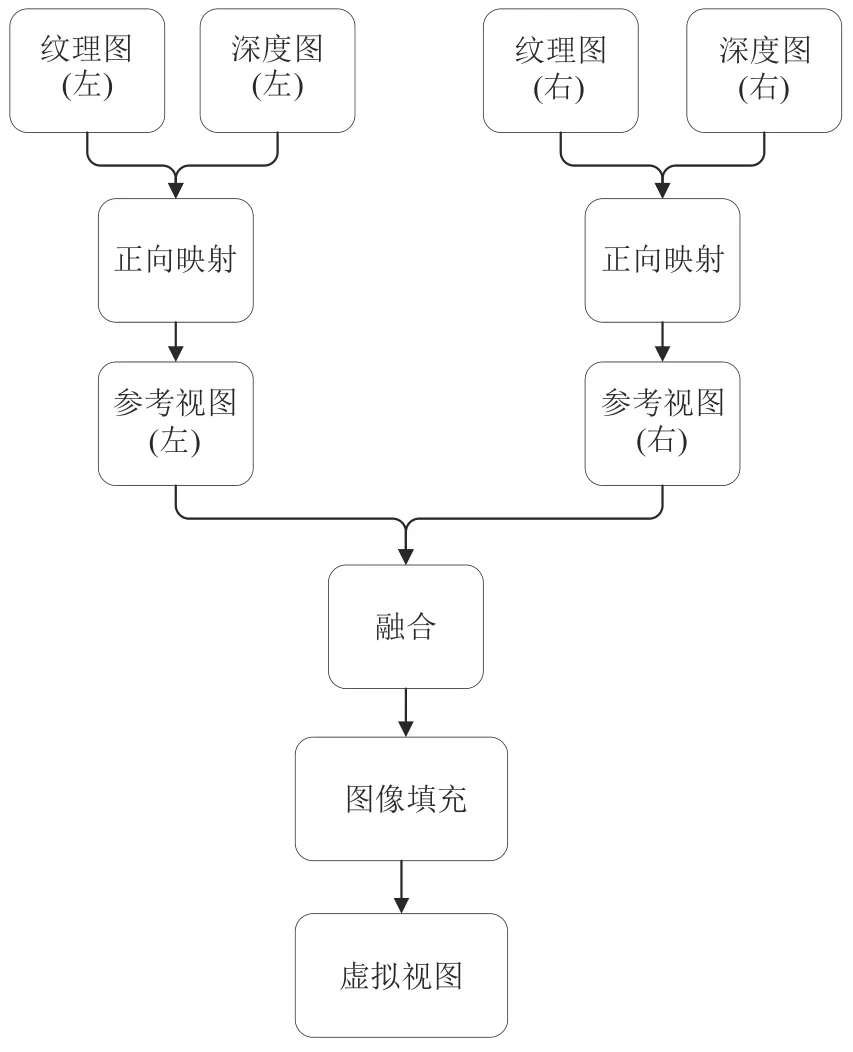

基于图像的视图合成算法通过参考已知视点的信息,利用3D-Warping 投影、插值等手段直接合成虚拟视图,高效生成符合需求的虚拟视图,因此基于图像的虚拟视图合成算法得到了广泛应用。此外,目前基于深度图像探索算法模型对已知场景进行虚拟视图合成的研究领域具有一定的热点。基于深度图像目标视点的虚拟视图合成方法(Depth Image Based Rendering,DIBR)[50-52]通过一组视频序列(纹理视频和深度视频)和相应的信息来生成非获取视点的图像,其算法框架如图7所示,主要分为三步:3D-Warping 投影、融合和图像修复。首先,对输入纹理视图及深度视图进行变换,各自生成一个虚拟的目标视图;其次,融合两幅生成的虚拟视图;最后,对融合后产生的空洞进行填充修复。然而,DIBR 方法存在缺陷,其主要针对传统2D场景。由于高自由度沉浸式视频的映射方式区别于2D 视频,满足高自由度沉浸式视频的虚拟视图合成模型亟待探索。

图7 DIBR算法基本框架Fig.7 Basic framework of DIBR

针对6DoF沉浸式视频,MPEG-I标准提出两种参考视图合成工具RVS(Reference View Synthesizer)及VSRS(View Synthesis Reference Software)[53-55],克服了低数量参考视图合成虚拟视图的限制,支持任意数量的输入视图进行视图合成,采用自然、逼真的渲染且无需事先进行3D 建模。值得注意的是,与RVS 相比,VSRS 在非平面相机对准和步进方面的结果较差,然而这两种软件工具都显示出较好的发展趋势,即有助于在未来工作中推断最佳输入的相机位置及数量,满足高自由度沉浸式视频的采集和渲染需求。

3.4 6DoF沉浸式视频质量评价

深度估计技术和虚拟视图合成技术对沉浸式视觉感知尤为重要,6DoF 沉浸式视频相比于3DoF沉浸式视频,表征的信息更多,因此更能带来沉浸式的视觉感知体验。对于沉浸式视频的质量评价而言,除了常用的纹理信息、边缘信息和色度信息等,也需要考虑深度信息,用于模拟主观感知场景过程中对景深信息的感知,因此深度估计技术对6DoF 视频主观评价过程具有重要意义。而虚拟视图合成技术能够对任意已知视图间的虚拟视图进行合成,视图能够进行任意切换满足了6DoF 视频观看时更高的沉浸式视觉感知体验。在6DoF 沉浸式视频质量评价研究工作中,除了利用多数经典算法所考虑的纹理信息、色度信息等信息,如何利用这两种技术设计出性能优越、鲁棒性好的算法模拟视觉感知,以此满足6DoF 沉浸式视频身临其境的体验需求,仍有待探索。

4 总结和展望

本文首先概述沉浸式视频的概念和研究背景,然后就3DoF 沉浸式视频的主观质量评价数据库和客观质量评价算法展开介绍,最后分析影响6DoF沉浸式视频质量评价的相关技术,并简要介绍了最新成果。随着人们在学习、工作和休闲等各个方面对视觉媒体不断增强的视觉体验需求,不同应用场景下的视频质量评估和质量感知优化工作需求日益递增。未来的研究工作中,端到端的沉浸式视频处理系统在拍摄、制作、编转码、传输分发和呈现设备中仍存在很大的发展空间,高自由度沉浸式视频也将在医疗、教育、虚拟游戏等领域得到广泛应用。因此,针对沉浸式视频的质量评价研究同时具有学术研究意义和现实应用意义,其主观和客观研究方向有望深入探索并应用于更多具体场景。