基于强化学习方法的变循环航空发动机推力控制

齐义文,张 弛,陈禹西

(沈阳航空航天大学 自动化学院,沈阳 110136)

变循环航空发动机与涡轮或涡扇发动机相比,增加了众多可变几何部件,可改变发动机的循环参数[1],以满足亚音速、跨音速、超音速等不同条件下的飞行要求,显著提高发动机推进系统的整体性能。但可控部件的增多、各部件之间存在的耦合等因素却给控制系统设计增加了负担,而PID控制、自抗扰控制、模糊控制等传统控制方法又存在响应速度较慢、鲁棒性较弱等局限,对于变循环航空发动机这一类多变量、多模态、强耦合系统,难以在全包线和变工况下达到理想的控制效能[2]。因此,探索其他性能更优异、设计更简便、响应速度更快的控制方法十分必要。而强化学习方法作为人工智能技术重要的前沿方法之一,具有不依赖模型、自学习、自更新等优点[3],可通过“试错”方式不断形成经验完善的控制策略,是解决复杂系统控制设计难题的一种有效手段。

有关强化学习方法在其他领域的应用,国内外已有颇多成果。Xie等[4]提出了一种基于强化学习的模糊自适应滑模控制器,改善了三刚体连杆机械手的抖振效果,并保持了鲁棒性。Samadi等[5]提出了一种基于多智能体的分布式微电网能量管理方法,采用强化学习优化了运行成本。You等[6]提出了一种基于深度确定性策略梯度的无人机连续战略机动规划方法,改善了三维动态高空环境下目标跟踪的鲁棒性。Zhao[7]利用一种新的强化学习方法,研究了多参与者连续时间非线性系统非零和博弈的最优跟踪控制问题。Lan等[8]应用强化学习理论实现了集群系统在未知动态环境下的协同学习与作业。Huang等[9]利用深度强化学习的高维特征提取和非线性泛化能力,开发了电力系统新型自适应应急控制方案。Chu等[10]提出了两种方法用于稳定强化学习的学习过程,利用大型合成交通网格模拟摩纳哥市的大型交通网络动态,试验证明所提出算法具有最优性和鲁棒性。相晓嘉等[11]以固定翼无人机为对象,考虑复杂动态环境的随机性和不确定性,提出了基于无模型深度强化学习的无人机编队协调控制方法。张耀中等[12]针对无人机集群协同执行对敌方来袭目标的追击任务,设计了一种引导型回报函数,有效解决了深度强化学习在长周期任务下的稀疏回报问题。

在变循环航空发动机控制方面,何凤林等[13]针对XTE76变循环航空发动机的控制结构问题,研究了对二分块之间进行解耦的控制方法。肖红亮等[14]针对变循环航空发动机存在的不确定性及外部干扰下多变量输出跟踪控制问题,给出了一种基于线性二次型调节器(Linear Quadratic Regulator,LQR)方法的增广模型参考自适应滑模控制方法。Chen等[15]提出了一种基于红外预测模型的变循环航空发动机最小红外特性性能寻求控制方法,并对双旁路可变循环航空发动机分别进行了最大推力、最小耗油率和最小红外特性优化控制仿真。陈玉春等[16]针对变循环航空发动机多变量稳态控制规律优化设计,提出了一种新方法—逆算法。

尽管变循环航空发动机控制取得了一些进展,但强化学习方法在本领域的应用尚不多见,仍多采用依赖于专家经验的PID变参控制方法。而强化学习方法具有不依赖模型的优点,用于变循环航空发动机这一类强非线性复杂系统的控制,可有效降低控制设计难度,其自学习性、自更新性可实现变循环航空发动机多变工况下的高性能控制。据此,本文针对变循环航空发动机,给出两种基于强化学习方法的变循环航空发动机推力控制设计方法,并通过仿真验证了方法的快速性、准确性、稳定性与鲁棒性。

1 变循环航空发动机模型

本文采用的是姜渭宇等[17]在“变循环涡扇发动机智能控制仿真平台研究”一文中建立的双外涵变循环航空发动机模型,其结构如图1所示。

图1 变循环航空发动机结构图

与传统发动机相比,该发动机增加了多个可调部件,其可控参数包括:主燃油流量、高压压气机导流叶片角度、加力燃油流量、风扇导流叶片角度、喷口临界面积、喷口膨胀面积、核心机风扇导流叶片角度、低压涡轮导向器控制角度、核心机风扇的混合器面积、第一外涵面积。此外,模型输入还包括来流气体参数,即进气静压、进气静温、进气总压与进气总温等。

变循环航空发动机传感器测点参数包括:风扇物理转速、高压物理转速、进气静压、进气静温、进气总温、进气总压、风扇后内涵温度、风扇后内涵压力、核心机风扇后内涵温度、核心机风扇后内涵压力、高压压气机后温度、高压压气机后压力、涡轮后温度、涡轮后压力等。此外,根据模型输入参数及传感器参数可间接计算推力、压比、流量、涵道比等不可测的变循环航空发动机性能参数。出于安全保护,变循环航空发动机在运行期间还需考虑高低压转速与涡轮前温度等限制。

2 基于强化学习的推力控制设计

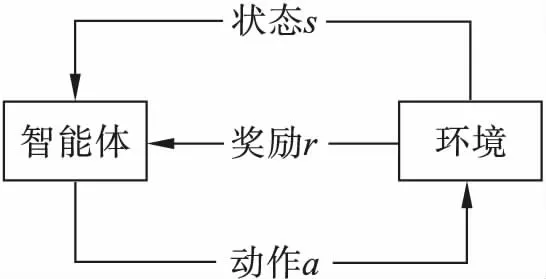

强化学习用于描述和解决智能体在与环境交互过程中通过学习策略以达成回报最大化或实现特定目标的问题[18],其简洁原理如图2所示。

图2 强化学习示意图

智能体不断接收环境状态信息,并基于状态信息反馈相应动作于环境,更新环境状态。同时,智能体在做出动作后会获得对应奖励,通过与环境的往复交互,利用奖励不断更新策略,达到既定学习目标。与传统控制方法相比,强化学习方法支持多维度输入输出,可不依赖控制模型,并对非线性复杂系统有着出色的逼近能力,且对对象运行特性的未知变化和不确定性有良好的预测、自学习能力和鲁棒性。

2.1 基于DQN的变循环航空发动机推力控制设计

深度Q网络(Deep Q Network,DQN)是一种基于值的强化学习算法[19],算法流程如图3所示。通过交互,不断更新Q网络参数来拟合动作价值函数,该函数进一步指导动作输出。同时,引入经验集合,缓存交互参数,并随机采样缓存经验实现网络参数的批量更新,既节约了计算资源,也有效减弱了时间序列对网络更新的影响。

基于DQN算法的变循环航空发动机推力控制设计主要分为如下4步。

(1)状态与动作参数选取

为降低Q网络对动作价值函数的拟合难度,状态参数需直观反映变循环航空发动机工作状态。此外,动作参数与状态参数之间需具有明确对应关系,否则会增加网络训练难度,甚至无法收敛。本设计将表征发动机运行情况的变循环航空发动机高低压转子转速作为状态参数。在设计初期,选取目标推力、推力误差、高低压转子转速3项作为控制器输入状态参数;选取主燃油流量作为控制器输出参数,其余执行机构输出由相关控制规律给定。在网络训练中,通过给定不同目标推力指令来实现可变推力控制要求。然而在实际训练中,由于控制精度要求,需对主燃油流量动作进行更精细的划分,并且不同目标推力给定的训练十分耗时。在这样的背景下,初期设计的网络对于训练之外的目标推力难以实现较好的预测效果。

图3 DQN算法原理图

进一步对状态和动作参数再设计,将控制器输入状态参数调整为推力误差、高低压转子转速和上一时刻主燃油流量;将控制器输出参数调整为主燃油流量的增量,并加以限制,使变循环航空发动机运行在安全范围内。这样,新设计方法既减小了动作集合A的大小,提高了训练速度,又能对变指令操作起到良好的控制效果。在上述设计基础上进一步扩展,考虑变循环航空发动机变工作点运行。在训练时,考虑不同工作点的来流参数。同时,引入推力阶跃训练指令,使控制器在变推力指令时仍具备高精度控制性能。最终,本文选用改进后的状态、动作参数作为控制器的输入输出。

(2)奖励函数设计

奖励函数的设计是否合理直接影响到网络能否收敛、收敛效果及控制精度。奖励条件与控制目标还需具有确切关系,以起到对网络训练的有效指导作用。此处设计的奖励函数由推力误差决定,推力误差绝对值越小,对应奖励值越大。设计初期采用的奖励函数为

(1)

式(1)中:Fn_e为推力误差绝对值;r为奖励值。但基于该奖励条件与上述选取的状态、动作参数设计的推力控制器稳态误差较大,无法满足控制要求。因此,对推力误差绝对值与奖励条件做了进一步划分,以达到高性能的控制目标,改进后的奖励函数为

(2)

最终,采用式(2)的奖励函数,有效减小了稳态误差,提高了控制精度。

(3)控制策略设计

由于网络层数较多,为便于理解,本文均以3层网络为例加以说明。Q网络接收变循环航空发动机状态参数s,输出当前状态下全部主燃油流量增量动作对应的Q值,即Q(s,A)。

(3)

式(3)中:ωQ1∈R(n+p)×m与ωQ2∈Rm×p均为权重矩阵;bQ∈Rm为偏置列向量;σ(·)为Relu激活函数,s∈Rn为变循环航空发动机状态列向量,A∈Rp为主燃油增量动作列向量,也称动作集合。通过ε-greedy策略从动作集合A中选择主燃油增量作为输出动作,变循环航空发动机状态参数更新为s′并得到奖励值r。ε-greedy策略为

(4)

式(4)中:a∈R为A中包含的主燃油增量动作之一;maxQ(s,A)为从式(3)选取最大的Q(si,ai),i=1,2,…,p对应的主燃油增量动作a;randmona为从A中随机选取主燃油增量动作;rand为0~1的随机数;ε为0~1的随机因子,通过改变ε的大小可调节Q网络训练期间的随机探索性。训练初期ε取0.3,使网络具有较大探索能力。随着训练时间的增加,ε逐渐减小。完成训练后,将ε置为0,使其完全按照已具备大量经验的Q网络输出主燃油增量动作。

(4)更新Q网络

鉴于变循环航空发动机仿真模型每次运行都包括约150s的起动段,之后强化学习控制器才介入,而起动段的交互信息对强化学习控制器训练是无效的,因此设定经验集合在强化学习控制器介入后才开始缓存交互经验。从经验集合中随机采样训练样本,每次采样的经验格式为[s,a,s′,r,is_done],其中is_done判断s′是否为终止状态,具体包括判断高低压转子转速、推力误差、涡轮温度、喘振等变循环航空发动机重要指标是否超限,若任一指标超限,则s′为终止状态,is_done为1,结束本轮仿真;否则is_done为0,继续执行仿真训练。s′输入至Q网络,Q网络输出s′状态下对应全部主燃油增量动作的Q值Q(s′,A),将最大Q值记为Q(s′,a′),据此,计算目标Q值即Q′

(5)

基于此,可计算Q网络反向传播误差JQ为

(6)

式(6)中:q为采样个数。Q网络通过梯度下降法更新权重与偏置参数

(7)

(8)

式(7)~(8)中:αQ∈R为Q网络更新步长。鉴于每轮仿真DQN控制器与变循环航空发动机模型的交互次数是可获取的,而每次交互获得的奖励值也是可记录的,当网络收敛至最优动作价值函数时,控制器每次交互均可得到最大的奖励值。基于此,将网络更新收敛条件设为单轮仿真累计奖励值最大,即控制器每次交互获得的奖励值最大。

2.2 基于DDPG的变循环航空发动机推力控制设计

深度确定性策略梯度(Deep Deterministic Policy Gradient,DDPG)是一种融合了基于值与策略的强化学习算法[20],算法流程如图4所示。与DQN算法相同的是采用经验集合缓存交互参数。与DQN不同在于,DDPG使用4个神经网络,并行两队快速更新和缓慢更新的神经网络,提高了网络稳定性。4个网络作用分别为:Actor估计网络与环境交互;和Critic估计网络通过交互信息更新自身参数并指导Actor估计网络更新;Actor目标网络与Critic目标网络预测下一时刻动作与动作价值函数。

图4 DDPG算法原理图

基于DDPG算法的变循环航空发动机推力控制状态参数选取、奖励函数设置、训练指令设计、网络收敛条件设定、经验集合缓存机制与DQN算法一致,不同在于DDPG算法无需构建离散的主燃油增量动作集合A,而是通过Actor估计网络自学习、自更新以输出主燃油增量动作。此外,还需对主燃油流量加以限制,实现对变循环航空发动机的安全保护。

基于DDPG算法的变循环航空发动机推力控制设计主要分为4步。

(1)Actor估计网络设计

以变循环航空发动机状态参数s作为Actor估计网络输入,输出对应主燃油增量aWf,更新变循环航空发动机状态s′并得到奖励r,动作aWf与状态s的关系为

aWf=ωea2Tσ(ωea1Ts-bea)+N

(9)

式(9)中:aWf′∈R为主燃油增量;ωea1∈Rn×m与ωea2∈Rm×l均为权重矩阵;bea∈Rm为偏置列向量,N∈R为添加的高斯噪声,且随着网络迭代增加,噪声强度逐渐减弱,以此来解决训练过程前、后期不同的探索与收敛需求。

(2)Critic估计网络设计

Critic估计网络评价Actor估计网络在当前变循环航空发动机状态s下输出主燃油增量动作aWf的优劣,以s和aWf作为Critic估计网络输入,输出评价函数Qc(s,aWf)。

(10)

式(10)中:ωec1∈R(n+l)×m为权重矩阵;ωec2∈Rm为权重列向量;bec∈Rm为偏置列向量。

(3)Actor与Critic目标网络设计

Actor目标网络、Critic目标网络分别与Actor估计网络、Critic估计网络初始参数及网络结构完全一致。Actor目标网络以Actor估计网络作用后的变循环航空发动机状态s′作为输入,输出新的主燃油增量动作aWf′,Critic目标网络以s′和aWf′作为输入,输出评价函数Qc(s′,aWf′)。

(4)网络更新

Critic估计网络的反向传播误差为

(11)

式(11)中:q为采样个数;yi为目标评价函数值。

(12)

式(12)中:ri为奖励;γ为折扣因子;取值范围为0~1。基于此,可得出Critic估计网络权重与偏置更新公式

(13)

(14)

式(13)~(14)中:αec为Critic估计网络更新步长。为减小Critic估计网络的反向传播误差Jec,Actor估计网络需输出使评价函数Qc(s,aWf)值更大的主燃油增量动作aWf,Actor估计网络的反向传播误差为

(15)

基于此,可得出Actor估计网络权重与偏置更新公式

(16)

(17)

需要注意的是,目标网络与估计网络具有不同的更新频率,以减弱网络间的耦合性,目标网络以软更新的方式更新权重与偏置,即每次只以较小幅度更新网络参数,Critic目标网络更新公式为

ωtci=τωeci+(1-τ)ωtci,i=1,2

(18)

btc=τbec+(1-τ)btc

(19)

Actor目标网络更新公式为

ωtai=τωeai+(1-τ)ωtai,i=1,2

(20)

bta=τbea+(1-τ)bta

(21)

式(18)~(21)中,τ为0.1以下的更新系数。

3 仿真验证与分析

分别在高度H=13 km、马赫数Ma=0.8和高度H=10 km、马赫数Ma=1.5两种飞行状态下,进行变循环航空发动机强化学习推力控制方法的仿真验证。控制器通过输入设定的变循环航空发动机状态参数,输出主燃油增量指令,其余控制变量由与反馈推力相关的控制规律给定,模型输出变循环航空发动机各性能参数。给出不同推力指令下实际反馈推力与主燃油流量的变化,并将基于DQN算法、DDPG算法设计的两种控制器进行对比分析。

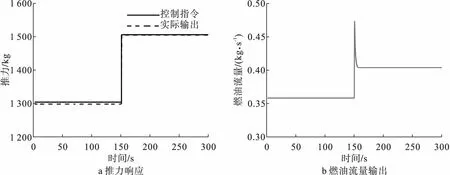

图5~图6给出了在高度H=13 km、马赫数Ma=0.8飞行条件下,基于DQN和DDPG算法的变循环航空发动机控制器150s阶跃指令下的推力响应和主燃油流量变化。DQN控制器达到了稳态误差0.067%、调节时间1.25 s和超调量0.53%的控制指标,DDPG控制器则实现了稳态误差0.067%、调节时间1.2 s和超调量0.27%的较高精度控制。两种设计均获得良好的跟踪控制品质,验证了控制设计的正确性和有效性。

图5 高度13km、Ma=0.8阶跃指令DQN控制器仿真结果

图6 高度13 km、Ma=0.8阶跃指令DDPG控制器仿真结果

图7~图8给出了在高度H=10 km、马赫数Ma=1.5飞行条件下,基于DQN和DDPG算法的变循环航空发动机控制器150 s阶跃指令下的推力响应和主燃油流量变化。可知,DQN控制器达到了稳态误差0.067%、调节时间1.31 s和超调量1%的控制指标,DDPG控制器实现了稳态误差0.067%、调节时间1.5 s和超调量0.27%的控制指标。

图7 高度10 km、Ma=1.5阶跃指令DQN控制器仿真结果

图8 高度10 km、Ma=1.5阶跃指令DDPG控制器仿真结果

在变循环航空发动机推力控制仿真验证中,DDPG控制器与DQN控制器达到了相同的高控制精度,二者调节时间差别不大,而DDPG控制作用下的超调量显著小于DQN控制器。需要注意的是,虽然DQN算法下的推力控制设计实现了较高的控制性能,但算法本身仅支持离散的燃油增量动作输出,其推力响应与主燃油流量输入经多次动作设计后仍存在较小幅度的振荡。DDPG算法支持连续的燃油增量动作输出,无需构建动作集合即可实现变循环航空发动机推力及主燃油流量的无振荡调节。由此,基于DDPG算法的变循环航空发动机推力控制器通过自学习、自更新,有效地实现了推力的稳定、快速、准确控制,进一步验证了基于强化学习方法的变循环航空发动机控制器输入输出参数及奖励函数设计的合理性。

由表1可见,基于DQN与DDPG两种强化学习方法的变循环航空发动机推力控制设计均实现了变循环航空发动机高精度可变推力控制。由于DQN算法仅支持离散动作输出,在推力控制设计中,需对其主燃油流量增量动作集合不断完善,设计不当会导致主燃油流量与输出推力发生大幅振荡。

表1 主要控制性能指标

综上,在不同飞行状态下,基于DQN和DDPG算法的变循环航空发动机推力控制设计在阶跃指令下均实现了高性能、高精度控制。

4 结论

本文对两种变循环航空发动机强化学习推力控制方法进行了研究,可得出以下结论:

(1)强化学习算法对于变循环航空发动机这一类具有强非线性、强耦合的复杂系统,可实现较好的控制效果,且具有稳定、快速、准确的优点。其不依赖模型的特点在一定程度上可简化控制设计,降低设计难度。

(2)控制增量设计可有效避免DQN一类基于值的强化学习算法输出存在振荡的问题,弥补算法本身只支持离散动作输出的不足,既提高了训练速度,也改善了控制精度。但动作设计的合理性需通过实验进一步确定。

(3)在网络训练过程中加入随机噪声可提高网络的探索性,引入变指令训练可提高网络对不同控制指令的控制及预测能力。从经验集合中随机采样训练样本,可有效减弱时间序列对网络训练带来的不利影响。

然而,在变循环航空发动机强化学习控制设计过程中,仍存在一些问题有待研究:

(1)如何利用已有的设计方案实现变循环航空发动机全包线、多工况、多变量、多目标的寻优设计,进一步提高控制品质。

(2)由于发动机的历史运行数据是可获取的,如何利用已有数据进行网络参数的初始化来减少网络运行成本,还需进一步考量。

(3)发动机性能衰退是发动机服役过程中不可避免的问题,而强化学习算法又具备自学习、自更新能力,如何使发动机在特性衰退时仍保持一定的性能水平,仍需研究。