生成式双波段彩色融合图像质量评价

张威

(中国石油大学(华东)计算机科学与技术学院,山东青岛 266580)

可见光(微光)与红外彩色融合技术通过生成一幅彩色融合图像帮助观察者更快更准确地发现热目标、理解场景内容,在交通、遥感、安防等领域发挥着重要作用[1]。如何有效地对彩色融合图像质量进行客观评价,一直是人们研究的焦点和难点。

传统的无参考图像质量评价方法分为两部分。首先设计学习器用于提取质量感知特征[2-6],然后通过映射函数将感知特征映射到质量分数进行评价。

近年来,有很多成熟的机器学习和深度学习方法被用于图像质量评价(Image Quality Assessment,IQA)[7-10]。文献[11]提出了一种高度无监督的IQA 方法,它不需要训练样本,也不依赖于人眼的主观评价评分。文献[12]提出了一种基于多个最小可觉察误差(Just Noticeable Distortion,JND)模型的无参考图像质量评价方法,将多种JND 模型应用于提取多尺度图像的特征和深度图,最后合并这些特征并映射到客观分数。文献[13]利用张量分解生成多个特征图提出了一种新的无参考质量评估方法。文献[14]通过门控卷积神经网络学习相邻块图像之间的颜色相关性,利用图像的语义信息提高了神经网络的识别能力,建立了更有效的图像颜色协调性评价模型。

基于以上研究,提出了一种生成式双波段彩色融合图像质量评价方法。该方法通过对抗生成网络(Generative Adversarial Net,GAN)预测彩色融合图像的主要内容,在目标函数中引入了结构差异度约束。根据约束函数向预测内容中加入不同程度的无序信息,生成一个伪彩色融合图像数据集。之后建立一个基于孪生网络的质量评估器,在伪彩色融合图像数据集中进行预训练,在真彩色融合图像数据集中进行微调,对彩色融合图像质量进行评估。

1 生成对抗网络

如图1 所示,对抗生成网络一般由两个子网络组成,分别为一个生成器G和一个判别器D。其中生成器用来生成样本,判别器用来区分真实样本和生成样本。G和D的训练过程是最小化一个目标函数:

图1 生成对抗网络模型结构

其中,Pdata为真实样本的分布,Pz为输入噪声的分布。

通过区分真实样本和生成样本不断地对判别器进行优化,而生成器通过不断地最小化ln(1-D(G(z))被优化。通过这种对抗性的训练,最终生成器可以生成更接近真实样本的生成样本,判别器无法区分真实样本和生成样本。

2 生成式双波段彩色融合图像质量评价模型

如图2 所示,生成式双波段彩色融合图像质量评价模型主要分成两个模块:基于GAN 的生成模块和基于孪生网络的质量评估模块。生成模块通过GAN 推测彩色融合图像的主要内容,生成大量的伪彩色融合图像;质量评估模块通过孪生网络在伪彩色融合图像数据集中进行预训练,在真彩色融合图像数据集中进行微调,之后对彩色融合图像质量进行评价。

图2 生成式双波段彩色融合图像质量评价模型结构

2.1 基于GAN的生成模块

生成模块由生成器G和判别器D构成,以红外图像Id1和可见光图像Id2作为输入,预测其主要内容Ig,即Ig=G(Id1,Id2)。判别器的主要目的是区分预测主要内容Ig和真实主要内容Ir。通过G和D之间的对抗训练,预测主要内容Ig越来越接近真实主要内容Ir。

通过采用WGAN-GP[15]的框架,将判别器D的目标函数定义为:

其中,Ladv为对抗损失,LGP为梯度惩罚项。

Ladv定义如下:

其中,Pr为真实主要内容的分布,Pg为预测主要内容的分布。

LGP的定义如下:

其中,Px表示在Pr和Pg之间沿直线均匀采样的抽样分布,‖‖∇xD(x)2表示D的输出相对于输入的梯度范数,λ表示惩罚系数。

在对抗损失Ladv的约束下,不断对生成器进行优化。除对抗损失外,为了使生成器G更准确地预测图像的真实内容,将像素损失Lpix和内容损失Lcon添加到生成器的损失函数中,其中,Lpix计算像素空间上预测主要内容Ig和真实主要内容Ir之间的差异,计算公式为:

其中,MSE 表示两个输入之间的均方误差。

内容损失定义预测主要内容Ig和真实主要内容Ir在特征空间上的差异,计算公式为:

其中,ϕk表示第k个卷积层的特征映射。

为了使得生成出的伪融合图像和真实融合图像更加一致,在生成器G的目标函数中提出了一个结构差异约束条件。使用输入图像与预测主要内容Ig之间的预测误差Iu表示无序信息,计算公式如下:

主要内容Ig包含输入图像的主要结构信息,因此主要内容Ig和预测误差Iu之间的结构相似性应尽可能小。利用经典的SSIM 计算结构相似度,定义为:

其中,x和y分别代表两幅要比较的图像,μx和μy分别为平均值,σx和σy为标准差,C1和C2为常数。将主要内容Ig和预测误差Iu之间的结构相似性定义为:

将Ig和Iu转化为灰度图像计算Is。为了保持主要内容的结构完整性,通过最小化下式来定义结构差异约束:

其中,W和H分别表示Ig的宽度和高度。

最后将生成器的目标函数表示为:

其中,μ为损失权重,用于平衡各类损失。

由于无法获得红外图像和可见光图像的真实主要内容,使用彩色融合图像进行替代。在完成生成器的训练之后,获得生成器目标函数的最小值Gmin*,为了向生成的伪彩色融合图像中加入不同程度的无序信息,设置不同的生成器目标函数值使得生成模块的训练提前停止,以此向伪彩色融合图像中加入不同程度的无序信息,计算公式为:

2.2 基于孪生网络的质量评估模块

在生成伪彩色融合图像数据集后,采用孪生网络对图像质量进行评价。首先基于孪生网络的质量评估模块在伪融合图像数据集中进行预训练,之后在真彩色融合图像数据集中进行微调。

基于孪生网络的质量评估模块结构如图3所示。

图3 基于CNN的质量评估模块结构

将两幅待比较的彩色融合图像分别输入至网络1 和网络2,网络1 和网络2 为参数共享的孪生网络,网络的配置为卷积-64、卷积-64、池化、卷积-128、卷积-128、池化、卷积-256、卷积-256、池化,其中卷积-m表示卷积核为3×3、步长为1 和输出通道为m的卷积层,孪生网络中的所有池化层大小均为2×2,步长2。两幅融合图像经过孪生网络之后进行合并,过程表述为:

其中,T表示孪生网络提取出的特征向量,subnetworki代表网络i的运算过程,concat 代表向量的合并。

3 实验结果与分析

3.1 数据集

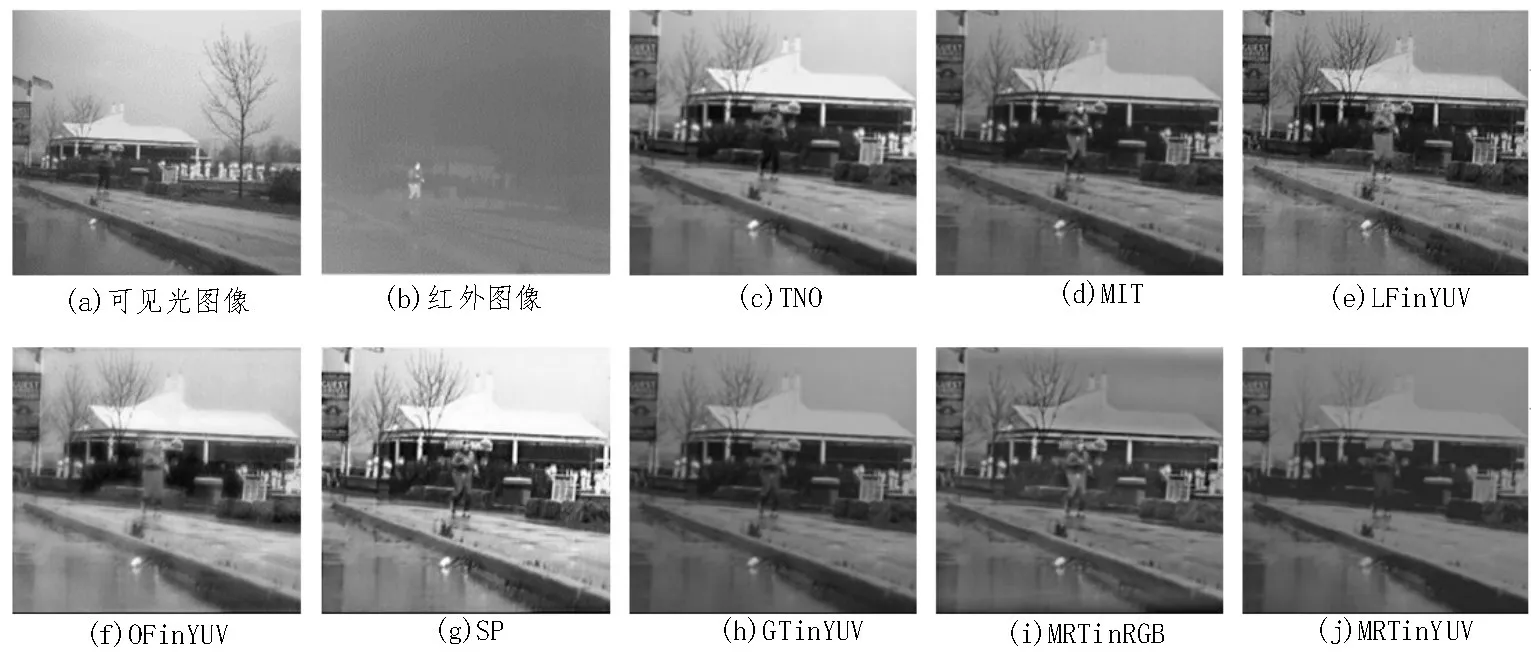

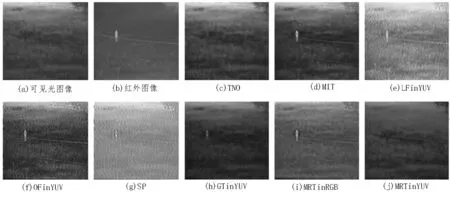

实验数据集来源于文献[16],数据集共分为三类典型场景,51 组图像,每组图像包含八幅彩色融合图像,分别由八种不同的融合算法融合同一场景下的可见光图像和红外图像生成,每幅图像大小均为320×240 像素。主观评价实验采用7 分制的评分标准,对应非常不满意到非常满意七个等级。图4-6 分别给出每类典型场景的一组融合图像,每组包含一幅可见光图像和一幅红外图像以及八幅融合图像。

图4 城镇建筑物场景图像中的一组源图像及八幅融合图像

图5 海天场景图像中的一组源图像及八幅融合图像

图6 绿色植物场景图像中的一组源图像及八幅融合图像

将数据集随机分为两个子集,80%用于训练,20%用于测试。在训练阶段,采用训练集对生成模块进行训练,将无序信息添加程度值设置为I,λi取[1,3]之间的I个均值,生成一个伪彩色融合图像数据集,其标签是两幅图像比较的结果。将质量评估模块在伪彩色融合图像数据集中进行预训练,在真彩色融合图像数据集中进行微调。在测试阶段,将两幅待比较的彩色融合图像输入到质量评估模块,输出彩色融合图像的评价结果。

采用准确率、Pearson 相关系数和Spearman 相关系数三个评价指标对模型进行评价。其中使用准确率可以直接判断模型在伪彩色融合数据集和真彩色融合图像数据集中的表现情况;通过评价结果对融合图像进行排序后使用Pearson 相关系数和Spearman 相关系数在真彩色融合图像数据集中衡量模型的性能。

3.2 模型评价结果分析

文中提出了一种生成式双波段彩色融合图像质量评价模型,从两方面对该模型进行有效性分析:1)分析模型本身的参数及网络结构对评价结果的影响;2)通过对比其他具有代表性模型的评价结果验证模型的有效性。

设置不同无序信息程度值I,模型的评价结果如表1 所示,其中,准确率A为质量评估模块在伪彩色融合图像数据集中评价的准确率,准确率B、Pearson相关系数和Spearman 相关系数为在真彩色融合图像数据集中的评价结果。随着I值不断减小,质量评估模块在伪彩色融合图像数据集中的表现越来越好,生成的伪彩色融合图像之间的差距也随之增大,但是会产生一定的过拟合情况,使得在真彩色融合图像数据集中的表现先提高然后再降低,Pearson 相关系数和Spearman 相关系数从另一个方面论证了这个结论。实验结果表明,当I值设置为10 时可以获得较好的评价结果。

表1 添加不同程度无序信息的评价结果

使用一些现有的卷积神经网络结构作为质量评估模块检验对模型评价结果的影响,分别采用Vgg16、Vgg19、Resnet50 和Resnet101 作为质量评估模块中的子网络进行训练,评价结果都是在真彩色融合图像数据集中得出,如表2 所示,Resnet 相较于Vgg 取得了更好的实验结果,残差结构可以使网络在提取图像特征时丢失更少的信息,文中设计的质量评估模块的结果略微优于Vgg。

表2 不同类型质量评估器的对比结果

之后对比两种基于局部图像的图像质量评价方法,其中文献[17]首次提出了此类图像质量评价方法(模型A),文献[18]提出采用全参考的方式对局部图像的质量分数进行定义(模型B),但是由于缺少参考图像,采用文献[16]中的方法对局部图像的质量分数进行定义。文中模型(模型C)与这两种方法的对比结果如表3 所示,模型A 中局部图像直接继承原始图像的质量分数的做法会引入大量的错误信息,所以模型A 的评价结果最差;由于真彩色融合图像数量过少,模型B 的评价结果也没有达到预期,而生成式双波段彩色融合图像质量评价模型取得了更好的评价结果,证明了该模型在双波段彩色融合图像质量评价方面的有效性。

表3 与基于局部图像方法的评价结果对比

另一类常用的图像质量评价方法是在ImageNet上进行预训练,由于ImageNet 与彩色融合图像数据库差别过大,使用文献[14]中基于门控卷积神经网络的图像质量评价模型(模型D)在AVA 数据集中进行预训练,之后在融合图像数据集中进行微调。此外还对比了文献[16]中基于记忆色的双波段彩色融合图像质量评价方法(模型E)。对比结果如表4 所示,由于AVA 数据集与彩色融合图像数据集相差较大,且融合图像数据量较少,模型D 的评价结果较差,而生成式彩色融合图像质量评价方法取得了与人眼主观评价较为一致的结果。

表4 与其他方法的评价结果对比

4 结论

文中提出了一种生成式双波段彩色融合图像质量评价方法,该方法分为基于GAN 的生成模块和基于孪生网络的质量评估模块。通过生成模块预测彩色融合图像的主要内容,在目标函数中引入了结构差异度约束函数,向伪彩色融合图像中加入不同程度的无序信息,生成了一个伪彩色融合图像数据集,解决了彩色融合图像数据量不足和参考图像缺失的问题。之后建立一个基于孪生网络的质量评估器,质量评估器在伪彩色融合图像数据集中进行预训练,在真彩色融合图像数据集中进行微调,对彩色融合图像质量进行评估。一系列的实验证明了该方法的有效性和优越性。