融合卷积神经网络的遥感图像全色锐化

路琨婷,费蓉蓉,张选德

(陕西科技大学 电子信息与人工智能学院,西安 710021)

0 引言

近年来,遥感图像被广泛应用于科学研究、精准农业、矿产探测、国土普查、城市规划、地震预报、军事防御等领域[1]。然而,由于物理设备的限制,直接从卫星遥感器获取到的图像仅仅有两种:低空间分辨率多光谱(Low-Resolution Multi-Spectral,LRMS)图像和高空间分辨率(High-Resolution,HR)全色(PANchromatic,PAN)图像。前者分辨率较低但拥有丰富的光谱信息,后者分辨率较高但含有的光谱信息较少。

全色锐化通常利用较高空间分辨率的PAN 图像对较低空间分辨率的多光谱(Multi-Spectral,MS)图像进行锐化,从而获得高空间分辨率多光谱(High-Resolution Multi-Spectral,HRMS)图像。解决全色锐化问题的方法分为传统方法和基于深度学习的方法两大类。传统方法包括成分替换(Component Substitution,CS)、多分辨率分析(Multi-Resolution Analysis,MRA)以及基于模型的方法。

CS 方法首先对LRMS 图像上采样后作适当的域变换,使表示频谱和空间的信息完全分离并用不同的分量表达;然后利用拥有更多空间信息的PAN 图像替换分离的空间分量;最后使用上述变换的逆变换将替换后的图像变换回原域得到HRMS 图像。CS 方法使用的变换包括亮度-色度-饱和度(Intensity-Hue-Saturation,IHS)变换[2]、主成分分析(Principal Component Analysis,PCA)变换、Gram-Schmid(tGS)变换[3]等,能展现清晰的空间结构,但存在一定的光谱失真。

MRA 方法假定可以通过PAN 图像的高频空间分量补充LRMS 图像的空间细节:利用低通滤波器获取PAN 图像的高频信息,然后将它注入MS 图像中得到HRMS 图像。常见的MRA 方法有抽取小波变换(Decimated Wavelet Transform,DWT)、非抽取小波变换(UnDecimated Wavelet Transform,UDWT)以及拉普拉斯金字塔(Laplacian Pyramid,LP)[4]等。MRA 方法最大限度地保留了LRMS 图像的光谱信息,但由于滤波的使用导致HRMS 图像会出现一定的空间失真。

随着稀疏表示算法和贝叶斯(Bayesian)框架的快速发展,基于模型的方法已被广泛应用于各种图形图像处理任务并取得显著效果。基于模型的方法将全色锐化看作图像重建的过程,利用各种先验信息建立统计模型。常见的基于模型的方法有压缩感知(Compressed Sensing)、贝叶斯、变分优化(Variational Optimization)等。这类方法的光谱和空间细节失真相对较低,但对先验信息的要求较高。

近几年,基于深度学习的全色锐化方法产生的HRMS 图像性能明显优于传统方法。Masi 等[5]首先将卷积神经网络(Convolutional Neural Network,CNN)应用于全色锐化并提出PNN(CNN based Pansharpening);Wei 等[6]引入残差学习提出一个具有11 个可学习层的深度残差网络(Residual Network,ResNet),在全色锐化问题中充分利用深度学习模型的高度非线性性质;Yang 等[7]提出的PanNet 由10 个堆叠的残差块组成,旨在解决全色锐化的两个基本问题,即光谱信息和空间信息保存;Yuan 等[8]设计的多尺度多深度的CNN(Multi-Scale and multi-Depth CNN,MSDCNN)模型拥有两个不同的可学习层数分支,性能优异;Fu 等[9]使用分组的多尺度扩张网络(Deep Multiscale Detail Network,DMDNet)扩大感受野,多尺度结构能够融合不同尺度的空间信息以进一步提升融合效果;Zhang 等[10]建立图像间的非线性梯度变换关系来约束空间结构,使网络对融合结果图像中含有的空间结构具有更强的合理性解释。除上述监督学习框架外,无监督学习框架也发展迅速:Wang 等[11]提出多尺度密集生成器网络来提取特征,采用两个鉴别器分别保护光谱和空间信息;Zhou等[12]设计双流生成器从MS 图像和PAN 图像中提取模态特定特征来提升性能。

传统的CS 和MRA 方法易于解释但效果在光谱保真和空间细节信息增强两方面各有侧重,得到的HRMS 图像质量各有利弊。此外,CS 和MRA 方法的一个很大的局限性是使用的线性注入模型通常不考虑用于全色锐化传感器的相对光谱响应。目前大多数全色锐化网络虽然能实现较好的融合效果,但缺乏如传统CS 和MRA 方法对模型和算法的直观解释,对原图像的开发利用不足,特征信息提取不够充分,对特征图的各个通道平等看待造成了光谱和空间信息的部分损失,在一定程度上阻碍了融合性能。

为解决上述问题,本文结合传统方法与深度学习方法构建融合效果良好的全色锐化方法CMRNet,以提高融合图像的光谱和空间分辨率。本文的主要工作如下:

1)聚合CS 和MRA 的思想,并结合CNN 实现非线性,克服传统方法线性注入模型的局限性,改善深度学习全色锐化方法的性能。

2)设计残差通道(Residual Channel,RC)块以充分提取光谱和空间信息,实现多尺度特征信息的融合提取,并引入通道注意力(Channel Attention,CA)[13]学习通道间的依赖关系使网络更关注重要的特征信息。

1 相关工作

1.1 基于CS的全色锐化方法

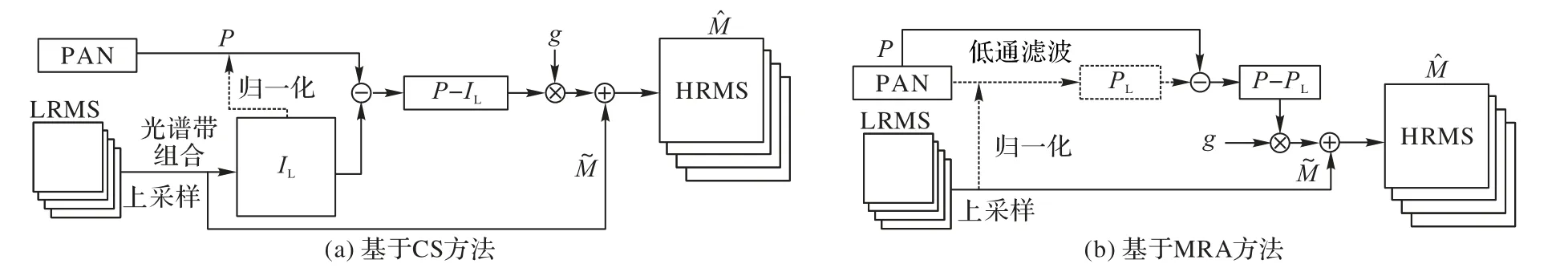

CS 方法基于PAN 图像对单一分量进行简单替换,这些强度分量通常通过MS 图像光谱带的线性组合获得。首先通过PAN 图像与强度分量的差值提取PAN 图像的高空间结构信息,再通过适当的注入方案将提取的高空间结构信息注入MS 图像。Tu 等[14]证明基于CS 的方法可推广到一种新的形式化,随后Dou 等[15]进一步扩展,提出了通用的CS 方法融合框架,现已被广泛使用。基于一般形式化的CS 方法的流程如图1(a)所示,数学表达式如下:

图1 传统的全色锐化方法流程Fig.1 Flowcharts of traditional pansharpening methods

其中:M表示LRMS 图像表示融合图像(即HRMS 图像)表示LRMS 图像上采样后的图像;IL表示要替换的强度分量;P表示PAN 图像,通常PAN 图像与IL分量进行归一化(如直方图匹配)以减少光谱失真;g表示注入权重。

1.2 基于MRA的全色锐化方法

Tu 等[14]也对基于一般形式化的MRA 方法进行扩展,算法流程如图1(b)所示,大多数基于MRA 方法的数学表达式如下:

其中,PL表示PAN 图像的低通版本。与CS 方法提取空间细节的方式不同,MRA 方法通过PAN 图像与它的低通版本的差值获得空间结构信息。

1.3 基于深度学习的全色锐化方法PanNet

基于深度学习的PanNet 方法[7]第一次应用了ResNet,网络模型分为空间保护和光谱保护两部分。对于空间保护,PanNet 在高通域训练图像以保存细节边缘信息;对于光谱保护,将上采样的MS 图像直接添加到网络输出以更好地保存光谱信息。网络损失函数为:

其中:N表示训练数据的总数;fw(·)表示ResNet 模型;G表示高通信息;↑表示上采样操作。

2 本文方法

传统的基于CS 和MRA 的全色锐化方法在理论解释方面的研究相对成熟,从理论分析以及实验实施均有发展成熟的各种常用方法;基于CS 的方法具有丰富的空间细节信息;基于MRA 的方法生成的融合图像具有较强的光谱保真度。CS 和MRA 方法的一个很大的局限性是通常假设使用线性注入模型,而不考虑用于全色锐化传感器的相对光谱响应。

结合MRA 方法对具有优越表现的PanNet 方法进行深入分析:在PanNet 方法中,网络输入包含PAN 图像和MS 图像的高通信息,最后将上采样的MS 图像添加到网络输出获得HRMS 图像;在MRA 方法中,PAN 图像与低通PAN 图像之间的差值获得的同样是PAN 图像的高通信息,将PAN 图像的高通信息注入到MS 图像即可获得融合图像。因此,PanNet方法可以看作是一种实现MRA 方法非线性的深度学习方法。

本文将遵循CS 和MRA 方法的一般形式化,使用CNN 实现CS 和MRA 方法的非线性,提高全色锐化方法性能。

2.1 网络结构

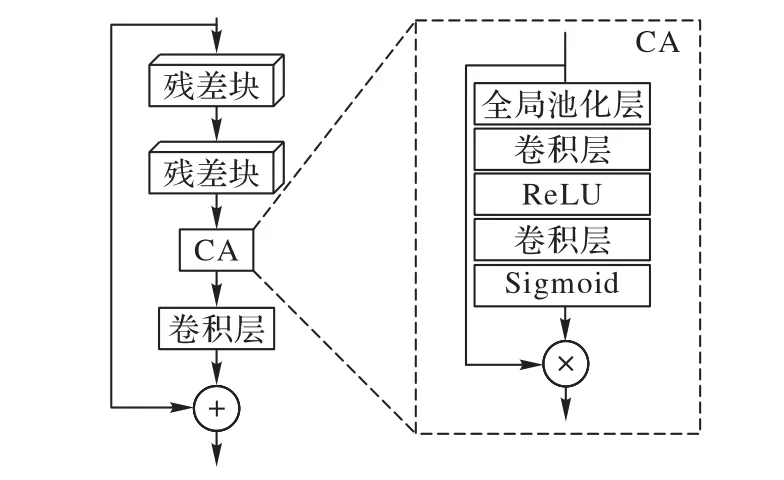

本文将结合传统与深度学习的全色锐化方法称作CMRNet,从而构建HRMS 图像的空间细节信息和光谱信息。受超分辨领域残差通道注意力网络(Residual Channel Attention Network,RCAN)[16]的启发,CMRNet 的网络框架采用长连接和短连接的方式,有助于传输丰富的低频信息,使网络学习到更有效的信息。网络主体结构由四个RC 块堆叠组成:RC 块保证在网络训练时,输入信息可通过所有参数层充分传播,并且能很好地提取空间和光谱信息。每个RC 块由两个残差块、通道注意力(CA)块、卷积、跳跃连接组成,RC 块采用跳跃连接将提取的特征信息跨层传播,实现多尺度特征信息的融合提取。此外,由于遥感图像的通道数较多且一般的网络结构无法充分利用通道间的相互依赖关系,导致获得的特征质量在通道方向参差不齐或冗余,这将限制网络学习的能力。因此,本文在RC 块中引入CA,使网络根据通道间的依赖关系为不同的通道分配不同的权重,进一步提高网络表达能力。

RC 块的主要结构如图2 所示,具体实现如下:1)输入信息经过两个残差块进行特征提取;2)通过CA 块让网络去注意多通道中对重建更有用的信息;3)使用一次卷积实现当前RC 块与前一个RC 块的通道数对齐,便于后续跳跃连接的实现;4)通过跳跃连接实现多尺度特征信息的融合提取。

图2 RC块结构Fig.2 Structure of RC block

CMRNet 的网络结构如图3 所示。首先,CMRNet 关注高通域的高频细节,通过高通滤波器获得PAN 图像和LRMS 图像的高通信息,使用上采样块将LRMS 图像的高通信息上采样到PAN 图像的分辨率;接着,使用上采样块将LRMS 图像上采样到PAN 图像的分辨率,并进行光谱带的线性组合得到要替换的强度分量,从而通过PAN 图像与强度分量间的差值进一步获得高空间结构信息;然后将PAN 图像的高通信息、上采样到PAN 图像大小后LRMS 图像的高通信息、高空间结构信息、PAN 图像与MS 图像间的差值级联后输入网络进行训练;最后,为更好地保存光谱信息,直接添加上采样的MS 图像到网络的输出使光谱信息直接传播到融合图像,最大限度地减小HRMS 图像与LRMS 图像之间的光谱信息差异,保持光谱质量以获得高质量的HRMS 图像。本文网络能充分利用原图像包含的丰富空间信息和光谱信息,经过高通滤波后的图像可以更好地显示其空间信息,利用较高的空间结构信息以及PAN 图像与MS 图像的差异可减少光谱和空间细节的损失。

图3 CMRNet方法的网络结构Fig.3 Network structure of CMRNet method

对结合CS 和MRA 的全色锐化方法CMRNet 进行抽象描述,该方法中PAN 图像的高通信息可类比于MRA 方法中的P-PL,高空间结构信息可类比于CS 方法中的P-IL,最后添加到网络输出的上采样的MS 图像也可类比于CS 和MRA方法中的。综上所述,本文方法将传统方法与深度方法相结合,不仅实现CS 和MRA 方法的非线性,而且能更好地保存光谱和空间信息。

2.2 损失函数

现有的基于深度学习的全色锐化方法采用图像域的监督方式,由于L2 损失函数能够惩罚较大的异常值,因此选用L2 损失对网络估计的HRMS 图像与真实标签数据的相似性进行约束,损失函数定义如下:

其中:PD表示复制到MS 图像分辨率的PAN 图像;f(⋅)表示本文网络。

3 实验与结果分析

3.1 实验设置

实验采用QuickBird 和GF1 卫星传感器收集的图像分别进行模型的训练和测试。对于QuickBird 传感器,PAN 图像和LRMS 图像的空间分辨率分别为0.6 m 和2.4 m;对于GF1传感器,PAN 图像和LRMS 图像的空间分辨率分别为2 m 和8 m。由于实际应用中遥感图像不存在真实标签数据,即网络训练中没有目标图像,因此需要构建训练数据集。本文根据Wald 协议[17]进行设计,将原始MS 图像和PAN 图像以采样率4 进行下采样,构建的训练数据集包括下采样后的LRMS、PAN 以及原始的MS 图像。降尺度评估以下采样后的图像作为网络输入,以原始MS 图像作为参考图像即真实标签数据。全尺度评估则直接将原始的卫星图像输入网络。QuickBird和GF1 卫星数据集中的PAN 和LRMS 图像对数分别为11 904和8 960,图像大小分别为128×128 和32×32,将它们随机分成90%和10%用于训练和测试。

为充分验证CMRNet 的性能,与较先进的方法进行实验对比,选用的方法如下:基于CS 方法的IHS[2]和GS[3],基于MRA 方法的Wavelet[4]、广义拉普拉斯金字塔(Modulation Transfer Function based Generalized Laplacian Pyramid,MTFGLP)[18],基于深度学习方法的DMDNet[9]、MSDCNN[8]、深度CNN 的遥感图像融合(Remote Sensing Image Fusion with deep CNN,RSIFNN)[19]与PanNet[7]。

本文的实验环境如下:PyTorch 1.13 深度学习框架,并在GeForce RTX 3090Ti 上训练。网络训练中使用Adam 优化器优化网络,批处理大小为32,初始学习率为0.001 并且每20个epoch 乘以0.5。

3.2 评价指标

实验采用的评价指标包括:峰值信噪比(Peak Signal-to-Noise Ratio,PSNR)、结构相似性(Structural SIMilarity,SSIM)、相关系数(Correlation Coefficient,CC)、光谱角度映射(Spectral Angle Mapper,SAM)、相对无量纲全局误差(Erreur Relative Globale Adimensionnelle de Synthese,ERGAS)、质量指标(Quality-index,Q4)、无参考质量指标(Quality with No Reference,QNR)和它的两个分量Dλ和DS。这几种指标中,PSNR、SSIM、CC、Q4、QNR 指标越高表明融合效果越好;SAM、ERGAS、Dλ、DS指标越低表明融合效果越好。指标具体说明如下所示。

CC 能衡量两个图像的相似度:

其中:x表示第x个像素;X表示像素数;表示融合图像;M表示参考图像;μ*表示图像的均值。

SAM 衡量两个图像像素点矢量间的角度的绝对值,可反映图像的光谱失真程度:

其中,u和v是融合图像和参考图像的像素向量。

ERGAS 是一个全局质量指标,能全面反映融合图像的质量:

其中:h和l分别表示PAN 图像和MS 图像的空间分辨率;B是图像的波段数;IRMSE(b)是融合图像和参考图像b波段的均方根误差;μ(b)是b波段的均值。

Q4是一个通用图像质量评价指标:

QNR 在没有任何参考图像的情况下衡量融合图像的全局质量,由Dλ和DS组成,分别反映光谱失真程度和空间失真程度:

其中:P表示PAN 图像,P↓表示下采样后的PAN 图像。

3.3 实验与结果分析

3.3.1 降尺度评估

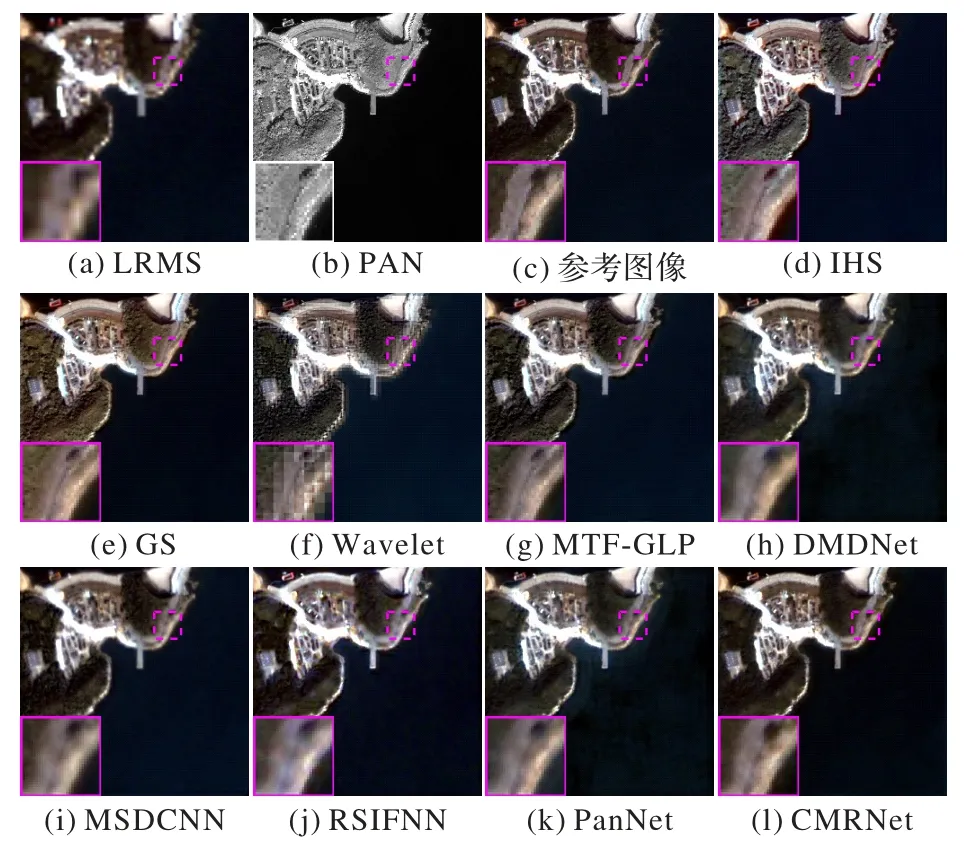

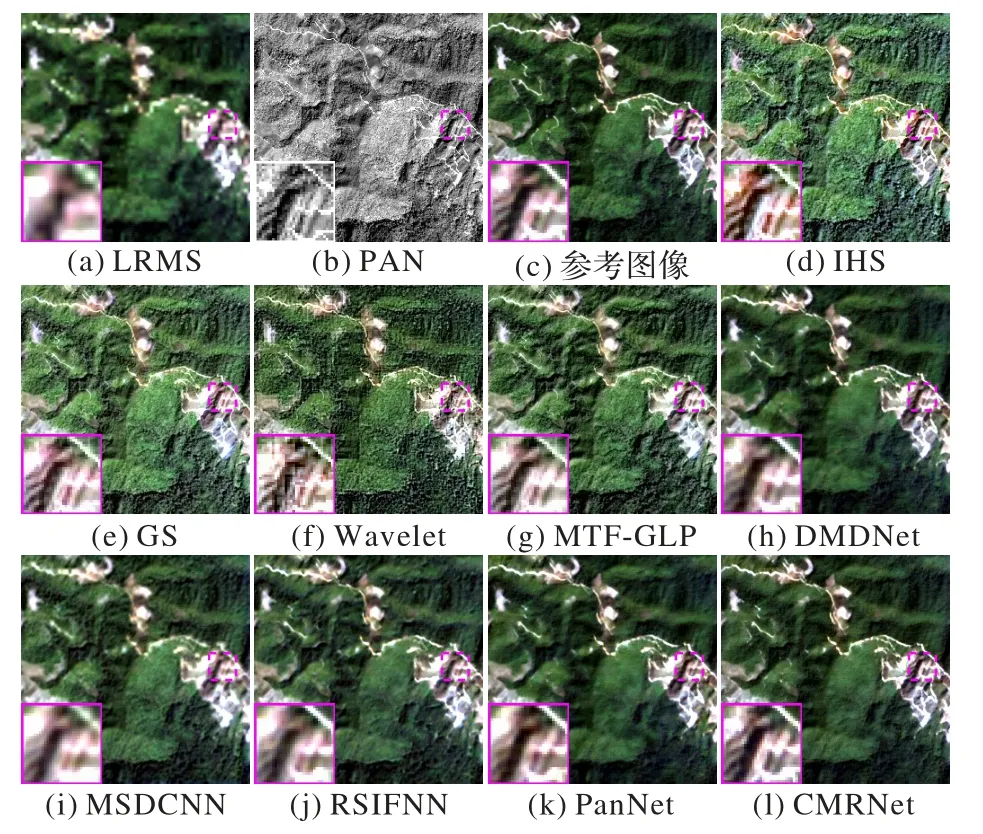

不同方法在降尺度QuickBird 数据集上对海边港口图像的锐化结果如图4 所示。与参考图像相比,只有PanNet、DMDNet 和CMRNet 能够很好地保存光谱信息,而其他方法均具有明显的光谱失真。为进一步进行可靠的对比,选取局部区域放大。比较3 种方法的局部放大图像,可以看出CMRNet 的光谱信息与参考图像最相似,边界也更清晰。在这些具有光谱失真的方法中,IHS、GS 和RSIFNN 方法的整体失真较为严重,光谱信息与参考图像差异较大,图像整体颜色较淡;MTF-GLP 方法和MSDCNN 方法部分光谱信息损失且边界较模糊;Wavelet 方法的锐化效果质量较差,空间细节信息较少且存在伪影和锯齿。与这些方法相比,本文的CMRNet 方法可以更好地保存光谱信息和纹理细节。

图4 降尺度QuickBird卫星图像的锐化结果Fig.4 Sharpening results at reduced-resolution on QuickBird dataset

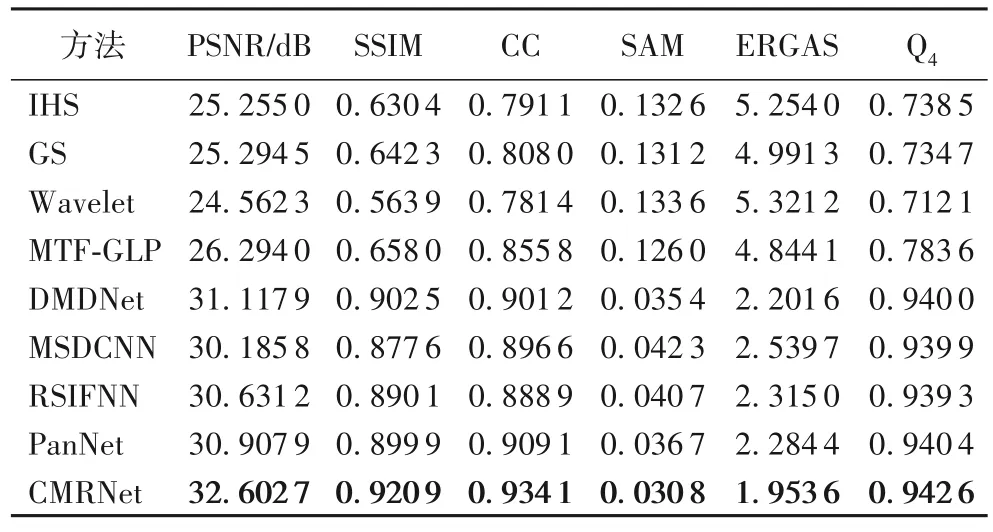

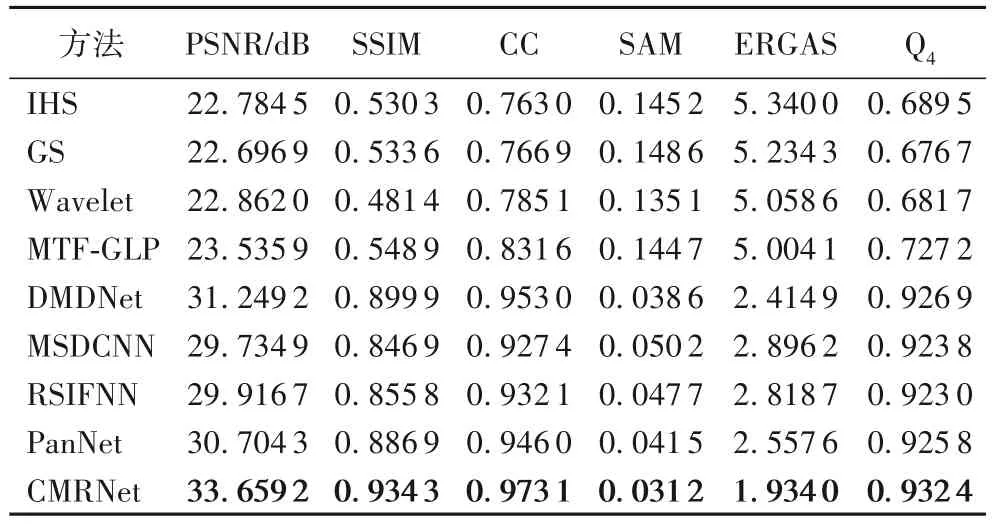

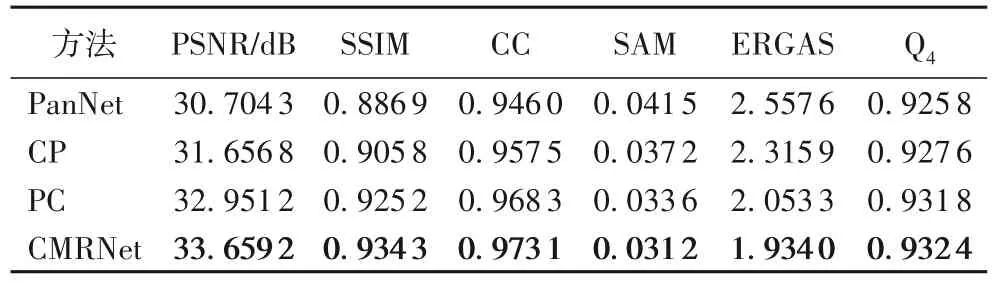

不同方法在QuickBird 数据集上测试的统计平均结果如表1 所示,最优结果加粗表示。从表1 可以看出,与几种常用的全色锐化方法相比,CMRNet 方法在PSNR、SSIM、CC、SAM、ERGAS 和Q4这6 种指标上都取得最好的效果。相较于PanNet 方法,CMRNet 的PSNR 提高了5.48%。因此,在QuickBird 卫星图像上,本文方法在定性和定量上的表现较好,融合图像在光谱分布和空间结构上均与参考图像最一致。

表1 不同方法在降尺度QuickBird数据集上的结果对比Tab.1 Comparison of results of different methods on reduced-resolution QuickBird dataset

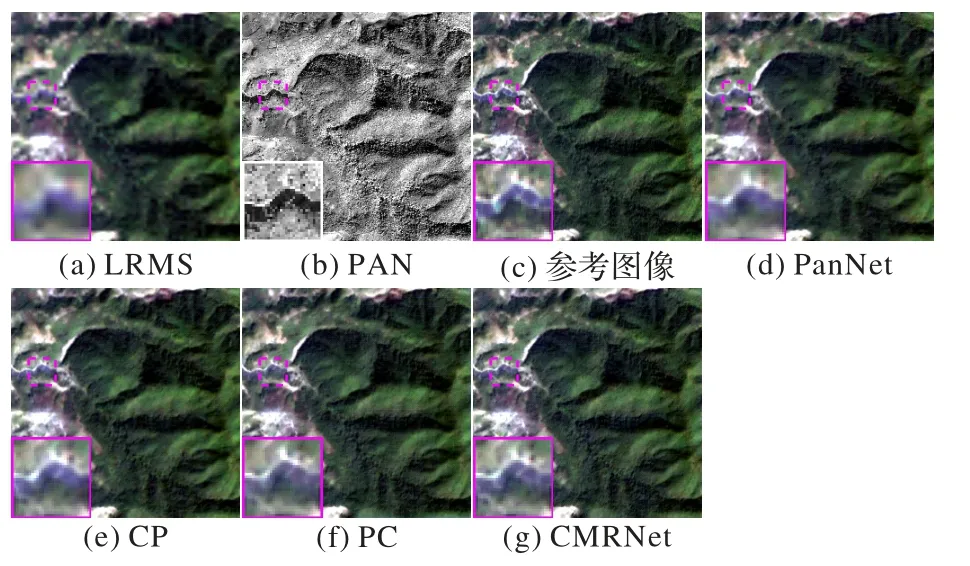

不同方法在GF1 数据集上对森林图像的锐化结果如图5所示。可以看出,传统的IHS、GS、Wavelet 和MTF-GLP 方法的光谱失真较为严重,锐化结果缺乏绿色光谱信息;MSDCNN 方法保留空间信息的能力较弱,图像较模糊;比较局部放大区域的河流,可以看出RSIFNN 方法在边界上有轻微的空间信息损失,PanNet、DMDNet 和CMRNet 方法的锐化效果较好,但本文的CMRNet 方法在保存光谱和空间信息方面略优于PanNet 和DMDNet 方法,并且在光谱和空间上最接近参考图像。

图5 降尺度GF1卫星图像的锐化结果Fig.5 Sharpening results at reduced-resolution on GF1 dataset

不同方法在降尺度GF1 数据集上测试的统计平均结果如表2 所示。从表2 可以看出,与几种常用的全色锐化方法相比,本文的CMRNet 方法在所有指标上都取得了最优;相较于PanNet,CMRNet 的PSNR 提高了9.62%。实验结果表明,本文方法的锐化效果优于其他方法,锐化结果不仅具有更准确的光谱分布,而且包含合理的局部纹理细节。综上,在GF1 卫星图像上,本文方法在定性和定量评价上均取得较好的效果。

表2 不同方法在降尺度GF1数据集上的结果对比Tab.2 Comparison of results of different methods on reduced-resolution GF1 dataset

3.3.2 全尺度评估

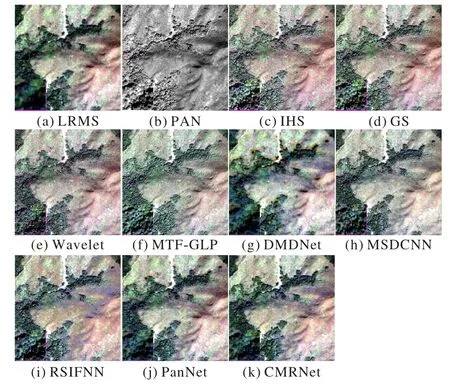

不同方法在QuickBird 数据集上的锐化结果如图6 所示。

图6 全尺度QuickBird卫星图像的锐化结果Fig.6 Sharpening results at full-resolution on QuickBird dataset

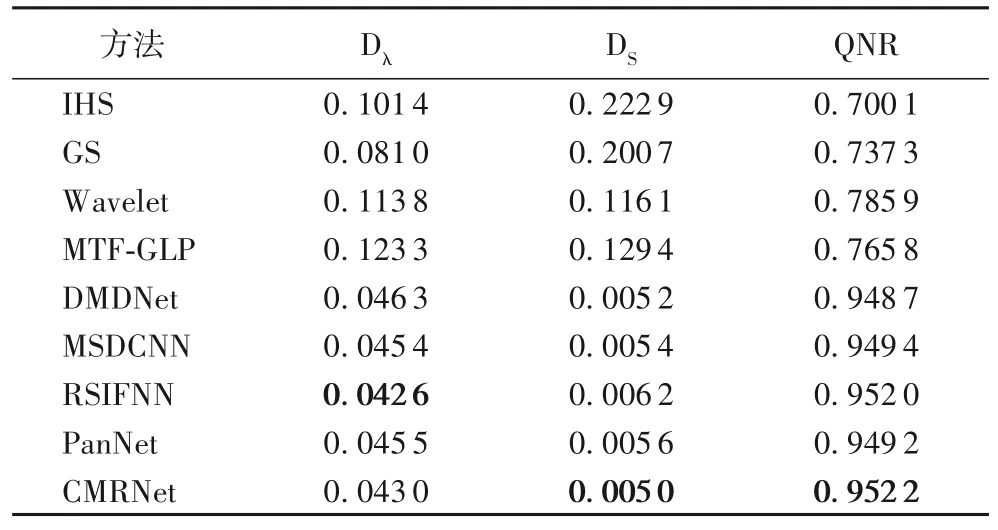

可以看出,除PanNet 和本文的CMRNet 方法外,其他方法生成的图像均有不同程度的红色光谱信息失真。与PanNet 方法相比,CMRNet 方法包含的绿色光谱信息稍多,颜色上与LRMS 图像最相似,主观感知方面优于其他方法。

不同方法在QuickBird 数据集上测试的统计平均结果如表3 所示。从表3 可以看出,与其他全色锐化方法相比,CMRNet 在DS和QNR 指标上取得了最优,Dλ指标也跟最优的RSIFNN 接近。总体来看,本文方法仍然在对比方法中表现最优,在全尺度实验中取得了良好的效果,充分验证了本文方法对全色锐化任务的积极作用。

表3 不同方法在全尺度QuickBird数据集上的结果对比Tab.3 Comparison of results of different methods on full-resolution QuickBird dataset

3.4 消融实验

为验证CMRNet 中CS 方法和MRA 方法相结合的思想及网络结构的有效性,在GF1 数据集上进行消融实验。

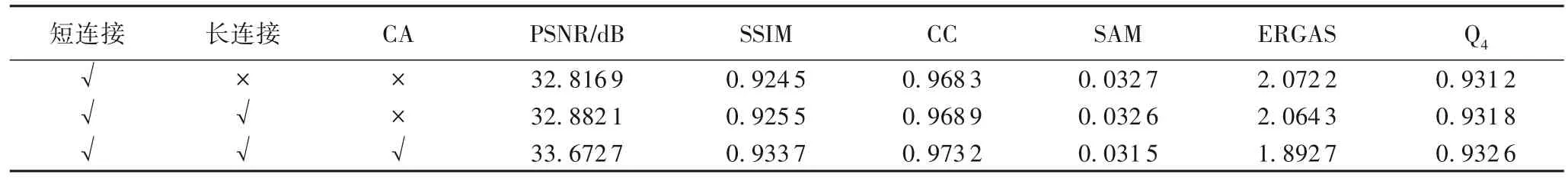

1)将CMRNet 与PanNet 与以下方法对比:使用本文的损失函数和PanNet 的网络结构进行训练的方法(简称CP);使用PanNet 的损失函数和本文的网络结构进行训练的方法(简称PC)。锐化效果如图7 所示。从局部放大区域可看出,CP、PC、CMRNet 的锐化效果都优于PanNet 方法,其中CMRNet 方法在光谱信息和空间细节方面与参考图像最接近,实现了较好的锐化效果。4 种方法的评价指标如表4 所示。在所有指标上,CP 均优于PanNet,验证了本文损失函数的有效性;PC 优于PanNet,验证了本文网络结构的有效性。而CMRNet 结合这两者进一步提升了融合效果。

表4 不同损失函数与网络结构组合的消融实验结果对比Tab.4 Comparison of ablation experiment results of different loss functions and network structure combinations

图7 消融实验的锐化结果及其对比图像Fig.7 Sharpening results of ablation experiments and their comparison images

2)对CMRNet 中的长连接、RC 块中的短连接和CA 的有效性进行消融实验,评价指标如表5 所示。从表5 可以看出,三者均对性能提升起着积极作用。

表5 不同模块的消融实验结果对比Tab.5 Comparison of ablation experimental results of different modules

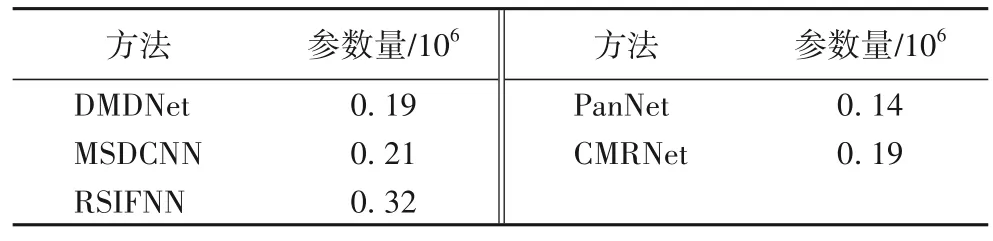

3.5 网络性能评估

本节对比了本文方法与DMDNet、MSDCNN、RSIFNN、PanNet 的参数量。所有的全色锐化方法均使用PyTorch 框架实现,各方法的参数量如表6 所示。可以看出,本文的CMRNet 方法具有较低的参数量。因此,CMRNet 方法不仅相对轻量化,并且能够实现较好的全色锐化效果。

表6 不同方法的参数量Tab.6 Parameters of different methods

4 结语

本文关注传统方法CS 和MRA 的思想,并将它们与CNN相结合,巧妙聚合这两种思想并实现非线性以克服线性注入模型的局限性,从而提升全色锐化方法的性能。考虑到遥感图像的通道数较多但大多网络结构忽略通道间的依赖关系使网络学习能力受到限制,引入通道注意力给每个通道分配不同的权重,让网络关注重要的特征并抑制不重要的特征,进一步提高性能。实验结果表明,与基于深度学习的方法相比,本文的CMRNet 方法不仅参数量较小,而且进一步提高了融合图像的光谱和空间分辨率(定量结果显示所有指标均有显著提升);此外,消融实验结果验证了本文思想和网络结构均对性能提升起着积极作用。综上所述,本文方法能较好地保存空间和光谱信息,具有广泛的研究与应用前景。未来将会对图像约束作进一步研究,以达到更好的效果。