一场关于人工智能风险的争议

文/本刊记者 余秀

人工智能灭绝人类风险言论在引发了广泛关注的同时,也引来了质疑的声音。诸多专家和公众人物认为,AI 末日论分散了人们对真正重要的实际问题的注意力。

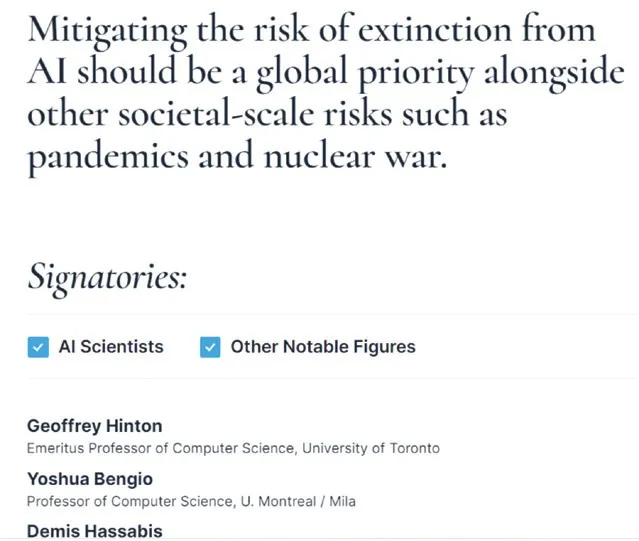

“减轻人工智能带来的人类灭绝风险,应该与大流行病和核战争等其他影响社会的大规模风险一同成为全球性的优先事项。”[1]5 月30 日,这则短短的声明,出现在美国非营利组织“人工智能安全中心(Center for AI Safety)”的官网上,超过350 名从事人工智能工作的高管、研究人员和工程师在上面签名。

人工智能对人类的威胁,堪比大流行病和核战争,这份简短声明旨在鼓励公开讨论 AI 最严重的威胁,降低AI 灭绝人类的可能风险。带头签名这份声明的是深度学习领域的两位重磅专家杰弗里·辛顿(Geoffrey Hinton)和约书亚·本希奥(Yoshua Bengio)。两人和杨立昆(Yann LeCun)一起,因在深度学习方面的开创性工作,共同获得了2018 年图灵奖(有“计算界的诺贝尔奖”之称),被称为“AI教父”或“深度学习教父”。除此以外,目前三大领先的自然语言大模型研究机构的CEO,OpenAI 的山姆·阿尔特曼(Sam Altman)、谷歌DeepMind 的杰米斯·哈萨比斯(Demis Hassabis)和Anthropic的达里奥·阿莫迪(Dario Amodei),也都签名支持。签名名单还包括了清华大学智能科学讲席教授、智能产业研究院院长张亚勤,中国科学院自动化研究所研究员、中国科学院大学教授曾毅等中国学者。

“减轻人工智能带来的人类灭绝风险,应该与大流行病和核战争等其他影响社会的大规模风险一同成为全球性的优先事项。”

当前对人工智能表示担忧的声音已经大到无法忽视。3 月,一封由科技行业专家牵头的公开信,因为担忧人工智能可能对“社会和人类构成深远风险”,呼吁暂停先进人工智能模型的开发。4 月,杰弗里·辛顿从谷歌离职,以便公开讨论人工智能技术的危险性。

在6 月的北京智源大会AI 安全与对齐论坛上,山姆·阿尔特曼和杰弗里·辛顿分别作了开场和闭幕演讲,强调了人工智能的未来风险,呼吁全球尽早迈出通用人工智能(AGI)治理的第一步。辛顿表示数字式智能群体共享知识的速度远超人类,当AI 进化到比人类更有智慧的时候,会带来巨大的风险。“到目前为止,我还想象不到更智能的事物,被一些反倒没那么智能的事物所控制的例子。我打个比方,假设青蛙创造了人类,那么你认为现在谁会占据主动权,是人,还是青蛙?”[2]

AGI 接管人类

人工智能可能灭绝人类的说法,有一个前提假设,即具备人类级别学习能力的计算机会由于技术优势而超越人类智能,成为通用人工智能(AGI)。通用人工智能(AGI)的重大进展可能导致人类灭绝或其他一些无法恢复的全球灾难,正如大猩猩的命运取决于人类的善意,人类的命运也可能取决于未来超级智能机器。

自阿兰·图灵开始,对失控的、自我改进的机器的担忧由来已久。随着ChatGPT 等生成式人工智能工具的普遍使用,曾经的极端观点引起了广泛关注。2021 年1 月发表在《人工智能研究杂志》的一篇文章,通过计算提出,控制远超出人类理解能力的超级智能几乎是不可能的。因为要控制超级智能,我们需要对其进行模拟和分析,但如果我们无法理解它,就无法创建这样的模拟。当我们不了解人工智能将要提出的场景类型,就无法制定诸如“不对人类造成伤害”之类的规则。[3]

一篇名为“自然选择偏爱AI,而不是人类(Natural Selection Favors AIs over Humans)”的文章,认为人类和AGI 的前途类似于自然选择。自然选择理论中,自私的物种通常在物竞天择中更具优势。达尔文主义也可以适用于AGI,当AGI 追求自身利益而对人类关注较少时,将会给人类带来灾难。[4]牛津大学人类未来研究所人工智能安全研究员瑞安·凯里(Ryan Carey)表示:“如果人工智能具有某些成分,即超人智能、广泛的自主权、一些资源和新技术,它可能会对人类的未来构成威胁。”“如果你将少数拥有一些资源和一些现代技术的现代人类置于一个拥有80 亿非人类灵长类动物成员的世界中,那可能对该物种的未来构成威胁。”

目前,以ChatGPT 为代表的大型语言模型(LLM)还远不能实现通用人工智能(AGI)。对于人工智能超过人类智能的AGI 什么时候到来的问题,杰弗里·辛顿表示:“这个东西实际上可能比人类更聪明——有一些人相信这一点,……但大多数人认为这还遥远。而我也认为离那还很远,可能是30 到50 年甚至更久以后。显然,我不再持有这样的观点了。”在备受推崇的预测平台Metaculus 上,AGI 的平均预测日期是2032 年。[5]

AI 对齐:回形针制造机

人工智能灭绝人类的风险假说,有令人信服的逻辑。剑桥大学计算与生物学习实验室的助理教授大卫·克鲁格(David Krueger),说明了人工智能接管人类的三个要素:

首先,AI 在优化特定目标时缺乏人类常识,可能发出奇怪和不受欢迎的行为。由于AI“思考”解决问题的方式,AI 处理看似简单的事情可能会产生无法预测的意想不到的后果。例如,如果有人告诉孩子家里的书本数量与大学录取有关,他可能不会多读书给孩子听,而是开始堆放成箱的书本。即使AI 只能在非常严格的规则下运行,异常行为仍然会发生。

第二,AI 在特定任务中的过度优化可能会导致权力寻求行为。当特定任务优化的AI 有一个单一的目标时,它可能会使用其掌握的所有工具来实现该目标。“这种推理循环不会自然结束,”克鲁格说,“如果你在做以目标为导向的推理,尤其是当你有一个长期目标时,你自然会最终寻求越来越多的权力和资源。”

第三,人类会主动向AI移交更多的权力。“如果你给系统更多的自主权、更多的权力,或者以更多方式重塑世界的能力,那么它就会更有能力。”克鲁格继续说道,“如果你让它直接采取影响现实世界或影响数字世界的行动,你将赋予它更多的力量,使其更有能力更高效地实现你的目标。”

将三个要素放在一起可能会导致这样的结果:人类目标可能与AI 的目标不同。当我们给AI 一个目标时,它可能不是我们的实际目标,这是“AI 对齐”问题。AI 对齐的目标是确保AGI 能够正确理解人类的意图,将其行动与人类价值保持一致。[6]

哲学家尼克·博斯特罗姆(Nick Bostrom)在回形针制造机思想实验中令人印象深刻地捕捉到了这一点。他设想了一个负责制作回形针的人工智能,通过对现实世界系统的充分控制,它可能会采取极端措施,如消耗所有资源和转化所有物质来制造尽可能多的回形针,从而对人类生存产生威胁。

分歧和质疑:AI末日论转移了对真正问题的注意

诚然,关于人工智能的未来风险存在分歧。据耶鲁大学首席执行官领导力研究所对高管进行的一项调查显示,42%的受访者表示人工智能可能在5~10 年内“毁灭人类”,58%的受访者表示“不担心”人工智能的生存威胁。[7]

人工智能灭绝人类风险言论在引发了广泛关注的同时,也引来了质疑的声音。诸多专家和公众人物认为,AI 末日论分散了人们对真正重要的实际问题的注意力。Meta 首席AI 科学家、与杰弗里·辛顿和约书亚·本希奥共同获得2018 年图灵奖的杨立昆(Yann LeCun)表示,对人工智能未来风险的担忧“极其荒谬”。计算机变得比人类更聪明,还需要很多年。他认为,那些担忧的人之所以这样,是因为他们无法想象如何才能确保人工智能的安全。“这就好像你在1930 年问如何确保涡轮喷气发动机的安全,1930 年涡轮喷气发动机还没有发明,就像人类水平的人工智能还没有发明一样……涡轮喷气式飞机最终变得非常可靠和安全,人工智能同样如此。”Meta 的人工智能研究副总裁乔尔·皮诺(Joelle Pineau)同意杨立昆的观点,她表示,对AI 未来风险的极度关注,挤压了讨论当前人工智能的危害的空间。[8]

纽约大学名誉教授加里·马库斯(Gary Marcus),于3 月签署了公开信,与包括埃隆·马斯克(Elon Musk)在内的1000 多人一起,呼吁全球暂停人工智能开发,但他没有签署22 字声明,他认为AI 的生存威胁被“夸大了”,社会不应该把注意力集中在没有人幸存的牵强的场景上,而应该把注意力集中在真正的危险所在。人工智能公司Cohere 的首席执行官艾丹·戈麦斯(Aidan Gomez)评价,这是“对我们时间的荒谬利用”。麻省理工学院经济学教授达伦·阿西莫格鲁(Daron Acemoglu)认为,它(AI 灭绝人类的风险)夸大了当前的技术水平,“使我们将注意力从这些新模型可能造成的更普遍的损害上移开,包括错误信息、失业、民主威胁等”。

同样地,Nature 网站上一篇题为“当AI 今天带来风险时,停止谈论明天的AI世界末日(Stop talking about tomorrow’s AI doomsday when AI poses risks today)”的社论文章旗帜鲜明地指出,就像魔术师的花招一样,人工智能灭绝人类的言论分散了人们对真正问题的注意力,阻碍了对人工智能目前造成的社会危害的有效监管。有关AI 风险和监管的对话默认了由公司高管和技术人员组成的同质群体主导,而将其他社区排除在外。纽约市AI Now 研究所(研究所专注于人工智能的社会影响)所长安巴·卡克(Amba Kak)表示,科技行业领袖撰写的声明“本质上是在界定谁才是这场对话中的专家”。

人工智能有许多潜在的好处,从合成数据到协助医疗诊断,可能将在医疗保健、教育和应对气候危机领域发挥重要的积极作用。但它同时也造成了有据可查的危害,生成和传播大量错误信息,带有系统偏见,挤压劳动市场岗位。关于这些明确而现实的问题的讨论正处于“缺氧”状态。政府必须建立适当的法律和监管框架,科技公司必须制定负责任地开发人工智能系统和工具的行业标准,研究人员必须发挥作用,建立负责任的人工智能文化。关于存在风险的危言耸听的叙述没有建设性,认真讨论实际风险以及遏制风险的行动更重要。“人类越早建立与人工智能的互动规则,我们就能越早学会与技术和谐相处。”[9]