基于Transformer的雷达信号分选方法

张旭威,徐鹏涛,管振辉

(中国船舶集团有限公司第七二三研究所,江苏 扬州 225101)

0 引 言

雷达信号分选作为雷达侦察系统的关键技术之一,其目的是从接收到的随机混叠脉冲流中分离出每一部雷达所产生的脉冲列[1]。分选结果的正确与否直接影响后续的信号处理工作,继而影响战场态势感知能力、情报获取能力和决策判断力。

信号分选的典型方法是将脉冲描述字(PDW)通过预分选稀释脉冲流,然后再对脉冲重复间隔(PRI)进行处理以完成主分选。

由于现代战场环境中雷达辐射源数量的激增、雷达信号调制的复杂多变等因素影响,战场电磁环境较之以往更加复杂,这给信号分选的实时性和准确性都带来了极大的挑战。传统的基于脉冲重复间隔(PRI)这一单参数进行分选的算法,如积累差直方图(CDIF)[2]、时序差直方图(SDIF)[3]、PRI变换法[4]等对固定、参差和正常抖动范围的低电磁环境复杂度下的雷达信号有较好的分选效果,然而分选过程需要人为设置多个参数以满足分选需要,灵活性差,越来越难以适应现代战场的需要。

机器学习[5]有着从样本数据中获取规律并利用此规律对未知数据进行预测的特点,而雷达信号分选从本质上来看,也是从一堆杂乱的样本信号数据中找出信号的规律并进行后续处理的过程。因此,将机器学习算法应用于雷达信号分选也是一种新的发展趋势。

本文提出一种基于Transformer[6]的雷达信号分选方法,该方法较传统雷达信号分选技术而言更为灵活,且对复杂调制雷达信号适应性较好。实验证明该方法对复杂电磁环境下的雷达信号仍然能够进行有效分选,且分选准确率较高。

1 Transformer模型简介

从脉冲序列的到达时间(TOA)角度来看,PDW数据就是一连串的序列型数据,信号分选就是对这个序列中的数据进行分类。单一地对每个输入数据进行处理,而不考虑序列中数据之间的关系是不能很好地对数据特征进行学习的。循环神经网络(RNN)[7]和长短期记忆网络(LSTM)[8]是处理序列问题的2个经典模型,但是又各有缺点(RNN存在长期依赖所导致的梯度消失问题,LSTM存在并行处理较弱的问题)。

注意力机制(Attention)[9]的发展有效避免了上述2种经典模型的缺点,已成为神经网络领域的一个重要概念。注意力机制选择性地关注部分区域的特征,从而提高观察精细度。

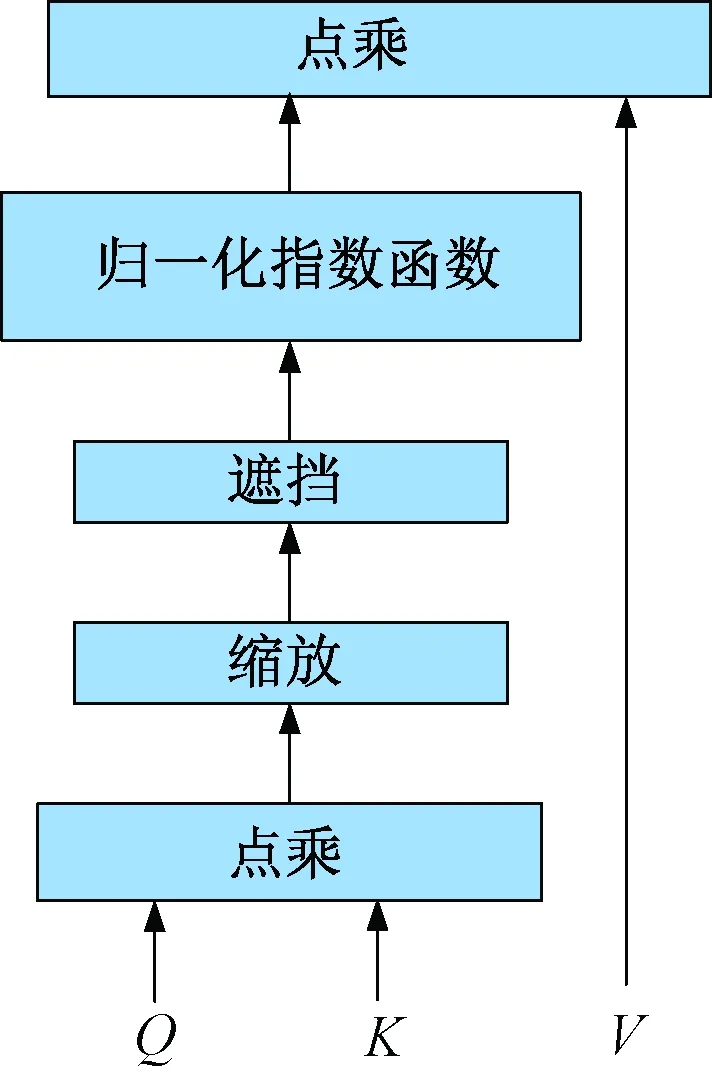

自注意力(Self-Attention)机制是注意力机制的改进,其通过将序列中数据间的所有成对交互关系进行建模,从而捕获数据内部特征的相关性,减少对外部信息的依赖。这种机制适用于挖掘雷达脉冲序列中PDW数据之间特征的相关性从而进行信号分选的问题。Self-Attention的结构图如图1所示,通过3个可学习权重的矩阵{WQ,WK,WV},将输入序列X做线性变换得到Q=XWQ,K=XWK,V=XWV。自注意力机制的计算公式如下:

图1 Self-Attention(自注意力)结构图

(1)

式中:dk为矩阵K的向量维度。

多头注意力(Multi-Head Attention)机制通过增加Self-Attention的数量来避免单个Self-Attention对序列数据学习能力不足的问题。Multi-Head Attention结构图如图2所示。从图中可以看到Multi-Head Attention包含多个Self-Attention层。

图2 多头注意力结构图

由于Transformer的Attention模块无法捕获输入序列数据的顺序,因此将位置编码添加到模型中以获得序列中数据的位置信息。位置编码公式如下:

Ep(pos,2i)=sin(pos/10 0002i/d)

(2)

Ep(pos,2i+1)=cos(pos/10 0002i/d)

(3)

式中:pos表示序列中数据的位置;d表示向量编码的维度;2i表示偶数维度;2i+1表示奇数维度。

将计算出的Ep与源数据向量相加就得到了含有位置信息的输入向量。

Transformer模型主要由编码器(Encoder)和解码器(Decoder)2个部分组成,而Encoder和Decoder又由若干个模块组成,模块中的典型多头注意力结构如上所述,Transformer的整体结构如图3所示。

图3 Transformer整体结构

Decoder模块中的Masked Multi-Head Attention是在Multi-Head Attention的基础上多了一步遮挡操作,目的是为了防止数据向量依赖于当前时刻之后的信息。

2 基于Transformer的雷达信号分选方法

2.1 数据准备

本文实验数据为模拟器生成的雷达信号,其中包含一些高重频、大抖动、同方位的复杂调制信号。为了便于网络模型训练、验证和测试,对接收到的信号进行标注处理。

2.2 网络结构

本文所使用的网络结构保留了原始Transformer模型的编码器部分,编码器模块的数量为4,在编码器后接一个全连接的线性层,由于使用的Pytorch中的交叉熵损失函数带有归一化指数函数(Softmax),故最后无需再进行Softmax操作。由于数据集中的辐射源数量为40余种,为了让模型注重于数据特征的学习,将网络的输出种类设置为50。具体的网络模型如图4所示。

图4 本文雷达信号分选的整体网络结构

3 实验及结果分析

本文实验所采用的深度网络框架工具为Pytorch,运算平台为CUDA11.4,python版本为3.8。硬件环境:CPU为Intel Core i7-8700,内存容量为64 GB,显卡型号为NVIDIA GTX1080Ti,显存容量为11 GB。将采集到的PDW数据经过处理标注后作为训练集送入到网络模型中进行训练,剩下的作为验证集和测试集。其中总的数据量大小为580 MB,训练集、验证集、测试集的划分比例为6∶2∶2。训练数据集反复迭代遍历30次,小批量尺寸设为16,采用Adam优化器,学习率设为0.000 1,损失函数为交叉熵,模型的评价准则为:

(4)

式中:npp表示预测和标签都是类别p的数量;tp表示类别p的真实数量。

实验结果如图5、图6所示。

图5 模型在训练集和验证集上的损失曲线

图6 模型在测试集上的准确度曲线

图9 基于扩展目标布点的目标成像结果

对实验结果进行分析可知,随着迭代次数的增加,训练集和验证集上的损失值不断降低,表明模型在不断学习数据的特征。将30轮次训练的模型参数保存后在测试集上对模型进行验证,可以看出模型在迭代轮次下标为28时对测试数据的表现最好,分选准确率达到93%以上。

4 结束语

本文提出了一种基于Transformer的雷达信号分选方法,该方法将完整的Transformer网络结构进行了适应性的修改以满足雷达信号分选的需要,利用模型中的位置编码和多头注意力机制加强对PDW的数据特征进行训练学习,从而达到雷达信号分选的目的。实验证明,本文提出的方法可以对复杂电磁环境下的信号进行有效分选,对于复杂调制的雷达信号仍然具有适应性,在整个测试集上的分选正确率达到93%以上。