基于计算机视觉的吸烟行为分析方法及系统

胡国昌,王诗太,邓俊芳,龙涛,李轩,赵俊伟,华辰凤,杜文,刘金云

1 湖南中烟工业有限责任公司技术中心,长沙市雨花区劳动中路386 号 410007;

2 深圳爱莫科技有限公司,深圳市南山区国际创新谷1 期2 栋A 座 518000;

3 中国烟草总公司郑州烟草研究院,郑州市高新技术产业开发区枫杨街2 号 450001

随着科学技术的快速进步、人们消费观念的转变以及卷烟品类创新的不断加快,卷烟消费者的需求和关注点也在不断变化。对消费者吸烟行为特征进行研究分析和持续跟踪,了解消费者吸烟习惯及其演变规律,有助于产品研发人员更加精准地进行卷烟产品设计,使新产品开发更加贴近市场需求。吸烟行为特征是吸烟者多个抽吸参数的综合描述,主要包括抽吸口数、抽吸持续时间、抽吸间隔等[1]。

目前国内外研究吸烟行为特征常用的方法主要有两种:第一种是人眼观察法,研究者通过观察吸烟现场或者吸烟视频,用人眼来判断吸烟者的卷烟抽吸情况,借助秒表记录抽吸起始和结束时刻,进而计算吸烟者的抽吸口数、抽吸持续时间和抽吸间隔等抽吸参数[2-5];第二种是记录仪测试法,研究者使用便携式吸烟行为CReSS 记录仪来自动记录抽吸参数,并比较了不同人群的抽吸行为差异[6-8]。人眼观察法是一种非侵入式的研究方法,不会干扰研究对象的吸烟行为,但存在记录数据不精确、投入人力成本高、难以大规模推广等问题;记录仪测试法尽管记录数据较为精确且可靠性高,但是一种侵入式测试,容易改变吸烟者真实抽吸行为,而且设备较为昂贵,收集数据效率较低。

近年来,基于深度学习的计算机视觉方法[9-10]在各行各业都得到了广泛应用,这些方法仅需要低成本的摄像头和智能计算设备,可替代人眼实现对物体或动作的识别、跟踪与测量。在吸烟行为检测技术领域,研究者开发了基于深度学习技术和人脸分析算法的公共场所吸烟行为检测系统,可以快速判断出摄像头拍摄范围内的吸烟行为[11-13]。这些研究虽然能够检测出特定环境内的吸烟行为,但是无法准确地记录吸烟者的抽吸参数。

本研究基于计算机视觉提出了一种无感式吸烟行为分析方法,并设计了一套吸烟行为分析系统,不仅可以对视频图像范围内多个吸烟行为自动识别,还可以准确记录每一位吸烟者的抽吸口数、抽吸持续时间和抽吸间隔等吸烟行为参数,可便捷地部署在公共吸烟区域,进行无感式、低成本、高效率、大规模的吸烟行为数据采集。基于获取吸烟人群大数据信息,分析吸烟者的消费模式的关键影响因素,并建立各种类型人群的卷烟消费模式和偏好预测模型,为企业卷烟产品设计和品牌营销提供数据支撑,同时也可为进一步推进文明吸烟环境建设提供参考依据。

1 系统设计

1.1 系统组成

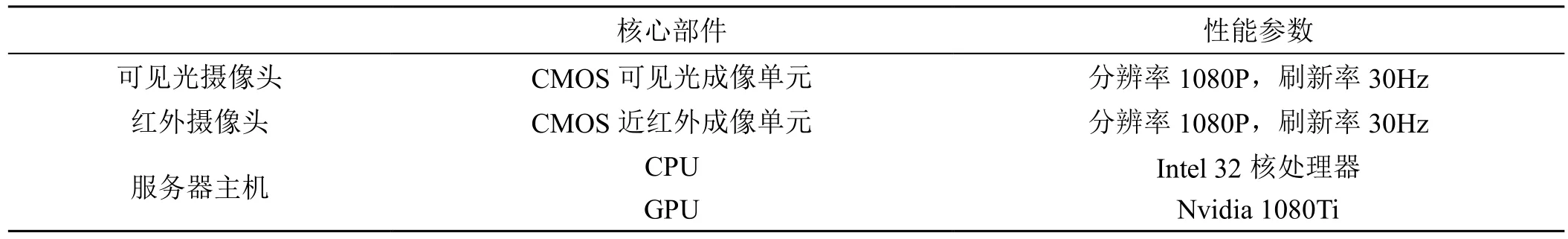

基于计算机视觉的吸烟行为分析系统主要由成像系统和处理系统两大部分组成,见图1。成像系统是由可见光摄像头和红外摄像头组成的双目摄像头,分别用于采集吸烟场景中人体姿态的可见光图像和吸烟场景中烟支烟头(燃烧锥)的红外图像,可见光图像和红外图像同步传输至处理系统。处理系统为一台服务器主机,是由高性能CPU、GPU、VPU 以及存储和通信模块搭建而成的计算平台,用于视频图像处理、吸烟行为分析算法运行、数据存储以及系统控制。吸烟行为分析系统主要硬件配置参数见表1。

表1 系统主要硬件及参数Tab.1 Main hardware and parameters of the system

图1 系统组成示意图Fig.1 System composition diagram

1.2 工作流程

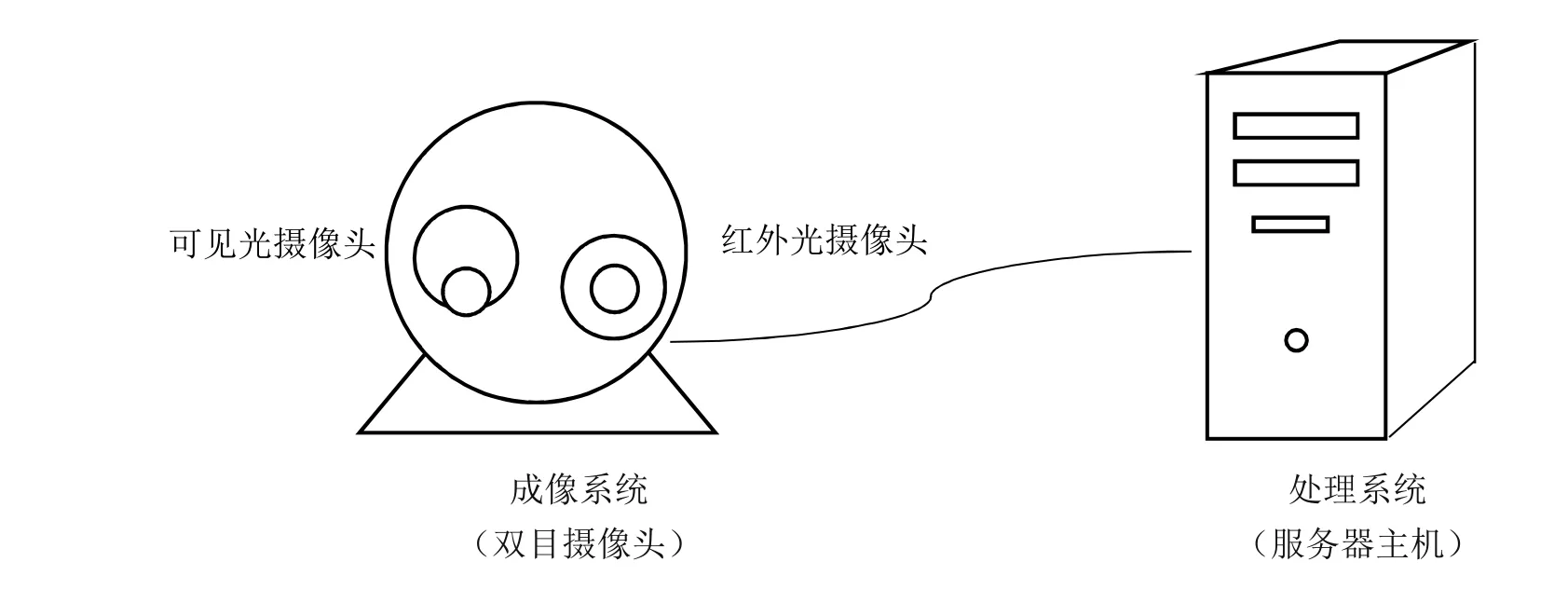

系统使用可见光和红外双目摄像头作为成像设备,首先对双目摄像头进行内外参数标定,使其能正确反映空间与图像之间对应关系,然后对所获得的红外图像进行立体矫正,使其与可见光图像对齐。双目摄像头采集的可见光图像和红外图像传输至处理系统,人脸检测算法对可见光图像中的人脸进行跟踪识别,创建虚拟ID,以便与后续抽吸参数绑定;人体姿态检测算法对人体姿态进行跟踪识别,通过手部与脸部的位置关系变化预判吸烟行为;红外图像经过预处理后,提取烟头光斑区域,烟头状态检测算法分析烟头光斑的位置区域,结合上述人脸检测和人体姿态检测,当光斑出现在人脸区域范围内并存在抽吸动作时,可判定为吸烟行为;烟头状态检测算法同时检测烟头光斑面积实时变化,根据烟头光斑面积变化判定抽吸起止时间,计算抽吸口数、抽吸持续时间和抽吸间隔时间等抽吸参数。系统工作流程见图2。

图2 系统工作流程图Fig.2 System processing flow chart

1.3 关键技术

1.3.1 人脸检测与ID 绑定

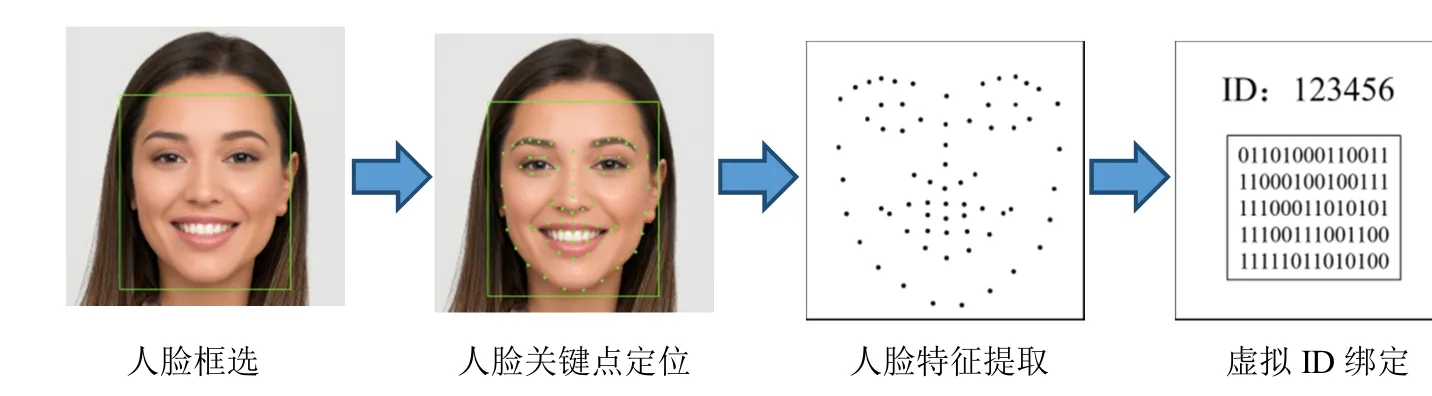

为了确定吸烟者与其吸烟行为的对应关系,首先需要对吸烟者特征进行准确识别。系统利用采集到的可见光图像,借助基于深度学习的人脸检测方法,自动为每个吸烟者创建一个独有的虚拟身份ID,并与其抽吸参数绑定。具体的实现步骤见图3,主要过程为:

图3 人脸检测流程Fig.3 The process of face detection

(1)人脸框选:采用基于级联卷积神经网络的人脸检测器(Cascade CNN[14]),从系统采集的可见光图像中定位人脸图像位置,形成人脸位置的矩形框;

(2)人脸关键点定位:采用级联回归森林算法(Cascade Regression Random Forests)从人脸矩形框中检测人脸轮廓、双眼、鼻尖、嘴角、眉毛等关键点,记录关键点位置;

(3)人脸特征提取:根据提取的人脸关键点对可见光图像进行标准化变换,采用深度学习模型提取人脸特征值,得到单个人脸的特征表达式,算法模型建立步骤及理论公式如下:

根据公式(1)确定检测到的人脸图像中的每一幅图像所对应的质量评价系数q :

式中:f 为每个图像中的人脸特征,μ是同一个人的人脸所对应的图片。

根据公式(2)可以得到人脸特征中的每一个对应的权重系数α :

式中:Constant 是常数,T 为矩阵转置;

根据公式(3)计算经融合的人脸特征μ′。

同时,公式(2)可以通过将公式(4)和公式(5)联立得到:

式中:i为自然数,α 为权重系数,α 满足约束∑α =1 且 α ≥0。

式中:i 和k 为自然数。

通过采用QP 求解器的求解方式来求解目标E(α),以获得权重系数α ,即可得到人脸识别网络的深度卷积网络。

(4)虚拟ID 绑定:根据提取的人脸特征表达式,对摄像头可见光图像中检测到的所有人脸创建虚拟ID,确定哪些人脸属于同一个人的虚拟ID,从而将这个人脸对应的抽吸行为与虚拟ID 进行绑定,实现对所有图像视频中出现的吸烟者个体抽吸行为的记录。

1.3.2 吸烟行为检测

吸烟行为检测主要由人体关键点检测、吸烟行为判定两部分组成。其中,人体关键点检测用于从可见光图像中检测人体各部分的关键点,如膝盖、手腕、鼻子等;吸烟行为判定是在人体关键点检测结果的基础上,通过手腕与鼻子的相对位置判定人物是否处于吸烟状态。当人体的手腕和鼻子部分存在重合且重合的比例达到设定阈值时,初步判定为吸烟行为。

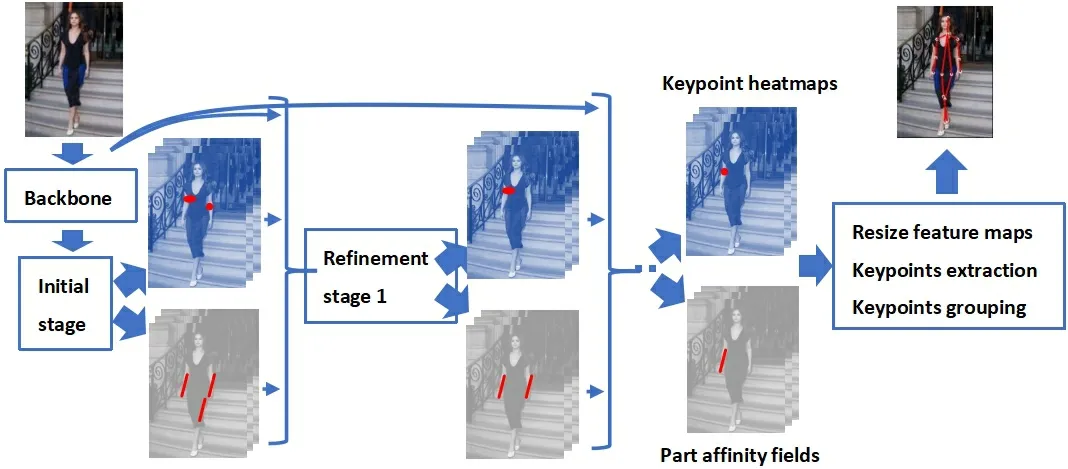

图4 展示了人体姿态检测流程,其核心是基于深度神经网络的检测模型。模型使用VGG-19 网络[15]的前十层作为主干网络,对可见光图像提取特征图。特征图在经过Initial stage 和Refinement stage 1 处理后得到关键点的存在性概率图(Keypoint heatmaps)和部分亲和域(Part Affinity Fields,PAFs),部分亲和域用于记录人体各部位的关联程度。通过贪心推理来对存在性概率图和PAFs 进行分析,最终得到人体的关键点。其中,Initial stage 和 Refinement stage1 均由两个分支网络组成,分别用于从上一阶段的特征图中预测关键点的存在性概率图和PAFs。借助于深度神经网络的鲁棒性,该检测模型可实现在多个体、复杂角度、相互遮挡、复杂姿态等极端条件下对人体多关节的细节进行实时自动提取。

图4 人体关键点检测模型整体检测流程Fig.4 The detection process of human body key points detection model

为了训练该检测模型,训练集采用Coco 人体关键点标注数据集。模型的检测效果如图5 所示。

图5 使用模型检测人体姿态及姿势判断Fig.5 Human body posture detection and judgment by the model

在通过人体关键点检测模型从可见光图像中得到人体各关键点的位置后,系统利用关键点的相对位置对抽吸动作进行识别。当检测到手腕标注点与鼻子标注点有覆盖重合且达到设定阈值时,可初步判定为吸烟行为。同时,通过红外图像可提取烟头光斑区域,对烟头进行精准定位,对区域形状分析以进行置信决策,如果光斑区域出现在人脸区域范围内,则可以判定为吸烟行为。

1.3.3 烟头状态检测

红外摄像头利用烟头燃烧温度较高、产生的红外线辐射显著高于拍摄环境的原理,能较好捕捉烟头光斑信息,精确定位烟头位置,识别烟头状态变化。由于红外摄像头对太阳光中的红外光较为敏感,图像易受其干扰,本研究在红外摄像头上增加一层滤光膜来降低太阳光对红外图像的影响。经测试,选取波长为940nm 滤光片作为阻隔膜可有效削减太阳光对红外成像的影响。

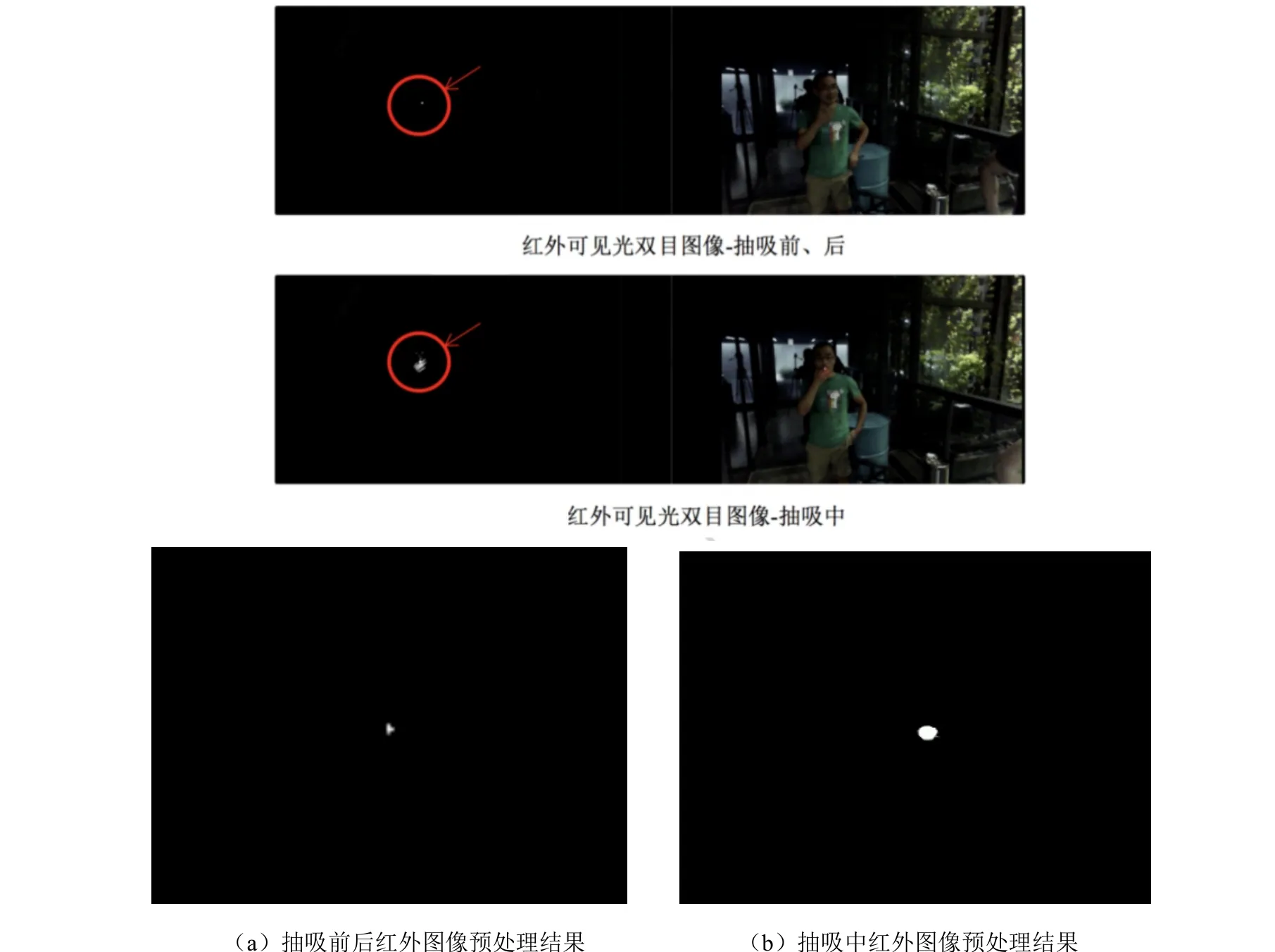

针对非理想测试环境下存在漏检、误检的情况,本研究通过在采集到的真实数据上进行动态阈值分割和联通域膨胀操作的方法,对红外图像进行预处理,使得背景部分与烟头的对比更明显,如图6 所示,突出烟头部分的存在及变化情况,以减少漏检、误检。

图6 红外图像预处理效果Fig.6 Infrared image pre-processing effect

在进行深入分析之前,需要基于人脸3D 角度信息,消除烟头红外光斑中的无关信息对吸烟行为分析的影响。本研究利用人脸角度的信息以及香烟角度的信息,模拟三维空间情况,对烟头的光斑大小进行旋转。当旋转至正面时,计算出对应的烟头光斑大小。此处光斑的面积可以用光斑所在区域的外接矩形的面积来代替。具体计算时,可以计算光斑的外接框,通过计算外接框的长heightold、宽widthold旋转之后所对应的长heightnew、宽widthnew,来计算得到旋转之后的外接矩形的面积areanew。具体的计算公式如下:

式中:α 为偏横角,β 为俯仰角。

在去除无关信息或尺度归一化之后,可以通过对比烟头红外光斑的大小变化与对应的经验阈值之间的关系,确定吸烟者的抽吸开始时刻和结束时刻。

1.3.4 抽吸参数提取

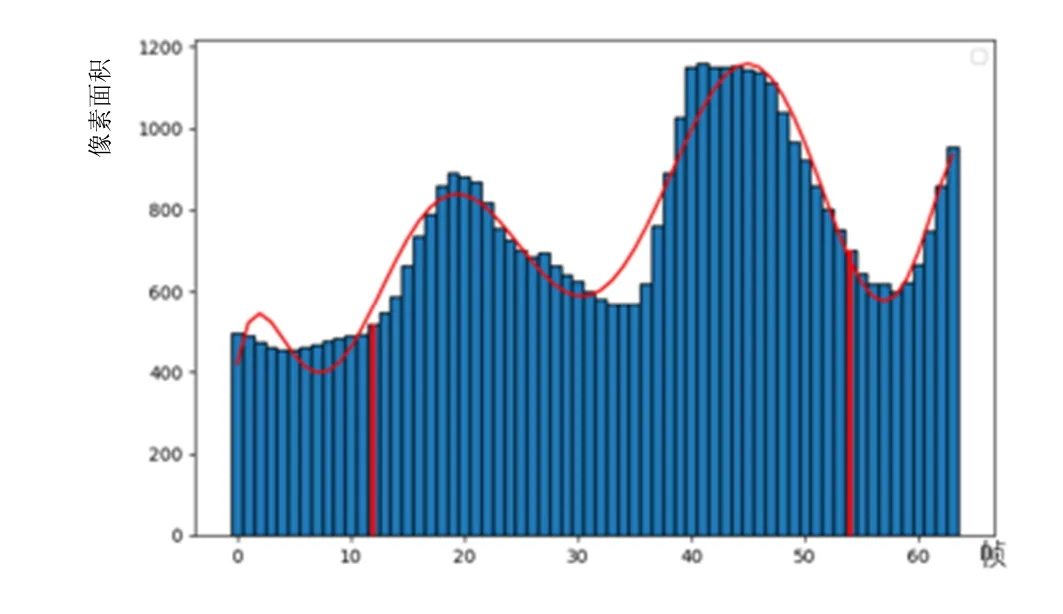

图7(a)展示了吸烟者抽吸前后和抽吸时的红外图像和可见光图像,可以看到,抽烟开始时烟头光斑面积随之增大,抽烟结束时烟头光斑面积会逐渐减小,抽吸时烟头光斑的大小显著高于抽吸前后。图7(b)展示了抽吸动作发生前后一段时间内,不同红外图像帧中的烟头光斑面积统计图。其中,横轴代表不同帧,纵轴为红外图像采集的烟头光斑面积,标红的两柱条分别代表吸烟记录仪记录吸烟的开始时刻和结束时刻。

然而光斑的增大与减小,容易受到烟头晃动、烟头靠近或离开摄像头等情况的影响。通过实验发现,经过高次多项式拟合出来的曲线,能够对吸烟的开始与结束时间,进行很好的辅助定位,曲线公式可以表示为:

式中:a、b、c 为常数,x为帧数,y为烟头光斑像素面积。

曲线拟合效果见图8。在抽吸不同阶段,其烟头光斑大小有明显差异,通过分析光斑尺寸变化情况可分析单口抽吸的始末节点,从而更准确地记录抽吸持续时间。

图8 对光斑面积变化的多项式拟合Fig.8 Polynomial-curve fitting of the smoking spot area change

在拟合出的高次多项式中,根据波峰与波谷附近的曲线积分面积,计算其变化趋势与间隔时间,从而初步判断吸烟的开始与结束时间。需要注意的是,在抽吸结束的后几帧中,会出现光斑面积变大的情况。这种情况实际上是“拖尾”现象导致的,即吸烟者抽吸结束时手放下的过程中,手的快速移动会导致烟头光斑产生较多残影,成像上变成带状,从而使得光斑面积异常增大。而进行正常抽吸动作时,烟头位置不会发生大幅度位移。基于上述分析,本研究增加如下逻辑来过滤因手快速移动导致烟头光斑变大这种情况:当检测到烟头光斑在视野范围内位置有较大位移且伴随烟头面积增大时,此时烟头面积增大的原因为快速移动造成,不作为判定吸烟特征的依据。

在抽吸过程中,吸烟者以及烟头位置也会存在一定的移动变化。本研究通过对光斑的中心位置坐标进行记录并观察发现,相邻帧间光斑中心位置变化和抽烟的起止时间存在较强的相关性。图9 展示了相邻帧间烟头光斑横纵坐标变化随时间变化的曲线。图9(a)纵坐标为烟头光斑面积大小,图9(b)纵坐标为相邻帧中光斑中心点的横坐标变化大小,图9(c)纵坐标为相邻帧中光斑中心点的纵坐标变化大小。可以看出,当处于抽吸过程中时,相邻帧间烟头光斑的位置差异较小;而当处于抽吸前或抽吸后的一段时间内,相邻帧间烟头光斑的位置差异显著变大。通过相邻帧间烟头坐标变化可有助于更准确判断抽吸状态,更精确地定位抽吸开始及结束时刻。

图9 相邻帧中烟头光斑横纵尺寸变化曲线Fig.9 Transverse and longitudinal dimension change curve of cigarette end spot in adjacent frame

最后,借助CReSS 吸烟行为记录仪标定抽吸开始时刻与结束时刻,并用摄像头记录烟头光斑面积变化,通过反复试验获取了大量抽吸时烟头光斑面积及其变化数据。取多次试验烟头光斑变化面积与总面积比值的平均值作为变化阈值,当光斑面积变化超过阈值设定的变化幅度,且其在拟合曲线的波谷及光斑中心点呈现变化趋势的时间点附近,系统可判定为吸烟的开始或结束时刻,从而可计算得到抽吸口数、单口抽吸持续时间、单口抽吸间隔时间等抽吸参数。

2 应用效果

2.1 试验设计

材料:市售常规卷烟(芙蓉王(硬),长度84 mm,圆周24.2 mm)和细支卷烟(芙蓉王(硬细支),长度97 mm,圆周16.9 mm)(由湖南中烟工业有限责任公司技术中心提供)。

仪器:基于计算机视觉的吸烟行为分析系统(本研究项目组设计,以下简称“吸烟行为分析系统”)、CReSS 吸烟行为记录仪(德国Borgwaldt KC 公司)。

方法:于湖南中烟工业有限责任公司技术中心招募30 名吸烟志愿者,告知测试目的,签署知情同意书,进行吸烟行为测试;在模拟公共吸烟室环境的实验室中,志愿者于吸烟行为分析系统摄像头水平距离3 m左右位置,手持CReSS 吸烟行为记录仪按照日常吸烟习惯先后抽吸常规卷烟和细支卷烟各1 支,编号并记为常规卷烟组和细支卷烟组,每组共抽吸30 支;吸烟行为分析系统和CReSS 吸烟行为记录仪同步记录志愿者抽吸参数(抽吸起止时间、抽吸口数、抽吸持续时间和抽吸间隔时间);根据卷烟规格和抽吸起止时间获取的抽吸支数与口数,对吸烟行为分析系统和CReSS 吸烟行为记录仪记录的吸烟行为参数(抽吸口数、抽吸持续时间和抽吸间隔时间)进行配对;以CReSS 吸烟行为记录仪获取的抽吸参数为标准对照,计算吸烟行为分析系统识别误差率,误差率=|吸烟行为分析系统数据—吸烟行为记录仪数据|/吸烟行为记录仪数据×100%。

2.2 数据分析

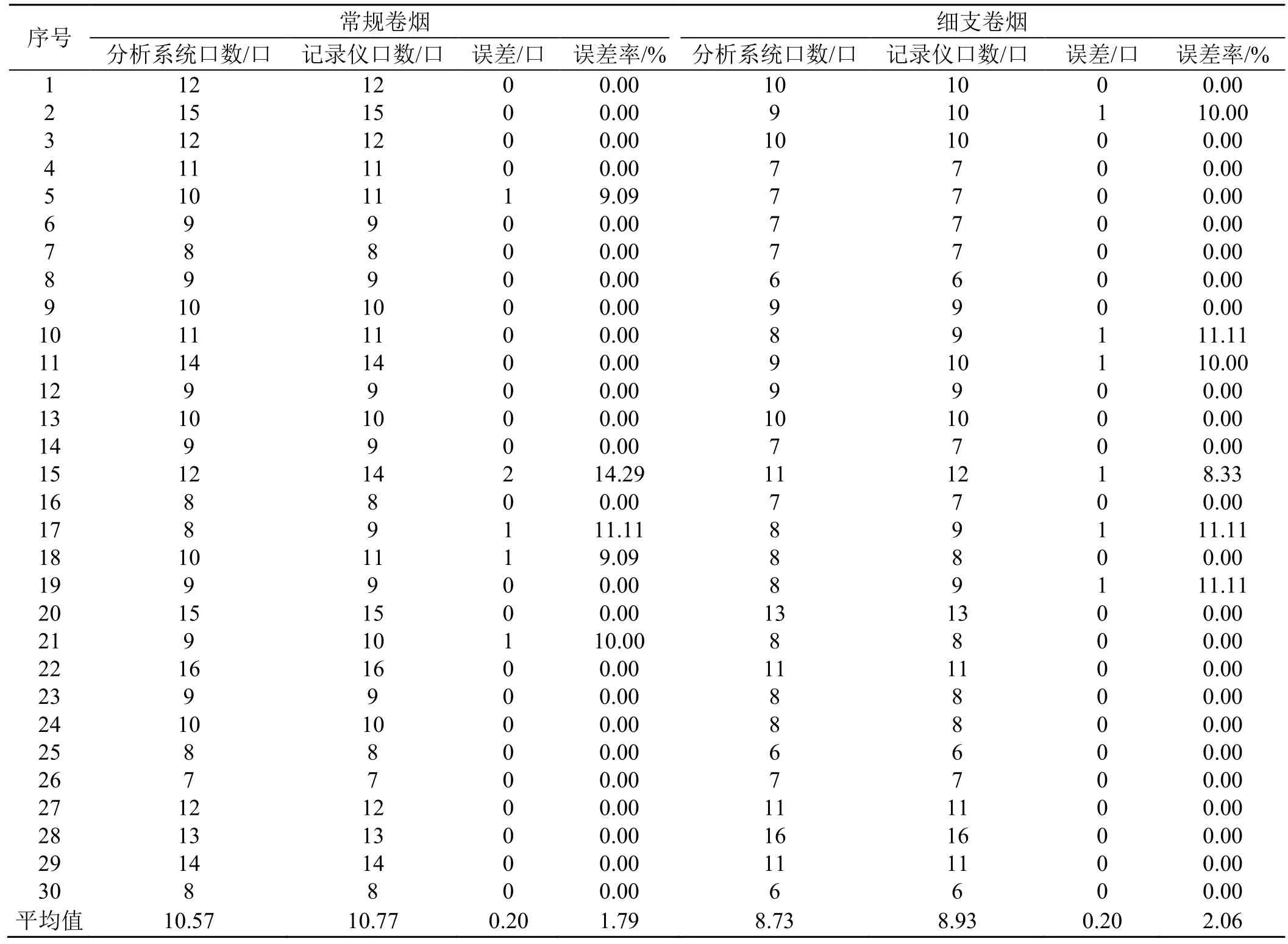

2.2.1 抽吸口数

由吸烟行为分析系统和CReSS 吸烟行为记录仪抽吸起止时间及卷烟规格可知,吸烟行为分析系统和CReSS 吸烟行为记录仪均记录到志愿者抽吸常规卷烟30 支、细支卷烟30 支,这与实际执行方案一致。其中吸烟行为分析系统和CReSS 吸烟行为记录仪记录到常规卷烟组总抽吸口数分别为317 口和323 口,细支卷烟组总抽吸口数分别为262 口和268 口。吸烟行为分析系统对每组单支抽吸口数的识别误差统计结果见表2。可见,吸烟行为分析系统对常规卷烟组和细支卷烟组的单支抽吸口数的识别误差都在2 口以下,识别平均误差率分别为1.79%和2.06%,识别准确性较高。

表2 抽吸口数识别误差Tab.2 Error of puff number

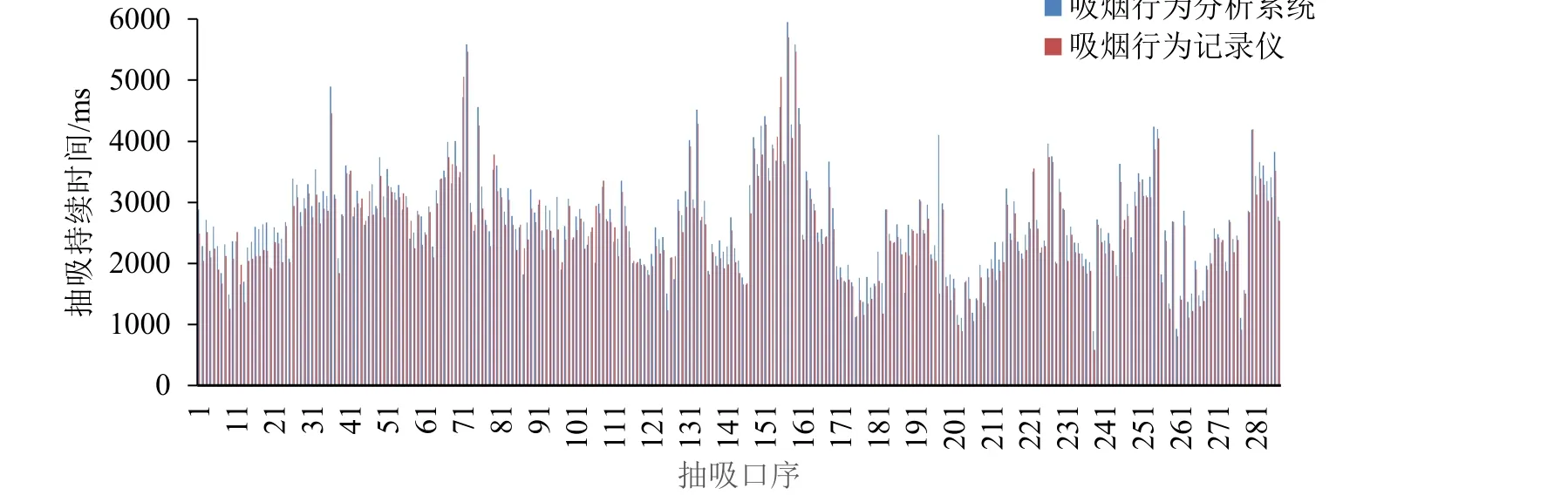

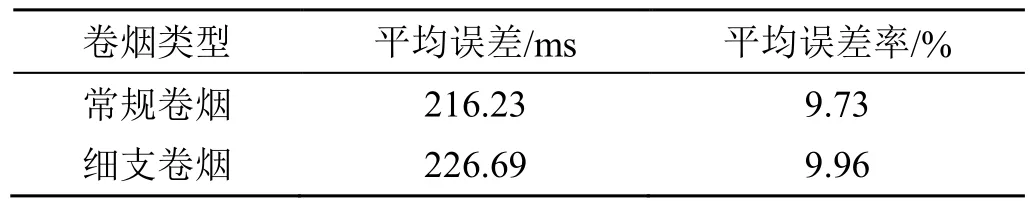

2.2.2 抽吸持续时间

由于每支烟的第一口抽吸为点烟动作,吸烟行为分析系统识别的抽吸数据参考性不强,因此本研究在数据分析时均去除第一口的抽吸参数(下同)。选择吸烟行为分析系统与CReSS 吸烟行为记录仪记录的每支卷烟抽吸口数一致的组内单口抽吸持续时间数据进行比对分析,结果见图10、图11。可见,吸烟行为分析系统记录的常规卷烟单口抽吸持续时间范围为893~5953 ms,平均值为2690 ms;细支卷烟单口抽吸持续时间范围为759~5233 ms,平均值为2786 ms。吸烟行为记录仪记录的常规卷烟单口持续时间范围为581~5703 ms,平均值为2531 ms;细支卷烟单口抽吸持续时间范围为660~4998 ms,平均值为2590 ms。

图10 常规卷烟两种方法抽吸持续时间比较Fig.10 Comparison of smoking duratioon of the conventional cigarettes using two puffing methods

图11 细支卷烟两种方法抽吸持续时间比较Fig.11 Comparison of smoking during of small cigarettes under two puffing methods

分别计算吸烟行为分析系统对两种卷烟单口抽吸持续时间识别的平均误差和平均误差率,结果见表3。可见,吸烟行为分析系统对常规卷烟和细支卷烟单口抽吸持续时间的识别误差率分别为9.73%、9.96%,识别准确性较高。

表3 抽吸持续时间识别误差Tab.3 Time error of smoking duration

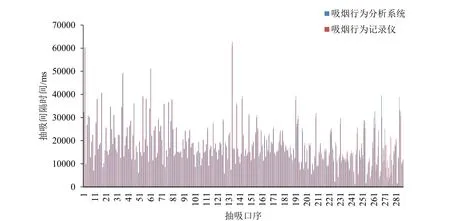

2.2.3 抽吸间隔时间

选择吸烟行为分析系统与CReSS 吸烟行为记录仪记录的每支烟抽吸口数一致的组内抽吸间隔时间数据进行比对分析,结果见图12、图13。可见,吸烟行为分析系统记录的常规卷烟单口抽吸间隔时间范围为1066~60997 ms,平均值为17816 ms;细支卷烟单口抽吸间隔时间范围为1881~57403 ms,平均值为18198 ms。吸烟行为记录仪记录的常规卷烟单口间隔时间范围为1477~62799 ms,平均值为18158 ms;细支卷烟单口抽吸间隔时间范围为2402~58344 ms,平均值为18188 ms。

图12 常规卷烟两种方法抽吸间隔时间比较Fig.12 Comparison of smoking interval time of the conventional cigarettes under two puffing methods

图13 细支卷烟两种方法抽吸间隔时间比较Fig.13 Comparison of smoking interval time of small cigarettes under two puffing methods

分别计算吸烟行为分析系统对两种卷烟单口抽吸间隔时间识别的平均误差和平均误差率,结果见表4。可见,吸烟行为分析系统对常规卷烟和细支卷烟抽吸间隔时间的识别误差率分别为6.59%、6.91%,识别准确性较高。

表4 抽吸间隔时间识别误差Tab.4 Smoking interval time error

3 结论

(1)本研究运用计算机视觉技术设计了一种无感式吸烟行为分析系统,通过双目摄像头采集吸烟场景视频图像,结合人脸检测算法、人体姿态检测算法和烟头状态检测算法同时识别多个吸烟行为并记录抽吸参数,为吸烟行为参数的智能化、高效率、准确性采集提供了一种新的方法。

(2)在湖南中烟工业有限责任公司技术中心招募30 名志愿者对系统应用效果进行了测试,结果表明:以相同条件下的CReSS 吸烟行为记录仪记录的数据为参照,吸烟行为分析系统对常规卷烟和细支卷烟抽吸口数识别的平均误差率分别为1.79%、2.06%,抽吸持续时间识别的平均误差率分别为9.73%、9.96%,抽吸间隔时间识别的平均误差率分别为6.59%、6.91%,表明系统具有较高的准确性,能够满足吸烟行为数据采集需要。

(3)该系统设计了数据脱敏功能,采集的图像和数据均经过匿名化处理,不涉及吸烟者个人信息和隐私;在实际应用时可通过设置提示标识,告知吸烟者可能被记录抽吸参数;系统设计符合《中华人民共和国个人信息保护法》的要求,在吸烟行为研究方面具有广阔的应用前景。

——基于波特五力模型理论的视角