无人机辅助的双层深度强化学习任务卸载算法

陈钊 龚本灿

收稿日期:2023-06-25;修回日期:2023-08-03 基金项目:国家自然科学基金资助项目(62172255)

作者简介:陈钊(1999—),男,河南许昌人,硕士研究生,主要研究方向为边缘计算、边缘智能;龚本灿(1970—),男(通信作者),湖北监利人,教授,硕导,博士,主要研究方向为边缘计算、网络安全(gonbc@sina.com).

摘 要:为了解决无人机轨迹优化、用户功率分配和任务卸载策略问题,提出了一种双层深度强化学习任务卸载算法。上层采用多智能体深度强化学习来优化无人机的轨迹,并动态分配用户的传输功率以提高网络传输速率;下层采用多个并行的深度神经网络来求解最优卸载决策以最小化网络的时延和能耗。仿真結果表明,该算法使得无人机能够跟踪用户的移动,显著降低系统的时延和能耗,能够给用户提供更优质的任务卸载服务。

关键词:无人机辅助;轨迹优化;双层深度强化学习;任务卸载

中图分类号:TP393 文献标志码:A

文章编号:1001-3695(2024)02-016-0426-06

doi:10.19734/j.issn.1001-3695.2023.06.0250

UAV-assisted two-layer deep reinforcement learning algorithm

for task offloading

Chen Zhaoa,b,Gong Bencana,b

(a.College of Computer & Information Technology,b.Hubei Key Laboratory of Intelligent Vision Based Monitoring for Hydroelectric Enginee-ring,China Three Gorges University,Yichang Hubei 443000,China)

Abstract:In order to solve the problems of UAV trajectory optimization,user power allocation and task offloading strategy,this paper proposed a two-layer deep reinforcement learning(TDRL) algorithm for task offloading.The upper layer used the multi-agent deep reinforcement learning to optimize the trajectories of UAVs,and dynamically allocated the user transmission power to improve the transmission rate of the network.The lower layer used multiple parallel deep neural networks to generate the optimal offloading decision to minimize network latency and energy consumption.The simulation results show that the proposed algorithm enables UAVs to track user movement,significantly reduces system latency and energy consumption,and provides users with better task offloading services.

Key words:UAV-assisted;trajectory optimization;two-layer deep reinforcement learning;task offloading

0 引言

近年来,随着物联网的快速发展,智能手机、智能穿戴、便携式设备等各种物联网设备的数据规模呈爆炸性增长[1]。移动设备的计算资源有限,难以处理时延敏感型任务和大规模计算任务。因此,移动边缘计算(MEC) 应运而生[2]。移动设备将需要处理的任务卸载到边缘服务器,以降低计算时延和能耗[3]。然而在一些特殊的应用场景中,固定部署的边缘服务器难以满足用户对网络带宽的需求,此时利用无人机高机动性和方便部署的特点,以无人机作为移动基站为用户提供临时的网络通信环境[4]。在MEC中,无人机的轨迹优化和资源分配问题已经成为当前的研究热点。文献[5]在满足传输速率、飞行速度和可用能量的约束下,以最大化系统的吞吐量为目标对无人机的飞行轨迹和功率分配进行了优化。文献[6]通过联合优化无人机的位置、通信和计算资源的分配,以最小化物联网设备的服务延迟和无人机的能耗。文献[7]提出了一种基于反向散射的任务卸载和资源分配算法,通过优化无人机的轨迹、用户发射功率、计算频率、卸载比例和反向散射的时间来最小化系统的总能耗。文献[8]提出了一种新的数据卸载决策框架,采用非合作博弈来最大化每个用户的满意度。文献[9]提出了一种多子群演化交互的均衡优化算法,能够优化多个无人机的位置及网络的卸载决策。

以上文献采用传统的优化算法或启发式算法来解决无人机辅助MEC中的资源分配问题,取得了较好的效果,但是传统的优化算法或启发式算法需要大量的迭代,使得这些算法不适合在复杂时变环境中用于无人机通信,或作为计算服务的实时解决方案。为了实时解决无人机辅助MEC中的资源分配问题,研究人员采用了深度强化学习方法,智能体通过与复杂的环境交互,可以在没有人工控制的情况下利用深度神经网络强大的学习能力来实时生成最优策略,自动适应快速变化的网络环境。

文献[10]采用深度Q网络和深度确定性策略梯度算法来优化无人机的轨迹和虚拟机的配置,以最小化系统的计算和通信延时。文献[11]提出了一种基于深度强化学习的无人机任务调度算法,平衡了无人机的负载,提高了每架无人机执行任务的效率。文献[12]提出了一种基于分布式深度强化学习的协同探索和优先经验重放方法,采用分布式探索过程,允许移动设备协同学习以获得具有最低成本的卸载策略。文献[13]提出了一个5G网络切片扩展设计框架,通过强化学习,系统控制器可以打开和关闭无人机的计算单元,并将任务卸载到其他无人机,以最大限度地减少功耗、任务损失和系统延迟。文献[14]提出了一种多智能体深度强化学习算法,建立了无人机的成本收益模型,通过联合优化功率控制、資源分配、用户与无人机的关联关系来最大限度地降低系统能耗,但该算法假定无人机集群只能沿着固定半径的圆形轨迹飞行。文献[15]提出了一种基于深度确定性策略梯度的无人机连续移动控制算法,考虑了能量消耗、用户服务质量和无人机覆盖的公平性。文献[16]提出了一种深度强化学习算法来求解边缘计算中多无人机的最优轨迹设计和卸载策略问题,但无人机只能在固定高度飞行。文献[17]提出了一种基于多智能体深度强化学习的无人机轨迹控制算法,用于管理每架无人机的轨迹,并优化用户的卸载决策。

以上算法能够进行实时的资源分配,但这些算法没有考虑用户的移动性,不能根据用户的移动来优化无人机的飞行轨迹,以最大化网络的传输速率。文献[18]提出了基于Q机器学习的无人机轨迹设计和功率控制算法。文献[19]提出了一种基于深度强化学习的无人机轨迹设计和功率分配算法。这两种算法都能规划无人机的轨迹,实现无人机对用户的跟踪,提高网络的传输速率,但都未考虑用户的卸载策略。

综上所述,在MEC中,现有基于深度强化学习的无人机辅助任务卸载算法没有同时考虑用户的移动性和用户的卸载策略。因此,本文在用户随机移动的背景下研究了无人机的飞行控制、用户与无人机的关联关系、用户的功率分配和卸载策略,以最大限度地减少网络的时延和能耗,这是一个时间序列混合整数非凸规划问题,涉及多个耦合的优化变量。为了解决这个问题,本文设计了一个双层深度强化学习架构,上层采用多智能体深度强化学习实现无人机对用户的跟踪,优化用户的功率分配,以提高网络的传输速率,为用户的任务卸载提供稳定的通信保障;下层使用多个并行的深度神经网络生成最优卸载决策,以最小化网络的时延和能耗。通过上下层的联合优化来解决无人机的飞行控制和系统的资源分配问题。

1 系统建模

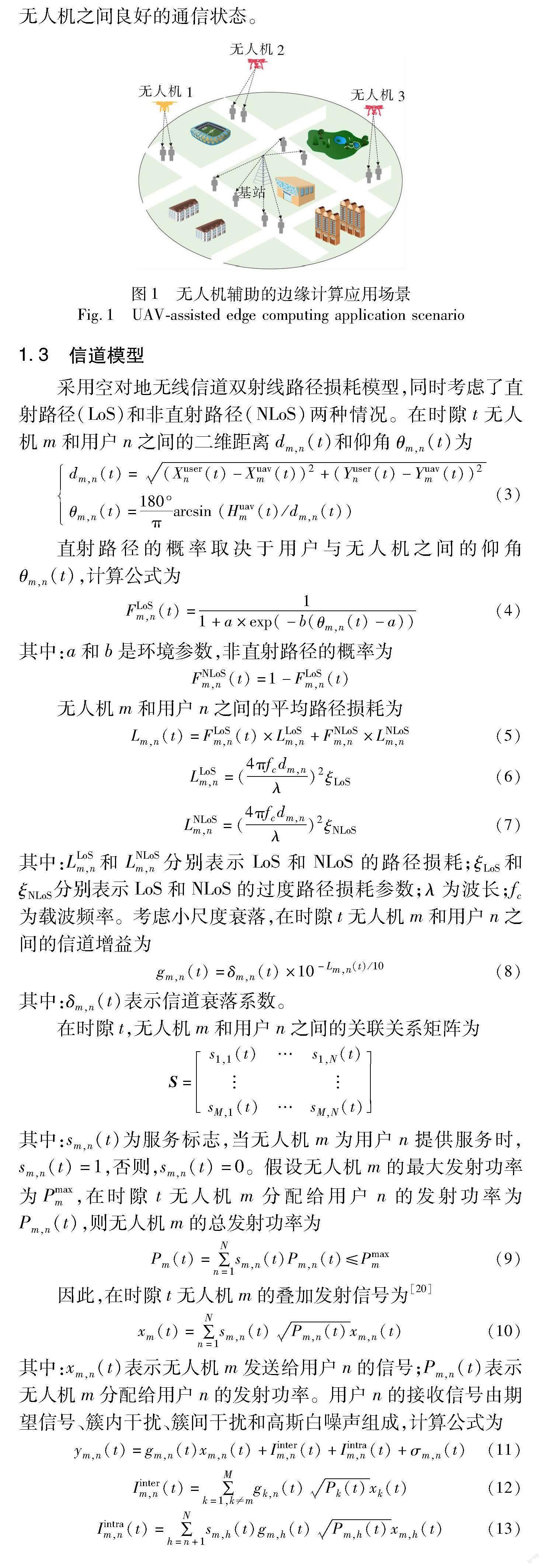

1.1 系统模型

本文的应用场景如图1所示。在一个三维空间内有大量用户、多个无人机和一个地面基站,由于地面基站无法为过多的用户提供可靠的通信服务,为了给过载的地面基站分担压力,所以采用无人机作为辅助设备,通过NOMA接入技术为移动用户提供高质量的通信和计算服务。当用户与地面基站之间的传输速率低于额定速率RQos时,将由无人机为其提供服务。用户在限定区域内可以自由移动,无人机(即智能体)能实时检测用户的位置,为用户分配无人机并规划无人机的飞行轨迹。假设被无人机服务的移动用户个数为N,其集合表示为n∈Euclid Math TwoNAp={1,2,…,N},无人机的数量为M,其集合表示为m∈Euclid Math TwoMAp={1,2,…,M}。无人机在T时间段内为用户提供服务,将整个服务时间均匀离散为长度Δt的时隙,其集合表示为t∈Euclid Math TwoTAp={1,2,…,T}。无人机m在时隙t的位置为Ouavm(t)=(Xuavm(t),Yuavm(t),Huavm(t))。每个用户n在时隙t的位置为Ousern(t)=(Xusern(t),Yusern(t),Husern(t)),设定用户只在地面行走,所以Husern(t)=0。用户随机移动,用户n在下一个时隙的位置可以表示为

Xusern(t+1)=Xusern(t)+randn×Vusermax×cos αn(t)(1)

Yusern(t+1)=Yusern(t)+randn×Vusermax×sin αn(t)(2)

其中:randn∈[0,1],αn∈[0,2π]都是随机数,表示用户的移动方向;Vusermax表示用户的最大移动速度,是一个系统参数。

1.2 自适应关联服务模型

为了减少干扰,根据用户的位置信息,将所有用户划分为与无人机同等数量的用户簇(C1,C2,…,CM),并为每个簇分配一个无人机,这样保证每个用户都能覆盖到且不会被重复服务。在服务过程中,由于用户处于随机移动状态,一段时间后簇内用户之间可能会相距很远,导致无人机与用户之间的通信质量变差。所以,设定重新分簇的距离阈值为dmax,当簇内任意两个用户之间的距离超过dmax时将重新分簇,以维持用户与无人机之间良好的通信状态。

1.3 信道模型

采用空对地无线信道双射线路径损耗模型,同时考虑了直射路径(LoS)和非直射路径(NLoS)两种情况。在时隙t无人机m和用户n之间的二维距离dm,n(t)和仰角θm,n(t)为

dm,n(t)=(Xusern(t)-Xuavm(t))2+(Yusern(t)-Yuavm(t))2

θm,n(t)=180°πarcsin (Huavm(t)/dm,n(t))(3)

直射路径的概率取决于用户与无人机之间的仰角θm,n(t),计算公式为

FLoSm,n(t)=11+a×exp(-b(θm,n(t)-a))(4)

其中:a和b是环境参数,非直射路径的概率为

FNLoSm,n(t)=1-FLoSm,n(t)

无人机m和用户n之间的平均路径损耗为

Lm,n(t)=FLoSm,n(t)×LLoSm,n+FNLoSm,n×LNLoSm,n(5)

LLoSm,n=(4πfcdm,nλ)2ξLoS(6)

LNLoSm,n=(4πfcdm,nλ)2ξNLoS(7)

其中:LLoSm,n 和LNLoSm,n分别表示LoS和NLoS的路径损耗;ξLoS和ξNLoS分别表示LoS和NLoS的过度路径损耗参数;λ为波长;fc为载波频率。考虑小尺度衰落,在时隙t无人机m和用户n之间的信道增益为

gm,n(t)=δm,n(t)×10-Lm,n(t)/10(8)

其中:δm,n(t)表示信道衰落系数。

在时隙t,无人机m和用户n之间的关联关系矩阵为

S=s1,1(t)…s1,N(t)

sM,1(t)…sM,N(t)

其中:sm,n(t)为服务标志,当无人机m为用户n提供服务时,sm,n(t)=1,否则,sm,n(t)=0。假设无人机m的最大发射功率为Pmaxm,在时隙t无人机m分配给用户n的发射功率为Pm,n(t),则无人机m的总发射功率为

Pm(t)=∑Nn=1sm,n(t)Pm,n(t)≤Pmaxm(9)

因此,在时隙t无人机m的叠加发射信号为[20]

xm(t)=∑Nn=1sm,n(t)Pm,n(t)xm,n(t)(10)

其中:xm,n(t)表示无人机m发送给用户n的信号;Pm,n(t)表示无人机m分配给用户n的发射功率。用户n的接收信号由期望信号、簇内干扰、簇间干扰和高斯白噪声组成,计算公式为

ym,n(t)=gm,n(t)xm,n(t)+Iinterm,n(t)+Iintram,n(t)+σm,n(t)(11)

Iinterm,n(t)=∑Mk=1,k≠mgk,n(t)Pk(t)xk(t)(12)

Iintram,n(t)=∑Nh=n+1sm,h(t)gm,h(t)Pm,h(t)xm,h(t)(13)

其中:gm,n(t)xm,n(t)表示期望信号;Iinterm,n表示当无人机m与用户n通信时来自其他无人机的簇间干扰;Iintram,n表示当无人机m与用户n通信时来自簇内其他用户的干扰;σm,n(t)为高斯白噪声。

采用NOMA接入技术时,接收端采用串行干扰消除(SIC)技术进行解码以消除干扰。SIC技术将接收到的用户信号功率从大到小进行排序后依次解码,得到用户数据,第n次被解码用户的信干噪比公式为

SINRm,n(t)=sm,n(t)gm,n(t)Pm,n(t)∑Nh=n+1sm,h(t)gm,h(t)Pm,h(t)+∑Mk=1,k≠mgk,n(t)Pk(t)+σm,n(t)(14)

在时隙t,無人机m与用户n之间的传输速率为

Rm,n(t)=B log2 (1+SINRm,n(t)2)(15)

其中:B表示无人机m的带宽。因此,在时隙t所有无人机与关联用户之间总的传输速率为

R(t)=∑Mm=1∑Nn=1Rm,n(t)(16)

1.4 计算模型

假设在时隙t用户n待处理任务的数据量为Dn(t)。采用二元卸载模式,用户的计算任务可卸载到无人机上执行,也可在本地执行,用户的卸载策略为

ψ=(x1(t),x2(t),…,xN(t))

其中:xn(t)∈{0,1},如果xn(t)=0时,则用户n的任务在本地执行,否则,用户n的任务全部卸载到无人机上执行。时延由传输时延和计算时延两部分组成,传输时延包括用户向无人机卸载任务的时延和无人机将计算结果返回给用户的时延,由于计算结果通常数据量比较小,所以和文献[21]相同。忽略返回结果所用的时间,总时延为

Ttotal(t)=Ttrans(t)+Tuavcompu(t)+Tlocalcompu(t)(17)

Ttrans(t)=∑Nn=1 ∑Mm=1Dn(t)xn(t)Rm,n(t)(18)

Tuavcompu(t)=∑Nn=1Dn(t)ωuavxn(t)fuav(19)

Tlocalcompu(t)=∑Nn=1Dn(t)ωuser(1-xn(t))fuser(20)

其中:Ttrans(t)表示卸载任务的传输时延;Tuavcompu(t)表示边缘服务器的计算时延;Tlocalcompu(t)表示本地的计算时延;ωuav和ωuser分别表示在边缘服务器和用户设备上处理每bit数据需要消耗的CPU周期数;fuav为无人机上边缘服务器的CPU计算频率;fuser为用户设备的CPU计算频率。完成任务的总能耗为

Etotal(t)=Etrans(t)+Euavcompu(t)+Eusercompu(t)+Emove(t)(21)

Etrans(t)=Ttrans(t)Pm,n(t)(22)

Euavcompu(t)=Tuavcompu(t)Puavcompu(23)

Eusercompu(t)=Tusercompu(t)Pusercompu(24)

Emove(t)=m(t)(Er-1)Ehmmax+Eh(25)

其中:Etrans(t)表示在时隙t任务的传输能耗;Euavcompu(t)和Eusercompu(t)分别表示无人机和用户设备的计算能耗;Pm,n(t)为无人机m向关联用户n发射信号的功率;Puavcompu和Pusercompu分别表示无人机和用户设备的计算功率;Emove(t)表示无人机的移动能耗;mmax表示无人机在一个时隙的最大移动距离;m(t)表示无人机在时隙t的移动距离;Eh表示无人机悬停一个时隙所消耗的能量;Er表示无人机飞行最大距离mmax所消耗的能量与悬停所消耗的能量之比。

1.5 问题描述

算法通过优化无人机的轨迹、用户的发射功率、用户与无人机之间的关联关系和卸载策略来最小化系统的时延和能耗,将优化问题定义为

P1:Q=minOuav,P,S,ψ ∑Tt=0(βEtotal(t)+(1-β)Ttotal(t))(26a)

s.t. Xmin≤Xuavm(t),Xusern(t)≤Xmax,m,n,t(26b)

Ymin≤Yuavm(t),Yusern(t)≤Ymax,m,n,t(26c)

Hmin≤Huavm(t)≤Hmax,m,t(26d)

Husern(t)=0,n,t(26e)

Ouavm(t)≠Ouavi(t),m,i∈Euclid Math TwoMAp,m≠i,t(26f)

Rm,n(t)≥RQos,m,n,t(26g)

∑Nn=1sm,nPm,n(t)≤Pmaxm,m,t(26h)

∑Mm=1sm,n(t)=1,n,t(26i)

Vuavm(t)≤Vuavmax,m,t(26j)

Vusern(t)≤Vusermax,m,t(26k)

xn(t) ∈{0,1},n,t(26l)

其中:约束式(26a)~(26e)是对无人机和用户位置的约束,保证无人机和用户在规定的区域内活动;约束式(26f)是为了避免无人机之间发生碰撞;约束式(26g)是为了确保用户的传输速率不低于额定速率,以保证通信服务质量;约束式(26h)是无人机的发射功率约束,保证每个无人机的发射功率不超过其最大发射功率;约束式(26i)表示每个用户只能被一个无人机所服务;约束式(26j)(26k)分别是无人机和用户的最大移動速度限制;约束式(26l)表示用户采用的是二元卸载决策。

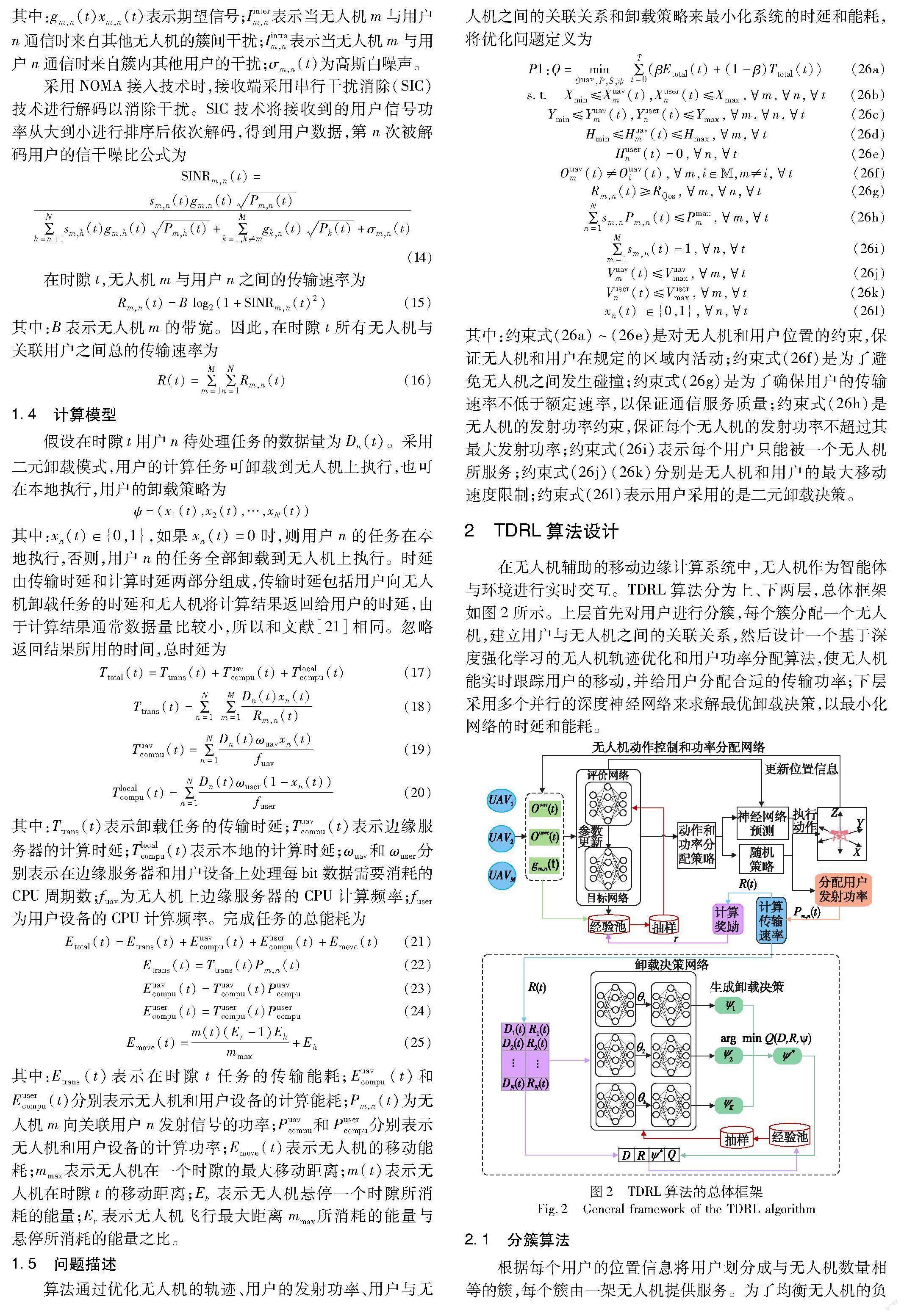

2 TDRL算法设计

在无人机辅助的移动边缘计算系统中,无人机作为智能体与环境进行实时交互。TDRL算法分为上、下两层,总体框架如图2所示。上层首先对用户进行分簇,每个簇分配一个无人机,建立用户与无人机之间的关联关系,然后设计一个基于深度强化学习的无人机轨迹优化和用户功率分配算法,使无人机能实时跟踪用户的移动,并给用户分配合适的传输功率;下层采用多个并行的深度神经网络来求解最优卸载决策,以最小化网络的时延和能耗。

2.1 分簇算法

根据每个用户的位置信息将用户划分成与无人机数量相等的簇,每个簇由一架无人机提供服务。为了均衡无人机的负载,分簇时应保证每个簇的用户数量不超过上限值。另外,为了避免干扰,簇的分布应尽量分散。Kmeans++分簇算法具有较低的复杂度,因此,在该算法的基础上进行改进,设计了自适应分簇算法。

假设用户位置的集合表示为Euclid Math TwoOAp={o1,o2,…,oN},M个簇分别表示为(C1,C2,…,CM),每个簇的质心分别表示为(p1,p2,…,pM)。

算法1 自适应分簇算法

输入:用户位置Euclid Math TwoOAp;需要生成的簇数M;最大迭代次数K;每个簇能容纳的最大用户数δ。

输出:M个簇(C1,C2,…,CM)。

从集合Euclid Math TwoOAp中随机选取一个用户oi

C1=C1∪{oi} //将该用户加入第1个簇中

Euclid Math TwoOAp=Euclid Math TwoOAp-{oi} //从集合中删除该用户

p1=oi //设置第1个簇的质心

for i= 1,2,…,M-1 do //选出M个用户作为初始的簇质心

dn=∑ij=1‖on-pj‖,on∈Euclid Math TwoOAp,/*计算每个用户n与现有簇质心间的距离之和*/

j=arcmax (dn) //取dn最大的用户

Ci+1=Ci+1∪{oj} //将该用户加入第i+1个簇中

Euclid Math TwoOAp=Euclid Math TwoOAp-{oj} //从集合中删除该用户

pi+1=oj //设置第i+1个簇的质心

end

for i= 1,2,…,K do //迭代

for n= 1,2,…,N do //所有用户加入簇

dn,j=‖on-pj‖,1≤j≤M//计算用户n与每个簇质心的距离

k=arcmin1≤j≤M(dn,j) //取dn,j最小的簇

Ck=Ck∪{on} //将用户n加入该簇

pk=1|Ck|∑o∈Cko //更新簇的质心

end for

SSE(i)=∑Mj=1∑o∈Cj‖o-pj‖2 //计算本轮的最小误差平方和

if SSE (i)=SSE (i-1) then

break

end if

end for

while |Cm|>δ,1≤m≤M do //簇中的用户数量超过上限值

将与质心pm距离最远的用户on从簇Cm中删除

将用户on添加到另一个与之最近的簇Ci中,Ci≠Cm

end while

输出生成的M个簇(C1,C2,…,CM)

2.2 无人机轨迹优化和用户功率分配算法

将无人机看作智能体,通过与环境的交互获得反馈信息,无人机对用户的动态跟踪和功率分配问题可以转换成马尔可夫决策过程(MDP),具体描述如下:

a)状态空间。包括在时隙t无人机m的坐标位置(Xuavm(t),Yuavm(t),Huavm(t))、用户n的坐标位置(Xusern(t),Yusern(t))、无人机m和所服务用户n之间的信道增益gm,n(t),位置信息是无人机对用户进行动态跟踪和功率分配的依据。

b)动作空间。包括无人机的飞行控制动作和功率分配动作。由于连续的动作空间具有较高的复杂性,而且无人机的移动幅度较小,离散的动作空间不会对飞行轨迹的精确性造成很大的影响。所以,采用离散化动作,设置了水平向前、向后、向左、向右、垂直向上、向下和悬停七个标准动作,同时设置了六个功率挡位。无人机选择一个飞行动作且为每个服务用户选择一个功率挡位后一直维持到下一个状态。

c)奖励函数。奖励函数的设置为了在保证用户公平性的前提下最大化网络的传输速率,奖励函数为

r=R(t)2k(27)

其中:R(t)表示所有用户的传输速率之和;k是惩罚系数。引入惩罚系数是为了保证用户的公平性和通信质量,当用户n的传输速率低于约定的速率RQos时,其值加1,k的初始值为0,每轮分为若干个时隙,每轮重置惩罚系数的值。

d)动作策略。在训练过程中采用递减的贪婪策略指导智能体选择动作,引入贪婪因子ε∈[0,1],产生一个[0,1]的随机数,若其值小于ε,则采用随机动作,否则采用神经网络的预测动作,贪婪因子ε每轮递减。在训练前期,智能体有较大的概率采用随机动作,以探索更多的可能性,隨着训练轮次的增加,预测动作被选用的概率逐渐增大,以得到最佳的飞行轨迹和传输功率。

e)神经网络的训练。在每轮训练中,无人机检测当前的状态s,根据动作策略选择下一步动作a,并为用户选择合适的功率挡位,得到奖励值r,更新状态s→s′,将(s,a,r,s′)保存到经验池中,采用经验重放技术,当经验池中的数据达到一定数量时,随机抽取部分数据训练神经网络。Q值的更新公式如下:

Q(s,a)=Q(s,a)+α[r+β max Q(s′,a′)-Q(s,a)](28)

其中:α为学习率;β为折扣系数,0<β<1。假设θ和θ′为评价网络和目标网络的参数,采用均方误差作为损失函数L(θ),计算公式如下:

y=r+β max Q(s′,a′,θ′)(29)

L(θ)=(y-Q(s,a,θ))2(30)

算法2 无人机轨迹优化和用户传输功率分配算法

输入:用户位置Ouser(t);无人机位置Ouav(t)和用户信道增益gm,n(t)。

输出:飞行控制动作和功率分配动作。

初始化应用场景,定义无人机与用户的活动范围

初始化评价网络和目标网络的权重参数

ε=0.9 //动作策略的贪婪因子

for each episode do //每一轮

ε= 0.99 ε //贪婪因子递减

k=0 //惩罚系数初值

对所有用户进行分簇(C1,C2,…,CM),并给每个簇分配无人机

for t= 1,2,…,T do //每一个时隙

获取用户和无人机的位置

计算各个簇内用户之间的距离di,j,i,j∈Euclid Math TwoNAp

if max (di,j)>阈值 then

对用户重新分簇,重新绑定服务关系

end if

for each UAV do

根据用户和无人机的信息生成状态数组s

根据动作策略选择动作a

执行动作a,得到下一个状态s′

if R(t) k=k+1 end if 根据式(27)计算奖励r 将(s,a,r,s′)存储到经验池 从经验池中随机选取部分数据来训练神经网络 根据式(29)计算目标值y 根据式(30)计算损失L(θ) 采用梯度下降法更新评价网络的参数 s→s′ end for 用户随机移动 end for end for 2.3 任务卸载算法 任务卸载算法的目标是根据用户的传输速率和任务的数据大小,使用K个并行的深度神经网络进行训练,以得到最优的卸载决策。算法的训练过程如下:输入每个用户在时隙t时任务的数据大小D(t)和传输速率R(t),使用K个DNN生成K个候选卸载决策,第k个卸载决策表示为ψk=(x1,x2,…,xN),xn∈{0,1},用式(31)的参数化函数fθk表示生成卸载决策的动作,θk表示第k个DNN的参数。根据ψk计算对应的Q(D,R,ψk),选择Q值最小的卸载决策作为最优卸载决策,记为ψ*。将数据元组(D(t),R(t),ψ*)存储到经验池中。 fθk:D(t),R(t)→ψk(31) ψ*=argmin Q(D(t),R(t),ψk)(32) 使用K个并行的DNN,有利于加快算法的收敛速度、减少波动,每个DNN具有相同的结构,所有DNN共享一个经验池,经验池设置为固定容量,超出后依次删除最旧的数据,采用经验重放技术每次从经验池中随机选取部分数据来训练DNN。由于使用二元卸载,但DNN的输出不一定是0或1,所以需要进行数据转换,当DNN的输出大于0时,将其值转换为1,否则转换为0。采用交叉熵损失函数和梯度下降法更新各神经网络的参数。 算法3 任务卸载算法 输入:各用户待处理任务的数据大小D(t)和传输速率R(t)。 输出:最优卸载决策ψ*。 初始化K个神经网络的参数θk 创建经验池memory,设置其容量的上限TOP和下限LOW for each episode do //每一轮 for t= 1,2,…,T do //每一个时隙 将D(t)和R(t)输入到K个DNN中 K个DNN生成K个候选卸载决策ψk 计算各卸载决策的Q值 根据式(32),得到Q值最小的卸载决策ψ* if memory_size > TOP then 从经验池中删除一条最旧的记录 将(D(t),R(t),ψ*)存入经验池 end if if memory_size > LOW then 从经验池中随机选取部分数据来训练神经网络 更新各DNN的网络参数θk end if end for end for 3 仿真实验 3.1 实验参数设置 主要实验参数设置如表1所示。 3.2 权重参数β和学习率lr的影响 首先通过实验研究权重参数β和学习率lr对算法性能的影响。不同权重参数β下的时延和能耗如图3所示,当权重参数β较小时,TDRL算法的优化目标更注重时延,此时时延越小,奖励值越大;反之当权重参数β较大时,优化目标更偏向能耗,此时能耗越小,奖励值越大。用户可以根据对时延和能耗的要求来调整权重参数。为了均衡时延和能耗对Q值的影响,以下实验将权重参数β设置为0.45。 上层神经网络在不同学习率下网络的传输速率如图4所示。网络的传输速率指所有用户的传输速率之和。当学习率为0.001时,算法的性能最好,在训练过程中传输速率逐渐上升,在10 000轮后趋向稳定;学习率为0.1和0.01时,网络的传输速率波动很大,没有收敛,因此将上层神经网络的学习率设置为0.001。下层神经网络在不同学习率下的Q值如图5所示,当学习率为0.01时,算法的性能最好,得到的Q值最小。因此,将下层神经网络的学习率设置为0.01。 3.3 实验结果分析 1) 无人机对用户的自动跟踪 当用户移动时,无人机对用户进行跟踪的飞行轨迹如图6所示。在图6中,不同颜色的圆圈代表不同的用户簇(见电子版),图中共有6个用户、3个簇,每个簇内有2个用户,在初始状态下的簇为A、B、C,用户移动后重新分簇的结果为A′、B′、C′,虚线表示用户的移动轨迹,实线是无人机的飞行轨迹,三角形▲是用户或无人机移动的起点,五角星★是用户或无人机移动的终点。可以看出:当初始簇B和C内的用户相距较远时将触发重新分簇,无人机能自动跟踪用户的移动,飞行到新簇的上方。 2)在不同分簇策略下传输速率的变化 将提出的自适应分簇算法与不分簇和周期性分簇进行了对比,实验结果如图7所示。周期性分簇是指设定一个固定的分簇周期,当分簇时间到达时触发分簇。 在分簇后的早期阶段,由于神经网络的訓练,传输速率逐渐增加,但随着网络运行时间的延长,如果采用不分簇方式,则网络的传输速率会逐渐降低。如果采用周期性分簇方式,则当到达分簇时间t=30 s时会触发分簇,网络的传输速率继续上升,但在t=41 s后,随着用户的移动,簇内用户之间的距离增加,网络的传输速率逐渐降低。如果采用自适应分簇,则在t=14 s时,由于检测到簇内有两个用户之间的距离过大,所以触发分簇。重新分簇后传输速率快速上升,在t=45 s后,随着用户的移动,网络的传输速率有所下降,但由于簇内用户之间的最大距离没有超过阈值,所以没有触发分簇。在三种分簇方式中,自适应分簇算法表现最好,为用户与无人机之间的稳定通信起到了基础保障作用。 3)在不同数据大小下各算法的Q值 为了评价无人机的飞行轨迹对网络性能的影响,将TDRL算法与固定轨迹算法(FUT)进行了比较。在FUT中,所有无人机均围绕一个圆心为(0,0),半径为2G/4的圆飞行,每个无人机之间的角度间隔为2π/M,M表示无人机数量。为了评价任务卸载算法对网络性能的影响,将神经网络替换成DQN,其他设置不变。此外,还与文献[21]提出的UMAP算法进行了比较。图8展示了在不同的数据大小下各算法Q值的变化情况。 可以看出,随着任务数据量的增大,各算法的Q值也随之增大,Q值与数据量的大小呈正相关。这是因为当数据量增大时,任务传输、计算的能耗和时延也会相应增加,TDRL算法的性能最优。FUT算法由于移动轨迹固定,不能适时跟踪用户的移动情况,导致用户的传输速率下降,时延和能耗增大,Q值也相应增加。TDRL算法采用多个并行的深度神经网络进行训练,每次取最优值,因此,其Q值小于DQN和UMAP。当数据量的大小为110时,TDRL的Q值比FUT小 17.5%,比DQN小11.2%,比UMAP小7.1%。 4)在不同用户数量下各算法的Q值 图9显示了在不同用户数量下各算法Q值的变化情况。可以看出,随着用户数量的增加,各算法的Q值也随之增长,这是因为当用户数量增加时,网络需要处理的总数据量相应增加,造成网络的时延和能耗变大。TDRL算法的Q值始终最小,其次是UMAP和DQN,FUT表现最差。这是因为当用户数量增加时,FUT算法不能为用户提供良好的通信环境,导致时延和能耗大幅增加。当用户数量为30时,TDRL的Q值比FUT小 23.7%,比DQN小10.5%,比UMAP小7.8%。 4 结束语 本文针对无人机辅助的移动边缘计算场景设计了一个双层深度强化学习架构。在无人机与用户双向移动的复杂环境中,上层将无人机的轨迹优化和用户的功率分配问题转换为马尔可夫决策过程,采用多智能体深度强化学习算法实现了无人机对用户的动态跟踪和功率分配,提高了网络的传输速率;下层通过多个并行的深度神经网络生成最优卸载决策。实验结果表明,在不同的数据大小、不同的用户数量下,TDRL算法的性能均优于FUT、DQN和UMAP算法。未来的研究工作包括采用部分卸载及具有优先级的任务卸载方法。 参考文献: [1]张依琳,梁玉珠,尹沐君,等.移动边缘计算中计算卸载方案研究综述[J].计算机学报,2021,44(12):2406-2430.(Zhang Yilin,Liang Yuzhu,Yin Mujun,et al.Survey on the methods of computation offloading in mobile edge computing[J].Chinese Journal of Computers,2021,44(12):2406-2430.) [2]施巍松,张星洲,王一帆,等.边缘计算:现状与展望[J].计算机研究与发展,2019,56(1):69-89.(Shi Weisong,Zhang Xingzhou,Wang Yifan,et al.Edge computing:state-of-the-art and future directions[J].Journal of Computer Research and Development,2019,56(1):69-89.) [3]Tun Y K,Park Y M,Tran N H,et al.Energy-efficient resource management in UAV-assisted mobile edge computing[J].IEEE Communications Letters,2021,25(1):249-253. [4]Seid A M,Boateng G O,Anokye S,et al.Collaborative computation offloading and resource allocation in multi-UAV assisted IoT networks:a deep reinforcement learning approach[J].IEEE Internet of Things Journal,2021,8(5):12203-12218. [5]Xing Na,Wang Yuehai,Teng Liping,et al.Communication and trajectory design in UAV-enabled flying network[J].Digital Signal Processing,2022,126:article lD 103489. [6]Yu Zhe,Gong Yanmin,Gong Shimin,et al.Joint task offloading and resource allocation in UAV-enabled mobile edge computing[J].IEEE Internet of Things Journal,2020,7(4):3147-3159. [7]李斌,楊蓉蓉.无人机辅助反向散射通信计算任务卸载与资源分配[J].电子与信息学报,2023,45(7):2334-2341.(Li Bin,Yang Rongrong.Computing task offloading and resource allocation in UAV-enabled backscatter communications[J].Journal of Electronics & Information Technology,2023,45(7):2334-2341.) [8]Pavlos A A,Georgios F,Eirini E T,et al.Data offloading in UAV-assisted multi-access edge computing systems under resource uncertainty[J].IEEE Trans on Mobile Computing,2023,22(1):175-190. [9]陈阳,皮德常,代成龙,等.多无人机协同陆地设施辅助移动边缘计算的系统能耗最小化方法[J].电子学报,2023,51(2):1-9.(Chen Yang,Pi Dechang,Dai Chenglong,et al.Energy minimization for a multi-UAVs cooperative ground access points assisted mobile edge computing[J].Acta Electronica Sinica,2023,51(2):1-9.) [10]Liu Ying,Yan Junjie,Zhao Xiaohui.Deep reinforcement learning based latency minimization for mobile edge computing with virtualization in maritime UAV communication network[J].IEEE Trans on Vehicular Technology,2022,71(4):4225-4236. [11]Yang Lei,Yao Haipeng,Wang Jingjing,et al.Multi-UAV-enabled load-balance mobile-edge computing for loT networks[J].IEEE Internet of Things Journal,2020,7(8):6898-6908. [12]Wei Dawei,Ma Jianfeng,Luo Linbo,et al.Computation offloading over multi-UAV MEC network:a distributed deep reinforcement learning approach[J].Computer Networks,2021,199:article lD 108439. [13]Faraci G,Grasso C,Schembra G.Design of a 5G network slice extension with MEC UAVs managed with reinforcement learning[J].Journal on Selected Areas in Communications,2020,38(10):2356-2371. [14]Xue Jianbin,Wu Qingqing,Zhang Haijun.Cost optimization of UAV-MEC network calculation offloading:a multi-agent reinforcement lear-ning method[J].Ad hoc Networks,2022,136:article ID 102981. [15]Yang Peng,Cao Xianbin,Xi Xing,et al.Three-dimensional continuous movement control of drone cells for energy-efficient communication coverage[J].IEEE Trans on Vehicular Technology,2019,68(7):6535-6546. [16]Luo Quyuan,Luan T H,Shi Weisong,et al.Deep reinforcement lear-ning based computation offloading and trajectory planning for multi-UAV cooperative target search[J].IEEE Journal on Selected Areas in Communications,2023,41(2):504-520. [17]Wang Liang,Wang Kezhi,Pan Cunhua,et al.Multi-agent deep reinforcement learning-based trajectory planning for multi-UAV assisted mobile edge computing[J].IEEE Trans on Cognitive Communications and Networking,2021,7(1):73-84. [18]Liu Xiao,Liu Yuanwei,Chen Yue,et al.Trajectory design and power control for multi-UAV assisted wireless networks:a machine learning approach[J].IEEE Trans on Vehicular Technology,2019,68(8):7957-7969. [19]Zhong Ruikang,Liu Xiao,Liu Yuanwei,et al.Multi-agent reinforcement learning in NOMA-aided UAV networks for cellular offloading[J].IEEE Trans on Wireless Communications,2022,21(3):1498-1512. [20]Cui Jingjing,Liu Yuanwei,Ding Zhiguo,et al.Optimal user scheduling and power allocation for millimeter wave NOMA systems[J].IEEE Trans on Wireless Communications,2018,17(3):1502-1517. [21]Chen Jingxuan,Cao Xianbin,Yang Peng,et al.Deep reinforcement learning based resource allocation in multi-UAV-aided MEC networks[J].IEEE Trans on Communications,2023,71(1):296-309.