基于空间相关性增强的无人机检测算法

张会娟,李坤鹏,姬淼鑫,刘振江,刘建娟,张弛

(1.河南工业大学 电气工程学院,河南 郑州 450001;2.北京理工大学 自动化学院,北京 100081)

随着无人机技术和功能的逐渐完善,各个领域都出现无人机的身影,这在丰富和便利人们日常生活的同时,也带来极大的安全隐患.管控不当导致黑飞乱飞事件的日益增多,给公共安全和人民生活带来极大的威胁[1].因此,须采用反无人机系统来防范非法无人机的侵入.在反无人机系统中,检测被视为至关重要的环节,因为只有在准确检测到无人机的存在之后,才能采取进一步的反制措施.因此,对现实场景中低空飞行的无人机进行快速准确检测具有重要的现实意义.

目标检测作为近年来计算机视觉领域的热门研究方向之一,在视觉搜索、虚拟现实、增强现实、自动驾驶等场景应用广泛[2].随着卷积神经网络(convolutional neural network,CNN)[3]的不断发展,基于深度学习的目标检测算法发展迅猛.目前,基于深度学习的目标检测算法可以分为基于回归的单阶段目标检测算法和基于候选区域的两阶段目标检测算法[4].比较有代表性的两阶段算法有RCNN[5]、Fast-RCNN[6]、Faster-RCNN[7]、Mask R-CNN[8]等.这类算法须先从生成的多个候选区域中提取特征,然后进行类标签和边界框的输出,检测精度较高,但是复杂的结构致使检测速度较慢,难以满足实时性的要求[9].以YOLO[10]、SSD[11]为代表的单阶段算法通过提取的特征直接回归目标的坐标和类别,具有检测速度快的优点,但检测精度往往不如两阶段算法.这2类算法对大目标和中目标的检测效果较好,但是在小目标检测方面效果并不理想.虽然两阶段算法具有较高的检测精度,但是无法突破检测速度的限制.对于一些实时性检测任务,无法满足速度要求.对于实际场景下的无人机目标检测须采用极高检测速度的算法,因此更适合使用单阶段算法来进行研究.

无人机作为小目标的一种,经过多层特征提取网络后,其分辨率降低,部分重要信息丢失.因此,实现无人机小目标的快速精准检测绝非易事.目前,诸多学者针对小目标检测提出有效的改进方法,检测性能不断提高.Wang等[12]将金字塔最顶层2个特征图通过注意力编码器进行特征融合,以增强特征图的局部特征和全局表征.Peng等[13]提出通道空间混合注意模块,抑制无用特征信息.Min等[14]提出注意特征金字塔网络结构,过滤冗余信息突出小目标,并通过前景相关上下文增强特征,抑制背景噪声.上述文献在特征融合时抑制冗余信息方面具有一定的效果,但是对于无人机此类微小目标的检测不能保证足够的精度.Ju等[15]设计扩张模块减少信息损失,并设计穿透模块来融合浅层细节信息和深层语义信息.Deng等[16]设计扩张模块减少信息损失,并设计穿透模块来融合浅层细节信息和深层语义信息.He等[17]提出多尺度特征增强融合网络,更好地融合提取的特征,同时提出SCSA模块提高交通场景中小目标的检测精度.Ji等[18]提出扩展的感知块获取更多的上下文特征,并在CIoU的权重函数中引入纵横比权重因子增强网络对小目标的学习能力.张娜等[19]提出双向加权特征金字塔网络,对解码后的位置信息进行通道再分配,进一步融合特征信息.谢誉等[20]提出深层次特征金字塔网络,深层次融合多尺度特征层.上述文献可以进一步增强小目标的特征信息,但是忽略了融合语义不一致特征时的冲突问题.

以上针对小目标检测提出的改进在一定程度上适用于颜色、纹理、形状等特征明显的小目标.在实际场景中对无人机检测时须对空拍摄,面临天空背景下的相机逆光情况.这种情况下的图像分辨率会大幅度降低,导致颜色、纹理、形状等低级特征大量丢失,这就需要融合更多低级特征.其次,无人机有时会在复杂的背景环境下飞行,有时目标的成像只有几个像素,如果不减小信息冲突、增强目标特征表达,无人机特征很有可能会淹没在背景杂波中.

针对上述问题,在一阶段检测算法YOLOv5的基础上,提出基于自适应上采样和空间相关性增强的无人机小目标检测算法.首先提出多尺度上下文信息和注意力特征融合增强(multi-scale context information and attention feature fusion enhancement,MCIAFFE)模块,通过不同空洞率的空洞卷积扩展多尺度的感受野,叠加多尺度的重要浅层特征,经过通道注意力模块 (channel attention module,CAM)提高目标通道的有效性,随后采用注意力特征融合模块抑制特征冲突;其次,提出自适应上采样结构,自适应融合亚像素卷积和双线性插值作为新的上采样方式,平衡计算量并保留更多无人机特征信息;最后,提出空间相关性增强(spatial correlation enhancement,SCE)模块,通过评估局部特征和全局特征的相似度,增强强相关的通道以提高目标辨识度,抑制弱相关的通道以抑制背景噪声,从而增强小目标的敏感度.

1 YOLOv5算法模型

YOLOv5作为端到端的单阶段检测网络,实现了检测速度和精度兼顾,能以极快的速度对目标完成分类和定位任务,被广泛应用于实时性要求高的目标检测任务中.YOLOv5整体结构分为3部分:骨干网络(Backbone)、特征融合网络(Neck)和检测头(Head).输入图片在进行训练之前采用和YOLOv4[21]一样的Mosaic数据增强方式,将4张图片经过随机剪裁、缩放变换后拼接在一起,不仅可以扩充数据集,而且可以提高训练速度,使模型具有更好的鲁棒性.

Backbone网络的主要作用是提取图像特征,将输入的3维图像转化为多层特征图.在网络训练过程中,输入图像经过Backbone结构实现32倍下采样提取特征.Neck网络的主要作用是跨层融合多尺度的特征图,整体采用PAN[22]结构,该结构通过上采样和下采样可以得到与Backbone中相同尺度、包含丰富语义信息的深层特征图.通过融合多尺度的深层特征与浅层特征,得到更丰富的特征表示,最终输出尺度为20×20、40×40、80×80的3个特征图,分别负责对大、中、小目标的检测[23].Head网络生成目标的边界框和类别概率,从而实现目标定位和分类[24].

虽然YOLOv5具有一定的小目标检测能力,但是不满足无人机此类对检测要求极高的小目标检测,因此须对YOLOv5算法的网络结构进行改进.

2 改进的YOLOv5算法

为了提高无人机小目标的检测性能,同时考虑算法实时性的问题,在YOLOv5算法上进行改进,改进后的网络结构如图1所示.首先,为了缓解多层特征提取网络导致的特征损失,同时为了减少语义不同和尺度不一致导致的特征冲突问题,在金字塔最顶层嵌入多尺度上下文信息和注意力特征融合增强模块MCIAFFE,使顶层特征图有效融合浅层特征图中丰富的小目标位置和细节这些低级特征;其次,为了减少YOLOv5采用最近邻插值法导致的上采样结果中的特征损失,提出自适应的上采样方式,通过自适应融合亚像素卷积和双线性插值2种上采样方式,在平衡计算量的同时还原更准确的特征信息,得到包含更多无人机小目标低级特征的特征图;最后,为了提高特征相似的背景下无人机的辨识度,在Neck结构中,对在自顶向下路径上的特征图进行下采样后,采用空间相关性增强SCE模块,增强小目标在复杂背景下的特征提取能力.

图1 改进后的YOLOv5网络结构Fig.1 Improved YOLOv5 network structure

2.1 多尺度上下文信息和注意力特征融合增强

无人机小目标的特征信息主要集中在拥有丰富位置信息和细节信息的浅层特征中,但高层特征图中包含的丰富的语义信息也不可忽略.为了解决在特征提取过程中,高层特征图中无人机小目标的低级特征丢失导致检测能力较弱的问题,须将浅层特征图的上下文信息融入到高层特征图中,即使得上下文信息能为小目标检测提供更有效的信息[25],故对金字塔最顶层进行特征融合增强.设计多尺度上下文信息和注意力特征融合增强模块MCIAFFE,该模块结构如图2所示.

图2 多尺度上下文信息和注意力特征融合增强模块Fig.2 Multi-scale contextual information and attentional feature fusion enhancement module

具体步骤如下.

如图2(a)所示为多尺度上下文信息和注意力特征融合增强模块整体结构图.首先,使用2、3、5这3个空洞率不同的空洞卷积对输入特征图X分别进行感受野扩大处理,学习小目标的局部上下文信息[26],得到X1、X2、X3,可以表示为

式中:dconv(·) 表示空洞卷积,右上角角标代表空洞率,右下角角标代表卷积核的大小;conv1×1(·)表示1×1的标准卷积,用于缩放通道减少计算量.

将得到的3个特征图进行拼接得到特征图F,之后经过CAM调整每个通道的权重,CAM同时使用自适应平均池化和自适应最大池化2种池化操作.将池化后的向量经过MLP操作和归一化函数得到通道注意力权重,拆分得到3个对应于X1、X2和X3的权重 α、β、γ,可以表示为

式中:split(·) 表示chunk函数,将注意力权重平均拆分为3份;S(·) 表示sigmoid函数,得到0~1.0的归一化权值[27];MLP(·) 表示输入经过卷积-Relu激活-卷积操作;Pa(·) 和Pm(·) 分别为平均池化和最大池化,用于对H×W×C的输入进行压缩,得到1×1×C大小的向量.

将得到的权重分别与输入相乘,调整不同输入的重要性,增强重要信息抑制噪声,则融合上下文信息的特征Y可以表示为

最后将语义特征不一致的输入特征X′和Y经过如图2(b)所示的注意力特征融合模块,得到分配给2个输入特征图的动态融合权重 δ 和(1-δ).将2个权重与输入相乘得到融合特征Z,可以抑制不同语义特征融合导致的信息冲突问题,防止无人机小目标信息被背景噪声覆盖,其中Z可以表示为

式中:δ(X′+Y) 表示输入特征相加后经过ICBAM得到的注意力权重矩阵.

ICBAM为改进的CBAM[28],ICBAM结构如图2(c)所示.首先经过CAM得到权重 ωc,而后通过空间注意机制SAM得到注意力权重 ωs.无人机小目标的重要特征是浅层的低级信息,而非高层的语义信息,输入Z相较于经过CAM得到的特征来说,语义信息更少.因此,将得到的 ωs与输入Z相乘,再利用归一化函数得到注意力权重矩阵Zo,可以表示为

式中:S(·) 为sigmoid归一化函数.

2.2 自适应上采样

YOLOv5算法采用最近邻插值法作为上采样方式,计算量小,运算速度快,但是最近邻插值法只考虑离采样点最近的像素值,不考虑其他相邻像素点造成的影响,导致插值结果不平滑,无人机小目标特征损失较严重.为了缓解上采样过程中,目标特征丢失的问题,对上采样方式进行改进,改进后的上采样方式如图3所示.

该模块使用亚像素卷和双线性插值法作为新的上采样方式.亚像素卷积对通道像素重新排列,得到高分辨率图像,实现对特征图放大的功能,可以保证完整的信息量,计算量小.由于放大特征图尺寸会缩减通道数,且亚像素卷积的结果并不会改变上一层特征图的特征信息,即上采样后得到的特征图与backbone网络中同尺度特征图相比,仍然损失一部分重要特征信息.双线性插值考虑采样点周围4个相邻点灰度值对它的影响,能更准确还原出浅层的无人机特征信息,在一定程度上克服了采样点不连续的问题,但是计算量更大一些.为了平衡计算量,尽可能还原更多重要特征信息,将亚像素卷积和双线性插值法进行融合输出.

如图3所示,首先对输入特征X进行通道缩放,减少计算量,得到特征图X′.然后对X′分别进行亚像素卷积和双线性插值操作得到特征图U和D,具体公式如下:

式中:conv(·) 表示卷积、批量归一化以及SiLu激活函数的组合;SPconv(·) 表示亚像素卷积操作;Bilinear(·) 表示双线性插值操作.之后将U和D融合得到特征图F.

特征融合方式可以采用如图3(a)所示的加权融合或如图3(b)所示的拼接融合,即通道维度的相加或通道维度的拼接.

为了证明2种融合方式的优劣,在公共数据集VisDrone2019[29]上进行对比实验,实验结果如表1所示.表中,P为准确率,R为召回率,mAP0.5表示IoU为0.5时所有类别的平均精度;mAP0.5∶0.95表示IoU在0.50~0.95以0.05的步长变化求得的10个检测精度的平均值;GFLOPs为10亿次浮点运算,用于表示模型的复杂度;基线模型为在YOLOv5算法模型的基础上引入了MCIAFFE和SCE模块.相比于拼接融合方式,加权融合模型复杂度较小,且其他指标均有提升,因此本研究选择加权融合方式对U和D进行融合.

表1 特征融合方式对比实验Tab.1 Comparison experiments of feature fusion methods

由于亚像素卷积在进行2倍上采样时通道数会缩减4倍,须将双线性插值的输出通道通过卷积操作调整为与之相同的数量才能进行加权操作.然后经过自适应平均池化、Softmax归一化以及chunk分块函数操作,得到自适应权重 µ 和λ,得到的权重向量元素的和越大表示对应的上采样方式越重要,还原无人机小目标信息的效果更好,更能达到增强有用信息抑制背景噪声的目的.最后调整通道得到特征图Y,具体公式如下:

2.3 空间相关性增强

无人机飞行时在真实成像设备中会呈现出只有几个像素的极小目标情况.当处于颜色相似或形状相似的复杂背景下时,由于受到背景噪声的干扰,准确提取前景小目标的特征十分具有挑战性.因此,增强背景和前景的辨识度和表达能力是非常有必要的.为了提高前景目标的敏感度,提出空间相关性增强方法SCE.通过局部特征与全局特征的相关性分析,自适应增强前景的特征识别能力.如图4所示为SCE模块的结构图.

图4 空间相关性增强Fig.4 Spatial correlation enhancement

首先对输入特征通道的重要性进行评估,抑制背景噪声.然后寻找输入特征图的空间局部特征,对空间局部特征进行均值处理和重要性评估.随后对局部特征与全局特征进行相似度度量,根据相似关系对全局特征通道抑制或增强,提高目标与背景的对比度,从而提高小目标的识别能力.

如图4所示,首先对输入特征图X利用自适应平均池化和自适应最大池化进行处理,将特征映射到通道方向,然后利用归一化函数对通道重要性进行建模,得到描述全局特征的权重向量gi,则gi可以表示为

同时,对H×W×C的输入特征图沿空间方向遍历,寻找对角线上的特征表示,并对得到的空间局部特征在W维度进行对齐,得到C×1×W的特征表达.随后对其进行一维卷积处理提取特征,得到空间局部特征表达H.

式中:ϕ(·) 表示查找函数,用于在空间方向寻找局部特征;φ(·) 表示对齐函数,将寻找的局部特征在W维度对齐;conv1d3表示卷积核为3的一维卷积,用于提取特征.

为了保证局部特征与全局特征在维度上保持一致,将H上的特征沿W维度映射,采用沿W维度取均值操作,得到大小为C×1×1 的特征向量.然后对其进行归一化处理,得到描述空间局部特征的权重向量表达ki,表达式如下:

式中:Pmn(·) 表示取均值 函数.

将全局特征的权重向量gi和局部特征的向量表达ki进行相似度度量,得到描述局部特征和全局特征的相关性向量Pi:

将相关性向量叠加到全局特征向量表达gi,并作用到输入特征图X上,达到增强目标抑制背景的目的,提高目标区域的敏感度,更有利于从复杂背景中准确提取目标特征.

3 实验与分析

3.1 数据集与实验环境介绍

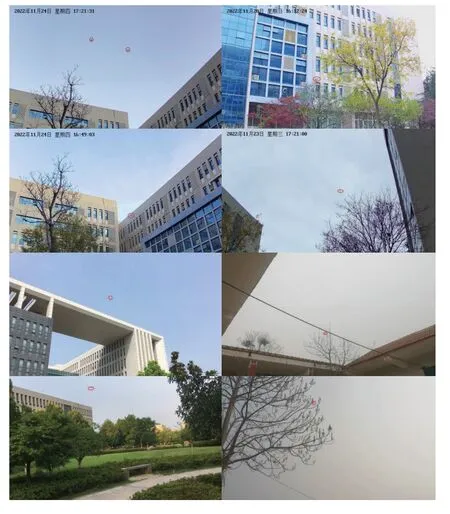

实验在自制无人机数据集和VisDrone2019数据集上进行测试.自制无人机数据集制作如下:采用海康威视摄像头拍摄DJIMINISE无人机在不同场景下不同背景的飞行视频,对视频图像进行剪裁处理,并从网上收集部分无人机图片,随后将所有图像划分为训练集、验证集和测试集,并进行人工标注.自建无人机数据集共有5 869张训练图像、1 218张验证图像和2 765张测试图片.如图5所示为自制无人机数据集中的样本图像.对数据集中的目标边界框尺度情况进行统计,结果如表2所示.表中,Aa表示目标框面积与图像面积的比值区间,φn表示目标框(或边界框)处于Aa区间内的数量百分比.

表2 不同尺度下的边界框统计Tab.2 Statistics of bounding boxes at different scales

图5 自制无人机数据集的样本图像Fig.5 Sample images from self-made UAV dataset

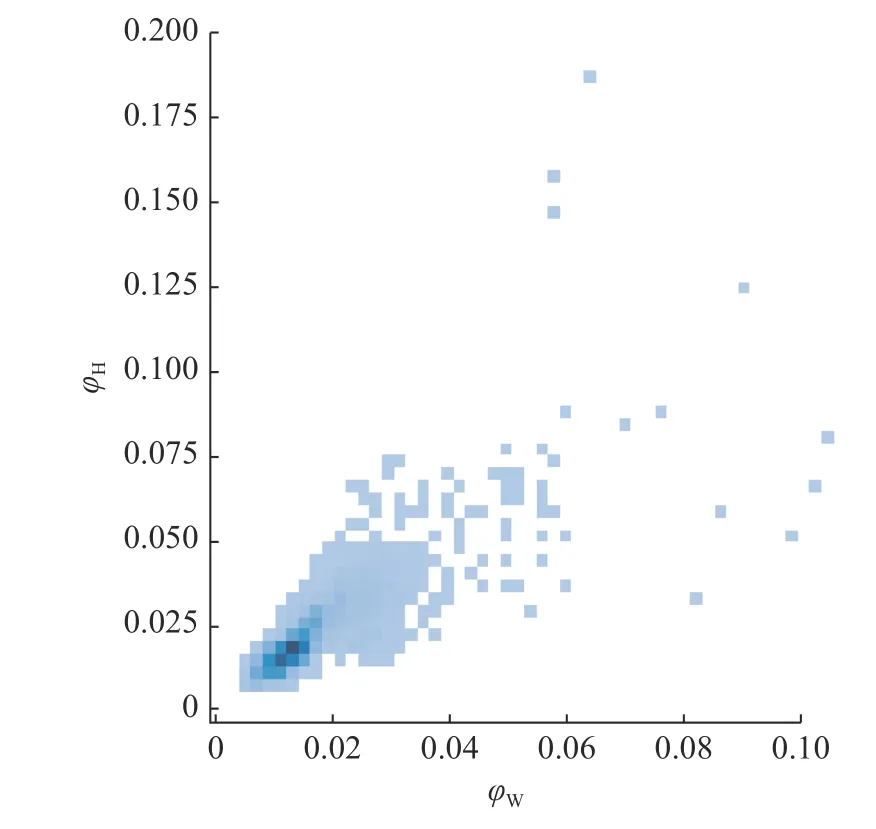

如图6所示为自建数据集中所有无人机标签大小的分布图.图中,φH、φW分别表示无人机真实框的宽度和高度所占比例.可以看出,几乎所有图像中无人机的宽度和高度所占比例均小于0.1,符合实际场景下无人机飞行时成像比例的一般情况.

图6 自制无人机数据集中无人机标签大小的分布图Fig.6 Distribution of UAV label size of self-made UAV dataset

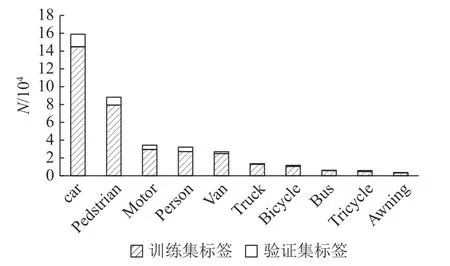

VisDrone2019数据集包含大量的密集小目标对象,共有6 471张训练图片,548张验证图片和1 580张测试图片,包含10个类别.如图7所示为训练集和验证集中每个类别标签的分布情况.图中,N为目标框的数量.

图7 VisDrone 2019数据集中训练集和验证集中每个类别的标签分布情况Fig.7 Distribution of labels of each category in train set and validation set of VisDrone 2019 dataset

采用Win10操作系统、基于pytorch框架的YOLOv5目标检测模型,在显卡为NVIDIA Ge-Force RTX 3080、torch 1.11.0、内存16 G、CUDA 11.5、显存10 G的环境上进行实验.其中,batchsize设为12,输入图像尺寸为640×640,采用余弦退火学习率调整策略、Adam优化器和mosaic数据增强策略,具体超参数采用算法默认值.采用准确率P、召回率R、mAP0.5、mAP0.5∶0.95、GFLOPs、FPS等指标作为模型的评价指标.其中,FPS为帧率,衡量模型的实时性能.

3.2 消融实验

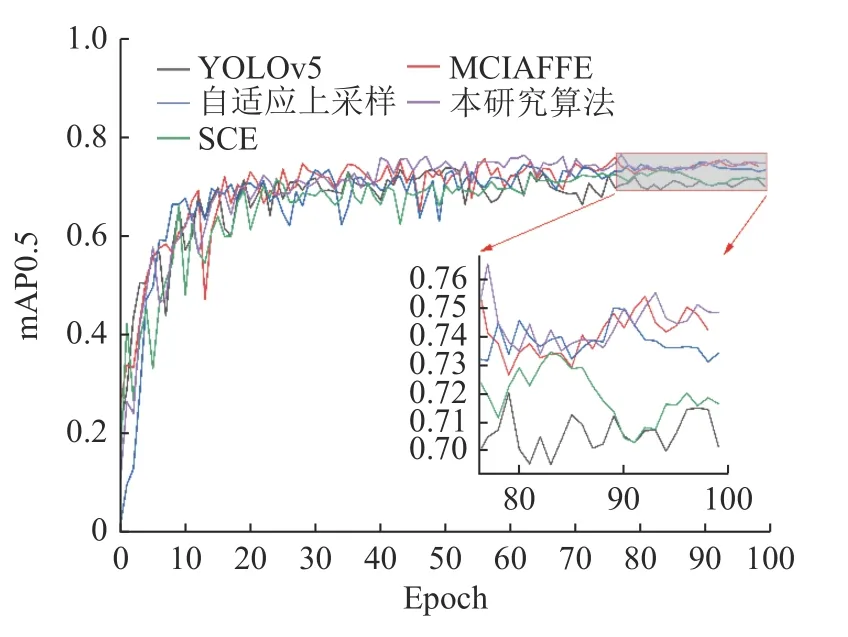

为了验证所提出的多尺度上下文信息和注意力特征融合增强模块、自适应上采样方式和空间相关性增强模块的有效性,在原始YOLOv5模型下依次加入各个模块进行消融实验,在自制数据集上训练并进行验证,训练100个epoch的结果如表3所示,训练过程中各个模块的mAP0.5变化如图8所示.

表3 自制无人机数据集上的消融实验结果Tab.3 Results of ablation experiments of self-made UAV dataset

图8 训练过程中mAP0.5的变化过程Fig.8 Change process of mAP0.5 during training

消融实验结果表明,与原始YOLOv5模型在自制无人机数据集上的训练参数相比,所提出的算法可以显著提高无人机目标检测性能.如表3所示,在原始YOLOv5中加入MCIAFFE后,算法各项指标得到提升,其中P提高了0.8%,R提高了2.9%,mAP0.5和mAP0.5∶0.95分别提高了2.7%和2.2%,证明上下文信息中含有丰富的无人机小目标信息;当加入自适应上采样后,P提高了0.6%,R提高了1.3%,mAP0.5和mAP0.5∶0.95分别提高了0.1%和2.0%,表明新的上采样方法可以还原更多的小目标位置和细节信息;加入SCE模块后,P和R分别提高了0.3%和1.2%,mAP0.5∶0.95提高了0.3%,由此可知,空间相关性增强模块可以增强复杂背景中目标与背景的辨识度,并提高特征识别能力.

由表3可知,所提出的算法相对于原始模型,P提高了1.6%,R提高了4.3%,mAP0.5和mAP0.5∶0.95分别提高了2.4%和2.7%,且检测速度依然能够达到58.5帧/s.由于实时检测要求检测帧率大于25帧/s,所提算法仍然满足实时性的要求.由图8可以看出,当训练过程趋于稳定后,所提算法的mAP0.5始终高于原始模型的.由此可见,所提算法能有效减少无人机目标在特征提取过程中造成的信息丢失,融合浅层重要的细节和位置信息,同时增强目标与背景的对比度,从而提高特征识别能力和无人机小目标的检测能力.

综上所述,在无人机数据集上训练时,加入所提算法,可以显著提高无人机检测的性能指标参数.

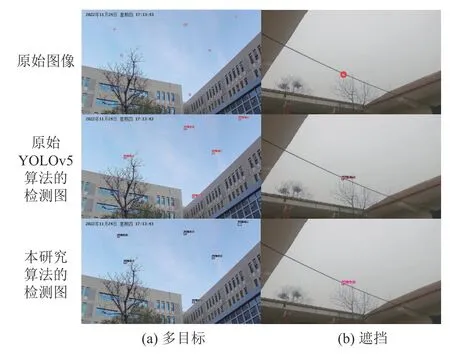

为了更直观地看出所提算法的检测性能,从自制无人机数据集中选取多目标和遮挡条件下的2幅图像,并用原始YOLOv5算法和本研究改进算法分别检测,结果如图9所示,图中从上到下分别为原始图像、原始YOLOv5算法的检测图、本研究改进算法的检测图.

图9 YOLOv5和本研究所提算法的检测结果对比Fig.9 Comparison of detection results between YOLOv5 and proposed algorithm

由图9(a)可以看出,原始YOLOv5算法对于极小尺寸的多无人机目标存在漏检的情况,且对于在特征相似的树枝背景下的无人机目标,准确率只有56%,而所提算法不仅解决了极小目标漏检的情况,检测准确率也大大提高,尤其对于相似特征背景下的无人机检测,准确率达到了80%.如图9(b)所示,在背景特征相似、目标被遮挡的情况下,所提算法的检测精度也高出原始YOLOv5算法6%.由图9的检测对比结果可知,所提算法提高了极小尺寸无人机目标的检测准确率,同时提高了复杂背景下小目标的特征提取能力.

3.3 对比实验

为了验证所提算法在无人机小目标检测方面具有良好的性能,在自制数据集上将所提算法与目前主流检测算法进行对比,结果如表4所示.可以看出,所提算法在几种经典的通用目标检测算法当中具有良好的检测性能,其中相比于SSD算法,mAP0.5提高27.5%;相比于Refinedet算法,mAP0.5提高了12.6%;相比于YOLOv4算法,mAP0.5和mAP0.5∶0.95分别提高了11.7%和13.7%;与YOLOv5相比,mAP0.5和mAP0.5∶0.95也有2.4%和2.7%的提高;与先进的改进通用目标检测算法相比,也表现出良好的性能,相比于Edgeyolo[31],所提算法的mAP0.5和mAP0.5∶0.95分别提高了13%和8%;与ScaledYOLOv4[32]相比,本研究算法依然具有更好的检测能力,其中P、R、mAP0.5和mAP0.5∶0.95分别提高了1.5%,1.6%,3.6%和1.8%.与其他小目标检测算法相比,所提算法也表现更好,如与MDSSD[33]相比,mAP0.5提高了16.8%,与SuperYOLO[34]相比,所提算法的P、R、mAP0.5和mAP0.5∶0.95分别提高了5.8%、2.9%、0.6%和0.9%.

表4 不同检测方法在自制无人机数据集上的实验结果Tab.4 Experimental results of different detection methods on self-made UAV dataset

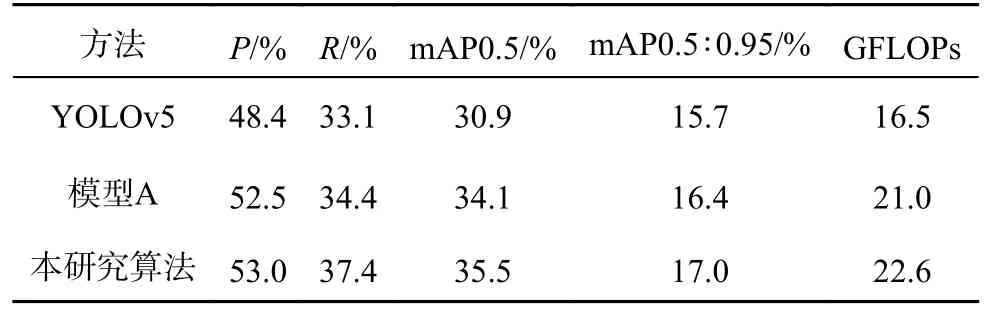

为了进一步验证本研究算法的有效性,在公共数据集VisDrone2019上进行实验,并与原始YOLOv5目标检测模型进行对比,实验结果如表5所示.表中,模型A为3.2节中提到的基线模型,即在YOLOv5算法上引入了MCIAFFE和SCE.可以看出,本研究提出的改进算法在Vis-Drone2019数据集上依然具有良好的性能,具体表现为:mAP0.5比原始YOLOv5模型提高了4.6%,mAP0.5∶0.95提高了1.3%,P和R分别具有4.6%和4.3%的提升,其中相对于模型A来说,替换本研究提出的上采样方式后,GFLOPs仅增加了1.6,且其他指标均略有上升.

表5 VisDrone2019数据集上的检测结果Tab.5 Detection results on VisDrone2019 dataset

如表6所示为所提算法与原始YOLOv5算法在VisDrone2019数据集上各个类别的mAP0.5.表中,Δ 为本研究算法相对于YOLOv5算法在mAP0.5上的提升.可以看出,所提算法对于所有类别均有不同程度的提升效果,其中对类别pedestrian、car和bus具有极为明显的提升,说明所提算法不仅对于无人机小目标具有良好的检测效果,对于其他目标依然具有较强的检测能力.

表6 VisDrone2019数据集上各个类别的mAP0.5Tab.6 mAP0.5 of each category on VisDrone2019 dataset

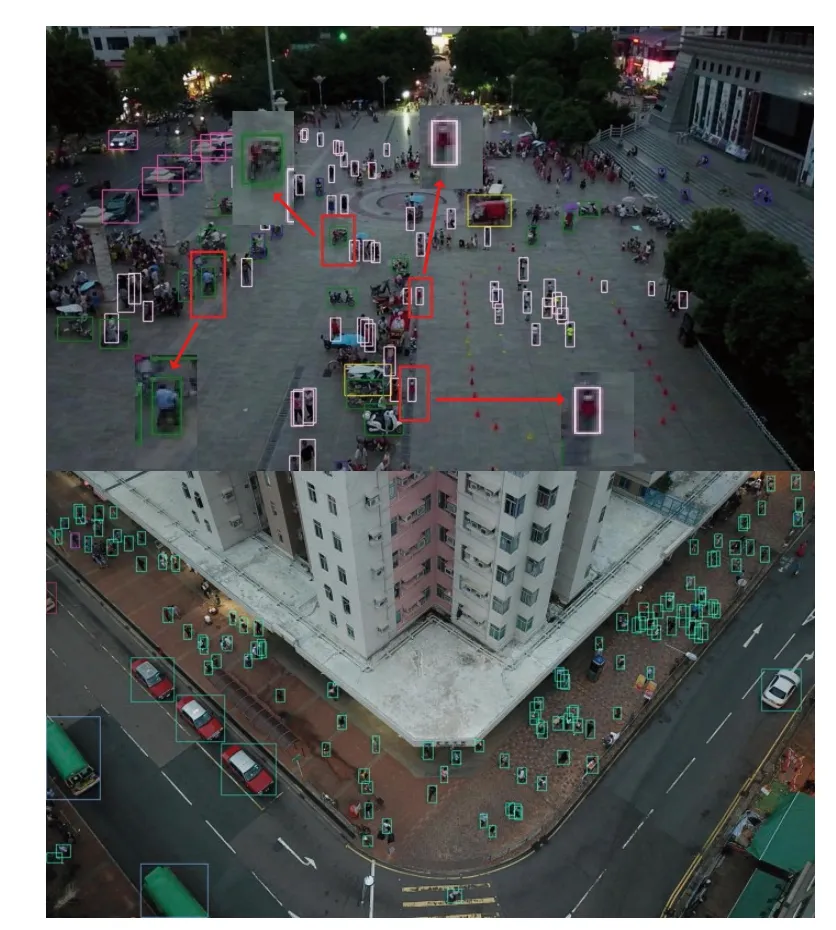

为了验证本研究算法在复杂场景中对密集目标的检测效果,从VisDrone2019数据集中的挑战性测试集中选取检测困难的2张图像进行可视化检测,结果如图10所示.可以看出,所提算法对于密集遮挡小目标依然具有良好的检测能力,能准确识别绝大多数目标.但是在模糊光线导致图像分辨力下降的场景中所提算法发生了误识别情况,如第1张图片中将左侧的pedestrian和中间的tricycle误识别为bicycle,将右侧的2个路障误识别为pedestrian.在光线条件较好的场景下,如第2张图片中,所提算法能够准确检测到被遮挡的密集行人,具有良好的性能.对模糊场景下的密集小目标的检测不可避免的存在误检情况,如何进一步优化算法网络是减小误检的关键.

图10 挑战性测试集检测结果Fig.10 Detection results on challenge testset

4 结语

为了提高无人机的检测效果,提出基于自适应上采样和空间相关性增强的无人机小目标检测算法.首先通过多尺度空洞卷积融合浅层重要特征,并采用改进CBAM的注意力特征融合模块抑制融合时的信息冲突;其次,提出基于自适应融合的上采样方式,更准确地还原低级特征同时平衡计算量;最后,提出空间相关性增强模块,通过局部特征和全局特征的相关性提高目标与背景的对比度,增强复杂背景下小目标特征提取的能力.在自制无人机数据集上进行实验,所提算法的mAP0.5和mAP0.5∶0.95分别为76.1%和32.5%,检测速度为58.5帧/s;在VisDrone2019数据集上,mAP0.5和mAP0.5∶0.95分别提高到35.5%和17.0%.实验结果表明,本研究所提算法在显著提高检测性能的同时保证了实时性.但是本研究算法仍有不足,未来将考虑对网络进一步优化以降低模糊场景下目标的误检率,同时引入剪枝操作对模型进行轻量化处理,保证算法性能并减小模型大小.