关于非齐次树上连续马氏信源熵密度的若干强偏差定理

关于非齐次树上连续马氏信源熵密度的若干强偏差定理

金少华1,赵玉姝1,闫会强2,宛艳萍3

(1.河北工业大学理学院,天津300401;2. 河北工业大学经济管理学院,天津300401;

3.河北工业大学计算机科学与软件学院,天津300401)

[摘要]树指标随机过程已成为近年来发展起来的概率论的研究方向之一.强偏差定理一直是国际概率论界研究的中心课题之一.本文通过构造适当的非负鞅,将Doob 鞅收敛定理应用于几乎处处收敛的研究,研究给出了一类非齐次树上连续马氏信源熵密度的若干强偏差定理.

[关键词]非齐次树; 鞅; 马氏信源; 强偏差定理

[收稿日期]2015-03-30

[基金项目]河北省高等学校科学技术研究重点项目(ZD2014051)

[中图分类号]O177.91[文献标识码]A

1前言

树指标随机过程已成为近年来发展起来的概率论的研究方向之一.强偏差定理一直是国际概率论界研究的中心课题之一.Shi和Yang[1]研究给出了m根Cayley 树指标m阶有限状态非齐次Markov链的一些极限性质. 文献[2]研究给出了Bethe树上非齐次马尔科夫随机场的一类强偏差定理.本文通过构造适当的非负鞅,将Doob 鞅收敛定理应用于几乎处处收敛的研究, 研究给出了一类非齐次树上连续马氏信源熵密度的若干强偏差定理.

2定义

设T是一个具有根顶点o的无限树,{Nn, n≥1}是一列正整数集,如果第n (n≥0)层上的每个顶点均与第n+1层上的Nn+1个顶点相邻,则称T为广义Bethe树或广义Cayley树.特别地,若对非负整数集N,用模m的同余关系对其分类得到模m的剩余类

(0)={0,m,2m,3m,…,nm,…},

(1)={1,m+1,2m+1,3m+1,…,nm+1,…},

……………………

(m-1)={m-1,2m-1,3m-1,…,(n+1)m-1,…},

当n∈(i)时,令

Nn+1=αi(αi均为正整数且不同时为1),i=0,1,2,…,m-1,

就得到了一类特殊的非齐次树Tα0,α1,…αm-1.以下恒以T表示树Tα0,α1,…αm-1,以Ln表示第n (n≥0)层上所有顶点的子图,Tn表示含有从o顶点到第n层上所有顶点的子图.

定义2.1设{Xσ,σ∈T}是定义在概率空间{Ω,F,P}上的取值于连续状态(+,β(+))的任意信源,其联合密度函数为

f(XTn=xTn)=f(xTn).

(1)

设

{P(X0,1∈A)},A∈β(+)

(2)

是{Xσ,σ∈T}的初始分布,并有正则条件概率族

P(σ,S(σ);Xσ,A)=E[IA(XS(σ))|Xσ],∀Xσ∈+, A∈B(+).

(3)

若

P(σ,S(σ);Xσ,A)=∫Af(σ,S(σ);Xσ,XS(σ))dXS(σ),

(4)

则称f(σ,S(σ);Xσ,XS(σ))为转移密度函数,记

f(σ,S(σ);Xσ,XS(σ))=fS(σ)(Xσ,XS(σ)).

(5)

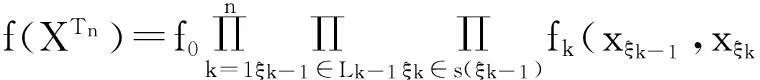

设fS(σ)(Xσ,XS(σ))是{Xσ,σ∈T}的一列转移密度函数,初始分布对应的概率密度函数记为f0,则称{Xσ,σ∈T}为具有初始分布(2)与正则条件概率族(3)的在+上取值的连续状态树指标非齐次马氏信源.则{Xσ,σ∈T}的联合密度函数为

(6)

设Q是(Ω,F)上的另一概率测度,{Xσ,σ∈T}在Q下的联合密度函数为

(7)

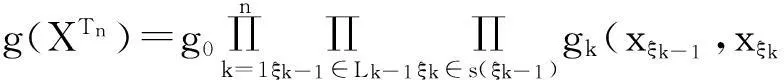

定义2.2设联合密度函数f(XTn),g(XTn)均如前定义,令

(8)

称φ(ω)为Q相对于P的样本散度.

定义2.3设λ为一实数,{hk(x)}是定义在+上的一函数列,称

(9)

为函数hk(Xξk)的Laplace变换.

3主要结果及其证明

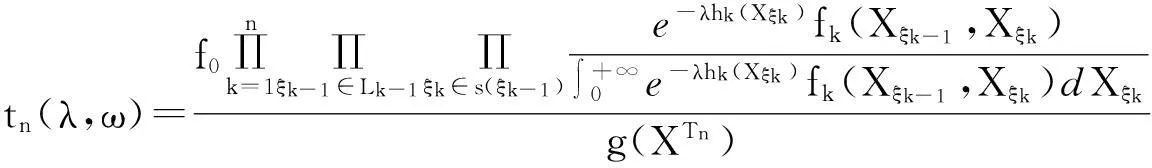

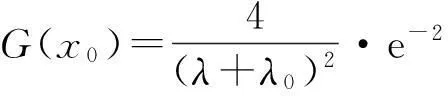

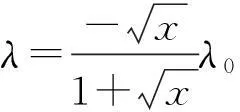

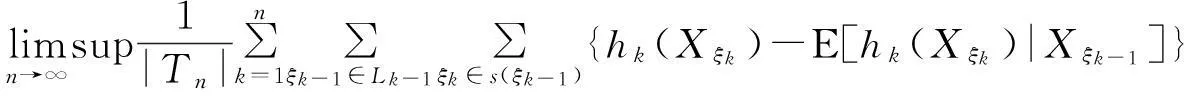

引理3.1设{Xσ,σ∈T}为定义在概率空间(Ω,F,P)上取值于连续状态(+,β(+))的任意信源,其联合密度函数由(1)式给出.f(XTn),g(XTn)与hk(x)均如前定义,φ(ω)如(8)式定义.令

(10)

则{tn(λ,ω),σ(XTn),n≥1}在测度Q下为一非负鞅.

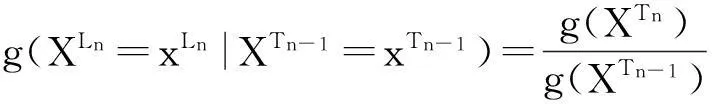

证由(7)式,有

(11)

由(10)式,有

tn(λ,ω)=tn-1(λ,ω)·In,

(12)

其中

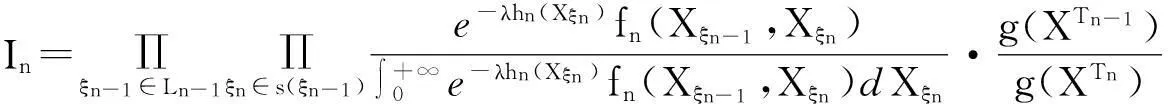

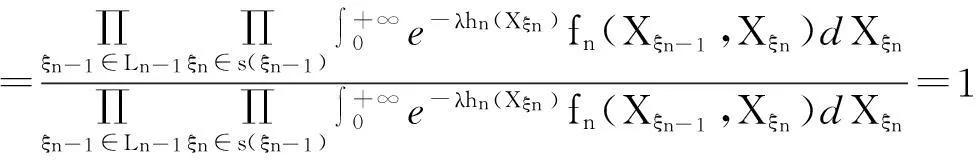

(13)

而

(14)

由(14)式,有

E[tn(λ,ω)|σ(XTn-1)]=tn-1(λ,ω),

所以{tn(λ,ω),σ(XTn),n≥1}在测度Q下为一非负鞅.

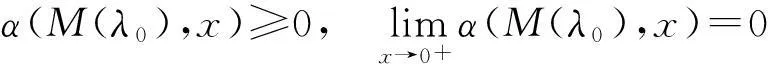

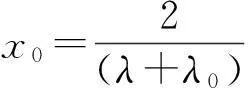

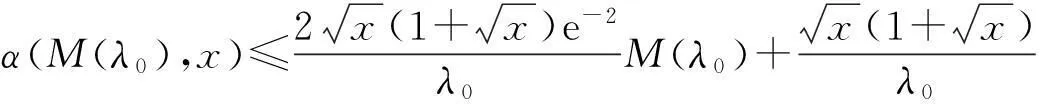

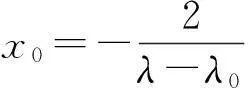

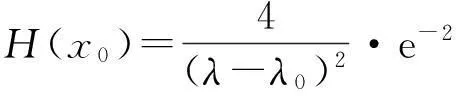

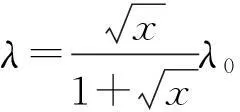

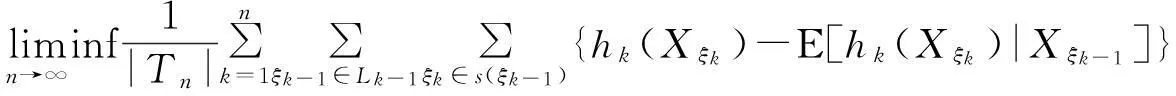

定理3.1设{Xσ,σ∈T}为定义在概率空间(Ω,F,P)上取值于连续状态(+,β(+))的任意信源,其联合密度函数由(1)式给出.φ(ω)和hk(x)如前定义.若存在λ0>0,使得当λ∈[-λ0,λ0]时,(λ)有定义.令D={ω:φ(ω)<+∞}.若

(15)

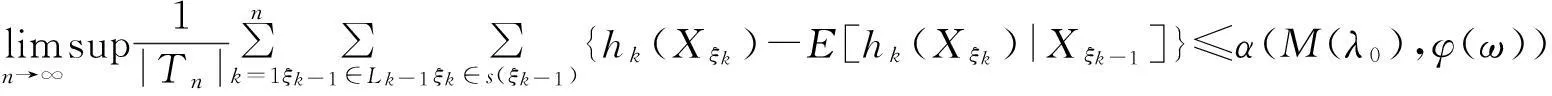

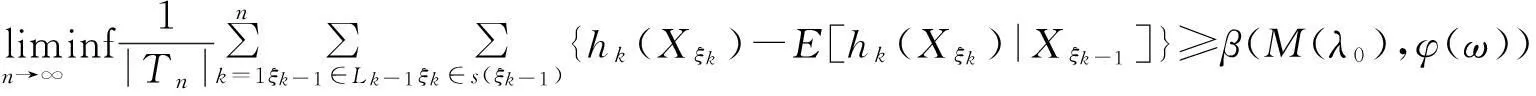

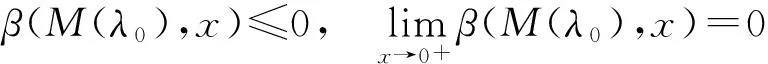

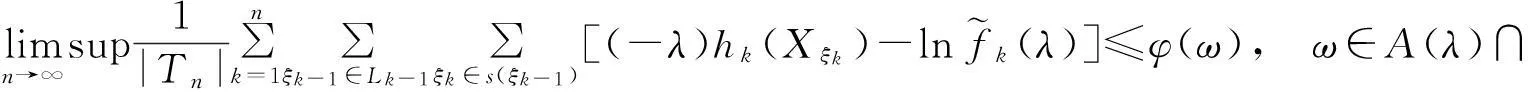

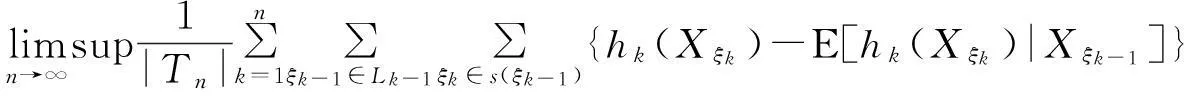

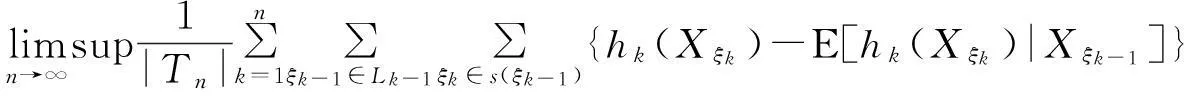

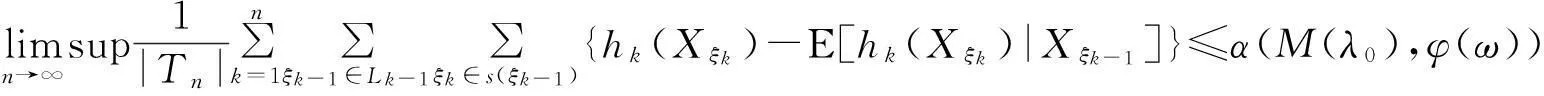

则

(16)

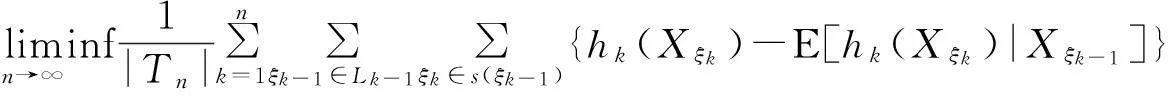

(17)

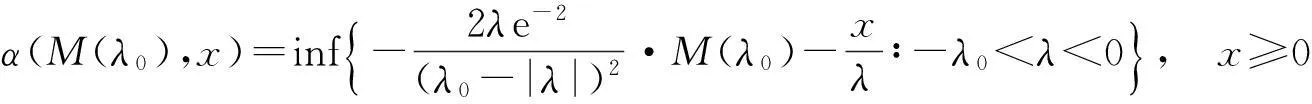

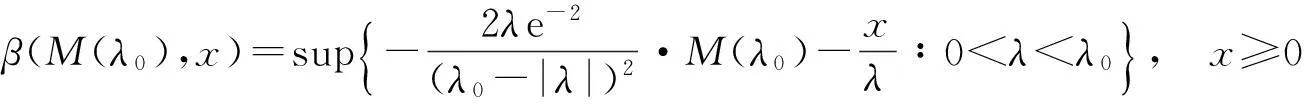

其中

(18)

(19)

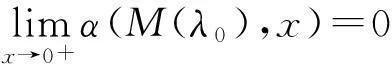

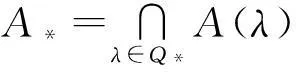

并且

(20)

(21)

证根据引理3.1及Doob鞅收敛定理,存在A(λ)∈F且P(A(λ))=1,使得

(22)

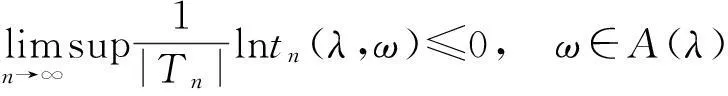

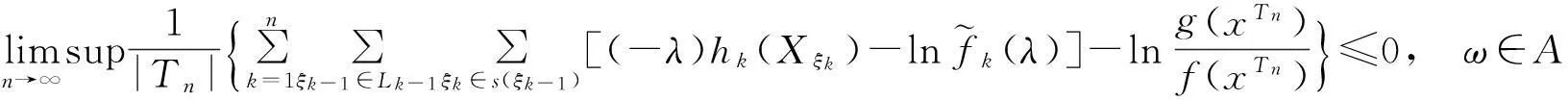

由(10)式和(22)式,对任意的λ∈[-λ0,λ0],有

(23)

于是由(8)式和(23)式,有

(24)

在(24)中取λ=0,有

φ(ω)≥0,ω∈A(0)∩D.

(25)

(26)

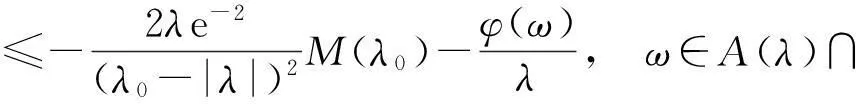

有

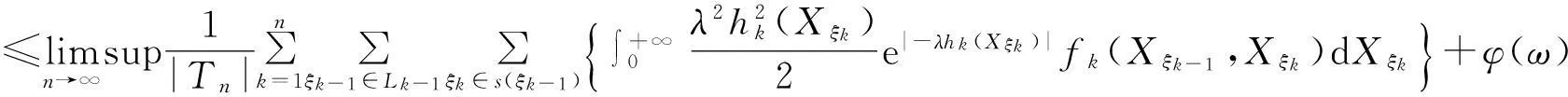

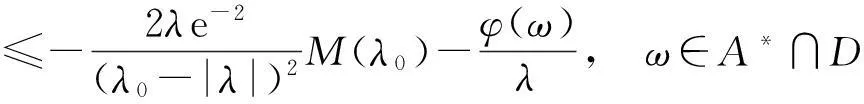

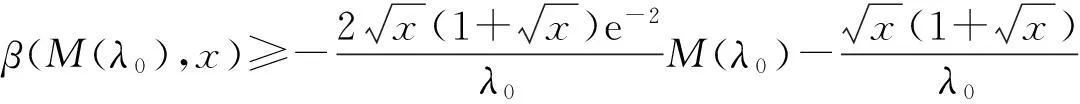

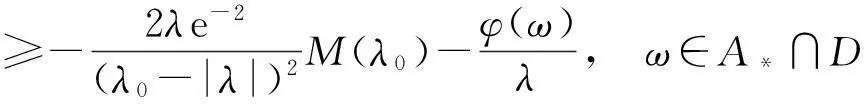

ω∈A(λ)∩D.(27)

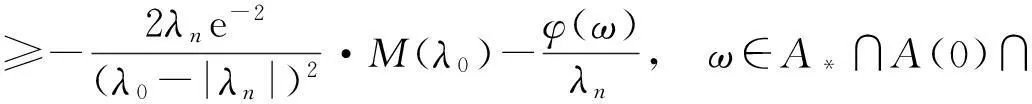

当-λ0<λ<0时,将(27)式两边同除以-λ,有

ω∈A(λ)∩D.

(28)

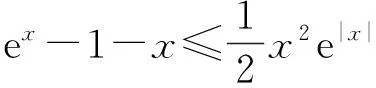

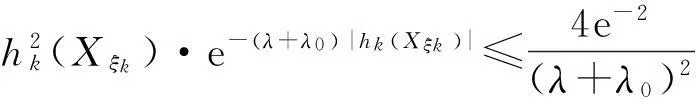

(29)

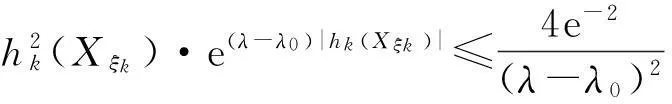

由于|hk(Xξk)|∈[0,+∞),则由(29)式,有

(30)

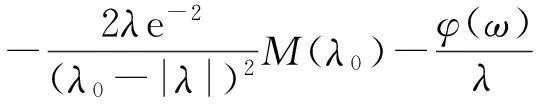

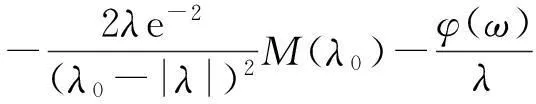

由(28)式及(30)式,有

(31)

(32)

(33)

(34)

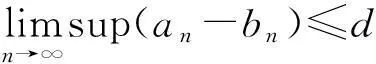

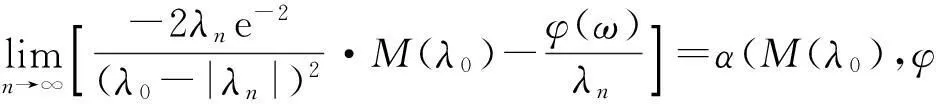

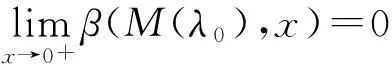

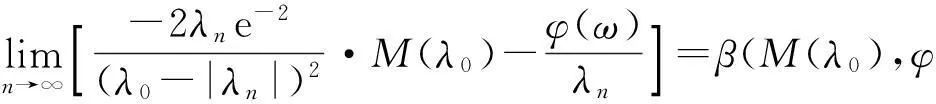

由(33)式,有

(35)

由(34)式和(35)式,有

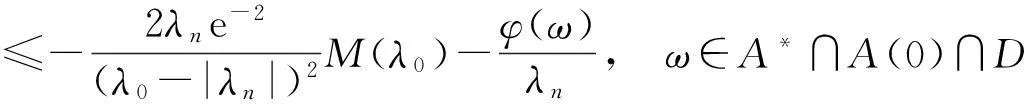

ω∈A*∩A(0)∩D.

(36)

因为P(A*∩A(0))=1,故由(36)式,有(16)式成立.

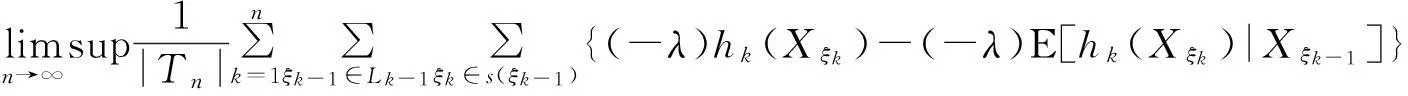

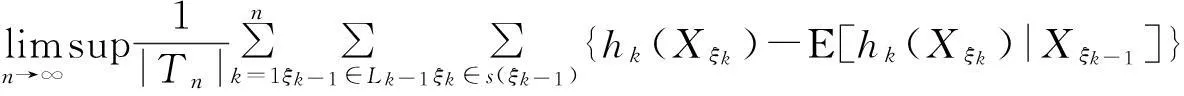

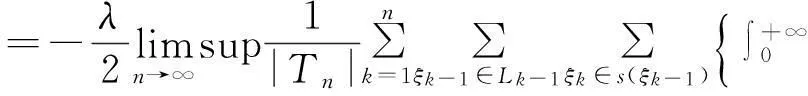

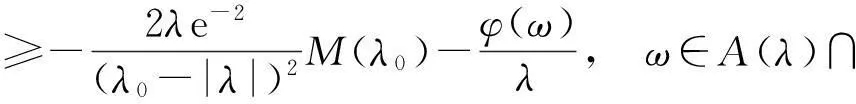

当0<λ<λ0时,将(27)式两边同除以-λ,有

ω∈A(λ)∩D.

(37)

(38)

由于|hk(Xξk)|∈[0,+∞),则由(38)式,有

(39)

由(37)式及(39)式,有

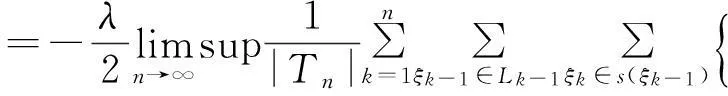

(40)

(41)

(42)

(43)

由(42)式,有

(44)

由(43)式和(44)式,有

(45)

因为P(A*∩A(0))=1,故由(45)式,有(17)式成立.

[参考文献]

[1]Shi Z Y, Yang W G. Some limit properties for them-th-order non-homogeneous Markov chains indexed by anmrooted Cayley tree [J]. Statistics & Probability Letters, 2010, 80(15): 1223-1233.

[2]Yang W G. A class of deviation theorems for the random fields associated with non-homogeneous Markov chains indexed by a Bethe tree [J]. Stochastic Analysis and Applications, 2012, 30(2):220-237.

A Class of Strong Deviation Theorems of the Entropy Density

of Continuous Markov Information Source on a Non-Homogeneous Tree

JINShao-hua1,ZHAOYu-shu1,YANHui-qiang2,WANYan-ping3

(1. College of Science, Hebei University of Technology, Tianjin 300401,China;

2. College of Economics and Business Administration, Hebei University of Technology, Tianjin 300401,China;

3.School of Computer and Engineering, Hebei University of Technology, Tianjin 300401,China)

Abstract:In recent years, tree indexed stochastic process has become one of the hot topics in probability theory . The strong deviation theorem has been one of the central issues of the international probability theory. In this paper, through constructing a non-negative martingale and applies Doob’s martingale convergence theorem to the research of a.e. convergence, a class of strong deviation theorems of the entropy density of continuous Markov information source on a non-homogeneous tree are given.

Key words: non-homogeneous tree; martingale; Markov information source; strong deviation theorem