增强现实技术综述

侯 颖,许威威

(杭州师范大学 杭州国际服务工程学院计算机系,杭州 311000)

增强现实技术综述

侯 颖,许威威

(杭州师范大学 杭州国际服务工程学院计算机系,杭州 311000)

增强现实技术是将计算机渲染生成的虚拟场景与真实世界中的场景无缝融合起来的一种技术,它通过视频显示设备将虚实融合的场景呈现给用户,使人们与计算机之间的交互更加的自然,同时具有广泛的应用前景,因此成为近年来的一个研究热点;随着跟踪注册技术的进步、计算机性能的飞速发展、深度摄像机的普及,以及Light Field投影技术在增强现实中的应用,增强现实技术逐渐成为下一代人机交互的发展方向;该文章首先概述了增强现实的主要研究内容和发展情况,并详细介绍了增强现实的关键技术、开发工具,然后分类概述了增强现实应用案例。

增强现实技术;跟踪注册技术;投影技术

0 引言

增强现实技术[1]的目标是将计算机生成的虚拟物体、场景或系统提示信息叠加到真实场景中,从而实现对现实场景的增强。该技术能够将虚拟信息应用到真实世界,通过计算机系统提供的信息有效提高用户对现实世界的感知能力和交互体验,因而受到了研究人员的高度关注。在1966年,Ivan Sutherland发明了头盔显示器,并在1968年使用光学透视式头盔显示器创建了第一个增强现实系统,同时也是第一个虚拟现实系统[2]。它通过两个6自由度的跟踪器进行跟踪注册:一个机械式跟踪器和一个超声波跟踪器。由于当时计算机处理性能的限制,只能实时显示非常简单的线框模型。近年来随着计算机图形图像及便携头戴式显示器等关键技术的发展,增强现实技术的实用性显著增强,出现了一系列代表性产品,包括谷歌眼镜、微软Hololens、国产蚁视眼镜等。因此,增强现实技术成为了当前计算机图形图像处理领域的研究热点。

目前对于增强现实有两种被广泛接受的定义。第一种定义是,1994年Paul Milgram和Fumio Kishino提出的“现实-虚拟连续体”[3]。它描述的是如何对虚拟物体和真实相结合的显示环境进行分类。真实环境和虚拟环境分布在两端,在这两者之间接近真实环境的是增强现实,接近虚拟环境的是增强虚拟,而位于中间的部分叫做混合实景。

第二种定义是1997年北卡大学的Ronald Azuma提出[4]。他认为增强现实技术应具有三个具体特征:1)虚实结合。增强现实没有完全取代现实环境,反而更依赖于现实世界,它依靠计算机技术构建出图片、视频、三维模型等和物理世界相结合,让物理世界和虚拟对象合为一体;2)三维注册。增强现实实时的跟踪相机的姿态计算出相机影像的位置及虚拟图像在真实场景中的注册位置,以实现虚拟场景和真实场景的完全融合[5];3)实时交互。它是指用户能够通过现实世界获取的信息及时的获取相应的反馈信息。

虽然增强现实是从虚拟现实中脱胎出来,但是它与虚拟现实有很大的不同。虚拟现实是通过模拟虚拟的世界使用户能够沉浸其中[6]。增强现实则是将虚拟物体带入真实世界中,将两者叠加在一个空间来实现对真实世界的“增强”[7]。随着科技的发展,增强现实越来越贴近人们的生活,不仅成为近年来国外众多知名大学和研究机构的研究热点之一,在医疗、教育、军事、工业、广告、游戏和旅游等领域都有更为广泛的应用。

本文主要概述了增强现实的关键技术,包括跟踪注册技术,显示技术以及智能交互技术。着重强调了这几年出现的最新的增强现实技术,如离线渲染技术,进而简要的列举了增强现实领域相关的开发工具,并对增强现实的应用领域做了总结。最后对增强现实技术将来的发展情况做了简单的预测。

1 增强现实的关键技术

增强现实技术是在计算机图形学,计算机图像处理,机器学习能基础上发展起来的[8]。它将原本在真实世界中的实体信息,通过一些计算机技术叠加到真实世界中来被人类感官所感知,从而达到超越现实的感官体验。为了使用户能够真实的与虚拟物体交互,增强现实系统必须要提供高帧率、高分辨率的虚拟场景,跟踪定位设备和交互感应设备[9]。因此,跟踪注册技术和系统显示技术是增强现实技术的基础。

1.1 跟踪注册技术

跟踪注册技术根据跟踪的对象可以简单的分为两类:1)把摄像机作为跟踪对象,如基于硬件传感器的跟踪技术和基于计算机视觉的跟踪技术。基于硬件传感器的跟踪技术通过手机等便携设备获取设备的位置、移动信息,从而达到跟踪注册的目的[10];基于计算机视觉的跟踪技术使用摄像机获取真实场景的图像,利用机器视觉的相关算法将虚拟物体与真实场景融合在同一个视频图像中。2)把人作为跟踪对象。即以人自己本身的信息或者人周边的信息作为被跟踪对象。例如,基于深度摄像机的跟踪注册技术可以识别并跟踪人体骨骼、人体周边物体的信息,从而对人体周边的环境做简单的建模并加载虚拟场景。

1.1.1 基于硬件传感器的跟踪注册技术

基于硬件传感器的跟踪注册技术通过传感器的信号发送器和感知器来获取到相关位置数据,进而计算出摄像机或智能设备相对于真实世界的姿态。基于硬件的三维注册技术有很多种,下面主要介绍其中的三种,即GPS全球定位系统、惯性导航系统和磁感应传感器跟踪注册技术。

GPS全球定位系统。它用在大规模的户外增强显示系统中来确定用户的地理位置[11],将获得的定位数据通过移动通信模块(gsm/gprs网络)上传至网络上的某台服务器从而可以在智能设备上查询位置。由于GPS的定位精度一般为1米到15米左右,精度不够,所以在实际中,我们只将它的定位数据作为一个粗略的初始位置,再使用其他跟踪注册算法来实现更加精确的三维跟踪[12]。

陀螺仪,它用于测定用户智能设备转动的角度以及运动的三维角速度。像陀螺仪这类的惯性跟踪器一般只能简单测量智能设备的运动模式,所以经常和加速传感器配合使用。加速传感器通过惯性原理来测定使用者的运动加速度,它和惯性跟踪器一同使用构成惯性导航定位系统,并通过这个惯性导航定位系统来测定智能设备的方位和速度,这种方法定位精度高,同时抗干扰能力强。户外增强显示系统一般使用GPS定位负责粗略的定位地理位置,惯性导航系统负责估计智能设备的姿态,但是它也有一定的缺点,在使用一段时间后各种传感器之间的数据交互会产生累积误差。

磁感应传感器,它是增强现实领域运用较为广泛的一种位置姿态测量装置。它能够通过线圈电流的大小来计算交互设备与人造磁场中心点的距离以及方向,此外它还可以通过地球的磁场来判断设备的运动方位。但是有一个明显的缺点是容易收到其他磁场的影响,并且跟踪的范围有一定的局限性。所以如果磁场强度较弱,它跟踪的精确度就会大大降低[13]。

1.1.2 基于计算机视觉的跟踪技术

根据是否采用人工标记物将基于计算机视觉的跟踪技术分为带标记跟踪和不带标记跟踪,我们主要对带标记跟踪进行分析,带标记跟踪技术又可以根据标记物的特点分为强标记[14-15]和弱标记跟踪两类。

1)基于强标记的跟踪技术:

基于强标记的跟踪注册技术需要在真实场景中事先放置一个标识物作为识别标记。使用标示物的目的是为了能够快速的在复杂的真实场景中检测出标识物的存在,然后在标识物所在的空间上注册虚拟场景。

一般的检测中使用的标记物非常简单,标记物可能是一个只有黑白两色的矩形方块,或者是一种具有特殊几何形状的人工标志物[16],如图1所示[17]。标记物上的图案包含着不同的虚拟物体,不同的标记物所含的信息也不相同,提取标记物的方法也不相同,所以应合理和选取人工标识物来提高识别结果的准确性。

图1 人工标志图

假设只考虑最简单的一种情况——将单个的人工标志放在白色的背景中。通过对图像做阈值化[18]和边缘检测[19]将人工标记物的边缘提取出来,再采用Hough变换得到四条边所在的直线,进而计算相邻直线的交点坐标,获取标志物顶点的图像坐标[20]。

为了把三维模型放置在真实场景中,我们需要知道匹配好的模版在真实世界中与摄像机的相对位置。我们使用一个投影变换来表示这个相对位置。标记物在三维空间中的位置和它在二维画面中的投影的关系式如下:

p=K[R|t]M

M为三维空间中的任一点的坐标;[R|t]为4*3的矩阵,表示一个欧氏变换;K为摄像机矩阵的内参矩阵,表示摄像机镜头的焦距等内参;p为三维空间任一点在二维屏幕上的投影的坐标,具体公式如下:

在强标记的增强现实系统,一般是在模版匹配结束后,计算出旋转与平移矩阵[R|t],得出外部参数,从而得到二维屏幕上的标记物的4个角点的坐标(如图2)[17]。

之后,我们再根据真实空间的四个角点的三维坐标和在屏幕上的投影,在恰当的位置渲染三维模型,如图3所示[20]。

图3 强标记的增强现实效果

2)基于弱标记的跟踪技术:

弱标记的标记物都是具有自然特征的图片[21]。由于标记物的模版被部分重叠依旧可以工作,所以它的模版没有严格的限制,可以采用任意的形状和纹理。虽然弱标记跟踪技术标记物模版的选取较为方便,但其模版图片却十分复杂。因为自然特征的标识物特征点的检测,提取和筛选较为复杂,需要很大的运算量,而现有的智能设备还不足以支撑起如此大的运算量[22],因此弱标记的应用必须存在于电脑端。

弱标记跟踪的基本流程是将视频中拍摄到的自然图片和预先存储的标准自然图片做特征点匹配,通过这些特征点集的匹配关系求出一个两张图片之间几何变换矩阵,再通过这个矩阵得到自然图片在真实场景中的位置关系并显示三维模型。

随着弱标记技术的发展,一些特征点描述子(Descriptor)在图像识别、图像剪接、匹配技术中得到了广泛应用。其中最常见的是SIFT描述子[23]和SURF描述子[24]。我们通过这两种算法使图4中[17]的两张图片中(一张是自然环境下的图片,另一张是程序后台存储的图片)的特征点进行对应。由于不可避免的噪声以及移动等原因的干扰,造成错误的匹配点,所以通常采用随机采样一致性(RANSAC)[25]算法来匹配特征点。

图4 标准的自然标记物以及真实场景下的自然标记物之间的特征点的对应

此外,基于视觉的增强现实应用有两方面:视频捕捉(Video Capture)和AR可视化(AR Visualization)。视频捕捉阶段包含从设备的摄像头接收视频帧,做一定的色彩转换,并把初步处理的视频帧发送到处理管线(Processing Pipeline)。由于对于手机以及任何可穿戴设备来说,处理视频帧的运算量还是相对非常大的,同时也是增强现实系统中最大的一部分运算量。所以对于手机来说,要获取尽可能大的性能,要从内存中直接读取视频帧,并且视频帧的图像处理压力不能太大。增强现实应用是实时性的,所以尽可能快的处理视频帧能增大帧率(FPS),屏幕视频显示越快,越不会给用户以停滞感。

1.1.3 基于深度摄像机的跟踪技术

由于环境光照的情况、标记被遮挡以及目标短暂性的消失这些因素会导致渲染系统不能真实的渲染三维物体,所以针对这些因素的影响,有些增强现实开发公司就在增强现实应用中加入其他辅助器材来实验性更精确的跟踪结果。如微软出品的Hololens智能眼镜就加入了四个深度摄像头。如图5所示。

图5 Hololens智能眼镜

深度摄像头采用SLAM[26]技术,先将周围的环境扫描之后生成点云,再将点云生成三角面片,最后进行SLAM。SLAM(Simultaneous Localization And Mapping)即同步定位与建图系统,即通过传感器获取环境的有限信息,比如视觉信息,深度信息(Kinect),还有自身的加速度,角速度等来确定自己的相对或者绝对位置,并且完成对于地图的构建。这个技术被用于机器人、无人汽车、无人飞行器的定位与寻路系统。

1.1.4 基于离线分析渲染的增强现实技术

该技术通过分析图像特征估计相机参数和场景光照并将虚拟物体渲染在真实图像中。由于分析算法计算量大,对于普通大小图像的分析时间以分钟为单位,目前只能在实时性要求不高的离线系统中应用。这类技术已经应用于PhotoShop等软件中做为对二维图片的三维图像的叠加处理技术。

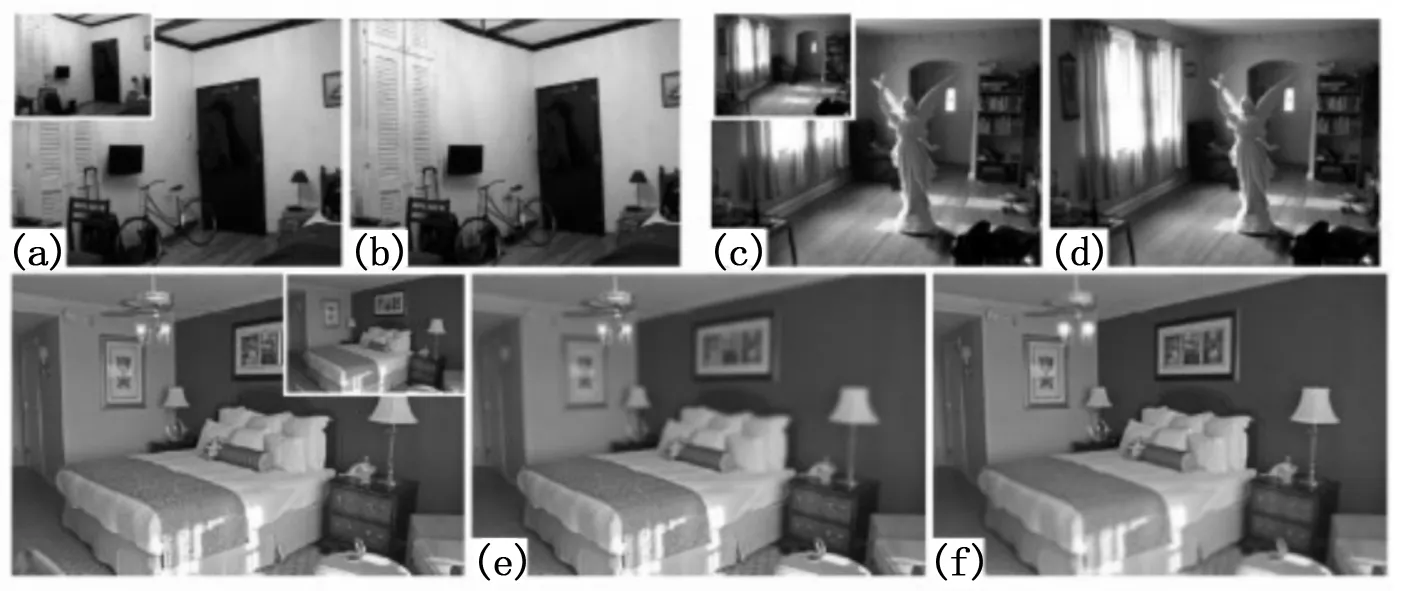

文献[27]描述了如何将虚拟物体融合到目标图像中。该论文使用位图表示虚拟对象,并在建立虚拟对象数据库是对虚拟对象的物理尺寸和光照环境进行了分析。融合过程中系统自动计算目标图像和数据库中二维虚拟对象的光照环境匹配度,提示用户选择匹配度高的虚拟对象进行融合,并简单绘制虚拟对象的阴影效果。文献[28]所实现的图片编辑系统可以允许用户在图片中拖入三维虚拟物体,并将其与图片中场景完美融合,交互简单。系统自动分析用户输入图片得到融合所需的图片相机、深度和光照信息。用户将三维虚拟物体拖入即可得到融合结果,如图6所示。

图6 融合效果示例

文献[28]的处理流程如图7所示。该流程主要包括三个步骤:第一步,估计场景的物理空间;第二步,根据上一步计算所得的物理空间参数来估计场景的光照;第三步,在场景中组合物体,增强光照或改变景深以使物体和场景融合后的图像接近源图像。下面对上述的三个步骤进行具体的分析:

图7 离线分析融合流程

1)单一图片的重建。如图8所示。

图8 单一图片的重建

该步骤估计场景的物理空间参数(包括深度图,摄像机参数,空间漫反射系数)。首先基于文献[29]的几何参数估计算法估计摄像机参数(焦距、图像中心)。然后使用文献[30]的算法估计每个像素的对应的空间的漫反射系数。最后,由前两步得到的参数和一个基于RGBD图像的数据库,根据非参数化的深度采样方法来计算场景中每个像素的深度值。

2)光照估计。如图9所示。

图9 光照估计

文献[28]把光源分为可视的光源(可以在照片中看到的光源)和潜在的光源(其他光照)。可视的光源可以用训练过的光照分类器在图片中检测出来,潜在的光源是一张被标记过球面全景图[31]的数据集通过一个数据驱动流程而后得到。最后,优化光照强度以使别渲染的场景相似于输入图片。

3)物体融合。如图10所示。

图10 物体的融合

文献[28]的离线渲染算法在LuxRender基于物理的图像渲染引擎里实现。用户只需要拖动一个物体进入图片里,系统就会自动执行离线渲染算法,最后生成光照、深度优化好的物体与实景融合的图片。

Autodesk公司出品的一款手机应用123D creature show就是对增强现实的离线渲染算法的实际应用。用户可以在该手机应用中可修改应用内置的几个三维模型,可以拍照以及在原有照片上叠加被用户修改好的三维模型。此外,该应用的Blend模式还可以对三维模型融合在真实场景中的光照情况进行优化。如图11所示。

图11 Autodesk 123D creature show效果图

1.2 显示技术

视觉是人类与外界环境之间最为重要且直接的信息传递通道,因此,显示技术是增强现实技术中的关键技术之一。显示技术的作用是将计算机生成的虚拟信息与用户所处真实环境融合在一起。增强显示系统中的显示技术有头盔显示器、手持式显示器、投影显示等。

1)头戴式显示器。

头戴式显示器是一种可以让用户感受到沉浸感的显示设备。它主要分为两种,基于摄像机原理的视频透视式头戴显示器和基于光学原理的光学透视式头戴显示器。

视频透视式头盔显示器通过头盔上一个或数个相机来获取实时影像。该影像通过图像处理模块和虚拟渲染模块产生的三维物体相互融合,最终在头戴显示器上显示出来。

目前,微软推出的Hololens[32]增强现实眼镜和Meta公司推出的Meta 2增强现实眼镜都是视频透视式头盔显示器。Hololens和Meta 2都具有强沉浸感、智能的人机交互方式的特点,但不同的是:Hololens可以让用户只需要带上眼镜而不需要连接任何设备就可运行增强现实应用;Meta 2(如图12)需要用户戴上增强现实眼镜后,连接电脑作为辅助计算,才能使用增强现实应用做交互。

图12 Meta 2增强现实眼镜

光学透视式头戴显示器是利用光的反射原理,在用户的眼前放置一块半透明的光学组合器,使用户能够看到虚拟三维物体与真实场景相互融合的画面。这个过程没有经过任何的图像处理,就是用户双眼看到的真实场景。

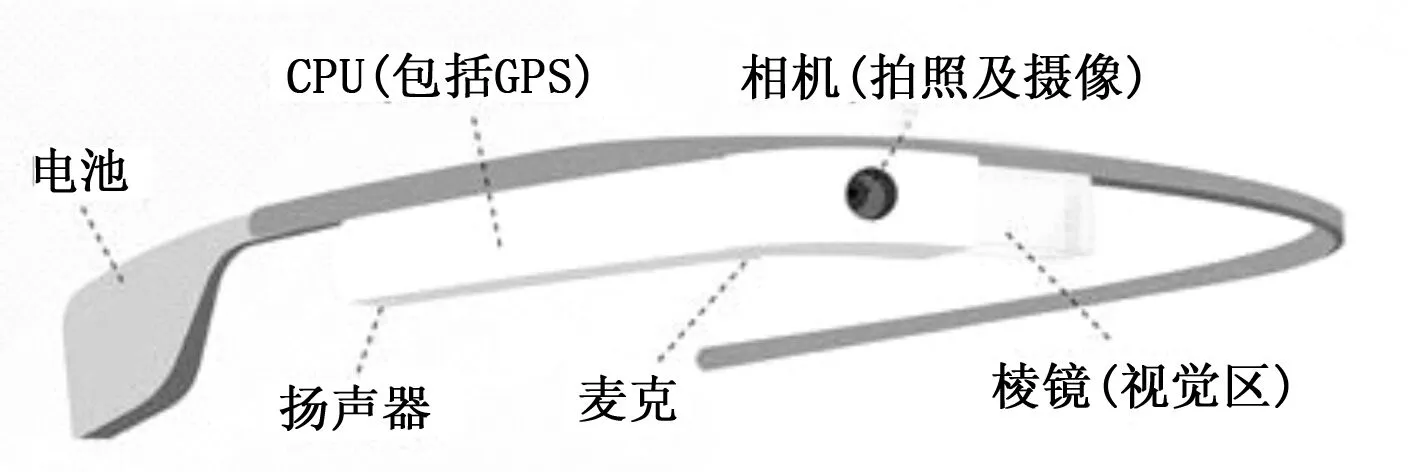

Google公司出品的Google智能增强现实眼镜是一款光学透视式头盔显示器。它不仅可以用来摄像拍照,还可以通过棱镜进行显示,同时还可以通过麦克风和扬声器来接听用户的指令命令。除此之外,它的CPU模块还包含了可以用来计算用户位置以及图像处理的GPS,如图13所示。

图13 Google智能增强现实眼镜

另外,还有一种特殊的头戴式显示器——基于LightField的Magic Leap开发的增强现实眼镜。如图14所示[33]。一束光线经过uv平面和st平面,令这两个交点的坐标为(u,v), (s,t),那么光场函数就可以描述为L(u,v,s,t)。

图14 Light Field原理图

Magic Leap开发的这款眼镜是通过眼镜里的一对摄像机来跟踪双眼,计算出双眼的焦距,再使用Light Field技术来让三维模型投影在双眼上,让双眼感受到真实世界的深度。

2)手持式移动显示器。

手持式移动显示器是一种允许用户手持的显示设备[34]。它虽然消除了用户佩戴头戴式显示器的不舒适感,但也相应地减弱了视觉的沉浸感。随着各种性能较强的移动智能终端的出现,为移动增强现实的发展提供了很好的开发平台。智能手机普遍都具有内置的摄像头、内置的GPS和内置的惯性传感器、磁传感器等,同时具有较大的高分辨率的显示屏,体积小易于携带,是增强现实技术开发中非常理想的设备。

3)计算机屏幕显示器。

计算机屏幕显示器拥有较高的分辨率,可以满足当前很多桌面机用户的视觉需求。这种显示设备适合那种室内需要渲染精细三维物体的增强现实的环境,并且适合于将虚拟物体渲染到范围较大的环境中。同时平面显示设备造价低,性价比高,多用于低端或者多用户的增强现实系统中,虽然屏幕的沉浸感非常弱,但对于多用户、大场景的的增强现实系统参与感确很强。

4)投影显示。

与平面显示设备把图像生成在固定的设备表面不同的是,投影设备能够将图像投影到大范围的环境中[33];与头戴式的显示设备相比,投影设备更适合室内AR应用环境,其生成图像的焦点不会随着使用者视角的改变而变化。

据悉,亚马逊获得了“物体追踪”和“反射测距”两个专利,其中,“物体追踪”是利用了相机和投影仪的基本原理,将虚拟的影像投射在真实的物体上去,再去捕捉人手的动作来实现互动, “反射测距”是通过投影仪将整个房间变成全息平台,进行测量人和物体的对应距离。如图15所示。

图15 “物体追踪”和“反射测距”原理图

这两个专利的原理跟微软研究院开发的RoomAlive项目的原理类似。不同的是RoomAlive项目利用Kinect与投影仪来扫描房间的几何形态,然后把虚拟影像投射到房间的任何角落来实现与用户的互动。

1.3 智能交互技术

在增强现实系统中,有多种方式实现人机交互,从传统的鼠标键盘交互到语言、手势交互,人机交互技术的发展将极大的扩展增强现实技术的应用。在增强现实系统中,常见的人机交互方式有以下几种:

1)基于传统的硬件设备。

鼠标、键盘、手柄等是增强现实系统中常见的交互工具,通过鼠标或键盘选中图像坐标系中的某一个点,对该点对应的虚拟物体做出如点按、拖动等操作。最大的不足在于不能给用户提供很好的交互体验,无法让使用者“身临其境”。如图16中,手机上的一种增强现实游戏,屏幕显示虚拟篮球场,通过手指在触摸屏的滑动,来做出射篮、运球等操作。

图16 增强现实游戏

2)手势交互手段。

基于手势的交互方式是近年来人机交互领域出现的一种新式的交互手段,在这种交互方式中,人手被当成了人机交互接口,以计算机捕捉到的各种手势、动作作为输入,这种交互方式更加直观、自然。比如微软的Hololens眼镜,眼镜上的深度摄像头提取人手的三维坐标、手势来操作交互界面上显示的三维虚拟物体或者场景。如图17所示。

图17 Hololens的手势交互

通过将人类自然且直观的交流手段引入人机交互接口中,作为计算机空间与人类认知空间交互的另一个桥梁。这种交互方式不但降低了人机交互的成本,而且更加符合人类的自然习惯,已经成为业内研究的热点。

3)便携式投影互动技术。

MIT大学的SixthSense[35]和微软开发的Omnitouch都属于这类便携式投影互动触摸技术。将操作菜单等可交互操作的画面投影到某一平面内。如图18所示。

图18 SixthSense

2 增强现实开发工具

为了推进增强现实的实际应用,除了对跟踪注册定位、人机交互和渲染虚拟场景等基本技术进行研究外,还应提供一个开发与运行环境,以便于各个领域增强现实相关应用的开发,因此增强现实的系统框架的研究也是这个领域的一个重要内容。增强现实领域相关的公司相继开放一些适合增强现实应用、可重用的系统开发库,用来支持增强现实应用系统的快速开发。这些框架包括Vuforia、Metaio等第三方开发库。

2.1 Vuforia

Vuforia[36]是由高通(Qualcomm)公司提供的增强现实开发包,除了iOS与Android等手机平台的SDK以外,也提供了Unity3D[37]游戏引擎的扩展控件。让用户轻松制作PC或手机端的增强现实应用。Vuforia可以免费下载,只有使用进阶功能与服务时才需要另外支付费用。

Fuerte International 利用Vuforia为丰田开发了一款AR游戏。它的原理很简单,通过摄像头拍摄印有“Made to Thrill”主题的图片,就会有一辆Toyota 86出现在屏幕上。利用操纵杆,你可以控制它加速、转弯、漂移。

2.2 Metaio

Metaio[38]是增强现实领域的领导者,公司脱胎于大众汽车启动的一个研究计划,和Vuforia增强现实开发包类似。Metaio提供Metaio SDKCreatorCloudJunaio(一个跨品台的增强现实浏览器)产品的整个垂直产业链,吸引众多独立开发者和企业。近期被苹果公司收购,将来不仅给开发者提供这方面更强大的支持,同时也会助力Metaio关于带增强现实起飞的愿景。

2.3 其他开源第三方增强现实开发框架

对于上述介绍的Metaio或者Vuforia等增强现实开发SDK并不是完全免费的,对于企业用户来说,有时需要向SDK开发公司索取授权,而授权费非常昂贵,每次升级换代还需要重新授权。所以就诞生了很多个人用户开发的增强现实库,比如早期的ARToolKit[39]开源工具包,它主要由日本大阪大学的Hirokazu博士开发,用于快速编写AR应用,并受到了华盛顿大学人机界面实验室和新西兰坎特伯雷大学人机界面实验室支持,曾经是AR领域使用最广泛的开发包。另外还有很多个人以及企业开发的增强现实开发包,比如Rajawali、ARLab、ARmedia等开发包[40]。

3 增强现实技术应用领域

3.1 工业制造和维修领域

这是增强现实技术被应用的第一个行业。通过头戴式显示器连接到需要施工的特定物体上,进而在显示器上描述出物体的图像[41]。微软公司开发的Hololens智能眼镜叠加三维影像在真实场景上。图19下展示出头戴Holoens眼镜的技术人员看到的东西:如何安装水管和旋转螺帽的视频。而智能眼镜将交互视频叠加在墙面上。

图19 Hololens眼镜的增强现实应用的交互效果

3.2 医疗领域

医生利用增强现实技术,在患者进行手术的过程中,可以看到注册到病人身上的MRI和CT图像[42],图形绘制模块可以将虚拟的模型动态实时的渲染,同时将视频文件播放出来,展示了良好的生物实验结果[43]。不仅如此,增强现实技术已经被应用在医疗教育培训中,大大的增强医务人员的医治水平。除此之外,增强现实还可以应用于虚拟手术模拟,虚拟人体功能,虚拟人体解剖和远程手术等。

3.3 军事领域

军队可以利用增强现实技术提供周边环境的重要信息,如显示建筑物另一侧的入口;显示军队的移动,从而让士兵转移到敌人看不到的地方。

BAE系统公司和英国伯明翰大学的专家们已经研发出了军事作战指导系统的雏形。系统配置了Oculus Rift虚拟现实头盔。通过这些技术,军官可以直接在便携式智慧中心来进行战略的部署和获取前线的实施战况。

3.4 电视转播领域

增强现实技术可以为电视台转播节目的时候提供实时的节目信息, CCTV5在转播2014年世界杯的时候,通过运用自然特征的图形标记来定位球场位置及其内部具体情况从而可以在节目现场展示被三维渲染的世界杯球场。摄像头捕捉到标记后,由后台运算系统计算得到自然标记的位置信息,最后由三维渲染系统将三维动画绘制在屏幕上。

3.5 娱乐、游戏领域

Ingress是谷歌发布的一个手机增强现实游戏。玩家可以加入“Resistance”或者“Enlightened”团队来定位和收集“异物质”,而“异物质”是存在于现实生活中的地点中的,因此玩家必须亲自去该地点来寻找它[43]。玩家通过GPS等位置传感器获取地点的位置信息,手机地图上会出现该地点的游戏信息。

3.6 教育领域

增强现实技术可以将静态的文字、图片读物立体化,增加阅读的互动性、趣味性。

Hye Sun Lee 和 Jong Weon Lee设计了一款目标人群是幼儿园和小学学生的教育游戏。旨在帮助学习者掌握数学中的加法相关知识[45]。如图20所示。

图20 增强现实的教育游戏

3.7 古迹复原和数字化遗产保护

文化古迹的信息以增强现实的方式提供给参观者,用户不仅能获取估计的文字解说,还能看到遗址上残缺部分的虚拟重构。

国内正在研究基于增强现实技术的圆明园景观数字重现方面的应用。游客把手机摄像头对准遗址,就能够看到被破坏前的原貌。游客可以了解到该移植的所有信息,包括何年何人主持建造、所用建筑材料等内容[46]。

ARCHEOGUIDE是一个个人电子导游的项目。该系统将视频拍摄到的遗址场景自然无缝的与虚拟三维模型渲染在便携设备屏幕上[47]。

3.8 家居领域

宜家2014年产品手册中,推出了增强现实目录,这款应用使用的是Metaio公司的影像识别技术来辨别特定的页面和图像。

这款应用能够使用实体产品目录作为标准尺寸,来判断家具的大体尺寸,然后把家具的样子投射到设备的显示屏上,让用户来了解自己心仪的某款家具摆在在房间里的样子,以及究竟是否合适。

4 展望

近日,创维推出了全球第一台AR电视S9D,用户可以通过S9D的电视屏幕来观察到游戏中增加的特效,能够大大提高用户的沉浸感。在创维推出AR电视的背后,我们除了看到提升了用户的体验感之外,更看到了AR技术的前景,比现在已经被广泛应用的VR更大的市场。

1)由于VR是一种“封闭式”的场景,使得用户的交互受到一定的限制,现在广泛应用于电子领域,而AR具有交互性强的优点可以适用于更多的领域,如现在大热的Pokemeon go游戏采用的就是AR技术。

2)2016年7月份Gartner 公布 2016 年新兴技术成熟度曲线,AR 技术在经历概念炒作阶段之后,现已进入商业化之前的沉淀期。当前市场已经将大量的不成熟的AR技术和冗余的服务淘汰,投资者对于AR有了一个更清晰,更实际的认识,符合现实的商业框架已经相对成熟,在未来的几年中AR将稳步进行发展,在不久的将来一定会达到行业的高峰。

但不可否认的是AR技术的发展还处于瓶颈期,受到软硬件的约束。首先,软件方面底层的算法必须要加强,精确的图像识别技术必须要结合观察者的相对位置以及三维坐标等信息进行定位来判断物体所处的位置,要做到对应的精确性和实时性是一个技术难点。其次,在硬件方面,这有是增强现实技术目前最大的障碍。由于我们不可能随时打开摄像头来扫描物体来获得增强现实的应用,所以像Google眼镜这种可穿戴设备最有可能普及起来。但是这种可穿戴设备又存在着一个图形畸变和色散的问题,当眼镜成像的时候由于反射原理会在人的视场周边出现色散现象,需要通过软件来消除这一现象这就会使得设备的成本大大增加,不利于普及。

增强现实技术的发展是科技发展的必然趋势,有利于改善生活的便利性,同时也代表了人们对未来便捷生活的憧憬,未来发展的空间不可估量。

[1] Tom caudell. AR at boeing(1990)[EB/OL]. http://www.ipo.tue.nl/homepages/mrauterb/presentation/HCI-history/tsld.htm.

[2] Sutherland I E. The ultimate display[J]. Multimedia: From Wagner to virtual reality, 1965.

[3] P Milgram, F Kishino. A taxonomy of mixed reality visual displays[J]. Leice Transactions on Information & Systems, 1994(12):1321-1329.

[4] R. Azuma. Tracking Requirements for Augmented reality[J]. Communications of the ACM,1993, 36(7): 50-51.

[5] Wagner D,Schmalstieg D. ARToolKit Plus for pose tracking on mobile devices[A].Computer Vision Winter Workshop[C].2007.

[6] Rosen J M, Soltanian H, Redett R J. Evolution of virtual reality[J]. IEEE Eng Med Biol Mag, 1996, 15(2):16.

[7] Bajura Michael, Henry Fuchs, Ryutarou Ohbuchi. Merging Virtual Reality with the Real World: Seeing Ultrasound Imagery Within the Patient[A]. Proceedings of SIGGRAPH[C].1992,153-161.

[8] 朱淼良, 姚 远, 蒋云良. 增强现实综述[J]. 中国图像图形学报, 2004(9):767-774.

[9] Feiner S, MacIntyre B, Hollerer T.A touring machine: Prototyping 3D mobile augmented reality systems for exploring the urban environment[Z]. 1997,19-30.

[10] Wagner D,Reitmayr G,Mulloni A,et al. Pose tracking from natural features on mobile phones[A].IEEE International Symposium on Mixed and Augmented Reality[C].2008.

[11] Jiang B,You S,Neumann U.A robust hybrid tracking system for outdoor augmented reality[A].Proceedings of IEEE Virtual Reality Conference[C].2004:3-10.

[12] Yokokohji Y, Sugawara Y, Yoshikawa T. Accurate Image Overlay on VideoSee-through HMDs Using Vision and Accelerometers[A]. Proc. IEEE Virtual Reality 2000[C]. IEEE CS Press, Los Alamitos, Calif., 2000, 247-254.

[13] 汪星荷. 基于 Android 终端的移动增强现实技术的研究[D]. 北京:北京邮电大学, 2013.

[14] 康 波. 增强现实中的跟踪技术[J].计算机测量与控制,2006,1431-1455.

[15] Andrei State, Gentaro Hirota, David T. Chen, et al. Superior Augmented Reality Registration by Integrating Landmark Tracking and Magnetic Tracking[A]. Procs. SIGGRAPH 1996[C]. New Orleans, LA, USA, 1996, 429-438.

[16] Andrei State, Mark A. Livingston, Gentaro Hirota, et al. Techniques for Augmented Reality Systems: Realizing Ultrasound-Guided Needle Biopsies[A]. Procs.SIGGRAPH1996[C]. New Orleans, LA, USA,1996, 439-446.

[17] Baggio, Daniel Lélis. Mastering OpenCV with practical computer vision projects[M]. Packet Publishing Ltd, 2012.

[18] Fritz G, Seifert C, Paletta L. Urban Object Recognition from Informative LocalFeatures[A]. Procs. ICRA 2005[C]. Barcelona, Spain, 2005, 132-138.

[19] Davison A J. Real-time simultaneous localisation and mapping with a singlecamera[A]. Procs.ICCV 2003[C]. Nice, France, 2003, 1403-1410.

[20] 查骏元,秦文虎,赵正旭.基于人工标志的增强现实技术[J].计算机工程与设计,2008,4819-4820.

[21] Guan T, Wang C. Registration based on scene recognition and natural features tracking techniques for wide-area augmented reality systems[J]. IEEE Transactions on Multimedia, 2009, 11(8): 1393-1406.

[22] Guan T, Duan L Y, Chen Y J, et al. Fast scene recognition and camera relocalisation for wide area augmented reality systems[J]. Sensors,2010, 10(6): 6017-6043.[23] Lowe D G. Distinctive image features from scale-invariant key points[J]. International Journal of computer Vision, 2004, 60(2).

[24] Bay H,uytelaars T, Gool L V.SURF:Speeded up robust features[A].ECCV.2006[C].

[25]MartinAFischler,RobertCBolles.Randomsampleconsensus:aparadigmformodelfittingwithapplicationstoimageanalysisandautomatedcartography[J].CommunicationsoftheACM, 1981, 24(6):381-395.

[26]ThrunS,LeonardJJ.Simultaneouslocalizationandmapping[M].Springerhandbookofrobotics.SpringerBerlinHeidelberg, 2008: 871-889.

[27]PhotoClipart[Z].

[28]KarschK,SunkavalliK,HadapS,etal.Automaticsceneinferencefor3Dobjectcompositing[J].ACMTransactionsonGraphics(TOG), 2014, 33(3): 32.

[29]LeeDC,HebertM,andKanadeT.Geometricreasoningforsingleimagestructurerecovery[A].InCVPR. 2009[C].2136-2143.

[30]GrosseR,JohnsonMK,AdelsonEH,adnFreemanW.Groundtruthdatasetandbaselineevaluationsforintrinsicimagealgorithms[A].ICCV.2009[C].

[31]XiaoJ,EhingerKA,OlivaA,andTorralbaA.Recognizingsceneviewpointusingpanoramicplacerepresentation[A].InCVPR.2012[C].

[32]Hololens眼镜[EB/OL].http://www.microsoft.com/microsoft-hololens/en-us.

[33]LevoyM,HanrahanP.Lightfieldrendering[A].Proceedingsofthe23rdannualconferenceonComputergraphicsandinteractivetechniques[C].ACM, 1996: 31-42.

[34]MistryP,MaesP.SixthSense:awearablegesturalinterface[A].ACMSIGGRAPHASIA2009Sketches[C].ACM, 2009: 11.

[35]LowK,WelehG,LastraA,etal.LifeSizedProjectoBasedDioramas[A].InACMSymposiumonVirtualRealitySoftwareandTeehnology[C].Pages161-168,2001.

[36]Vuforia[EB/OL].http://developer.vuforia.com/.

[37]Unity3D[EB/OL].http://unity3d.com/.

[38]Metaio[EB/OL].http://www.metaio.com/.

[39]ARToolKit[EB/OL].http://www.hitl.washington.edu/artoolkit/.

[40]AugmentedRealitySDKCompare[EB/OL].http://socialcompare.com/en/comparison/augmented-reality-sdks.

[41]SARDisplay[EB/OL].http://www.spatialar.eom.

[42]GlombitxaG,EversH,Hassfeld,EngelmannU,Meinzer.Virtualsurgeryinateleradiologyframework.InformationTechnologyinBiomedicine[J].IEEETransactions,1999,3(9):186-196.

[43]BajuraMichael,HenryFuchs,RyutarouOhbuchi.MergingVirtualRealitywiththeRealWorld:SeeingUltrasoundImageryWithinthePatient[A].ProceedingsofSIGGRAPH[C].1992,153-161.

[44]GoogleIngress.http://www.ingress.com.

[45]HyeSunLee,JongWeonLee.MathematicalEducationGameBasedonAugmentedReality[A].Z.Panetal.ProceedingofEdutainment[C].Berlin:Springer-Verlag, 2008, 442-450.

[46] 程 志, 金义富. 基于手机的增强现实及其移动学习应用[J]. 电化教育研究, 2013(2):66-70.

[47]VlahakisV,KarigiannisJ,TsotrosM,etal.ARCHEOGUIDE:FirstresultsofanAugmentedReality[A].In:MobileComputingSysteminCulturalHeritageSites,VirtualReality,Archaeology,andCulturalHeritageInternationalSymposium(VAST2001)[C].Glyfada,NrAthens,Greece(2001).

A Survey of Augmented Reality Technology

Hou Ying, Xu Weiwei

(College of Hangzhou International Institute of Service Engineering, Hangzhou Normal University, Hangzhou 311000, China)

This paper presents a survey on the field of Augmented Reality, which combines virtual computer-generated material with the surrounding physical world, registers real and virtual object with each other and runs interactively at real time. Augmented Reality makes use of video display device to present the situation after the fusion of virtual and reality to the user, thus greatly improving the human visual experience. Augmented Reality technology is a new technology which is produced in recent years with the development of virtual reality technology. Augmented Reality research encompasses a large number of areas in computer science. With the development tracking technology, the image quality and the rapid development technology have become a new requirement. The paper introduces the primary content and state of art in this field. The key technologies, including basic tracking methods, display devices and registration processes, are discussed. Many typical AR applications and developing tools are listed. Finally, the paper describes different AR application.

augmented reality; registered tracking technology; projection technology

2016-09-22;

2016-10-12。

国家自然科学基金(61272392,61322204)。

侯 颖(1992-),女,河南驻马店人,硕士研究生,主要从事增强现实方向的研究。

许威威(1975-),男,安徽绩溪人,博士,研究员,主要从事计算机图形图像处理,三维打印技术方向的研究。

1671-4598(2017)02-0001-07

10.16526/j.cnki.11-4762/tp.2017.02.001

TP18; TP391

A