基于高分辨率卷积神经网络的场景文本检测模型

陈淼妙 续晋华

(华东师范大学计算机科学与技术学院 上海 200062)

0 引 言

随着互联网和移动终端的飞速发展,越来越多的信息载体以图像的形式存在。自然场景中的文本具有丰富、明确的语义信息,利用计算机技术快速、准确地提取场景图像中的文本信息是计算机视觉和模式识别领域当下热门的研究课题之一。场景文本检测技术是文本识别的基础,在人们的日常生活和生产中有着广泛的应用。例如:手机设备上的拍照翻译软件,可以对异国街景中的文本进行即时的实景翻译,给出国旅游带来极大的便利;汽车上的智能拍摄设备,可以对道路交通指示牌上的文本进行检测和识别,获取实时的地理位置信息和道路周边情况,实现辅助驾驶。除此之外,场景文本检测技术在盲人辅助、商业票据处理、工业自动化等领域也有着重要的应用价值。

与传统OCR[1]相比,自然场景图像中的文本检测面临背景复杂、文本尺度和字体多样、图像质量的不确定性等诸多困难和挑战。近年来,随着深度学习技术的迅速发展,深度学习的方法在文本检测任务上效果显著,现有的卷积神经网络已经具备很好的表征能力,但网络定位能力不强,对文本的边界定位不准确。特征金字塔网络可以融合不同尺度的特征,但小尺度文本的高级语义信息在网络高层已经丢失,导致模型对多尺度文本的检测能力不强。

鉴于此,本文设计专门用于文本检测的主干网络,通过引入空洞卷积层,提高网络高层特征图的空间分辨率,以学习更精细的文本位置信息,提高模型的多尺度检测性能。

1 研究现状

场景文本检测是从自然场景图像中定位出文本的位置。近年来,随着基于深度学习的目标检测和图像分割算法的快速发展,场景文本检测的研究也进入了一个新阶段,涌现出大量基于深度学习的方法。这些方法主要分为三类:基于回归的文本检测方法、基于分割的文本检测方法和基于混合的文本检测方法。

1.1 基于回归的文本检测方法

受通用目标检测框架的启发,基于回归的文本检测方法通常采用回归文本边界框的方式获取文本区域,主要分为两类:

(1)间接回归。Faster R-CNN[2]的思想进入文本检测领域,将目标检测的各个阶段整合到深度神经网络中。间接回归首先通过卷积神经网络得到整幅图像的特征图,再通过锚点(anchor)机制或区域建议网络(Region Proposal Network)获得文本候选框,最后使用回归方法或其他方式精细调整候选框得到最后的文本检测结果。CTPN[3](Connectionist Text Proposal Network)提出了一种垂直锚点机制,将文本区域细分为多个固定宽度、预测高度的文本段,以提取多尺度的文本特征。RRPN[4](Rotation Region Proposal Networks)利用任意角度的区域建议网络,可以检测任意方向的场景文本。

(2)直接回归。YOLO[5]属于直接回归的目标检测框架。受此启发,直接回归的文本检测方法直接用一个神经网络预测给定点到文本边界框的偏移量,不需要进行二次回归。FCRN[6](Fully-Convolutional Regression Network)利用人工合成的场景文本训练基于YOLO的深度神经网络。He等[7]基于直接回归,采用多任务学习的框架,缓解了锚点机制不能有效检测倾斜长文本的问题。

这类方法采用整体化思想,计算速度较快,但在一些情况下检测出的文本边界框不够精确且无法调整。

1.2 基于分割的文本检测方法

文本检测的核心是设计特征来区分出文本和背景。基于分割的文本检测方法将文本检测问题转化为文本与背景的语义分割问题,首先通过分割网络提取文本块区域,再进行后处理获取文本边界框。大多数方法采用全卷积网络框架(FCN[8])。Yao等[9]将文本置信度、字符置信度和相邻字符连接方向多个通道的信息在一个网络中进行端到端训练,以精确分割文本与背景。He等[10]先利用一个多尺度全卷积网络提取文本块区域,再级联一个实例感知分割网络得到精细的文本实例。PixelLink[11]基于实例分割,先进行文本类别和连通预测,再利用实例分割得到最后的检测结果。这些方法可以检测倾斜或呈曲线的文本行,对文本边界定位较为准确,但对小尺度文本的检测能力不强,而且离得较近的文本行不容易区分开。

1.3 基于混合的文本检测方法

混合的思想是将回归方法与分割方法相结合,融合两种方法的优势。Zhou等[12]提出了一个简单、高效的文本检测器(EAST),直接在整幅图像上预测任意方向的场景文本,整个流程没有冗余的中间步骤。Lyu等[13]提出基于角点检测与区域分割的文本检测方法,以准确检测长宽比变化较大的文本实例,解决了相邻文本行的分割结果粘连的问题。

以上这些方法更多地受益于通用目标检测框架和图像分割方法,较少针对文本的尺度变化研究专门用于场景文本检测的主干网络。因此,本文基于混合思想,设计更关注文本的尺度变化和边界位置的网络结构,在不增加计算量的前提下提高模型的检测性能。

本文主要贡献是研究高分辨率特征图对文本检测结果的影响,因此本文采用了EAST[12]中的流程(Pipeline),设计新的高分辨率主干网络。实验结果表明,新的主干网络与原始的EAST模型相比,提高了召回率,取得了更好的检测性能。

2 方法原理

本文提出的模型是一个端到端可训练的场景文本检测器,该模型由两部分组成:深度神经网络和后处理。受DetNet[14]启发,通过维持较高的网络高层特征图的空间分辨率,让网络学习到文本的多尺度特征和精细的边界位置,从而提高模型的分类、定位能力。

2.1 网络结构

模型的主体是深度神经网络,网络结构如图1所示。网络由三部分构成:主干网络、特征融合层和输出层。图1中:Conv代表卷积操作,后面的参数分别为卷积核尺寸、通道数和下采样倍数;Max pool代表最大池化操作;Concat代表将两个特征图按通道维度进行拼接;Unpool代表上采样,直接使用双线性插值。

图1 网络结构

主干网络:基于ResNet50,改进Block 3使得其特征图分辨率是输入的1/16(而不是原来的1/32),以提取到合适的多尺度特征和精细的文本位置。相应地改进Block 4为Dilated Block,该结构块由一个带有1×1卷积项的空洞卷积[15]结构(图2(a))开始,再堆叠两个无1×1卷积项的空洞卷积结构(图2(b)),以增大网络的有效感受野,捕获高级语义信息,增强网络的分类能力。同时,Dilated Block的网络宽度与Block 3保持一致,以减少网络的计算代价。

(a)带有1×1卷积项 (b)无1×1卷积项

特征融合层:从主干网络的最高层开始,将其中的5层特征融合,以增强网络低层的表征能力,充分利用网络各层提取到的特征来应对文本的尺度变化。融合方式如下:

(1)

(2)

式中:[·,·]代表拼接操作。

输出层:特征融合层得到原图四分之一大小的特征图,利用1×1卷积操作得到6个通道的输出,其中一个通道预测每个像素属于文本区域的置信度,四个通道分别预测每个像素距离文本外接矩形4条边的距离,另一个通道预测该文本外接矩形的旋转角度。

2.2 标签生成

标签生成过程如图3所示,图中虚线四边形为ground truth对文本区域的标注。将虚线四边形的4条边均向内缩减0.3倍的短边长得到一个内部四边形,目的是缓解紧挨文本区域存在的分割结果粘连的问题;将内部四边形内的像素视作正样本,真值为1,其余区域值设为0;生成虚线四边形的最小外接矩形;仅对内部四边形内的像素计算损失,以图3中一个像素点为例,4个箭头代表该像素点距离外接矩形4条边的距离;用θ表示外接矩形的旋转角度,最终表示出文本区域的外接旋转矩形。

图3 标签生成示意图

2.3 损失函数

网络的损失函数是分类损失与回归损失的加权和:

L=Lcls+λregLreg

(3)

式中:Lcls代表分类损失;Lreg代表回归损失;平衡系数λreg设为1。与EAST中的交叉熵损失不同,本文采用二分类的Dice损失作为分类损失Lcls:

(4)

(5)

(6)

Lreg=Lgeo+λθLθ

(7)

式中:λθ是几何损失和角度损失的平衡系数,实验中设置为20。

2.4 非极大值抑制算法

非极大值抑制算法(Non-Maximum Suppression,NMS)的本质是局部极大值搜索,抑制非极大值元素。该算法在文本检测任务的后处理中被广泛应用,目的是去除冗余的检测结果,得到最佳的文本边界框。

模型的后处理采用融合NMS[12],算法步骤如下:

(1)对模型生成的文本边界框按行从左向右依次进行融合操作,计算两个文本边界框的面积交叠率(PIoU),计算公式如下:

(8)

式中:area(·)代表文本边界框的面积。如果交叠率大于设定的阈值,对文本边界框的4个顶点坐标分别进行相应的权重平均,得到融合后的文本边界框,其置信度设为原始文本边界框的置信度之和;否则,保留原始文本边界框。

(2)将经过融合操作后的所有文本边界框按照置信度从高到低排序,并将第一个文本边界框作为当前抑制文本边界框。

(3)非极大值抑制:将其他文本边界框作为被抑制的元素,计算当前抑制文本边界框与被抑制文本边界框的面积交叠率。如果交叠率大于设定的阈值,去除该文本边界框。

(4)按照步骤(2)中的排序结果,取下一个未被抑制的文本边界框作为当前抑制文本边界框,执行步骤(3),重复步骤(4)直至剩下最后一个文本边界框,算法结束。

3 实 验

3.1 数据集

为了验证模型的有效性,实验在公开的场景文本检测数据集ICDAR2015上进行性能评估。ICDAR2015数据集包含1 000幅训练图像和500幅测试图像,图像相对模糊且文本为任意方向、包含畸变,标注真值为文本区域外接四边形的4个顶点坐标。

3.2 网络参数设置

实验中使用Adam优化器来进行网络训练,训练数据为ICDAR2013训练集中的229幅图像和ICDAR2015训练集中的1 000幅图像。为了加速网络收敛,训练前将图像随机裁剪缩放(缩放比例为0.5、1.0、2.0、3.0),并用黑色填充以重新将图像大小调整为512×512,Batch Size设为16。初始学习率为0.000 1,之后每1万步以0.96的比例衰减,总迭代次数为9万次。

3.3 性能指标

研究采用标准的自然场景文本检测评估指标:准确率(P)、召回率(R)和F值(F)。它们的计算公式分别为:

(9)

(10)

(11)

式中:TP表示检测正确的文本框数量;D表示模型检测出的文本框数量;G表示ground truth中真实的文本框数量。若检测结果与ground truth之间的交并比大于阈值(一般设为0.5)并且得分也大于相应阈值,则认为该检测结果是正确的。F值是准确率和召回率的调和平均数,以综合评估模型的性能。

3.4 实验结果

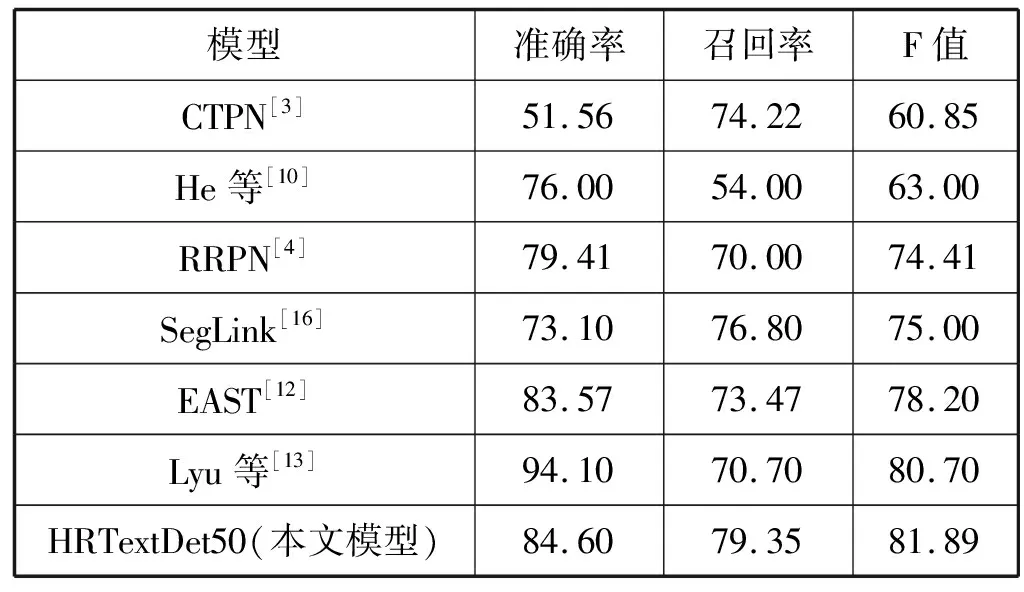

为了验证专为文本检测任务设计的主干网络(TextNet)的性能,首先将提出的模型(HRTextDet)在ICDAR2015数据集上进行测试,在输入图像为单尺度的条件下,与原始模型(EAST[12])进行实验对比。如表1所示,本文模型最大的优势在于召回率得到显著的提升,达到79.35%,比原始模型提高5.88%;准确率达到84.60%,比原始模型提高1.03%;F值达到81.89%,提升3.69%。

表1 HRTextDet与原始模型的性能对比 %

此外,原始模型PVANet2x(EAST)使用多尺度测试PVANet2x_MS(EAST)后,召回率得到极大的提升,说明原始模型尽管融合了高低层特征,仍无法应对文本剧烈的尺度变化。然而,本文模型使用单尺度测试与使用多尺度测试的PVANet2x_MS(EAST)相比,在准确率、召回率和F值上分别仍有1.33%、1.02%和1.17%的提升。这是因为专为文本检测设计的主干网络,能够提取到文本的多尺度特征和精细的边界位置。图4为原始EAST模型和提出模型的结果对比图。图4(a)中,原始EAST模型在多尺度文本检测上能力不足,而提出的模型具有较高的网络高层特征图的空间分辨率,在不均匀照明、低分辨率、背景复杂等各种有挑战的场景中,仍能有效地检测出多尺度文本;图4(b)中,原始EAST模型对文本的边界定位不准确,而本文模型能准确地定位出文本的位置;图4(c)中,原始EAST模型存在背景误检的情况,而本文模型能有效地保留高级语义信息,具有较强的分类能力,能减少对背景误检的情况。

(a)多尺度检测

为了探讨主干网络的网络深度对模型性能的影响,改变主干网络的网络深度,在TextNet50的最高层堆叠一个Dilated Block,得到TextNet59。在ICDAR2015数据集上进行单尺度测试,并与HRTextDet50模型进行实验对比。如表2所示,主干网络为TextNet59的模型在准确率、召回率和F值上与主干网络为TextNet50的模型相比均有所下降。这表明主干网络的深度不是越深越好,与文本检测可能不需要太深的高级语义信息这一猜想吻合。

表2 不同深度TextNet的性能对比 %

为了验证Dilated Block设计中1×1卷积项具有开启新的语义阶段的作用,实验使用无1×1卷积项的空洞卷积结构开启TextNet59主干网络的第二个Dilated Block,把该结构叫作TextNet59_v0。在ICDAR2015数据集上用TextNet59_v0进行单尺度测试,并与主干网络为TextNet59的HRTextDet模型进行实验对比。如表3所示,主干网络为TextNet59_v0的模型在F值上与主干网络为TextNet59的模型相比略有下降,这表明1×1卷积项可以开启新的语义阶段。

表3 Dilated Block中有/无1×1卷积项的性能对比 %

图5给出了更多检测结果,其中:(a)是检测成功的例子;(b)是检测失败的例子。图像中的文本太过模糊时,对文本检测器是个很大的挑战。

(a)检测成功示意图

最后,把HRTextDet模型与常用的自然场景文本检测方法进行实验对比,在ICDAR2015数据集上的实验结果如表4所示。可以看出,本文模型F值达到81.89%,比之前最好的方法提高1.19%。HRTextDet模型的最大的优势在于召回率得到显著的提升,比之前最好的方法SegLink[16]的76.80%提高2.55%。

表4 在ICDAR2015数据集上的实验结果 %

4 结 语

本文提出一个具有高空间分辨率的文本检测模型,通过专为文本检测任务设计的主干网络使得模型可以提取到文本的多尺度特征和精确的边界位置。实验结果表明,在不均匀照明、低分辨率、背景复杂等各种有挑战的场景中,本文模型能有效地应对文本剧烈的尺度变化,准确地检测出场景文本。本文模型能检测任意方向的场景文本,由于采用旋转矩形来表示文本区域,在一定程度上限制了模型对弯曲文本的检测性能。因此,下一步的工作将尝试采用多边形来表示文本区域,使得模型能检测任意方向和任意形状的场景文本。