融合RGB-D信息的三维物体识别算法

凌滨 刘晓锋 李云龙

摘 要: 图像处理是物体识别的关键环节,不同的模态特征之间具有互补性,同时使用能够提高目标的识别准确率,但现有研究仅仅是将多模态特征直接融合或者人工构造特征描述子进行识别工作,没有区别对待不同模态的不同特征且忽略了特征的内部联系。为了更客观地反映物体三维特性,结合稀疏自编碼网络和改进的卷积神经网络,提出一种新的深度学习模型SAE?RCNN与一种分段训练网络的方法,可以提取有辨别力的特征而且避免了网络退化的问题,并将特征在全连接层高效融合,通过分类器Softmax得到实验结果。实验数据采用Washington RGB?D标准数据集。结果表明,SAE?RCNN算法模型的物体识别率达到89.7%,较其他算法取得了更好的识别效果。

关键词: 物体识别; 深度学习模型; 网络训练; 特征提取; 特征融合; 准确率提升

中图分类号: TN911.73?34; TP391 文献标识码: A 文章编号: 1004?373X(2020)23?0024?06

Abstract: Object recognition is a key link of image processing. The complementarily of different modal features can improve the recognition accuracy of objects. However, the existing research only involves the fusion of multimodal features or the construction of feature descriptors, but does not treat the different features discriminatively and ignores the internal relation of the features. In order to reflect the three?dimensional features of objects more objectively, a new deep learning model SAE?RCNN (sparse autoencoder?region with CNN features) and a multi?stage network training method are proposed in combination with the sparse self?coding network and the improved convolutional neural network. The algorithm can extract features with discriminative power while avoiding network degradation and fuse them efficiently in the fully connected layer. The experimental result was obtained with classifier Softmax. The Washington RGB?D standard database is adopted for the experiment data. The results show that the object recognition rate of SAE?RCNN algorithm model reaches 89.7%, which is better than other algorithms.

Keywords: object recognition; deep learning model; network training; feature extraction; feature fusion; precision rate improvement

0 引 言

图像识别一直是人工智能的重要领域之一,以往仅仅基于RGB图像的物体识别容易受到光照强弱、视角变动等外界因素的干扰。随着Kinect、RealSens、Xtion PRO等三维传感器的普遍流行,同时获得高分辨率的RGB图与深度图已经非常容易。深度图作为RGB图的有力补充,丰富了识别过程中可利用的信息。这使得基于RGB?D图像的目标识别技术受到广泛关注。

神经网络拥有强大的学习本领,图像领域在引入深度学习算法后,取得了巨大成功,许多基于RGB?D的物体识别的深度学习算法被提出。文献[1]利用核函数的基础特性,提出了Depth Kernel描述子方法。文献[2]提出了卷积[K]均值描述符自动学习有意义的局部特征,将兴趣点附近的响应绘制成直方图进行判别。文献[3]提出了分层匹配追踪算法HMP。首先对特征区域进行稀疏编码,并将特征向量输入空间金字塔最大池化SPMP进行学习。文献[4]将卷积神经网络和递归神经网络结合提出了CNN?RNN算法,RNN利用来自CNN低维数据的平移不变性来学习高维数据特征。文献[5]提出MS?CRNN算法,从4种不同的模态提取低层尺度特征,并将其输入多层递归神经网络RNNs得到高层特征。文献[6]提出了多层卷积神经网络CNNs模型。这些算法在三维物体的识别方面均取得了不错的效果,但忽略了不同模态之间的联系,导致数据大量冗余,仍然具有一定的局限性。

RGB特征与深度图特征的重要性是相对的。当目标之间轮廓外形相近时,RGB图特性往往比深度图特性重要,当目标之间外形有较大差异时两种特性的重要性则相反。由于特征描述子提取特征的方式仅仅是将模态之间的联系线性叠加,容易忽略一些细微但是具有判别力的特征。因此,本文提出了一个基于SAE网络改进的多模态网络模型SAE?RCNN。整个网络采用分层机制,不仅可以将第一层提取的有代表性的特征在第二层抽象化,并且网络可以自发学习特征之间的联系,在全连接层进行有效融合,降低了数据冗余,增强了特征的非线性表达。由实验可知,新的网络模型取得了更高的识别率,有效地完成了识别工作。

1 相关理论

1.1 稀疏自编码算法

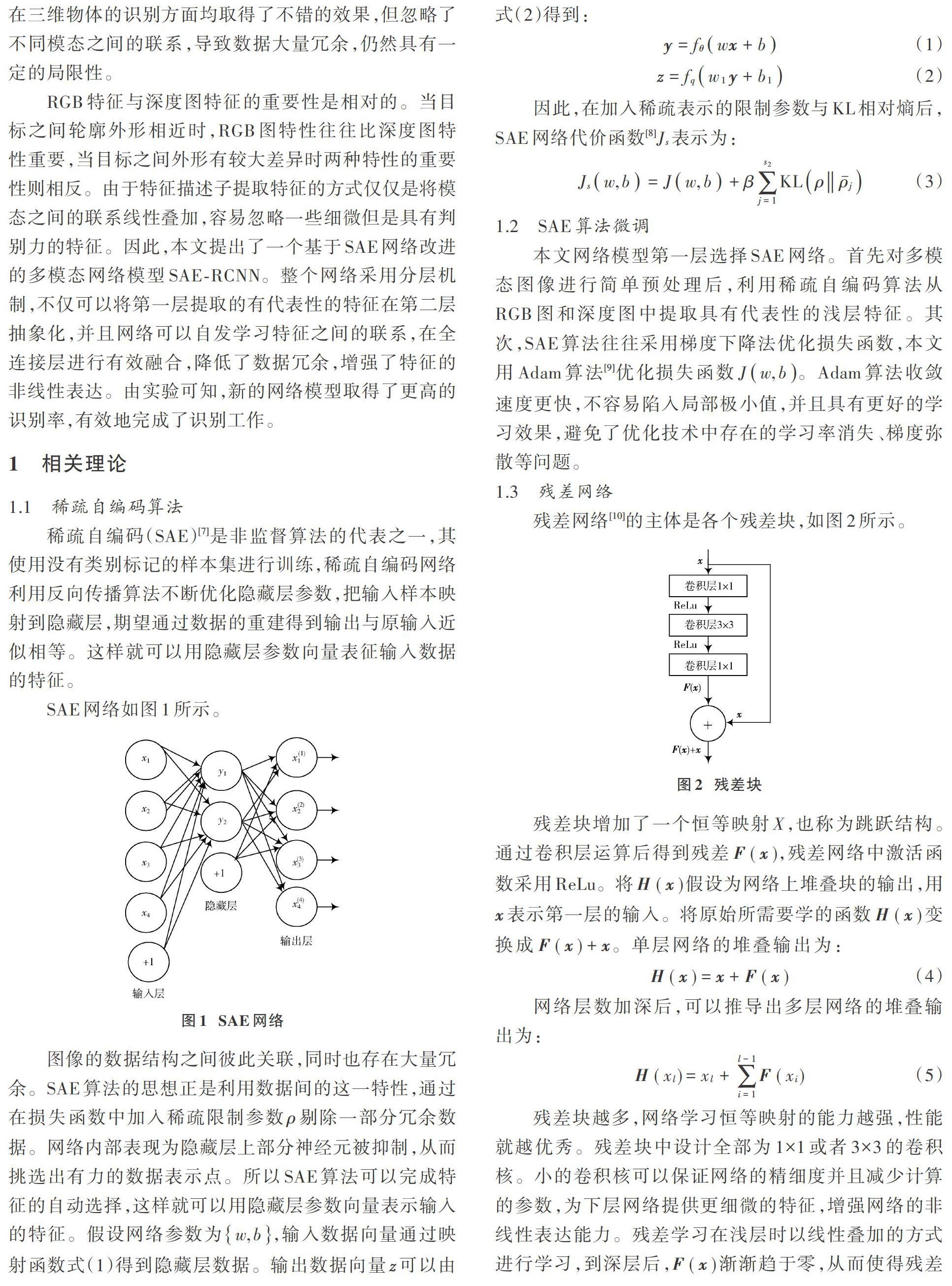

稀疏自编码(SAE)[7]是非监督算法的代表之一,其使用没有类别标记的样本集进行训练,稀疏自编码网络利用反向传播算法不断优化隐藏层参数,把输入样本映射到隐藏层,期望通过数据的重建得到输出与原输入近似相等。这样就可以用隐藏层参数向量表征输入数据的特征。

SAE网络如图1所示。

图像的数据结构之间彼此关联,同时也存在大量冗余。SAE算法的思想正是利用数据间的这一特性,通过在损失函数中加入稀疏限制参数[ρ]剔除一部分冗余数据。网络内部表现为隐藏层上部分神经元被抑制,从而挑选出有力的数据表示点。所以SAE算法可以完成特征的自动选择,这样就可以用隐藏层参数向量表示输入的特征。假设网络参数为[w,b],输入数据向量通过映射函数式(1)得到隐藏层数据。输出数据向量[z]可以由式(2)得到:

1.2 SAE算法微调

本文网络模型第一层选择SAE网络。首先对多模态图像进行简单预处理后,利用稀疏自编码算法从RGB图和深度图中提取具有代表性的浅层特征。其次,SAE算法往往采用梯度下降法优化损失函数,本文用Adam算法[9]优化损失函数[Jw,b]。Adam算法收敛速度更快,不容易陷入局部极小值,并且具有更好的学习效果,避免了优化技术中存在的学习率消失、梯度弥散等问题。

1.3 残差网络

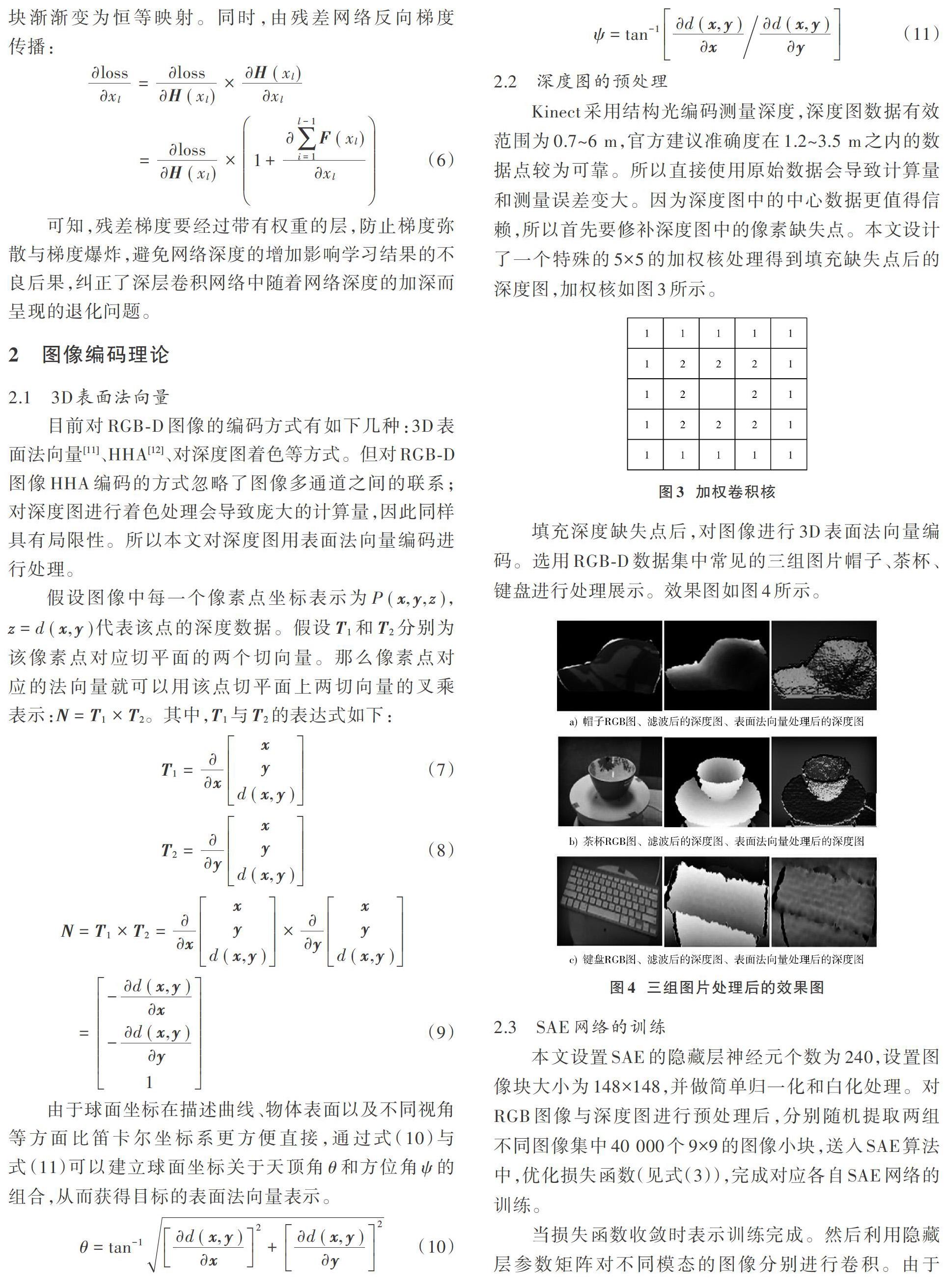

残差网络[10]的主体是各个残差块,如图2所示。

残差块增加了一个恒等映射[X],也称为跳跃结构。通过卷积层运算后得到残差[F(x)],残差网络中激活函数采用ReLu。将[H(x)]假设为网络上堆叠块的输出,用[x]表示第一层的输入。将原始所需要学的函数[H(x)]变换成[F(x)+x]。单层网络的堆叠输出为:

残差块越多,网络学习恒等映射的能力越强,性能就越优秀。残差块中设计全部为1×1或者3×3的卷积核。小的卷积核可以保证网络的精细度并且减少计算的参数,为下层网络提供更细微的特征,增强网络的非线性表达能力。残差学习在浅层时以线性叠加的方式进行学习,到深层后,[F(x)]渐渐趋于零,从而使得残差块渐渐变为恒等映射。同时,由残差网络反向梯度传播:

可知,残差梯度要经过带有权重的层,防止梯度弥散与梯度爆炸,避免网络深度的增加影响学习结果的不良后果,纠正了深层卷积网络中随着网络深度的加深而呈现的退化问题。

2 图像编码理论

2.1 3D表面法向量

目前对RGB?D图像的编码方式有如下几种:3D表面法向量[11]、HHA[12]、对深度图着色等方式。但对RGB?D图像HHA编码的方式忽略了图像多通道之间的联系;对深度图进行着色处理会导致庞大的计算量,因此同样具有局限性。所以本文对深度图用表面法向量编码进行处理。

假设图像中每一个像素点坐标表示为[P(x,y,z)],[z=d(x,y)]代表该点的深度数据。假设[T1]和[T2]分别为该像素点对应切平面的两个切向量。那么像素点对应的法向量就可以用该点切平面上两切向量的叉乘表示:[N=T1×T2]。其中,[T1]与[T2]的表达式如下:

2.2 深度图的预处理

Kinect采用结构光编码测量深度,深度图数据有效范围为0.7~6 m,官方建议准确度在1.2~3.5 m之内的数据点较为可靠。所以直接使用原始数据会导致计算量和测量误差变大。因为深度图中的中心数据更值得信赖,所以首先要修补深度图中的像素缺失点。本文设计了一个特殊的5×5的加权核处理得到填充缺失点后的深度图,加权核如图3所示。

填充深度缺失点后,对图像进行3D表面法向量编码。选用RGB?D数据集中常见的三组图片帽子、茶杯、键盘进行处理展示。效果图如图4所示。

2.3 SAE网络的训练

本文设置SAE的隐藏层神经元个数為240,设置图像块大小为148×148,并做简单归一化和白化处理。对RGB图像与深度图进行预处理后,分别随机提取两组不同图像集中40 000个9×9的图像小块,送入SAE算法中,优化损失函数(见式(3)),完成对应各自SAE网络的训练。

当损失函数收敛时表示训练完成。然后利用隐藏层参数矩阵对不同模态的图像分别进行卷积。由于一幅彩色图像就是一个三维矩阵,所以对于每一幅图像卷积完成后可以得到三维矩阵大小为240×140×140。对提取到的特征进行最大池化处理,设置池化窗口大小为2×2,步长为2,池化后可以得到的三维矩阵大小为240×70×70。之后将其送入多层卷积神经网络学习更细致的特征。

3 SAE?RCNN网络

3.1 算法流程

新的深度学习框架SAE?RCNN分为两层,算法框图如图5所示。将RGB图像与深度图像转换为数据向量后输入第一层SAE稀疏自编码网络,提取RGB图像与深度图的有区别性的特征。第二层网络由三个卷积层、三个残差块、网络的全连接层与Softmax组成。在对分支网络进行调优后将RGB特征与深度图特征进行特征融合,之后利用小的卷积核学习前层网络融合后的特征,再通过分类器进行目标识别。

算法步骤如下所示:

1) 分别对RGB图像与深度图像进行预处理,并设置尺寸大小为[r×r],记为[IRGB]与[IDepth],并将深度图用表面法向量编码。

2) 分别从预处理后的RGB图与深度图中随机选取长宽都为[d]的[N]个图像块,并且对其进行标准化处理。

3) 将步骤2)得到的数万个图像块作为SAE算法的输入,训练两个SAE网络,得到对应的特征参数矩阵。

4) 利用上述得到的SAE模型的参数矩阵,分别对步骤1)中的图像进行卷积操作,以提取各自图像对应的特征。设置SAE隐藏层节点个数为[K],则卷积后得到三维矩阵大小均为[s×s×K],其中,[s=r-d+1]。

5) 对卷积后的特征采取最大池化处理,设置池化目标大小为[a×a],池化步长为[b],则池化后得到的特征大小为[c×c×K],其中,[c=s-ab+1]。

6) 利用单通道神经网络分别对RGB图片和Depth图片进行测试,获得准确率分别为[fR]和[fD],比重为[α],[β]。

7) 设单通道网络输出RGB与Depth图最后一层神经元分别为[al-1ri]和[al-1di],[klij]代表卷积核,[Wl],[bl]表示所在层的权重与偏置。那么融合层的第[j]层神经元可以由式(14)计算:

8) 将融合后的特征输入残差网络,之后对全连接层网络进行调优,从而完成对整个网络模型的训练。

9) 从样本测试集中获得最终的对象识别精度。

3.2 RCNN网络的调优训练

神经网络在较大的数据集上会表现出较好的性能,所以本文使用在ImageNet数据库上预训练[13]得到一个初始的网络模型。然后分别在这两个分支网络的基础上根据RGB和深度图数据进一步调优。调优训练实际上就是在自己的数据集上继续训练,调优训练是用预训练的模型文件训练好的参数初始化,再利用实验数据集很快达到理想的准确率,本文在预训练的基础上提出一个两步调优法,即分别对卷积网络和特征融合的网络进行调优。

3.3 网络模型可行性分析

提高物体识别准确率的首要任务是寻找有替代性和区别性的特征区域。近些年来的研究大体分为两方面:一方面从图像的编码入手,例如对RGB图分通道处理、对深度图编码、着色[14]、设计新的特征描述子[15]、处理深度图点云模态[16];另一方面,由于深度学习在物体识别方面表现出了巨大作用,所以不断设计新的网络架构去挖掘更高层的数据信息渐渐成为主流。

本文结合这两方面进行了创新优化。首先对深度图进行表面法向量编码,通过SAE网络实现对原始数据降维处理,降低计算复杂度。本文设计了一个12层的网络架构(每个残差块为3层),分流卷积网络保证了各种模态处理的独立性,但网络模型中的优化权重赋值融合使得特征紧密结合。其次,引入残差网络提高了网络的预测性能[17],使网络表现出非常强的鲁棒性。相比几十层甚至上百层的网络,本文在保证结果可靠的基础上同时兼顾网络体系与计算时间适中。在对网络的训练方面,采用预训练的方式可以有效减少训练时间;不同于以前研究者的工作,本文除设计分支网络并优化后,又新增对整个网络全连接层调优,进一步保证了网络的性能。

4 实验与结果分析

4.1 实验数据与平台

常用公开数据集有SUN RGB?D、2D/3D数据集、Washington RGB?D数据集等。Washington RGB?D数据集通过Kinect上的一个三维传感器采集日常生活中的51类物体得到。每一幅图片的分辨率为640×480,在 不同视角下记录了300多种目标41 877幅RGB?D图像,部分RGB?D数据库常用图片如图6所示。

本文算法的实验平台为:Python 2.7,OpenCV 3.4.0,CPU i5?3210M,RAM 8 GB,NVIDIA780显卡。

4.2 实验结果对比

本文在WashingtonRGB?D数据集上采用[K]交叉验证方法。关于SAE网络与RCNN网络的训练方法前文已经说明。设置相同实验条件,每次用300幅图像做训练,用30幅图像做测试,重复10次统计平均识别准确率。表2列出了本文算法与之前出现的部分RGB?D物体识别算法的识别准确率。表2中出现的算法前文已经有介绍。

从表2可以看出:SAE?RCNN在基于RGB的二维图像上与基于RGB?D的三维图像上均获得了最高的识别率。在对RGB?D物体的识别上,相比MS?CRNN算法准确率提升了1.5%;在深度图的识别率上与MS?CRNN算法水平相当。说明新网络模型可以提取物体更多丰富的特征。根据不同特征识别贡献率进行差异化赋值这一策略保证了两种模态之间的紧密联系。数据表明,SAE?RCNN算法取得了更好的识别率,有效地完成了对RGB?D物体的识别。

4.3 误差分析

除了不同算法对实体平均识别率对比外,还利用本文算法测试了10类物体的RGB图、深度图、RGB?D图的识别率,实验设置方法与前文相同,结果如表3所示。从结果可知,本文算法对实体识别已经达到了很好的效果,但是实验中发现仍然存在一些问题。

实验中本文方法出现误判的类别如图7所示。苹果、橙子;梨、柠檬;灯笼椒、西红柿。对此类物体识别准确率不高是因为它们颜色相近,外形轮廓相似,從而导致分类出现偏差。此种情况的本质原因在于没有足够的数据做训练,以至于对它们的区别力不足。本文方法的局限性也在于并未探究出有效的数据增强方法,以至于在数据有限的情况下对类间相似的物体区分力度不足。

5 结 语

本文提出的SAE?RCNN是在SAE算法上进一步扩展新的算法模型得到的深度学习框架。网络采用分层学习的形式。由于不同尺度下反映的特征不同,且RGB特性与深度特征有某种潜在的联系,网络自动学习它们之间的联系比赋予两种不同尺度特征不同的权值进行学习可以更真实地反映三维物体的特性。优化算法的调整也提高了整个网络框架的运行效率与鲁棒性,但本文算法同样暴露了问题,即对类间相似与类内相似物体的判准率不够高。所以有两个方向将会成为下一步研究的重点:

1) 丰富深度图信息,寻找有效的数据增强策略从而提高网络的识别能力;

2) 构建更好的网络模型尝试学习视频流等无监督数据,提高整个网络的学习能力。

注:本文通讯作者为刘晓锋。

参考文献

[1] BO Liefeng, REN Xiaofeng, FOX D. Depth kernel descriptors for object recognition [C]// 2011 IEEE/RSJ International Conference on Intelligent Robots and Systems. San Francisco, CA, USA: IEEE, 2011: 821?826.

[2] BLUM M, SPRINGENBERG J T, WULFING J, et al. A learned feature descriptor for object recognition in RGB?D data [C]// IEEE International Conference on Robotics and Automation. Washington, DC, USA: IEEE Press, 2012: 1298?1303.

[3] BO Liefeng, REN Xiaofeng, FOX D. Unsupervised feature lear?ning for RGB?D based object recognition [M]// DESAI J P, DUDEK G, KHATIB O, et al. Experimental robotics. Switzerland: Springer International Publishing, 2013: 387?402.

[4] SOCHER R, HUVAL B, BHAT B, et al. Convolutional?recursive deep learning for 3D object classification [EB/OL]. [2013?12?09]. https://wenku.baidu.com/view/c1334febd15abe23482f4de3.html#.

[5] 骆健,蒋旻,刘星,等.多尺度卷积递归神经网络的RGB?D物体识别[J].计算机应用研究,2017,34(9):2834?2837.

[6] SONG Lingyun, LIU Jun, QIAN Buyue, et al. A deep multi?modal CNN for multi?instance multi?label image classification [J]. IEEE transactions on image processing, 2018, 27(12): 6025?6038.

[7] BAI Jing, WU Yan, ZHANG Junming, et al. Subset based deep learning for RGB?D object recognition [J]. Neurocompu?ting, 2015, 165: 280?292.

[8] ZHANG Yan, ZHANG Erhu, CHEN Wanjun. Deep neural network for halftone image classification based on sparse auto?encoder [J]. Engineering applications of artificial intelligence, 2016, 50: 245?255.

[9] KINGMA D P, BA J L. Adam: a method for stochastic optimization [EB/OL]. [2018?12?30]. http://www.docin.com/p?2163732296.html.

[10] HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition [C]// 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA: IEEE, 2016: 770?778.

[11] ZHOU Feng,HU Yong, SHEN Xukun. MSANet: multimodal self?augmentation and adversarial network for RGB?D object recognition [J]. The visual computer, 2019, 35(11): 1583?1594.

[12] SONG Hangke, LIU Zhi, DU Huan, et al. Depth?aware salient object detection and segmentation via multiscale discriminative saliency fusion and bootstrap learning [J]. IEEE transactions on image processing, 2017, 26(9): 4204?4216.

[13] WANG Anran, LU Jiwen, CAI Jianfei, et al. Large?margin multimodal deep learning for RGB?D object recognition [J]. IEEE transactions on multimedia, 2015, 17(11): 1887?1898.

[14] EITEL A, SPRINGENBERG J T, SPINELLO L, et al. Multimodal deep learning for robust RGB?D object recognition [C]// IEEE/RSJ International Conference on Intelligent Robots and Systems. Hamburg, Germany: IEEE Press, 2015: 681?687.

[15] ROSTAMI R, BASHIRI F S, ROSTAMI B, et al. A survey on data?driven 3D shape descriptors [J]. Computer graphics forum, 2018, 38(1): 356?393.

[16] GUPTA S, GIRSHICK R B, ARBELAEZ P, et al. Learning rich features from RGB?D images for object detection and segmentation [EB/OL]. [2015?11?01]. https://wenku.baidu.com/view/d8e02f65fab069dc51220128.html.

[17] REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Object detection networks on convolutional feature maps [J]. IEEE tran?sactions on pattern analysis & machine intelligence, 2017, 39(7): 1476?1481.