复杂背景下昆虫图像的快速分割与识别

陈冬梅 张赫 魏凯华 袁琳 金晶 吴开华

摘要:昆虫图像分割是昆虫图像的识别与鉴定的重点和难点。目前,昆虫分割算法速度慢、过程复杂且大多数只针对于单一背景图像。为了更准确高效地实现昆虫图像的前景背景图像分离,提出一种基于逐像素聚类的端对端的昆虫图像分割方法,能够同时实现复杂背景下的昆虫图像分割与昆虫种类识别。采用覆盖5个昆虫目级阶元的37种实际场景下拍摄的昆虫图像作为研究对象,首先通过试验确定所提模型的最优参数设置,选择ResNet101作为分割模型的主干特征提取网络,在IoU取0.50时,其掩膜分支平均准确度均值、定位平均准确度均值及平均识别误差率分别为93.15%、95.06%和12.12%,分割每张昆虫图像仅需0.080 s,所提模型能够同步实现复杂背景下昆虫目标与背景的快速准确分割并进行分类。

关键词:昆虫图像;复杂背景;实时性;实例分割;识别分类

中图分类号:TP391.41 文献标志码: A

文章编号:1002-1302(2021)24-0195-10

收稿日期:2021-06-01

基金项目:浙江省基础公益研究计划(编号:LGN19F030001);浙江省农业重大技术协同推广计划项目(编号:2020XTTGCY04-02、2020XTTGCY01-05);浙江省基础公益研究计划(编号:LGN19D010001、LGF20F050004、LQ16F050002);国家自然科学基金(编号:61705056);浙江省教育厅科研计划(编号:Y201533689);中国博士后科学基金(编号:2020M681848)。

作者简介:陈冬梅(1988—),女,山东烟台人,博士,副教授,主要从事图像分析处理在农业领域的研究。E-mail:chendonmei@hdu.edu.cn。

通信作者:吴开华,博士,教授,主要从事光电检测技术及仪器、在线检测技术及仪器、无人机技术等方面的研究工作。E-mail:wukaihua@hdu.edu.cn。

庞大的昆虫家族是大自然生物链中的重要一环,占据着节肢动物门的最大一纲。这些生物形态各异,数量惊人,分布又极其广泛,迄今发现的昆虫有120多万种,占整个动物界种类的80%左右[1]。其中,绝大多数昆虫以植物为寄主,通过取食作物获取营养,会造成农作物的产量和品质显著降低,成为制约农业生产的重要因素之一[2]。因此,研究昆虫的规律,找出其中可供利用的特性,对于农业发展,尤其是害虫防治策略的设计和益虫的保护与利用都具有十分重要的意义。在昆虫研究中,昆虫的识别既是昆虫研究和害虫防治的基础,也是昆虫研究的重要内容之一[3]。

传统的昆虫识别是通过分类学专家或具有昆虫分类知识的技术人员对昆虫进行种类的鉴定[4]。但现有的分类学专家和掌握分类的技术人员无论在分布还是在数目上均难以满足时下正呈现扩大倾向的各类实际场景需求。同时,昆虫图像识别由于昆虫本身纹理丰富而被视为一类相对困难的图像细粒度识别问题。当识别种类及数量较多时,群体所呈现出的种间相似性、种内多样性以及不同姿态的差异会进一步增加数据复杂度,此类图像的区分信息更多地集中在像素层面,用人为构建并筛选的特征对图像进行表达很容易丢失其中的细节[5]。

信息技术的快速发展使得计算机代替人脑进行判别的方法成为了可能,以计算机为基础的昆虫自动识别方法可以处理最常见的昆虫图像数据,先将采集的昆虫图像进行图像处理和背景前景分离,再使用图像识别方法进行类别分析。目前,基于计算机的昆虫图像分割主要依赖于传统图像分割方法,如基于阈值的分割方法、基于边缘的分割方法、基于区域的分割方法以及基于数学形态学的分割方法等[6]。Mele等提出了基于全局阈值与局部种子区域生长法相结合的昆虫图像分割方法[7]。刘晓静等根据复杂背景下的昆虫彩色图像的特点,采用了一种融合颜色和空间信息的静态图像压缩(JSEG)分割算法[8]。一方面,这些研究只利用图片中边缘、颜色、纹理等低级特征,分割结果并不精确,同时对于图像的要求较高,且对于昆虫的分类大多是在分割结果的基础上进行,整个过程须要分步进行,存在效率低、适用性差等缺点。另一方面,目前多数研究是将某领域中较成熟的图像分割算法直接或稍加改进后,在较小的测试集或某张图像上进行仿真测试,很少对大样本的图像做测试,不能充分说明方法的可行性[9]。自然环境下昆虫种类繁多,实际场景下获取的昆虫图像背景复杂,有些昆虫目标与背景相似度高,这使得仅依靠图片中低级特征去解决复杂背景下昆虫目标的分割及识别分类存在较大的局限性。

近年來,随着机器学习的迅速发展,国内外学者越来越关注以机器学习和深度学习算法为基础的图像识别分割。在昆虫分割方面,杨信廷等以粉虱和蓟马为例,提出了一种基于边缘检测算子分割和支持向量机的温室粉虱和蓟马诱虫板的图像识别算法,实现温室害虫的诱虫板图像识别[10]。王卫民等针对害虫图像分割和计数存在的问题,在U-Net基础上改进得到了Insect-Net模型用于昆虫的识别和计数[11]。竺乐庆等基于全卷积网络实现了鳞翅目标本图像前背景的自动分割[12]。Pang等针对传统分类器对图像要求高且分类不准确等问题,基于F-RCN对昆虫进行识别[13]。上述昆虫分割方法仅在实验室环境无背景或单一背景的昆虫图像上具有较好的分割效果。对于自然环境下复杂背景的昆虫图像的分割及识别分类效果还有待进一步探索。

针对自然环境下昆虫图像分割和识别的特殊性和复杂性,以及目前昆虫图像分割及识别的不足,本试验提出逐像素聚类的端对端的昆虫图像分割方法,拟同时实现复杂背景下的昆虫图像背景分离和昆虫识别,本研究主要包括材料与方法、试验与结果以及总结与展望。

1 材料与方法

1.1 图像数据与试验环境

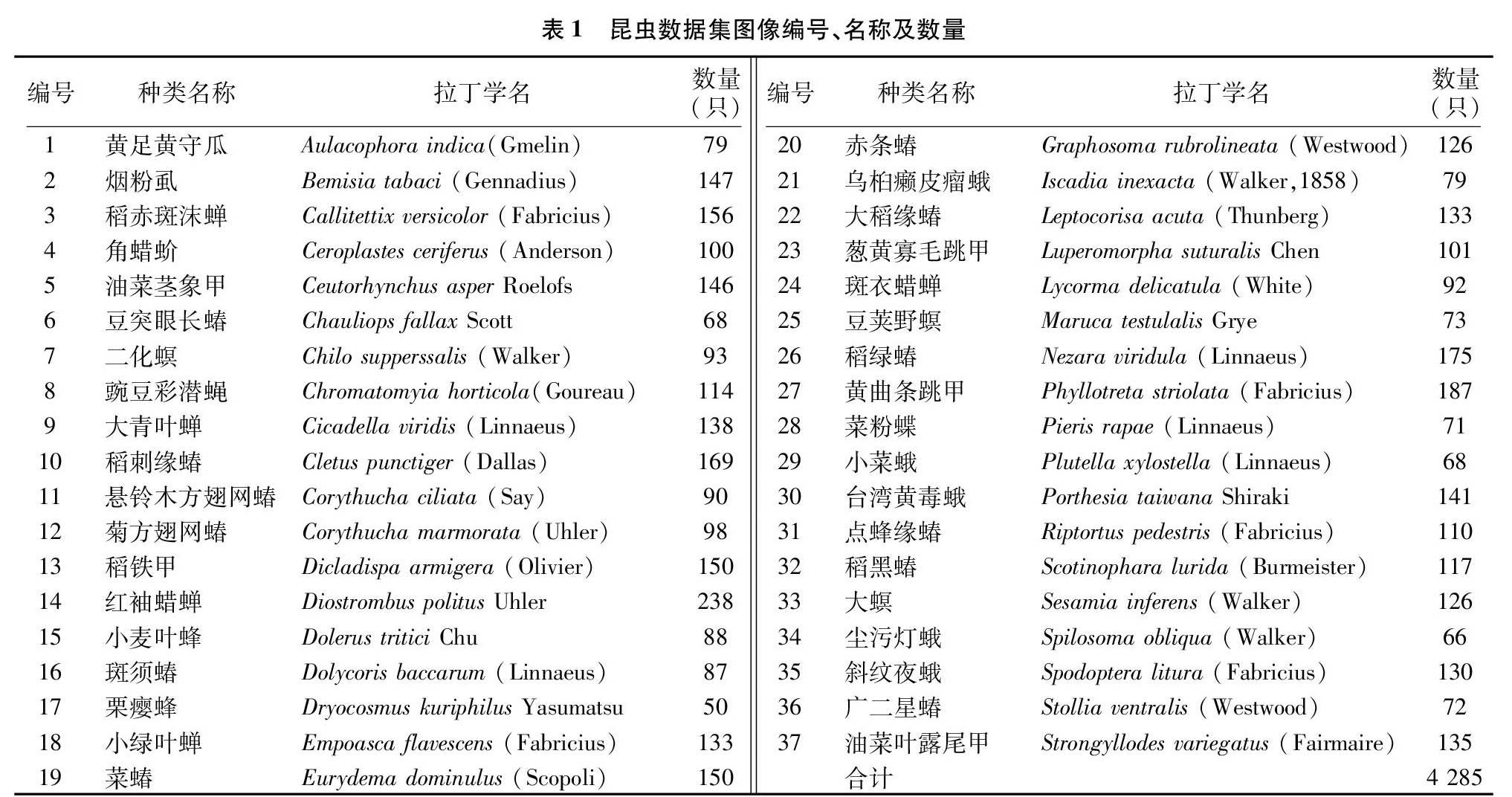

本试验的试验图像数据涵盖5个目级阶元下的37类共4 285张昆虫图像[14-15]。所有图像都是通过数码相机(佳能、尼康和移动设备等)捕获的。为了消除光照变化的潜在负面影响,所有样品图像在作物田间情况下均采用统一的光照设置进行预处理。本试验采用图像标注软件Labelme[16]以VOC格式对图像添加掩膜标签,并生成模型训练所需的掩膜图片,数据集中每类昆虫图像及其对应的掩膜图像示例如图1所示。图1中对应每种昆虫的编号、种类名称及数量均在表1中详细列出。试验在杭州电子科技大学高性能计算机平台上进行。该平台操作系统为Windows 10,平台采用单块型号为NVDIA GTX 1080Ti的图形处理器,搭载Intel(R) Core(TM) i7-8700k的CPU,内存为11 G。

1.2 昆虫图像分割方法概述

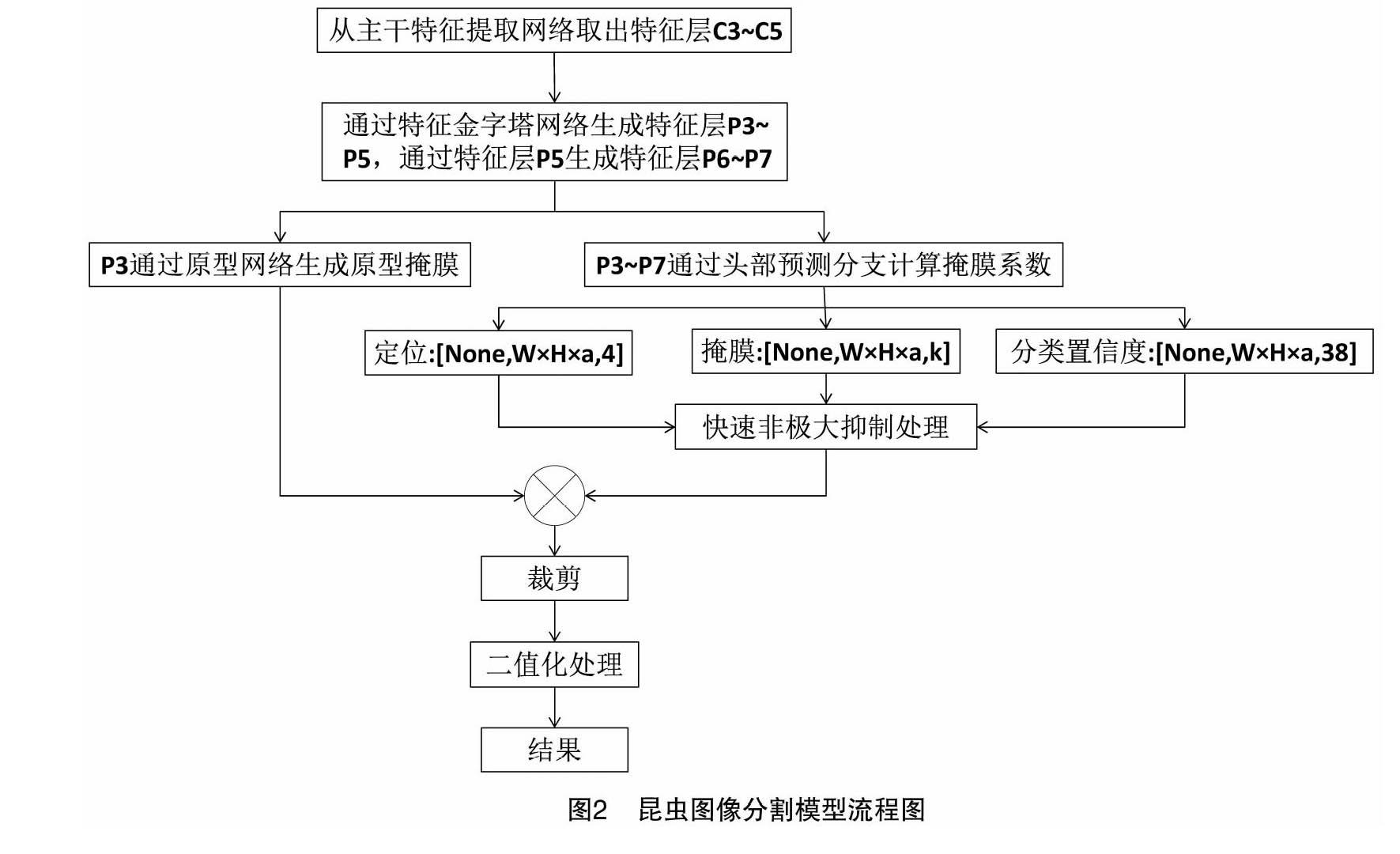

本研究拟使用基于YOLCAT++[17]的昆虫分割模型,其算法整体流程如图2所示。首先,昆虫原始图像通过主干特征提取网络得到特征图,然后C3~C5层特征图通过特征金字塔网络FPN[18]得到P3~P5层特征图。同时为消除混叠效应,对P3~P5层进行卷积得到新的P3~P5层,P6、P7层是由P5层卷积得到。模型将分割过程拆分为头部预测和原型网络2个并行的分支,将2个分支的输出合并获得最终的掩膜。笔者使用快速非极大抑制对每个实例预测得到的掩膜进行处理。通过裁剪将边界外的掩膜清零,其中训练阶段的边界是真实边框,评估阶段的边界是预测的边框。最后,以0.5为阈值对生成的掩膜进行图像二值化处理得到最终结果。

1.2.1 主干特征提取网络结构 目前,主流的图像识别算法主要是利用卷积神经网络(CNN)自动提取图像特征,而后依据提取到的特征进行目标的提取和分类。特征金字塔网络是一种通用结构,它可以与VGG[19]、ResNet[20]、Mobilenets[21]、Darknet[22]等不同的骨架网络组合使用。本研究分别使用了ResNet50、ResNet101与FPN组合的结构,具体结构如图3所示。从图3可以看出,ResNet-FPN分为3个部分,分别是自下而上连接部分、自下而上连接部分及横向连接部分。其中,自下而上部分是以ResNet作为骨架结构进行特征的提取,ResNet分为5个不同的阶段,其中将阶段3到阶段5各层最后输出的一层特征分别定义为C3、C4、C5。自上而下是从最高层开始以最近邻法进行上采样。横向连接是利用256×1×1的卷积核对C3~C5各层进行卷积操作,不经过激活函数直接得到256通道的特征图输出,将其与上采样得到的特征图进行加和得到融合特征图。然后用3×3的卷积核对融合后的特征图进行卷积,以便消除混叠效应。最终得到 P3~P5特征层。特征层P6则是P5经过步长為2的最大池化下采样得到,特征层P7则是P6经过步长为2的最大池化下采样得到。 其中, P3用于输入到原型网络分支,P3~P7特征层作为后续头部预测分支的输入。

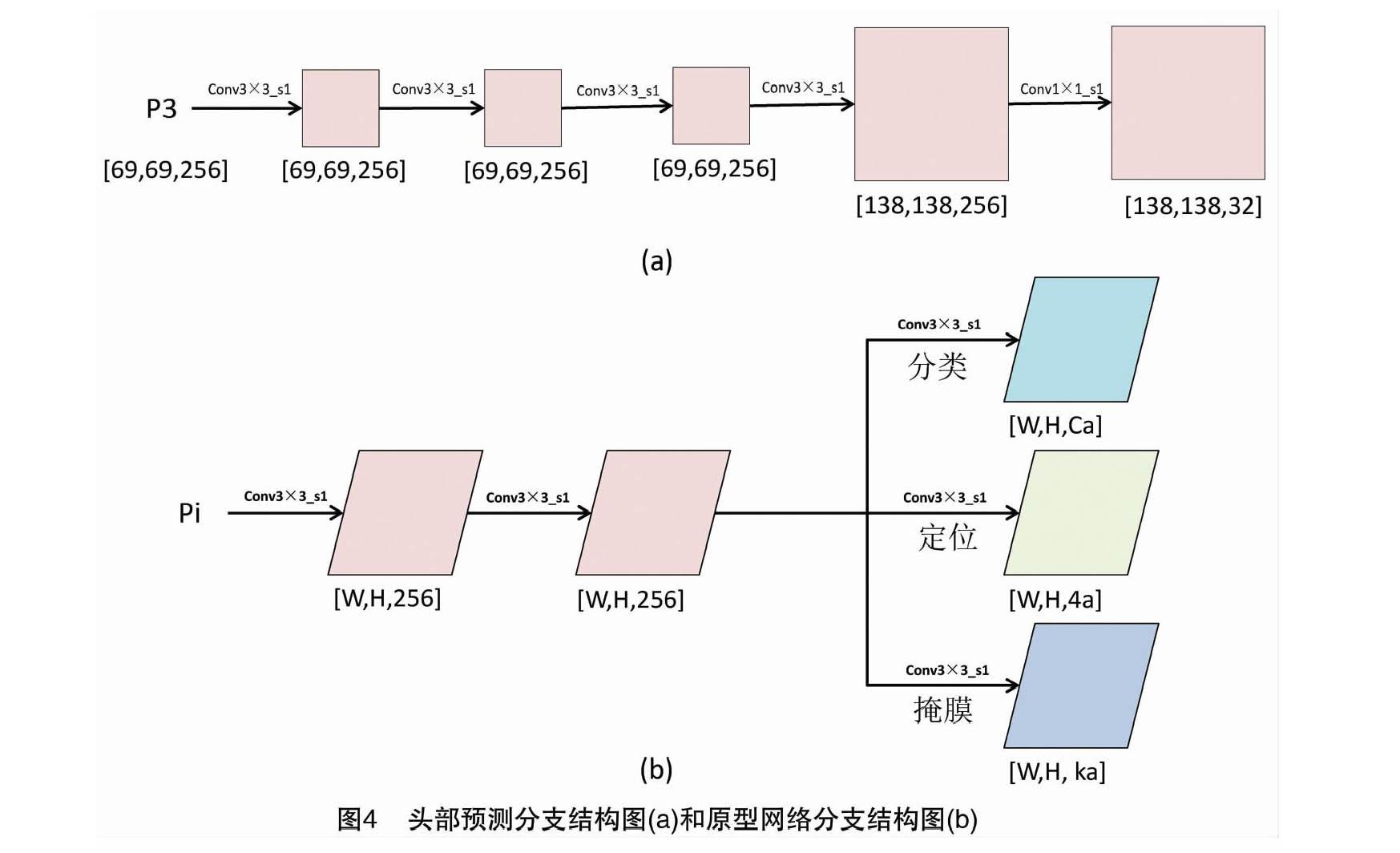

1.2.2 原型掩膜及系数计算 原型网络是一种简单、高效的学习方式,其基本思路是对于每一个分类来创建一个原型表示。模型中原型网络分支由若干卷积层组成,其结构如图4-a所示。以P3层作为输入进入到原型网络分支,利用全卷积神经网络产生一系列与图像大小一致的原型掩膜,这一过程不依赖任一特定实例且不依赖重池化,因此产生了质量非常高且稳定性更好的掩码。P3层昆虫特征图经过卷积层卷积后输出维度为138×138×32的掩膜,即32个大小是138×138的原型掩膜。

为了提高速度,达到实时分割的目的,引入共享卷积网络,在RetinaNet[23]的基础上改进得到头部预测分支,其网络结构如图4-b所示。以P3~P7作为输入进入到预测头,然后有1个分支输出目标位置,1个分支输出掩膜系数,1个分支输出分类的置信率,即在原本目标检测分支的基础上添加一个掩膜输出,对每个锚框来预测掩膜系数,也就是对实例的表示编码为原型域的表达。所以决定目标的有4(位置)+k(掩膜系数)+37(分类置信率)个参数。将预测头分支得到的掩膜系数和原型分支得到的原型掩膜做矩阵乘法,得到图像中每一个目标物体的掩膜。

以P3层昆虫特征图为例进行说明,P3的维度是69×69×256,则P3层生成的锚框个数是14 283(69×69×3=14 283)。然后头部预测分支将其分为3个分支输出,分别是 (1)类别置信度,本数据集共有38类(包括背景),所以其维度为542 754(P3层生成的锚框个数×38);(2)位置偏移,维度为 57 132(P3层生成的锚框个数×4);(3)掩膜置信度,维度为457 056(P3层生成的锚框个数×32)。对P4~P7进行相同的操作,最后将这些结果拼接起来,标记共有19 248,本数据集共有38类(包括背景),所以全部类别的置信度维度为731 424(标记个数×38);全部位置偏移维度为76 992(标记个数×4);全部掩膜的置信度维度为615 936(标记个数×32)。

同时,在模型中引入了可变形卷积[24],即采用自由形式的采样代替了传统的刚性网格采样,将ResNet C3~C5层中的各个3×3标准卷积每隔3个卷积层换成一个3×3可变形卷积。因此,相比标准卷积,可变形卷积通过学习位置偏移得到更符合待检目标形状和尺寸的采样点。在锚框策略上,本研究采用的是保持比例[1,1/2,2]不变,把FPN每一层的特征尺寸数目增加3倍。

1.3 分割结果评价指标

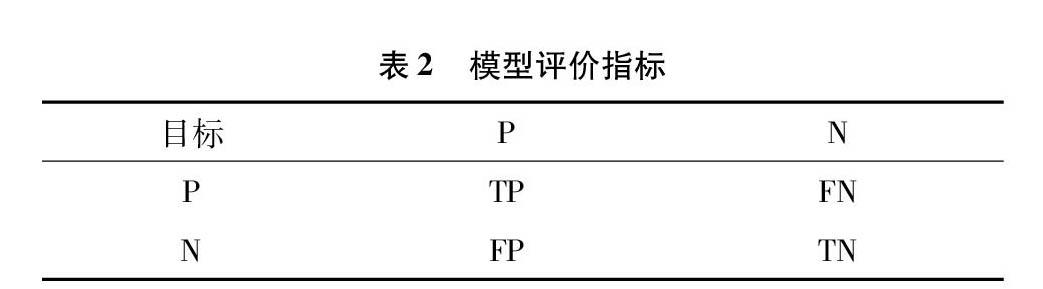

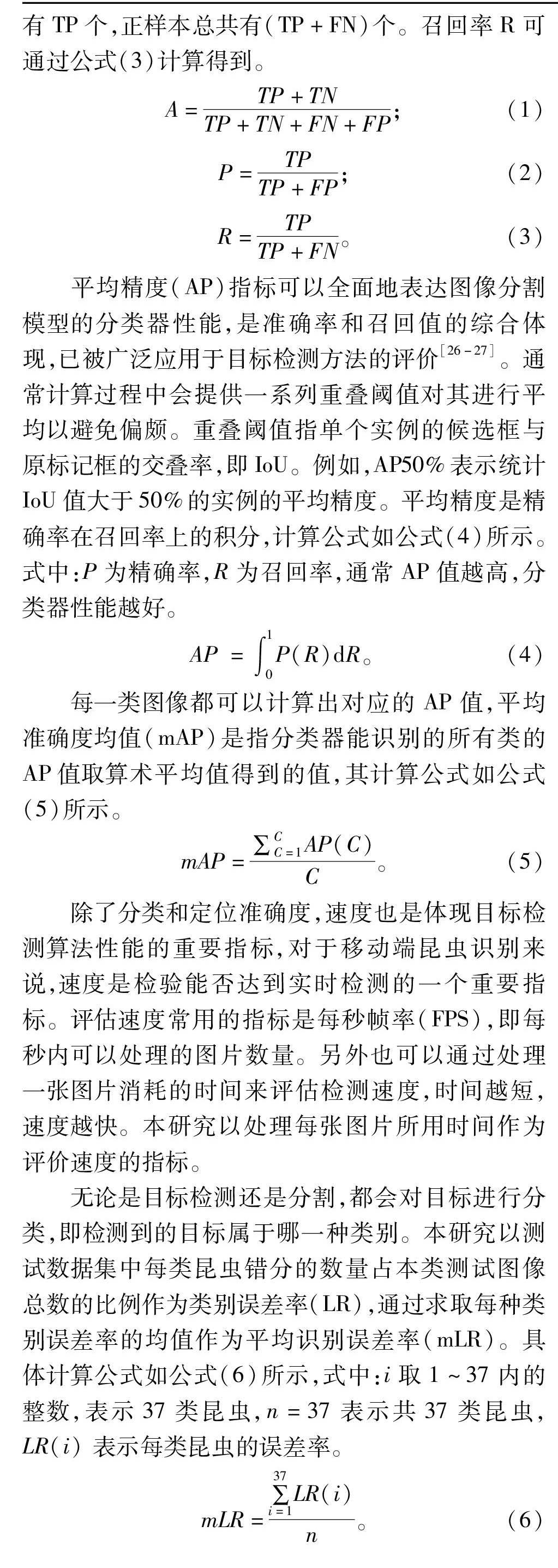

图像分割的评价指标是从文献检索演变而来的,将图像分割的像素点属于感兴趣区域的可能性与文本的相关性相关联,从而将文本检索中的性能评价指标应用到图像分割[25]。目标一般分为2类(正例和负例,分别用P和N表示)。模型评价指标一般由TP(true positive)、FP(false positive)、FN(false negative)及TN(true negative)4个参数表示(表2)。其中,TP表示把正例判为正例的数目,FN表示把正例判为负例的数目,FP表示把负例判为正例的数目,TN表示把负例判为负例的数目。

准确率是指判断正确的情况占所有情况的比例,其中判断正确的总共有(TP+TN)个,准确率A可通过公式(1)计算得到。精确率是指把正的预测为正的个数占所有预测为正的样本的比例。预测为正的样本总共有(TP+FP)个,精确率P可由公式(2)计算得到。召回率是指所有正样本中被预测正确的占所有正样本的比例,其中正样本预测为正的有TP个,正样本总共有(TP+FN)个。召回率R可通过公式(3)计算得到。

A=TP+TNTP+TN+FN+FP;(1)

P=TPTP+FP;(2)

R=TPTP+FN。(3)

平均精度(AP)指标可以全面地表达图像分割模型的分类器性能,是准确率和召回值的综合体现,已被广泛应用于目标检测方法的评价[26-27]。通常计算过程中会提供一系列重叠阈值对其进行平均以避免偏颇。重叠阈值指单个实例的候选框与原标记框的交叠率,即IoU。例如,AP50%表示统计IoU值大于50%的实例的平均精度。平均精度是精确率在召回率上的积分,计算公式如公式(4)所示。式中:P为精确率,R为召回率,通常AP值越高,分类器性能越好。

AP=∫10P(R)dR。(4)

每一类图像都可以计算出对应的AP值,平均准确度均值(mAP)是指分类器能识别的所有类的AP值取算术平均值得到的值,其计算公式如公式(5)所示。

mAP=∑CC=1AP(C)C。(5)

除了分类和定位准确度,速度也是体现目标检测算法性能的重要指标,对于移动端昆虫识别来说,速度是检验能否达到实时检测的一个重要指标。评估速度常用的指标是每秒帧率(FPS),即每秒内可以处理的图片数量。另外也可以通过处理一张图片消耗的时间来评估检测速度,时间越短,速度越快。本研究以处理每张图片所用时间作为评价速度的指标。

无论是目标检测还是分割,都会对目标进行分类,即检测到的目标属于哪一种类别。本研究以测试数据集中每类昆虫错分的数量占本类测试图像总数的比例作为类别误差率(LR),通过求取每种类别误差率的均值作为平均识别误差率(mLR)。具体计算公式如公式(6)所示,式中:i取1~37内的整数,表示37类昆虫,n=37表示共37类昆虫,LR(i) 表示每类昆虫的误差率。

mLR=∑37i=1LR(i)n。(6)

2 试验与结果

在试验中,对超参数进行了统一设置,其中batch size设置为4,学习率设置为0.001,使用了动量的随机梯度下降(SGDM)优化算法[28],交叉验证的L2正则化参数设置为0.000 5。

2.1 主干特征提取网络对比试验

主干特征提取网络是特征提取的重要组件,其复杂程度很大程度上決定了目标分割算法的耗时,且模型的性能很大程度上依赖于主干特征提取网络。本研究分别以ResNet50和ResNet101作为主干特征提取网络对昆虫分割模型进行试验。首先,通过判断训练总损失曲线、定位损失曲线、分类损失曲线及掩膜损失曲线是否收敛来确定不同主干特征提取网络对于分割模型是否具有良好的拟合泛化能力,在确定拟合泛化能力之后,通过比较不同主干下模型的平均准确度均值、平均识别误差率、训练时间及测试每张昆虫图片所耗时间等4项性能评价指标,进而确定分割效果最优的主干特征提取网络。分别以ResNet50和ResNet101作为主干特征提取网络,对模型进行训练和测试。图5是模型在不同主干特征提取网络下模型各类损失训练曲线,可以看出,2个模型在训练和验证的迭代过程中,分类、边框及掩膜的损失值均呈整体下降趋势,且最终达到收敛。说明2种主干特征提取网络组成的分割模型均具有较强的拟合及泛化能力。在确定模型的拟合泛化能力之后,对不同主干下模型的整体性能进行分析。表3为模型分别以ResNet50、ResNet101作为主干特征提取网络的条件下,IoU取0.50~0.95阈值时模型边框及掩膜的平均准确度均值。随着IoU值的递增,定位及掩膜的mAP值逐渐变小。由表3可知,在IoU取0.50时,平均准确度均值最大。由表4可知,IoU取0.50时,以ResNet50作为主干特征提取网络得到的掩膜平均准确度均值稍高于ResNet101,且训练时间和测试每张图片消耗的时间均少于ResNet101,但分类平均识别误差率比ResNet101高3.48百分点,因此对模型而言,以ResNet101作为主干特征提取网络时得到的整体性能更佳。

2.2 模型与Mask R-CNN分割性能对比试验

在实现分割与分类的同时,如何提高图像的识别速度是本研究的重点之一。在以Mask R-CNN为代表的双阶段实例分割方法中模板掩膜的生成与特征定位的准确与否有着密切的关联,现有的方法是通过对特征进行“repooling”(RoI pooling/Align)使其与原始图像位置对准,之后将新的定位特征送入掩膜分支进行预测,这个过程须要分步骤进行,因此很难加速。通过对本研究采用的单阶段分割模型与双阶段分割模型Mask R-CNN进行比较,分析两者在分割效果及效率上的性能。

对于Mask R-CNN模型,同样分别以ResNet50和ResNet101作为主干特征提取网络进行试验。首先通过判断训练总损失曲线、定位损失曲线、分类损失曲线及掩膜损失曲线是否收敛来确定不同主干特征提取网络对于Mask R-CNN模型是否具有良好的拟合泛化能力,在确定拟合泛化能力之后,通过比较不同主干下模型的平均准确度均值、平均识别误差率、训练时间及测试每张昆虫图片所耗时间等4项性能评价指标,进而确定分割效果最优的主干特征提取网络。然后将得到的结果与基于本研究网络模型得到的结果进行对比分析。

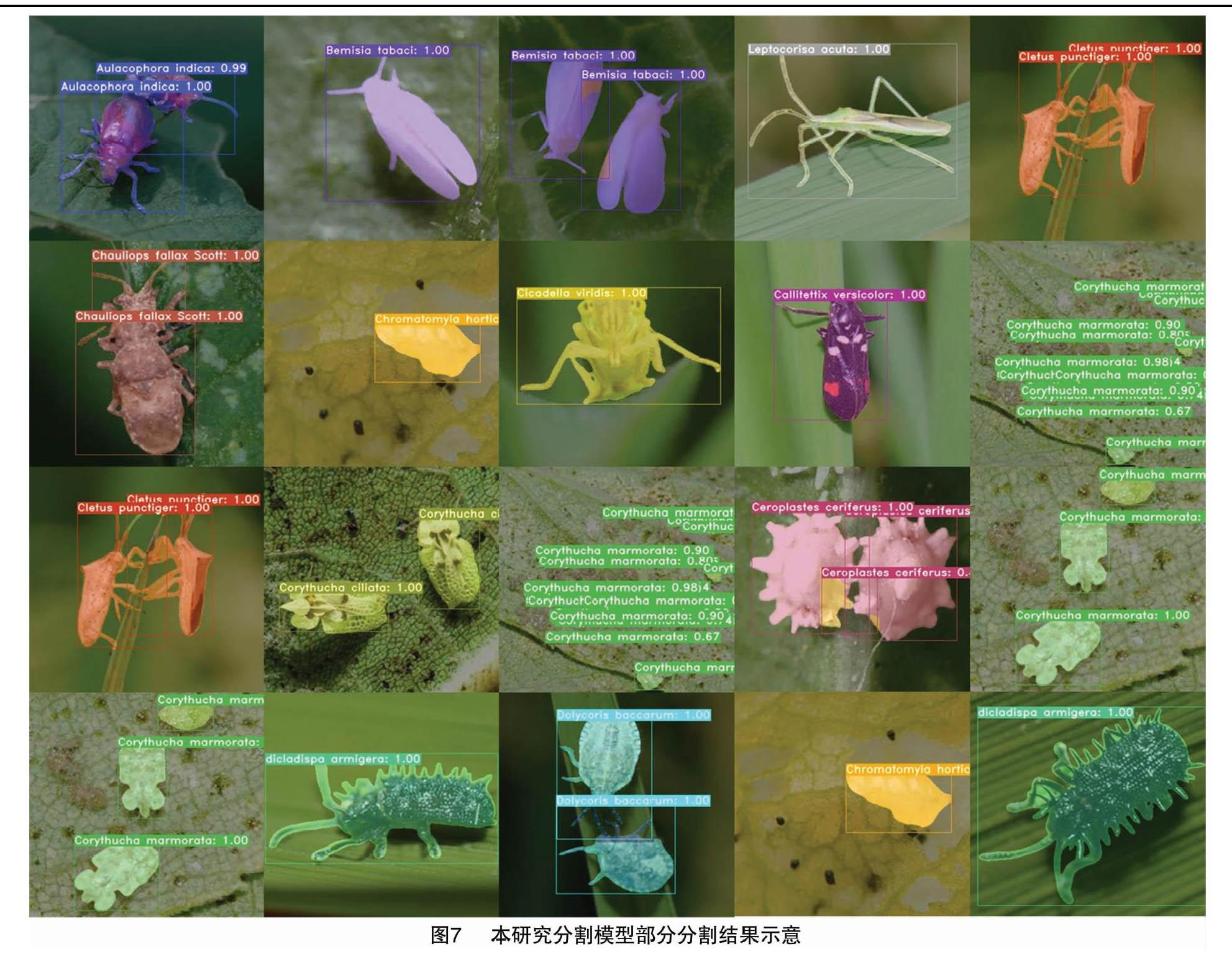

对Mask R-CNN及本研究模型在掩膜分支的性能进行分析比较。不同模型在主干特征提取网络分别为ResNet50及ResNet101的情况下,IoU取0.50时掩膜平均准确度均值、平均识别误差率、训练时间及测试每张昆虫图片所耗时间4项性能指标的值如表5所示。由表5可知,本研究所用模型在训练时所耗时间要远远多于Mask R-CNN,但是测试每张昆虫图片所耗时间要远少于Mask R-CNN。其中,本研究采用的模型以ResNet50作为主干特征提取网络时测试每张昆虫图片所耗时间要少于以ResNet101作为主干特征提取网络时的时间。在平均识别误差率方面,以ResNet50作为主干特征提取网络的Mask R-CNN比以ResNet50作为主干特征提取网络的分割模型低7.03百分点;以ResNet101作为主干特征提取网络的分割模型与以ResNet101作为主干特征提取网络的Mask R-CNN相当。在平均准确度均值方面,无论是以ResNet50还是以ResNet101作为主干特征提取网络,基于本研究模型得到的平均准确度均值均优于Mask R-CNN。综合上述分析,以ResNet101作为主干特征提取网络时本研究采用的模型具有较好的分割性能,在保证识别误差率和分割精度的基础上,大大减少了分割消耗的时间。图6、图7所示分别是基于本研究模型和基于Mask R-CNN得到的部分分割结果,通过对比可以看出,基于本研究模型得到的掩膜结果要明显优于Mask R-CNN。

2.3 分割异常分析

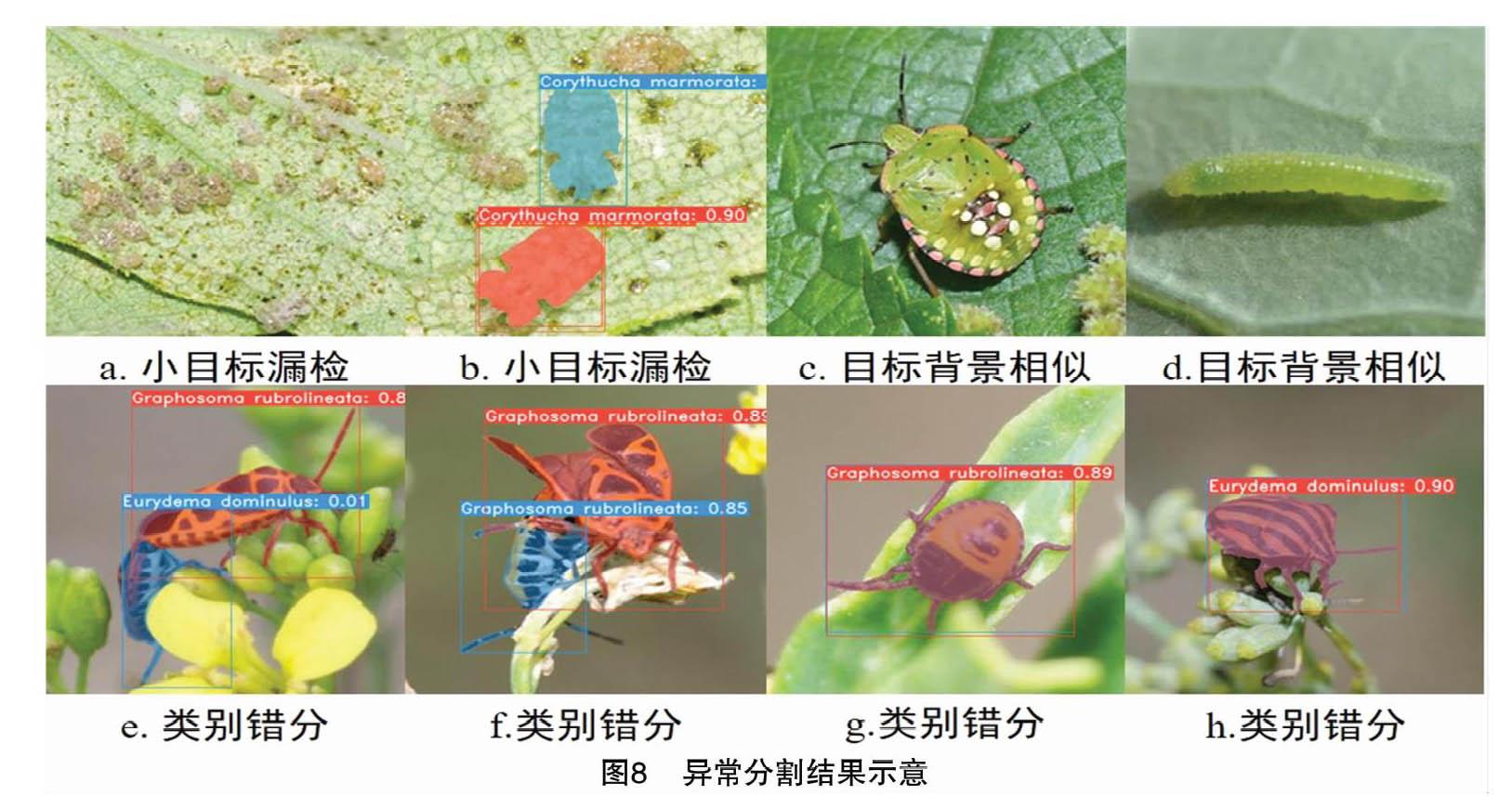

在分割结果中存在少数异常的情况,存在异常结果的昆虫种类主要包括菊方翅网蝽、菜蝽、赤条蝽、稻绿蝽和小菜蛾等。虫害图像分割异常主要包括小目标漏检、图像中目标与背景相似导致目标无法识别及类别错分等3种情况。图8-a、图8-b是小目标未被检测到的示例,本研究分割模型是基于锚框的,大目标的检测主要依靠小的特征图,而小目标的检测依赖于较大的特征图,大特征图来自于浅层网络,浅层网络提取到的特征主要是一些浅层特征,小目标的像素特征少,检测往往更依赖于浅层特征,由于所能得到的特征信息过少造成小目标漏检的结果。图8-c、图8-d是由于图像目标与背景相似导致网络提取不到足够的信息对目标进行分类、定位及分割,从而造成结果异常。图8-e、图8-f、图8-g、图8-h是种类错分的示意图,由于图像目标之间存在较大的相似性,在卷积网络提取特征的过程中,不同种类之间可用于区分的信息较少导致类别出错,测试结果中错分主要包括2个种类,将菜蝽和赤条蝽错分。

3 总结与展望

本研究以作物常见昆虫图像为研究目标,基于单阶段实例分割模型设计了复杂背景下作物昆虫快速识别分割方法,分别对不同主干特征提取网络单阶段实例分割算法及双阶段实例分割算法Mask R-CNN进行试验及性能的对比分析,结果表明,以ResNet101作为主干特征提取网络时,本研究采用的模型具有最好的分割性能,在IoU取0.50时,其掩膜分支平均准确度均值、定位平均准确度均值及平均识别误差率分别为93.15%、95.06%和12.12%,分割每张昆虫图像仅需0.080 s。与双阶段分割算法Mask R-CNN相比,本研究采用的单阶段分割算法在保证识别误差率及精确度的同时,极大地缩减了分割图片消耗的时间。

本方法初步实现了昆虫图片的识别与分割。虽然在识别误差率上仍须要进一步优化提高,但是与之前的研究相比,该方法实现了复杂背景下昆虫目标的分割,同时大大缩减了昆虫目标分割所消耗的时间,这对于实现昆虫图像的实时性分割具有重要意义,且对于特定场景下昆虫的识别及分割具有参考价值。

目前,病虫害分割主要是利用温室或田间地头的摄像头、相机等设备采集作物叶片上的虫害图像,然后将图像上传到远端服务器进行相关图像处理[10]。在后续相关工作中,对于分割模型,在保证分割准确率及分割效率的情况下,可以通过简化模型大小,将模型应用到移动端。其次,可以开发对应的虫害计数软件应用,这样农户可以随时对作物虫害进行识别分类及计数,进而对虫情进行实时判断并采取对应的措施。

本研究所用数据集大多是单目标图像,对于昆虫计数,在后续研究中需要增加图像的复杂性,进而通过分割结果得到计数结果。此外,在对于多种类的昆虫检测及分割达到相对较好效果的条件下,将算法模型应用于特定应用场景下昆虫的检测及分割还有待进一步研究,相应的昆虫图像数据集有待进一步健全。

参考文献:

[1]阎锡海,王延锋,李延清. 昆虫起源、进化及其原因模糊性研究[J]. 延安大学学报(自然科学版),2003,22(1):81-84.

[2]吳孔明. 我国农业昆虫学的现状及发展策略[J]. 植物保护,2010,36(2):1-4.

[3]陈学新. 21世纪我国害虫生物防治研究的进展、问题与展望[J]. 昆虫知识,2010,47(4):615-625.

[4]姚 青,吕 军,杨保军,等. 基于图像的昆虫自动识别与计数研究进展[J]. 中国农业科学,2011,44(14):2886-2899.

[5]刘子毅.基于图谱特征分析的农业虫害检测方法研究[D]. 杭州:浙江大学,2017.

[6]华敏杰.基于深度学习的图像语义分割算法概述[J]. 中国战略新兴产业,2018(4):120.

[7]Mele K.Insect soup challenge:segmentation,counting,and simple classification[C]//2013 IEEE International Conference on Computer Vision Workshops.Sydney,NSW,Australia:IEEE,2013:168-171.

[8]刘晓静,耿国华,周明全,等. 一种基于复杂背景下的昆虫彩色图像分割方法[J]. 计算机应用与软件,2008,25(11):37-38,88.

[9]王江宁,纪力强. 昆虫图像分割方法及其应用[J]. 昆虫学报,2011,54(2):211-217.

[10]杨信廷,刘蒙蒙,许建平,等. 自动监测装置用温室粉虱和蓟马成虫图像分割识别算法[J]. 农业工程学报,2018,34(1):164-170.

[11]王卫民,符首夫,顾榕蓉,等. 基于卷积神经网络的虫情图像分割和计数方法[J]. 计算机工程与科学,2020,42(1):110-116.

[12]竺乐庆,马梦园,张 真,等. 基于全卷积网络的鳞翅目标本图像前背景自动分割方法研究[J]. 昆虫学报,2018,61(2):255-262.

[13]Pang H W,Yang P P,Chen X L,et al. Insect recognition under natural scenes using R-FCN with anchor boxes estimation[C]//International Conference on Image and Graphics.Springer,Cham,2019:689-701.

[14]Xie C J,Zhang J E,Li R,et al. Automatic classification for field crop insects via multiple-task sparse representation and multiple-kernel learning[J]. Computers and Electronics in Agriculture,2015,119:123-132.

[15]Xie C J,Wang R J,Zhang J E,et al. Multi-level learning features for automatic classification of field crop pests[J]. Computers and Electronics in Agriculture,2018,152:233-241.

[16]Russell B C,Torralba A,Murphy K P,et al. LabelMe:a database and web-based tool for image annotation[J]. International Journal of Computer Vision,2008,77(1/2/3):157-173.

[17]Bolya D,Zhou C,Xiao F,et al. YOLACT++:better real-time instance segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,99:1.

[18]Lin T Y,Dollár P,Girshick R,et al. Feature pyramid networks for object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu,HI,USA:IEEE,2017:936-944.

[19]Simonyan K,Zisserman A. Very deep convolutional networks for large-scale image recognition[J]. Computer Science,2014:1409-1556.

[20]He K M,Gkioxari G,Dollár P,et al. Mask R-CNN[C]//Proceedings of the IEEE international conference on computer vision.Venice,Italy:IEEE,2017:2961-2969.

[21]Howard A G,Zhu M L,Chen B,et al. MobileNets:efficient convolutional neural networks for mobile vision applications[J]. Computer Vision & Pattern Recognition,2017:1704-4861.

[22]Redmon J,Divvala S,Girshick R,et al. You only look once:unified,real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Las Vegas,NV,USA:IEEE,2016:779-788.

[23]Lin T Y,Goyal P,Girshick R,et al. Focal loss for dense object detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,42(2):318-327.

[24]Zhu X Z,Hu H,Lin S,et al. Deformable ConvNets V2:more deformable,better results[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Long Beach,CA,USA:IEEE,2019:9300-9308.

[25]鄧 颖,吴华瑞,朱华吉. 基于实例分割的柑橘花朵识别及花量统计[J]. 农业工程学报,2020,36(7):200-207.

[26]Kapoor A J,Fan H,Sardar M S.Intelligent detection using convolutional neural network[J]. Earth and Environmental Science,2019,234:12061.

[27]Revaud J,Almazan J,Rezende R,et al. Learning with average precision:training image retrieval with a listwise loss[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV).Seoul,Korea (South):IEEE,2019:5106-5115.

[28]Theodoridis S. Stochastic gradient descent[M]//Machine learning. Amsterdam:Elsevier,2015:161-231.