基于多特征融合的防爆自动导引车避障方法研究

万伟 刘子龙 孙帅 张莹

摘 要:为解决在工厂环境中防爆自动导引车(Automated Guided Vehicle,AGV)难以在不同光照条件下实现行人检测的问题,本文提出将“结构光+双目视觉相机”的图像采集方案应用于爆炸性危险环境。针对传统的基于RGB(代表红、绿、蓝三个通道的颜色)图像的HOG-LBP(Histogram of Oriented Gradient-Local Binary Pattern)方法受光照影响较大且对特征利用率低的情况,设计了基于RGB-D(RGB-Depth)图像的HOG-CLBP(Histogram of Oriented Gradient-Completed Local Binary Pattern)框架,并提出了一种改进的多特征融合方法,通过支持向量机分类实现实时行人目标检测。实验验证该方法可以有效解决在不同光照条件下实现对行人目标的检测,从而实现避障功能。

关键词:双目视觉;行人检测;避障;特征融合

中图分类号:TP29 文献标识码:A

Abstract: This paper proposes an approach to applying image acquisition with "structured light + binocular vision camera" to an explosively dangerous environment since it is difficult for explosion-proof Automatic Guided Vehicle (AGV) to detect pedestrians under different lighting conditions in factory environment. Traditional HOG-LBP (Histogram of Oriented Gradient-Local Binary Pattern) method based on RBG (red, blue, green) channels of images is greatly affected by illumination and has low utilization rate. Therefore, a HOG-CLBP (Histogram of Oriented Gradient-Completed Local Binary Pattern) framework based on RGB-D (RGB-Depth) images is designed, and an improved multi-feature fusion method is proposed to realize real-time pedestrian target detection through support vector machine classification. Experiments verify that this method can effectively solve the problems of pedestrian targets under different lighting conditions to achieve the obstacle avoidance function.

Keywords: binocular vision; pedestrian detection; obstacle avoidance; feature fusion

1 引言(Introduction)

防爆AGV是指依據GB3836系列国家标准[1]设计,经相关防爆检验检测机构认证,可以应用于爆炸性危险环境的装备有自动导引装置的多功能移载运输车。随着2019年10月1日防爆电器正式被纳入CCC(China Compulsory Certification)认证管理范围,自2020年10月1日起,未取得3C证书和认证标志的防爆产品被禁止出厂、销售、进口,或在其他经营活动中使用,因此防爆AGV具有极为广阔的市场前景。

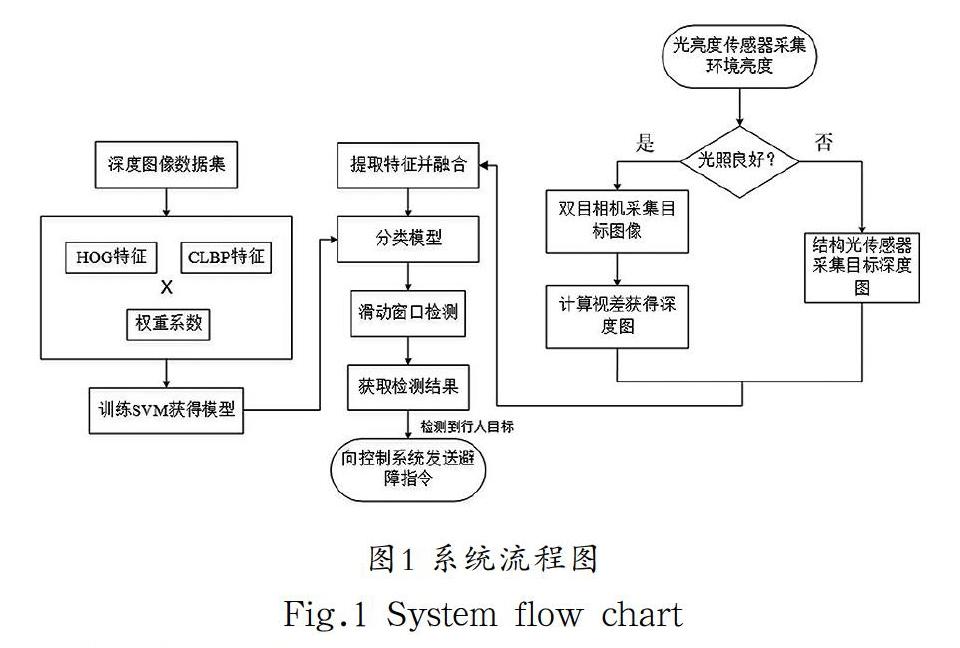

与通用型AGV结构相同,防爆AGV主要通过隔爆型、增安型和本质安全型等[2]防爆方式解决AGV小车的控制单元、驱动单元等部分的电气防爆问题。由于应用环境的特殊性,通用型AGV常用的激光雷达等避障方案在爆炸性危险环境中较难解决防爆安全问题。由于AGV运行轨迹通常较为固定,且在爆炸性环境中对于物料堆放有着严格的规定,因此本文中需要躲避的障碍对象主要为出现在小车前进路线上的行人。本文设计了“结构光+双目视觉相机”的图像采集方案,通过HOD-CLBP框架实现行人检测从而进行避障。

2 相关工作(Related work)

行人检测就是通过图像采集设备对工作环境进行视频或图片采集,对目标图像中的行人与其他内容进行区分,简单地说就是一种单一分类问题。本文的主要工作内容是对训练集中的图像分别提取HOG特征[3]和CLBP特征[4],通过改进的特征融合算法对提取到的特征进行融合,再使用融合后的特征训练分类器获得分类模型。应用过程中,针对不同的光照条件,使用“结构光+双目视觉相机”[5]对目标区域进行深度图像采集,使用训练好的分类器对行人目标进行检测。

HOG特征假设一个对象可以根据其边缘方向和大小来表征。此外,它考虑用图像的小矩形区域来处理图像,这使得算法不受光度或几何变换的影响。但是单一HOG特征对图像信息的描述不够完整,对目标检测的精度较低[6]。传统的LBP特征只计算了相邻像素与中心像素间的差值信息,而不计算像素的幅值信息,导致图像部分纹理信息的缺失。本文通过CLBP特征对图像的符号、幅值及中心灰度特征分别进行提取和融合,对图像的纹理信息进行全面描述,大幅提升了图像纹理信息的准确性。通过改进的特征融合算法融合提取到的特征值和特征向量,最后使用SVM(Support Vector Machines)分类器[7]对图像进行分类。图1为本文设计的方法实现流程。

3 算法与实现(Algorithm and implementation)

3.1 深度HOG特征

在特征提取步骤对数据集的深度图像提取方向梯度直方图特征即为HOG特征。

(1)图像预处理与gamma归一化。

(2)梯度计算。使用一维离散微分模板[-1,0,1]和[-1,0,1]T

计算水平方向和垂直方向的梯度值。通过式(1)和式(2)分别计算和方向的梯度、,对原始图像进行卷积。

(3)梯度幅值和角度。使用上一步获得的和,通过式(3)和式(4)计算梯度幅度和角度。

(4)直方图计算。如图2所示,输入的图像被分割为单元化的小矩形区域,其中每个单元由8×8个像素组成。然后计算每个单元的直方图。直方图通常定义为一个元素数组,其中每个元素表示数据集中一系列值的出现频率。对于每个像素,计算九个区间的直方图。将0°—180°的角度均分为20°的小区间。在单元格中,与每个像素对应的梯度值被添加到对应的区间中。

为了进一步提升精确度,通过双线性插值将幅度离散化至每个区间。对于单元格中的每个像素,对其大小进行双线性插值到其对应的区间和其最近的邻域中。对每一格中的所有像素执行此操作,就得到一个单元格的直方图。接下来再对图片进行分块,每一块由2×2个单元格组成,每个块与前一个块重叠50%。因此,每个块具有36维特征向量。

(5)归一化。归一化是影响检测精度的关键步骤。本文中,使用L2-norm归一化来进一步提高可靠性和精度。如式(5)所示,用表示归一化特征向量;即为第k个块的特征向量;?是一个常数,用来避免出现分母为零的情况。图3为HOG算法提取的梯度特征。

3.2 CLBP特征

如图4(a)和图4(b)所示,将图像中的某一像素记为,以其为中心的九宫格中的个相邻像素记为,将与的差值记为,获得的向量即表示像素处图像的局部信息。

向量可以进一步表示为符号与幅值的乘积形式,将的符号与幅值分别记为、:

由前人实验可以得知,图像中像素的差值信息比幅值信息包含的有效数据更多,CLBP特征将幅值和差值信息进行了有效的融合,并且利用了中心像素的信息,进一步表述图像的纹理特征。

将CLBP特征的符号信息、幅值信息及中心像素灰度三个算子分别设为CLBP_S、CLBP_M、CLBP_C。其中,CLBP_S与传统的LBP特征一样,可以表示为:

图5为图像的CLBP特征提取结果图。在本文中,通过联合的方式建立这三种算子的联合直方图,用以完整表述图像的纹理信息,并在后续的特征融合阶段与HOG特征融合后形成特征模型,用以训练分类器。

3.3 特征融合

通过对经典的线性判别分析(Linear Discriminant Analysis)理论[8]的深入研究,采用特征权重组合的算法对提取到的特征进行融合,在实验中对算法权重系数进行优化以改进识别效果。

以、分别表示同类样本相似性的均值和对应的差平方;代表和样本的特征相似度,其中和均来自容量为的行人样本,即可得到如下公式:

同理,用、分别表示行人样本和其他类型样本相似性的均值和对应的差平方,则权重系数可以表示为:

将前面提取到的HOG特征与CLBP特征匹配其对应的权重系数,再对特征进行融合,用融合后的特征向量训练分类器实现行人的分类。

4 实验与分析(Experiment and analysis)

实验环境为Intel Core i7-8750H、GPU版本1050Ti、4GB内存,实验环境系统为Ubuntu16.04、Python3.7、Opencv3.3.1[9]。由于实际条件,文中使用CVC-02-Classification数据集对分类器进行训练和测试。该数据集主要为行人数据,训练集和测試集的正负样本情况如表1所示,并且该数据集提供RGB图像和对应的深度图。

本文中设计的算法实现过程如下:

(1)使用CVC-02-Classification数据集提供的训练图片进行HOG特征和CLBP特征的提取。

(2)通过改进的特征融合算法对提取的特征进行融合,并对SVM分类器进行训练获取模型。

(3)使用CVC-02-Classification数据集提供的测试图片进行测试,并根据测试数据计算特征权重获取新的特征向量。

(4)将新的特征向量输入SVM分类器中获得完整的行人检测算法。

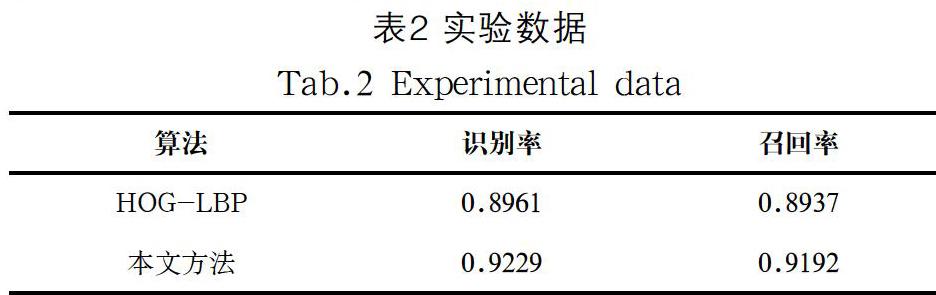

实验中,为了验证算法在深度图目标识别中的优越性,我们在数据集提供的深度图与RBG图上分别进行实验,并与传统HOG-LBP算法进行对比[10]。我们在训练集上分别进行HOG和CLBP特征融合,将融合后的特征用于训练SVM分类器,以确定权重向量和偏差。实验数据如表2所示。实验结果表明,该方法识别准确率达到92.29%。

由图6(a)和图6(b)对比实验结果可以看出,在RGB图中右侧的儿童,由于距离过远图像提供的特征不足,且由于衣服和路面颜色接近、灰度值接近,导致漏检。图6(c)和图6(d)中左下角穿白色衣服的行人由于姿态及在图像中比例较小而被漏检。在两组对比实验的深度图实验结果中均检测到目标。

通过分析漏检的测试图片发现,多数漏检情况如图7所示,图片中行人躯干大部分被其他已检测出的行人遮挡,或者前景已经识别出行人,背景中的目标被漏检。根据本文的实际应用背景,当前景中识别出目标,AGV小车即会采取制动措施躲避目标,如图7所示的情况不会对背景中的行人造成危险。而对比实验结果也可以看出,用深度特征训练的分类器的漏检情况明显优于在RGB图上的实验情况。

5 结论(Conclusion)

本文提出了用“结构光+双目视觉相机”来解决爆炸性危险环境中AGV小车避障过程中的行人检测问题。在实际应用中,可根据不同光照情况,分别通过结构光或双目相机系统采集目标的深度图。基于深度图的改进HOG+CLBP特征融合的行人检测方法在Intel Core i7-8750H、Python3.7、Opencv3.3.1实验环境下取得较好的实验效果。实验证实,算法实时性与准确性可以基本满足爆炸性危险环境下AGV小车对于实时行人检测的需求。本文中使用的CVC数据集均为站立状态下的行人,与实际工作环境下可能存在不同工作姿态的工人有一定差异,后续将对不同姿态下行人目标的检测进行研究,进一步提升该方法的可靠性与实用性。

参考文献(References)

[1] GB 3836.1—2010 爆炸性环境 第1部分:设备通用要求[S].北京:中国标准出版社,2011.

[2] Emil Pop, Gabriel-Ioan Ilcea, Ionut-Alin Popa. Distance Control and Positive Security for Intrinsic Equipment Working in Explosive Potential Atmospheres[J].Engineering, 2018,10(3):75-84.

[3] Xiong Zhang, Shangguan, H., Ning, A., et al. Pedestrian Detection with EDGE Features of Color Image and HOG on Depth Images[J]. Automatic Control and Computer Sciences, 2020(54):168-178.

[4] 满忠昂,刘纪敏,孙宗锟.基于局部二值模式与深度置信网络的人脸识别[J].软件工程,2020,23(05):13-16;12.

[5] Qian Zhang, Guoqin Gao, Mengru Liu. Pose detection of parallel robot based on improved Hough-K-means and SURF algorithms[J]. The Journal of Engineering, 2019(22):24-29.

[6] 王志宽.改进的量子模型与灰色理论相结合图像融合算法的研究[D].天津:天津工业大学,2018.

[7] Redouan Lahmyed, Mohamed El Ansari, Ayoub Ellahyani. A new thermal infrared and visible spectrum images-based pedestrian detection system[J]. Multimedia Tools and Applications, 2019, 78(12):61-85.

[8] Hu Wei, Shen Weining, Zhou Hua. Matrix Linear Discriminant Analysis[J]. Technometrics, 2020, 62(2):196-205.

[9] 孙思瑞,陶月松,陈彬,等.基于Opencv的双目视觉智能防撞系统[J].自动化技术与应用,2020,39(05):11-14.

[10] 程海鹰,王凤随,朱树明.基于HOG-LBP特征和SVM分類器的视频摘要方法[J].四川理工学院学报(自然科学版),2018,31(04):43-48.

作者简介:

万 伟(1993-),男,硕士生.研究领域:机器视觉,机器人控制.

刘子龙(1972-),男,博士,副教授.研究领域:控制科学与控制理论,机器人控制.

孙 帅(1993-),男,硕士生.研究领域:非接触型监测,机器学习.

张 莹(1993-),女,硕士生.研究领域:机器人控制,神经网络.