基于三维语义包围框的车辆事故检测方法研究∗

陆林东 张伟伟

(上海工程技术大学 上海 201620)

1 引言

随着智能交通系统的发展,监控视频下的交通流量、违章检测和交通事故检测等取得了巨大的成就。由于交通事故检测算法在智能交通系统中扮演重要的角色,因此也推动了研究人员对事故自动检测的研究。

在过去的研究工作中,通常利用视频图像处理来开发事故自动检测的方法。主要分析车辆活动,提取相关车辆的方向和加速度等运动特征来识别车辆运动中的安全状态。Chen Y[1]利用OF-SIFT算法以提取运动特征并使用ELM分类器对交通事故进行分类。刘纬琪[2]提出OBB算法使车辆生成二维包围盒投影在地面上,检测不同车辆的包围盒是否相交判断碰撞状态。刘松[3]建立了基于相干运动场的车辆相互作用模型。梁帅[4]构建了一个双高斯模型的交通事故检测框架。Singh D[5]提出了一种基于堆叠式自动编码器(SAE)的深度学习体系结构模型,自动学习时空因果关系,在此基础上建立了不均匀扩散模型,用于分析不同时段不同区域的交通异常。Hui Z[6]通过基于混合高斯模型的背景建模并使用均值漂移算法实现车辆的跟踪。Yun K[7]利用运动交互场(MIF)的对称性来检测和定位交通事故。Mo X、Wang J、Xia L M[8~10]在视频异常检测中,采用了稀疏重建技术。

不同于现有方法,本文引入了一个深度学习框架来检测与跟踪车辆的外观和运动特征。当交通事故发生时,车辆的姿态和运动状态的突变是事故检测的关键特征。因此本文在输入的监控视频中通过三维物体检测与跟踪算法映射整个过程的三维姿态和轨迹的运动状态。在此基础上将生成的车辆三维包围框和运动特征建立三维事故检测评价函数。设定碰撞阈值,将高于此阈值的车辆运行状态判定为发生碰撞事故。

2 算法框架

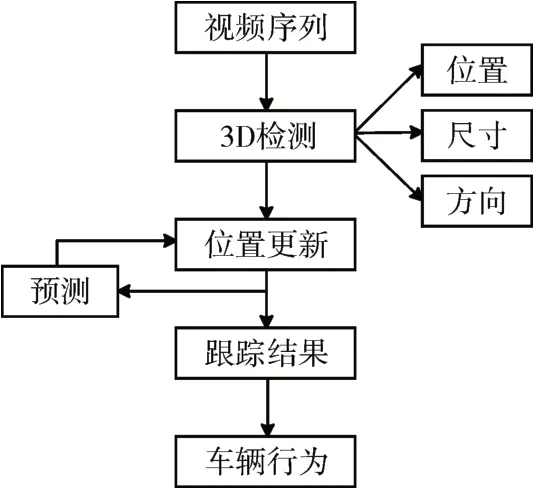

图1为本文提出的算法是基于单目视觉的三维物体检测与多目标跟踪的框架,算法主要由三个阶段组成。第一阶段:利用卷积神经网络训练一个三维物体检测器来检测道路上的车辆;第二阶段:利用扩展卡尔曼滤波对检测到的车辆进行预测及状态更新,生成二维-三维多目标跟踪,从而在整个视频序列中实现车辆6自由度的三维目标姿态恢复;在最后一阶段中,基于运动车辆轨迹以及外观建立了一个车辆行为函数用来判断事故的发生。

图1 算法框架示意图

3 车辆事故检测

3.1 三维车辆检测

车辆的三维包围框可以提供位置、尺寸与朝向等信息,即9个自由度表示车辆的运动状态。(x,y,z)表示车辆中心点所在三维坐标系中的位置;(w,h,l)表示车辆的宽高长;(α,β,γ)则表示车辆的偏转角、航向角及俯仰角。本文基于Darknet-53[11]网络模型通过端到端的方式训练模型,再由自由度参数和摄像机投影矩阵形成三维边界框。在卷积层中提取了与特征金字塔网络(FPN)相似的特征描述模块,该模块包含了更深的卷积层和反卷积层来捕获图像细节。如图2所示三个不同输出张量,高分辨率的输出张量能够捕获更丰富的图像细节,诸如视野远处的物体,而低分辨率的输出张量能捕获更多的图像上下文信息。将输入的每张图像都归一化尺寸为416*416,本文所设计输出类别为车辆,输出参数为9个自由度参数加一个置信度参数,输出3个不同尺寸的特征图谱,则张量深度为

图2 模型输出张量

针对这些输出参数,设计了3D Box Proposal Networks(3DBPN)损失函数,3DBPN损失函数主要包括位置Lloc、尺寸Lsize和朝向Lθ。xi,yi,zi与分别表示空间中的真实空间坐标与预测坐标;wi,li,hi与分别表示物体的真实尺寸与预测尺寸;θi与分别表示真实方向与预测方向。每个损失函数都设置了不同的权重α用于进一步提高参数的预测性能,损失函数如下所示:

通过非极大抑制算法过滤较低得分的候选生成框,以提升较高精确度的车辆三维包围框。车辆的3D检测算法提供了在监控视角下的车辆位姿预测,便于执行下一步的3D跟踪。

3.2 车辆跟踪

在当前的检测结果中建立帧与帧之间的关系,融合二维-三维扩展卡尔曼滤波(EKF)对道路上的车辆进行运动预测与状态估计,从而实现车辆的三维姿态跟踪。如前一节所述,在初始帧中检测到的车辆输出三维包围框尺寸和角度信息后,确定初始化的车辆位姿。在连续的两帧图像中,利用扩展卡尔曼滤波器通过三维重投影来估计下一帧目标的跟踪状态。观测结果由3D物体检测与2D检测相结合构成了所有的观测模型,使用MRF模型从生成的大量假设性观测结果中选择合适的观测结果作为下一帧的初始检测框。

结合投影和反投影操作,将轨迹点应用于三维边界框的中心位置。递归神经网络LSTM用于跨帧关联和匹配道路中车辆的位置。从LSTM模型中获取速度,并利用该速度估计三维姿态来更新三维位置。根据训练数据的平均大小,可以随着视野远近定期更新三维包围框的大小。图3提供了一组由二维-三维扩展卡尔曼滤波观测组成的轨迹假设,这些假设与检测生成三维物体相关并利用轨迹假设来跟踪物体。通过一个新的观测结果来更新现有的假设,并得到最优的评分跟踪轨迹。

图3 二维-三维扩展卡尔曼滤波观测组成的轨迹假设

3.3 事故检测

基于车辆的运动姿态,本节建立了监控视频下由车辆轨迹、3D包围框尺寸和旋转角的变化组成的交通事故评价函数A。

车辆轨迹是交通视频监控中最直观的车辆运动行为表达方式。利用轨迹数据提取不同类型的车辆轨迹进行先验训练,在1~n帧里对轨迹点p采用K最近邻分类算法。给定权重参数wt,车辆的3D包围框轨迹函数Trajobj与轨迹评价函数Dt如下:

车辆碰撞同时也会带来相应的3D包围框的快速变化,本文为每个车辆设置一个合适的变化范围用于对比车辆正常行驶中的3D包围框。先验包围框的长宽高平均尺寸设为sˉ,合理尺寸si变化范围设置如下:

计算车辆3D包围框的尺寸方差O3D(W ,H,L),设置权重参数ws,可以得到车辆的包围盒尺寸评价函数Ds。

相应地计算出车辆包围框三个旋转角O3D( α,β,γ)变化方差,设置权重参数wθ,得到车辆的旋转角评价函数Dθ。

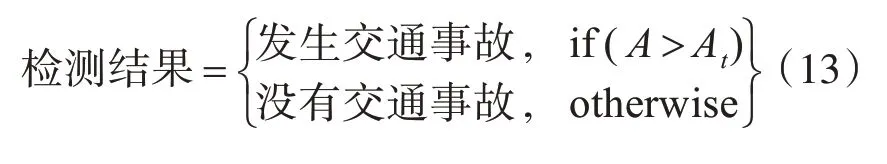

在连续帧中被检测到发生车辆事故由阈值参数At决定,检测结果函数设置如下:

4 实验

4.1 训练过程

本实验主要在路口监控视角下测试车辆的检测跟踪以及事故检测的性能。用于实验测试的数据集来自于KITTI数据集[11]与国内各路口监控数据集,涵盖了不同天气环境和交通流量,从中提取了100个视频序列并进行图像标注。用于训练的视频帧数占据交通视频总帧的五分之三,其余视频帧作为测试帧。通过随机梯度下降法对每一批1000张图片进行训练,计算它们的平均损失函数值以更新参数值。前3万次迭代中设置学习率为0.001,后1万次迭代设置学习率为0.0001。

4.2 实验结果

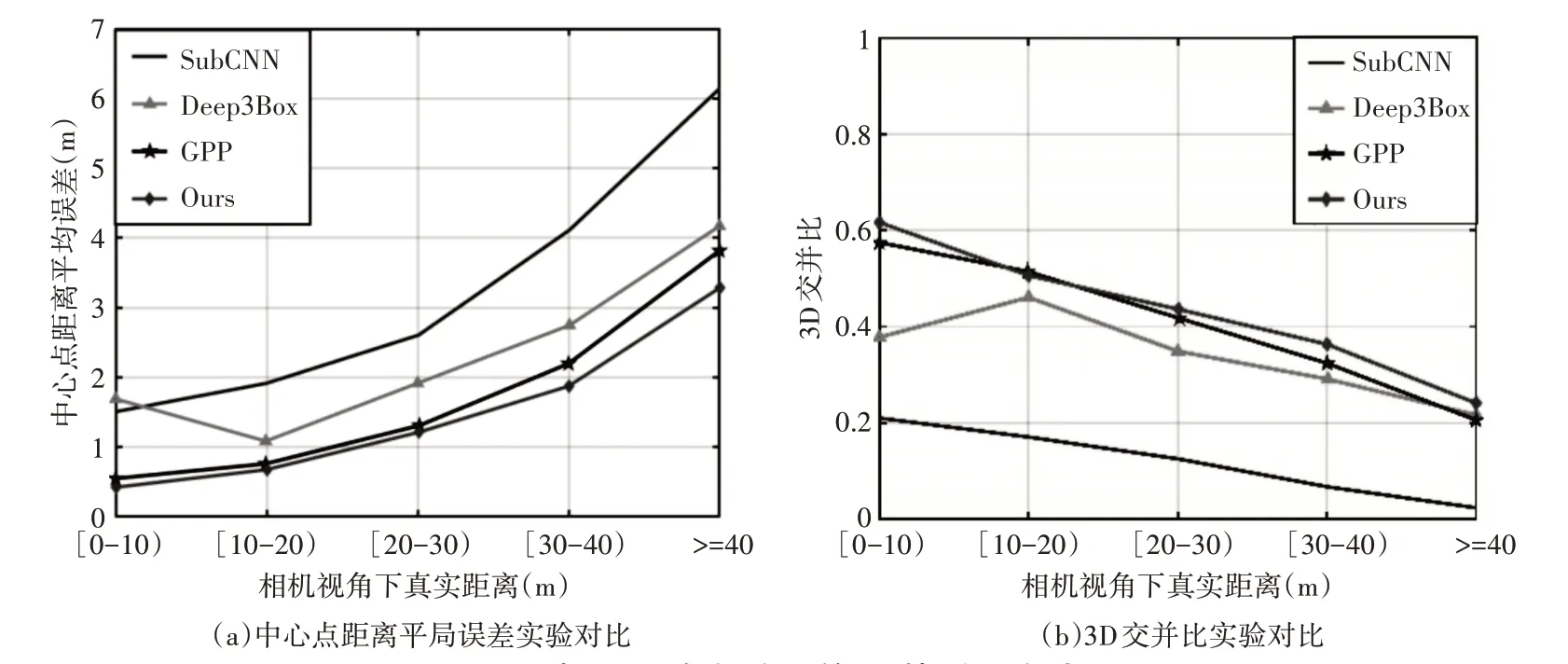

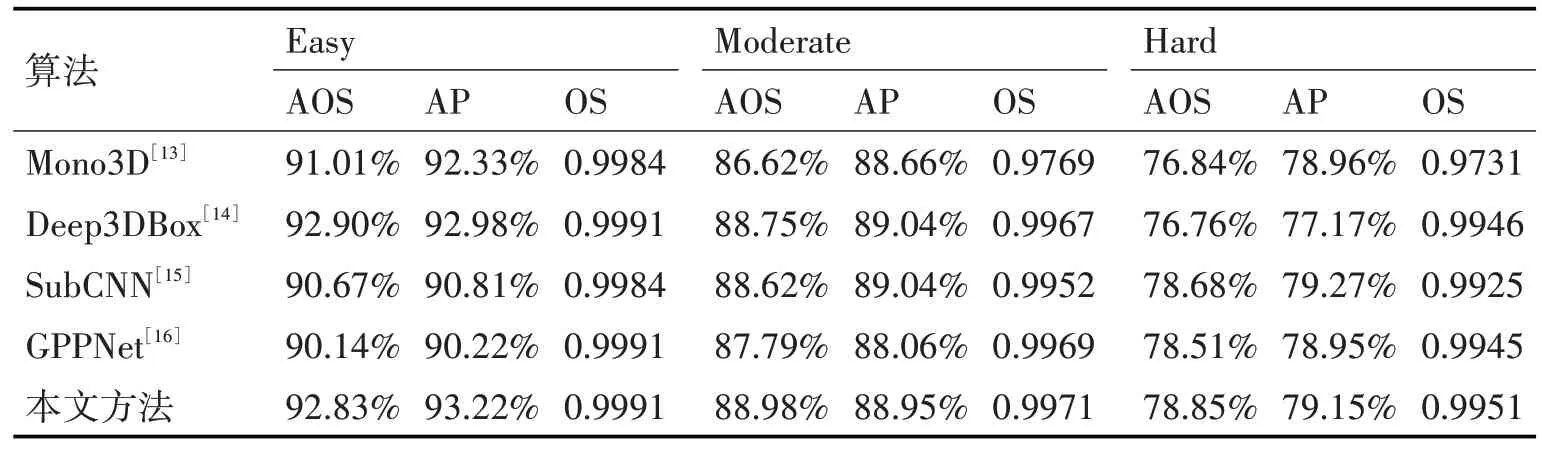

本文的实验与目前最先进的几个车辆3D姿态检测器进行了比较。检测车辆用KITTI数据集官方评估方法,在三个不同遮挡程度下进行检测。为了评估三维物体检测的准确性,根据实际情况制定了三个评估标准。首先是计算物体的三维包围框中心点距离相机的真实距离与估测距离的误差率,其次比较随物体与相机真实距离增大,检测到的三维包围框与真实三维包围框的交并比变化趋势。图4(a)、(b)所示在KITTI数据集3D检测的前两个评估标准下,本文方法与其他方法的实验对比图。最后一个评估标准为车辆方向的比较,通过检测三种不同遮挡程度的数据集,比较平均方向相似度(AOS)、平均精度(AP)和方向得分(OS)。如表1所示,本文的方法与其他三种3D检测方法相比,综合准确率在其他方法之上。

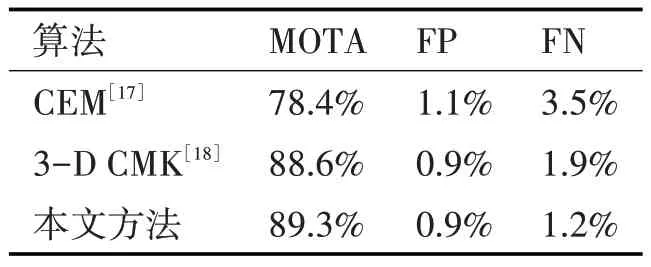

在三维目标跟踪中,尺度变化、方向变化以及遮挡都会对跟踪性能造成影响。本文对50个交通监控视角下的视频序列进行跟踪测试,并与其他跟踪方法进行比较。分别从多目标跟踪平均精度(MOTA),假阳性(FP)与假阴性(FN)来多指标评估模型的鲁棒性。如表2、图5所示,本文的3D目标跟踪轨迹清晰,三维包围框回归的车辆姿态比较准确。

图4 在KITTI数据集上的3D检测实验对比

表1 车辆方向回归实验对比

表2 跟踪效果实验对比

图5 道路监控下的跟踪效果

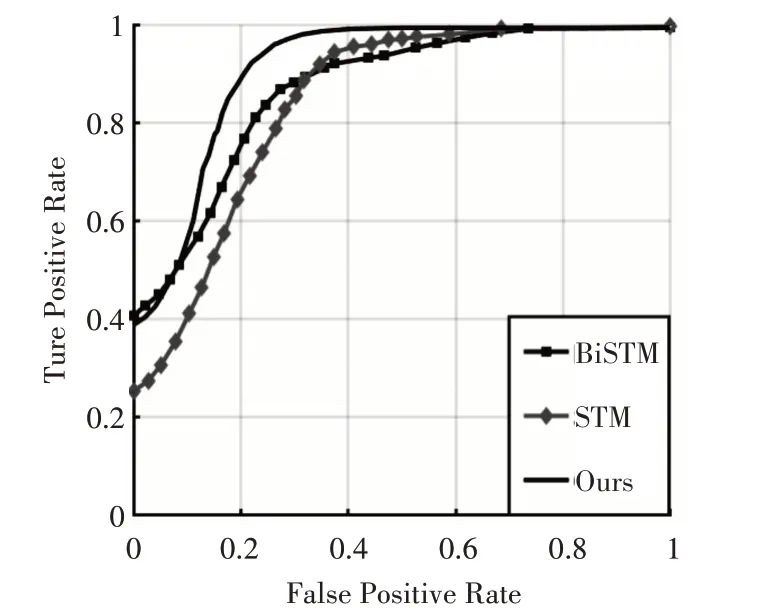

对于交通事故检测性能的评价方法,本文利用真阳性率(TPR)与假阳性率(FPR)两个评价指标绘制了ROC曲线。如图6所示,与BiSTM[9]、STM[10]相比,本文提出的算法能够以较高的准确率识别多种环境下道路上的交通事故。

图6 事故检测ROC曲线

5 结语

对于道路监控下车辆事故的自动检测,本文提出了一种融合二维图像与三维信息的事故检测方法。通过车辆的三维检测与跟踪任务生成的三维语义包围框用来提取车辆的运动特征,其中包括车辆的轨迹、3D包围框的尺寸与朝向,并利用三维语义包围框建立了事故检测评价指标。实验结果表明,本文实现的算法在事故检测上具有鲁棒性、准确性、稳定性。