多尺度空洞卷积金字塔网络建筑物提取

张春森 刘恒恒 葛英伟 史书 张觅

摘 要:为改善现有深度学习方法获取图像特征尺度单一、提取精度较低等问题,提出多尺度空洞卷积金字塔网络建筑物提取方法。多尺度空洞卷积金字塔网络以U-Net为基础模型,编码-解码阶段采用空洞卷积替换普通卷积扩大感受野,使得每个卷积层输出包含比普通卷积更大范围的特征信息,以利于获取遥感影像中建筑物特征的全局信息,金字塔池化模块结合U-Net跳跃连接结构整合多尺度的特征,以获取高分辨率全局整体信息及低分辨率局部细节信息。在WHU数据集上进行提取实验,交并比达到了91.876%,相比其他语义分割网络交并比提升4.547%~10.826%,在Inria数据集上进行泛化实验,泛化精度高于其他网络。结果表明所提出的空洞卷积金字塔网络提取精度高,泛化能力强,且在不同尺度建筑物提取上具有良好的适应性。

关键词:建筑物提取;多尺度;空洞卷积;金字塔池化

中图分类号:P 237

文献标志码:A

文章编号:1672-9315(2021)03-0490-08

DOI:10.13800/j.cnki.xakjdxxb.2021.0314

Abstract:In order to improve the existing deep learning methods for acquiring image feature scales with single scale and low extraction accuracy,building extraction method from multi-scale dilated convolutional pyramid network is proposed based on U-Net.The dilated convolution was used in the en-decoding stage to replace ordinary convolution to expand the receptive field,resulting in the fact that the output of each convolution layer contains a larger range of feature information than ordinary convolution,which facilitates the acquisition of global information about the building features in remote sensing images.The pyramid pooling module is combined with the U-Net jump connection structure to integrate multi-scale features with high-resolution global overall information and low-resolution local detailed information obtained. The extraction experiment was conducted on the WHU dataset, and the intersection ratio reached 91.876%,an increase of 4.547%~10.826% compared to other semantic segmentation networks. The generalization experiment was performed on the Inria dataset, and the generalization accuracy was higher than that by other networks. The results show that the proposed dilated convolutional pyramid network has high extraction accuracy, high generalization ability, and strong adaptability in the extraction of buildings of different scales.

Key words:building extraction;multiscale;dilated convolution;pyramid pooling

0 引 言

建筑物作為城市的主体之一,其空间分布可以有效帮助判断该地区城镇化水平,并且对于城市规划、违章建筑监测等方面具有重要的意义。随着遥感影像技术的迅猛发展,高分辨率遥感影像数据不断涌现,基于高分辨率遥感影像的建筑物提取成为了学者们研究的热点,并取得了大量的研究成果。

遥感影像建筑物提取方法主要利用建筑物的光谱特征、形状特征、纹理特征、上下文特征、阴影特征、局部特征(直线与边缘角点)等[1]。游永发等利用建筑物光谱特征、形状特征与上下文特征结合面向对象与形态学建筑物指数提取建筑物,但其受人工设计特征影响较大,与建筑物纹理、形状接近的易错分,亮度、对比度低的及稀疏、尺寸大的易漏分[2];冉树浩等利用建筑物形状特征与阴影特征提取建筑物,但阴影交错重叠的区域会对结果产生影响[3];朱俊杰等利用建筑物几何特征与光谱特征结合图像分割提取建筑物,但目前已有的图像分割算法本就面临着过分割和欠分割的问题[4];贺晓璐等将引入红色边缘波段规则面向对象方法提取建筑物信息的结果与基于样本面向对象方法提取建筑物信息的结果进行融合来提取建筑物[5];林祥国等将直角点和直角边2种特征融合提取建筑物[6];吕凤华等根据高分遥感影像不同尺度下特征表现不同提出了多层次特征建筑物提取方法[7]。

近年来,深度学习技术飞速发展,相比传统方法,深度学习方法可以自动提取影像目标的特征,避免了人工设计特征的繁琐,且传统方法通过人工设计特征带来的一些弊端也得以避免[8-9]。FCN作为深度学习中语义分割的经典之作,尽管FCN存在着语义信息丢失、缺乏像素之间关联性研究等问题,但其将编码-解码的结构用于图像语义分割,为后续图像语义分割网络的研究有着极大的贡献[10]。SegNet采用了编码-解码的结构,相比FCN的改进之处有上采样过程中用反池化替代反卷积,使得参数量下降,加快了模型的训练速度,且在反池化过程中使用下采样最大池化过程的位置信息,保证了高频信息的完整性,但是在对较低分辨率的特征图进行反池化时,会忽略邻近像素之间的信息[11-12]。U-Net网络是基于FCN的一种语义分割网络,相比FCN的改进之处有,FCN通过特征逐点相加进行特征融合,只是单一尺度的特征融合,而U-Net是通过特征通道拼接进行特征融合,融合了不同尺度的特征,同时使用跳跃连接使得特征更加精细[13]。刘浩等选取U-Net为基础模型,在编码过程使用特征压缩激活模块使网络学习特征的能力增强,解码过程复用编码过程相应尺度的特征以恢复空间信息,实现特征压缩建筑物的提取[14];王舒洋等使用深度编解码网络提取建筑物的低阶语义特征,使用多项式核对深度网络中间特征图进行高阶描述,将低阶特征与高阶描述级联实现融合高阶信息的建筑物提取[15];陈凯强等基于编解码网络CNN实现建筑物的提取,并使用FoVE方法減轻建筑物边缘提取精度不高现象[16];惠健等将U-Net作为基础模型,加入Xception模型并结合多任务学习方法来进行建筑物的实例分割[17];崔卫红等选取VGG16网络作为基础模型,对原始影像不同尺度下采样,获取不同尺度的特征,并将不同尺度的特征进行相加合并,同时上采样过程用全卷积替换全连接层,实现多尺度全卷积网络建筑物的提取[18]。

在U-Net基础上改进网络模型,加入空洞卷积扩大感受野,使得每个卷积输出包含比普通卷积更大范围的特征信息,利于获取遥感图像中建筑物特征的全局信息。并加入金字塔池化层结合U-Net跳跃连接结构来融入更多尺度的特征以获取高分辨率全局整体信息及低分辨率局部细节信息,以实现建筑物的精提取。

1 网络及算法

1.1 U-Net卷积神经网络

U-Net是全卷积神经网络FCN的一种变体,最早应用于医学图像细胞壁的分割。其网络结构对称,形似字母“U”而得名U-Net。U-Net采用了编码-解码的结构,并在此基础上加入了跳跃连接,编码过程通过卷积池化提取图像特征同时丢失了位置信息,而在解码过程恢复位置信息,跳跃连接通过特征维度拼接进行特征融合可以获取多尺度特征(图1)。

1.2 空洞卷积(dilated convolution)

在将遥感图像输入卷积神经网络过程中,对图像进行连续卷积和池化或者其他下采样操作整合多尺度上下文信息,这样在降低图像尺寸的同时增大感受野,会损失一些分辨率,使得一些图像细节信息无法重建。针对以上问题,在U-Net中利用空洞卷积增大感受野,每个卷积输出包含比普通卷积更大范围的特征信息,利于获取遥感图像中建筑物特征的全局信息[19]。

空洞卷积向卷积层引入了一个“扩张率(dilation rate)”的新参数,该参数定义了卷积核处理数据时各值的间距。设置不同扩张率时,感受野会不同,从而能够获取遥感影像多尺度特征信息。实验中,根据遥感图像的原始尺寸来设定相应卷积神经网络中空洞卷积所提取的特征图的大小,进而设定空洞卷积扩张率。空洞卷积如图2所示。

1.3 金字塔池化模型(pyramid pooling model,PPM)

由于U-Net获取多尺度是通过特征维度拼接进行特征融合实现的,因此其尺度有一定的局限性,因此文中将金字塔池化与U-Net跳跃连接结合起来,实现更广意义上的多尺度特征提取[20]。

金字塔池化将输入特征图经过多种不同尺度的池化得到不同尺度的特征图,经过1×1卷积后特征维度压缩为原先的1/N(N表示金字塔的层级),然后上采样之后恢复至输入特征图尺寸,在通道上与输入特征图拼接形成多尺度特征的融合。由于金字塔池化模块由不同尺度的池化层组成,分辨率高的池化由于其感受野大,因此可以获取全局整体信息,分辨率低的池化,由于其感受野小,感受野受到限制,无法获取全局整体信息,但可以获取局部细节信息,将其进行融合后,可以获取影像的多尺度信息。金字塔模型如图3所示。

1.4 空洞卷积金字塔网络结构

空洞卷积金字塔网络结构如图4所示,主要分为编码(左)-解码(右)以及中间的金字塔池化和跳跃连接。编码是提取影像特征的过程,网络输入512×512 RGB影像,经过4次下采样,每次下采前经过一个普通卷积层、一个扩张率为2的空洞卷积层,下采样采用最大池化,每个卷积层后接BN层及RELU激活函数,在第4次下采样后添加Dropout正则化防止过拟合[21-22]。解码过程对应编码过程进行4次上采样,上采样通过转置卷积逐层恢复图像至原图像大小。金字塔池化将输入特征图经过4种不同尺度的平均池化得到1×1,2×2,4×4,8×8等4种尺度的特征图,经过1×1卷积后特征维度压缩为原先的1/4,然后上采样恢复至输入特征图尺寸,在维度上与输入特征图拼接。跳跃连接结构将金字塔池化拼接的特征图与解码阶段的特征图特征进行特征维度拼接结合实现多尺度特征融合,在对不同尺寸的建筑物提取上相比于单一尺度的网络具有更好的效果。

1.5 评价指标

文中选取语义分割常用的4个评价指标(交并比IoU,准确率Precision,召回率Recall,F1分数)来评价文中方法的精度,计算公式见式(1)~式(4)。

式中 TP为真实值是正例,模型预测为正例的数量;TN为真实值是负例,模型预测为负例的数量;FP为真实值是负例,模型预测为正例的数量;FN为真实值是正例,模型预测为负例的数量。

2 实验与分析

2.1 实验数据

文中实验使用武汉大学季顺平教授团队提供的开源建筑物数据集—WHU建筑物数据集中的航空影像数据集,其覆盖新西兰Christchurch市450 km2,包含22万栋形态不一的建筑物,空间分辨率为0.075 m[23],部分影像如图5所示。

将影像裁剪成适合网络输入的512×512子图,并分为60%训练集、20%验证集和20%测试集,得到1 096张训练影像,365张验证影像,366张测试影像。为了增强网络的鲁棒性,降低模型对某些属性的依赖,提升模型的泛化能力,因此需要对训练集进行数据增强。对训练集影像进行旋转、翻转、模糊处理、添加随机噪声和伽马变换等数据增强操作,将训练集增加到了5 480张数据。数据增强后的结果如图6所示。

2.2 实验结果与分析

实验均基于Windows下的Tensorflow框架,Python编程语言实现,硬件环境CPU Intel(R)Xeon(R)E5-2630 v4,显卡为NVIDIA Quadro M40008G内存。采用Adam优化器初始学习率为10-4,最低学习率不低于10-5,优化超参数为β1=0.9,β2=0.999,δ=10-8,迭代次数设为10次,模型训练结果如图7所示。

为验证空洞卷积金字塔网络的有效性,与最大似然法、支持向量机法等传统方法对比[24-25]。从图8(c)、(d)可以看出,最大似然法和支持向量机法提取建筑物的边界模糊,且存在“椒盐”现象,明显将路及其它与建筑物光谱相近的地物判别为建筑物,存在严重的错误。从图8(j)可以看出,空洞卷积金字塔网络提取建筑物的边界清晰、完整,且未存在误判现象。

将空洞卷积金字塔网络与经典的深度学习方法对比,包括FCN-32s,FCN-16s,FCN-8s,SegNet,U-Net。从图8(e)(f)(g)可以看出,FCN-32s,FCN-16s,FCN-8s算法提取的建筑物结果很粗糙。从图8(h)可以看出,SegNet算法提取的建筑物边界不清晰。从图8(i)可以看出,U-Net算法提取建筑物边界相比SegNet清晰,但存在少量“椒盐”现象。从图8(j)可以看出,空洞卷积金字塔网络相比其它深度学习算法提取建筑物的边界更加清晰、平滑、完整。且从图8中可以看出,其他方法在小尺寸建筑物上容易出现漏检,大尺寸建筑物提取不完整,而空洞卷积金字塔网络对不同尺寸建筑物均可以完整的提取,说明空洞卷积金字塔网络在对不同尺度建筑物的提取上具有更好的效果。

为定量评价文中方法的有效性,统计深度学习方法方法的准确率、召回率、F1分数和交并比。

从表1可以看出,空洞卷积金字塔网络在交并比、准确率、召回率、F1分数与其它深度学习方法相比,空洞卷积金字塔网络是最优的。相比于FCN-32s,FCN-16s,FCN-8s,SegNet、U-Net,空洞卷积金字塔网络交并比、准确率、召回率及F1分数都有很大的提升,证明了空洞卷积金字塔网络的有效性。

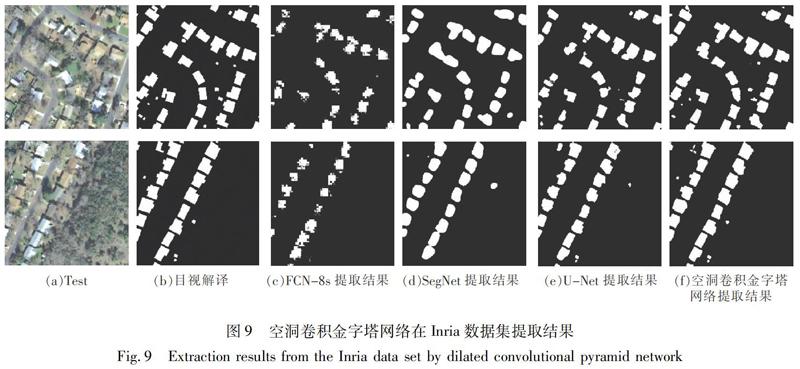

2.3 泛化能力验证

通过大量实验对比发现,空洞卷积金字塔网络在WHU建筑物数据集上表现优秀,为了充分验证空洞卷积金字塔网络的泛化能力,采用Inria数据集[26]进行验证,其中训练集1 000张512×512影像,验证集和测试集都为200张512×512影像。

从提取结果可以看出,空洞卷积金字塔网络的泛化能力优秀,无论是大型建筑物还是小型建筑物都能被很好的提取。

3 结 论

1)加入空洞卷积扩大感受野,使得每个卷积输出包含比普通卷积更大范围的特征信息,利于获取遥感图像中建筑物特征的全局信息。并加入金字塔池化层结合U-Net跳跃连接结构来融入更多尺度的特征以获取高分辨率全局整体信息及低分辨率局部细节信息,以实现建筑物的精提取。在WHU建筑物數据集进行建筑物的提取,结果表明,空洞卷积金字塔网络相比以往传统方法和深度学习方法建筑物提取的精度有所上升,且在对不同尺度建筑物的提取上均具有更好的效果。

2)通过Inria数据集一方面验证了空洞卷积金字塔网络的泛化能力,另一方面验证了无论是大型建筑物还是小型建筑物文中方法均表现优异。

3)空洞卷积金字塔网络在建筑物提取上表现优异,但在其它经典地物(道路、水体、耕地等)提取的表现上有待进一步探索。

参考文献(References):

[1] 王俊,秦其明,叶昕,等.高分辨率光学遥感图像建筑物提取研究进展[J].遥感技术与应用,2016,31(4):653-662,701.WANG Jun,QIN Qiming,YE Xin,et al.A survey of building extraction methods from optical high resolution remote sensing imagery[J].Remote Sensing Technology and Application,2016,31(4):653-662,701.[2]游永发,王思远,王斌,等.高分辨率遥感影像建筑物分级提取[J].遥感学报,2019,23(1):125-136.YOU Yongfa,WANG Siyuan,WANG Bin,et al.Study on hierarchical building extraction from high resolution remote sensing imagery[J].Journal of Remote Sensing,2019,23(1):125-136.[3]冉树浩,胡玉龙,杨元维,等.基于样本形态变换的高分遥感影像建筑物提取[J].浙江大学学报(工学版),2020,54(5):996-1006.RAN Shuhao,HU Yulong,YANG Yuanwei,et al.Building extraction from high resolution remote sensing image based on samples morphological transformation[J].Journal of Zhejiang University(Engineering Science),2020,54(5):996-1006.[4]朱俊杰,范湘涛,杜小平.几何特征表达及基于几何特征的建筑物提取[J].应用科学学报,2015,33(1):9-20.ZHU Junjie,FAN Xiangtao,DU Xiaoping.Geometric feature representation and building extraction based on geometric features[J].Journal of Applied Sciences Electronics and Information Engineering,2015,33(1):9-20.[5]贺晓璐,刘振华,胡月明.基于面向对象的建筑物信息提取方法研究[J].河南理工大学学报(自然科学版),2020,39(2):53-61.HE Xiaolu,LIU Zhenhua,HU Yueming.Research on object-oriented building information extraction method[J].Journal of Henan Polytechnic University(Natural Science),2020,39(2):53-61.[6]林祥国,宁晓刚.融合直角点和直角边特征的高分辨率遥感影像居民点提取方法[J].测绘学报,2017,46(1):83-89.LIN Xiangguo,NING Xiaogang.Extraction of human settlements from high resolution remote sensing imagery by fusing features of right angle corners and right angle sides[J].Acta Geodaetica et Cartographica Sinica,2017,46(1):83-89.[7]吕凤华,舒宁,龚龑,等.利用多特征进行航空影像建筑物提取[J].武汉大学学报(信息科学版),2017,42(5):656-660.LV Fenghua,SHU Ning,GONG Yan,et al,Regular building extraction from high resolution image based on multilevel-features[J].Geomatics and Information Science of Wuhan University,2017,42(5):656-660.[8]仲志丹,樊浩杰,李鹏辉.基于稀疏自编码神经网络的抽油机井故障诊断[J].西安科技大学学报,2018,38(4):669-675.ZHONG Zhidan,FAN Haojie,LI Penghui.Fault diagnosis of pumping well based on sparse auto-encoder neural network[J].Journal of Xian University of Science and Technology,2018,38(4):669-675.[9]范荣双,陈洋,徐启恒,等.基于深度学习的高分辨率遥感影像建筑物提取方法[J].测绘学报,2019,48(1):34-41.FAN Rongshuang,CHEN Yang,XU Qiheng,et al.A high-resolution remote sensing image building extraction method based on deep learning[J].Acta Geodaetica et Cartographica Sinica,2019,48(1):34-41.[10]LONG J,SHELHAMER E,DARRELL T.Fully convolutional networks for semantic segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,39(4):640-651.[11]BADRINARAYANAN V,KENDALL A,CIPOLLA R.SegNet:A deep convolutional encoder-decoder architecture for image segmentation[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2017,39(12):2481-2495.[12]张春森,葛英伟,蒋萧.基于稀疏约束SegNet的高分辨率遥感影像建筑物提取[J].西安科技大学学报,2020,40(3):441-448.ZHANG Chunsen,GE Yingwei,JIANG Xiao.High-resolution remote sensing image building extraction based on sparsely constrained SegNet[J].Journal of Xian University of Science and Technology,2020,40(3):441-448.[13]RONNEBERGER O,FISCHER P,BROX T.U-Net:Convolutional networks for biomedical image segmentation[C]//International Conference on Medical Image Computing and Computer-Assisted Intervention.Springer,Cham,2015:234-241.[14]刘浩,骆剑承,黄波,等.基于特征压缩激活Unet网络的建筑物提取[J].地球信息科学学报,2019,21(11):1779-1789.LIU Hao,LUO Jiancheng,HUANG Bo,et al.Building extraction based on SE-Unet[J].Journal of Geo-information Science,2019,21(11):1779-1789.[15]王舒洋,慕晓冬,杨东方,等.融合高阶信息的遥感影像建筑物自动提取[J].光学精密工程,2019,27(11):2474-2483.WANG Shuyang,MU Xiaodong,YANG Dongfang,et al.High-order statistics integration method for automatic building extraction of remote sensing images[J].Optics and Precision Engineering,2019,27(11):2474-2483.[16]陈凯强,高鑫,闫梦龙,等.基于编解码网络的航空影像像素级建筑物提取[J].遥感学报,2020,24(9):1134-1142.CHEN Kaiqiang,GAO Xin,YAN Menglong,et al.Building extraction in pixel level from aerial imagery with a deep encoder-decoder network[J].Journal of Remote Sensing(Chinese),2020,24(9):1134-1142.[17]惠健,秦其明,许伟,等.基于多任务学习的高分辨率遥感影像建筑实例分割[J].北京大学学报(自然科学版),2019,55(6):1067-1077.HUI Jian,QIN Qiming,XU Wei,et al.Instance segmentation of buildings from high-resolution remote sensing images with multitask learning[J].Acta Scientiarum Naturalium Universitatis Pekinensis,2019,55(6):1067-1077.[18]崔卫红,熊宝玉,张丽瑶.多尺度全卷积神经网络建筑物提取[J].测绘学报,2019,48(5):597-608.CUI Weihong,XIONG Baoyu,ZHANG Liyao.Multi-scale fully convolutional neural network for building extraction[J].Acta Geodaetica et Cartographica Sinica,2019,48(5):597-608.[19]季顺平,田思琦,张驰.利用全空洞卷积神经元网络进行城市土地覆盖分类与变化检测[J].武汉大学学报(信息科学版),2020,45(2):233-241.JI Shunping,TIAN Siqi,ZHANG Chi.Urban land cover classification and change detection using fully atrous convolutional neural network[J].Geomatics and Information Science of Wuhan University,2020,45(2):233-241.[20]ZHAO H,SHI J,QI X,et al.Pyramid scene parsing network[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).IEEE,2017:2881-2890.

[21]IOFFE S,SZEGEDY C.Batch normalization:Accelerating deep network training by reducing internal covariate Shift[C]//International conference on machine learning.PMLR,2015:448-456.[22]HINTON G E,SRIVASTAVA N,KRIZHEVSKY A,et al.Improving neural networks by preventing co-adaptation of feature detectors[J].Computer Ence,2012,3(4):212-223.[23]JI S P,SHI Q.Fully convolutional networks for multisource building extraction from an open aerial and satellite imagery data set[J].IEEE Transactions on Geoence and Remote Sensing,2019,57(1):574-586.[24]王旭東,段福洲,屈新原,等.面向对象和SVM结合的无人机数据建筑物提取[J].国土资源遥感,2017,29(1):97-103.WANG Xudong,DUAN Fuzhou,QU Xinyuan,et al.Building extraction based on UAV imagery data with the synergistic use of objected-based method and SVM classifier[J].Remote Sensing for Land and Resources,2017,29(1):97-103.[25]李远成,刘斌.应用主动学习SVM的网络流量分类方法[J].西安科技大学学报,2017,37(5):742-749.LI Yuancheng,LIU Bin.Network traffic classification method based on active learning support vector machine[J].Journal of Xian University of Science and Technology,2017,37(5):742-749.[26]MAGGIORI E,TARABALKA Y,CHARPIAT G,et al.Can semantic labeling methods generalize to any city? The inria aerial image Labeling benchmark[C]//Igarss IEEE International Geoscience & Remote Sensing Symposium.IEEE,2017:3226-3229.