基于红外相机和毫米波雷达融合的夜间行人检测*

尚 昊,孙立博,秦文虎

(东南大学仪器科学与工程学院,江苏 南京 210096)

驾驶环境感知系统作为无人驾驶体系最基本组成部分,直接决定无人车自主驾驶的能力和智能化水平,感知系统一般以视觉相机为主搭配不同类别的传感器,因此研究基于传感器融合的感知技术至关重要。近年来,利用可见光相机和毫米波雷达融合的环境感知方案得到了越来越多的研究,文献[1]利用方向梯度直方图(Histogram of Oriented Gradient,HOG)和支持向量机(Support Vector Machine,SVM)获取行人特征,与毫米波雷达检测结果进行特征融合,对不同工况行人具有较高识别率。文献[2]使用立体摄像机和毫米波雷达进行信息融合,利用视觉获取近横向物体运动信息,利用毫米波雷达获取远纵向物体运动信息,检测结果投影至感兴趣区域(Region of Interest,ROI),再结合自身车辆运动状态进行危险环境感知。文献[3]在图像行人检测中加入主成分分析(Principal Component Analysis,PCA)降维,利用加入深度信息的目标匹配方法实现毫米波雷达与机器视觉融合的行人检测,在光线良好、视野清晰的天气条件下具有较好的检测效果。但对于夜晚黑暗无光的场景,可见光相机检测效果会受到很大影响。2018年3月22日,美国一辆Uber无人车撞上一名过马路的行人,致其死亡,这是无人车首起致人死亡事件,警方公布的视频显示,受害人从黑暗处突然出现在车辆前方,车辆闪躲不及导致事故发生。因此需要研究一种行人检测方法提升目前环境感知系统在夜间场景的信息获取能力。由于红外相机获取的是场景中的红外辐射信息,不受光照条件影响,可在夜间场景对行人清晰成像,因此,可以使用红外相机代替可见光相机进行夜间环境感知。

文献[4]对车载红外夜视技术的发展进行了研究,红外视觉被越来越多地应用在车辆辅助驾驶系统以提升行车安全性,并分析了车载红外夜视辅助系统需要能够进行全天候工作,应对红外行人尺度、外观变化大以及存在遮挡等问题的挑战。因此需要更好的目标检测算法来解决红外行人检测存在的问题。随着深度学习的发展,基于卷积神经网络进行目标检测的模型展现出了良好的效果,文献[5-6]使用两阶段(two-stage)目标检测算法,在候选区域运行目标分类器进行检测,文献[7-9]YOLO(you only look once)系列一阶段(one-stage)目标检测算法,将目标检测问题转换成回归问题,不断改进网络模型结构和细节,提升了检测速度、信息覆盖度和泛化能力。文献[10]将YOLO算法应用于红外图像行人检测,改进模型输入分辨率取得较好效果,文献[11]为YOLO的第四个版本在网络结构和多尺度检测上做了进一步改进,符合红外图像行人尺度变化大的特征,可以用来进行红外图像行人目标检测的研究。在红外图像中检测到行人目标之后,还需要获得行人的距离速度等信息,文献[12]利用红外图像进行测距研究,10 m~70 m内的测距绝对误差在3米之内,70 m~110 m绝对误差远大于3 m,而毫米波雷达在中距离绝对误差在0.25 m之内,长距离在0.5 m之内,具有更好的测距精度,同时文献[13]分析指出毫米波雷达以其波长短、穿透能力强、大气衰减小、不受尘埃及恶劣天气影响的特点具备全天候障碍物距离和速度测量的能力,因此毫米波雷达满足与红外相机在夜间环境进行行人检测的条件,同时红外图像行人检测结果可以弥补毫米波雷达在场景语义信息获取能力的不足,研究两传感器融合感知可以实现优势互补。在视觉与毫米波雷达融合策略选择上,文献[14]利用卡尔曼滤波处理Mobileye和毫米波雷达匹配的目标,文献[15]利用毫米波雷达产生ROI并在其中运行图像检测算法。由于红外图像测距精度不高,毫米波雷达对行人目标进行检测时产生的回波不稳定,本文不使用这两种融合策略。

本文提出的基于红外相机和毫米波雷达融合的夜间行人检测,对两传感器数据分别进行处理,红外图像处理采用改进的YOLOv4算法,毫米波雷达数据处理采用卡尔曼滤波和生命周期算法,利用红外图像的语义信息和雷达数据的运动状态信息进行基于特征的融合,实现行人检测;在此基础上发挥毫米波雷达的运动跟踪优势,提升红外图像对运动过程中存在遮挡的行人的检测能力。最后通过实验证明融合算法的有效性。

1 基于红外相机和毫米波雷达的融合算法

1.1 融合算法设计

基于红外相机和毫米波雷达融合的夜间行人检测融合算法如图1所示,首先进行两传感器原始数据的采集,并进行数据的时间配准,确保采集到同一时刻的场景信息,再分别处理两传感器数据:对红外图像利用改进YOLO网络进行行人检测,通过检测算法输出的检测框获取行人类别信息;对场景中的毫米波雷达数据先进行基于潜在危险的目标预处理以降低模型复杂度,再将上一个算法处理周期的雷达有效目标与本周期数据预处理之后的目标进行一致性匹配,匹配成功的目标进行卡尔曼状态估计,对于未匹配的目标,可能是场景中新出现的目标也可能是已经不在当前场景的旧目标,对于新目标执行目标生成算法来避免虚假检测,对于仍处在生命周期内的旧目标进行状态预测来避免雷达漏检,最终获得检测目标的距离和速度信息。数据处理完成之后,对两传感器检测目标进行空间匹配,将雷达坐标系中的点投影到图像的像素坐标系下,基于图像检测框执行目标匹配算法,使得雷达检测目标带有的距离和速度特征与检测框中的行人类别特征进行融合,最终实现行人检测。

图1 传感器融合算法图

在行人运动过程中,由于红外图像对比度低或可能被路边障碍物部分遮挡,图像检测算法可能存在漏检导致没有检测框输出,此时目标匹配失败,导致融合没有结果输出。对于这种情况,如果此时毫米波雷达检测到行人,可以利用已经进行过类别特征融合的毫米波检测目标点弥补基于图像检测的不足。因此在行人后续运动过程中,对图1中的融合算法进行改进,改进模型如图2所示。

图2 行人运动过程算法改进模型图

改进模型从目标匹配开始描述,依然将检测框中目标与毫米波雷达目标进行匹配,若匹配成功,进行行人类别特征和距离、速度特征融合,然后判断当前毫米波雷达目标是否第一次与图像框进行匹配,是第一次则将类别信息反馈给毫米波目标检测结果,毫米波检测目标增加一个标志位记录当前目标的类别;不是第一次匹配,则进行结果输出。

目标匹配成功之后,如果已经记录了类别信息的毫米波雷达目标点并没有与红外图像框成功匹配,则表明后续行人运动过程中存在红外图像漏检,这种情况下直接用毫米波检测的信息进行输出,弥补红外图像行人检测算法中的漏检,这类目标称为雷达成功跟踪目标。

对融合算法中检测目标不同特征的选取方法进行总结,如表1所示。

表1 融合特征及选取方法

1.2 红外图像行人检测算法

本文基于YOLO网络进行红外图像行人检测。YOLO网络的检测策略是将输入图像分为7×7的网格,每个网格均进行2个检测框的预测,且每个网格只预测一个类,输出检测框是检测目标的置信度以及多目标预测概率。对于检测目标而言,目标中心所在的网格单元负责该目标的检测,输出边界框(bounding box)并用置信度分数(confidence)来表征边界框是否包含目标以及目标位置是否正确,计算如式(1)。

式中,Pr(object)为边界框中存在物体的概率,表示交并比(Intersection Over Union,IOU),计算如式(2)。

式中,area为图像区域面积,PB(Prediction Box)表示预测框,GT(Ground Truth)表示真实区域。YOLO最终预测结果即为7×7×2个检测框,再使用阈值筛选和非极大值抑制去除冗余窗口。

YOLOv3使用骨干网络darknet53并加入特征金字塔网络(Feature Pyramid Networks,FPN)结构[16],以其良好的性能和具有普适性的网络得到较为广泛的应用,后续基于YOLO的算法均在YOLOv3的网络基础上进行性能的提高。

YOLOv4将一阶段目标检测算法分为对原始图像进行操作的输入层(Input),特征提取的骨干网络(Backbone);负责最后的预测的头部(head),连接Backbone和head的颈部(neck),并对各个部分在YOLOv3的基础上进行改进。

YOLOv4保留了darknet53架构并使用跨阶段局部(Cross Stage Partial,CSP)[17]网络结构对骨干网络进行改进。CSP网络的特点是将输入特征图按照通道切割,只将其中一部分经过网络前向传播,而另一部分则与前一部分经过网络的输出结果直接进行张量拼接,因为只有一部分进入网络,因此参与计算的输入量减少,模型计算量大大减少,减少了梯度信息的重复利用,也减少了内存的消耗使得网络轻量化的同时保持准确性。在neck部分加入空间金字塔池化(Spatial Pyramid Pooling,SPP)[18]模块,增加了不同尺度特征图的特征获取能力,同时在FPN结构中加入路径聚合网络(Path Aggregation Network,PAN)[19]即在上采样形成的特征金字塔之后加入一个自底向上的特征金字塔,融合了不同特征层的特征信息交给检测层进行输出,最大程度丰富特征信息。

YOLOv4作者公开了YOLOv4、YOLOv4-csp和YOLOv4-custom三种网络配置,本文在YOLOv4网络的基础上进行模型训练并进行部分细节改进。

激活函数的选择对卷积神经网络非常重要,为了使网络梯度变化更为平滑从而得到更精确的检测效果,本文使用Swish函数[20]代替YOLOv4骨干网络中的激活函数Mish,Swish函数具有零时的单侧有界性,平滑性和非单调性,表达式如式(3)。

而Mish函数允许一部分负梯度流入,使得神经网络接收更多的信息,在骨干网络之外,本文使用Mish代替Leaky ReLU,Mish函数如式(4)

YOLOv4网络处理检测结果中存在的多余或者错误的目标候选框时采用greedy_nms进行非极大值抑制算法,算法使用式(2)计算IOU,这种计算方法对于两个检测框重叠的不同情况无法进行区分,为了解决这个问题,本文的非极大值抑制算法采用DIOU[21]计算检测框的交并比,DIOU既考虑了检测框的重叠面积又考虑了尺寸和中心点的距离,计算如式(5)

式中,ρ(b,bmax)表示当前检测框(b)与最大概率检测框(bmax)中心的欧氏距离,c表示两个检测框最小外接矩形的对角线长度。

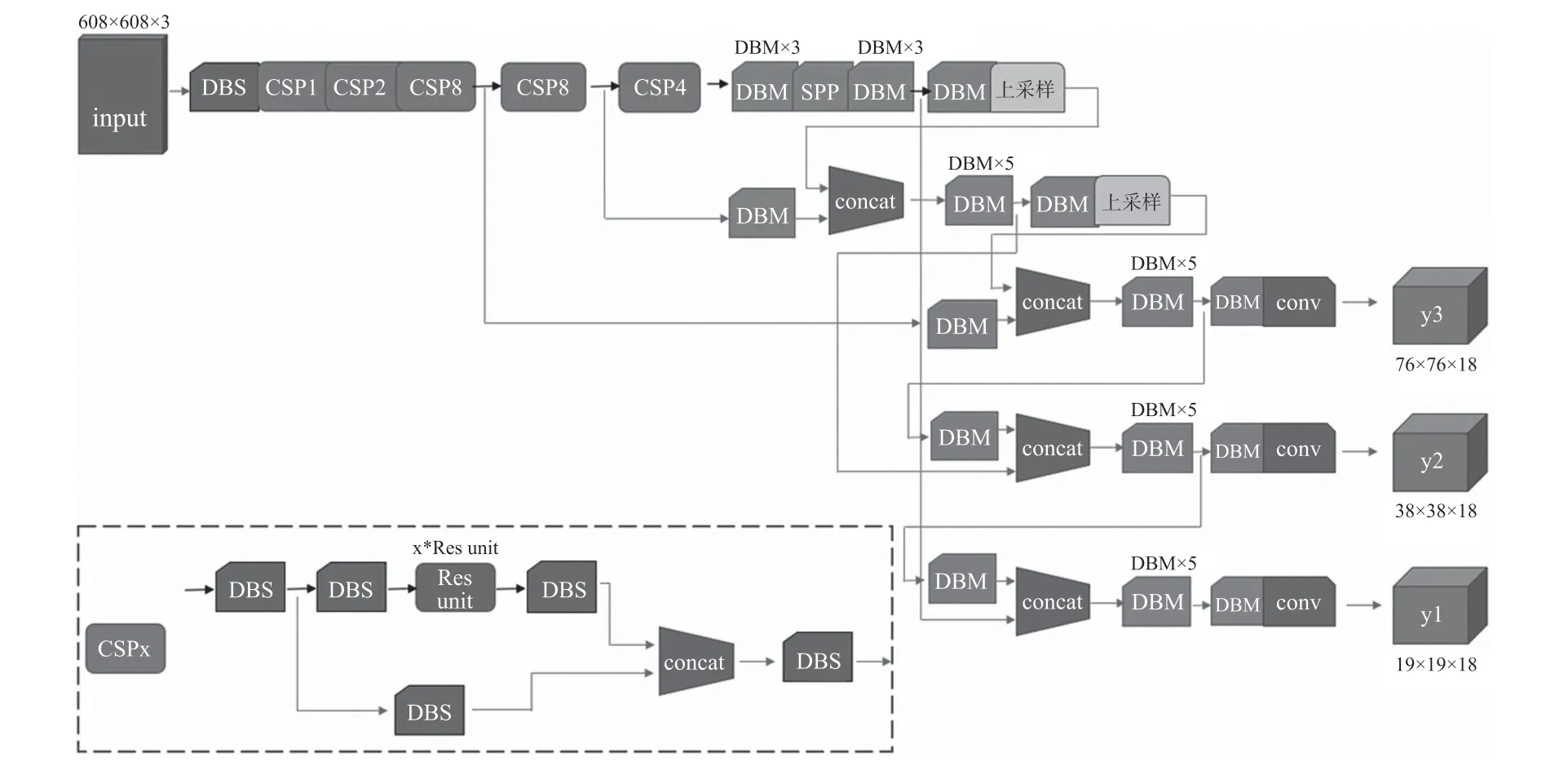

由于改变了backbone中的激活函数,本文将改进后的YOLOv4网络称为YOLOv4_Swish,结构如图3所示。图中DBM(Darknet,Batch normalization,Mish)部分在原YOLOv4网络中为DBL(Darknet,Batch normalization,Leaky ReLU),DBL对应卷积,批量归一化以及Leaky ReLU激活函数,DBM则对应卷积,批量归一化以及Mish激活函数。网络结构中DBS(Darknet,Batch normalization,Swish)与CSPx即为backbone部分,CSPx代表CSP模块,内部有x个残差单元,DBS对应卷积,批量归一化以及Swish激活函数。YOLOv4的backbone中最小单元均为DBM,而在YOLOv4_Swish中替换为DBS。

图3 YOLOv4_Swish网络结构

1.3 毫米波雷达数据处理

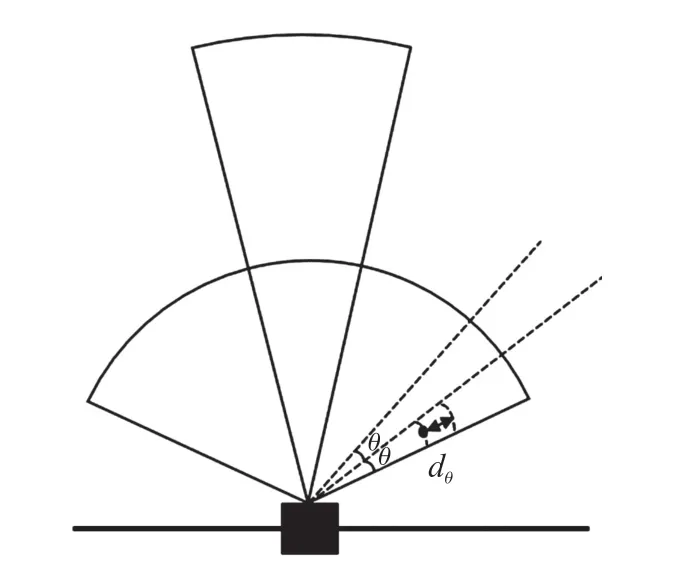

毫米波雷达能够对场景中的长距离和中距离各种类型障碍物进行检测,对于驾驶车辆来说,存在潜在危险的障碍物主要为距离较近和运动的物体,因此为了降低数据处理的复杂度,在避免碰撞潜在危险障碍物的基础上进行雷达数据的预处理。在雷达检测的角度范围内,从检测边缘开始,每一个小角度θ之内选取距离最近的障碍物,从雷达原始检测目标中过滤掉与该障碍物距离超过阈值dθ的静止障碍物,运动物体保留,如图4所示。

图4 雷达数据预处理示意图

由于雷达测量存在着误差,为获取更准确的行人运动信息需要对雷达数据进行滤波处理,本文建立了三阶卡尔曼滤波模型对行人运动的x和y方向的运动状态进行处理,取x方向进行说明。

首先对行人运动这一连续过程建立系统的连续状态方程,如式(6)。

式中,X=[x(t),v(t),a(t)]T表示连续时间域状态向量,A为状态矩阵,B为噪声驱动矩阵,u表示系统噪声。

对该连续时间域运动过程按照毫米波雷达采样间隔进行离散化处理,取检测障碍物x方向的相对距离、x方向相对速度和x方向的相对加速度作为系统状态向量Xk=[xk,vk,ak]T,取x方向的测量距离作为观测向量Zk=[x′k]T。

建立系统从第k次探测周期向第k+1周期变化的系统状态方程如式(7)。

根据精确离散方法,式中:Φ为状态转移矩阵,G为系统的噪声驱动矩阵,ωk为采样周期k的过程噪声。

建立系统观测方程如式(8)。

本文取x方向距离为观测值,H为量测矩阵,Vk+1代表距离的测量噪声。

对该过程使用卡尔曼滤波算法处理方法如下:

再计算先验误差的协方差矩阵并进行更新。

式中,QK表示系统过程噪声的方差,然后进行卡尔曼增益的计算,更新卡尔曼增益。

式中,Rk+1表示测量噪声的方差,利用以上参数进行第k+1采样周期障碍物运动状态的最优估计。

计算新的最优估计的误差的协方差矩阵并进行更新。

更新最优状态,并重复上述过程进行新一周期的状态最优估计。算法初次运行时以观测值作为初始值。

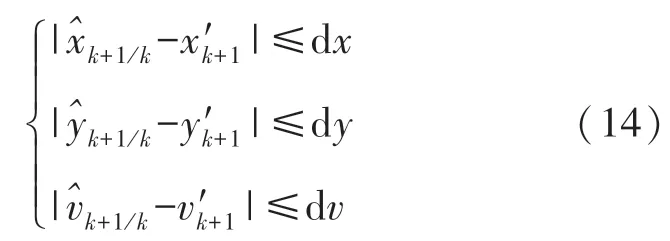

为了确定相邻两个检测周期中雷达目标的对应关系,需要进行目标一致性匹配[22],利用当前状态信息依据式(9)进行下一周期目标状态的预测,比较预测值与测量值之间的差距,选择满足纵向距离变化dy,横向距离变化dx,速度变化dv在阈值范围内的目标为同一障碍物,如式(14)。

利用目标一致性匹配规则进行雷达检测目标匹配,对不同匹配结果依据生命周期算法[23]进行处理,对于能匹配的检测目标,将当前帧雷达观测值与前一帧的算法估计值输入卡尔曼滤波器进行状态估计。对于不能匹配的检测目标,若为新出现的目标,进行目标生成过程,连续三次采样均出现的目标才认为是真实的新目标;若为当前帧未检测出的上一场景旧目标,如果连续检测丢失次数在阈值之内,则利用式(9)进行预测并输出结果,并更新生命周期值,否则认为目标已经消失。最终完成毫米波雷达对当前场景障碍物目标的检测输出。

1.4 两传感器目标匹配

进行传感器数据融合的基础是能将同一场景时刻的毫米波雷达的检测数据点投影在红外图像上,然后结合红外图像的检测结果进行分析,因此需要对传感器检测结果进行时空匹配。

由于传感器的采样频率不同,采用雷达进行采样后触发相机采样的方法完成时间配准,保存该时刻的传感器信息进行数据处理。

为实现空间匹配,需将毫米波雷达坐标系下的障碍物检测结果先转换至红外相机坐标系,这一步可以利用相机外参矩阵进行平移和旋转操作,再利用相机成像模型最终转移至像素坐标系。以相机成像平面为xy平面,垂直于该平面为z方向,则坐标转换可表示为式(15):

式中,(u,v)表示图像中的像素坐标值,Zc为障碍物点在相机坐标系下的Z坐标,R为3×3的旋转矩阵、T为3×1的平移矩阵,(Xm,Ym,Zm)为毫米波雷达坐标系下障碍物坐标,fx,fy,u0,v0均为相机内参。根据实际安装情况进行外参测量,实现雷达坐标系到像素坐标系的转换。

由于两传感器安装的相对位置(如图5所示),毫米波雷达检测行人的检测点投影到图像上一般处于行人障碍物的中间部位,因此目标匹配算法从检测框的中心点出发寻找与之匹配的毫米波雷达检测点,由于行人障碍物细长的形状特点,以检测框宽度为依据进行匹配,匹配距离限制在阈值dlimit之内,阈值计算方法如式(16)。

式中,γ为阈值系数,使用阈值系数考虑了距离远近带来的尺度变化问题[24],测试时γ取值为1.4,Wbox为检测框的宽度的一半,匹配时选取与检测框中心欧式距离最近的雷达点与图像目标进行匹配。

如果两传感器目标匹配成功,则依据表1对检测目标特征进行选取,输出融合结果;如果图像成功检测目标,但是雷达无检测目标结果,则以图像目标检测框的中心点作为行人位置的表征点,将该点依据式(15)转换至雷达坐标系,即可得到该像素点对应雷达坐标系中的物理坐标,从而得到目标的位置信息,同时借助连续视频帧计算行人运动速度信息,以图像检测结果为最终输出结果;如果雷达实现了目标跟踪,红外图像检测框并未输出,则以雷达检测结果作为融合结果输出,雷达模块依据图2所示方法流程记录类别信息,弥补红外漏检。

2 实验及结果分析

2.1 场景采集系统搭建

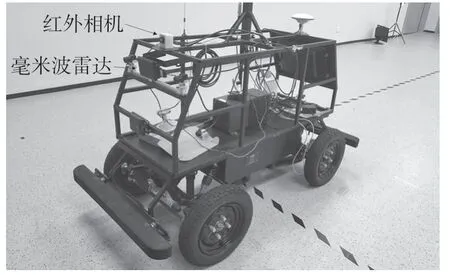

场景信息系统借助百度Apollo智能移动平台搭建,如图5所示。红外相机选用XCore LA3110非制冷红外机芯组件,毫米波雷达为Delphi ESR雷达,车载电源统一为设备供电;车载计算机使用ROS操作系统接收红外相机数据和雷达检测数据并执行本文所述算法。

图5 采集系统设备图

2.2 夜间场景红外图像行人检测实验

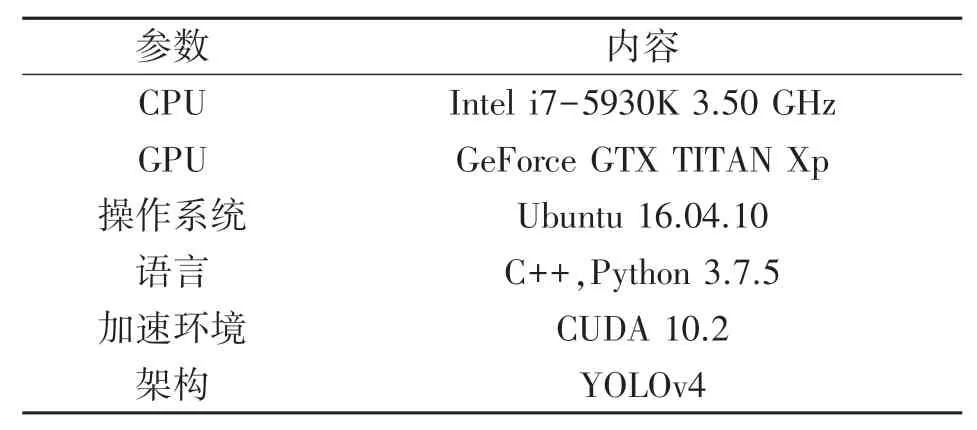

在道路场景中利用红外相机进行夜晚行人数据采集,采集1 698张高质量红外图像并进行标注制作数据集,其中1 197张为训练集,501张为测试集对网络模型进行训练和评价,实验环境如表2所示。

表2 红外图像行人检测实验环境介绍

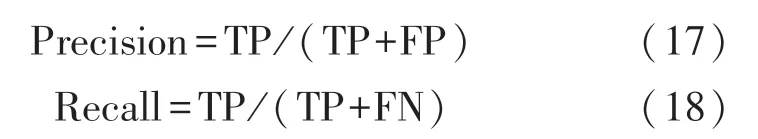

在目标检测领域使用平均准确率(Average Precision,AP)对模型进行评价。利用式(2)计算检测值与真实值之间的比值IOU,以IOU为评价标准将检测结果分为真正例(true positives,TP)、假正例(false positives,FP)和假反例(false negatives,FN),TP表示IOU≥阈值的检测结果的数量,FP表示IOU<阈值的检测结果的数量,FN表示IOU为0的检测结果的数量。据此计算模型的精度(Precision)和召回率(Recall),如式(17)、(18)所示。

平均准确率综合考虑精度和召回率,调整阈值从0%~100%,计算不同阈值时对应的Precision和Recall值,并以此绘制Precision-Recall曲线,计算曲线与x轴之间的面积,如式(19)。

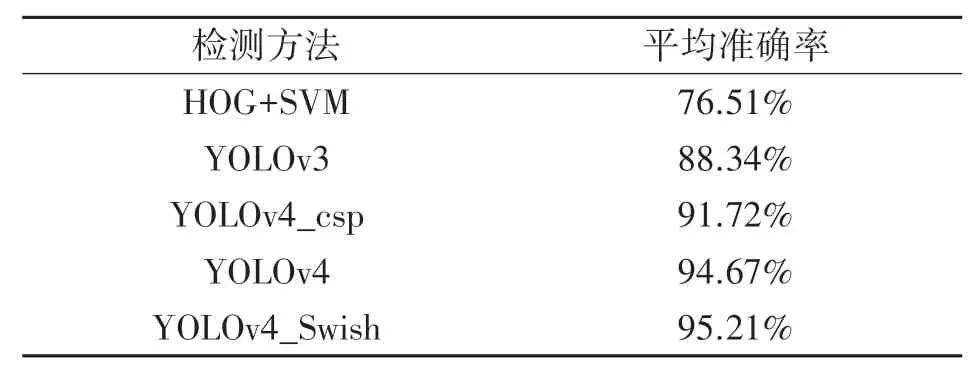

使用不同算法应用于本文的数据集,分别计算平均准确率,如表3所示。

表3 不同模型方法平均准确率对比

可以看出本文使用的改进方法YOLOv4_Swish相比YOLOv4算法可以更准确检测出行人目标,相比使用传统机器学习的方法在图像行人特征提取上具有更好的效果,适用于本文融合算法中红外图像数据处理部分。

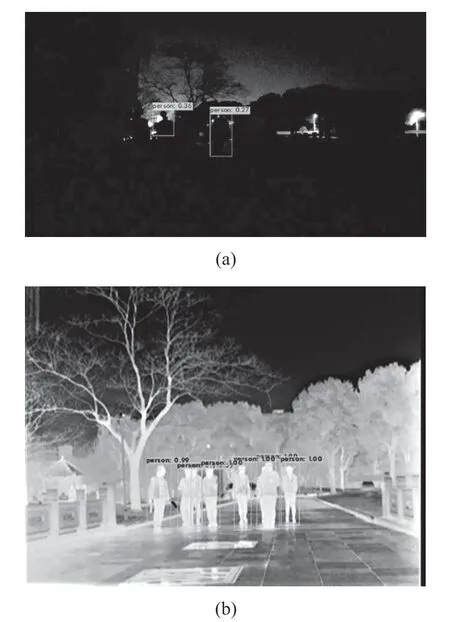

在校园环境下利用可见光相机和红外相机进行夜间视频的同步采集并运行目标检测网络,通过对比可以明显看出红外相机在夜间环境具有明显优势,图6(a)为可见光相机拍摄视频中截取的一帧,图6(b)为红外相机拍摄视频中截取的相似时刻的一帧图像。

图6 夜间环境检测效果对比

图6中可见光图像行人检测采用YOLOv4模型公开的权重和网络配置,红外图像行人检测采用本文YOLOv4_Swish网络及训练的模型权重,验证了夜间场景红外图像行人检测具有良好的效果。

2.3 毫米波雷达目标检测实验

为了说明毫米波雷达对运动行人的检测能力,统计单个行人在信息采集系统的左前方从纵向距离3米行走至纵向距离83 m运动过程的雷达检测数据(原始数据没有检测到目标时以0表示检测结果),并使用1.3节的方法对雷达原始数据进行处理,结果如图7所示。

图7 滤波算法处理前后雷达目标距离数据

图7中的横坐标为雷达采样的周期数,纵坐标为距离,单位为米。图7(a)为原始数据,图7(b)为处理之后的数据。原始数据中有很多检测距离为0的点,这是由于雷达检测行人的回波不稳定出现目标漏检,1 098个原始数据点中出现613次漏检,如果以原始数据作为雷达模块检测结果,雷达目标检测成功率低,导致融合结果中缺失雷达数据,无法从雷达数据结果中获取目标的运动信息,只能以红外图像检测结果作为融合结果;同时,如果雷达检测结果中存在较多漏检,则在红外图像漏检时,雷达无法起到补充作用,对已融合目标难以进行跟踪,导致融合算法检测成功率降低。

采用雷达数据处理算法时,设置生命周期算法中允许最大连续检测丢失次数为15(15个雷达采样周期,0.75 s),这考虑到了系统的实时性要求。由处理结果图表明,雷达数据处理算法能够对漏检目标进行较好的预测,应用数据处理算法后,只存在129组漏检数据,对于纵向距离在50 m以内的行人目标能够进行较为准确的连续检测,50 m以上实现部分连续检测,预测距离数据能够与目标运动趋势相符合。

2.4 融合算法实验

行人检测融合算法的重点是将毫米波雷达的检测目标点与红外图像中的行人进行目标匹配,典型匹配结果如图8所示,图中的行人检测框为YOLOv4_Swish算法检测,圆点为雷达检测目标点。

图8 目标匹配结果图

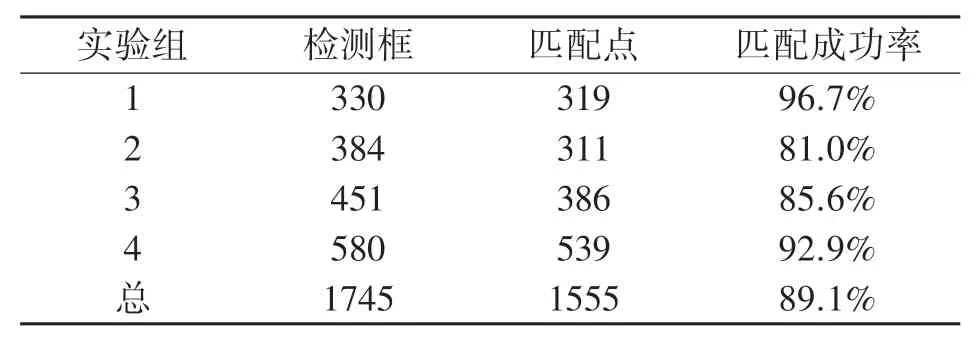

从匹配结果可以看出,对于稀疏行人,雷达检测目标具备匹配点,对于并排行走的密集行人只有一个目标匹配点,这是受到Delphi ESR雷达在中距离多目标辨别能力限制(多目标辨别距离1.3 m)。因此进行目标匹配实验时,综合考虑雷达的检测范围和多目标辨别能力,在雷达可检测的角度范围内,选取稀疏行人场景计算两传感器检测目标的匹配准确率。

在校园道路进行目标匹配算法重复实验,以红外图像中成功检测的行人为基础,统计与之成功匹配的毫米波雷达目标点。表4中实验组1为中距离单人行走场景,实验组2包含较多远距离行人目标,实验组3、4为稀疏多行人场景,选取雷达检测效果较好的检测范围内的目标进行统计,以红外图像检测框为基准,计算有多少个雷达点与红外图像框能够匹配成功,并计算匹配成功率。

表4 行人特征融合目标匹配准确率

实验结果如表4所示,总体目标匹配成功率为89.1%,达到了良好的效果,具备了后续行人运动过程改进融合算法的实验基础。

分析之前的夜间红外图像行人检测实验,红外图像漏检的行人主要特点为行人与背景环境对比度低或者行人存在遮挡,因此在具备这样特点的场景下进行改进融合算法的实验,证明毫米波雷达对红外图像行人检测总体检测率的提升。

图9(a)、9(b)为夜间行人与背景环境对比度低导致行人检测不稳定的场景示意图;图9(c)、9(d)为行人运动过程存在部分遮挡示意图,图9(c)的行人在运动至图9(d)的时刻被路边障碍物遮挡,红外图像检测算法并没有检测出目标。因此在图9(b)和图9(d)的场景中,雷达检测结果作为行人检测的最终输出结果,提升了红外视觉检测能力。

图9 运动过程行人融合检测

在校园道路进行夜间驾驶环境行人检测重复实验,实验中包括上述红外视觉检测不稳定的场景,也包括多人并排行走的场景,分别使用视觉、雷达和融合的方法对场景中的行人进行检测,检测结果如表5所示。

表5 不同方法检测结果

从表5可以看出,传感器融合方案能够在一定程度克服传感器弊端,提升单传感器检测成功率,传感器融合的方案总体上具备较好的夜间环境行人检测能力。

2.5 对比分析

如表6所示,从不同传感器方案角度出发分析红外相机和毫米波雷达融合的夜间行人检测效果。相对可见光相机和毫米波雷达融合的方案,红外相机在夜间行人检测表现出了更好的性能;相比红外相机和毫米波雷达单独检测方案,传感器融合方案解决了毫米波雷达语义信息缺失和红外相机测距测速不准确的问题。

表6 不同传感器方案检测对比

从目标特征检测方法进行分析,与文献[1]相比,本文使用YOLOv4_Swish进行特征提取,相比HOG+SVM特征提取效果更好;与文献[3]相比,本文在特征融合的基础上做了进一步改进,达到利用毫米波雷达提升红外图像检测成功率的效果。与文献[12]相比本文不使用红外测距,使用测距测速精度高的毫米波雷达检测行人运动信息;与文献[15]相比,由于毫米波雷达对行人检测不如汽车稳定,本文不适合使用毫米波雷达生成ROI再运行图像处理的算法,而是采用两传感器分别处理再进行基于特征的融合方法。

3 结束语

本文采用的基于红外相机和毫米波雷达融合算法,既发挥了视觉传感器在目标类别特征获取的优势,又发挥了毫米波雷达在目标运动状态特征获取的优势。采用YOLOv4_Swish处理红外图像提升了模型的平均准确率,相比传统方法得到更为精确的行人检测结果,再利用毫米波雷达提升红外图像在行人存在遮挡等场景下的检测成功率。实验结果表明,应用本文的行人检测方案能够提升驾驶员和行人夜间出行的安全性。相比目前自动驾驶环境感知方案的主流传感器可见光相机和激光雷达,红外相机和毫米波雷达在烟尘等恶劣天气具有更强的抗干扰能力,如何利用本文传感器方案克服目前主流传感器的弊端也是后续重要的研究内容。