基于分层强化学习的联合作战仿真作战决策算法*

于博文,吕 明,张 捷

(南京理工大学,南京 210094)

0 引言

随着作战装备的发展,以及军事仿真技术的不断完善,针对协同作战的仿真建模已经成为指挥与控制(Command and Control,C2)领域的重要研究方向,是决定战争胜负走向的主要影响因素[1]。目前大多数指控研究主要集中在基础作战单元的仿真研究上,其目标明确、基础行为模型建模相对较为简单,从微观层面上描述实体的作战行为[2-6]。而针对宏观层面的战役指控仿真研究相对较少,其主要关注的对象从单个作战实体变为多个作战实体,需要对战场态势信息进行综合考虑,如敌我双方兵力部署、战场环境等。真实战场中信息跨域特性明显,信息维度较高,如何高效地处理战场态势信息一直以来都是仿真作战研究领域的重点及难点。

随着人工智能的迅速发展,未来战争中的作战体系自主能力会跨越式地提升,战场态势信息的获取和应对速度将会成为左右战局的决定性因素[7]。近年来,人工智能技术在围棋、星际争霸等领域取得了重大突破,同时也表明了强化学习、人工神经网络等技术应用于指控建模的可行性。指控与人工智能结合将会成为指控领域的重要研究方向。基于此,结合战场的实际情况,本文提出了一种基于分层强化学习的联合作战仿真作战决策算法,以空地一体化联合作战为背景,分析了武器装备体系作战决策流程,采用“分而治之”的策略,将整个战场的作战决策分为宏观的战役决策和微观的战术决策,通过决策模型实现自主作战决策,最后,通过自主开发的仿真平台对其可行性及性能进行验证,为联合作战中指挥决策的适应性机制问题提供较为有效的解决方法。

1 基于分层强化学习的联合作战仿真作战决策算法

1.1 联合作战决策流程

战场环境瞬息万变,如何有效地对战场态势进行认知和作出有效的作战决策,是左右战争胜负的决定性因素。武器装备种类繁多,使得战场环境变得更为复杂,战场态势信息爆炸式增长,对响应速度的要求更高,依托于指挥员的传统作战模式无法在短时间内完成全局作战资源的规划和调度,无法适应现阶段作战的需求[8],因此,需要仿真系统中的决策单元在对抗环境中具有自适应能力和较强的决策能力,才能有效地根据敌方的作战部署来快速调整我方的对抗策略,提升作战计划的有效性与灵活性。基于此,设计如图1 所示的作战资源指挥流程,通过有效的态势信息获取手段,并结合智能决策单元通过仿真系统对作战资源进行合理规划调度。

图1 基于仿真作战系统的战场资源指挥流程

1.2 决策行为描述

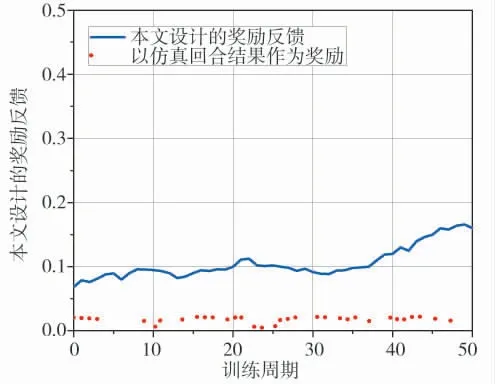

依据文献[9]将作战指挥决策分解为战役决策和战术决策,按照其层级关系对状态空间和指令空间进行分割。战役决策针对全局作战态势信息(敌我作战资源伤亡情况、主要打击目标等)下达宏观作战指令,例如,空中打击、地面打击、侦察等。战术决策对执行宏观作战指令的作战编组下达微观作战指令,例如,地面打击,以歼灭敌方地面作战部队为目标,根据交战双方作战单位数量、阵型等局部作战态势信息,对作战单元下达攻击、机动规避等微观作战指令,其他战术决策与此类似。如图2 所示为决策行为示意图。

图2 指挥决策智能单元决策行为示意图

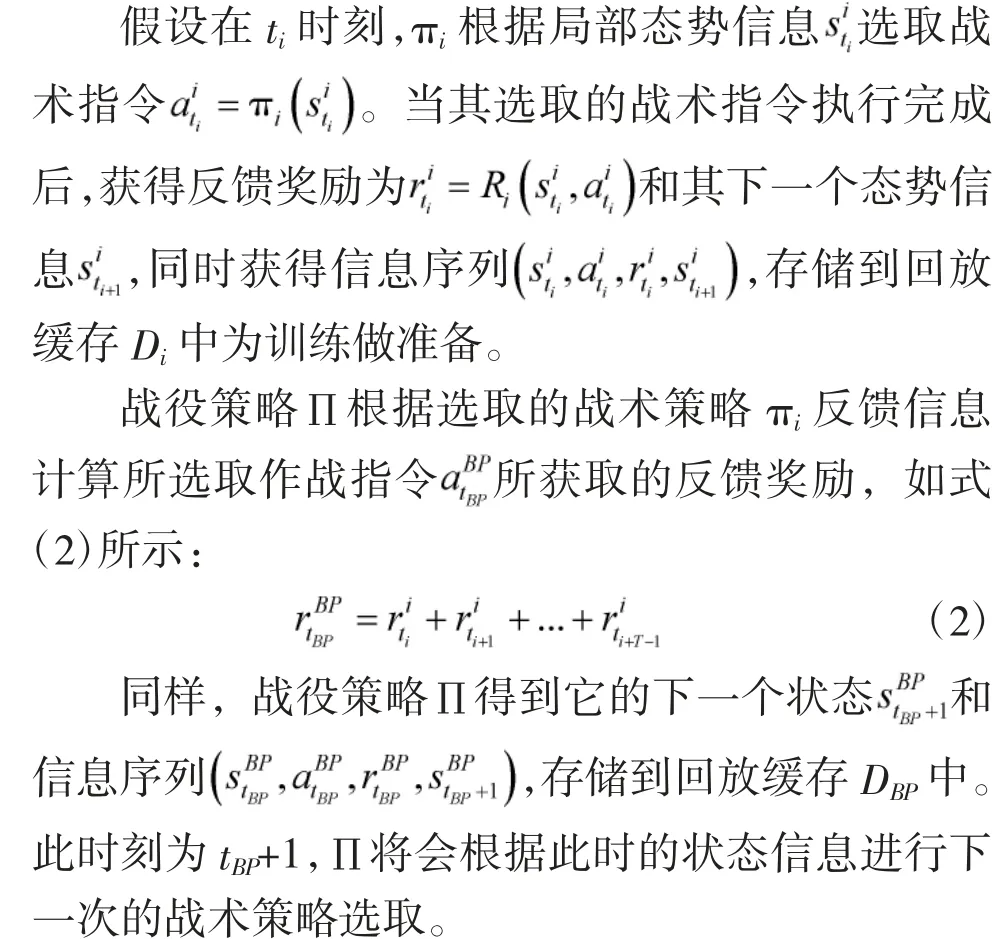

1.3 分层结构

本文针对仿真作战决策设计的层次结构如下页图3 所示。定义BP 为战役决策、bp 为战术决策,∏为战役策略,定义∏的状态空间、指令空间、反馈奖励为SBP、ABP、RBP,用(π1,π2,…,πm)代表在战术决策池内的m 个战术策略,定义πi的状态空间、指令空间、反馈奖励为Si、Ai、Ri。

图3 总体层次结构

1.4 奖励函数

奖励函数在强化学习中具有重要作用,在仿真作战中,目标是在战损最小的情况下对敌方造成最大伤害。如果奖励函数设计基于最后的胜负结果,它将会变得非常稀疏,从而导致学习速度变慢。因此,本文针对不同的战术策略设计与其执行结果相关的奖励函数。例如,地面打击策略的奖励如式(3)所示:

式(3)中,LossO为我方损失兵力,KillE为我方歼灭敌方数量,Destroy_mainE为我方销毁敌方重要目标的数量,补给策略的奖励如式(4)所示:

Standardnum、Lownum、OutOfWorknum分别为处于不补线、视补线、急补线的装备数量。其他战术策略的奖励函数设计与此类似。而对战役策略的奖励包括己方奖励和全局奖励,己方奖励包括我方基础物资、作战物资、所有武器装备的消耗情况和重要作战资源的毁伤程度;全局奖励包括被歼灭的敌方武器装备和重要目标的数量,如式(5)所示:

式(5)中,fSA、fSB为基础物资、作战物资消耗的系数,fWH、fIH为武器装备、重要作战资源的毁伤程度系数,fECCL、fEWL为被歼灭的敌方武器装备、各重要目标的数量的系数,ρ1、ρ2作为己方奖励、全局奖励的权重系数。

1.5 网络结构

Q-Learning 此类表格强化学习方法在处理较大的状态空间问题时,具有一定的局限性。为了解决这个问题,在设计作战决策算法时,采用改进的近端策略优化算法。同时,为了更全面地获取仿真环境的态势信息,将执行作战指令的基础单元视图信息和鹰眼视图信息作为决策神经网络的输入信息,并设置其输入形状224×128×3 和128×128×3,通过稠密连接卷积神经网络[10]提取特征信息,其参数配置如下页表1 所示,结合系统统计数据作为决策网络的输入。在决策网络中,采用ReLU 函数作为隐含层的激活函数,Softmax 函数作为其输出层的激活函数,输出信息为每个战术指令的执行概率。我们设计的模型输入、输出及其结构如图4 所示。

图4 分层强化学习模型的网络结构

1.6 训练方法

整个训练学习的过程中应用改进的近端优化学习算法来更新网络参数,具体步骤如图5 所示。在PPO(Proximal Policy Optimization)算法[11]的损失函数中加入Entropy、Self-learning 的损失计算,以平衡其在学习过程中对信息序列的探索和发现,损失函数如式(6)所示:

Episodic Memory Deep Q-Networks(EMDQN)将经验回放机制与结合到一起,有效地提高了采样效率[12],因此,将EMDQN 的方法迁移到强化学习算法PPO 中。式(7)中Self-learning 部分如式(10)~式(12)所示:

2 作战仿真及结果分析

2.1 作战想定与仿真原型

为了进行联合作战的仿真研究,基于Unity3D引擎自主开发了一款以空地一体化联合编组对抗为背景的武器装备作战对抗仿真原型系统,如下页图6 所示,系统中的物理作战空间为100 m2×100 m2的三维空间,根据实际所需的作战装备及资源进行3D 模型建模,系统中的3D 模型均按照Unity3D 中的标准比例尺进行建模,各类型武器装备均可动态编辑和添加,指挥决策智能单元则根据对抗双方的编队结构由仿真系统自动添加。仿真开始时,按照预定位置部署红蓝双方的作战编队,作战开始时,双方按照编队预定的移动方向进行移动,直到双方遭遇并进行作战仿真对抗。其中,战术层、战役层决策均由指挥决策智能单元来进行决策。

图6 仿真系统运行界面

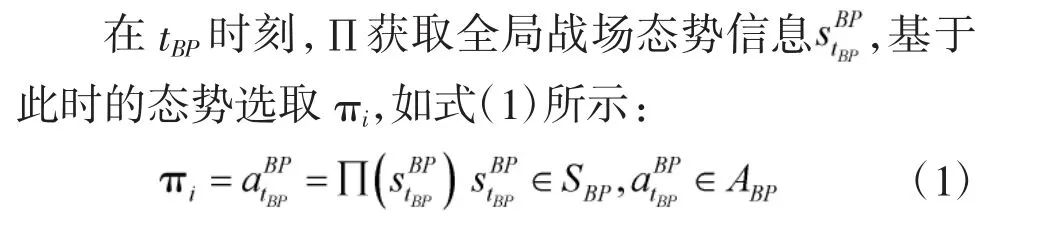

红蓝双方根据要求配置其战斗编队,其中,参与对抗的红蓝双方参战资源一致,双方战斗资源配置如表2 所示。

表2 仿真战斗资源配置

红方采用本文所提出的作战策略决策算法,战术决策主要包括:空中打击、地面打击、补给、感知;蓝方采用基于状态判断的作战策略决策方法,根据当前双方状态信息下达行动指令,状态-行动指令信息总结归纳,如下页表3 所示。

表3 状态-行动指令信息表

训练周期设置为500,每个训练周期内完成100 次仿真对抗作战,每个仿真对抗作战最大仿真步长设置为1 500,战役策略每4 s 选择一个战术策略,战术策略每1 s 执行一个战术指令,学习速率0.001,折扣因子0.9,ρ1、ρ2设置为1。

2.2 实验结果分析

2.2.1 层次结构与非层次结构效能对比

首先研究层次结构和非层次结构对决策单元学习效率的影响。去掉图3 中的战役策略选择模块,变为非层次结构,决策模型直接通过原始态势信息来进行作战决策学习。两者实验结果对比如图7 所示,可以看出在训练的初始阶段,两者胜率相差不大,随着学习周期的增加,层次结构决策模型的学习能力和最终学习效果明显优于非层次结构决策模型。可以看出,引入层次结构后,按照战役决策、战术决策将原始状态空间和指令空间分为若干局部空间,缩小了决策网络学习时状态空间的维度,可以引导指挥控制决策单元脱离盲目的搜索过程,有效提高其学习效率。

图7 层次结构与非层次结构胜率对比

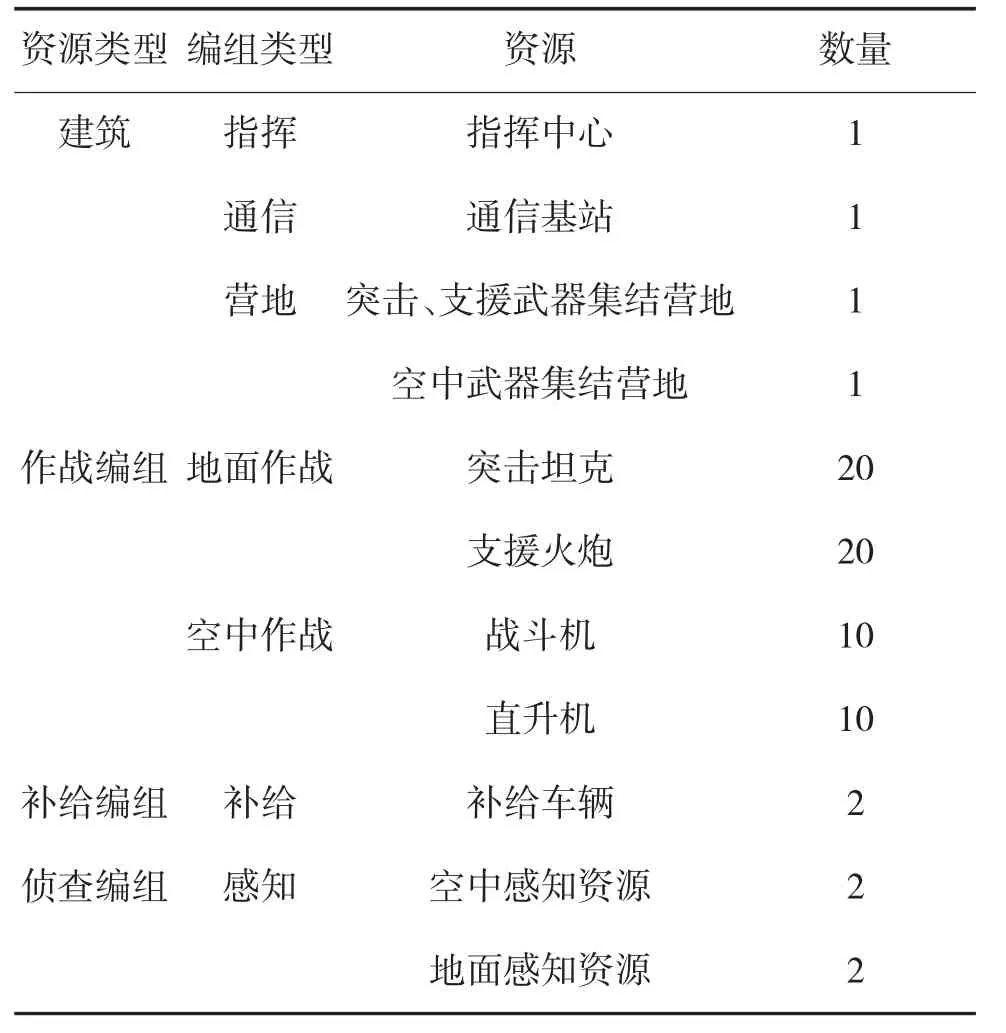

2.2.2 奖励函数效能对比

本文所提出的奖励函数反馈和以仿真结果为奖励函数反馈如式(13)、式(14)所示:

为了验证Rhandcrafted和Rwin-loss对模型学习过程的影响,进行了对比实验,实验结果如图8 所示,可以看出,如果采用以Rwin-loss作为奖励反馈,随着训练周期的增加,其胜率并没有提高的趋势,效果较差,由于其过于稀疏,无法在策略学习的过程中提供有效的奖励反馈,在执行决策指令时,可能会忽略某些直击要害的作战指令。而采用本文所设计的Rhandcrafted的奖励反馈,与时间步同步提供决策指令反馈,可以保证每条作战指令结束时均可得到其相对应的激励反馈,保证各个作战单元具有较高的作战效能,可以有效提高决策单元的学习效率。

图8 目标奖励函数与仿真回合结果作为奖励胜率对比图

2.2.3 超参数效能对比

用各种不同的参数进行实验,发现在每次迭代的参数更新次数,对决策单元的整个策略学习过程有较大的影响,而其他参数对训练影响不明显。当更新次数较小时,整个学习过程变得不稳定且难以收敛。通过适当提高其更新次数,可以有效解决此问题。图9 为不同参数更新次数的实验结果对比。

图9 参数更新次数对胜率的影响

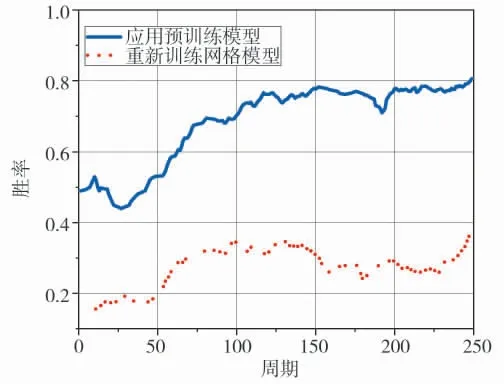

2.2.4 模块化训练效能对比

本文采用的是层次学习结构,可以根据实际情况任意替换战术策略,当某战术策略被替换后,整个决策网络的参数都会被保留下来,在重新学习和训练的过程中,只更新新增的策略参数部分,这样可以大大提升决策网络的学习速度。相反地,若采用非层次网络结构,当修改某一个战术策略时,需要重新训练整个决策网络,这将会大大降低效率。如图10 所示,在实验中对某战术策略进行替换,可以看到模块化的训练方式可以有效提高决策网络的学习效率。

图10 不同网络模型训练对比

2.2.5 仿真可视化结果分析

在算法收敛阶段选取一组仿真作战数据,通过仿真系统的回放功能对算法进行解析。图11 为各个作战阶段的战斗画面。

图11 仿真可视化场景

其中,图11(a)为红蓝双方完成编队侦查编组部署、寻找敌方作战单元的画面;图11(b)为红蓝双方根据侦查信息完成作战编队部署,即将展开作战的画面;图11(c)为红蓝双方在作战区域激烈对战的画面;图11(d)为红方战事占优而蓝方根据预案撤退的画面;图11(e)为红方乘胜追击歼灭蓝方所有有生作战资源,红方取得最后胜利画面。

通过对上述仿真数据进行分析,可得出红方编队取得胜利的主要原因有以下几个方面:1)红方优先派出空中打击力量和支援武器对蓝方地面支援武器进行毁灭打击,致使其无法为蓝方突击武器提供火力支援;2)红方采用支援武器配合突击武器对蓝方突击武器进行联合打击,在红方火力压制下作战能力明显下降;3)红方基础资源和战斗资源合理分配,保证了其具有持久作战的能力;4)红方合理的战术机动,使其规避了蓝方部分支援火力和空中打击,降低了红方的作战伤亡。

3 结论

本文提出了基于分层强化学习的联合作战仿真作战决策算法,采用“分而治之”的策略将作战决策分为战役决策和战术决策,对态势信息、指令空间等进行有效的层级划分,通过强化学习来促进决策网络的进化。同时,提出了一种改进的近端策略优化算法,有效提高样本数据的利用率效率。最后,通过自主开发的仿真作战平台,对其可行性进行了验证。本文研究的内容在信息化对抗的大背景下,可以为指战员在处理复杂作战任务决策时提供有效的辅助决策支持。