环境效应检测与评价中的图像识别技术综述

陈星昊,舒 畅,黄 伦,李念林

(1.西南技术工程研究所,重庆 400039; 2.环境效应与防护国家重点实验室,重庆 400039; 3.海南万宁大气环境材料腐蚀国家野外科学观测研究站,海南 万宁 571522)

1 引言

装备环境效应是指装备在其寿命周期内的各种单一或组合环境作用下,引起装备的材料、元器件、结构件等出现疲劳、腐蚀、磨损、老化、性能退化或降级的现象。装备环境效应的采集与分析是装备环境适应性评价的基础,是保障装备在寿命周期内正常使用的关键。在装备环境效应中,表观损伤是其中最直接的体现。通过对表观损伤的检测与分析,可以在一定程度上对装备的性能、功能的衰退起到预警作用。如通过表面防护涂层环境效应的表观损伤分析,可判定部组件涂层边缘起泡时,该处的基体金属有一定程度的腐蚀,这对装备部组件的维护维修起到了预示预警作用。装备环境效应的采集与分析对于装备环境适应性评价的重要性毋庸置疑,但现阶段,装备环境效应的采集与分析主要依靠具有一定评定经验的专家人工采集及分析评定,其评定方式具有较大的主观性,评定结果与评定专家经验密切相关,不同的专家可能会产生不同的评定结果。另一方面,当需要采集大量表观损伤图像进行分析评定时,人工操作往往会耗费大量的时间,并且还会影响采集及分析评定工作的准确性和有效性。但随着近年来图像识别技术蓬勃的发展,特别是机器学习和深度学习在目标检测、目标分割等问题上的技术突破,给装备环境效应检测与评价工作带来了新思想,提供了新方案,使得客观、快速、准确的评价成为可能。

2 图像识别技术研究进展

图像识别是一门以图像为研究对象,利用计算机等数字化的工具,分析处理包含于图像中的内容,从而认识图像中要检测的目标的技术。按照图像识别技术一般识别步骤,其可以分成图像预处理、特征提取和学习和特征分类等主要内容。这几个方面的内容可涵盖图像处理、模式识别、机器学习等相关学科,多学科的交叉才促使图像识别技术蓬勃发展。

2.1 图像处理技术

图像处理是指通过计算机或其他数字化手段对图像进行去噪、增强、复原、分割和缩放等处理的方法和技术,其处理后得到的图像是后续特征提取的基础。常见的图像处理有图像灰度化与二值化、直方图均衡化、中值滤波、边缘检测、图像腐蚀与膨胀等。

彩色图像的颜色空间主要有RGB、HSV、YUV和HLS等[1]。一张RGB颜色空间的图像如以黑色为基准色,并且让图中的每个像素都变成黑色的0%~100%之间的某个饱和度,则变换后的图像就是灰度图。图像二值化是将其每个像素点都设置为0或者255的灰度值,使得变换后的图像呈现出“非黑即白”的视觉效果。图像灰度化与二值化的目的是节约图像的存储成本,进一步加快图像处理的时效性。

图像直方图是其灰度分布规律的一个统计,通常会利用特定的变换函数进行直方图均衡化等操作。根据转换后的直方图对原图进行修改,则修改后的图像所占的像素空间会被拉大,加大了图像的整体反差,会突出一些图像细节,从而达到图像增强的目的。

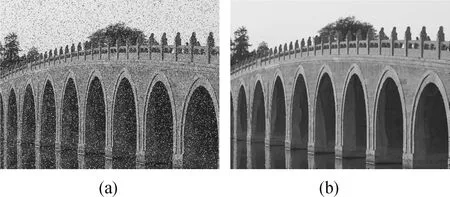

中值滤波就是把一张图像每个像素点的灰度值转换为其某邻域内所有像素点灰度值的中值。其滤除脉冲影响和图像扫描噪声的效果是最好的。图1展示了中值滤波前后图像。

图1 原图像(a)和中值滤波后的图像(b)Fig.1 Original image (a) and median filtered image (b)

图像边缘是相邻像素灰度发生阶跃或强烈变化的像素的总集,是区分前景和背景之间、不同物体之间、不同基元之间的关键因素。其变化类型有阶跃型、屋顶型和凸缘型等[2]。

对于图像中的噪点和断裂点,一般会对图像先进行形态学的膨胀处理,然后再对图像进行腐蚀处理[3]。这种先膨胀后腐蚀的操作是闭运算。用来消除图像毛刺,平滑形状边界,而不改变其面积的操作是开运算。

2.2 模式识别技术

图像处理技术是把图像中所有的特征给找了出来,但是有的特征对图像识别有用,有的特征对图像识别无用,甚至会干扰图像正确识别分类,如何正确地将特征与图像匹配起来是非常重要的,模式识别就是完成特征与图像匹配的技术。

模式识别指的是利用计算机等数字化的机器设备自动分析,使计算机自己识别事物。例如,识别人的笑脸时,事先人为设定笑脸的特征——“嘴角上扬”,那么模式识别就是比照“嘴角上扬”这一特征去寻找出对应的笑脸图像,完成特征与图像的自动匹配。通过机器自动识别分析对象是模式识别研究的关键,而识别偏差的大小是评判模式识别系统性能的重要指标。

2.3 基于深度学习的图像识别技术

深度学习是机器学习的一个发展阶段,其是浅层学习的延伸。典型的浅层学习模型包括SVM(支持向量机)、Boosting、MaxEnt(最大熵方法)、高斯混合、Logistic回归模型等[4]。2006年,Hinton提出了深度学习的概念,其作为一种深层神经网络,是由许多相互独立的神经元组合而成,每一层的神经元都与上一层的神经元相连接。例如典型的深度学习网络DNN,其输入和输出都是向量[5],输入向量的每个分量分别对应识别对象的一个特征,而输出向量的每个分量对应的是识别对象的一个类别。

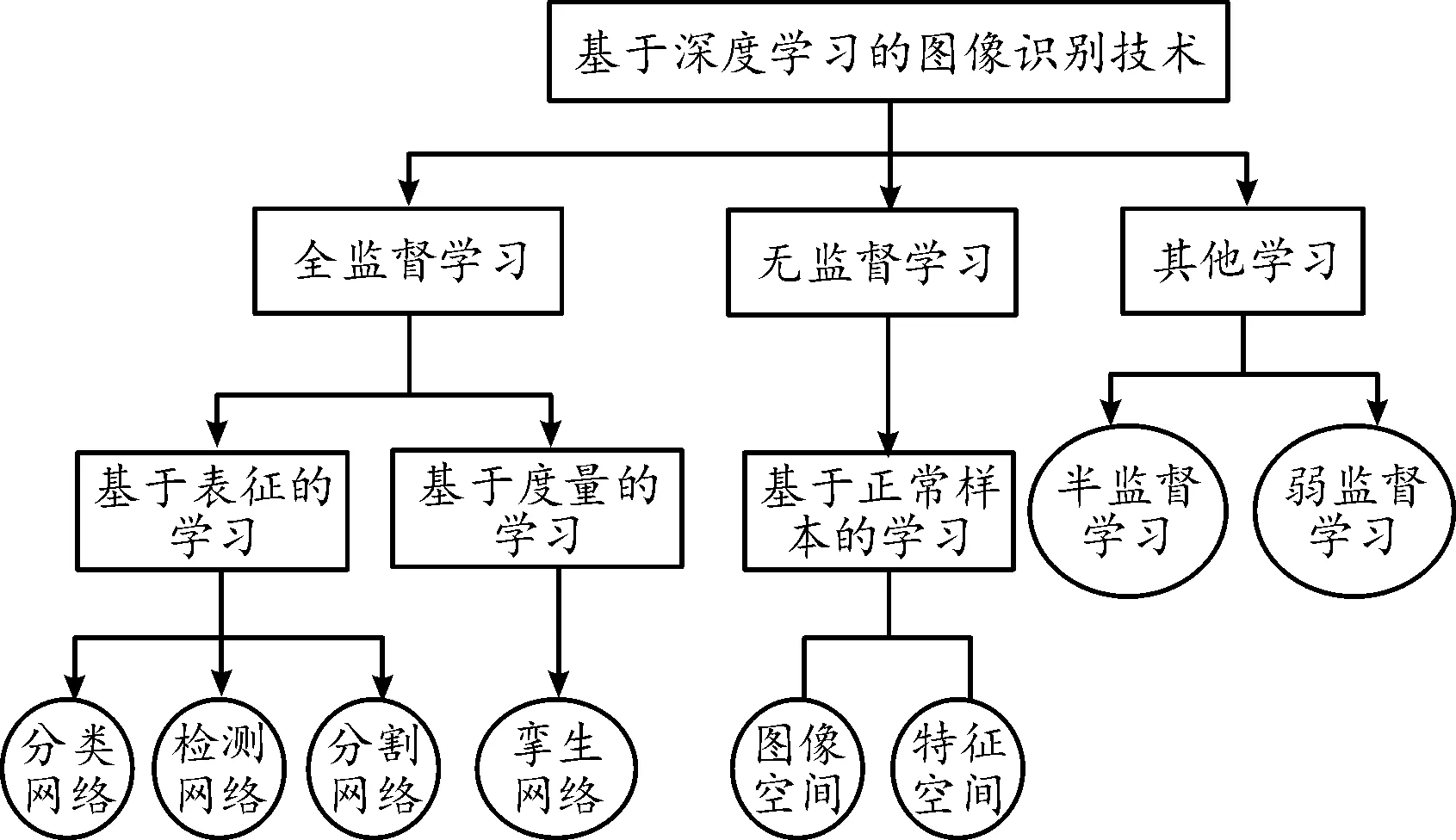

基于深度学习的图像识别技术按照数据标签的不同可以分为全监督学习、无监督学习和其他学习(半监督学习和弱监督学习),其分类如图2所示。

图2 基于深度学习的图像识别技术分类框图Fig.2 Classification block diagram of image recognition technology based on deep learning

2.3.1基于表征的全监督学习

将带有标签的图像输入至模型中,模型通过学习训练,其会具备图像分类、目标检测及目标分割的能力,从而完成对缺陷图像的识别。根据识别任务不同,基于表征的全监督学习可分为分类网络、检测网络、分割网络。

1) 分类网络

在真实的装备环境效应检测与评价场景中,不同检测对象的形状、尺寸、表面纹理、颜色、光线角度和光照强度等因素的巨大差异使装备环境表观损伤分类与评价成为一项非常困难的任务。依靠CNN强大的特征提取能力,可以有效地解决这一难题。运用广泛模型有AlexNet[6],VGG[7],GoogleNet[8],ResNet[9],MobileNet[10]等。根据分类网络实现任务的不同,可以将其细分为3个小类:利用网络直接分类、利用网络定位损伤、利用网络提取特征。

2014年,奥地利科技研究所采集了光度立体图像来训练CNN网络实现了轨道表面空洞损伤分类,在钢轨表面数据集上的错误识别率仅为1.108%[11]。釜山大学Park等构建了一种CNN分类网络,用于自动检测表面零件上的划痕、毛刺、磨损等。该网络在试验损伤数据集上的平均检测正确率为98%[12]。纽伦堡大学采用改进的VGG19网络用于识别太阳能面板损伤,识别率达到了88.42%[13]。威斯康辛大学Li等人首先利用基于LBP(Local Binary Pattern)的目标检测器定位材料的扫描隧道显微镜图像的待检测区域,然后再利用CNN模型对待检测区域识别,以获取表观损伤具体类型[14]。在面对多分类问题时,先采用一个基础网络进行损伤与正常样本二分类,然后在相同网络上共享特征提取部分,修改或增加损伤类别。日本山羊小野田大学Fusaomi等提出了一种具有两个分类分支的网络[15],第一个分类分支采用SVM分类正常样本和非正常样本,第二个分类分支用来细分非正常样本中的7种损伤类别。

利用滑动窗口是最简单且直观的定位损伤的方法。曼尼托巴大学Cha等[16]利用基于滑动窗口的CNN分类网络实现了裂纹表面损伤定位。三菱电气研究室Feng[17]、美国普渡大学Chen[18]、韩国延世大学Park[19]都采用了相同的方法进行了城市建筑物表观损伤、金属表面裂纹、路面裂纹的损伤定位。热力图也能通过颜色深浅来反映损伤区域的位置。新加坡国立大学Ren等人在2017年利用图像分块和特征迁移的方法获取了每个分块属于损伤的置信度即概率,并将所得到的结果转换成了热力图[20]。

如果给分类网络额外添加一个分割图像分支,构成多任务学习网络,就能完成分类和分割2种任务。斯洛文尼亚卢布尔雅那大学Racki等人设计了一个拥有分类和分割功能的多任务CNN结构的模型来识别表观损伤,其在DAGM2007数据集上取得了非常好的效果[21]。

许多研究者利用CNN提取特征,然后将获取到的特征输入到各种分类器中进行分类。新加坡科技设计大学Malekzadeh等[22]利用VGG的fc6层的输出作为特征输入到SVM中,实现了飞机蒙皮损伤的分类,其精度达到了96%。

2) 检测网络

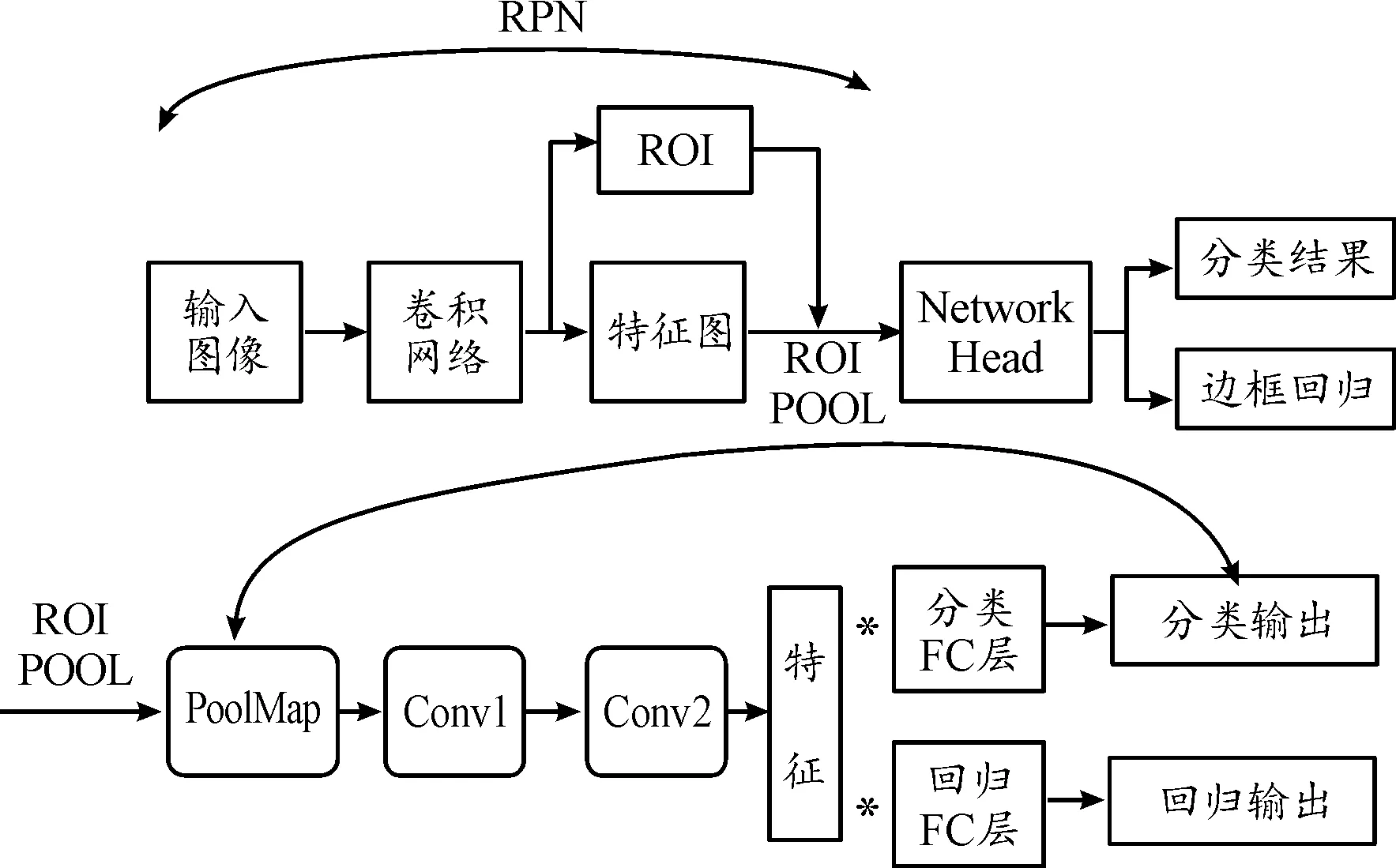

目标检测是为了获取精确的位置和类别信息,其可以分为two stage网络和one stage网络。图3是Faster R-CNN示意图。两者区别是前者需要预先框选出可能包含损伤的区域,再进行目标检测;后者直接利用提取的特征来预测损伤的位置和类别。

图3 Faster R-CNN示意图Fig.3 Schematic diagram of Faster R-CNN

two stage 损伤检测网络首先通过backbone网络识别输入图像的特征图,进一步使用RPN计算锚框置信度,得到候选框,将候选框区域的特征图进行池化后输入网络,最终得到损伤的定位和损伤类别的结果。加拿大曼尼拖巴大学Cha等人早在2017年就将Faster R-CNN应用到了桥梁表观损伤的定位,模型的准确值达到了87.8%[23]。

one stage损伤检测网络大致可分为SSD和YOLO两种,两者都是将图像直接作为网络的输入,最后在输出层回归边界框的位置即损伤区域的位置。SSD网络还引入了特征金字塔模型,其可从不同尺度的特征图中来预测目标的位置和类别。

3) 分割网络

分割网络将表观损伤检测识别任务转化为正常区域与损伤区域的语义分割,其不但能精确划分出损伤的区域,还能获取损伤的类别及长度、宽度、中心、面积等几何属性。分割网络大致可以分为FCN和Mask R-CNN。

FCN首先利用卷积过程提取特征和编码,然后再通过反卷积或者上采样将图像尺寸还原。东京城市大学Dung等人利用基于VGG16编码器的FCN对混凝土表面裂缝进行了分割,其平均像素准确率达到了90%[24]。U-Net继承并改进原始FCN的思想,使用跳跃层将编解码的特征图融合,进一步完善了分割区域的细节。美国太平洋西北实验室Roberts等人在解码器的上采样操作过程中使用了相应编码器的最大池化步骤中计算的池化索引,在分割中保持了高频细节的完整性[25]。

Mask R-CNN结合了检测网络与分割网络特点,是一种多任务学习模型。当多个同类型损伤有交错重叠时,实例分割能将每个损伤进行分离并进一步统计这种损伤类型的数目。相较于语义分割往往将多个同类别的损伤当作一个整体处理,实例分割能够精确地分离出多个同类别的损伤,这对于精细化分割任务十分重要。工业制造损伤[26]、螺栓紧固件[27]、皮革表面损伤[28]、路面损伤[29]等都应用了实例分割网络。相较于分类网络和检测网络,分割算法在一些特定的损伤识别场景更具有优势,但其与检测网络具有相同的弊端——需要大量的数据支撑,且数据的标注必须是逐像素的,所以往往会花费大量的精力和成本。

2.3.2基于度量的全监督学习

基于度量的全监督学习指的是学习输入图像的相似性度量,其模型通常是孪生网络。相较于基于表征的全监督学习,基于度量的全监督学习的输入是两张及以上的图像,通过比较多张输入图像的相似度来判断其是否属于同一类。韩国浦项科技大学Kim等人设计了一个基于CNN的孪生网络并对钢表观损伤图像进行了分类,他们首先将两张成对的图像输入到权值共享的2个CNN中完成特征的提取,然后利用基于相似度函数的对比损失计算2个特征之间的差异程度[30]。

基于度量的全监督学习可以理解为样本在特征空间进行聚类,而基于表征的学习可以理解为获取样本在特征空间的分界面。现目前,大部分孪生网络还是用来完成损伤分类的任务。

2.3.3无监督学习

表观损伤检测的无监督学习模型通常是基于正常样本学习的,其只需要正常图像进行学习训练即可。因为网络只接受正样本进行训练,其具备强大的正样本重建和判别能力,当输入负样本时,就能产生与正常样本不同的结果。相较于有监督学习,其能够识别检测出预先没有设定的损伤类别,冗余性能较好。

基于图像空间的无监督学习重要思想之一是样本重建和补全。用输入的原始图像与重建图像相减得到残差图像即重建误差,当重建误差大于一定阈值时,就能判定输入原始图像存在损伤,差异很大的区域即损伤区域。泰国农业大学Youkachen等人使用CAE进行图像重建,通过锐化处理重建误差最终获取了热轧钢表观损伤分割结果[31]。莱奥本高分子研究中心Haselmann等人利用FCN,通过正样本补全和重建图像与原始图像的误差实现了装饰性塑料零件表观损伤识别[32]。除了样本重建与补全的方法,另一种思想是训练生成类似于正样本的伪图像即训练生成对抗网络GAN,并将其判别器当作分类器,用于分类损伤和正样本。

通过正样本与负样本特征分布之间的差异即异常分数也可以进行损伤检测。当异常分数高于某个阈值时即可认为出现损伤。2017年,维也纳医科大学Schlegl等人就提出了AnoGAN,完成了从图像空间到潜在空间的映射,图像空间中差异和其网络判别器最后一层特征图之间的差异构成异常分数[33]。到了2019年,Schlegl等人将AnoGAN网络进行了升级改进形成了f-AnoGAN,其异常分数由编码器模块实现的图像样本重建损失和GAN判别器最后一层特征图之间的差异构成[34]。

3 图像识别技术应用现状

3.1 国内外表观损伤检测常用数据集

数据是深度学习的基础,没有海量的数据作为支撑,损伤图像的识别检测任务就完成不了。相较于计算机视觉任务中的COCO、ImageNet、PASCALVOC2007/2012等数据集,表观损伤的数据集相对分散且数据量较少,根据检测对象及检测方法的不同,往往会使用不同的数据集。

东北大学创建了基于分类网络的应用于钢材表面损伤的数据集NEU-CLS[35]以及基于检测网络的应用于钢材表面损伤的数据集NEU-DET[35]。上海交通大学建立了基于孪生网络的PCB板的数据集PCB Dataset[36]。中国科学院大学、北京交通大学、香港理工大学都基于分割网络分别建立了磁瓦表面数据集Magnetic-tiledefect-datasets[37]、钢轨表面数据集RSDDs dataset[38]、地面裂纹数据集Crack Dataset[39]。相较于国内损伤检测数据集,国外损伤检测数据集应用场景更加丰富,具有太阳能板、金属表面、扫描隧道显微镜、木材表面、铸件X射线图像等多种材质损伤的公开数据集。

纽伦堡大学利用分类网络建立了太阳能板损伤数据集elpv-dataset[40]、卢布尔雅那大学、芬兰奥卢大学也同样利用分类网络建立了金属表面数据集KoletorSDD[41]、木材表面wood defect database[42]。斯坦福大学利用检测网络建立了铸件X射线损伤图像数据集GDXray Casting[43]。麦威德软件有限公司、米兰理工大学利用了无监督学习网络分别建立了多种材质损伤数据集MVTec AD[44]、扫描隧道显微镜损伤图像数据集NanoTWICE[45]。博世中央研究院用弱监督学习网络建立了损伤数据集DAGM2007[46]。国内外表观损伤检测常用数据集名称如表1所示。

表1 国内外表观损伤检测常用数据集名称

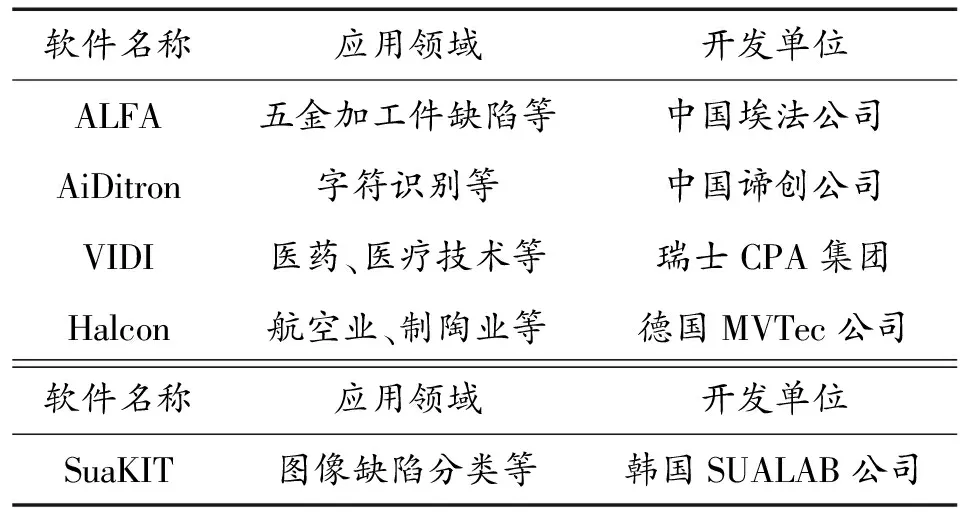

3.2 国内外表观损伤检测软件

埃法智能科技有限公司开发的ALFA深度学习外观损伤检测软件,可以实现五金加工件缺陷检测、移印检测、太阳能电池板表观损伤检测、焊缝检测等。由谛创科技有限公司开发的AiDitron软件,能够实现字符识别、缺陷检测、图片分类等功能。国外也有许多成熟的商用深度学习损伤检测软件。CPA集团开发的VIDI软件,是世界上首个提供基于深度学习的图像分析方法的软件,目前已成功应用于医药、医疗技术、汽车、纺织、印刷、物流和制表行业。由德国MVTec公司开发的Halcon软件已成功应用于航空业、汽车制造业、制陶业、电子元件制备业等应用场景,能够实现图像分类及缺陷检测等功能。2017年,由SUALAB开发的SuaKIT深度学习损伤检测软件能够对图像的缺陷实现分类、目标识别、目标分割等功能。国内外表观损伤检测软件名称如表2所示。

表2 国内外表观损伤检测软件名称

4 图像识别技术应用展望

4.1 加强基于数字图像的环境效应评价方法

目前,不管是国内还是国外,均无基于图像的环境效应定量评价方法,但多个标准中均含有部分表观损伤评级方法,例如GB/T 18590《金属和合金的腐蚀 点蚀评定方法》、GB/T 6461《金属基体上金属和其他无机覆盖层经腐蚀试验后的试样和试件的评级》、GB/T 1766《色漆和清漆 涂层老化的评级方法》、GB/T 22639《铝合金加工产品的

剥落腐蚀试验方法》等。GB/T 18590《金属和合金的腐蚀 点蚀评定方法》中介绍了蚀坑的识别与检查、以及点蚀的评定方法,根据标准图表法可初步确定点蚀的密度和大小,根据力学性能损伤可确定点蚀对材料性能的影响程度;GB/T 22639《铝合金加工产品的剥落腐蚀试验方法》中介绍了剥落腐蚀敏感性的实验室试验方法和基于目视检测评定的腐蚀等级和腐蚀程度;GB/T 6461《金属基体上金属和其他无机覆盖层经腐蚀试验后的试样和试件的评级》,该标准把覆盖层的保护等级与损伤面积、覆盖层破坏类型建立了相关联系,保护等级仅能反映覆盖层对于金属基体的保护性,并不能反映金属腐蚀的严重程度。前述3个标准分别对3种类型的金属腐蚀给出了一定的评价,但并未把腐蚀类型、损伤面积、损伤程度三者结合起来进行综合等级评级。相对于金属腐蚀类损伤,防护涂层体系老化损伤的量化评定有相对完善的评级方法,GB/T 1766《色漆和清漆 涂层老化的评级方法》枚举了老化损伤的破坏类型,对破坏程度、数量、大小的评定均有一整套相对完善的方法。但该标准是基于人工检测的量化评级方法,有些损伤是基于人的触感,如粉化,很难直观反映到图像中。该方法应用到基于图像的定量评级中仍需要改进。

4.2 构建数据丰富且完整的环境效应数据集

国内,各行各业的人员通过较长的环境试验,已积累了丰富的环境效应数据,但是目前并没有人将其系统地收集归类,没有进行较为完整的整合,存在着数据多而不精、多而不全的尴尬局面,后续相关人员应该统筹先前的环境效应数据及将要采集的环境效应数据,形成一个数据丰富且完整的环境效应数据集,这对图像识别技术在装备环境效应检测与评价中的发展十分重要。

4.3 研发更加高效的环境效应识别算法

基于深度学习的环境效应识别算法已大量应用,但还存在着许多不足:有监督的学习方法需要大量人工标注,耗费人力及物力;深度学习算法训练过程时间长;现阶段深度学习算法分类的类别还比较少,不能满足实际需求。针对上述问题与不足,环境效应识别算法可以朝这几个方面进行更新升级:通过利用多种图像检测、分割算法自动完成对目标图像的标注;深入研究无监督学习算法在装备效应检测与评价中的应用研究,以达到减少人工标注图像工作的目的;研发出既能准确找出图像缺陷特征又相对层数较少的学习算法;将多种环境效应复合的损伤图像加以标注分类,使算法能够识别更多类型的环境效应损伤图像。

4.4 图像采集与识别平台向小型化、实时化、智能化发展

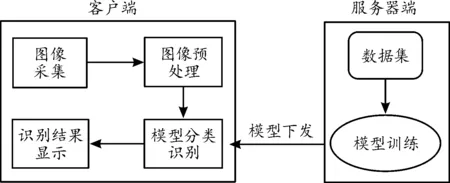

由于深度学习在模型训练阶段需要大量的计算,其对硬件的要求是很高的,所以现阶段大多采用桌面式模型训练工作站,并配备高端的CPU和GPU才能缩短训练的时间。但另一方面,在实际的图像采集和识别场景中,往往需要在室外例如暴露场进行原位采集,这就要求采集与识别平台的小型化、实时化,解决这一问题大致有2种方案:(a).在线式(b).离线式。在线式图像采集与识别平台主要工作流程框图如图4。使用者通过客户端进行图像采集,并通过互联网上传到服务器端,服务器端先对图像进行预处理后输入模型进行分类识别,最后将识别结果通过互联网下发至客户端,完成整个识别流程。这种方案的好处是客户端的硬件要求很低,只需要一个照相功能就行了,全部的计算过程都是在服务器端完成的。同样会带来一个缺点:数据容易泄露,通过互联网进行数据的上传和下发有可能会泄露敏感信息。而离线式图像采集与识别平台不与互联网相连,实现物理隔离,其工作流程图如图5。首先在服务器端将需要的模型训练好,再通过物理连接的方式将模型下发至客户端,服务器端和客户端都不与互联网相连。在图像识别阶段,客户端即为一个单独的整体,能够独立的完成识别任务。当模型需要优化更新时,再通过物理连接获得新的模型。这种方案,使得敏感信息与外界隔离,从而最大程度上保证了信息的安全。

图4 在线式图像采集与识别平台主要工作流程框图Fig.4 Main workflow block diagram of online image capture and recognition platform

图5 离线式图像采集与识别平台主要工作流程框图Fig.5 Main workflow block diagram of off-line image capture and recognition platform

在图像采集与识别平台向小型化、实时化发展的同时,智能化也是其发展的重点之一。所谓智能化是指利用机器人等智能的工具去代替人为的现场原位采集与识别的工作,减轻科研人员在暴露场等恶劣环境下长期工作的负担,并且实现规律性、规模性的图像采集与识别。

5 结论

通过对基于深度学习的图像识别技术分类,了解了不同深度学习网络的适用范围。国内的图像识别技术研究应该逐步建立丰富、完整的表观损伤数据库,为发展表观损伤检测R的软件打下基础。对于图像识别技术在装备环境效应检测与评价领域的发展应着重关注:① 加强基于数字图像的环境效应评价方法的研究;② 构建数据丰富且完整的环境效应数据集;③ 研发更加高效的环境效应识别算法;④ 图像采集与识别平台向小型化、实时化、智能化发展。