基于深度学习的像素级全色图像锐化研究综述

杨勇, 苏昭, 黄淑英, 万伟国, 涂伟, 卢航远

1. 江西财经大学 信息管理学院, 南昌 330032;

2. 天津工业大学 软件学院, 天津 300387;

3. 江西财经大学 软件与物联网工程学院, 南昌 330032

1 引 言

由于受遥感卫星传感器设计、遥感成像机理等因素的影响,单源遥感图像在空间、光谱分辨率等方面相互制约,一般遥感卫星只能获得单幅低空间分辨率的MS(Multispectral)图像或高空间分辨率的PAN (Panchromatic) 图像(Vivone 等,2015;Li 等,2020a);然而,在实际遥感应用中,如地物分类(Aguilar 等,2013; Gianinetto 等,2017)、目标识别(Chen 等,2019;Mohammadzadeh 等,2006)和地表变化检测(Chen 等,2018;Souza等,2003)等任务往往需要高空间分辨率多光谱HRMS(High Spatial Resolution Multispectral)的图像。全色图像锐化又称Pansharpening 是将PAN 图像的高分辨率空间细节信息与MS 图像的丰富光谱信息进行融合,得到高质量、理想的HRMS 图像(陈毛毛 等,2021)。因此,如何有效提取MS图像和PAN 图像的相关信息,并通过融合得到HRMS图像,一直都是遥感图像处理领域亟待解决的重要问题(Yang 等,2018b)。

遥感图像融合起源于20 世纪70 年代,按照不同的处理级别,可以划分为3 个层次:像素级融合、特征级融合和决策级融合。其中,像素级融合是直接在原始遥感图像各像素上的直接融合处理,其目的是为了获得质量更高的融合图像,如提升观测图像的分辨率、增强原始图像的清晰度等。像素级融合在3个层次的融合中应用范围最为广阔、研究成果最为丰富,也是目前研究的热点之一 (李树涛 等,2021;Zhou 等,2022)。因此,本文将立足于像素级层次的全色图像锐化展开综述。

像素级全色图像锐化方法通常分为3 类(Yang 等,2018a):(1)成 分 替 换CS(Component Substitution)法(Yang 等,2018c;Liu 等,2018a;Shahdoosti 和Javaheri,2017;Li 等,2018)。CS 方法先将MS 图像转换到一个新的空间,然后在新的映射空间用PAN 图像对转换后的MS图像空间信息成份进行替换(Alparone 等,2015),其不足在于光谱失真较为明显;(2) 多分辨率分析MRA(Multi-Resolution Analysis)法(Khan 等,2008;Lu等,2017;Xing 等,2018b)。MRA 方法首先利用多尺度变换方法,如小波变换或者金字塔变换等,将源图像分解获得高、低频成份,再运用适当的融合规则对不同尺度的高、低频成份进行融合,最后将融合后的高、低频成份反变换获得融合图像(陈毛毛 等,2021),其不足在于空间细节失真较为严重;(3)基于模型MB(Model-Based)的方法(Kang 等,2014;Palsson 等,2015)。MB 方法根据理想的融合图像与PAN 图像、MS 图像之间的关系建立能量函数,并通过最优化求解获得HRMS融合图像,但其计算较为复杂(Lee 等,2021)。此外,也有不少学者(Yang 等,2018c;He 等,2019)将CS、MRA 两种方法进行结合来构建注入模型融合框架。

近年来,由于深度神经网络具有能够自动发现数据特征表示的能力,它促进了自然语言处理、计算机视觉等研究取得巨大进展(Bowman 等,2015;He 等,2016;Huang 等,2017)。因此,近6 年来(2015 年以来),许多研究者对基于深度学习的像素级全色图像锐化进行了深入的研究,并取得了丰硕的研究成果(Yang 等,2017;王芬等,2021;Lee 等,2021;Zhou 等,2022);同时,已有几位学者对深度学习在全色图像锐化领域中的研究进行了部分的总结和评述(Liu 等,2018c;Ma 等,2019;Tsagkatakis 等,2019;Javan 等,2021)。Liu 等(2018c)综述了基于深度学习的各种像素级图像融合的研究进展,包括多聚焦、医学及遥感图像融合等,文中对7个代表性的基于深度学习的全色图像锐化模型进行了较为详尽的评述,但对方法缺乏定量化的比较及分析;Ma 等(2019)从元分析(Meta-analysis)的角度对深度学习在全色图像锐化等多个应用领域进行了综述,但对全色图像锐化方法也缺少具体的算法性能分析;Tsagkatakis 等(2019)从自编码器AE(Autoencoders)和卷积神经网络CNN(Convolutional Neural Networks)两个方面对基于深度学习的全色图像锐化算法进行了阐述,但论文未涉及到深度学习与传统方法相结合的融合模型;Javan 等(2021)主要从CS、MRA、Hybrid 和VO(Variational Optimization)等4类方法对传统全色图像锐化算法进行详尽阐述,然而对基于深度学习的全色图像锐化算法仅做了简要介绍,缺乏对算法的定量化比较及分析。总体而言,以上文献(Liu 等,2018c;Ma 等,2019;Tsagkatakis 等,2019;Javan 等,2021)只是部分地或从某一角度对基于深度学习的像素级全色图像锐化研究成果进行阐述,在系统性和定量化分析方面存在一定的不足。为此,本文将对基于深度学习的全色图像锐化研究成果进行全面和系统的归纳与总结,建立一个较完整的领域研究视图、给出该领域的发展脉络,并提出未来5 个重要的研究方向。本文的创新工作包括:(1)提出从经典方式和协同方式两个方面对基于深度学习的像素级全色图像锐化研究成果进行综述;(2)对一些代表性的融合算法运用有参考和无参考图像质量评价指标进行了性能提升比的对比、分析和归纳,并以此给出其发展脉络;(3)结合深度学习和全色图像锐化的发展态势,给出基于深度学习的像素级全色图像锐化的5个主要研究方向。

本文给出了遥感卫星图像常用数据集,并对全色图像锐化质量评价进行介绍,以经典方式与协同方式两个方面分门别类地介绍了基于深度学习的全色图像锐化方法,同时对代表性的算法进行对比、分析和归纳,最后对全色图像锐化的3个常见应用领域进行分析以及对该领域的发展前景进行展望。

2 遥感卫星图像数据集

全色图像锐化所采用的数据为PAN 图像和MS图像,数据集多由遥感光学卫星商业公司提供。常用的遥感图像数据集主要来自国外Digital Globe卫星公司的WorldView 系列、IKONOS、QuickBird和GEOEYE 等卫星数据集。WorldView 系列中的WorldView-2 卫 星(https://gbdxdocs.digitalglobe.com/docs/worldview-2[2021-06-18])2009 年发射,能够提供0.46 m 全色和1.85 m 多光谱影像,其星载多光谱传感器不仅有4 个标准波段(红、蓝、绿和近红外),还含有4 个额外波段(黄、红边、海岸和近红外2);Pléiades 卫星(https://www.geoimage.com.au/satellite/Pleiades[2021-06-18])发射于2011 年,能够提供0.5 m 全色和2.0 m 多光谱影像,多光谱传感器有4个标准波段。其他卫星数据集还有Landsat 等。部分卫星图像参数见表1(Yang 等,2020b);https://gbdxdocs.digitalglobe.com/docs/worldview-3[2021-06-18];https://gbdxdocs.digitalglobe.com/docs/quickbird[2021-06-18];https://gbdxdocs.digitalglobe.com/docs/ikonos[2021-06-18])。

表1 常用国外卫星基本参数Table 1 Basic parameters of common foreign satellites

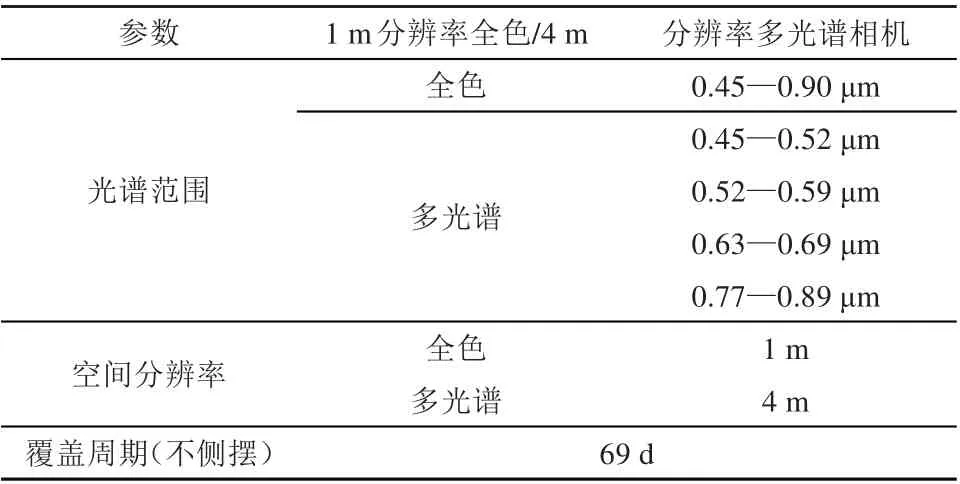

国内遥感图像数据集多来自高分卫星家族,如“GF-1”与“GF-2”,但“GF-2”的PAN 图像和MS 图像分辨率比“GF-1”都提高1 倍,分别达到了1 m 和4 m 的空间分辨率,其技术参数如表2(http://www.kosmos-imagemall.com/[2021-06-18])所示。GF-1 技术参数在光谱范围与GF-2一致,全色图像分辨率是2 m,多光谱图像分辨率为8 m。高分卫星家族在环保、农业等领域都发挥了重大的经济价值与社会价值。

表2 GF-2卫星基本参数Table 2 Basic parameters of GF-2 satellite

3 全色图像锐化质量评价

全色图像锐化质量评价,通常包括主观评价和客观评价两部分。主观评价是从视觉的角度判断融合图像的清晰度与原始MS 图像之间的光谱相似度(Alparone 等,2015);客观评价是一种对融合图像进行定量化的评价方法,该方法通常分为两类,即有参考和无参考质量评价(Alparone 等,2015)。下面就常用的客观评价指标给出其定义和说明。

3.1 有参考质量评价指标

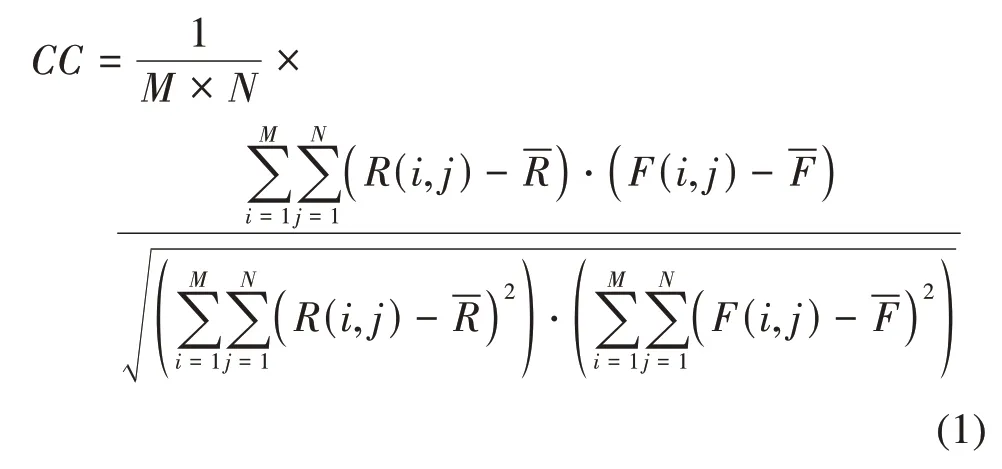

(1) 相 关 系 数CC (Correlation Coefficient)(Alparone 等,2015)。计算公式如下:

式中,M×N为图像的大小,R为参考图像,F为融合图像。R(i,j)是R中位置坐标(i,j)的像素值,-R为R的平均像素值;F(i,j)是F中位置坐标(i,j)的像素值,-F为F的平均像素值。CC用于对融合图像在空间上的扭曲度进行定量评价。CC的值域区间是[0,1],CC越趋近于理想值1,表明融合图像的质量越趋近于参考图像。

(2)光谱角映射SAM(Spectral Angle Mapper)(Alparone 等,2007)。计算公式如下:

式中,uR、uF分别为标准图像和融合图像的谱向量。SAM 用于定量评价标准图像与融合图像光谱信息的相似度。SAM 的值越趋近于理想值0,融合图像与参考图像的光谱信息相似度越高,表明融合图像的光谱失真越小。

(3)全局相对光谱损失ERGAS(Erreur Relative Global Adimensionnelle de Synthèse)(Wald,2000)。计算公式如下:

式中,h表示PAN 图像的空间分辨率,l表示MS图像的空间分辨率,-Fk为各个通道的总体像素平均值。ERGAS 用来对融合图像的光谱与空间质量进行定量评估,ERGAS的值越趋近于最优值0,表明融合图像与参考图像的相似度越高。

(4)全局融合指标(Q4)(李红 等,2016)。对图像进行分块(D×D),每块计算Q4。

式中,X(i,j)为参考图像,F(i,j)为融合图像,Q4反映了参考图像与融合图像在空间和光谱间的整体相似度,融合结果越好,Q4的值越接近于1。

3.2 无参考质量评价指标

QNR(杨勇 等,2020)是遥感图像融合领域常用的无参考图像质量定量评价指标,它是基于UIQI的质量评价指标,用来表征对比图像与融合图像间的亮度、对比度以及局部相关性。令Q(•)是计算UIQI的函数,则QNR可用如下公式定义。

式中,PN为PAN 图像,PNL为低空间分辨率的PN,q代表范数。Ds的值越小,代表空间失真度低(杨勇 等,2020),即图像融合算法的实际效果越理想。

式中,p是一个正整数,用来表征光谱差,t和d为通道的数量。Mt为MS 图像的第t个通道,Ft为融合图像的第t个通道。Dλ的值越小,即融合算法的效果越好(杨勇 等,2020)。

Ds和Dλ的最优值均为0,Ds和Dλ值越小,则QNR值越大,融合图像的质量越高,QNR的理想值为1。

4 基于深度学习的全色图像锐化

深度学习DL(Deep Learning)的概念由Hinton和Salakhutdinov(2006)以及Hinton 等(2006)提出,属于机器学习的范畴,其目标是构建模拟人类大脑自动分析并能够理解数据的神经网络,并于2018年获得图灵奖。

本节与像素级全色图像锐化相关的5种重要的DL 模型,分别是AE、CNN、深度残差网络DRN(Deep Residual Network)、生成对抗网络GAN(Generative Adversarial Nets)和循环神经网络RNN(Recurrent Neural Network)。

深度学习因提取特征能力强,识别精度高等优点被广泛应用在计算机视觉领域,许多研究人员将深度学习应用到像素级全色图像锐化中,在最近6年中取得了巨大的进步。通过对现有诸多文献的分析挖掘,本文给出了基于深度学习的全色图像锐化方法的发展历程及其分类,如图1 所示。下面将根据深度学习模型与传统融合算法,从经典方式与协同方式两个方面来分门别类地综述这些研究成果。

图1 基于深度学习的像素级全色图像锐化发展历程及分类Fig. 1 Deep learning based pixel-level pansharpening development and classification

4.1 经典方式

经典方式主要是直接把深度学习的一种模型单独应用于全色图像锐化。当前,常见的是基于AE、CNN、DRN 和GAN 等4 种深度学习模型的全色图像锐化方法的研究。

4.1.1 基于AE的全色图像锐化

AE 是由输入层、隐含层(编码层)和输出层构成的3层深度神经网络,其中,输入层X 和输出层Z 具有同样大小。输入层X 到隐含层Y 是一个编码过程;隐含层Y 到输出层Z 是一个解码过程。AE通过BP反向传播算法训练,不断调整编码器和解码器的参数(权重),重构损失最小化,使输入层X 等于输出层Z,最后得到编码层Y 的结果(低维向量的形式)即是对输入层X的特征表达。

Huang 等(2015) 首次把DNN (Deep Neural Network)应用于遥感图像融合,假定 HR/LR PAN图像之间的映射关系与HR/LR MS 图像的映射关系是一致的,提出了一个主体包含MSDA(Modified Sparse Denoising Autoencoder)的深度神经网络融合模型。MSDA 能够学习获得LR PAN 图像与HR PAN图像之间的映射关系,然后把训练后的MSDA通过叠加构造一个DNN,最后通过DNN 完成从LR MS 图像到HR MS 图像的重构,从而达到融合目的。

为训练网络中的参数,Huang等(2015)定义了以下损失函数:

Huang等(2015)提出的方法与数个传统融合算法进行了比较,在QuickBird 和IKONOS 两个卫星数据集上,前者能得到更优的主客观融合图像,验证了基于DL的全色图像锐化的有效性。

Cai 等(2018)提出了一个CSDA(Coupled Sparse Denoising Autoencorder)的融合框架。CSDA由4个子网络组成,分别是LM-HP 网络、HR-MS 网络、特征映射网络FMN(Feature Mapping Network)和微调网络(Fine-Tuning Network)。其中LM-HP 网络和HR-MS 网络是SAE(Sparse AutoEncoder)网络,分别用来学习MS、PAN 图像和HRMS 图像的特征表达信息;特征映射网络SDAE (Sparse Denoising Autoencoder)用来对由SAE 提取的两个特征建立映射关系;微调网络通过BP 算法对CSDA的参数进行调整。

LM-HP网络的损失函数定义如下:

优化网络的损失函数定义如下:

式(10)—(13)中,LRi表示LM-HP 图像向量,Pani表示HR-MS 图像向量真实值,HRi表示CSDA网络的输出,KL(ρ||ρ)表示稀疏正则项。

该融合方法工作过程是:首先,对上采样的MS 图像和PAN 图像向量化,然后,利用LM-HP网络、HR-MS 网络分别提取MS、PAN 图像的特征,接着,利用SDAE 网络建立MS、PAN 图像特征的映射关系,得到HRMS 图像特征,最后,重构获得HRMS融合图像。

作为早期的基于深度学习的像素级遥感图像融合模型,虽然较传统融合算法在效果上有较大提升,但由于AE 结构的限制、不能直接处理图像以及较少考虑到遥感图像融合领域的先验知识等,相较其他基于深度学习的遥感图像融合模型存在一些不足。另外,该类方法提升融合效果往往使得网络模型结构、损失函数等较为繁杂,不具简明性。

4.1.2 基于CNN的全色图像锐化

CNN 是一种多层感知机,主要用来处理二维图像数据(张洪群 等,2017)。相比传统的多层感知机,CNN 的特点在于:网络的输入直接采用原始信号,从而使得传统识别算法中复杂的特征提取得以避免;卷积阶段通过权值共享结构减少了网络参数量,使得网络的训练效率显著提高;池化阶段通过对特征图下采样操作,在主要特征信息得以保存的同时,使得特征空间的大小明显减小。

受Dong 等(2016)的启发,Masi 等(2016 和2017)把SRCNN(Super-Resolution CNN)中的CNN应用到遥感图像融合领域,提出了首个基于CNN的全色图像锐化模型PNN(CNN-based Pansharpening),其架构如图2 所示。PNN 模型以PAN 和上采样后的MS 图像为输入,然后经过3 层CNN,最后得到HRMS 融合图像。PNN 模型在WorldView-2、IKONOS 和GeoEye-1这3个卫星数据集上与十几个传统融合算法做了大量的对比实验,验证了PNN模型应用于遥感图像融合的有效性。

图2 PNN模型结构Fig.2 The network structure of PNN

He 等(2018)通过实验发现:当训练网络的图像太小时,网络对图像边缘、纹理等细节信息的学习能力会变弱,导致融合图像空间细节信息失真;当训练网络的图像太大时,容易导致网络陷入过拟合。基于此,He 等(2018)设计了一个三通道的CNN 框架,其中每个通道对应不同分辨率大小的训练MS图像和PAN 图像,最后经过统一池化操作得到融合图像;Ye 等(2018)设计了一个多尺度的CNN 模型,以上采样的MS图像和增强PAN 图像作为训练后融合网络的输入,最后得到融合图像,其中增强PAN 图像由低频的MS图像注入到经NSLP(Non-Subsampled Laplacian Pyramid)变换的PAN 图像而得到;李红等(2016)在CNN的基础上,提出了一个DSVL Nets(Deep Support Value Learning Networks)的融合框架,DSVL Nets在传统CNN 的基础上,移除特征层的下采样操作,提升了图像融合的效果。

Masi 等(2016)提出的PNN 模型具有开创性的意义,后续许多学者沿着此路径开展研究,无论是从网络类别、网络宽度、网络深度、目标函数等方面都受PNN 模型的影响。然而,由于PNN模型网络深度较浅,只是3层的CNN,其信息表征(特征提取)能力受到制约。同时,该网络模型是将PAN图像和上采样的MS图像直接作为PNN模型的输入,没有充分考虑到遥感图像融合领域的特殊性,导致部分空间、光谱信息的丢失。后续的研究(He 等,2018)在CNN 的网络宽度上均有增加,实验结果表明,在主观视觉和客观指标上均达到比PNN模型更高质量的融合效果。

4.1.3 基于DRN的全色图像锐化

在深度学习中,图像特征随着网络深度的加深而变得更为抽象,增加网络深度可以有效地提取更多高层的特征(Zeiler和Fergus,2014)。但是随着网络模型深度的逐步增加,参数更新过程中可能会出现“梯度消失”,使得网络模型难以优化(He 和Sun,2015)。为 了 解 决 该 问 题,He 等(2016)创新性地把“Shortcut Connections”概念(Ripley,1996)引入到CNN 中,设计了深度残差网络模型ResNet,也即DRN。

通过对PNN 等模型不足之处的分析以及结合遥感图像融合领域的先验知识,Yang 等(2017)以遥感图像融合的两大主要目标:光谱信息、空间信息的理想保留,创新性地提出了一个主体包含ResNet 结 构 的PanNet (Deep Network for Pan-Sharpening)模型,其结构框架如图3 所示。该模型为显著地保留MS图像和PAN 图像中的光谱和空间信息,引入了两个损失函数。其中,针对空间信息保持,其定义如下损失函数:

图3 PanNet模型结构Fig.3 The network structure of PanNet

式中,fW代表图5 中的ResNet,G表示高通滤波操作,↑是上采样操作,P、M、X分别表示PAN 图像、MS图像和HRMS融合图像。

PanNet 的另一显著特点在于,在输入到训练网络前,对MS 图像和PAN 图像进行高通滤波操作,使得PanNet 模型的泛化性能得到提升,在WorldView-2 和WorldView-3 卫星数据集上表现出显著的融合效果。

Wei 和Yuan(2017)、Wei 等(2017)受Kim等(2016) 使用深度残差网络的启发,提出DRPNN (Deep Residual Pan-sharpening Neural Network)融合模型,取得了比PNN 模型以及数个经典融合算法更高质量的融合图像;受传统CS、MRA 方法以及ResNet 模型的启发,为学到HRMS图像与MS 图像之间的空间“残差”信息,Rao 等(2017)设计了一个具有残差学习功能的CNN 以完成高质量的图像融合;受Kim 等(2016)的启发,并假定LRPAN、HRPAN图像与MS、HRMS图像具有相同的映射关系,Li 等(2017)训练了一个DRN 模型,该模型通过训练获得LR PAN 图像与HR PAN 图像之间的映射函数,然后把该训练模型用于完成从 MS 图像到HRMS 图像的重构,从而达到融合的目的;Jiang 等(2019)设计了一个DRN框架,该模型能够将HRPAN 图像与MS 图像之间的差异信息映射到HRMS 图像与HRPAN 图像之间的差异信息,从而达到融合的目的。

Yang 等(2020a)做了进一步的研究,提出了PCDRN(Progressive Cascade Deep Residual Network)融合框架,其以串联的形式包含两个ResNet 子网络,分两次学习LR MS 图像和PAN 图像到HR MS图像的非线性的特征映射,使得融合图像可以保留PAN 图像中更丰富的空间信息。另外,为解决融合过程中过拟合的现象,Yang 等(2020a)还设计了一个新的多任务损失函数:

在遥感图像不同的区域上,光谱、空间分辨率存在差异,利用显著性分析对光谱、空间信息进行划分具有合理性。受此启发,Zhang 等(2019a)将注意力机制中的显著性分析原理与DRN 相结合,提出基于显著性引导的DRN 融合模型,同时,通过设计了一个新的损失函数,使得融合图像获得更丰富的细节信息,进一步提升了融合图像的质量;Yao等(2018)设计了一个主体结构是AE 的PUNet(U-Net for Pansharpening)融合框架,在IKONOS 与WorldView-2 两个卫星数据集上的实验表明,PUNet 获得了比GIHS(Tu 等,2001)、AWLP(Otazu 等,2005)等传统算法更好的融合效果。

Scarpa等(2018)从损失函数、网络深度、是否加入残差学习模块等3 个方面对遥感图像融合PNN 模型进行全面的实验分析、改进,提出了一个目标自适应的带有残差学习模块的3 层CNN 融合框架,在WorldView-2、WorldView-3、IKONOS和GeoEye-1这4个卫星数据集上得到高质量的融合图像;随后,Scarpa 等(2018)对该模型框架又开展了进一步的研究(Vitale 等,2018;Vitale,2019);Vinothini 和Bama(2019)使用RDN(Residual Dense Network)模型(Zhang 等,2018)设计了一个RDMPSnet(Residual Dense Model for Pan-Sharpening Network)的融合框架,在WorldView-2 和IKONOS-2 两个卫星数据集上的实验表明,RDMPSnet 获得了比PNN、PanNet 等模型更好的融合效果;Xiang 等(2019)设计了一个多尺度密集深度学习的融合框架,框架的特色在于包含一个多尺度的卷积层、一个密集深度学习模块(Dense Learning Block)和一个全局的特征连接结构。其中多尺度卷积层用来提取PAN 图像的多尺度特征;密集深度学习模块用来提高网络对图像的光谱、空间表达能力;全局的特征连接结构则保留了上采样后的MS 图像的光谱结构信息。

Guo 等(2019) 设计了一个主体包含DMB(Dilated Multilevel Block)的融合框架。Li和Cheng(2019)在Landsat 8 卫星数据集上设计了一个由特征提取、非线性映射关系构造、融合图像重构3部分构成的DRN 融合框架;以改进PNN 模型为出发点,提升对图像各尺度的信息表达能力,Li 等(2020b)设计了一个基于多尺度通道注意力机制的DRN 融合框架,该框架的一个核心模块是MSRBCA(Multi-scale Residual Block With Channel Attention),其主要作用是实现对源图像多尺度的特征提取。

基于DRN 的全色图像锐化方法充分利用其网络中的快捷/跳转连接(Shortcut Connections),使得用于学习图像特征的DRN 兼顾到较为浅层的图像特征的同时,网络更深,学习效率更高。在实验效果上,无论从光谱信息、空间细节的保留上均达到比传统CNN 模型更好的主客观融合效果;另外,Zhang 等(2019a)和Li 等(2020b)把注意力机制加入到DRN 模型,使得基于DRN 的全色图像锐化方法更为丰富和更具灵活性。

4.1.4 基于GAN的全色图像锐化

Goodfellow 等(2014) 提 出 生 成 对 抗 网 络GAN,其重要特征在于其包含两个网络模型:生成器G(Generator)和判别器D(Discriminator)。生成器G 尽可能使得生成的图像更为“真实”,导致判别器D难辨真伪;判别器D判定输入样例是来自数据集还是生成器G 生成的图像。两个网络模型相互对抗并不断提升各自的算法能力,直到判别器无法分辨数据集图像与生成图像。

Liu 等(2018b)首次将GAN 用于遥感图像融合,提出了PSGAN 模型,其中生成器用来得到HRMS融合图像,其损失函数定义为

式(16)和(17)中,X、Y分别表示MS 图像和PAN 图像,P表示HRMS 融合图像,N为训练图像样本数,α、β为1—100 范围的参数,G、D 分别是生成器和判别器。

PSGAN 模型在Quickbird 和GaoFen-1 两个卫星数据集上获得比PNN 等数个融合算法更高质量的融合图像。

然而,PSGAN 在生成器的训练效率以及细节信息保持上仍有很大的提升空间。Shao 等(2020)把GAN 与具有残差学习能力的自编码器思想相结合,设计了RED-cGAN(Residual Encoder-Decoder Conditional Generative Adversarial Network)的融合框架。RED-cGAN 中的生成器采用了双分支子网络结构,分别用它们提取PAN 图像和MS 图像的特征信息,接着通过RED(Residual Encoder-Decoder Module) 结 构 生 成HRMS 融 合 图 像,与PSGAN 模型的不同在于:RED-cGAN 的判别器使用PAN 图像与生成器产生的图像代替上采样的MS图像与生成器产生的图像作为其输入,以保留更多的空间细节信息。在WorldView-2和WorldView-3两个卫星数据集上RED-cGAN 得到比DRPNN、PanNet 和PSGAN 等模型更高质量的融合图像。Ozcelik 等(2020)设计了一个PanColorGAN 的融合框架,在Pléiades 和WorldView-2/3 卫星数据集上,PanColorGAN 获得了比PanNet 等多个融合算法信息更丰富的融合图像;Ma 等(2020)设计了一个基于GAN 模型的无监督学习融合框架Pan-GAN,其包含两个判别器,分别是光谱判别器和空间判别器,以更充分地保留源图像的光谱和空间信息。在WorldView-2 和GaoFen-2 两个卫星数据集上Pan-GAN 得到了比PNN、PanNet 和PSGAN等模型更高质量的融合图像;另外,Zhang 等(2019c)、Chen 等(2020)以及Zhang 等(2020)也将GAN应用于遥感图像融合的研究。

基于GAN 的全色图像锐化方法与其他模型(如基于CNN、DRN 的全色图像锐化)最大的不同在于GAN 由两个网络构成,分别是生成器与判别器,目前生成器所采用的网络模型多是自编码器。GAN 结构的优点在于可以并行地生成图像,与自回归模型相比,GAN 生成图像的速度比较快,而且生成的图像比较清晰(陈佛计 等,2021);另外,GAN 结构中的判别器可以进一步提升生成器所生成的图像的质量。由于GAN 结构具有以上优点,因此基于GAN 的全色图像锐化成为当前的研究热点。

4.1.5 对比小结

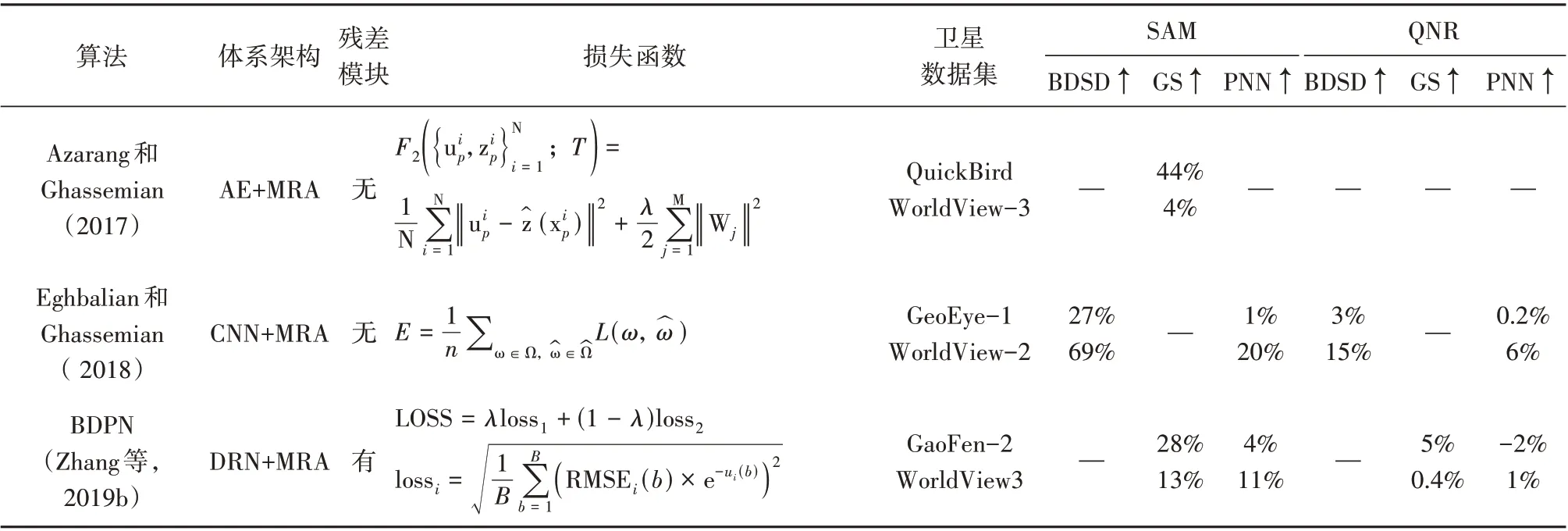

上述4节介绍了经典方式下,AE、CNN、DRN和GAN 等4 种常见的深度学习模型单独应用于遥感图像融合的研究,本节对这4类方法各自的特点和异同点进行小结,并在表3 中将4 类方法中的典型算法运用有参考和无参考图像质量评价指标进行了性能提升比的对比、分析和归纳(选择性能提升比作为定量分析的主要原因在于各融合算法采用的数据集存在差异)。综合考虑到算法对比的广泛性和代表性,选取BDSD (Garzelli 等,2008)、GS(Laben 和Brower,2000)和PNN(Masi等,2016)这3 种算法作为比较的基准算法;考虑到评价的全面性,选取有参考评价指标SAM(Alparone 等,2007) 和无参考评价指标QNR(杨勇 等,2020)作为比较指标,得到以下结论:

表3 经典方式算法比较(基准算法分为传统方法BDSD、GS,基于DL的PNN,选择SAM和QNR为比较指标,↑表示相对当前指标的提升比,— 表示空值)Table 3 Comparison of classical algorithms (the benchmark algorithm is divided into traditional methods BDSD, GS, and DL-based PNN, SAM and QNR are selected as the comparison indicators, ↑ represents the improvement ratio relative to the current indicator, — represents the null value)

续表

(1)相比于PNN 模型,融合效果提升的方法中,大多采用了DRN 网络结构或者网络宽度更宽的CNN网络,而极少使用AE网络;

(2)残差模块以及GAN 的使用,可以有效提升融合效果,如Liu 等(2018b) 提出的方法,GAN也表现比较强的潜力;

(3)即使采用简单的浅层CNN,如果在损失函数、残差模块等方面优化融合模型,仍可得到高质量的融合图像,如Scarpa 等(2018)提出的方法;

(4)损失函数中加入评价指标因子(如UIQI等),可增加融合网络模型的可解释性,如Yang等(2020a)提出的方法。采用GAN 的融合算法,损失函数中包含生成器损失L(G)和判别损失L(D),相比于其他模型的损失函数较为复杂,如Liu 等(2018b)和Ozcelik等(2020)提出的方法;

(5)各算法在SAM 指标上提升的幅度大于(或等于)在QNR指标上的提升幅度,少数算法在某些卫星数据集上QNR 指标没有得到提升,如Ozcelik等(2020)提出的方法。

4.2 协同方式

在深度学习技术应用于全色图像锐化之前,基于传统方法的全色图像锐化已经开展了数十年的研究,在这期间,产生了大量的融合算法,不乏有些算法已经应用于专业遥感软件系统,因而出现诸多把传统方法与DL 技术结合开展全色图像锐化的研究(Zhong 等,2016;Azarang 和Ghassemian,2017;He 等,2019)。由于CNN、DRN在全色图像锐化的显著效果,也出现了CNN 与DRN结合的全色图像锐化等方法。基于此,本文将传统方法+DL技术的全色图像锐化方法以及不同DL模型相结合的全色图像锐化方法概括为协同方式。

4.2.1 基于DL+CS的全色图像锐化

为了在全色图像锐化中保留MS 图像中的空间信 息,Zhong 等(2016) 把DL 技 术 与 传 统GS(Gram-Schmidt)方法结合构建一个新的融合框架。其中DL 技术采用的是SRCNN 模型,用来增强MS图像,然后将PAN图像与增强MS图像作为GS融合框架的输入,最后得到HRMS 图像;Azarang 等(2019)使用训练后的CAE(Convolutional AutoEncoder)网络以提升LRMS图像的空间信息,然后把CAE纳入CS的融合框架,最后完成遥感图像融合。

上述研究可看作DL与CS方法结合完成遥感图像的融合。其共同点是DL 技术用来增强MS 图像的空间信息,然后再按照传统CS融合方法得到融合图像;其不同点在于Zhong 等(2016)采用SRCNN模型增强MS 图像信息,而Azarang 等(2019)采用的是CAE网络。

4.2.2 基于DL+MRA的全色图像锐化

Azarang 和Ghassemian (2017) 设 计 了 一 个MRA 和DNN(Deep Neural Networks)结合的融合框架,其中DNN 由基本的AE 构成。Eghbalian 和Ghassemian(2018)设计了一个包含两个DNN 的融合框架,并分两大阶段对遥感图像进行融合,第一阶段完成图像融合,第二阶段进行光谱补偿。其中第一阶段的深度卷积神经网络DCNN(Deep Convolution Neural Network)与MRA 融合方法相结合完成图像融合,DCNN 的作用是用来提取MS 图像需要注入的空间信息;第二阶段的光谱补偿网络SCN(Spectral Compensation Network)实质上是在DCNN 网络的基础上,增加了新的损失函数,SCN 网络的目的是减少融合图像的光谱失真,同时尽可能地保存空间信息,在WorldView-2、GeoEye-1 和Pléiades 这3 个 卫 星 数 据 集 上 的 实 验结果表明该方法有效地提高了遥感图像融合效果。Huang 等(2018) 设计了一个主体由NSCT(Nonsubsampled Contourlet Transform)与DNN 构成的融合框架。该方法通过训练和融合两个阶段完成融合任务,在训练阶段,使用NSCT 分别对HR/LR PAN 图像在不同分辨率和方向上进行分解,得到高、低频子带图像并作为DNN 的输入来训练网络,以提取更丰富的空间结构信息;在融合阶段,由A-PCA(Adaptive PCA)与NSCT 联合把MS 图像分解为高频子带图像和低频子带图像,使用其高频子带图像作为训练后DNN 的输入,再把输出与MS 图像的低频子带图像联合,经过NSCT 逆变换等操作得到HRMS融合图像。

Zhang 等(2019b)设计了BDPN(Bidirectional Pyramid Network)的融合框架,BDPN 包含两个分支子结构,分别是重构分支和细节提取分支。细节提取分支结构是一个DRN 网络,用来提取PAN图像的空间细节信息,再注入到上采样的MS 图像中,然后利用重构分支得到HRMS 融合图像。Benzenati等(2020)设计了一个基于CNN的广义拉普拉斯金字塔融合框架,其中CNN 用来提高GLP(Generalized Laplacian Pyramid)的空间细节注入信息。

通常情况下,CS融合方法空间信息保持较好,光谱失真大;MRA 融合方法光谱细节保持较好,空间细节失真大。为客观评价基于DL+MRA 的融合方法在空间信息、光谱细节保持上的表现,表4给出了算法性能提升比分析,与之比较的方法有两类,包括CS 方法:IHS(Carper 等,1990)、文献(Shah 等,2008)和GFP(Liu 和Liang,2016);MRA 方法:Indusion(Khan 等,2008)、文献(Da等,2006)和Seg_GLP(Aiazzi 等,2007)。得到如下结论:

表4 WorldView-3数据集上DL+MRA算法比较(选择CC、SAM和QNR为比较指标)Table 4 Comparison of DL+MRA algorithms on WorldView-3 dataset (CC, SAM and QNR were selected as comparison indexes)

(1)在空间信息保持上,基于DL+MRA 的融合方法优于单独使用CS的融合方法;

(2)基于DL+MRA 的融合方法,在光谱细节保持上,能获得比单独MRA 方法更好的结果,均达到超过5%的提升;

(3)基于DL+MRA 的融合方法,在QNR 指标上,同样获得了比单独MRA方法更好的结果。

基于以上3 点,得出基于DL+MRA 的融合方法,起关键作用的是DL 技术的运用,其不仅能够增强该方法在光谱信息保持方面的能力,而且能克服MRA 方法在空间信息保持方面的不足,甚至超过CS方法在空间信息保持方面的优势。

4.2.3 基于DL+MB的全色图像锐化

Xing 等(2018a) 提 出 了 一 个DML-GMME(Deep Metric Learning based Geometric Multi-Manifold Embedding)融合框架。DML-GMME 分两个阶段完成图像融合,分别是训练阶段和重构阶段。训练阶段的网络模块是由数个SSAE(Stacked Sparse AutoEncoder)构成,用来提取由聚类分组的PAN 图像块和下采样PAN 图像块的流形(Manifold),即分别是HR 流形和LR 流形;在重构阶段,假定使用LR 流形重构MS 图像块的系数与使用HR 流形重构HRMS 图像块的系数相同,最后通过HR 流形,以及由MS 图像块与LR 流形计算出的系数共同重构出HRMS图像。

Ye等(2019)设计了一个DL 与优化模型相结合的融合框架。该融合框架由预处理、DRN 和重构这3 个部分构成,其核心模块是DRN,主要用来提取PAN 图像的空间信息。不同于大多数基于CNN 的融合方法在像素域训练网络,DRN 是在图像梯度域训练网络;重构模块是ADMM(Alternating Direction Method of Multipliers),ADMM把DRN输出的梯度信息和MS图像的上采用信息作为输入,最后重构出融合结果HRMS 图像。由于该融合框架的核心模块DRN 是在图像梯度域训练网络,使得该方法泛化性能得到提高,DRN 在WorldView-2 和QuickBird 两个卫星数据集上训练,能够使得融合框架在WorldView-3 和IKONOS 卫星数据集上直接得到融合图像,较PNN 等得到更高质量的图像。

4.2.4 基于DL+注入模型的全色图像锐化

He 等(2019)设计了两个基于CNN 的细节注入框架,分别是DiCNN1 (Detail injection based CNN)和DiCNN2。DiCNN1 通过CNN 从MS 图像和PAN 图像中提取细节,然后注入到MS 图像,得到HRMS 图像;DiCNN2通过CNN 从PAN 图像中提取细节,然后注入到MS 图像,从而得到HRMS 图像。DiCNN1 和DiCNN2 共同之处是DL 技术与细节注入模型结合完成图像融合,不同之处主要是网络结构、损失函数和应用目标的差异。DiCNN1 和DiCNN2 在World View-2,IKONOS 和Quickbird 这3 个卫星数据集上较PNN 与DRPNN 等模型得到信息更丰富的融合图像;He 等(2020)设计了SAPNN的融合框架,在上述3个常见卫星数据集上获得了比PNN 与DRPNN 等模型更高质量的融合结果。

Deng 等(2020)把传统融合方法与深度学习方法相结合,设计了Fusion-Net 的融合框架。Liu等(2020)提出了基于浅-深卷积网络与细节注入模型结合的融合框架MIPSM(Multispectral Image Pan-Sharpening Method),包 含SDCN (Shallow-Deep Convolutional Network) 和SDDI (Spectral Discrimination-based Detail Injection)两个子模型。其中SDCN中的浅层CNN分支网络用来提取PAN图像中层的空间特征,另一个深层DRN 分支网络用来提取PAN 图像高层的空间特征,然后将提取的空间细节注入到上采样的MS图像得到融合图像。

特别地,MIPSM定义如下的损失函数:

式中,GjMS表示上采样MS 图像第j个通道的光谱信息,gD表示SDCN输出的空间信息,fMS表示“真实图像”,S表示上采样MS图像的通道数。

整体上,MIPSM 在IKONOS 和QuickBird 两个卫星图像数据集上的融合实验达到比PNN 等模型更好的结果。但是,MIPSM 在某些指标上(如SAM)泛化性能表现不足。

从结构上分析,He 等(2019)提出的DiCNN融合模型与Liu等(2020)提出的MIPSM 融合模型共同点在于都是基于DL+注入模型的全色图像锐化方法,不同点在于MIPSM 融合模型利用高通滤波提取PAN 图像高频信息,有效提高了该方法的泛化能力。

4.2.5 基于CNN+DRN的全色图像锐化

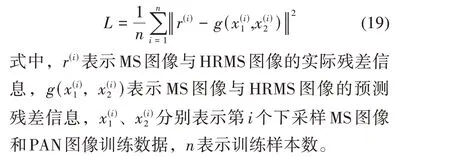

受Masi 等(2016)工作的启发,为提升基于DL 的全色图像锐化的融合质量,Yuan 等(2018)设计了一个包含PNN 和多尺度深度神经网络的两个子网络结构的融合框架MSDCNN (Multiscale and Multidepth Convolutional Neural Network),其中PNN 用来提取简单特征;多尺度深度神经网络用来提取多尺度的特征,以增强对高分辨率图像中丰富的空间信息的提取、提高各种复杂地面场景中特征提取的鲁棒性。另外,为了让多尺度深度神经网络深度更深以及提升训练效率,该子网络也加入了跳转连接,MSDCNN 在QuickBird 和WorldView-2 两个卫星数据集上获得比PNN 等更好的融合效果,Shao 和Cai(2018)设计了一个包含双分支CNN 的融合框架RSIFNN (CNN-based remote sensing image fusion)。两个分支CNN 分别提取源图像的特征,最后经过进一步处理来得到融合图像。特别地,Shao 和Cai(2018)定义了以下的损失函数:

Hu 等(2019)设计了一个DSL (Deep Self-Learning model)用于自适应遥感图像融合。DSL融合框架由3 部分构成,分别是点扩展函数PSF(Point Spread Function) 计算模块、图像配准模块和图像融合模块。其中PSF计算模块实质上是一个CNN 网络,用来完成对MS 图像的PSF 计算;图像配准模块完成MS图像与PAN 图像的配准;图像融合模块实质上是一个DRN 网络,使用PSF 对配准后的MS 图像与PAN 图像进行降采样得到训练样本,对DRN 网络进行训练, 最后通过训练后的DRN 网络自适应地完成图像的融合。DSL在GF-2、GF-1 和JL-1A 这3 个卫星数据集的实验表明,较数个传统模型,DSL得到更高质量的融合图像。

上述基于CNN+DRN 的全色图像锐化的共同点是融合框架里都包含两个网络,分别是CNN 和DRN,融合框架较其他方法在网络的深度、宽度上都有较大的突破,这样就使得此类模型对PAN 图像、MS 图像信息提取更为充分;不同之处是PAN图像与MS 图像共同作为MSDCNN 的输入和DSL 融合框架中融合子模块DRN的输入,而RSIFNN的两分支网络单独对PAN 图像和MS 图像分别提取信息,即PAN 图像作为RSIFNN 的一个分支网络的输入,MS图像作为其另一分支网络的输入。

4.2.6 基于RNN+CNN的全色图像锐化

RNN 可以将神经元输出再输入到该神经元,网络结构的串联性便于处理时间序列数据,从而使得对数据中的依赖关系能有效保持。然而,传统的RNN 对信息的长期保存往往难以实现。为解决这个难题,Hochreiter 和Schmidhuber(1997)设计了长短期记忆LSTM (Long-Short Time Memory)网络,LSTM 较一般的RNN具有更为灵活的内部结构。Shi 等(2015)把2D 的卷积操作引入到LSTM设计出CLSTM,能够处理2 维特征图信息并自动捕捉时间依赖性。同时,CLSTM 也能够用于处理三维数据(Wang等,2020)。

除上述5 类主流的协同方式全色图像锐化外,也有学者将其它的DL 模型运用于该研究领域,如RNN模型。Wang等(2020)设计了一个包含CLSTM(Convolutional Long-Short Term Memory)的融合框架DCNet(dual-channel network,DCNet),首次将基于CLSTM 的RNN 模型应用于全色图像锐化领域。DCNet包含两个分别用于提取空间特征信息和光谱特征信息的CNN 分支网络,其中提取空间特征信息的子网络采用2D CNN 实现,提取光谱特征信息的子网络采用3D CNN 实现。为了更充分地融合提取的空间、光谱特征信息,DCNet 借助于S2-CLSTM(Spatial-Spectral CLSTM)模块并采用分层的融合策略,最后通过重构模块得到融合图像HRMS。DCNet在GaoFen-2和 WorldView-2两个卫星数据集上得到了比PNN 等模型更好的融合结果。

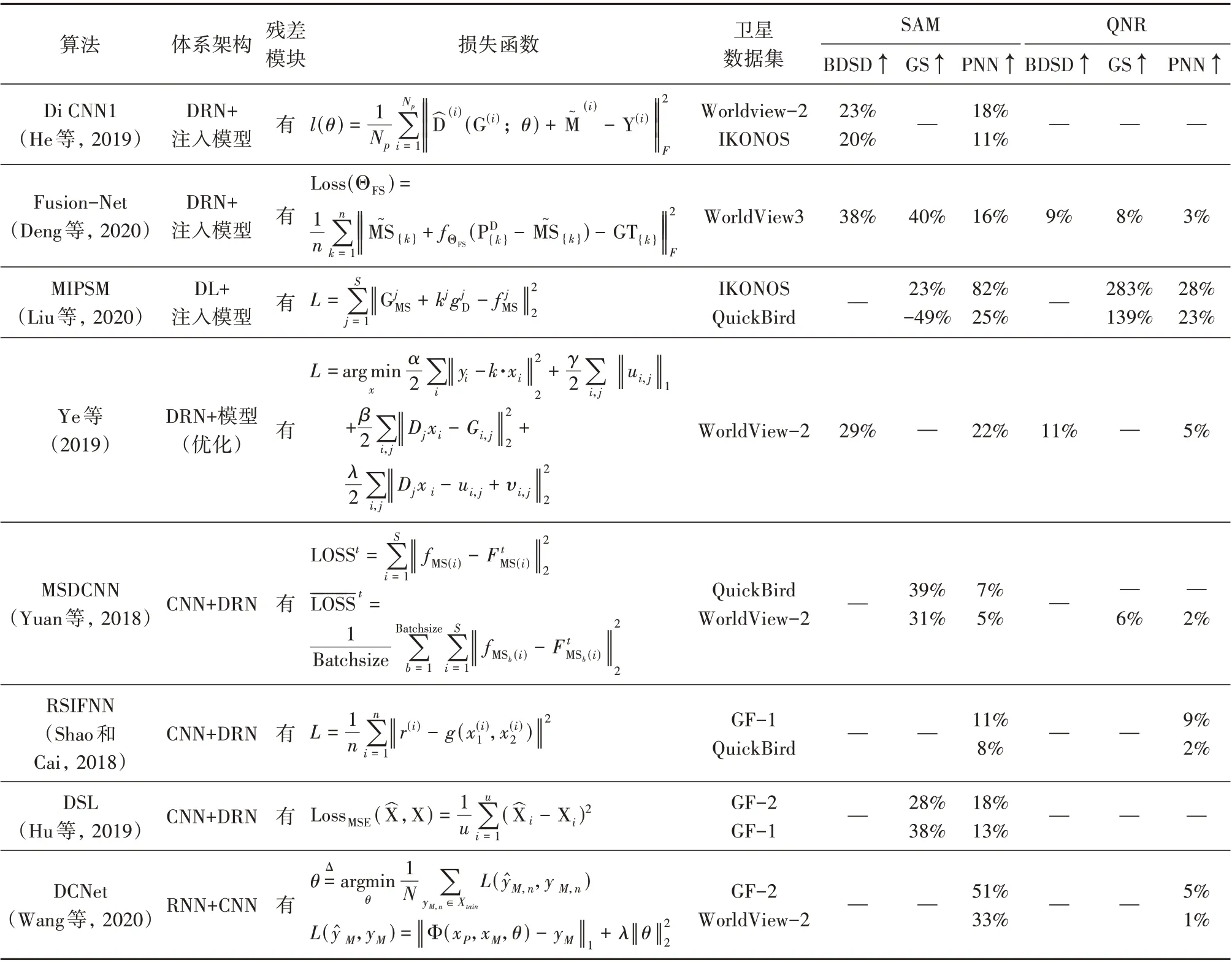

4.2.7 对比小结

上述介绍了协同方式下,DL+CS、DL+MRA、DL+MB、DL+注入模型、CNN+DRN 和RNN+CNN应用于解决遥感图像融合问题。本节对这6类方法各自的特点和异同点进行小结,并在表5 中将6 类方法中典型算法进行性能提升比对比分析,可以得到以下结论:

表5 协同方式算法比较(基准算法分为传统方法BDSD、GS,基于DL的PNN,选择SAM和QNR为比较指标)Table 5 Comparison of collaborative methods algorithms (the benchmark algorithm is divided into traditional methods BDSD and GS, and DL-based PNN, and SAM and QNR are selected as comparison indexes)

续表

(1)较PNN 模型,融合效果有所提升的方法中,大多数采用了DRN 网络结构或者CNN+DRN网络;

(2)较PNN 模型提升融合效果最好的几个方法中,DL+注入模型等DL 技术与传统融合方法相结合的方法表现出良好性能,如He 等(2019)、Deng等(2020)和Liu等(2020)提出的方法;

(3)相对PNN 模型提升10%以上的方法中,使用自适应学习机制,可使得模型在不同的卫星数据集上的融合质量偏差限制在较小范围内(±5%以内),表现出较强的泛化性能,如Hu 等(2019)提出的方法;

(4)大多数算法在SAM 指标上提升的幅度大于(或等于)在QNR 指标上的提升幅度,少数算法在QNR 指标上得到较高提升,如Liu 等(2020)提出的方法。

协同方式下,上述6节中采用的方法共同点在于网络结构较为复杂。为便于直观理解,下面给出一个典型的基于DL+注入模型的遥感图像融合算法框架图4(Liu 等,2020)。图4中DL技术使用了CNN网络和DRN 网络,其中CNN 采用浅层网络,DRN为深层网络,两者联合起来提取PAN 图像的空间细节信息;采用注入模型,把获得的空间信息注入到上采样的MS图像,从而得到HRMS融合图像。

图4 典型的基于DL+注入模型的遥感图像融合框架Fig.4 Typical remote sensing image fusion framework based on DL+ injection model

4.3 经典方式与协同方式对比小结

第4.1 和4.2 节分别从经典方式与协同方式两个视角对融合算法进行了比较和分析;本节对两种融合方式进一步归纳,可得出如下结论:

经典方式与协同方式的共同点是:都是利用DL 技术能够自动学习复杂数据特征的优势,提取MS 图像或PAN 图像的特征信息,而这些信息正是HRMS融合图像需要保留的。

两种方式的不同点是:从融合模型结构上分析,一般经典方式结构较为简明,而协同方式由于是多个方法、框架的结合,往往结构较为复杂。此外,从表3、表5 可看出,无论是经典方式,还是协同方式,融合模型结构的复杂性与损失函数复杂度是正相关的,如Cai 等(2018) 提出的CSDA 方法、Ye 等(2019)、Yuan 等(2018)提出的MSDCNN 方法以及基于GAN 融合方法的损失函数。

从融合效果上看,从表4 和表5 可以看出,一般情况下,协同方式能够获得比传统融合算法以及经典方式更高质量的融合效果,如Zhang 等(2019b)提出的BDPN方法。

为更好地理解经典方式与协同方式融合算法的发展脉络,我们选取了一些代表性的算法进行对比说明,如表6 所示。从表6 可以看出现有大部分融合算法体系结构中包含DRN 模块,损失函数多数采用L2 loss,采用GAN 网络的融合算法的损失函数为Adversarial loss。

表6 经典方式与协同方式融合算法基本发展脉络Table 6 Development of classical and collaborative pansharpening

此外,从基于深度学习的全色图像锐化自身研究领域来看,早期的基于深度学习的融合方法,多数利用了深度学习模型强大的数据拟合能力,较少地关注全色图像锐化的领域问题(Huang等, 2015)。随着研究的逐步深入,如通过深度学习方法和传统融合方法相结合等,这样设计出的融合模型就考虑到了光谱失真、空间失真等领域问题,并提出相应的解决方案,从而使得深度学习方法可以进一步提升全色图像锐化的效果,如PanNet、BDPN等融合模型。

5 全色图像锐化的应用

随着遥感技术的发展,全色图像锐化的应用领域愈加广泛,具体包括地物分类、目标识别以及变化检等。下面对此简要介绍:

(1)地物分类。Gianinetto 等(2017)利用遥感融合图像,并结合基于目标的图像分析技术,设计了一个对复杂地貌进行层次分类的模型并应用于意大利威尼斯地区地物分类,达到了较高的分类准确率;Aguilar 等(2013)利用GeoEye-1 卫星和WorldView-2卫星的融合图像,对西班牙南部阿尔梅里亚省的遥感图像进行地物分类,并对两个卫星的融合图像分类结果加以对比分析,得出融合图像中的光谱信息对分类结果有较大影响;Pálsson 等(2012)在IKONOS 和QuickBird 两个卫星图像数据集上,运用6种全色图像锐化方法分别得到融合图像,在此基础上对冰岛雷克雅未克和意大利罗马两个城市的遥感图像进行地物分类,并对其分类结果进行定量分析,得出如下结论:融合图像的光谱信息在可接受的范围内,空间信息保持越好越有利于地物分类。

(2)目标识别。使用高质量的遥感融合图像对桥梁进行识别和损伤检测,在紧急救援和生命线安全评估中具有重要意义(Chen 等, 2019)。Chen 等(2019)设计了基于领域知识的方法对广东省惠阳市(区)遥感融合图像中的桥梁进行识别和损伤检测;Garzelli 等(2009)使用遥感融合图像对意大利马尔彭萨机场的小型目标进行识别,并分析了不同融合方法对目标识别效果的差异。在地理空间目标识别中,道路信息的提取是一项重要的研究任务, Mohammadzadeh 等(2006)把模糊逻辑和形态学应用于融合后的IKONOS卫星图像,对位于埃及金字塔周围城市、郊区和乡村等地区的道路中心线信息进行提取和识别。

(3)地表变化检测。地表变化检测是一种评估和预测灾害、监测地表覆盖变化的关键技术(李胜, 2018)。为了检测和评估自然灾害对水上桥梁的破坏程度,Chen 等(2018)提出了一种利用遥感融合图像进行水上桥梁损伤检测与评估的方法,并应用于浙江省舟山市水上桥梁的损伤检测和评估;Bovolo等(2010)利用意大利特伦托市的卫星图像,从定性和定量方面分析了5种全色图像锐化方法所生成的融合图像在地表变化检测任务上的差异;森林退化图的绘制能够改进地区或全球生态模型以及碳预算估计,Souza 等(2003)利用遥感融合图像研究了亚马逊东部地区的森林变化情况,并绘制了亚马逊东部地区的森林退化图。

6 展 望

自2006 年以来深度学习技术得到日新月异的发展,并在多个领域取得突破性进展,激励着许多学者将深度学习技术应用于全色图像锐化领域,近6年来取得一系列研究成果,但仍然有一些关键性问题需要深入探索,通过分析、思考,本文凝练出以下五个研究方向。

(1)与遥感领域知识的结合。根据遥感图像的特点,可利用遥感领域大量现有的特定领域知识有针对性地对深度学习模型进一步改进,充分挖掘深度学习的潜力,从而得到细节更为丰富,光谱更加自然的融合图像(Deng 等,2020)。例如,可以根据遥感领域特定的知识构建新的目标函数和度量方法,找到MS 图像、PAN 图像以及融合图像之间的潜在联系;根据MS 图像多波段光谱信息以及PAN 图像空间信息丰富的特点,设计多层次、多尺度的全色图像锐化模型。

(2)自监督的全色图像锐化方法。大部分基于深度学习的遥感图像融合方法都是通过使用大量的根据Wald协议(Wald 等,1997)所获得的模拟数据进行监督学习。然而,所获得的模型受限于监督学习中所使用的样本数据,不具备良好的泛化能力。当训练数据和测试数据的约束条件一致时,可以获得显著的效果。然而,当训练数据和测试数据的约束条件不一致时,往往会导致光谱失真和空间细节丢失。自监督学习可以从未标记的数据中学习到有效的特征表示而无需人工标注的标签信息,这样使得自监督学习得到的模型不会受限于样本数据,具有良好的泛化性能。所以,基于自监督学习的遥感图像融合方法是一个值得研究的方向。

(3)全色图像锐化标准数据集。对于深度学习模型,不断增加的高质量训练数据能够提升其性能。然而,在当前研究中,训练数据集大多从现有几个卫星数据集中由研究者自主选取,不可避免地存在一定程度的主观性和局限性。标准数据集构建已经在图像处理其它领域取得成功,如图像分类领域的ImageNet 等公开标准数据集。然而,在遥感图像融合领域还没有被深入广泛地探索。研究遥感图像融合的标准数据集,构建巨大规模的标准数据集以及基于标准数据集的新型融合算法设计是未来可以努力的重要方向,如Transformer 在标准数据集上的应用、各类全色图像锐化模型在标准数据集上的比较研究等。

(4)面向全色图像锐化应用的评价。全色图像锐化在诸如地物分类、目标识别等任务中有着重要的应用价值。然而从现有的文献来看,评价各算法模型主要注重提升融合图像的质量,对模型的应用评价却并未涉及。融合算法在具体应用中的性能如何,不仅与高质量的融合图像有关,更与具体应用领域的知识相关。因而,面向应用的遥感图像融合算法评价是今后需要进一步研究的方向,如某些花草类植物的识别更注重MS 图像部分光谱波段的信息,所以常用的定量评价指标就需要根据具体的应用进行调整以满足对光谱信息的有效评价(罗代清 等,2016)。

(5)轻量级全色图像锐化深度模型。现有的基于深度学习的全色图像锐化模型,在主观效果和客观指标上一般优于传统的融合方法。然而,基于深度学习的全色图像锐化模型需要对大量的网络参数进行训练,另外,为追求性能的进一步提升,研究者通常构建结构更为复杂的模型,从而造成全色图像锐化模型容量更大、训练时间更久,这限制了全色图像锐化深度模型在实际中的应用。轻量级深度模型具有较小的网络容量和较低的时间复杂度,同时对硬件的要求也较低,为使基于深度学习的全色图像锐化模型更为实用,利用诸如通道权重参数共享、快速引导滤波器等方法构建轻量级的全色图像锐化模型也是今后一个值得探索的方向。

7 结 语

深度学习技术对非线性、结构复杂的数据具有强大的学习表征能力,在计算机视觉等研究领域取得了较大进展。受此启发,许多研究者将该技术运用于像素级全色图像锐化的研究中,并取得了一系列的研究成果。然而,专门的、系统全面的基于深度学习的像素级全色图像锐化研究综述尚未见于文献。为此,本文提出从经典方式和协同方式两个方面对现有基于深度学习的像素级全色图像锐化模型研究成果进行详尽的综述、分析挖掘其演进规律路径,并结合深度学习最新的发展趋势,凝练了基于深度学习的全色图像锐化研究领域的5个未来研究发展方向。

当前,基于深度学习的像素级全色图像锐化研究尚处于初步阶段,其研究成果日新月异。可以预见,在未来的研究中,面向标准数据集的且高效的基于深度学习的全色图像锐化模型将大量涌现。本文针对基于深度学习的全色图像锐化方法进行的综述研究希望能够为相关研究人员提供一些参考和启发。