图像特征融合的行人重识别方法*

齐宝光,何小海,卿粼波,陈洪刚

(四川大学,四川 成都 610041)

0 引言

2006 年,Gheissari 等人[1]第一次提出了行人重识别的概念,其被当作跨摄像头多目标跟踪下的子问题进行研究,即如何在跨摄像头中利用行人特征的相似度进行轨迹关联。类似于其他计算机视觉的任务,行人重识别也存在很多难点,例如,人物被遮挡、无正脸照、姿态变化、配饰变化、拍摄角度改变、低分辨率、室内外环境或光线变化、服装搭配穿衣风格变化以及目标检测算法[2]的误检等。尽管存在这些困难,但通过研究人员的努力,基于深度学习的行人重识别方法仍取得了很大的进步,识别精度得到了很大的提升,这些方法包括一些有监督的方法[3-12]以及无监督和弱监督的方法[13-19]。大部分方法主要使用表征学习[3,6,8]和度量学习[4,7,11,16]的方法。最近,越来越多的研究者关注行人的局部特征[9,12,17]和注意力机制[10],并取得了很多成果,这是因为局部特征能提供更多的细节信息。

文献[20]提出了姿势提取模型并应用于行人重识别任务,该文献提出的姿势提取网络提取出14个人体关键点,并完成人体关键点计算、行人特征提取和特征融合。为了降低遮挡物体对姿势提取模型的影响,文献[21]首先使用姿势提取模型提取人体关键点,其次计算关键点的置信度。在计算融合特征时,置信度低于阈值的关键点权重会被置零不参与计算。文献[22]通过水平切割深层特征块,将全局特征水平分割为多个均匀的小块,分别表示人体不同的部件。文献[23]提出了金字塔模型,该模型通过粗粒度到细粒度的渐变保留了全局特征和局部特征,最终得到的融合特征包含有渐变关系。基于姿势估计的局部特征方法,通常需要依靠外部的姿势估计数据集和姿势估计器,其带来的数据误差会影响到重识别精度。基于特征空间分割的局部特征方法,可以有效地缓解遮挡和低分辨率对性能带来的影响,但仍需探究如何更好地融合全局特征和局部特征,以提升重识别的性能。

因此,为了在遮挡、低分辨率、视角变化等场景下,捕捉到更充足的细节信息,得到更可靠的特征表达,本文提出了基于图像特征融合的行人重识别方法。该方法在训练时,对骨架网络提取到的深层特征水平分割,得到3 块局部特征,并分别进行身份(Identification,ID)损失的计算,然后将全局特征也独自进行ID 损失的计算,以优化网络的特征表达,使图像特征注意到更多的细节信息,并且对全局特征进行距离度量,对行人特征的相似度进行约束。本文方法在对目标行人检索时,将局部特征与全局特征融合到一起进行距离度量,以得到具有足够细节信息的图像特征。通过在Market1501[24]和DukeMTMC-reID[25]上进行广泛的实验,证实了本文所提方法的有效性,并达到了目前比较可观的性能。

1 图像特征融合的行人重识别方法

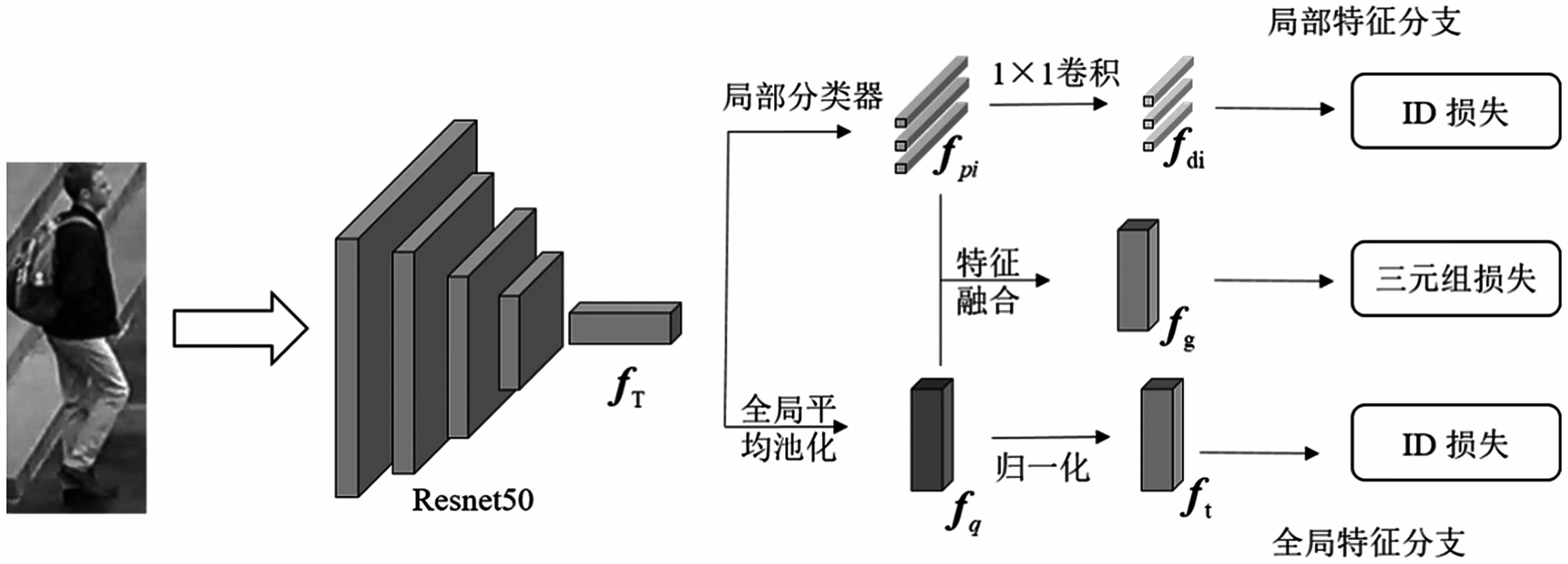

本文采用的行人重识别网络结构如图1 所示,该方法使用Resnet50 网络作为骨架提取行人的视觉特征。为了解决行人重识别中常出现的遮挡以及图像质量低等问题,提出的方法采用全局特征融合局部特征的方式加强图像特征的表述力。当行人图像通过骨架网络Resnet50 的最后一层得到特征fT后,使用两个分支对特征fT进行后续处理,一个分支进行全局特征处理,称为全局特征分支,全局特征作为对图像的整体描述关注行人图像的整体信息;另一个分支进行局部特征处理,称为局部特征分支,局部特征分支会注意到更多的细粒度局部显著特征,从而改善遮挡和低分辨率的问题。

图1 图像特征融合的行人重识别网络

1.1 图像的ID 损失

在全局特征分支,首先将特征fT通过全局平均池化得到特征fq,其次令fq通过归一化结构取得归一化特征ft用于全局特征的ID 损失。给定一个包含N个元组的数据集,每个元组都有一个图像x和ID 标签y,使用F(·|θ)指代特征提取网络,使用C指代分类器,全局特征的ID 损失由多分类交叉熵 ℓce来表示,并使用软交叉熵损失函数-qlogp进行监督,则有:

式中:Lid为多分类交叉熵函数对输入图像的计算结果;Lt为使用软交叉熵损失函数进行监督的结果。

在局部特征分支,首先将特征fT分割为3 块来对应行人不同的身体部位,但由于直接水平切割的硬化分类会出现局部不对齐的情况,所以使用了一个单独的局部块分类器来对各个块进行分类并调整各个块与块之间的特征以实现图像的软分割,完成局部对齐。由于要对张量fT中每个预划分的区域块的边界部分进行微调,因此需要对区域块中抽样出的更小的块f进行分类。为了完成图像块分类器,对f进行分类的定义公式为:

其次计算f属于Pi块的概率P(Pi|f),其中WiT是局部块分类器的可训练权重矩阵。由于f是fT的子集且每个块Pi都是从所有的f中以采样权重P(Pi|f)进行采样得到的,因此当给定特征f与其对应局部Pi的概率P(Pi|f)后可以推出:

通过将各个块边缘部分的离群值重新划分到邻近的块上,增强各个块之间信息过渡的连续性,实现了水平切块的软分割。最后将这3 块局部特征通过卷积操作得到特征fdi计算独自的ID 损失 Lid,原理与式(1)和式(2)相同。

1.2 图像的三元组损失

通过对特征fq进行归一化操作[26]得到ft,对特征fpi进行卷积操作得到fdi,使得ID 损失和三元组损失在不同的嵌入空间中分别使用余弦距离和欧式距离进行模型优化,更利于三元组损失的收敛与模型的优化。

本文使用三元组损失[27]训练融合特征fg,使得相同身份的图像样本距离更加接近并将不同身份的样本推远。融合特征fg由局部特征fpi与全局特征fq按照式(5)计算得到:

式中:λpi为局部特征fpi的平衡参数,且λpi=0.1。

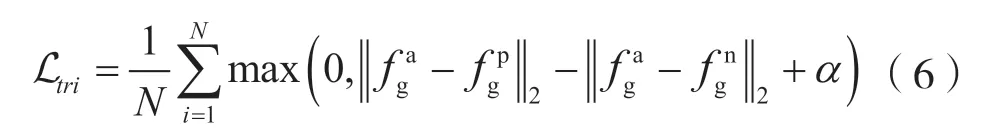

融合了局部特征和全局特征的fg在关注全局信息的同时也注意到了更多的细节信息,提高了模型的鲁棒性。三元组损失由固定图片(Anchor)、正样本图片(Positive)、负样本图片(Negative)3 张图片组成,其中Anchor 是数据集中随机抽取的图片,Positive 是与Anchor 相同类别的图片,Negative是与Anchor 不同类别的图片。分别使用fgp和fgn表示fga的正样本和负样本,||·表示欧氏距离,其计算式为:

在图像特征的处理中,本文使用了分块特征联合全局特征的策略解决了行人图像不匹配的问题。在训练阶段将全局特征和局部特征分别送入全连接层计算ID 损失,并计算融合特征fg的三元组损失,在测试阶段将全局特征与局部特征根据特征融合策略联合到一起得到fg进行距离度量。

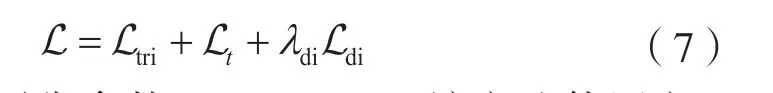

1.3 联合损失函数

最终的损失函数是图像全局特征的ID损失tL、局部特征的ID 损失 Ldi、三元组损失 Ltri的组合:

式中:λdi为平衡参数,且λdi=0.1。该方法使用交叉熵损失(cross-entropy loss)作为ID 损失,ID 损失作用于图像的全局特征,使它们具有区分行人的能力。ID 损失作用于局部块,使每个局部特征都具有独自区分行人的能力,增强了特征表达,可以帮助网络注意到更多的局部细节信息。三元组损失拉近了正样本之间的特征距离,推远了负样本之间的距离,并且通过归一化和卷积操作,减少了不同任务之间的相互约束,使ID损失和三元组损失更加收敛,在联合损失优化的同时也优化了视觉特征网络的调参,得到更鲁棒的视觉特征。在多种损失的联合训练下,该模型可以达到较好的检索效果。

2 实验结果分析

2.1 数据集

为了验证所提出的方法对行人重识别的作用,本文在Market1501、DukeMTMC-reID 上进行了广泛的实验,使用平均精度(mean Average Precision,mAP)、Rank1 作为评价指标,并与主流算法进行了对比。

2.1.1 Market1501

Market1501 是目前在行人重识别中大规模使用的公共数据集,它包含从6 个不同的视点捕获的32 668 个标记的边界框,其中包含1 501 个身份。使用局部可训练的变形零件模型(Discriminatively Trained Part-Based Models,DPM)[28]检测边界框。数据集分为用于训练的具有751 个身份的12 936 幅图像和用于测试的具有750 个身份的19 732 幅图像两部分。在测试时,将使用3 368 张具有750 个身份的图像作为检索图像。

2.1.2 DukeMTMC-reID

DukeMTMC-ReID 数据集包含8 个非重叠摄像机视图捕获的1 812 个行人,共有36 411 张图像。该数据集包括用于训练的16 522 张图像和用于测试的19 889 张图像,以及2 228 张查询图像和17 661张检索图像。其中1 404 类为3 个以上摄像头拍摄,其余408 类为1 个摄像头所拍摄,将出现在多个摄像头的1 404 类行人图像平均分成两部分。

2.2 实验内容

2.2.1 参数设置

本文使用pytorch 框架来训练模型,使用Image Net 上的预训练模型初始化Resnet50,并将全连接层的尺寸更改为N,表示训练数据集中的类别数。采用Adam 算法对模型进行优化,整个模型有多个损失任务,训练时模型计算每个任务产生的梯度并使用加权梯度更新网络。本文将图像全局特征ID损失和三元组损失的梯度权重分配为1,将图像分块特征的ID 损失的梯度权重λdi设为0.1。网络中所有全连接层的丢弃率设为0.5。实验过程中,在数据集中随机抽取P位行人的K张图像组成一个训练批次,批量大小等于B=P×K,将P设置为16,K设置为4。每张图像的大小调整为256×128,并以0.5 的概率水平翻转图像。然后将每张图像解码为[0,1]中的32 位浮点原始像素值,最后分别减去0.485、0.456、0.406 并除以0.229、0.224、0.225,从而对RGB 通道进行归一化。

在Market1501 和DukeMTMC-reID 上进行了实验,在训练时对全局特征和局部特征分别计算损失,测试时将全局特征和局部特征联合到一起得到融合特征进行查找,得到的检索准确率高于原始baseline 的准确率,并且算法性能优于较新的行人重识别算法。

2.2.2 与主流算法的对比

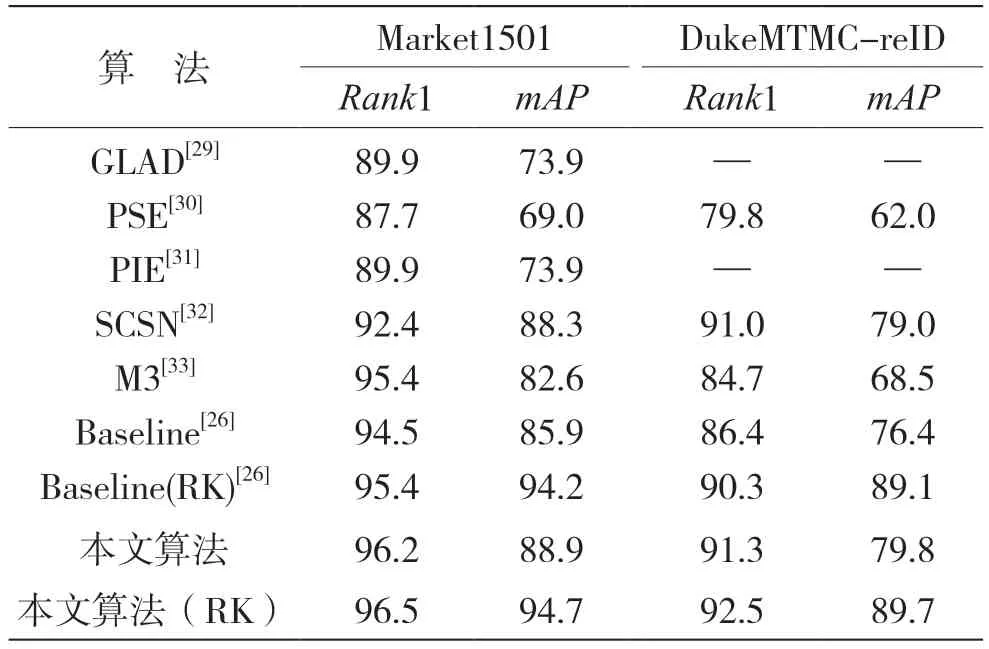

在Market1501 和DukeMTMC-reID 上与主流算法的对比结果如表1 所示。其中GLAD[29]、PSE[30]和PIE[31]是基于姿态特征的算法,SCSN[32]、M3[33]都是最新的行人重识别算法,跟它们对比可以说明本文模型的先进性。

表1 Market1501 和DukeMTMC-reID 上与主流算法的对比结果 %

在使用相同主干网络(ResNet50)的情况下,对比结果可知,本文所提出算法的Rank1 精度和平均精度(mAP)都高于这些算法。其潜在原因是本文使用的局部特征增强了网络对细节信息的关注度,一定程度上改善了遮挡和低分辨率的问题,提高了网络对视角变化和配饰变化的鲁棒性。在Market1501 上获得Rank1=96.2%,mAP=88.9%的准确率,并且在DukeMTMC-reID 数据集上获得Rank1=91.3%,mAP=79.8%的准确率,得到了较好的效果,高于所有对比算法。

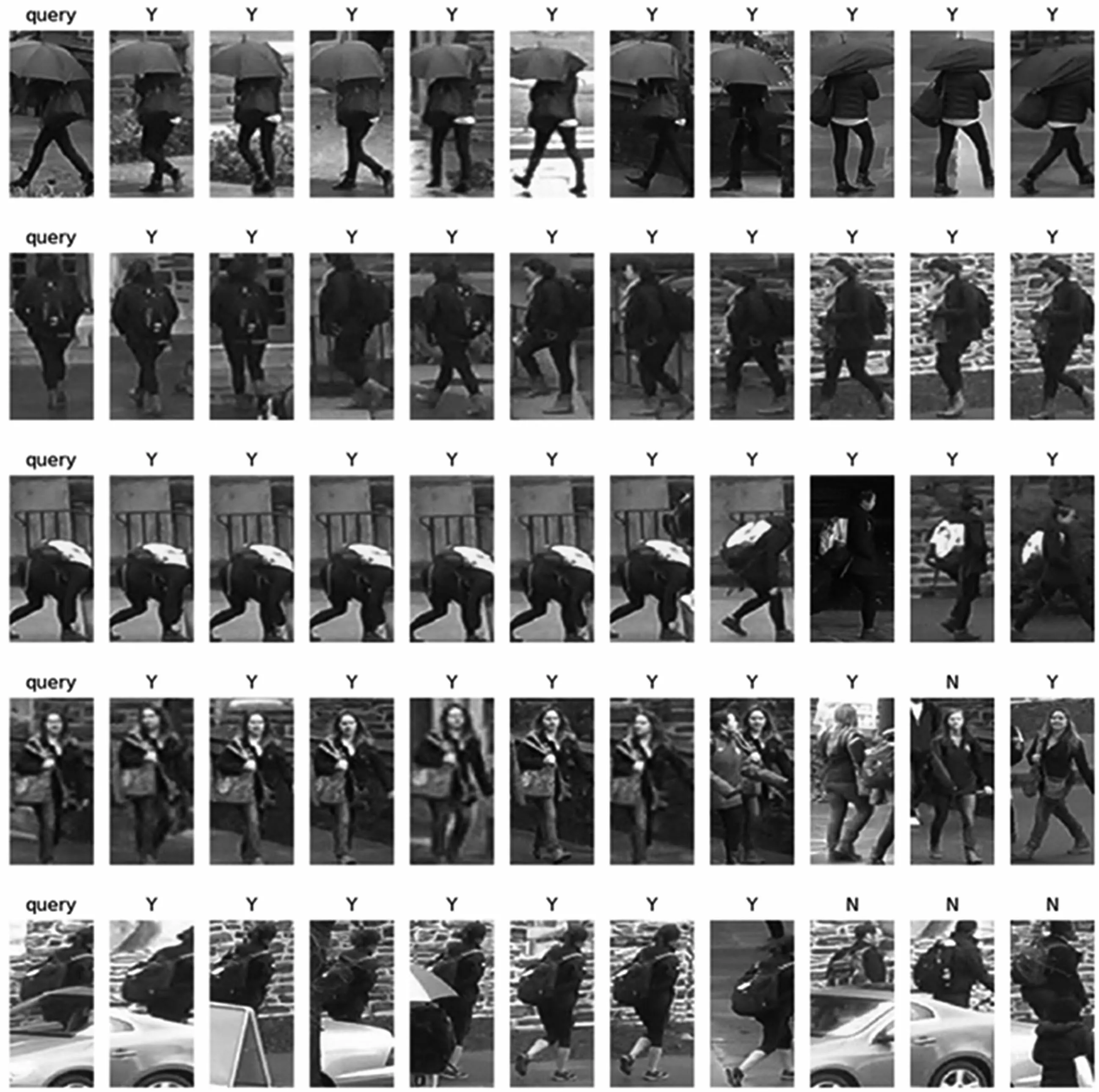

2.2.3 可视化分析

图2 展示了在DukeMTMC-reID 数据集下的部分实验结果图,其中字母“Y”表示检索成功,字母“N”表示检索失败。第一列为查询图像(Query),其检索结果为排名前10 的图像,根据与查询图像相似度从大至小依次排列。前3 行检索结果显示了算法强大的鲁棒性,无论这些捕获的行人姿势或步态如何变化,融合特征都可以鲁棒地表示其身份的辨别性信息。第4 位行人的检索图像分辨率低,十分模糊不清,但是本文算法只在排名第9 的图像检索错误,其余均检索正确且包含被遮挡的图像、背部图像和高质量图像。最后一位行人的检索图像被严重遮挡且包含了大量无用信息,但融合特征仍然能够根据背包和黑色上衣等细节信息找到大量正确样本,包括该行人无遮挡的全身照。因此从实验效果图可以看出,本文算法在姿态变化、低分辨率、遮挡等多种情况下的鲁棒性较高。

图2 DukeMTMC-reID 数据集下的部分实验结果

3 结语

本文提出了一种图像特征融合的行人重识别方法,解决了姿态变化、低分辨率以及遮挡情况下网络提取特征不可靠的问题。本文通过构建全局特征分支和局部特征分支使网络注意到足够的整体信息和细节信息,在检索时通过融合全局特征和局部特征得到最后的融合特征。局部特征的引入,使网络关注到更可靠的局部信息,忽略掉遮挡以及图像中质量较低的信息,大大提升了网络的性能和识别的准确率。在行人重识别数据集Market1501 和DukeMTMC-reID 上的实验证明了融合特征优于原始的全局视觉特征,并且在遮挡、姿态变化、图像质量低等因素下具有较强的鲁棒性,达到了较先进的性能。